AI視頻終于告別"等等黨"- MirageLSD讓實時生成成為現實

昨天看到DecartAI團隊在X上發布了一條消息:"我們很興奮地推出MirageLSD:首個直播流擴散AI視頻模型。"

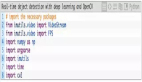

圖片

圖片

說實話,剛看到這個宣傳語的時候,我第一反應是又來一個宣傳過度的AI工具。

但仔細研究了一下他們的技術細節,發現這次可能真的不一樣。

如果你用過Runway、Pika這些AI視頻工具,肯定對一件事印象深刻:等待。輸入提示詞,點擊生成,然后就是漫長的等待時間。

傳統的AI視頻工具通常需要等待10秒以上才能生成一個5-10秒的短視頻。而且生成完成后,如果你想要修改其中某個細節,就得重新開始整個流程。

從"小時級"到"毫秒級"的技術突破

MirageLSD最核心的突破在于實現了真正的實時視頻生成。什么叫實時?就是你對著攝像頭做一個動作,AI立即就能把你變成鋼鐵俠,延遲低到你基本感覺不到。

具體來說,MirageLSD的響應時間是40毫秒以下,能夠以24幀每秒的速度進行實時視頻轉換。相比之下,其他AI視頻模型的響應速度要慢16倍以上。

我試著在他們的網站上測試了一下這個功能。打開攝像頭,輸入"cyberpunk style"的提示詞,然后就看到自己實時變成了賽博朋克風格的角色。這種感覺真的很奇特,就像魔法一樣。

"MirageLSD是首個實現無限、實時視頻生成且零延遲的系統。這是在屏幕上看魔法和親自制造魔法之間的區別。" —— DecartAI團隊

技術層面的兩大突破

為什么以前的AI視頻工具做不到這一點?主要有兩個技術難題:

第一個難題:錯誤累積

傳統的自回歸視頻生成模型有個致命問題:每一幀都依賴于前一幀,小的錯誤會逐漸累積,最終導致畫面完全崩壞。就像傳話游戲一樣,傳到最后往往面目全非。

DecartAI通過兩個技術解決了這個問題:

? Diffusion Forcing - 對每一幀獨立加噪聲,讓模型學會在不依賴完整視頻上下文的情況下清理圖像。

? History Augmentation - 在訓練時故意給模型展示損壞的歷史幀,讓它學會識別和糾正常見錯誤。

第二個難題:延遲優化

要實現真正的實時生成,每一幀必須在40毫秒內完成。這對GPU的計算能力提出了極高要求。

DecartAI的解決方案包括:

? 定制CUDA內核 - 專門為英偉達Hopper GPU架構優化的代碼

? 架構感知剪枝 - 去除模型中不必要的參數,同時保持輸出質量

? 捷徑蒸餾 - 訓練小模型來復制大模型的結果

這技術能用來干什么?

實時AI視頻轉換開啟了很多之前不可能的應用場景:

- 直播和視頻通話:你可以在視頻會議中實時變換背景和風格,把普通的Zoom會議變成科幻電影場景。

- 游戲和娛樂:想象一下,你揮舞一根木棍,AI實時把它變成光劍。這種即時反饋的體驗是傳統技術無法提供的。

- 內容創作:對于YouTuber和直播主來說,這意味著可以實時創造出更有趣的內容,而不需要復雜的后期制作。

我特別看好的是教育領域的應用。想象一下歷史課上,老師可以實時把自己"變"成拿破侖,或者在講物理時讓學生看到分子的實時運動。

不過也有局限性

當然,MirageLSD目前還不完美。

首先是記憶窗口有限。模型只能"記住"最近幾幀的內容,這意味著在長時間的視頻流中,一致性可能會降低。

其次是控制精度的問題。雖然你可以通過文字描述來引導風格轉換,但要精確控制特定物體或區域的變化還比較困難。

還有就是在極端風格轉換時,偶爾會出現物體結構扭曲的情況。不過DecartAI說他們正在解決這些問題,今年夏天會定期發布更新。

這意味著什么?

MirageLSD的出現標志著AI視頻生成進入了一個新階段。從之前的"離線生成"模式轉向"實時交互"模式,這不僅僅是技術上的進步,更是用戶體驗的根本性改變。

想想看,當AI可以實時響應你的每一個動作和想法時,創作的過程就變得更加自然和直觀。你不再需要預先計劃每一個鏡頭,而是可以像演員一樣即興表演,讓AI成為你的實時特效師。

不過話說回來,技術再先進,最終還是要看能否真正解決用戶的實際需求。MirageLSD目前還處于早期階段,真正的價值還需要時間來驗證。

如果你也對這個技術感興趣,可以去他們的網站 mirage.decart.ai 試試,據說iOS和Android應用下周就會上線。

至少從技術角度來說,AI視頻的"等等黨"時代可能真的要結束了。