AREAL 開源:解耦架構與創新算法驅動的強化學習系統

大家好,我是肆〇柒。推理能力在當下 AI 領域,尤其自然語言處理、智能決策系統、科學研究輔助等眾多關鍵領域,已然成為推動技術革新的關鍵要素。然而,目前大型語言模型雖已取得矚目成果,但在處理復雜邏輯時,常受困于邏輯連貫性把控,長鏈推理面臨信息丟失、邏輯斷裂問題,長序列輸出任務下推理耗時久、資源消耗大,這些痛點嚴重制約模型應用場景拓展與性能深化。

現有強化學習(RL)系統在提升模型推理能力方面也遇到發展瓶頸。同步強化學習系統在訓練過程中,GPU 利用率低、可擴展性差等問題凸顯。以同步 RL 系統處理長序列輸出為例,系統需等待批次中最長序列完成才開啟訓練,因序列長度差異大,GPU 等待時間漫長,運算資源閑置浪費嚴重。不僅如此,隨著模型規模擴大、序列長度增加,同步系統擴展性不足,訓練效率直線下滑。這些難題倒逼業界尋求創新解決方案,由清華大學與螞蟻研究院聯合研發的 AREAL 系統被提出并開源。AREAL 作為全新完全異步大型強化學習系統,憑借獨特架構與創新算法,實現訓練效率和模型性能的跨越式提升。

以 AIME24 基準測試為例,1.5B 模型和 7B 模型訓練中,推理設備因等待時間過長,訓練效率備受打擊。同步系統執行時,長序列輸出需全部完成才進入下一步,設備空轉、運算停滯,極大拖延訓練進程。AREAL 在此做了優化,直擊同步系統要害,以創新異步架構重塑強化學習訓練流程。其核心在于完全解耦生成與訓練環節,生成過程不受訓練等待限制,訓練流程即時響應生成數據,高效利用每一秒運算時間,打破同步系統枷鎖,為模型推理訓練鋪就高速通道。本文將介紹 AREAL 的優勢、架構、算法革新及實驗成果。一起了解一下吧。

AREAL 的系統架構

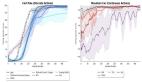

AREAL 的系統架構是其高效運行的核心基礎,通過精心設計的四大核心組件——可中斷的 Rollout Worker、獎勵服務、Trainer Worker 和 rollout 控制器,實現了完全異步的強化學習訓練流程。下圖展示了同步 RL 系統和單步重疊 RL 系統的執行時間線,突出同步系統中推理設備的低效利用問題。

同步(上)和單步重疊(下)強化學習系統的執行時間線,展示了未充分利用的推理設備

1. 可中斷的 Rollout Worker

Rollout Worker是 AREAL 系統中負責生成數據的關鍵組件。它主要處理兩類請求:生成請求和更新權重請求。在生成請求中,Rollout Worker根據當前模型的參數,為給定的提示(prompt)生成響應。這一過程是連續的,每個Rollout Worker獨立運行,無需等待其他組件完成任務,從而最大化 GPU 的利用率。

當系統需要更新模型參數時,Rollout Worker會收到更新權重請求。此時,Rollout Worker會立即中斷當前正在進行的生成任務,丟棄舊參數計算的 KV 緩存,并重新加載新的模型參數。加載完成后,Rollout Worker會繼續從上次中斷的地方開始生成剩余的序列。這一過程不僅確保了生成數據的實時性,還通過緩沖機制保持了訓練批次的大小一致,從而維持了 PPO 算法的穩定性。

2. 獎勵服務

獎勵服務是 AREAL 系統中負責評估生成數據質量的組件。它接收 Rollout Worker生成的響應,并根據預定義的獎勵函數計算每個響應的獎勵值。例如,在代碼生成任務中,獎勵服務會提取生成的代碼片段,運行單元測試,并根據代碼的執行結果和規范性給出獎勵分數。在數學推理任務中,獎勵服務會驗證生成的答案是否正確,并據此給出獎勵。

獎勵服務的高效性對于整個系統的性能至關重要。AREAL 通過將獎勵計算與 GPU 計算分離,并利用多線程和異步編程技術,確保獎勵計算不會成為系統的瓶頸。這種設計使得獎勵服務能夠快速響應,及時將獎勵信息反饋給Trainer Worker ,從而加速整個訓練流程。

3. Trainer Worker

Trainer Worker 是 AREAL 系統中負責模型更新的核心組件。它們從回放緩沖區(replay buffer)中采樣數據,當數據量達到配置的批次大小時,Trainer Worker 會執行 PPO 更新,并將更新后的模型參數存儲到分布式存儲中。Trainer Worker 的高效運行依賴于多個關鍵設計:

- 動態批處理策略:Trainer Worker 采用動態批處理策略來處理可變長度的輸出序列。該策略根據序列長度對數據進行排序,并將長度相近的序列分配到同一個微批次中,從而最大化 GPU 內存的利用率。通過減少不必要的填充操作,Trainer Worker 能夠顯著提高訓練吞吐量。

- 并行更新:Trainer Worker 可以并行運行多個更新任務,充分利用多 GPU 的計算能力。這種并行化設計進一步提升了系統的整體性能。

4. Rollout 控制器

Rollout 控制器是 AREAL 系統中負責協調各組件的關鍵組件。它在數據集、Rollout Worker、獎勵服務和Trainer Worker 之間起到橋梁的作用。在訓練過程中,rollout 控制器從數據集中讀取數據,并向 Rollout Worker 發送生成請求。Rollout Worker生成的響應會被發送到獎勵服務進行評估,評估結果(即獎勵值)和生成的軌跡一起存儲在回放緩沖區中。當Trainer Worker 完成模型更新后,rollout 控制器會通知 Rollout Worker 更新權重。

Rollout 控制器的高效協調能力是實現異步訓練的關鍵。它通過精確控制數據的流動和任務的調度,確保生成和訓練過程能夠無縫銜接。此外,rollout 控制器還負責監控系統的整體狀態,及時調整任務分配策略,以應對不同任務和模型規模的需求。下圖展示了 AREAL 的架構,包括異步生成和訓練組件。

具有異步生成和訓練組件的AREAL架構

異步訓練流程

AREAL 的異步訓練流程是其區別于傳統同步 RL 系統的核心特征。在同步 RL 系統中,生成和訓練是嚴格交替進行的,生成步驟必須等待批次中最長的序列完成才能開始訓練,這導致了 GPU 的大量閑置時間。而 AREAL 完全解耦了生成和訓練過程,Rollout Worker 和 Trainer Worker 可以獨立運行,互不等待。

- 生成過程:Rollout Worker以流式的方式持續生成新的輸出,無需等待其他工作者完成任務。這種設計使得 GPU 能夠始終保持高利用率,顯著提高了系統的整體效率。

- 訓練過程:Trainer Worker 在獲得一批數據后立即開始更新模型,無需等待生成過程完成。更新完成后,模型參數會同步到所有 Rollout Worker,確保生成數據始終基于最新的模型版本。

通過這種異步設計,AREAL 不僅解決了同步系統中 GPU 利用率低的問題,還實現了高效的分布式訓練,能夠輕松擴展到數千個 GPU。這種架構為大規模強化學習訓練提供了強大的支持,使得 AREAL 能夠在復雜的推理任務中展現出卓越的性能。下圖演示了 AREAL 的生成管理,包括訓練就緒時間和新參數到達時的中斷請求。

在 AREAL 中的生成管理示意圖。垂直線表示下一步訓練的準備就緒時間。藍色叉號表示在新參數到達時被中斷的請求

AREAL 的系統優化

AREAL 通過一系列系統級優化措施,顯著提升了異步強化學習訓練的效率和穩定性。這些優化策略涵蓋了從硬件資源管理到數據處理的各個環節,為高效的模型訓練提供了堅實基礎。

1. GPU 與 CPU 資源分離

AREAL 將 GPU 計算與 CPU 操作分離,避免了兩者之間的相互干擾,提升了整體運算效率。系統將規則化獎勵計算及基于 TCP 的數據傳輸等操作分配給 CPU 執行,而將復雜的神經網絡計算任務留給 GPU。通過在不同線程中獨立運行這些任務,并利用流水線技術將它們有機結合起來,AREAL 實現了獎勵計算和數據傳輸與后續生成請求的并行處理,充分利用了多核 CPU 和 GPU 的并行計算能力,從而顯著提高了系統的吞吐量。

2. 可中斷的 Rollout Worker

可中斷的 Rollout Worker是 AREAL 系統中實現高效訓練的關鍵機制之一。在傳統的同步 RL 系統中,生成任務必須等待當前批次中最長的序列完成才能進行下一步操作,這導致了 GPU 的大量閑置時間。而 AREAL 的 Rollout Worker 能夠在接收到更新權重的信號時,立即中斷當前正在進行的生成任務,丟棄舊參數計算的 KV 緩存,并重新加載新的模型參數。加載完成后,Rollout Worker 會從上次中斷的地方繼續生成剩余的序列。這一過程不僅確保了生成數據的實時性,還通過緩沖機制保持了訓練批次的大小一致,從而維持了 PPO 算法的穩定性。這種可中斷的機制使得 Rollout Worker 能夠快速響應模型參數的更新,避免了因等待長序列完成而導致的資源浪費,顯著提高了 GPU 的利用率和訓練效率。通過以下圖表可以更直觀地了解可中斷生成對系統性能的影響:

可中斷的 Rollout 消融研究

3. 動態批處理策略

AREAL 采用了動態批處理策略來處理可變長度的輸出序列,這一策略在固定內存約束下實現了對 token 分布的優化平衡。系統會根據序列長度對數據進行排序,然后將長度相近的序列分配到同一個微批次中,從而最大化 GPU 內存的利用率。通過減少不必要的填充操作,AREAL 能夠顯著提高訓練吞吐量。此外,動態批處理策略還能夠根據當前可用的 GPU 內存動態調整微批次的大小,確保在不同模型規模和序列長度下都能充分利用 GPU 資源。這種靈活的批處理方式不僅提高了內存利用率,還減少了前向 - 后向傳遞的次數,進一步提升了訓練效率。動態微批分配策略對系統吞吐量的提升效果顯著,下圖展示了相關的消融研究結果:

動態微批次分配的消融研究

4. 并行獎勵服務

為了進一步提升系統的效率,AREAL 引入了并行獎勵服務。在傳統的 RL 系統中,獎勵計算通常是串行進行的,這成為了系統的性能瓶頸之一。AREAL 通過將獎勵計算任務分配給多個并行的獎勵服務進程,實現了對獎勵計算的并行化處理。每個獎勵服務進程獨立地對生成的響應進行評估,并計算相應的獎勵值。這種并行化的獎勵服務不僅提高了獎勵計算的速度,還能夠更好地利用多核 CPU 的計算能力,從而進一步加快了整個訓練流程。

5. 異步通信機制

AREAL 采用了高效的異步通信機制,確保了系統各組件之間的快速數據傳輸和同步。在異步訓練過程中,生成的數據需要及時傳遞給Trainer Worker 進行模型更新,而更新后的模型參數也需要迅速同步到 Rollout Worker,以便生成新的數據。AREAL 通過使用消息隊列和異步通信協議,實現了數據的快速傳遞和組件之間的無縫銜接。這種異步通信機制不僅減少了數據傳輸的延遲,還提高了系統的整體吞吐量,使得 AREAL 能夠在大規模分布式訓練環境中高效運行。

6. 資源調度與負載均衡

AREAL 還在資源調度和負載均衡方面進行了優化。系統能夠根據當前的任務需求和資源使用情況,動態調整各組件的資源分配。例如,在生成任務較重時,系統會優先分配更多的 GPU 資源給 Rollout Worker;而在訓練任務較重時,則會將更多的資源分配給Trainer Worker 。此外,AREAL 還通過負載均衡算法,確保了各個 GPU 和 CPU 核心之間的負載均衡,避免了部分資源過載而其他資源閑置的情況。這種動態的資源調度和負載均衡策略,使得 AREAL 能夠在不同的訓練階段和任務場景下,始終保持高效的資源利用率和穩定的訓練性能。

通過以上一系列系統級優化措施,AREAL 在硬件資源利用、數據處理效率和訓練穩定性等方面都取得了顯著的提升。這些優化策略不僅為 AREAL 的高效異步訓練提供了有力支持,也為其他大規模強化學習系統的開發提供了寶貴的參考。

AREAL 的算法創新

AREAL 的算法創新是其高效異步訓練的核心驅動力,主要體現在對數據陳舊性問題的應對策略以及解耦的 PPO 目標函數的提出。下圖演示了 PPO 的解耦目標和陳舊性控制的消融研究,展示了算法選擇對訓練結果的影響。

對分離的PPO目標和陳舊性控制進行了消融研究。這兩種算法選擇都至關重要。在采用適中的陳舊性值和分離目標的情況下,訓練進度可以加快2倍以上,同時保持最終評估性能不變

數據陳舊性問題與解決方案

在異步強化學習系統中,數據陳舊性是一個關鍵挑戰。由于生成和訓練過程完全解耦,訓練批次中可能包含由不同版本策略生成的數據。這種陳舊性可能導致訓練數據的策略分布與當前最新策略產生偏差,從而影響學習性能。AREAL 通過引入最大允許陳舊度 η 這一超參數,對策略版本差異進行嚴格限制。具體而言,假設當前最新參數版本為 i,系統共生成了 Nr 條軌跡,訓練批次大小為 B,則要求 ?Nr/B? ≤ i + η。系統實時追蹤 Nr 和參數版本 i,一旦發現請求違反陳舊度約束,即刻予以拒絕。這種機制確保了訓練數據的新鮮度,避免了因數據過時而導致的性能下降。

解耦的 PPO 目標函數

為適應異步 RL 訓練環境,AREAL 對傳統的 PPO 算法進行了創新性的改進,提出了解耦的 PPO 目標函數。在標準 PPO 中,所有采樣數據必須來源于單一的行為策略 πold,模型更新圍繞此單一策略展開。而 AREAL 大膽地將行為策略 πbehav 和近端策略 πprox 分離。行為策略負責生成訓練數據,而近端策略則作為模型更新的參照標桿。通過重要性采樣,解耦后的 PPO 目標函數能夠有效地利用不同策略版本生成的數據,使模型更新始終在近端策略構筑的信賴區域內穩步邁進。

解耦的 PPO 目標函數通過引入近端策略 πprox,將原始 PPO 的優化目標分解為兩個部分:一部分是基于行為策略 πbehav 的重要性采樣,另一部分是基于近端策略 πprox 的信任區域約束。這種分解不僅提高了模型更新的穩定性,還允許在異步環境中有效地利用陳舊數據。數學上,解耦后的 PPO 目標函數可以表示為:

其中,πprox 表示近端策略,用于計算重要性采樣比率;πbehav 是行為策略,用于生成訓練數據。這種設計使得 AREAL 能夠在異步環境中,即使數據存在一定陳舊性,也能保持訓練的穩定性和有效性。

算法優勢與實驗驗證

解耦的 PPO 目標函數在處理異步數據時展現出了顯著的優勢。實驗對比表明,在不同陳舊度情況下,解耦 PPO 能夠維持訓練的穩定性,并顯著提升模型的最終性能。例如,在數學推理任務中,當數據陳舊度 η 設置為 4 時,模型的最終準確率僅比零陳舊度 oracle 模型低 1%,但訓練速度卻提升了 2 倍以上。這表明解耦 PPO 目標函數能夠在保證模型性能的同時,大幅提高訓練效率。此外,通過消融實驗進一步驗證了解耦 PPO 目標函數和陳舊度控制的有效性。開啟解耦 PPO 后,訓練曲線更加平穩,最終性能顯著提升;適當設置最大允許陳舊度 η 值,在 η=4 時,模型在多個數學推理基準測試中性能近乎與零陳舊度 oracle 相當,卻換來成倍訓練加速。這些實驗結果有力地支持了解耦 PPO 與陳舊度控制對于異步訓練的關鍵價值。

下表對比了不同數據陳舊度下的評估分數,展示了有無解耦目標函數的影響。

在數據陳舊性變化時的評估分數,比較了有無解耦目標時的性能表現。與最佳分數相差在±1以內的數值已用下劃線標出

AREAL 與其他現有異步 RL 系統的對比

系統架構維度,AREAL 的完全解耦生成與訓練架構,賦予其硬件資源利用與擴展性的卓越基因。對比之下,其他系統模塊間緊密耦合,難以解鎖硬件性能全部潛能。

算法原理上,解耦的 PPO 目標函數是 AREAL 的殺手锏。它在異步數據處理及陳舊性應對方面技高一籌,相較于其他系統算法,AREAL 的模型更新更精準、高效,如同在復雜路況中仍能保持穩定高速的賽車,輕松跨越數據陳舊性障礙,持續輸出優異性能。

數據處理方式對比,AREAL 的高效性與靈活性讓人印象深刻。它創新的數據管理策略,面對異步訓練挑戰,總能游刃有余。而其他系統在數據收集、篩選等環節,要么動作遲緩,要么僵化死板,難以適配瞬息萬變的訓練需求。

性能表現層面,實驗數據顯示訓練速度、準確率、可擴展性指標上,AREAL 憑借線性擴展趨勢、卓越長序列生成訓練表現,遙遙領先同步系統與競品異步系統。當其他系統在 GPU 數量增加時遇到瓶頸,而 AREAL 的訓練吞吐量節節攀升,尤其在長序列生成訓練場景中,線性擴展優勢尤為明顯。

下圖展示了 AREAL 與其他系統的強擴展趨勢對比,凸顯 AREAL 的線性擴展優勢。

虛線表示理想的線性擴展。Verl在32k上下文長度和32B模型下持續遇到內存不足(OOM)問題,因此缺少數據點

AREAL 的實驗評估

AREAL 的實驗評估較為全面且深入,目的是全方位驗證系統的性能和優勢。實驗設置嚴謹,選用的模型涵蓋從 1.5B 到 32B 參數規模,任務類型包括數學推理與代碼生成,基準測試選取 AIME24、LiveCodeBench 等權威標準,訓練步驟和評估協議規范且詳細,計算資源為 64 節點、每節點 8 GPU 的 H800 GPU 集群,為實驗提供了堅實的硬件基礎。實驗所采用的訓練配置和超參數如下表所示:

訓練配置和超參數

端到端比較

端到端比較環節,AREAL 的表現令人矚目。在數學推理任務中,以 1.5B 模型為例,與同步系統相比,AREAL 的訓練吞吐量提升高達 2.57 倍。模型在 AIME24 基準測試中的準確率從同步系統的 42.0% 提升至 42.2%,訓練時長從 41.0 小時大幅縮短至 14.8 小時。對于 7B 模型,準確率從 63.0% 略升至 63.1%,訓練時長則從 57.7 小時縮減至 25.4 小時。在代碼生成任務中,14B 模型在 LiveCodeBench 基準測試中的準確率從同步系統的 56.7% 提升至 58.1%,訓練時長從 48.8 小時降至 21.9 小時。32B 模型同樣展現出顯著的性能提升。這些詳實的數據充分展示了 AREAL 在提高訓練效率和模型性能方面的卓越能力。

下表展示了端到端性能比較,包括數學和代碼任務的準確率和訓練時間。

端到端性能對比。在AIME24數學基準測試和LiveCodeBench(2024年8月1日至2025年2月1日)編程基準測試上進行評估。將最大生成長度限制為32K token,并針對每個問題采樣32個回答,報告平均通過率@1的準確率。*表示通過強化學習獲得的最佳已知可復現結果,分別引用自DeepScaler 和DeepCoder。AReaL在訓練時間少2倍的情況下,實現了相當的性能表現

可擴展性測試

可擴展性測試中,AREAL 隨著 GPU 數量的增加,訓練吞吐量展現出近乎理想的線性增長趨勢。以 1.5B 模型、16k 上下文長度為例,對比 verl 系統,AREAL 在 32 GPU 時的吞吐量達到 29k token/s,是 verl 的 1.5 倍;在 64 GPU 時,吞吐量更是高達 41k token/s,遠超 verl。而 verl 在 GPU 數量增加時吞吐量增速緩慢,AREAL 的線性擴展優勢十分明顯。尤其在長序列生成訓練場景中,這種優勢更為突出,這得益于 AREAL 完全解耦生成和訓練過程的設計,使其能夠高效地利用更多的 GPU 資源。

算法消融研究

算法消融研究進一步驗證了 AREAL 算法創新的有效性。實驗對比了開啟和關閉解耦 PPO 目標函數以及不同最大允許陳舊度 η 值下的訓練結果。結果顯示,開啟解耦 PPO 目標函數后,訓練曲線更加平穩,最終性能顯著提升。在適當設置 η 值的情況下,例如 η=4 時,模型在多個數學推理基準測試中的性能近乎與零陳舊度 oracle 相當,但訓練速度卻提升了 2 倍以上。這有力地證明了解耦 PPO 目標函數和陳舊度控制對于異步訓練的關鍵價值,表明這兩種機制能夠有效地應對異步環境中的數據陳舊性問題,加速訓練過程的同時保持模型性能的穩定。

實驗挑戰與解決方案

在實驗過程中,AREAL 團隊也遇到了一些挑戰。例如,在數據收集和預處理階段,如何確保數據的質量和多樣性是一個難題。團隊通過制定嚴格的數據清洗、標注和篩選流程,確保了數據集的可靠性和適用性。在模型訓練過程中,超參數的調整也是一個關鍵問題。團隊通過大量的實驗和經驗積累,確定了合適的學習率、折扣因子、批量大小等超參數,以優化模型的訓練效果。此外,團隊還開發了一系列工具和方法來監控和調試訓練過程,以便及時發現和解決問題。

綜上所述,AREAL 的實驗評估驗證了系統的高效性和優越性,同時也展示了其在實際應用中的可靠性和穩定性。通過端到端比較、可擴展性測試和算法消融研究等多個維度的實驗,AREAL 證明了其在大規模強化學習訓練中的強大能力和廣闊應用前景。

AREAL 的開源與應用

AREAL 的開源舉措是要點贊的,其開放性體現在多個維度。項目不僅公開訓練細節、數據集和基礎設施配置,還提供詳盡的代碼和配置示例,助力研究者與開發者快速上手。新手開發者可直接利用這些資源,從編寫訓練腳本到調整超參數,再到環境部署與多機多卡訓練擴展。

開源倉庫介紹

AREAL 的開源倉庫(見參考資料)是開發者實踐和探索的寶貴資源。倉庫精心組織,包含以下核心模塊:

- core:系統核心組件的實現代碼,包括可中斷的 Rollout Worker、獎勵服務、Trainer Worker 和 rollout 控制器。

- algorithms:包含解耦的 PPO 算法及其他 RL 算法的實現。

- utils:提供系統運行所需的工具函數,如動態批處理、異步通信等。

- examples:提供多個示例腳本,展示如何使用 AREAL 進行不同任務的訓練和評估。

倉庫還提供詳細的文檔和教程,指導開發者快速入門。例如,通過以下命令即可在本地訓練 Qwen3 1.7B 模型:

sh examples/run_async_ppo.sh評估模型的命令如下:

cd evaluation

python eval_and_aggregate.py \

--model_path ${MODEL_PATH} \

--output_path ${OUTPUT_PATH} \

--data_names aime24,aime25 \

--max_gen_tokens 32768 \

--data_names codeforces,lcb_v5 \

--prompt_type qwen3-think-pure \

--temperature 1.0這些腳本和命令為開發者提供了便捷的操作指南,使其能夠迅速開展實驗。

應用場景拓展

AREAL 的應用不僅限于數學推理和代碼生成,還可拓展至邏輯謎題、科學問題解決等更多推理任務領域。以邏輯謎題為例,開發者可設計相應的獎勵函數,將謎題解決步驟轉化為可量化獎勵信號,引導模型逐步探索解空間。同時,定制環境設置,模擬謎題操作界面,讓模型實時交互試錯。盡管任務數據稀缺性和模型結構適配性等挑戰接踵而至,但 AREAL 憑借異步訓練機制,靈活調整采樣策略與模型架構,仍能輸出令人滿意的推理成果。

在科學問題解決任務中,AREAL 能高效處理復雜科學數據集。多元特征與長序列模型訓練難題也被異步架構輕松化解。開發者可利用 AREAL 的異步訓練機制,高效處理科學數據,提升模型在科學問題解決任務中的表現。

總結

當我讀完 AREAL 相關論文材料,我對這款大型語言模型高效推理的強化學習系統,有了一定理解。AREAL 異步架構和創新算法為模型推理訓練提供了全新思路。從架構系統來看,AREAL 通過將生成與訓練完全解耦,讓 Rollout Worker 和 Trainer Worker 能夠獨立運行,避免了同步系統中因等待長序列完成而導致的資源浪費。這種設計顯著提高了 GPU 的利用率,使得訓練過程更加高效。同時,系統各組件的協調工作,如可中斷的Rollout Worker能夠及時響應模型參數更新,獎勵服務高效評估生成數據質量等,都為整個系統的高效運行提供了有力支撐。

在算法層面,AREAL 針對異步強化學習中的數據陳舊性問題提出了有效解決方案。通過限制策略版本差異和采用解耦的 PPO 目標函數,AREAL 使模型更新能夠在高質量近端策略的信賴區域內進行,從而穩定訓練過程。這一創新不僅巧妙化解了異步系統中數據陳舊性的難題,還體現了研究者對 RL 算法本質的深刻認識。系統優化措施也給我留下了深刻印象。動態批處理策略、可中斷的 Rollout Worker等設計,處處體現出對計算資源的極致追求。

AREAL 的開源舉措非常棒。它不僅公開了訓練細節、數據集和基礎設施配置,還提供了詳盡的代碼和配置示例,為研究者和開發者提供了寶貴的資源。這種開放共享的科研精神有助于加速整個行業的發展,讓更多人有機會在這一領域進行探索和創新。

總體而言,AREAL 這個框架大型語言模型強化學習帶來了顯著進步。其異步訓練架構、系統優化措施和算法改進等方面都展現出強大的優勢。當然,AREAL 仍有很大的發展空間,如進一步優化推理和訓練設備的比例、探索多輪交互和智能體場景的應用等。