OpenAI科學家:現有模型+后訓練足以產生黎曼猜想的新證明

一個全新的模型能力衡量指標誕生了?!

OpenAI科學家塞巴斯蒂安?布貝克(Sebastien Bubeck)(下圖左)表示:

AI模型的能力可以用AGI時間來衡量:

GPT-4可以完成人類需要幾秒或幾分鐘的任務;o1 可以完成人類需要若干小時完成的任務,也就是可以用“AGI小時”衡量的任務;明年,模型可能會實現AGI日,并在3年后實現AGI周,能夠解決重大的開放問題。

看到AGI時間這個新概念,網友們也是立即就展開了熱烈的討論。

有人認為,如果模型可以達到人類需要數周或數月才能完成的任務,也就代表它可以將長期推理和計劃結合起來,也就和真正的AGI差不多了:

不過也有人表示這個說法有點模糊,人腦也很難機械地把任務完成時間限定為幾個月、幾年:

而反方辯手湯姆·麥考伊(Tom Mccoy)則對LLM能否解決復雜的開放性問題持懷疑態度。

他表示,語言模型雖令人驚嘆,但能力源于訓練數據,目前沒有證據顯示它們可以產生能解決開放問題的新范式。

讓兩位大佬爭論不休的問題,就是最近由世界知名理論計算機科學機構Simons Institute提出的辯題:

當前基于縮放定律的LLM,能否在未來幾年內產生可以解決重大數學難題(如P≠NP、黎曼假設)的證明技術。

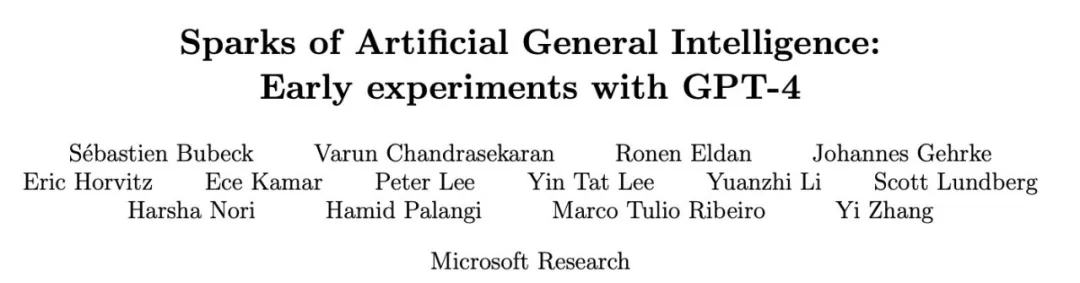

持正方觀點的塞巴斯蒂安?布貝克是應用數學博士,曾在普林斯頓大學擔任助理教授,后在微軟研究院任職十年,主導開發了 Phi 系列小語言模型,也是Sparks of AGI(AGI的火花)論文的重要作者之一。

此次辯論中,塞巴斯蒂表示他堅信LLM潛力無限,認為以當前模型的能力加上更多的數據和后期訓練就足以解決數學難題。

反方辯手湯姆是認知科學博士,現任耶魯大學語言學助理教授,

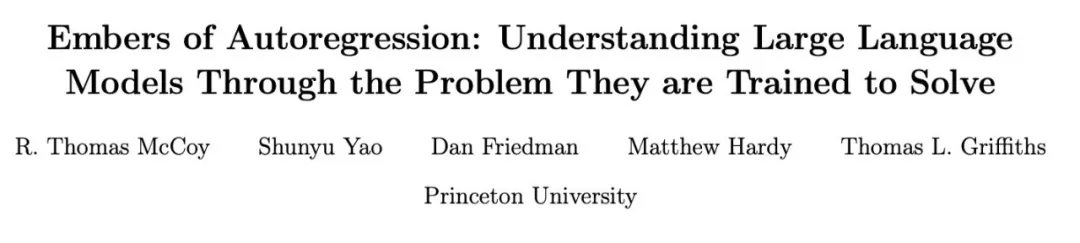

他也是“Embers of Autoregression(自回歸余燼)”論文的主要作者,文中他深刻剖析了當前LLM的局限性。

同時參與這次討論的還有Anthropic的研究員Pavel Izmailov,和MIT諾伯特·維納(Norbert Wiener)數學教授Ankur Moitra。

在不改變原意的基礎上,量子位對本次辯論的主要觀點進行了梳理總結,希望能帶給你更多的啟發和思考。

正方:o1已展現出自發的涌現模式

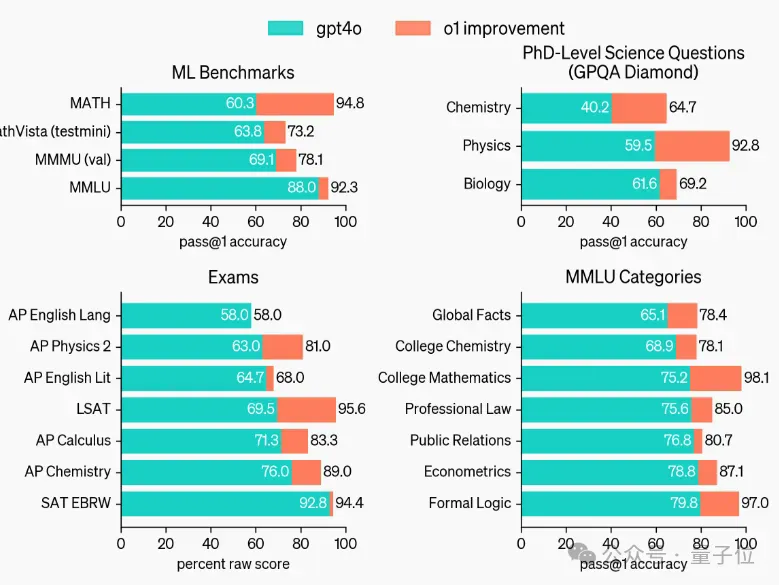

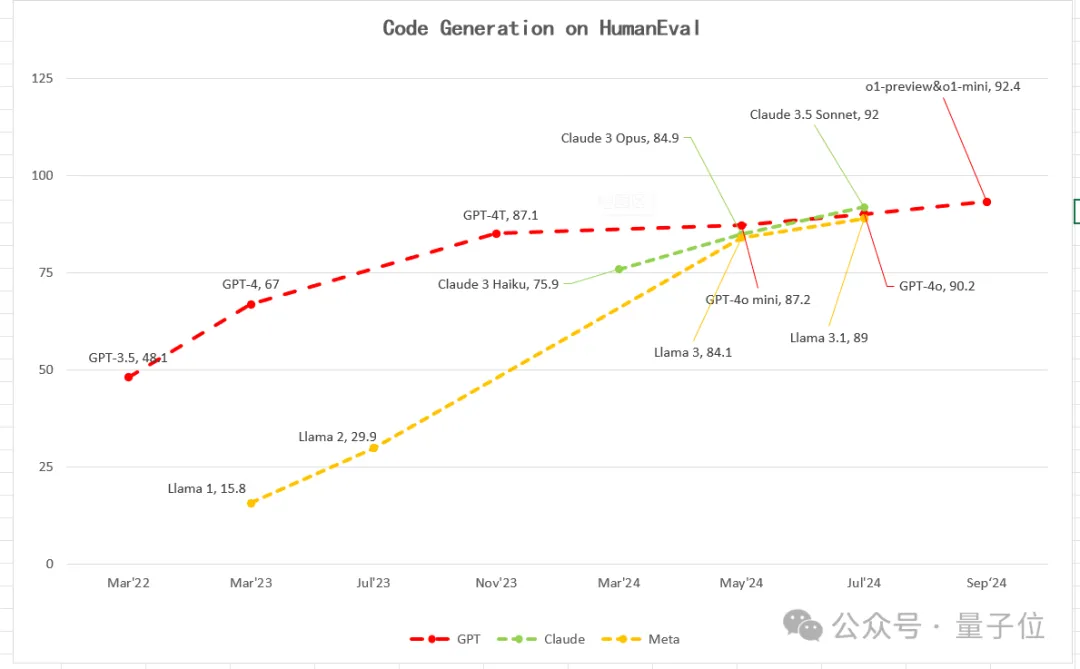

塞巴斯蒂安首先用數據回顧了LLM最近幾年的發展歷程,他表示GPT系列已在多領域的基準測試上都表現亮眼。

比如在MMLU測試中,GPT-4 成績飆升至 86%,o1 模型更是逼近 95%,遠超 GPT-3 的 50%,在高中科學知識問答方面已接近人類 90% 的水平。

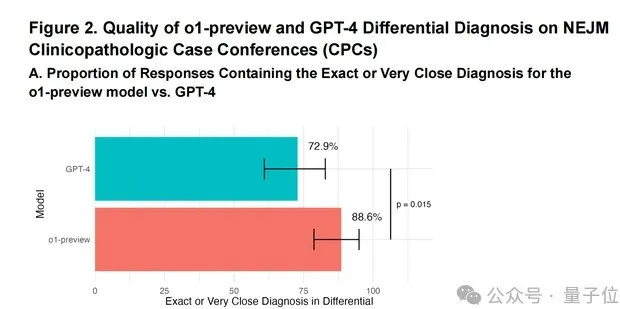

在醫學診斷領域,GPT-4 準確率高達 90%,遠超人類醫生的 75%,有力證明了模型強大的學習與應用能力,且這種提升趨勢為解決數學難題奠定基礎。

△圖片來自論文Superhuman performance of a large language model on the reasoning tasks of a physician

他進一步指出:

智能發展層級遞進顯著,GPT-4只有AGI秒級思考能力,而o1模型已達AGI分鐘甚至小時級別。

依此趨勢,未來實現AGI日級、周級思考時長指日可待,可能明年、后年就能達到。

屆時,模型將擁有充足時間和能力深入思考復雜數學問題,從而找到解決重大猜想的路徑。

同時他還強調了后訓練技術的重要性:后訓練技術是挖掘模型深層潛力的關鍵。

從GPT-3.5開始,模型就可以實現在后訓練過程中提取智能。到了o1模型時代,其采用的強化學習等創新訓練范式,使模型在復雜任務(比如編程、數學)處理上實現質的飛躍。

尤其是在特定數學問題中,o1能迅速關聯看似不相關的知識概念,自發地涌現出一些新的思路,為解決難題提供新線索。

反方:當前縮放定律依賴數據、存在幻覺,難以產生新思考模式

湯姆則認為,目前LLM的發展存在3個明顯制約:

1.LLM受訓練數據頻率限制嚴重:

在單詞計數和排序任務中,數據頻率影響清晰可見。如統計單詞數量時,對常見長度列表準確率高,罕見長度則大幅下降;排序任務中,對常用的字母正序處理良好,逆序則表現不佳。

這表明模型在面對新證明技術這類低頻任務時,缺乏創造性突破的根基,難以跳出訓練數據的固有模式。

而且,根據各種測評數據,模型能力與數據量級呈對數關系,未來想要提升模型能力需要新的指數級數據,而目前已有嚴重數據瓶頸,在未來幾年很難迅速突破。

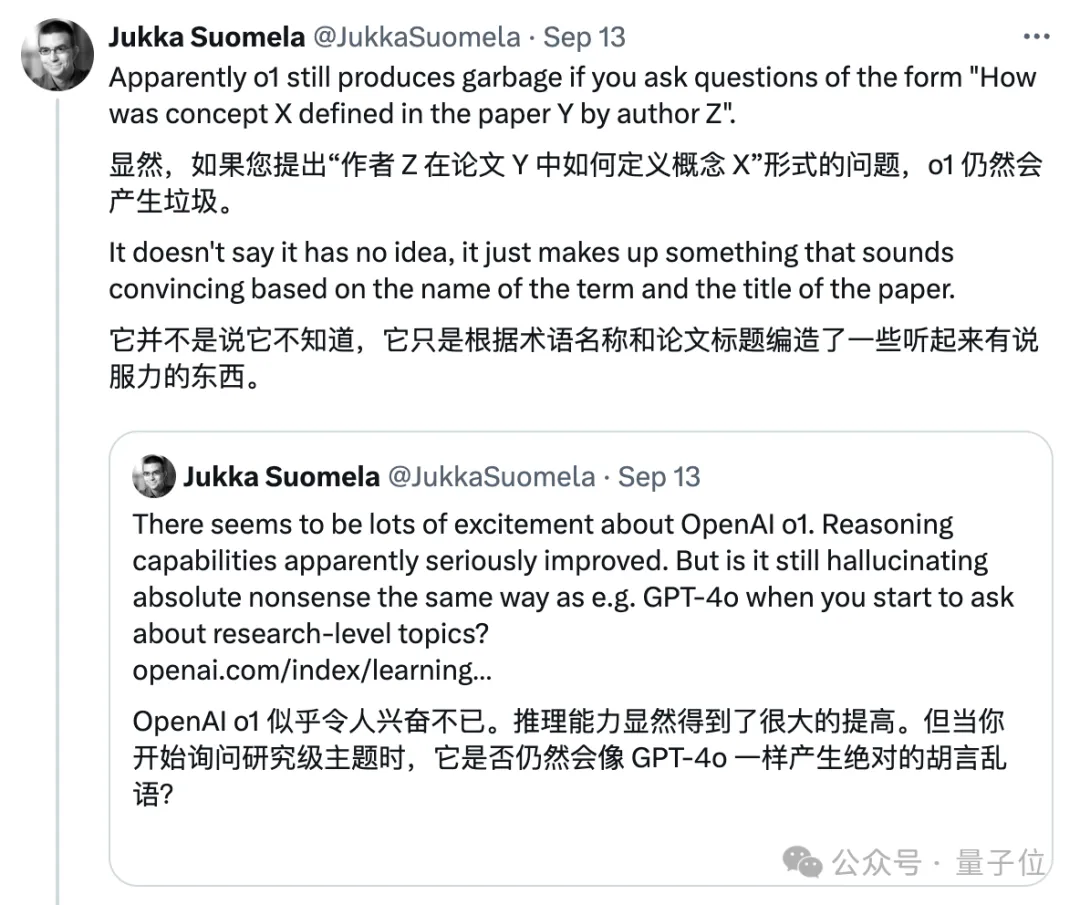

2.長推理過程中的幻覺問題是致命傷:

即使類o1模型在多步推理場景下進步顯著,但LLM仍易生成錯誤信息。隨著數學證明篇幅拉長,極低的錯誤率也會因累積效應使證明失效。

也就是人們常說的“薄弱環節會破壞整個推理鏈條”,嚴重阻礙模型解決復雜數學證明的能力。

o1已經可以和人類專家合作,但想要獨自解決數學問題,必須做到超越人類,目前看起來比較困難,甚至還無法達到以穩健的方式使用現有想法。

3.當前縮放方法本質缺陷難破:

基于語言預測的訓練模式,使模型在處理數學問題時難以直接觸及深度推理和創新思維核心。

比如在數學符號處理和抽象邏輯推導方面,模型的處理方式與專業數學方法相比缺乏專業推導,需要從底層架構和訓練理念上進行徹底變革。

隨后正方還對反方觀點進行了駁斥。

塞巴斯蒂安表示,當前很多人類的頂級成果是依靠組合現有知識產生的,而模型在這個方面的能力會通過強化學習進一步發展。

而且人類在超過50頁的證明中也經常會出錯,未來可以讓不同的智能體進行合作互相指正,可以有效減少這一方面的失誤。

其他專家:需結合證明驗證器、符號空間探索等方式

Anthropic研究員帕維爾?伊斯梅洛夫也發表了觀點,他認為LLM在識別數據結構上確有優勢,但數學領域專業性強,需借助強化學習與Lean等證明驗證器構建有效訓練機制。

鑒于數學的獨特性,探索類似AlphaGo式的非LLM智能搜索方法在符號空間的應用,或許能為解決數學難題另辟蹊徑,突破語言模型固有局限。

針對觀眾的提問“飛機也不是完全模擬鳥類的飛行,為什么一定要要求LLM模擬人類思維”的問題,帕維爾首先表示贊同,AlphaGo帶給人類的一個驚喜正是來自于它可以用很多人類沒有的方法下棋。

但同時他也指出:

也許以人類的方式做事的唯一理由是,如果我們關心的是試圖理解證明、并提取一些定義之類的東西,那么我們希望它至少是類人或人類可讀的。但我認為如果我們關心的是證明能力,比如能夠證明事物,那么不一定要以類人的方式。

MIT諾伯特·維納數學教授安庫爾?莫伊特拉(Ankur Moitra)也發表了自己的看法。

他也贊同重大數學問題的解決絕非簡單的能力堆疊:

我們關心數學難題,關心的不只是具體的證明細節,更希望可以在證明的過程中產生可以引發數學體系變革的新想法。

他認為當前LLM 雖在部分任務取得進展,但與解決如黎曼假設這類問題所需的深度和創新性仍相距甚遠。

安庫爾還提議,未來模型發展或許應聚焦于知識在模型中的有效表示、數學家與模型間的高效協作模式等關鍵層面,探索新的突破方向。

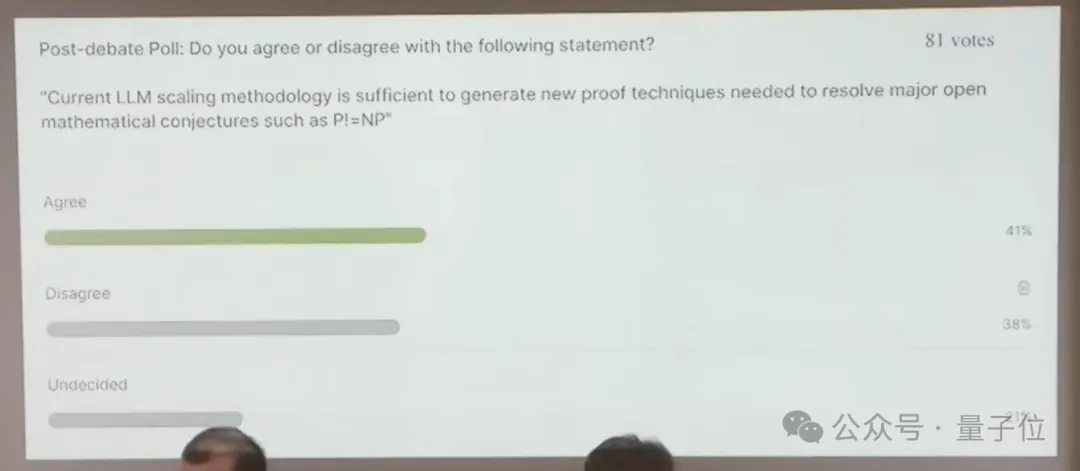

現場還進行了一次不記名投票,可以看到正反方的觀點基本還是持平的~

感興趣的朋友可以查看完整視頻和論文。

參考鏈接:

[1]辯論完整視頻:https://www.youtube.com/live/H3TnTxVKIOQ。

[2]Sebastien Bubeck撰寫的論文Sparks of AGI:https://arxiv.org/abs/2303.12712。

[3]Tom McCoy撰寫的論文Embers of Autoregression:https://arxiv.org/abs/2309.13638。