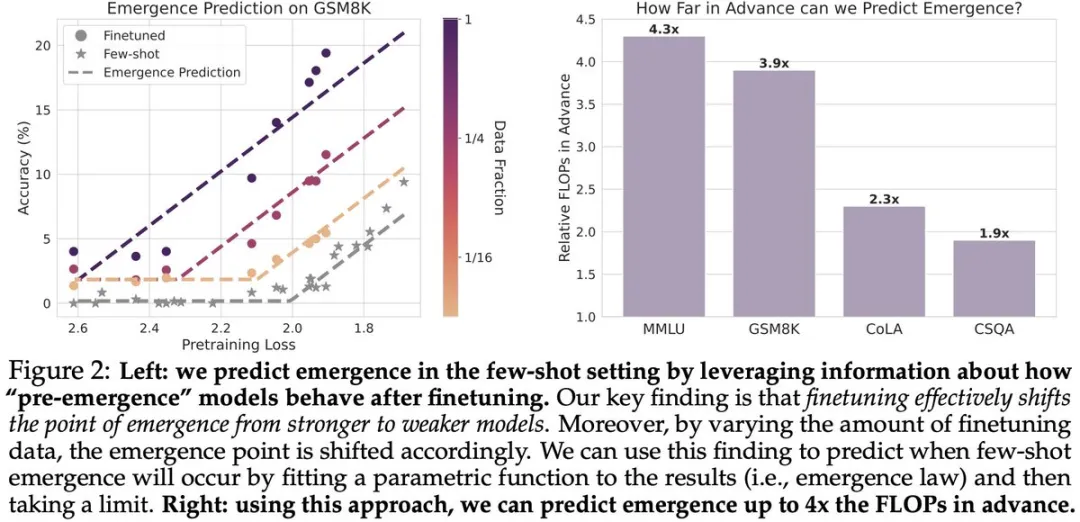

GPT-5涌現(xiàn)能力可預(yù)測(cè)?UC伯克利僅使用當(dāng)前模型檢查點(diǎn)預(yù)測(cè)未來(lái)模型

LLM 規(guī)模擴(kuò)展的一個(gè)根本性挑戰(zhàn)是缺乏對(duì)涌現(xiàn)能力的理解。特別是,語(yǔ)言模型預(yù)訓(xùn)練損失是高度可預(yù)測(cè)的。然而,下游能力的可預(yù)測(cè)性要差得多,有時(shí)甚至?xí)霈F(xiàn)涌現(xiàn)跳躍(emergent jump),這使得預(yù)測(cè)未來(lái)模型的能力變得具有挑戰(zhàn)性。

最近,來(lái)自加州大學(xué)伯克利分校(UC 伯克利)的研究團(tuán)隊(duì)提出涌現(xiàn)預(yù)測(cè)的任務(wù):是否可以僅通過(guò)使用 GPT-N 模型的檢查點(diǎn)(即當(dāng)前模型的狀態(tài))來(lái)預(yù)測(cè) GPT-N+1(未來(lái)模型)是否會(huì)出現(xiàn)涌現(xiàn)能力? 并在論文《Predicting Emergent Capabilities by Finetuning》中給出了答案。

- 論文標(biāo)題:Predicting Emergent Capabilities by Finetuning

- 論文地址:https://arxiv.org/pdf/2411.16035

值得注意的是,這篇論文的作者包括強(qiáng)化學(xué)習(xí)大牛 Sergey Levine。

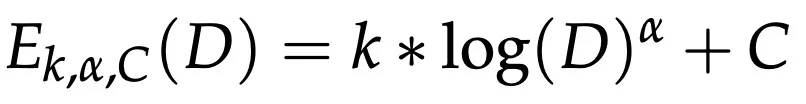

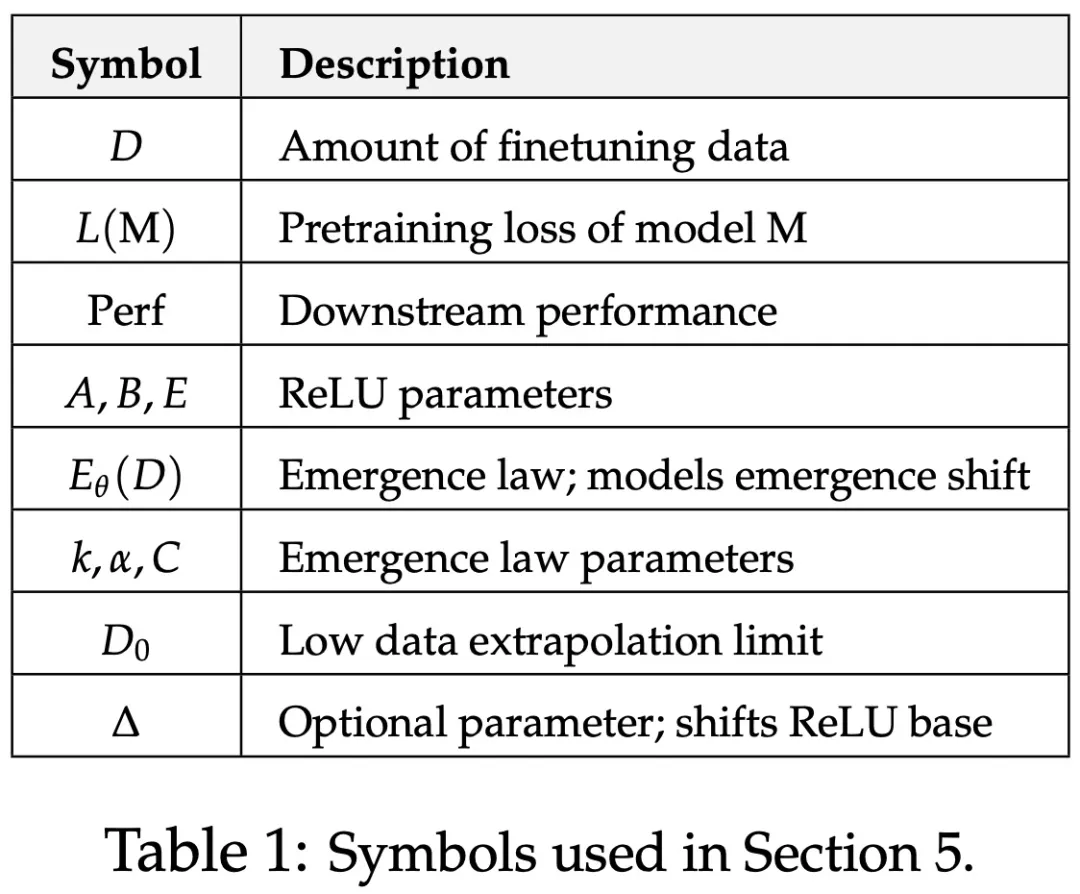

該研究擬合了一個(gè)參數(shù)函數(shù) —— 涌現(xiàn)定律,模擬了涌現(xiàn)點(diǎn)如何隨數(shù)據(jù)量的變化而變化。

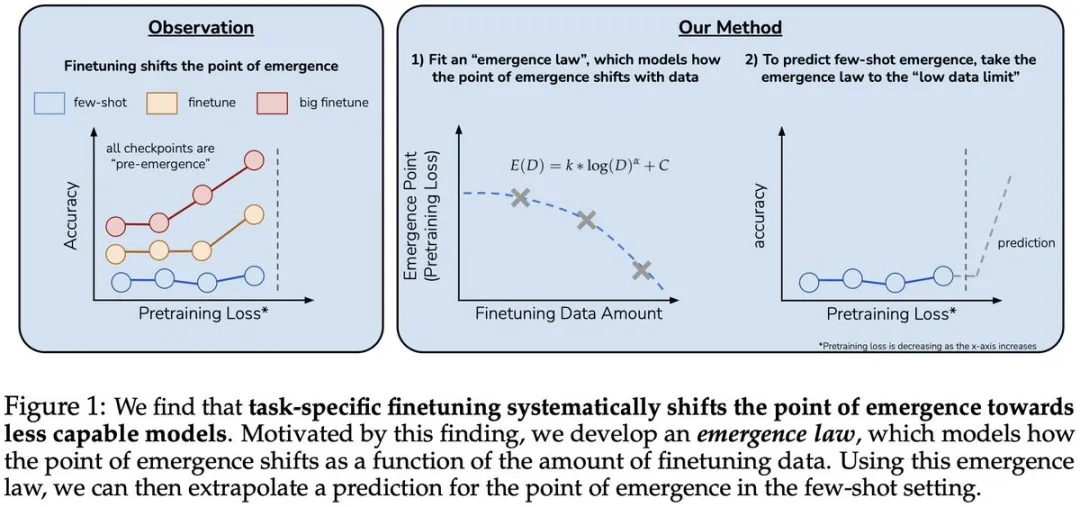

為了進(jìn)行驗(yàn)證,該研究使用四個(gè)標(biāo)準(zhǔn) NLP 基準(zhǔn) ——MMLU、GSM8K、CommonsenseQA 和 CoLA。通過(guò)僅使用小規(guī)模 LLM 來(lái)擬合涌現(xiàn)定律,該研究能夠準(zhǔn)確預(yù)測(cè)涌現(xiàn)點(diǎn)。

最后,該研究提出了兩個(gè)實(shí)際的涌現(xiàn)案例研究,表明該研究提出的涌現(xiàn)定律可用于預(yù)測(cè)更復(fù)雜的能力。

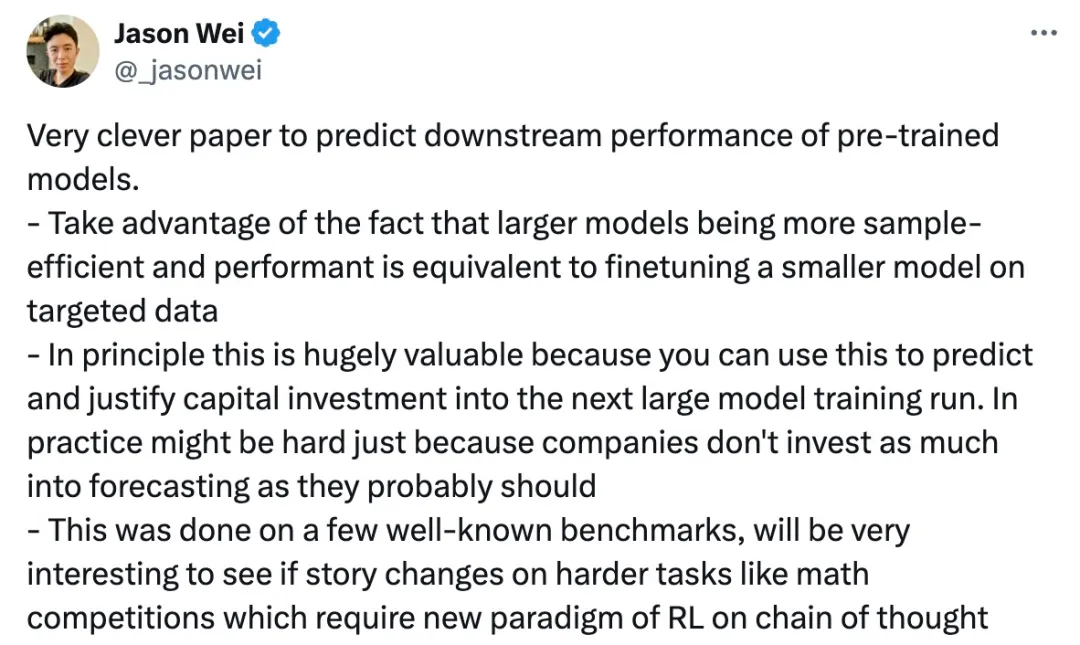

思維鏈提出者 Jason Wei 稱(chēng)贊:「這是一篇非常聰明的論文,可以預(yù)測(cè)預(yù)訓(xùn)練模型的下游性能,非常有價(jià)值。因?yàn)榭梢允褂盟鼇?lái)預(yù)測(cè)和證明對(duì)下一個(gè)大模型訓(xùn)練運(yùn)行的資本投資的合理性。」

論文介紹

作者首先提出了涌現(xiàn)預(yù)測(cè),并將涌現(xiàn)預(yù)測(cè)定義為僅使用涌現(xiàn)前的模型檢查點(diǎn),來(lái)識(shí)別發(fā)生涌現(xiàn)的擴(kuò)展點(diǎn)的問(wèn)題。

簡(jiǎn)單理解就是,對(duì)于給定的 LLM,其在特定任務(wù)上具有隨機(jī)少樣本準(zhǔn)確率,我們能否預(yù)測(cè)這個(gè) LLM 在哪個(gè)擴(kuò)展點(diǎn)(例如,預(yù)訓(xùn)練損失)上性能將超越隨機(jī)表現(xiàn)?

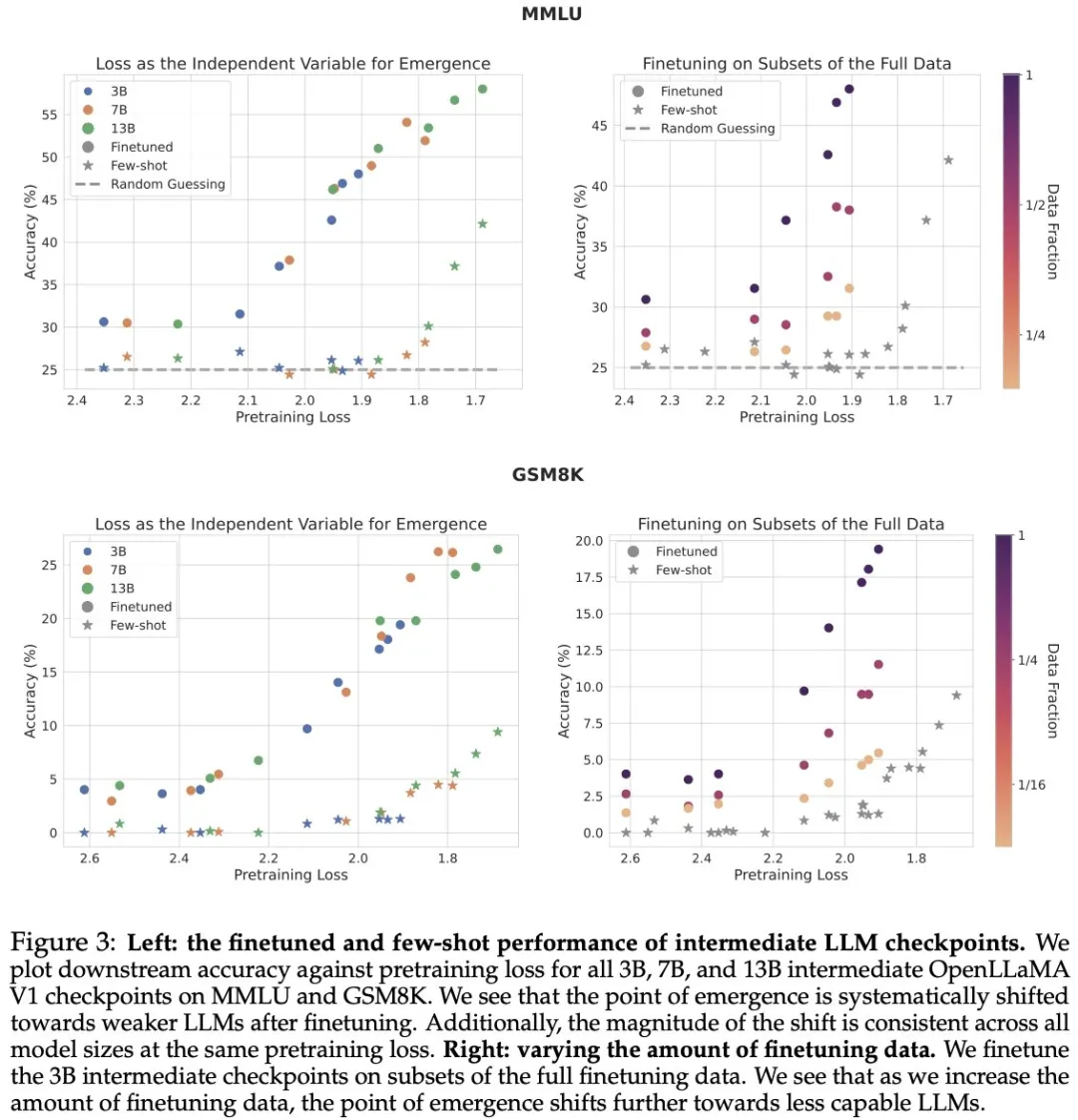

帶著這一疑問(wèn),作者發(fā)現(xiàn)了這樣一個(gè)見(jiàn)解:在給定的任務(wù)上微調(diào) LLM, 可以將涌現(xiàn)發(fā)生的臨界點(diǎn)向著能力較低的模型移動(dòng) ,這意味著,通過(guò)微調(diào),模型在涌現(xiàn)能力出現(xiàn)的時(shí)間點(diǎn)可以提前,這對(duì)于理解模型擴(kuò)展和能力躍升的過(guò)程非常重要。微調(diào)所使用的數(shù)據(jù)量,會(huì)調(diào)節(jié)這種臨界點(diǎn)移動(dòng)的幅度。

圖 3(左)繪制了每個(gè)模型在 GSM8K 和 MMLU 上的少樣本和微調(diào)性能與預(yù)訓(xùn)練損失的關(guān)系。可以看到,微調(diào)后的模型遵循與少樣本設(shè)置類(lèi)似的 ReLU 形狀。此外,在相同的預(yù)訓(xùn)練損失下,所有模型大小的轉(zhuǎn)變都是一致的,這表明預(yù)訓(xùn)練損失可以作為少樣本和微調(diào)設(shè)置中有效的獨(dú)立變量。

作者還發(fā)現(xiàn)出現(xiàn)涌現(xiàn)偏移受微調(diào)數(shù)據(jù)量的影響。圖 3(右)繪制了 3B 模型檢查點(diǎn)在完整數(shù)據(jù)子集上進(jìn)行微調(diào)后的性能。在 MMLU 和 GSM8K 上,隨著微調(diào)數(shù)據(jù)量的增加,涌現(xiàn)點(diǎn)進(jìn)一步向能力較弱的 LLM 偏移。因此,微調(diào)數(shù)據(jù)量可以調(diào)節(jié)涌現(xiàn)偏移。

為了將這一洞察付諸實(shí)踐,作者針對(duì)不同數(shù)量的數(shù)據(jù)對(duì) LLM 進(jìn)行了微調(diào),并擬合了一個(gè)參數(shù)函數(shù)(即涌現(xiàn)定律),該函數(shù)模擬了涌現(xiàn)點(diǎn)如何隨數(shù)據(jù)量的變化而變化。

然后,根據(jù)這一發(fā)現(xiàn)可以推斷出在少樣本設(shè)置中關(guān)于涌現(xiàn)的預(yù)測(cè)。

作者利用四個(gè)標(biāo)準(zhǔn) NLP 基準(zhǔn)來(lái)驗(yàn)證涌現(xiàn)定律,結(jié)果發(fā)現(xiàn)涌現(xiàn)定律可以提前準(zhǔn)確預(yù)測(cè)涌現(xiàn)點(diǎn),最多可提前 4 倍 FLOP。

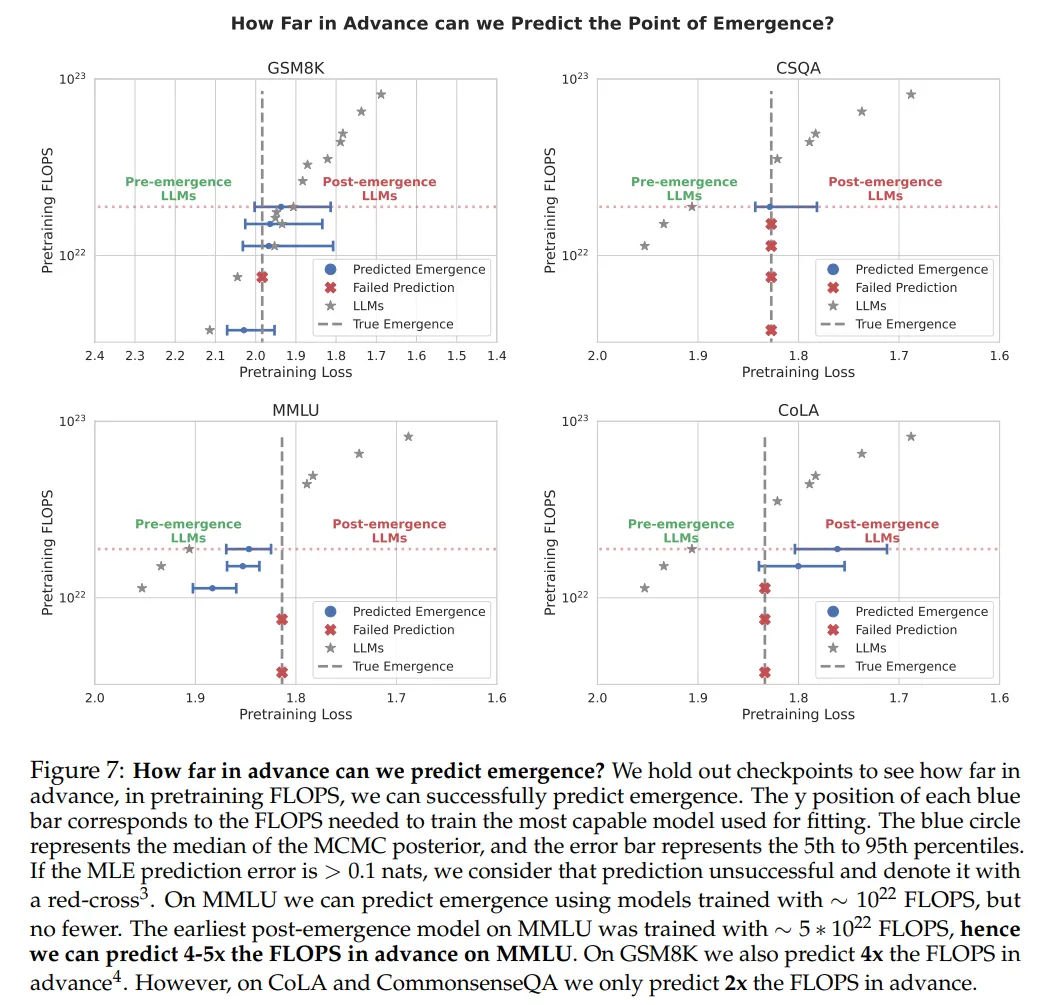

接下來(lái)作者進(jìn)行了這樣一個(gè)實(shí)驗(yàn),就預(yù)訓(xùn)練 FLOPS 而言,可以提前多久成功做出預(yù)測(cè)。結(jié)果發(fā)現(xiàn),可以提前預(yù)測(cè)涌現(xiàn)的程度在某種程度上取決于任務(wù)。

在 MMLU 和 GSM8K 上,可以分別提前最多 4.3 倍和 3.9 倍的 FLOPS 涌現(xiàn)出現(xiàn)。然而,在 CommonsenseQA 和 CoLA 上,分別只能提前預(yù)測(cè) 1.9 倍和 2.3 倍。

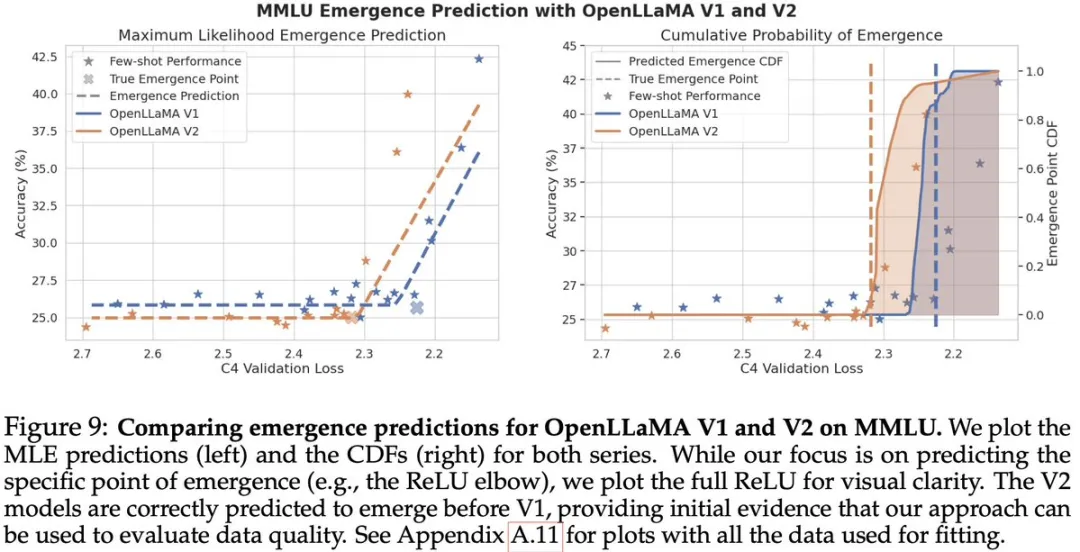

最后,作者還進(jìn)行了真實(shí)世界的案例研究:1)低成本評(píng)估預(yù)訓(xùn)練數(shù)據(jù)質(zhì)量(左)。2)使用困難 APPS 編碼基準(zhǔn)預(yù)測(cè)更復(fù)雜的能力,更接近未來(lái)前沿模型的能力(右)。

感興趣的讀者可以閱讀論文原文,了解更多研究?jī)?nèi)容。