NeurIPS 2024 Oral | 還原所見!揭秘從腦信號重建高保真流暢視頻

本篇論文的工作已被 NeurlPS(Conference on Neural Information Processing Systems)2024 會議接收為 Oral Presentation (64/15671=0.4%) 。本文主要作者來自同濟大學苗奪謙,張奇團隊,其余作者來自俄亥俄州州立大學、悉尼科技大學、中科院自動化所、北京安定醫院。其中,第一作者龔子璇就讀于同濟大學計算機學院,研究方向涉及 fMRI 解碼和多模態學習。

從大腦信號還原視覺刺激一直是神經科學和計算機科學研究人員們津津樂道的話題。然而,基于非侵入式大腦活動 fMRI(功能性磁共振成像)到視頻的重建研究仍然有限,因為解碼連續視覺刺激的時空感知是一項艱巨的挑戰。為此,本文提出了一種名為 NeuroClips 的創新框架,用于從 fMRI 數據中解碼高保真和流暢的視頻。

- 論文題目:NeuroClips: Towards High-fidelity and Smooth fMRI-to-Video Reconstruction

- 論文鏈接:https://arxiv.org/abs/2410.19452

- 項目主頁:https://github.com/gongzix/NeuroClips

從 fMRI 重建視頻具有哪些挑戰?

1.fMRI 的低時間分辨率。功能性磁共振成像 fMRI 相比于常用的 EEG 腦電信號而言,具有極高的空間分辨率,可以對全腦進行細致的掃描。但是由于全腦掃描更加耗時,fMRI 擁有較低的時間分辨率,通常 2s 才能完成一次采樣,幀率只有 0.5。然而,需要重建視頻的時間分辨率是極高的,通常達到 30~60 的幀率。因此 fMRI 的低時間分辨率(0.5fps)和真實視頻采樣的高時間分辨率(30fps)之間存在嚴重沖突。

2. 重建視頻的低級視覺感知缺乏控制。以往的研究對于視頻重建,已經實現了較為精準的語義重建。例如,當采集被試看見一個男人的 fMRI 信號并用于重建,可以獲得一段男人的視頻。然而,視頻更難的點在于物體形狀變化,人物動作以及場景的變化。因此過往的研究缺乏對重建視頻的低級視覺感知的控制。

為了解決上述挑戰,我們主張利用關鍵幀圖像作為過渡視頻重建的錨點,與大腦的認知機制相吻合。此外,fMRI 到視頻重建考慮低級感知特征,從大腦活動解碼低級感知流,如運動和動態場景,以補充關鍵幀,從而增強高保真幀的重建,生成平滑的視頻。我們提出了一種新穎的 fMRI-to-video 重建框架 NeuroClips,引入了兩個可訓練的組件 —— 感知重建器(Perception Reconstructor)和語義重建器(Semantics Reconstructor),分別用于重建低級感知流和語義關鍵幀。而在推理過程中,采用一個預先訓練好的 T2V 擴散模型,注入關鍵幀和低級感知流,以實現高保真度、平滑度和一致性的視頻重建。該模型不僅在各項指標上實現了 SOTA 性能,還通過使用多 fMRI 融合,開創了長達 6 秒、8 幀率視頻重建的探索。

研究方法

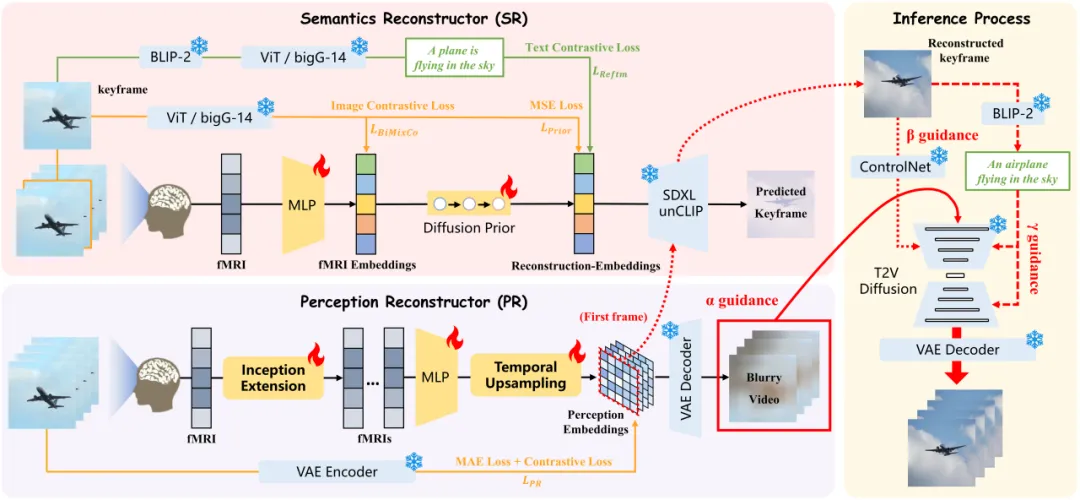

NeuroClips 的整體框架如下圖所示:

圖 1:NeuroClips 的整體框架。紅色的線代表推理過程。

NeuroClips 包括三個關鍵組件:感知重建器(PR)從感知層面生成模糊但連續的粗略視頻,同時確保其連續幀之間的一致性;語義重建器(SR)從語義層面重建高質量的關鍵幀圖像;推理過程是 fMRI 到視頻的重建過程,它使用 T2V 擴散模型,并結合 PR 和 SR 的重建結果,以高保真度、平滑度和一致性重建最終的保真視頻。

1、感知重建器(Perception Reconstructor,PR)

將視頻按兩秒間隔分割成多個片段(即 fMRI 的時間分辨率)。通過在 Stable Diffusion 的 VAE 解碼器中添加時間注意力層,獲得對齊的 fMRI 模糊嵌入,這些嵌入可以用于生成模糊視頻,其缺乏語義內容,但能感知場景的通用動作信息,在位置、形狀、場景等感知指標上表現出最先進的水平。

2、語義重建器(Semantics Reconstructor , SR)

語義重構器(SR)的核心目標是重建高質量的關鍵幀圖像,以解決視覺刺激和 fMRI 信號之間的幀率不匹配的問題,從而提高最終視頻的保真度。現有愈發成熟的 fMRI 到圖像重建研究促進了我們的目標,包括將 fMRI 進行低維處理、關鍵幀圖像與 fMRI 的對齊、重建嵌入生成以及文本模態的重建增強。受到對比學習的啟發,我們在 和

和 之間進行對比學習,通過額外的文本模態來增強重建嵌入

之間進行對比學習,通過額外的文本模態來增強重建嵌入 。對比損失作為這一過程的訓練損失

。對比損失作為這一過程的訓練損失 。我們設置混合系數

。我們設置混合系數 和

和 來平衡多個損失。

來平衡多個損失。

其中, 是關鍵幀圖像和 fMRI 對齊采用的結合了 MixCo 和對比損失的雙向損失,

是關鍵幀圖像和 fMRI 對齊采用的結合了 MixCo 和對比損失的雙向損失, 是重建時與 DALLE?2 相同的擴散先驗損失。

是重建時與 DALLE?2 相同的擴散先驗損失。

3、推理過程(Inference Process)

我們結合模糊的粗略視頻(PR 輸出)、高質量的關鍵幀圖像(模糊視頻第一幀嵌入 和 fMRI 嵌入輸入到 SR 中的 SDXL unCLIP 生成)和額外的文本模態分別作為

和 fMRI 嵌入輸入到 SR 中的 SDXL unCLIP 生成)和額外的文本模態分別作為 、

、 和

和 Guidance 來重建具有高保真度、平滑度和一致性的最終視頻。我們采用 text-to-video(T2V)的擴散模型來幫助重建視頻,而由于嵌入的語義僅來自文本模態。我們還需要通過增強來自視頻和圖像模態的語義來創建 “綜合語義” 嵌入,以幫助實現 T2V 擴散模型的可控生成。

Guidance 來重建具有高保真度、平滑度和一致性的最終視頻。我們采用 text-to-video(T2V)的擴散模型來幫助重建視頻,而由于嵌入的語義僅來自文本模態。我們還需要通過增強來自視頻和圖像模態的語義來創建 “綜合語義” 嵌入,以幫助實現 T2V 擴散模型的可控生成。

4、多 fMRI 融合(Multi-fMRI Fusion)

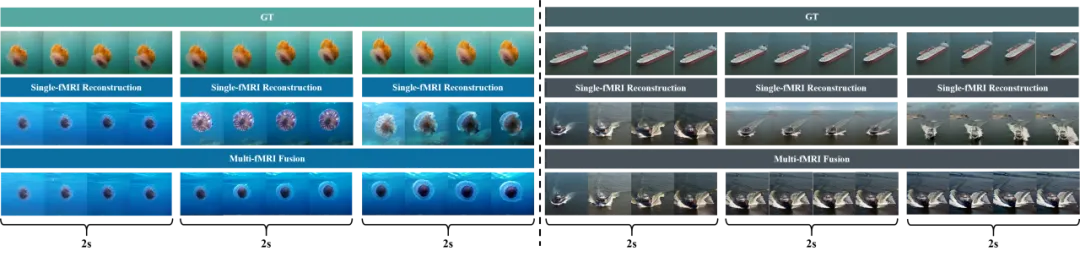

如何從 fMRI 中重建更長的視頻呢?在推理過程中,我們考慮來自兩個相鄰的 fMRI 樣本的兩個重建關鍵幀的語義相似性,如果語義相似,我們就用前一個 fMRI 重建視頻的尾幀替換后一個 fMRI 的關鍵幀,該幀將作為后一個 fMRI 的第一幀來生成視頻。如圖 2 所示,通過這一策略,我們首次實現了長達 6 秒的連續視頻重建。

圖 2:多 fMRI 融合的可視化。

實驗結果

本文使用開源的 fMRI-video 數據集(cc2017 數據集)進行了 fMRI-to-video 的重建實驗,通過基于幀的和基于視頻的指標進行了定量評估,并進行了全面分析。

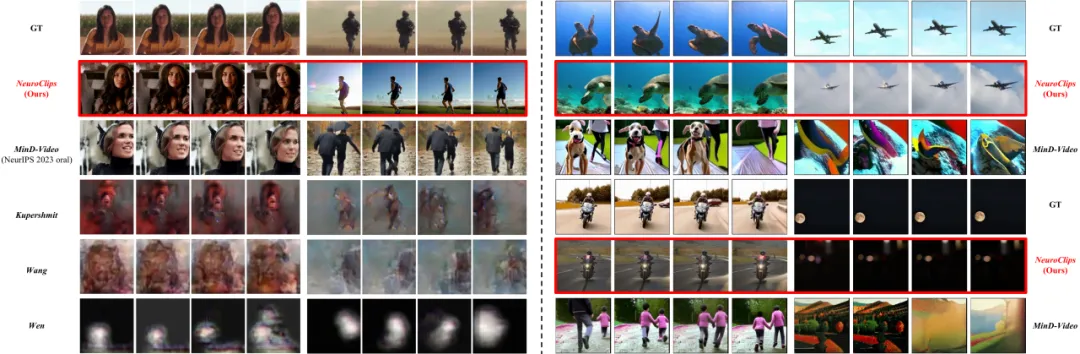

從 fMRI 重建視頻的 Demos

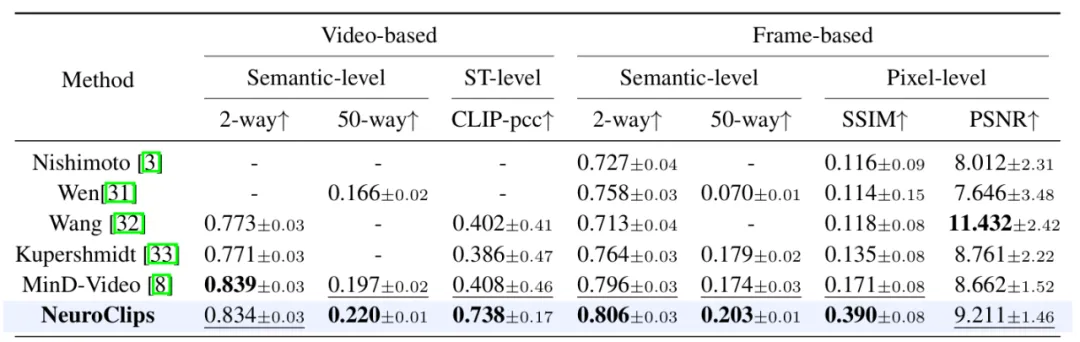

表 1:NeuroClips 重建性能與其他方法的定量比較。

結果如上表所示,NeuroClips 在 7 個指標中的 5 個上顯著優于先前的方法,SSIM 性能大幅提升,表明其補充了像素級控制的不足。語義層面的指標也總體上優于先前的方法,證明了 NeuroClips 更好的語義對齊范式。在評估視頻平滑度的 ST 級指標上,由于我們引入的模糊的粗略視頻( Guidance),NeuroClips 遠超 MinD-Video,重建視頻更加流暢。

神經科學解釋性

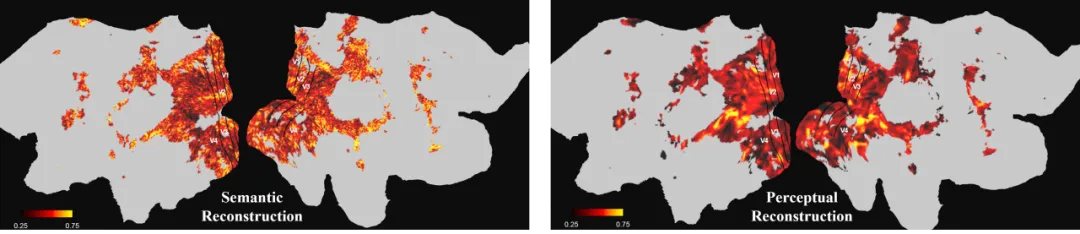

此外,為了探究神經層面的可解釋性,本文在腦平面上可視化了體素級別的權重以觀察整個大腦的關注度。可以觀察到,任何任務視覺皮層都占據著重要的位置,以及 SR 和 PR 的不同權重。

結論

本文創新性地提出了 NeuroClips,這是一種用于 fMRI-to-video 重建的新穎框架。通過感知重建和語義重建兩條路徑實現了體素級和語義級的 fMRI 視覺學習。我們可以在不進行額外訓練的情況下將它們配置到最新的視頻擴散模型中,以生成更高質量、更高幀率和更長的視頻。NeuroClips 能夠在語義級精度和像素級匹配程度上恢復視頻,從而在該領域建立了新的最佳水平,我們還可視化了 NeuroClips 的神經科學可解釋性。