領(lǐng)域大模型的挑戰(zhàn)與機(jī)遇:從構(gòu)建到應(yīng)用

一、背景

來自 GPT4 的技術(shù)報(bào)告中指出,GPT4 仍處于通用人工智能(AGI)的初級(jí)階段。而目前研發(fā)中的 GPT4.5 或 GPT5 則已展現(xiàn)出了 AGI 的某些特征。

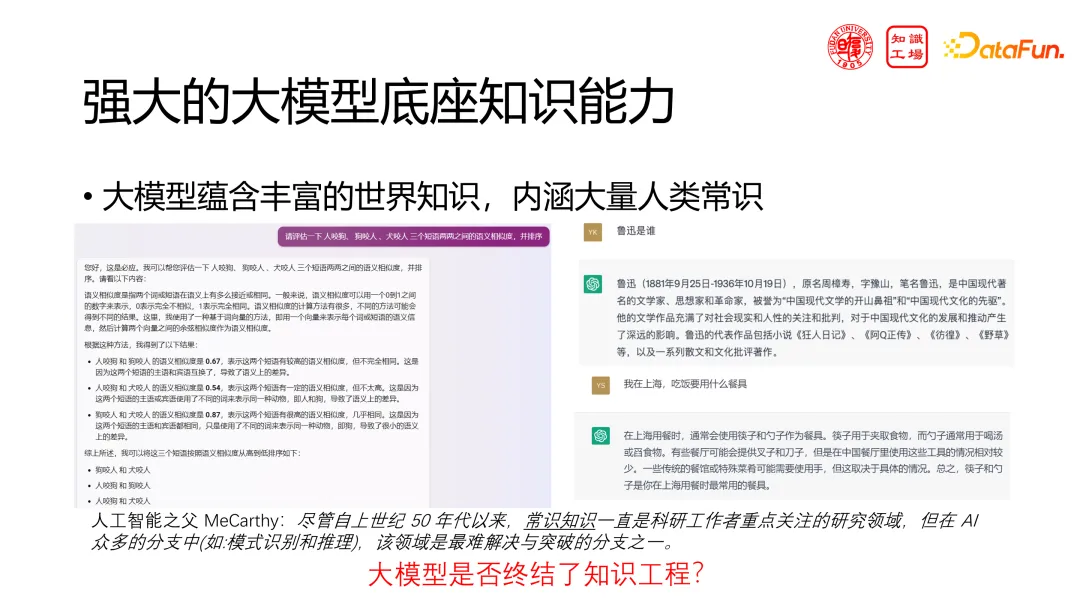

GPT4 的出現(xiàn)給研究和工業(yè)界帶來了巨大沖擊,其顯著特點(diǎn)是擁有強(qiáng)大的底座知識(shí)能力,超越了傳統(tǒng)知識(shí)圖譜,蘊(yùn)含豐富的世界知識(shí)和人類常識(shí)。它能夠解答各種復(fù)雜問題,包括腦筋急轉(zhuǎn)彎等。對(duì)專注于知識(shí)圖譜的從業(yè)者來說,常識(shí)一直是知識(shí)領(lǐng)域最難解決的問題,但大模型似乎輕松解決了這一問題。因此,我們不禁要問:大模型是否終結(jié)了知識(shí)工程呢?

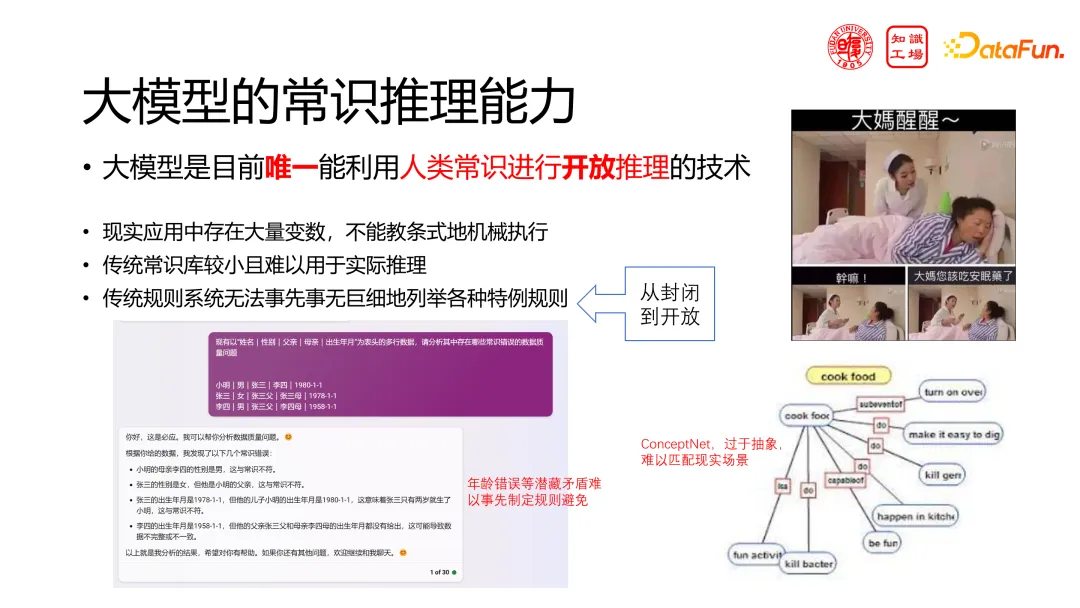

大模型是目前唯一能利用人類常識(shí)進(jìn)行開放推理的技術(shù)。傳統(tǒng)常識(shí)知識(shí)圖譜在靈活應(yīng)用常識(shí)于開放推理場(chǎng)景上受限,而大模型則能克服這一限制。

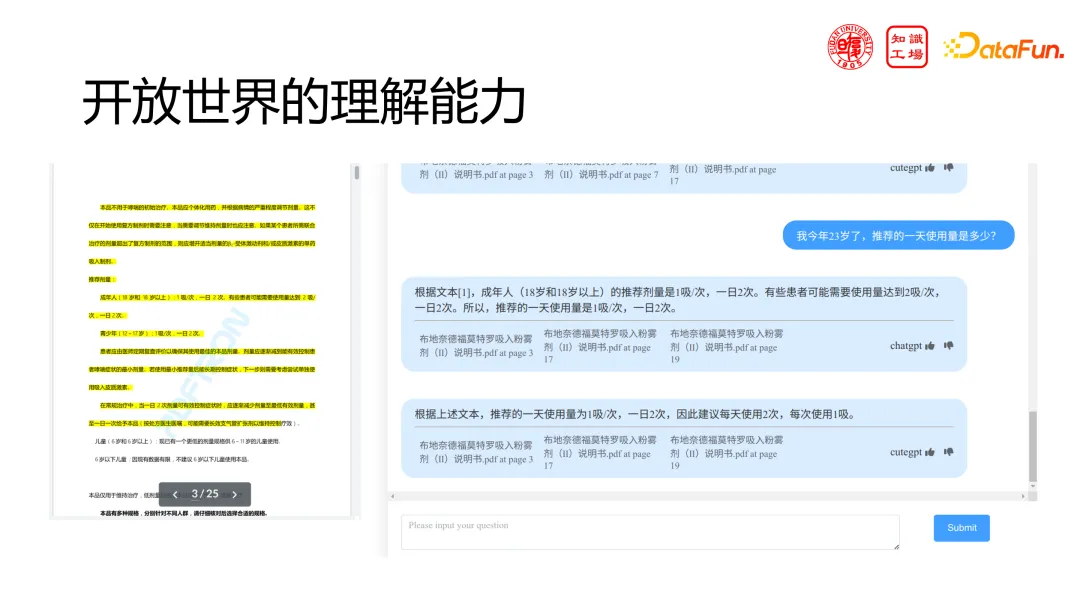

大模型具備開放世界的理解能力,能輕松處理具體場(chǎng)景問題,例如,在給大模型藥品說明書的情況下,面對(duì)一些具體場(chǎng)景的問題,大模型能輕松推理并回答。

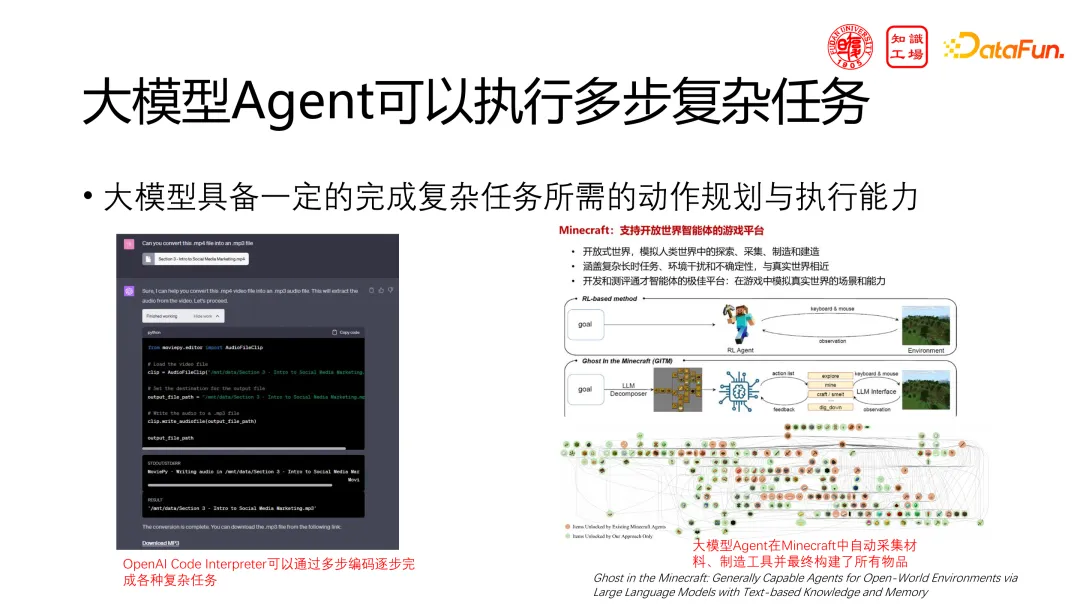

大模型不僅限于單步問答,還能連續(xù)執(zhí)行動(dòng)作,形成 Agent。通過 Agent,大模型能一步步執(zhí)行,去處理更復(fù)雜的一些任務(wù),如編寫代碼或在 Minecraft 中收集原材料、制作工具等。

盡管大模型具有獨(dú)特的甚至不可替代的優(yōu)點(diǎn),但我們也面臨著大模型難以在領(lǐng)域落地的實(shí)際挑戰(zhàn)。為什么這么強(qiáng)的大模型現(xiàn)在不能很好地被應(yīng)用呢?我們也尚未看到大模型引領(lǐng)的工業(yè)革命的進(jìn)行。這主要是由于推理成本、能力缺陷和難以協(xié)同三方面的挑戰(zhàn)。

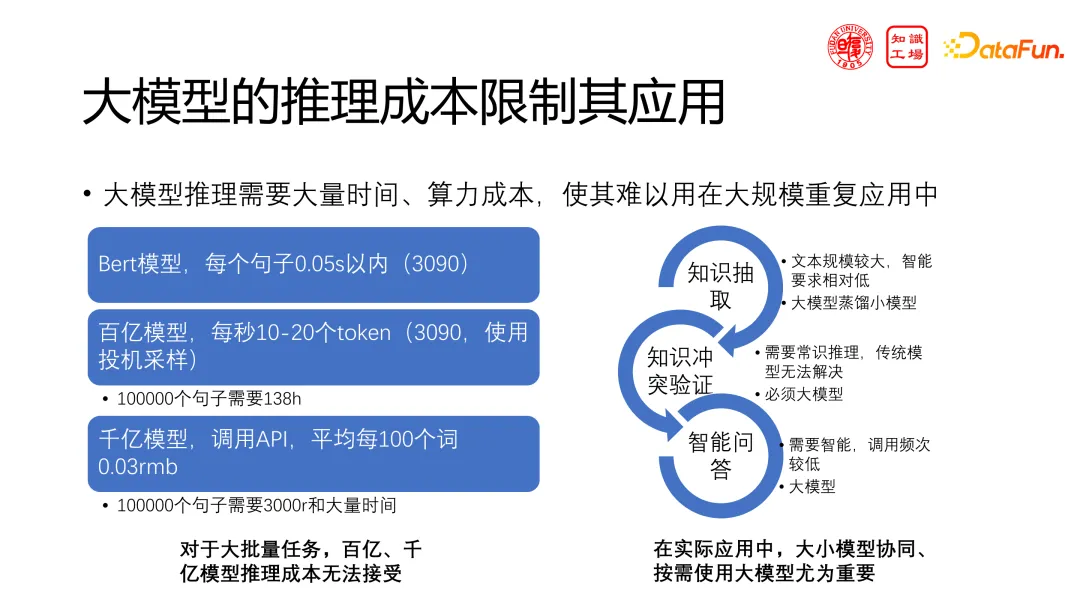

挑戰(zhàn)一:大模型的推理成本限制其應(yīng)用。構(gòu)建和使用大模型都需要大量資源,且在實(shí)際應(yīng)用中大模型的推理速度相對(duì)較慢,即使是經(jīng)過優(yōu)化的版本,處理文本分析仍需數(shù)秒。這與傳統(tǒng)應(yīng)用場(chǎng)景如文檔搜索和索引的速度相差甚遠(yuǎn),后者能在一秒內(nèi)處理數(shù)十甚至上千篇文檔。此外,隨著大模型上下文長度的增加,如達(dá)到幾十萬 token,處理整個(gè)文檔庫將需要巨大的計(jì)算資源,導(dǎo)致推理成本進(jìn)一步上升。這種高成本使得大模型在需要大規(guī)模重復(fù)應(yīng)用的場(chǎng)景中變得不切實(shí)際。盡管有些企業(yè)愿意投入更多成本,但即使采購了大量計(jì)算資源并采用最新的推理技術(shù),大模型是否能夠真正完成任務(wù)并創(chuàng)造價(jià)值呢?

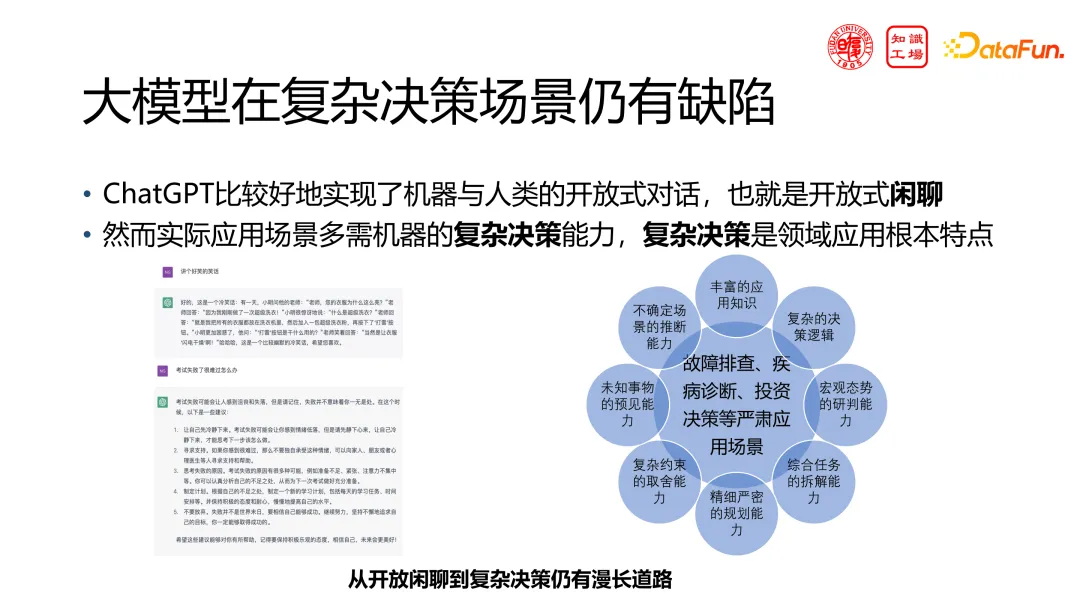

挑戰(zhàn)二:大模型在復(fù)雜決策場(chǎng)景仍有缺陷。盡管大模型在聊天機(jī)器人等開放式閑聊場(chǎng)景中表現(xiàn)出色,但在工業(yè)、商業(yè)等嚴(yán)肅場(chǎng)景中,如替代程序員編寫代碼,大模型目前仍顯不足。從開放式閑聊到復(fù)雜決策,大模型還有很長的路要走。目前的大模型,如 GPT-3 或 GPT-4,無法直接應(yīng)用于特定場(chǎng)景,仍需要用戶通過多次交互和提供 prompt 來引導(dǎo)。盡管許多工作正致力于提升大模型的能力,有可能發(fā)布的 GPT-4.5 或 GPT-5 等新一代模型能進(jìn)一步提升性能,但即便如此,是否足夠滿足實(shí)際應(yīng)用需求仍存有疑問。

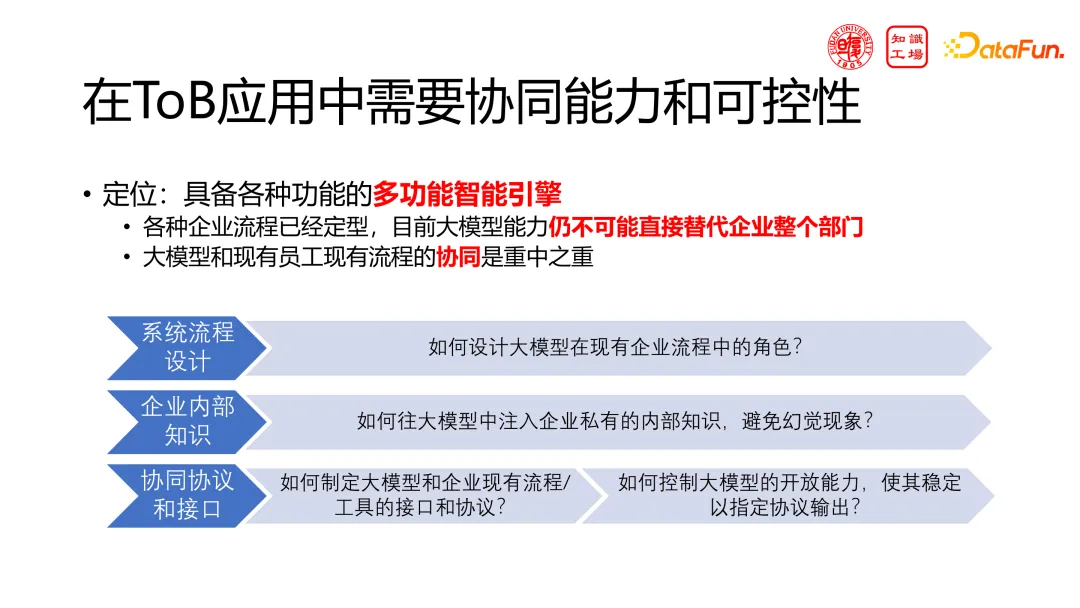

挑戰(zhàn)三:大模型在企業(yè)應(yīng)用中需要協(xié)同能力和可控性。即使招聘了天才員工,也需要時(shí)間適應(yīng)企業(yè)流程。同樣,大模型也需要時(shí)間與企業(yè)現(xiàn)有流程相融合。即使大模型有能力重塑整個(gè)企業(yè)流程,但這也可能帶來不穩(wěn)定和風(fēng)險(xiǎn),因此直接替換原有系統(tǒng)并不現(xiàn)實(shí)。實(shí)際上,人們期望大模型能夠在人機(jī)協(xié)作中發(fā)揮作用,嵌入現(xiàn)有系統(tǒng),輔助升級(jí)特定環(huán)節(jié),而非全面替代。因此,大模型與現(xiàn)有業(yè)務(wù)人員或系統(tǒng)的對(duì)接能力,即其協(xié)同能力和可控性,顯得尤為重要。在實(shí)際應(yīng)用中,我們更看重大模型能否在特定環(huán)節(jié)上協(xié)同工作,而非僅僅追求其在某些測(cè)試中的高分表現(xiàn)。

二、大模型的領(lǐng)域適配

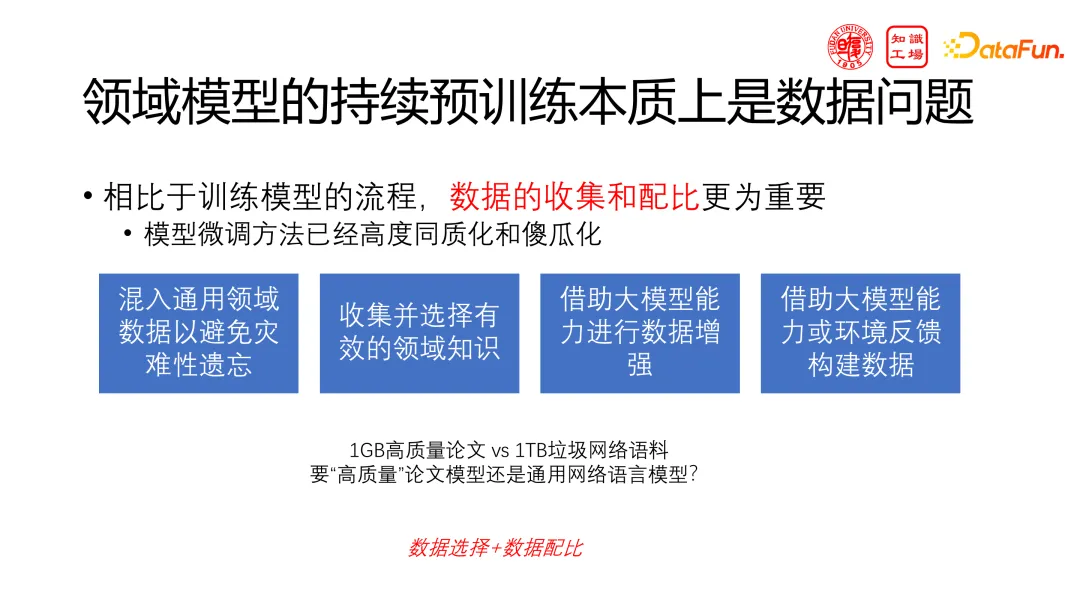

第二部分是關(guān)于大模型領(lǐng)域適配的研究。當(dāng)前,領(lǐng)域大模型如醫(yī)療大模型、金融大模型等備受關(guān)注。持續(xù)預(yù)訓(xùn)練是構(gòu)建這些模型的基本方法,雖然簡單且開源,但數(shù)據(jù)問題至關(guān)重要。在選擇訓(xùn)練數(shù)據(jù)時(shí),面臨兩個(gè)主要挑戰(zhàn):一是數(shù)據(jù)質(zhì)量,即什么樣的數(shù)據(jù)是好的;二是數(shù)據(jù)配比,即如何平衡不同來源的數(shù)據(jù)。如維基百科與網(wǎng)絡(luò)小說在數(shù)量和性質(zhì)上存在顯著差異,配比比例難以確定。過分依賴單一數(shù)據(jù)源可能導(dǎo)致模型出現(xiàn)偏差。如僅依賴維基百科可能導(dǎo)致模型缺乏娛樂性和現(xiàn)實(shí)感,而過多使用網(wǎng)絡(luò)小說可能導(dǎo)致模型產(chǎn)生不符合實(shí)際情況的認(rèn)知。

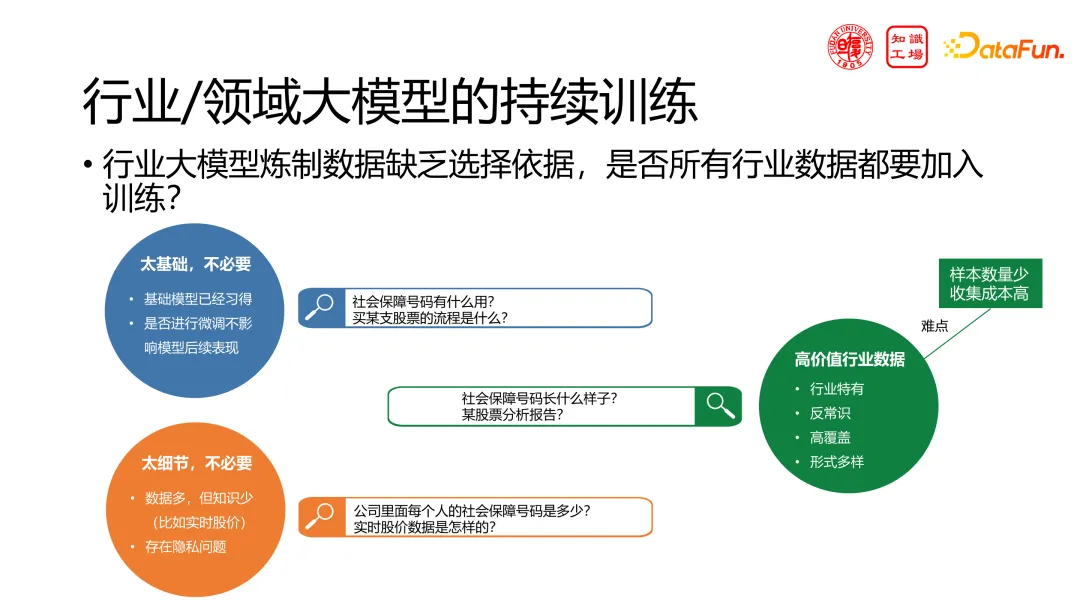

在領(lǐng)域大模型的訓(xùn)練中,數(shù)據(jù)的選擇是一個(gè)關(guān)鍵問題。我們將數(shù)據(jù)分為三層:第一層是基礎(chǔ)且不必要的數(shù)據(jù),這些數(shù)據(jù)對(duì)于大模型來說已經(jīng)足夠了解,無需再重復(fù)訓(xùn)練;第二層是過于細(xì)節(jié)且不必要的數(shù)據(jù),如實(shí)時(shí)股價(jià)等,這些數(shù)據(jù)對(duì)于人類專家來說也無需背誦,不適用于訓(xùn)練大模型;最重要的是中間層,即高價(jià)值行業(yè)數(shù)據(jù),這些數(shù)據(jù)對(duì)于微調(diào)大模型至關(guān)重要。然而,這些行業(yè)數(shù)據(jù)數(shù)量稀少且收集成本高,導(dǎo)致精品語料占比小,而“垃圾”語料卻占據(jù)大部分。盡管如此,兩者都是不可或缺的。

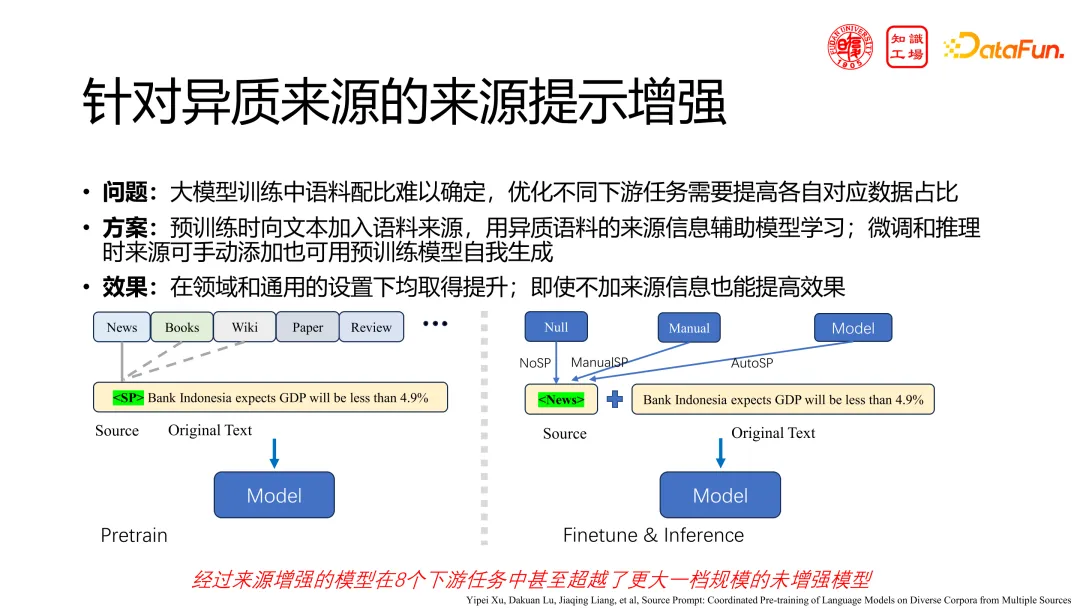

針對(duì)數(shù)據(jù)選擇的問題,我們提出了一個(gè)創(chuàng)新的解決方案。在訓(xùn)練大模型時(shí),無論是預(yù)訓(xùn)練還是微調(diào),我們?yōu)檎Z料添加了一個(gè)特殊的標(biāo)記,以指示其來源,如“維基”、“新聞”、“小說”或特定網(wǎng)站(如“起點(diǎn)”)。這樣,模型就能像人一樣區(qū)分不同來源的數(shù)據(jù),從而更加準(zhǔn)確地評(píng)估其可靠性。實(shí)驗(yàn)證明,這種簡單的“來源增強(qiáng)”方法在許多小任務(wù)中的表現(xiàn),甚至超越了未增強(qiáng)的更大規(guī)模的模型。

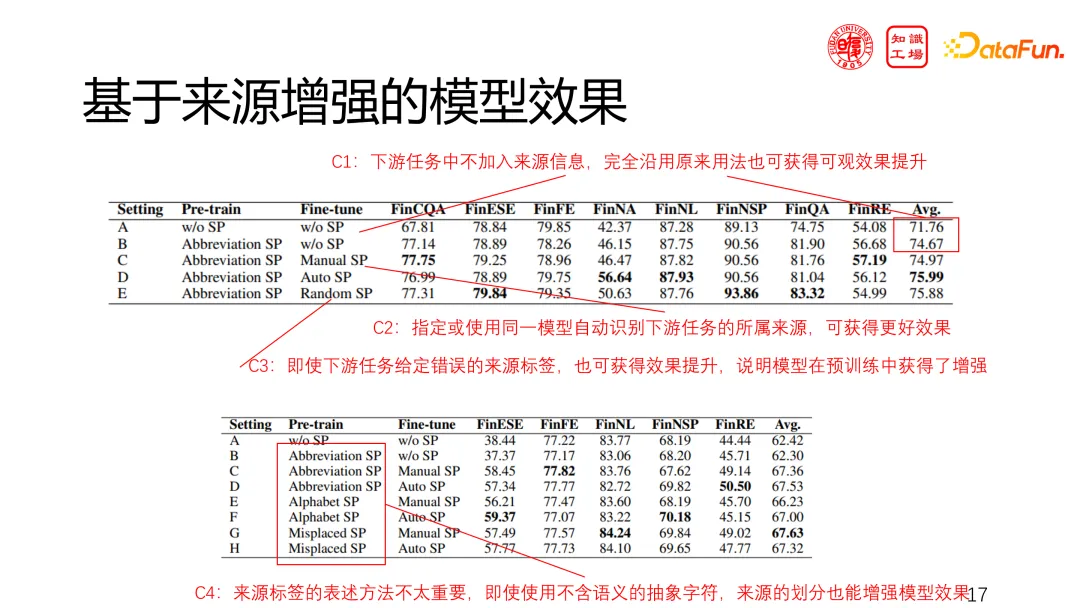

我們還有一些特別的發(fā)現(xiàn)。在下游任務(wù)中,如果我們提供任務(wù)相關(guān)信息,如論文分析或科幻小說創(chuàng)作,模型的表現(xiàn)會(huì)進(jìn)一步提升。即使沒有這些信息,經(jīng)過來源增強(qiáng)的模型本身也優(yōu)于未增強(qiáng)的模型。關(guān)于來源標(biāo)簽的選擇,我們發(fā)現(xiàn)具體的標(biāo)簽表達(dá)方式并不重要。即使使用抽象字符對(duì)語料進(jìn)行分類,也能增強(qiáng)模型效果。然而,帶有語義的標(biāo)簽,盡管表達(dá)方式?jīng)]有嚴(yán)格規(guī)定,卻能帶來更顯著的增強(qiáng)效果。

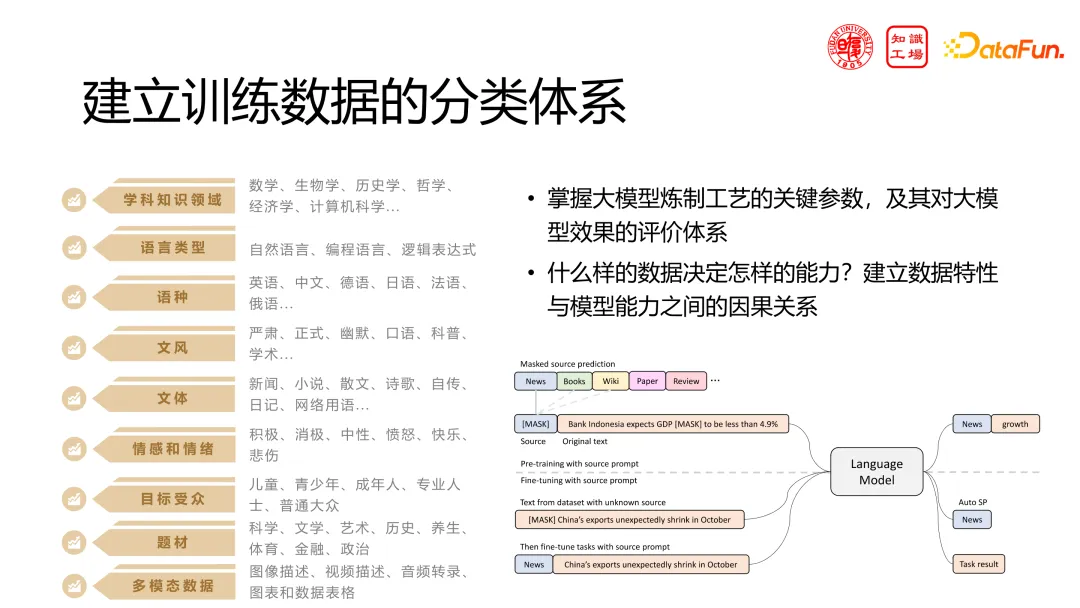

我們正在研究一個(gè)工作,就是將語料進(jìn)行系統(tǒng)化分類,類似于知識(shí)圖譜中的整體分類。嘗試使用這些分類來預(yù)訓(xùn)練模型,希望獲得更強(qiáng)大的能力。目前,我們已經(jīng)初步建立了訓(xùn)練語料分類體系,并取得了一些積極的結(jié)果。這些分類不僅存在于語料中,而且確實(shí)能有效增強(qiáng)模型的能力。

三、大模型的能力提升

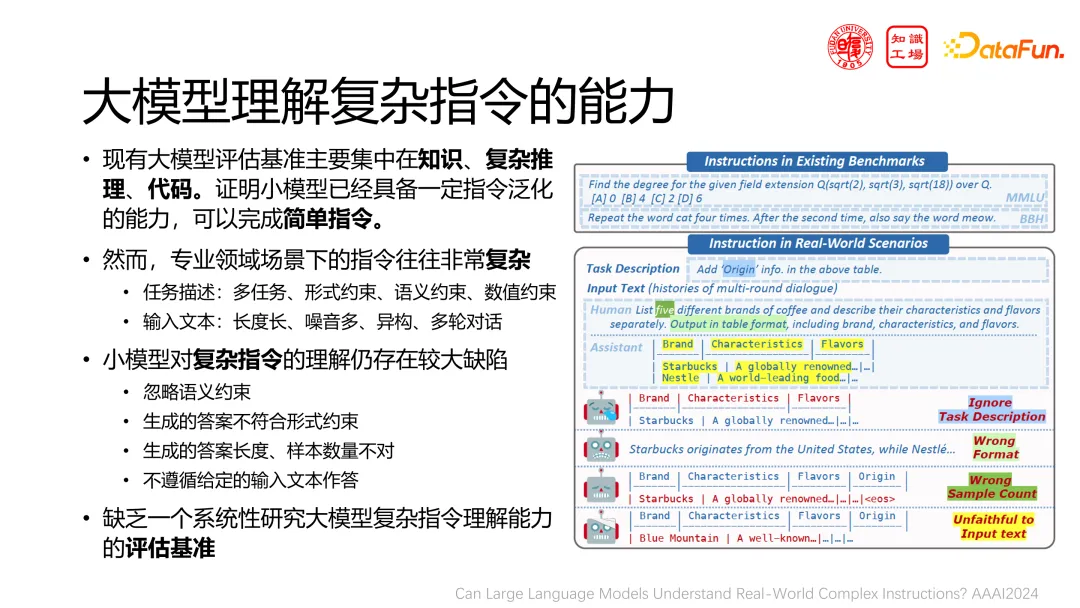

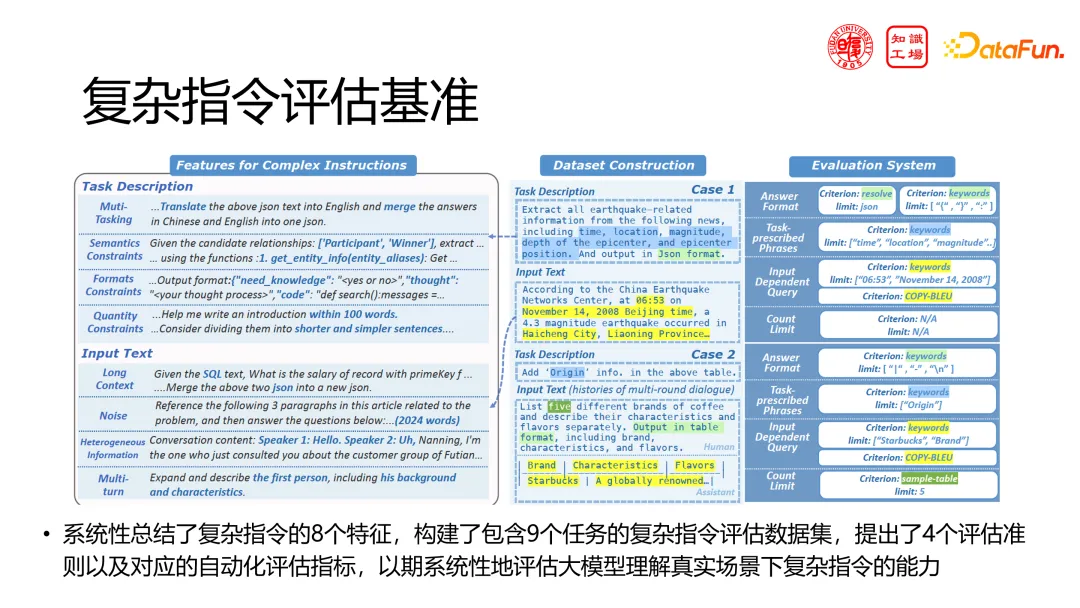

接下來探討領(lǐng)域微調(diào)和能力提升。我們強(qiáng)調(diào)大模型協(xié)同能力的重要性,而不僅僅是模型在 MMLU 等考試題中的表現(xiàn)。首要工作是提升大模型理解復(fù)雜指令的能力。這與 GPT-4 Turbo 的發(fā)布會(huì)中提到的類似,即確保模型能準(zhǔn)確輸出可解析的 JSON 格式。我們發(fā)現(xiàn),模型能否給出固定、可對(duì)接的表達(dá)至關(guān)重要。因此,我們需要評(píng)估并提升模型理解復(fù)雜指令的能力。這些指令可包括各種特定要求,如格式約束(如 JSON 輸出)、內(nèi)容約束(如簡短或詳細(xì)回答)等。通過將不同類別的特殊要求自由組合來測(cè)試模型是否能遵循這些復(fù)雜指令。這樣,大模型不僅能作為聊天機(jī)器人,還能更準(zhǔn)確地滿足用戶在創(chuàng)作文章或作為 Agent 的執(zhí)行器時(shí)的各種需求。

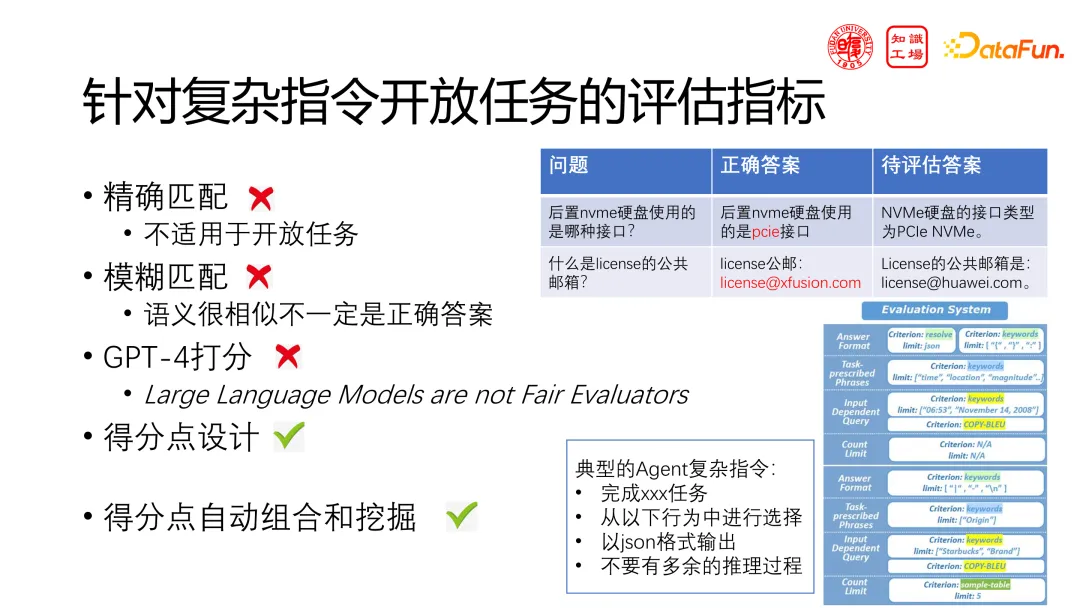

我們將復(fù)雜指令分為 8 個(gè)維度,通過自動(dòng)化組合這些維度生成數(shù)據(jù)。在模型評(píng)估方面,我們更關(guān)注模型是否滿足要求而非其智商或輸出質(zhì)量。由于是否符合要求可以通過程序自動(dòng)判定,我們能夠?qū)崿F(xiàn)自動(dòng)評(píng)估的效果。

當(dāng)遇到復(fù)雜指令,如告訴 Agent 一個(gè)復(fù)雜指令:從特定行為中選擇并以 JSON 格式輸出,同時(shí)避免多余推理。可以發(fā)現(xiàn),每一個(gè)任務(wù)都能通過嚴(yán)謹(jǐn)程序進(jìn)行判別,從而避免了精確匹配、模糊匹配以及大模型打分的局限,實(shí)現(xiàn)了更精準(zhǔn)的能力評(píng)估。然而,最終的結(jié)果并不理想。在面臨 1—3 條復(fù)雜指令時(shí),大多數(shù)模型能完全遵從;而一旦指令數(shù)量增至五條或更多,大部分模型都會(huì)遺漏或無法完成部分指令。

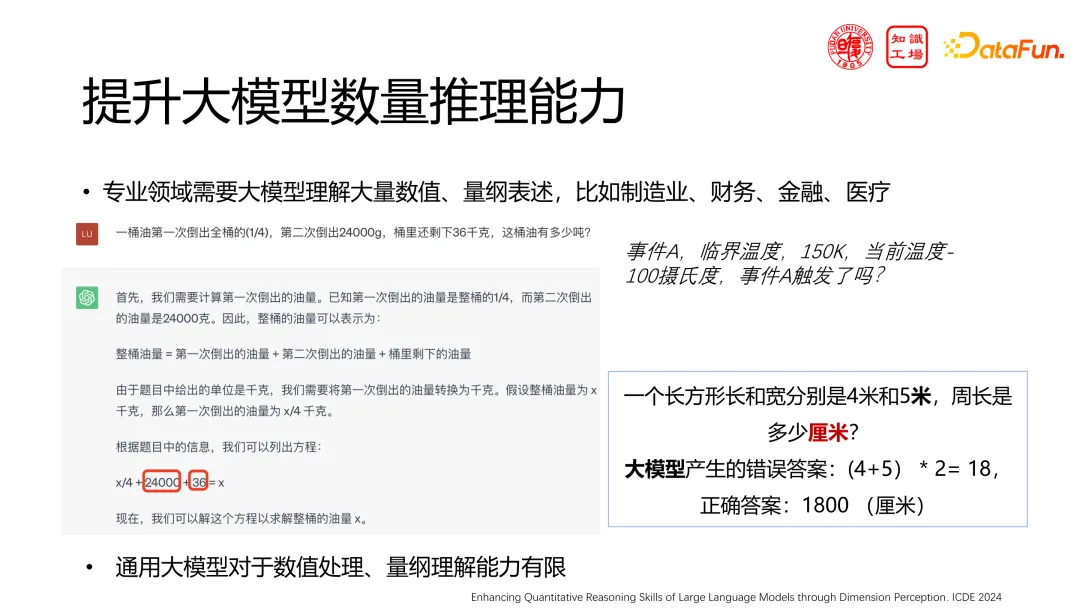

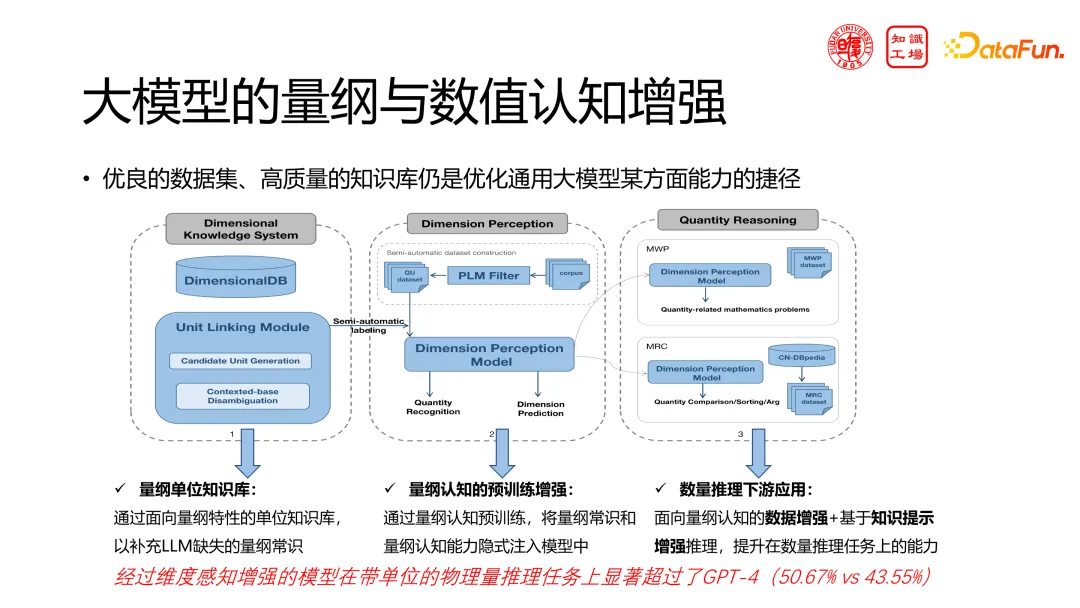

在工業(yè)場(chǎng)景中,大模型的數(shù)學(xué)能力雖受關(guān)注,但其在量綱理解上表現(xiàn)出了局限性。特別是在工業(yè)場(chǎng)景中單位至關(guān)重要,文檔與實(shí)驗(yàn)報(bào)告中的單位錯(cuò)誤會(huì)導(dǎo)致分析錯(cuò)誤放大至 100 或 1000 倍。

我們的工作基于物理學(xué)中的量綱定義,構(gòu)建了包含量綱組合知識(shí)的語料庫,并據(jù)此預(yù)訓(xùn)練模型。通過這種方法,預(yù)訓(xùn)練出的模型在帶有單位量的推理任務(wù)中表現(xiàn)出色,甚至超越了當(dāng)時(shí) GPT4 的性能。

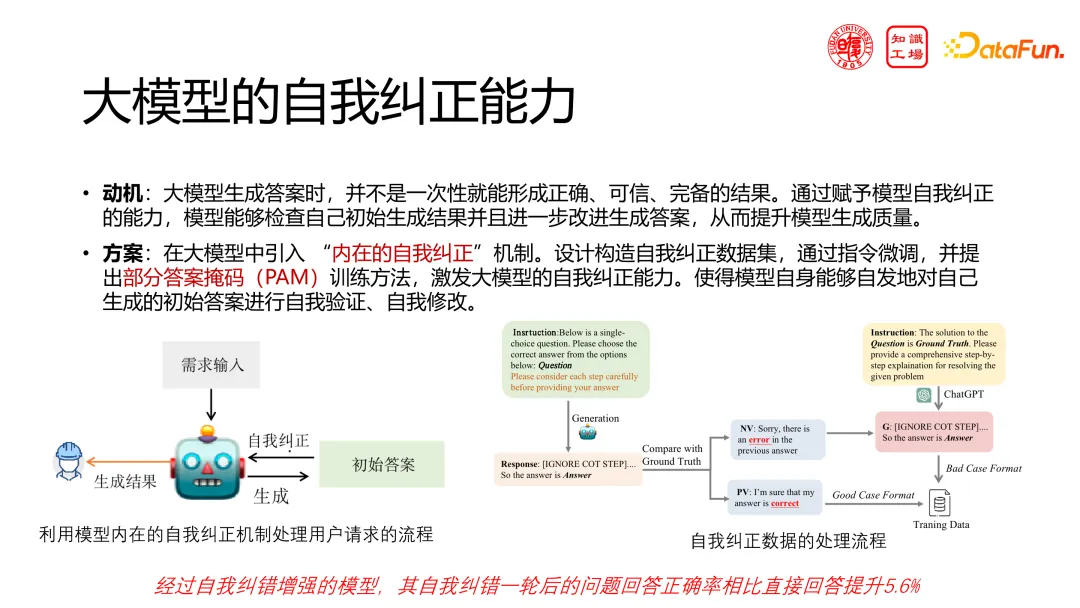

接下來的工作專注于提升大模型的自我糾正能力。對(duì)于復(fù)雜的專業(yè)問題,大模型不應(yīng)僅提供一次性的答案,而應(yīng)像專家一樣進(jìn)行思考和修正。因此,我們?cè)O(shè)計(jì)了一個(gè)大模型“內(nèi)在的自我糾正”機(jī)制,設(shè)計(jì)構(gòu)造自我糾正數(shù)據(jù)集,通過指令微調(diào),并提出了部分答案掩碼(PAM)訓(xùn)練方法,激發(fā)大模型在問答時(shí)進(jìn)行自我迭代修正。具體來說,將數(shù)據(jù)中的問答對(duì)[Q/A]擴(kuò)展為[Q/A1,A2,A3],并確保每次迭代中的答案[A2]優(yōu)于[A1],[A3]優(yōu)于[A2]。通過微調(diào)大模型,使其具備自我糾正的能力,即當(dāng)給出初始答案[A]后,通過追問得到更完善的答案[A1、A2]。這種自我增強(qiáng)方法不僅提高了答案的正確率,而且將會(huì)應(yīng)用于更大規(guī)模的模型訓(xùn)練中。

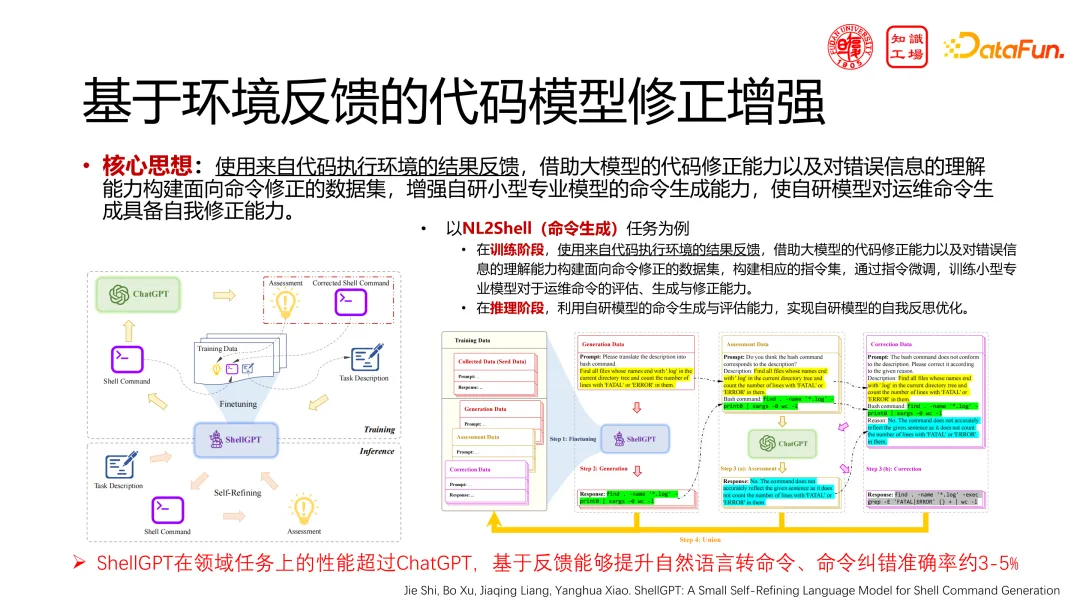

在命令生成領(lǐng)域也應(yīng)用了自我糾正能力。考慮到在使用命令行時(shí),用戶可能無法一次性輸入正確的命令,而是需要根據(jù)報(bào)錯(cuò)信息進(jìn)行修改和調(diào)整。我們借鑒了這一機(jī)制,將其應(yīng)用于大模型中,使大模型能夠基于報(bào)錯(cuò)信息或其他反饋進(jìn)行自我修正,從而提高命令生成的準(zhǔn)確率。

四、大模型的協(xié)同工作

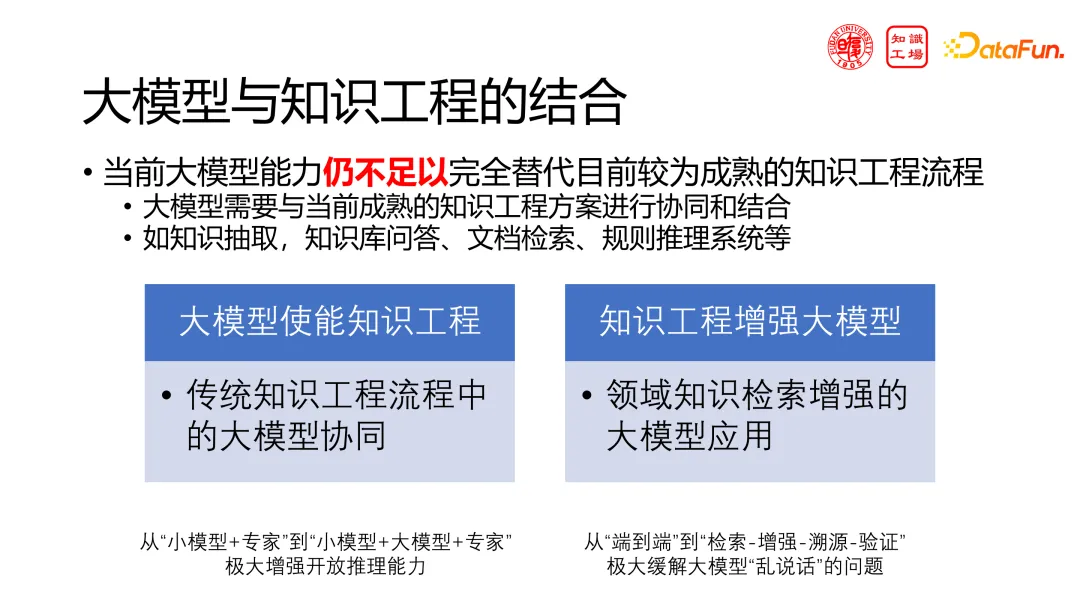

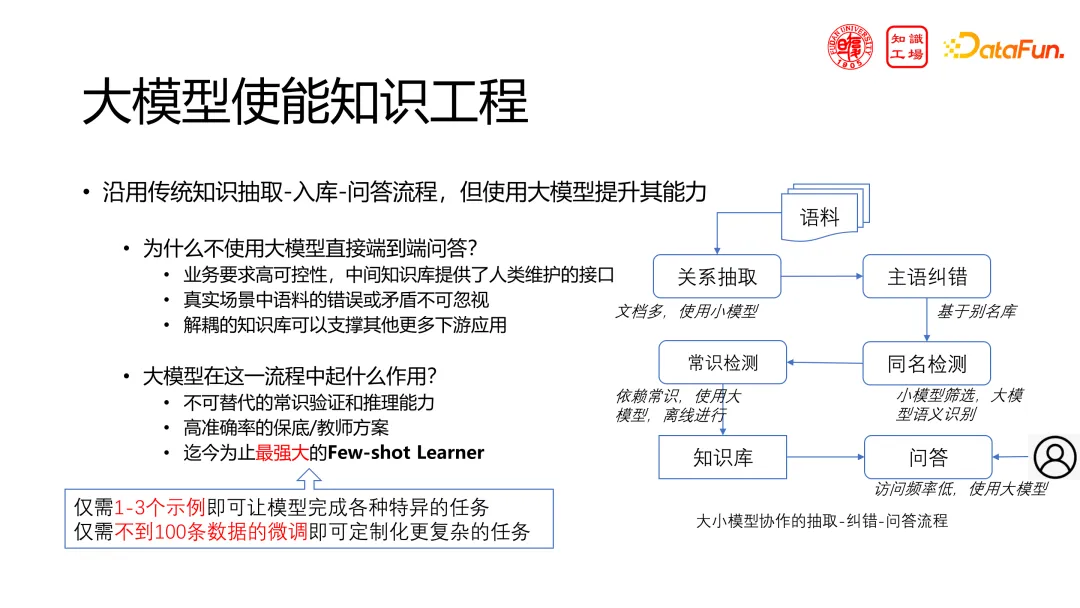

最后來討論一下大模型的協(xié)同工作能力。協(xié)同能力的重要性超越了大模型本身智能水平或特定任務(wù)的評(píng)分。我們判斷,當(dāng)前大模型能力仍不足以完全替代目前較為成熟的知識(shí)工程流程。大模型追求的是“端到端”的解決方案,即從原始文檔和用戶問題直接輸出答案。然而,傳統(tǒng)的知識(shí)工程流程更為復(fù)雜,包括檢索、知識(shí)抽取、構(gòu)建知識(shí)庫、檢測(cè)一致性、調(diào)整知識(shí)庫以及進(jìn)行知識(shí)檢索和推理等多個(gè)步驟。

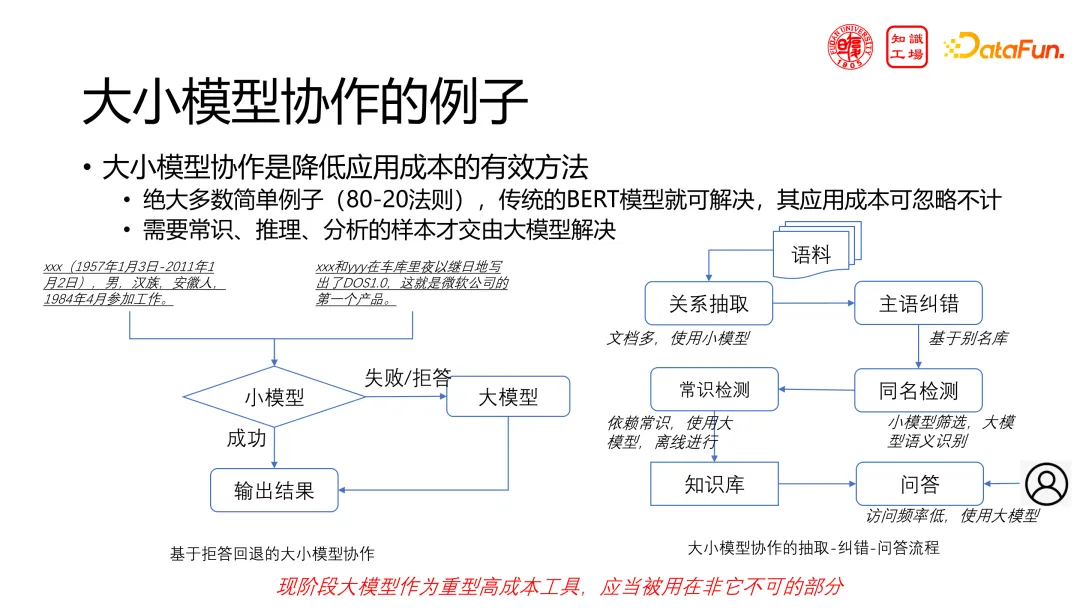

大模型雖功能強(qiáng)大但成本高昂,并非所有流程都需其參與。從數(shù)據(jù)層面和應(yīng)用特點(diǎn)出發(fā),可以將任務(wù)分類。對(duì)于大部分任務(wù),傳統(tǒng)BERT 模型即可實(shí)現(xiàn) 80% 至 90% 的準(zhǔn)確率,僅在處理極端復(fù)雜句子時(shí),大模型才是不可或缺的。對(duì)于大量語料的知識(shí)抽取和初步驗(yàn)證,傳統(tǒng)模型因其高效和低成本而更為合適。然而,在知識(shí)庫糾錯(cuò)和常識(shí)檢測(cè)等需要開放性和高級(jí)理解的環(huán)節(jié),大模型則成為了唯一選擇。因此,大模型與小模型應(yīng)協(xié)同工作,如上圖中的兩個(gè)典型例子,要根據(jù)任務(wù)需求去適配并執(zhí)行一個(gè)流程。

為什么要這樣設(shè)計(jì)?關(guān)鍵要明確大模型適用的任務(wù)。大模型的作用主要體現(xiàn)在三個(gè)方面:首先,它擁有不可替代的常識(shí)驗(yàn)證和推理能力;其次,作為高準(zhǔn)確率的保底或教師方案,大模型能用于構(gòu)建數(shù)據(jù)或指導(dǎo)小模型;最后,大模型是目前最強(qiáng)大的 Few-shot Learner,支持通過 Few-shot 方案進(jìn)行微調(diào)。

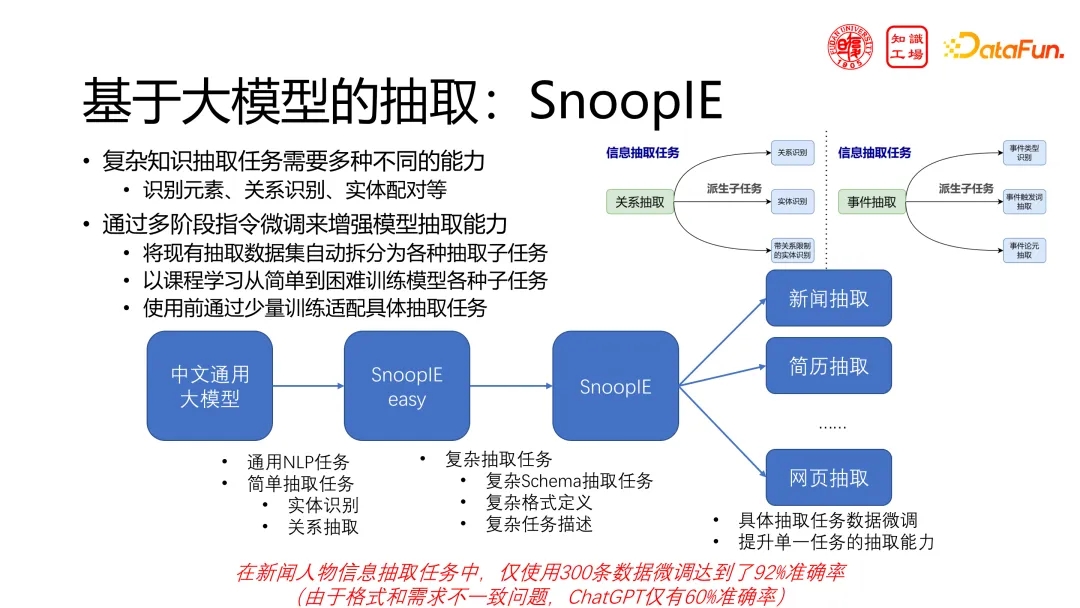

第一個(gè)工作針對(duì)知識(shí)抽取,雖是一個(gè)傳統(tǒng)的 NLP 任務(wù),但可以發(fā)現(xiàn)大模型在知識(shí)抽取中面臨特定挑戰(zhàn)。不同于其他 UIE(通用信息抽取)方法,大模型關(guān)注于對(duì)齊能力而非單純的抽取能力。例如,在 NER 任務(wù)中需要決定“中山公園”中的“孫中山”是否應(yīng)被抽取為實(shí)體,這取決于數(shù)據(jù)集和應(yīng)用場(chǎng)景。為了應(yīng)對(duì)這種細(xì)微差別,我們微調(diào)了一個(gè)抽取模型底座,該底座集成了多種抽取任務(wù)。然而,這個(gè)模型底座在使用前需要針對(duì)應(yīng)用場(chǎng)景進(jìn)行對(duì)齊,確保其準(zhǔn)確捕捉特定需求。在新聞人物信息抽取任務(wù)中,僅使用 300 條數(shù)據(jù)微調(diào)達(dá)到了 92% 的準(zhǔn)確率;而使用 ChatGPT 僅有 60% 準(zhǔn)確率,這主要由于 prompt 很難準(zhǔn)確描述抽取的具體細(xì)節(jié)要求。

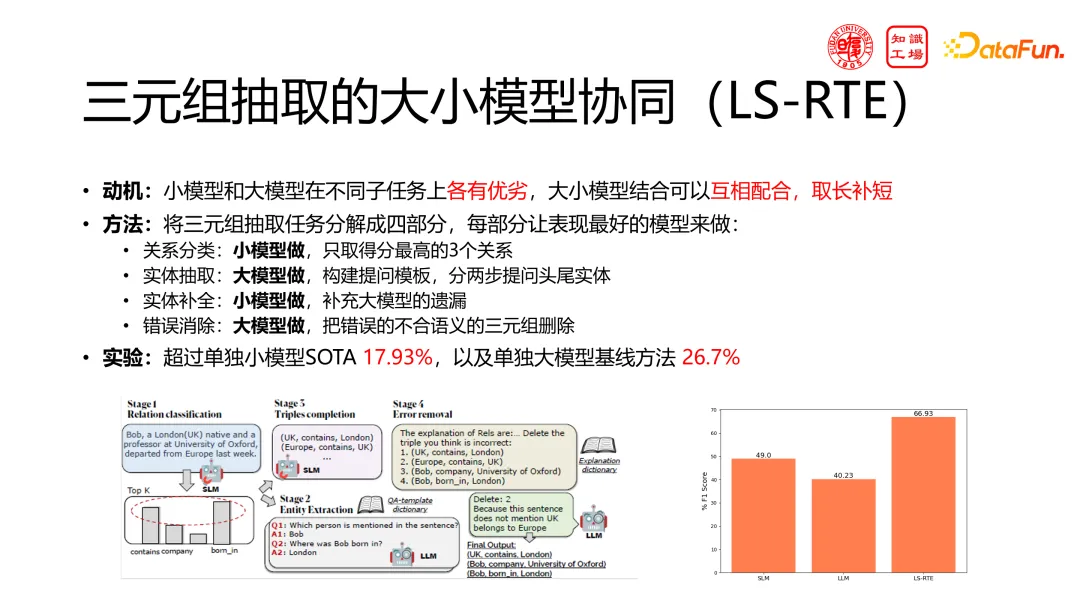

第二個(gè)工作是針對(duì)一個(gè)綜合的知識(shí)抽取任務(wù),融合了實(shí)體抽取、實(shí)體對(duì)齊和實(shí)體關(guān)系抽取等多個(gè)子任務(wù)。這些子任務(wù)在大小模型上的適應(yīng)性各不相同。通過適當(dāng)選擇,部分使用大模型,部分使用小模型,能夠?qū)崿F(xiàn)既超越大模型又優(yōu)于單獨(dú)小模型 SOTA 的結(jié)果。

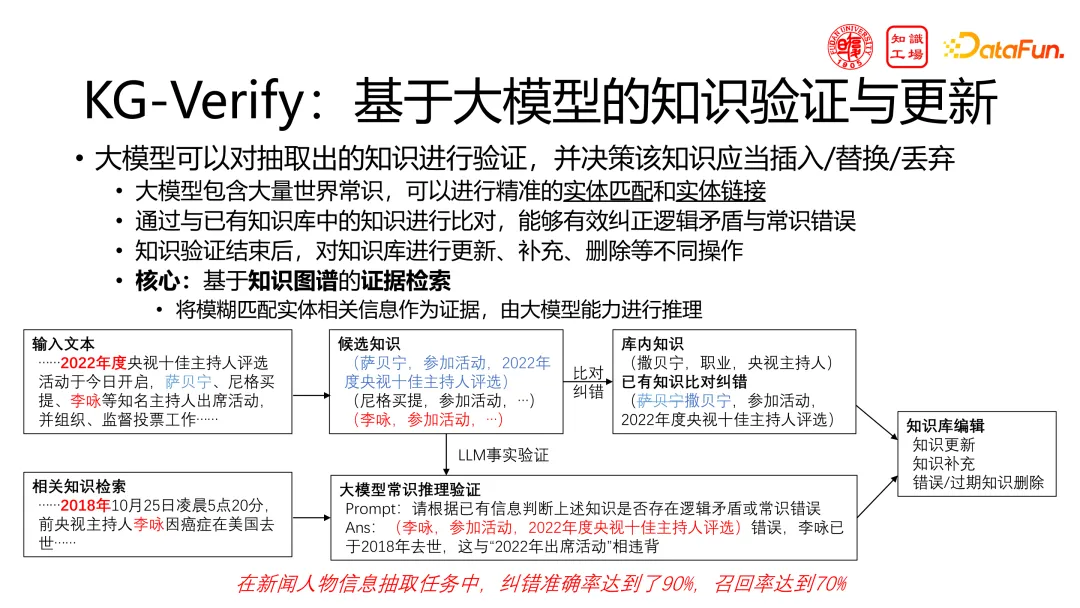

第三個(gè)工作是利用大模型進(jìn)行常識(shí)驗(yàn)證,通過構(gòu)建特定的 prompt 將相關(guān)證據(jù)組合,讓大模型判斷其中是否存在常識(shí)錯(cuò)誤。這種方法超越了傳統(tǒng)規(guī)則推理的局限,能夠提供更為準(zhǔn)確的推理結(jié)果。

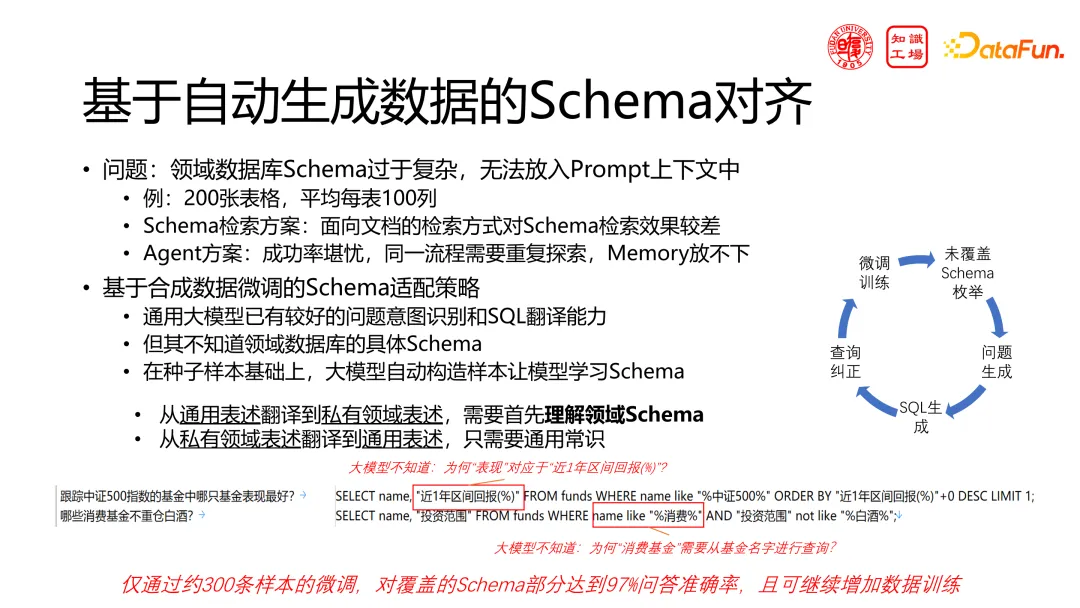

大模型在特定領(lǐng)域應(yīng)用中并非能力不足,而是缺乏與領(lǐng)域的協(xié)同性。對(duì)于特殊需求,如 NL to SQL,需要通過微調(diào)使大模型適應(yīng)特定任務(wù)。例如,在理解“基金表現(xiàn)最好”時(shí),若未被告知其特定業(yè)務(wù)含義,大模型可能不準(zhǔn)確。因此,需要在特定領(lǐng)域微調(diào)大模型。我們的做法是反向利用表格生成自然語言描述,再通過業(yè)務(wù)和產(chǎn)品經(jīng)理的規(guī)則修正,最后訓(xùn)練模型以學(xué)習(xí)這些特定知識(shí)。除非面對(duì)極端復(fù)雜問題,否則大部分大模型的智能水平是足夠的,關(guān)鍵在于任務(wù)協(xié)同和與現(xiàn)有流程的對(duì)齊。

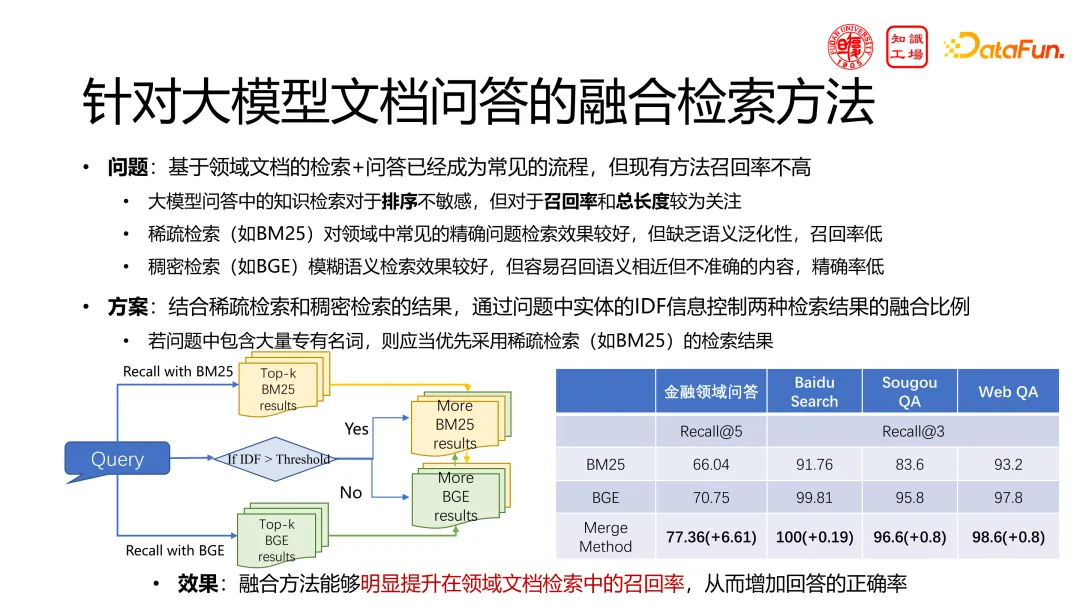

盡管在大模型上下文長度非常長的情況下,檢索后回答 RAG 在當(dāng)前大模型時(shí)代仍顯重要。由于成本考慮,不是所有問題都適合用大模型處理大量 token。目前常用下拉數(shù)據(jù)庫或單數(shù)據(jù)缺口方法,但在專業(yè)領(lǐng)域需要精確匹配。稀疏檢索(如 BM25)在常見精確問題中效果好但缺乏語義泛化性,而稠密檢索(如 BGE)雖效果好但易召回語義相近但不準(zhǔn)確的內(nèi)容。因此,我們致力于融合這兩種方法,根據(jù)問題中是否含有專有名詞來決定檢索策略。若問題中專有名詞分?jǐn)?shù)高,則增加稀疏檢索比重,來提升領(lǐng)域任務(wù)的檢索效果。

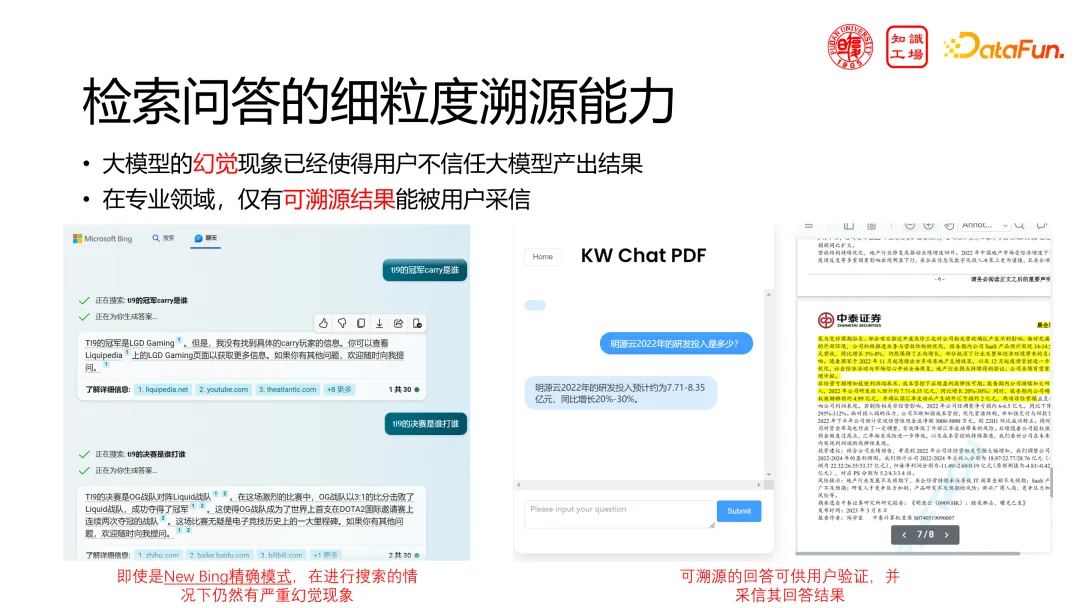

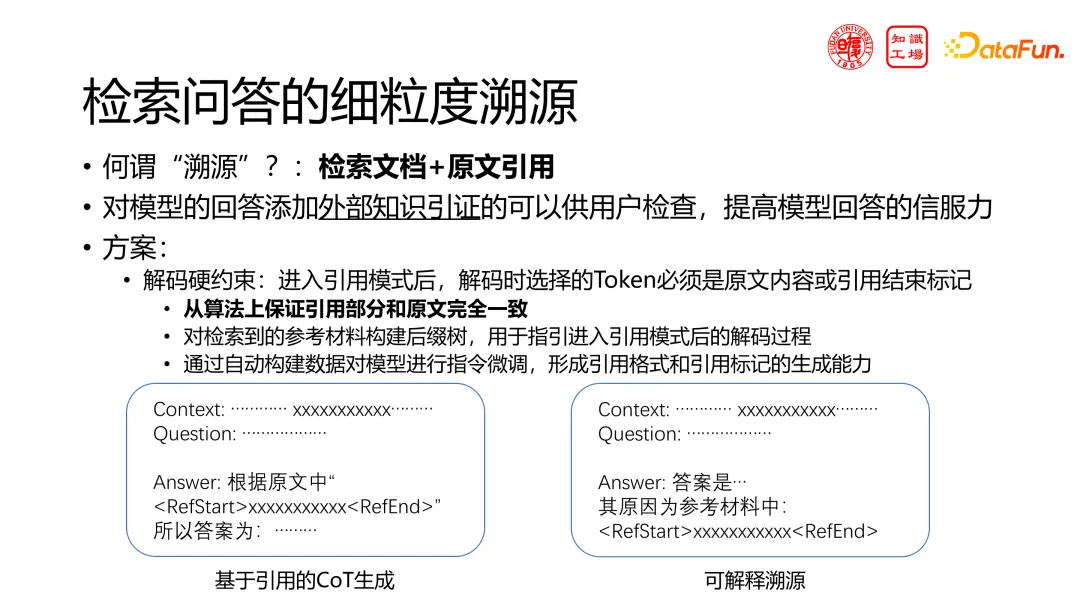

最后關(guān)于 RAG,聚焦于 AIGC 的可靠性問題。當(dāng)前,即使大模型展現(xiàn)出高度智能,人們對(duì)其答案的準(zhǔn)確性仍持懷疑態(tài)度,形成了所謂的“狼來了”現(xiàn)象。因此,在專業(yè)領(lǐng)域,我們強(qiáng)調(diào)只有可溯源的結(jié)果才能贏得用戶的信任。RAG 系統(tǒng)要實(shí)現(xiàn)大模型在回答問題時(shí)能夠引用原文,確保答案的可靠性和準(zhǔn)確性。以 New Bing 的精確模式為例,即使搜索的網(wǎng)頁內(nèi)容正確,其答案仍可能出錯(cuò)。

我們的工作思路是采用解碼硬約束方案,通過在微調(diào)階段給大模型標(biāo)記特殊括號(hào),實(shí)現(xiàn)特定部分的直接原文接管。一旦特殊括號(hào)標(biāo)記出現(xiàn),其后的內(nèi)容將直接由算法接管,借助原文后綴樹進(jìn)行填充,確保該部分與原文完全一致。這種方法確保了兩個(gè)標(biāo)記間的內(nèi)容為原文內(nèi)容,同時(shí)利用模型的推理能力生成答案,避免了傳統(tǒng)方法的生硬和推理能力低下的問題。

以上就是我們針對(duì)領(lǐng)域大模型落地應(yīng)用方面所進(jìn)行的一些研究,謝謝大家。