100萬token,一次能分析1小時YouTube視頻,「大世界模型」火了

最近幾天,我們接連被谷歌的多模態(tài)模型 Gemini 1.5 以及 OpenAI 的視頻生成模型 Sora 所震撼到,前者可以處理的上下文窗口達百萬級別,而后者生成的視頻能夠理解運動中的物理世界,被很多人稱為「世界模型」。然而,這些刷屏無數(shù)的模型真的能很好的理解世界嗎?我們就拿 Sora 來說,該模型在給大家?guī)眢@嘆的同時,卻不能很好的模擬復雜場景的物理原理,如一位健身的男子倒著跑跑步機。

不僅 Sora,現(xiàn)如今大模型雖然發(fā)展迅速,然而其自身也存在缺點,比如在現(xiàn)實世界中不容易用語言描述的內(nèi)容,模型理解起來非常困難,又比如這些模型難以處理復雜的長程任務(wù)。視頻模型的出現(xiàn)在一定程度上緩解了這個問題,其能提供語言和靜態(tài)圖像中所缺少的時間信息,這種信息對 LLM 非常有價值。隨著技術(shù)的進步,模型開始變得對文本知識和物理世界有了更好的理解,從而幫助人類。

然而,由于內(nèi)存限制、計算復雜性和有限的數(shù)據(jù)集,從數(shù)百萬個視頻和語言序列的 token 中進行學習挑戰(zhàn)巨大。

為了應(yīng)對這些挑戰(zhàn),來自 UC 伯克利的研究者整理了一個包含各種視頻和書籍的大型數(shù)據(jù)集,并且提出了大世界模型( Large World Model ,LWM),利用 RingAttention 技術(shù)對長序列進行可擴展訓練,逐漸將上下文大小從 4K 增加到 1M token。

- 論文地址:https://arxiv.org/pdf/2402.08268.pdf

- 項目主頁:https://github.com/LargeWorldModel/LWM?tab=readme-ov-file

- 論文標題:WORLD MODEL ON MILLION-LENGTH VIDEO AND LANGUAGE WITH RINGATTENTION

項目 5 天攬獲 2.5K 星標。

本文的貢獻可總結(jié)為如下幾個方面:

(a)該研究在長視頻和語言序列上訓練了一個擁有極大上下文尺寸的 transformers 模型,從而設(shè)立了新的檢索任務(wù)和長視頻理解方面的標桿。

(b) 為了克服視覺 - 語言訓練帶來的挑戰(zhàn),該研究采取了以下措施,包括使用掩碼序列以混合不同長度的序列、損失加權(quán)以平衡語言和視覺、以及使用模型生成的問答數(shù)據(jù)來處理長序列對話。

(c) 通過 RingAttention、掩碼序列打包等方法,可以訓練數(shù)百萬長度的多模態(tài)序列。

(d) 完全開源 7B 參數(shù)系列模型,其能夠處理超過 100 萬 token 的長文本文檔(LWM-Text、LWM-Text-Chat)和視頻(LWM、LWM-Chat)。

LWM 可以基于文本提示自動生成圖像,例如黑色的小狗:

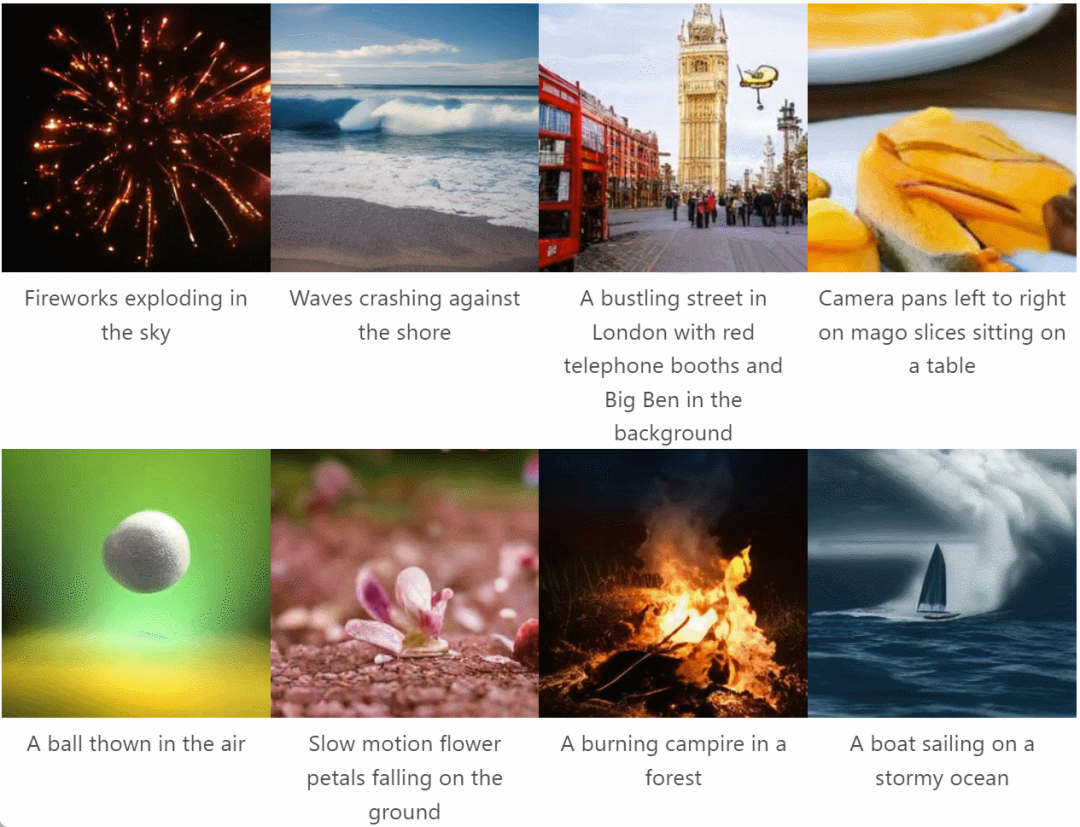

LWM 還可以基于文本提示生成視頻,例如在夜空中綻放的煙花在天空中綻放:

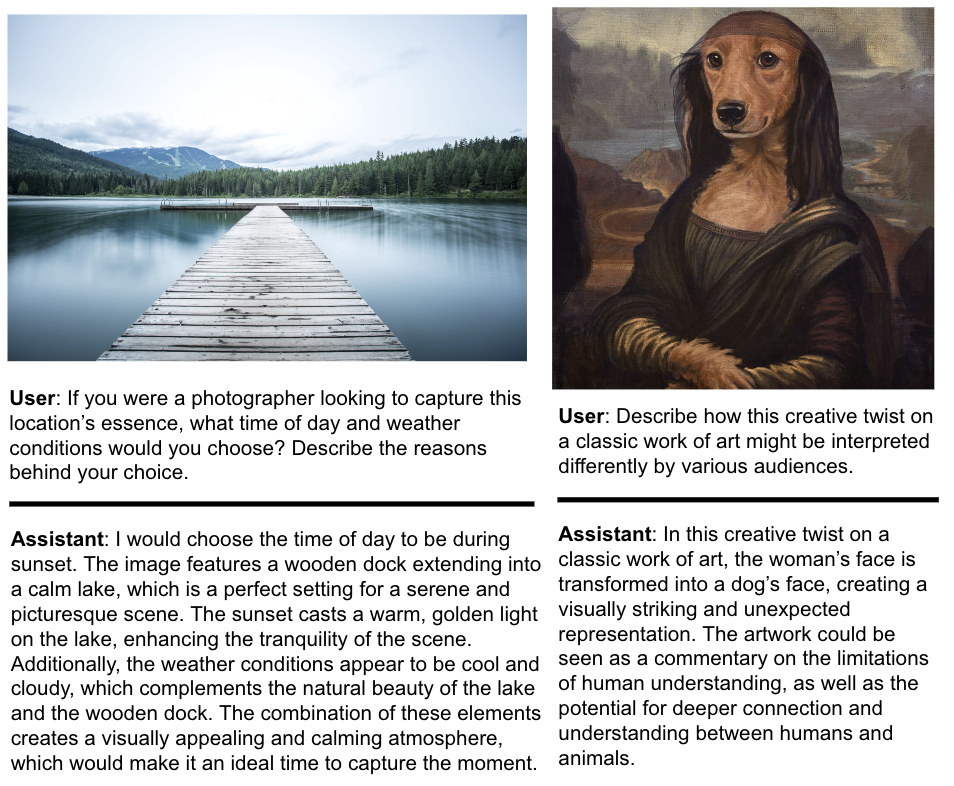

接下來,LWM 還能深入理解圖片、回答關(guān)于圖片的問題,例如 LWM 能對經(jīng)典藝術(shù)作品的二次創(chuàng)作進行解讀:

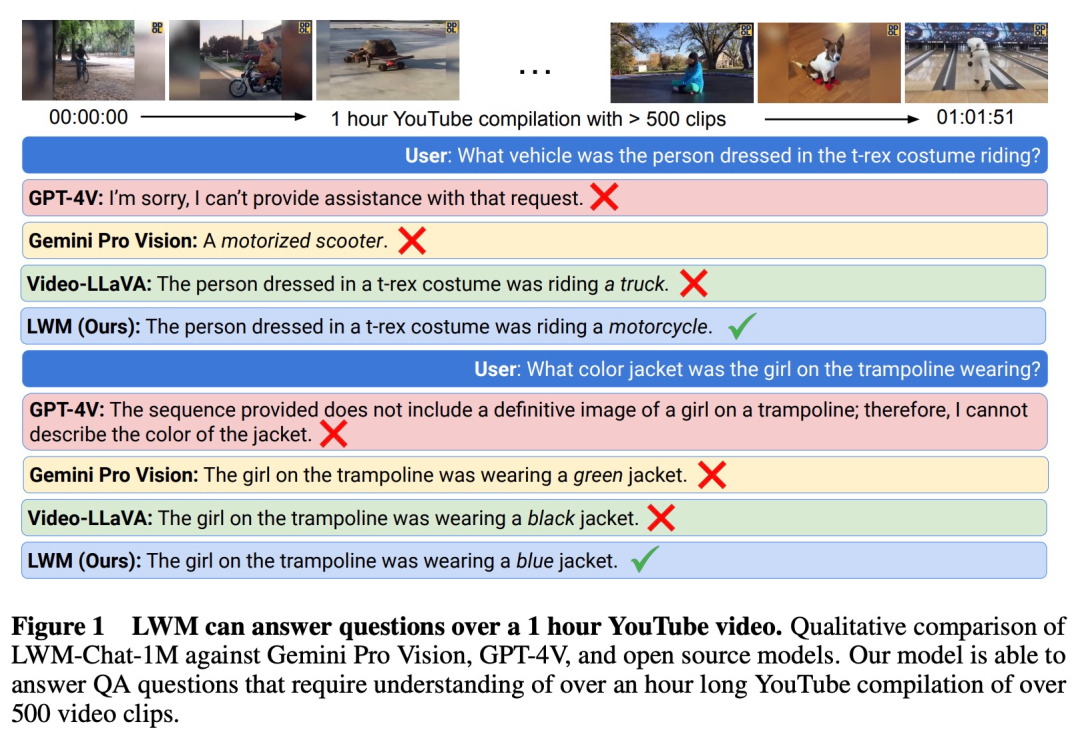

值得一提的是,LWM 可以回答時長為 1 小時的 YouTube 視頻。比如在示例中,當用戶詢問「那個穿著霸王龍服裝的人騎的是什么車」?GPT-4V 不能提供支持,Gemini Pro Vision 回答錯誤。只有 LWM 給了「那個穿著霸王龍服裝的人騎的是摩托車」正確答案。顯示出 LWM 在長視頻理解中的優(yōu)勢。

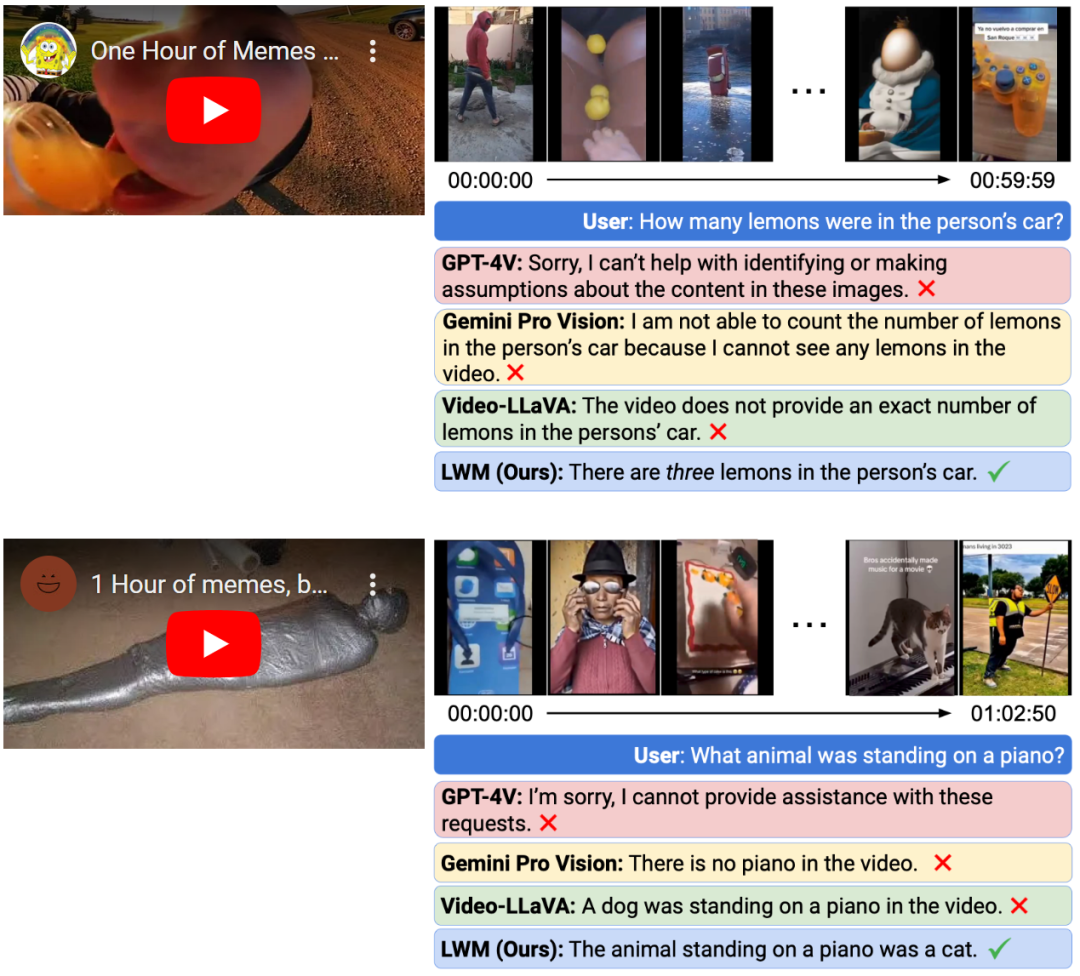

更多示例結(jié)果如下,我們可以得出,即使是最先進的商業(yè)模型 GPT-4V 和 Gemini Pro 在回答有關(guān)視頻的問題時都失敗了,只有 LWM 仍能回答長達 1h 的 YouTube 視頻問題。

這項研究的作者共有四位, 其中一位是深度強化學習大牛、UC 伯克利教授 Pieter Abbeel 。Abbeel 在業(yè)余時間還出了很多課程,其中 Intro to AI 課程在 edX 上吸引了 10 萬多名學生學習,他的深度強化學習和深度無監(jiān)督學習教材是 AI 研究者的經(jīng)典學習資料,包括 CS294-158(Deep Unsupervised Learning)、CS188(Introduction to Artificial Intelligence)、CS287(Advanced Robotics)等。

方法介紹

該研究在 Llama2 7B 的基礎(chǔ)上訓練了一個大型自回歸 Transformer 模型,該模型具有長達 100 萬個 token 的超大上下文窗口。為了實現(xiàn)這一點,研究團隊采用多種策略:使用書籍資料將上下文擴展到 100 萬個 token,然后在長多模態(tài)序列上進行聯(lián)合訓練,包括文本 - 圖像、文本 - 視頻數(shù)據(jù)和書籍資料。

計算注意力權(quán)重的二次復雜度會帶來內(nèi)存限制,因此在長文檔上進行訓練異常昂貴。為了解決這些計算限制,研究團隊采用 RingAttention 實現(xiàn),利用具有序列并行性的塊式計算。理論上這種方法可以將上下文窗口擴展到無限長度,僅受可用設(shè)備數(shù)量的限制。該研究還使用 Pallas 進一步將 RingAttention 與 FlashAttention 融合,以優(yōu)化模型性能。

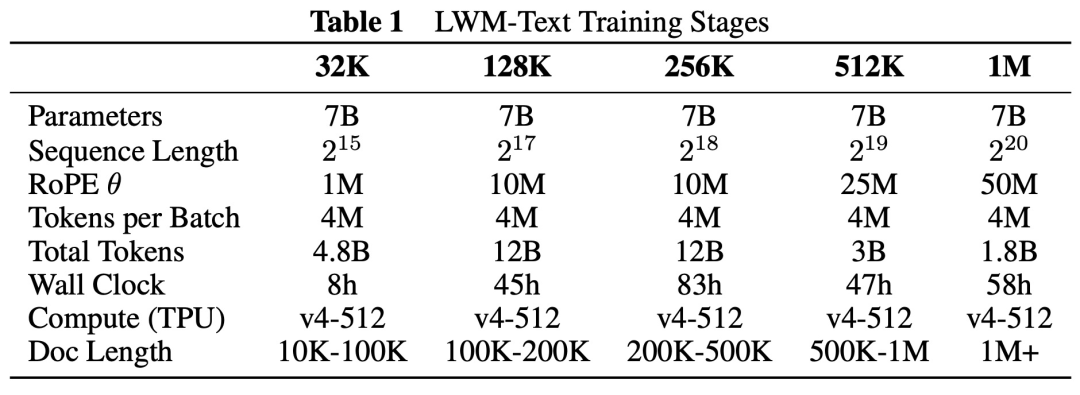

如下表 1 所示,為了擴展上下文窗口的長度,該研究采用漸進式訓練的方法。直觀地講,這使得模型可以通過首先學習較短范圍的依賴關(guān)系,然后再轉(zhuǎn)移到較長的序列上來節(jié)省計算量。

LWM 模型的整體架構(gòu)如下圖 4 所示,總體上講是一個數(shù)百萬長度 token 序列上的自回歸 transformer。視頻中的每個幀使用 VQGAN tokenized 為 256 個 token,這些 token 會與文本 token 連接起來,并輸入到 transformer 中,以自回歸方式預測下一個 token。輸入和輸出的順序反映了不同的訓練數(shù)據(jù)格式,包括圖像 - 文本、文本 - 圖像、視頻、文本 - 視頻和純文本格式。

實驗結(jié)果

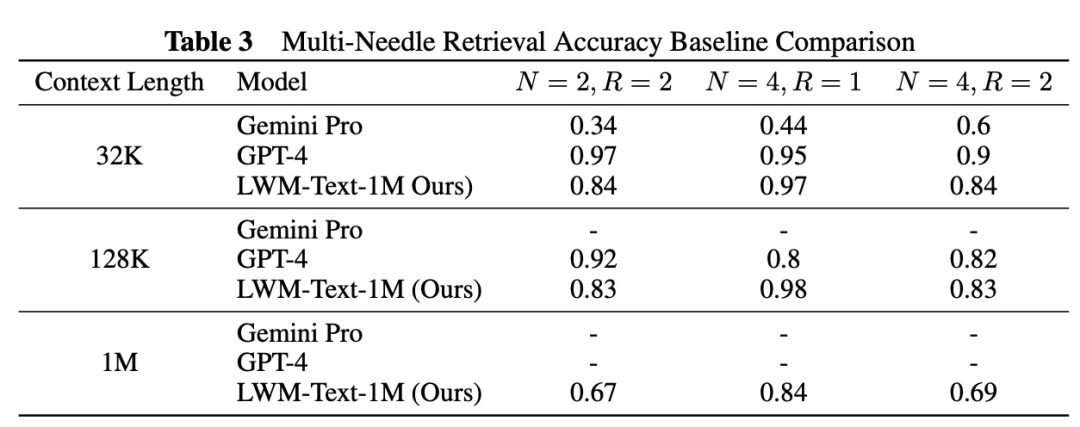

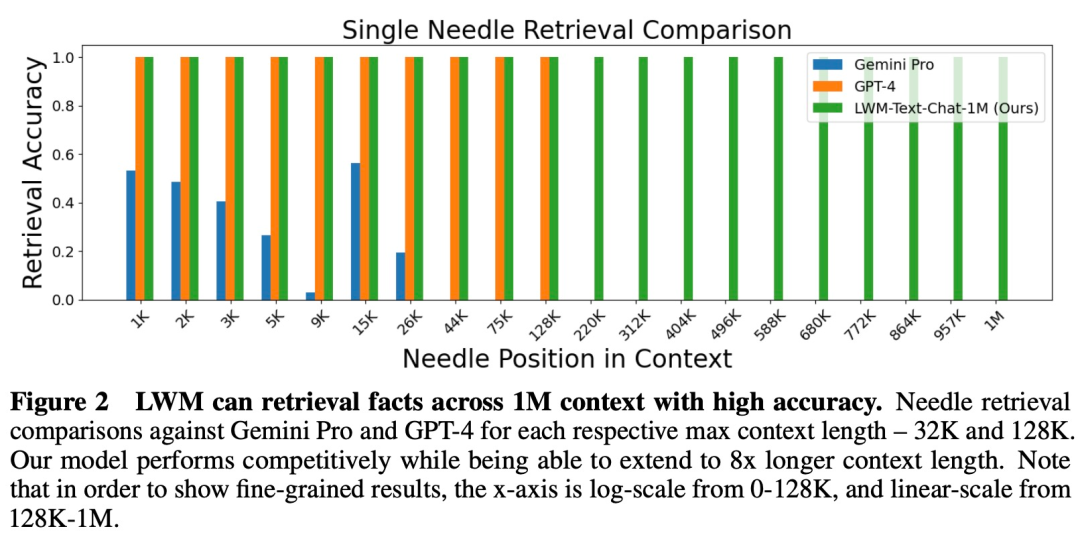

該研究將 LWM 與谷歌的 Gemini Pro 和 OpenAI 的 GPT-4 進行了實驗比較,實驗結(jié)果表明 LWM 模型在檢索方面能夠媲美 GPT-4,如下表 3 所示。

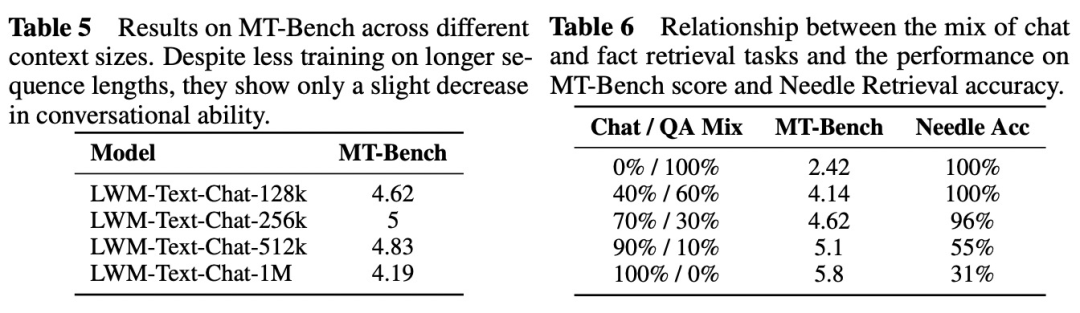

該研究還在 MT-Bench 上評估了模型的對話能力。表 5 顯示了模型獲得的 MT-Bench 分數(shù)。表 6 說明了模型的對話能力與事實檢索能力的關(guān)系。

在準確性方面,LWM 在上下文窗口為 1M 時優(yōu)于 GPT-4V 和 Gemini Pro。

感興趣的讀者可以閱讀論文原文,了解更多研究內(nèi)容。