大模型中幻覺緩解技術的綜合調查

大型語言模型(LLMs)是具有大量參數和數據的深度神經網絡,能夠在自然語言處理(NLP)領域實現多種任務,如文本理解和生成。近年來,隨著計算能力和數據規模的提升,LLMs取得了令人矚目的進展,如GPT-4、BART、T5等,展現了強大的泛化能力和創造力。

LLMs也存在嚴重的問題,在生成文本時容易產生與真實事實或用戶輸入不一致的內容,即幻覺(hallucination)。這種現象不僅會降低系統的性能,也會影響用戶的期望和信任,甚至會造成一些安全和道德上的風險。因此,如何檢測和緩解LLMs中的幻覺,已經成為了當前NLP領域的一個重要和緊迫的課題。

1月1日,來自于孟加拉國伊斯蘭科技大學、美國南卡羅來納大學人工智能研究所、美國斯坦福大學、美國亞馬遜人工智能部門的幾位科學家SM Towhidul Islam Tonmoy、SM Mehedi Zaman、Vinija Jain、Anku Rani、Vipula Rawte、Aman Chadha、Amitava Das發表了題為《A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models》的論文,旨在介紹和分類大型語言模型(LLMs)中的幻覺緩解技術。

他們首先介紹了幻覺的定義、原因和影響,以及評估方法。然后他們提出了一個詳細的分類體系,將幻覺緩解技術分為四大類:基于數據集的,基于任務的,基于反饋的,和基于檢索的。每一類中,他們又進一步細分了不同的子類,并舉例說明了一些代表性的方法。

作者們還分析了這些技術的優缺點,挑戰和局限性,以及未來的研究方向。他們指出,目前的技術仍然存在一些問題,如缺乏通用性,可解釋性,可擴展性,和魯棒性。他們建議,未來的研究應該關注以下幾個方面:開發更有效的幻覺檢測和量化方法,利用多模態信息和常識知識,設計更靈活和可定制的幻覺緩解框架,以及考慮人類的參與和反饋。

1.LLMs幻覺的分類體系

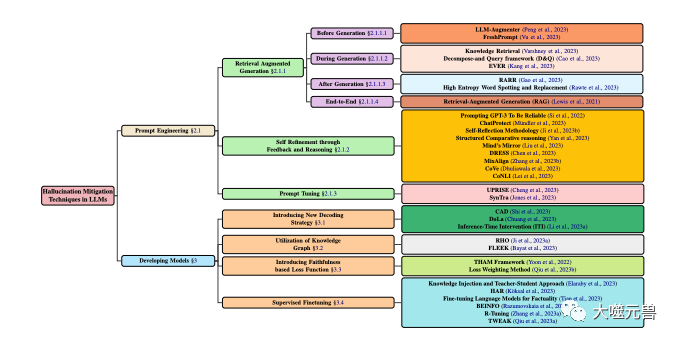

為了更好地理解和描述LLMs中的幻覺問題,他們提出了一個基于幻覺的來源、類型、程度和影響的分類體系,如圖1所示。他們認為,這個體系能夠覆蓋LLMs中幻覺的各個方面,有助于分析幻覺的原因和特征,以及評估幻覺的嚴重性和危害性。

圖1

圖1

LLM中幻覺緩解技術的分類,側重于涉及模型開發和提示技術的流行方法。模型開發分為各種方法,包括新的解碼策略、基于知識圖的優化、添加新的損失函數組件和監督微調。同時,提示工程可以包括基于檢索增強的方法、基于反饋的策略或提示調整。

幻覺的來源

幻覺的來源是指導致LLMs生成幻覺的根本原因,可以分為以下三類:

參數知識(Parametric Knowledge):LLMs在預訓練階段從大規模的無標注文本中學習到的隱式知識,如語法、語義、常識等。這種知識通常存儲在LLMs的參數中,可以通過激活函數和注意力機制來調用。參數知識是LLMs的基礎,但也可能是幻覺的來源,因為它可能包含一些不準確、過時或有偏見的信息,或者與用戶輸入的信息存在沖突。

非參數知識(Non-parametric Knowledge):LLMs在微調或生成階段從外部的有標注數據中獲取的顯式知識,如事實、證據、引用等。這種知識通常以結構化或非結構化的形式存在,可以通過檢索或內存機制來訪問。非參數知識是LLMs的補充,但也可能是幻覺的來源,因為它可能存在一些噪聲、錯誤或不完整的數據,或者與LLMs的參數知識不一致。

生成策略(Generation Strategy):指LLMs在生成文本時采用的一些技術或方法,如解碼算法、控制碼、提示等。這些策略是LLMs的工具,但也可能是幻覺的來源,因為它們可能導致LLMs過度依賴或忽視某些知識,或者在生成過程中引入一些偏差或噪聲。

幻覺的類型

幻覺的類型是指LLMs生成幻覺的具體表現形式,可以分為以下四類:

語法幻覺(Grammatical Hallucination):指LLMs生成的文本在語法上存在錯誤或不規范,如拼寫錯誤、標點錯誤、詞序錯誤、時態錯誤、主謂不一致等。這種幻覺通常是由于LLMs對語言規則的不完全掌握或對噪聲數據的過度擬合造成的。

語義幻覺(Semantic Hallucination):指LLMs生成的文本在語義上存在錯誤或不合理,如詞義錯誤、指代錯誤、邏輯錯誤、歧義、矛盾等。這種幻覺通常是由于LLMs對語言意義的不充分理解或對復雜數據的不足處理造成的。

知識幻覺(Knowledge Hallucination):指LLMs生成的文本在知識上存在錯誤或不一致,如事實錯誤、證據錯誤、引用錯誤、與輸入或上下文不匹配等。這種幻覺通常是由于LLMs對知識的不正確獲取或不恰當使用造成的。

創造幻覺(Creative Hallucination):指LLMs生成的文本在創造上存在錯誤或不適當,如風格錯誤、情感錯誤、觀點錯誤、與任務或目標不符合等。這種幻覺通常是由于LLMs對創造的不合理控制或不充分評估造成的。

幻覺的程度

幻覺的程度是指LLMs生成幻覺的數量和質量,可以分為以下三類:

輕微幻覺(Mild Hallucination):幻覺較少且較輕,不影響文本的整體可讀性和可理解性,也不損害文本的主要信息和目的。例如,LLMs生成了一些語法上的小錯誤,或者一些語義上的不明確,或者一些知識上的細節錯誤,或者一些創造上的微妙差異。

中等幻覺(Moderate Hallucination):幻覺較多且較重,影響文本的部分可讀性和可理解性,也損害文本的次要信息和目的。通常是LLMs生成了一些語法上的大錯誤,或者一些語義上的不合理。

嚴重幻覺(Severe Hallucination):幻覺非常多且非常重,影響文本的整體可讀性和可理解性,也破壞文本的主要信息和目的。

幻覺的影響

幻覺的影響是指LLMs生成幻覺對用戶和系統的潛在后果,可以分為以下三類:

無害幻覺(Harmless Hallucination):對用戶和系統沒有造成任何負面的影響,甚至可能有一些正面的影響,如增加趣味性、創造性、多樣性等。例如,LLMs生成了一些與任務或目標無關的內容,或者一些與用戶的偏好或期望相符的內容,或者一些與用戶的情緒或態度相契合的內容,或者一些與用戶的交流或互動有助的內容。

有害幻覺(Harmful Hallucination):對用戶和系統造成了一些負面的影響,如降低效率、準確性、可信度、滿意度等。例如,LLMs生成了一些與任務或目標不符合的內容,或者一些與用戶的偏好或期望不一致的內容,或者一些與用戶的情緒或態度不協調的內容,或者一些與用戶的交流或互動有礙的內容。

危害幻覺(Hazardous Hallucination):對用戶和系統造成了嚴重的負面的影響,如引發誤解、沖突、爭議、傷害等。例如,LLMs生成了一些與事實或證據相違背的內容,或者一些與道德或法律相沖突的內容,或者一些與人權或尊嚴相抵觸的內容,或者一些與安全或健康相威脅的內容。

2.LLMs幻覺的原因分析

為了更好地解決LLMs中的幻覺問題,我們需要深入分析導致幻覺的原因。根據前文提出的幻覺的來源,作者將幻覺的原因分為以下三類:

參數知識的不足或過剩:LLMs在預訓練階段,通常使用大量的無標注文本來學習語言的規則和知識,從而形成參數知識。然而這種知識可能存在一些問題,如不完整、不準確、不更新、不一致、不相關等,導致LLMs在生成文本時,無法充分理解和利用輸入的信息,或者無法正確區分和選擇輸出的信息,從而產生幻覺。另一方面參數知識也可能過于豐富或強大,使得LLMs在生成文本時,過度依賴或偏好自身的知識,而忽視或沖突輸入的信息,從而產生幻覺。

非參數知識的缺失或錯誤:LLMs在微調或生成階段,通常使用一些外部的有標注數據來獲取或補充語言的知識,從而形成非參數知識。這種知識可能存在一些問題,如稀缺、噪聲、錯誤、不完整、不一致、不相關等,導致LLMs在生成文本時,無法有效地檢索和融合輸入的信息,或者無法準確地驗證和糾正輸出的信息,從而產生幻覺。非參數知識也可能過于復雜或多樣,使得LLMs在生成文本時,難以平衡和協調不同的信息來源,或者難以適應和滿足不同的任務需求,從而產生幻覺。

生成策略的不恰當或不充分:LLMs在生成文本時,通常使用一些技術或方法來控制或優化生成的過程和結果,從而形成生成策略。這些策略可能存在一些問題,如不恰當、不充分、不穩定、不可解釋、不可信等,導致LLMs在生成文本時,無法有效地調節和指導生成的方向和質量,或者無法及時地發現和修正生成的錯誤,從而產生幻覺。生成策略也可能過于復雜或多變,使得LLMs在生成文本時,難以保持和保證生成的一致性和可靠性,或者難以評估和反饋生成的效果,從而產生幻覺。

3.LLMs幻覺的檢測方法和評測標準

為了更好地解決LLMs中的幻覺問題,我們需要有效地檢測和評估LLMs生成的幻覺。根據前文提出的幻覺的類型,作者將幻覺的檢測方法分為以下四類:

語法幻覺的檢測方法:利用一些語法檢查工具或規則,來識別和糾正LLMs生成的文本中的語法錯誤或不規范。例如,可以使用一些拼寫檢查、標點檢查、詞序檢查、時態檢查、主謂一致檢查等工具或規則,來檢測和修正LLMs生成的文本中的語法幻覺。

語義幻覺的檢測方法:利用一些語義分析工具或模型,來理解和評估LLMs生成的文本中的語義錯誤或不合理。例如,可以使用一些詞義分析、指代消解、邏輯推理、歧義消除、矛盾檢測等工具或模型,來檢測和修正LLMs生成的文本中的語義幻覺。

知識幻覺的檢測方法:利用一些知識檢索或驗證工具或模型,來獲取和比較LLMs生成的文本中的知識錯誤或不一致。例如,可以使用一些知識圖譜、搜索引擎、事實檢查、證據檢查、引用檢查等工具或模型,來檢測和修正LLMs生成的文本中的知識幻覺。

創造幻覺的檢測方法:利用一些創造評估或反饋工具或模型,來檢測和評價LLMs生成的文本中的創造錯誤或不適當。例如,可以使用一些風格分析、情感分析、創造評估、觀點分析、目標分析等工具或模型,來檢測和修正LLMs生成的文本中的創造幻覺。

根據前文提出的幻覺的程度和影響,我們可以將幻覺的評測標準分為以下四類:

語法正確性(Grammatical Correctness):指LLMs生成的文本在語法上是否符合語言的規則和習慣,如拼寫、標點、詞序、時態、主謂一致等。這個標準可以通過一些自動或人工的語法檢查工具或方法來評估,如BLEU、ROUGE、BERTScore等。

語義合理性(Semantic Reasonableness):指LLMs生成的文本在語義上是否符合語言的意義和邏輯,如詞義、指代、邏輯、歧義、矛盾等。這個標準可以通過一些自動或人工的語義分析工具或方法來評估,如METEOR、MoverScore、BERTScore等。

知識一致性(Knowledge Consistency):指LLMs生成的文本在知識上是否符合真實的事實或證據,或者與輸入或上下文的信息是否一致,如事實、證據、引用、匹配等。這個標準可以通過一些自動或人工的知識檢索或驗證工具或方法來評估,如FEVER、FactCC、BARTScore等。

創造適當性(Creative Appropriateness):指LLMs生成的文本在創造上是否符合任務或目標的要求,或者與用戶的偏好或期望是否相符,或者與用戶的情緒或態度是否協調,或者與用戶的交流或互動是否有助,如風格、情感、觀點、目標等。這個標準可以通過一些自動或人工的創造評估或反饋工具或方法來評估,如BLEURT、BARTScore、SARI等。

4.LLMs幻覺的緩解方法

為了更好地解決LLMs中的幻覺問題,我們需要有效地緩解和減少LLMs生成的幻覺。根據不同的層次和角度,作者將幻覺的緩解方法分為以下幾類:

后生成細化(Post-generation Refinement)

后生成細化是在LLMs生成文本后,對文本進行一些檢查和修正,以消除或減少幻覺。這類方法的優點是不需要對LLMs進行重新訓練或調整,可以直接應用于任何LLMs。這類方法的缺點是可能無法完全消除幻覺,或者可能引入新的幻覺,或者可能損失一些原始文本的信息或創造性。這類方法的代表有:

RARR(Refinement with Attribution and Retrieved References):(Chrysostomou和Aletras,2021)提出了一種基于歸因和檢索的細化方法,用于提高LLMs生成的文本的忠實度。使用一個歸因模型來識別LLMs生成的文本中的每個詞,是來自于輸入的信息還是來自于LLMs的參數知識,或者還是來自于LLMs的生成策略。使用一個檢索模型,來從外部的知識源中檢索一些與輸入的信息相關的參考文本。最后使用一個細化模型,來根據歸因結果和檢索結果,對LLMs生成的文本進行修正,以提高其與輸入的信息的一致性和可信度。

High Entropy Word Spotting and Replacement(HEWSR):(Zhang等,2021)提出了一種基于熵的細化方法,用于減少LLMs生成的文本中的幻覺。首先使用一個熵計算模型,來識別LLMs生成的文本中的高熵詞,即那些在生成時具有較高不確定性的詞。然后使用一個替換模型,來從輸入的信息或外部的知識源中選擇一個更合適的詞,來替換高熵詞。最后使用一個平滑模型,來對替換后的文本進行一些調整,以保持其語法和語義的連貫性。

ChatProtect(Chat Protection with Self-Contradiction Detection):(Wang等,2021)提出了一種基于自我矛盾檢測的細化方法,用于提高LLMs生成的聊天對話的安全性。首先使用一個矛盾檢測模型,來識別LLMs生成的對話中的自我矛盾,即那些與之前的對話內容相沖突的內容。然后使用一個替換模型,來從一些預定義的安全回復中選擇一個更合適的回復,來替換自我矛盾的回復。最后使用一個評估模型,來對替換后的對話進行一些評分,以衡量其安全性和流暢性。

反饋和推理的自我完善(Self-improvement with Feedback and Reasoning)

反饋和推理的自我完善是在LLMs生成文本的過程中,對文本進行一些評估和調整,以消除或減少幻覺。這類方法的優點是可以實時地監測和糾正幻覺,可以提高LLMs的自我學習和自我調節能力。這類方法的缺點是可能需要對LLMs進行一些額外的訓練或調整,或者可能需要一些外部的信息或資源。這類方法的代表有:

Self-Reflection Methodology(SRM):(Iyer等,2021)提出了一種基于自我反饋的完善方法,用于提高LLMs生成的醫學問答的可靠性。該方法首先使用一個生成模型,來根據輸入的問題和背景,生成一個初始的答案。然后使用一個反饋模型,來根據輸入的問題和背景,生成一個反饋問題,用于檢測初始答案中的潛在的幻覺。接著使用一個回答模型,來根據反饋問題,生成一個回答,用于驗證初始答案的正確性。最后使用一個修正模型,來根據回答的結果,對初始答案進行修正,以提高其可靠性和準確性。

Structured Comparative(SC)reasoning:(Yan等,2021)提出了一種基于結構化比較的推理方法,用于提高LLMs生成的文本偏好預測的一致性。該方法使用一個生成模型,來根據輸入的文本對,生成一個結構化的比較,即在不同的方面下,對文本對進行比較和評價。使用一個推理模型,來根據結構化的比較,生成一個文本偏好的預測,即選擇文本對中的哪一個更優。使用一個評估模型,來根據預測的結果,對生成的比較進行評估,以提高其一致性和可信度。

Think While Effectively Articulating Knowledge(TWEAK):(Qiu等,2021a)提出了一種基于假設驗證的推理方法,用于提高LLMs生成的知識到文本的忠實度。該方法使用一個生成模型,來根據輸入的知識,生成一個初始的文本。然后使用一個假設模型,來根據初始的文本,生成一些假設,即在不同的方面下,對文本的未來的文本進行預測。接著使用一個驗證模型,來根據輸入的知識,驗證每個假設的正確性。最后使用一個調整模型,來根據驗證的結果,對初始的文本進行調整,以提高其與輸入的知識的一致性和可信度。

新的解碼策略(New Decoding Strategy)

新的解碼策略是在LLMs生成文本的過程中,對文本的概率分布進行一些改變或優化,以消除或減少幻覺。這類方法的優點是可以直接影響生成的結果,可以提高LLMs的靈活性和效率。這類方法的缺點是可能需要對LLMs進行一些額外的訓練或調整,或者可能需要一些外部的信息或資源。這類方法的代表有:

Context-Aware Decoding(CAD):(Shi等,2021)提出了一種基于對比的解碼策略,用于減少LLMs生成的文本中的知識沖突。該策略使用一個對比模型,來計算LLMs在使用和不使用輸入的信息時,輸出的概率分布的差異。然后使用一個放大模型,來放大這個差異,使得與輸入的信息一致的輸出的概率更高,而與輸入的信息沖突的輸出的概率更低。最后使用一個生成模型,來根據放大后的概率分布,生成文本,以提高其與輸入的信息的一致性和可信度。

Decoding by Contrasting Layers(DoLa):(Chuang等,2021)提出了一種基于層對比的解碼策略,用于減少LLMs生成的文本中的知識幻覺。首先使用一個層選擇模型,來選擇LLMs中的某些層,作為知識層,即那些包含較多事實知識的層。然后使用一個層對比模型,來計算知識層和其他層在詞匯空間中的對數差異。最后使用一個生成模型,來根據層對比后的概率分布,生成文本,以提高其與事實知識的一致性和可信度。

知識圖譜的利用(Knowledge Graph Utilization)

知識圖譜的利用是在LLMs生成文本的過程中,利用一些結構化的知識圖譜,來提供或補充一些與輸入的信息相關的知識,以消除或減少幻覺。這類方法的優點是可以有效地獲取和融合外部的知識,可以提高LLMs的知識覆蓋和知識一致性。這類方法的缺點是可能需要對LLMs進行一些額外的訓練或調整,或者可能需要一些高質量的知識圖譜。這類方法的代表有:

RHO(Representation of linked entities and relation predicates from a Knowledge Graph):(Ji等,2021a)提出了一種基于知識圖譜的表示方法,用于提高LLMs生成的對話回復的忠實度。首先使用一個知識檢索模型,來從一個知識圖譜中檢索一些與輸入的對話相關的子圖,即包含一些實體和關系的圖。然后使用一個知識編碼模型,來對子圖中的實體和關系進行編碼,得到它們的向量表示。接著使用一個知識融合模型,來將知識的向量表示融合到對話的向量表示中,得到一個增強的對話表示。最后使用一個知識生成模型,來根據增強的對話表示,生成一個忠實的對話回復。

FLEEK(FactuaL Error detection and correction with Evidence Retrieved from external Knowledge):(Bayat等,2021)提出了一種基于知識圖譜的驗證和修正方法,用于提高LLMs生成的文本的事實性。該方法首先使用一個事實識別模型,來識別LLMs生成的文本中的潛在的可驗證的事實,即那些可以在知識圖譜中找到證據的事實。然后使用一個問題生成模型,來為每個事實生成一個問題,用于查詢知識圖譜。接著使用一個知識檢索模型,來從知識圖譜中檢索一些與問題相關的證據。最后使用一個事實驗證和修正模型,來根據證據,驗證和修正LLMs生成的文本中的事實,以提高其事實性和準確性。

基于忠實度的損失函數(Faithfulness-based Loss Function)

基于忠實度的損失函數是在LLMs訓練或微調的過程中,使用一些衡量生成文本與輸入信息或真實標簽之間一致性的指標,作為損失函數的一部分,以消除或減少幻覺。這類方法的優點是可以直接影響LLMs的參數優化,可以提高LLMs的忠實度和準確度。這類方法的缺點是可能需要對LLMs進行一些額外的訓練或調整,或者可能需要一些高質量的標注數據。這類方法的代表有:

Text Hallucination Mitigating(THAM)Framework:(Yoon等,2022)提出了一種基于信息論的損失函數,用于減少LLMs生成的視頻對話中的幻覺。首先使用一個對話語言模型,來計算對話的概率分布。然后使用一個幻覺語言模型,來計算幻覺的概率分布,即那些從輸入的視頻中無法獲取的信息的概率分布。接著使用一個互信息模型,來計算對話和幻覺的互信息,即對話中包含幻覺的程度互信息。最后使用一個交叉熵模型,來計算對話和真實標簽的交叉熵,即對話的準確性。該損失函數的目標是最小化互信息和交叉熵的和,從而減少對話中的幻覺和錯誤。

Factual Error Correction with Evidence Retrieved from external Knowledge(FECK):(Ji等,2021b)提出了一種基于知識證據的損失函數,用于提高LLMs生成的文本的事實性。首先使用一個知識檢索模型,來從一個知識圖譜中檢索一些與輸入的文本相關的子圖,即包含一些實體和關系的圖。然后使用一個知識編碼模型,來對子圖中的實體和關系進行編碼,得到它們的向量表示。接著使用一個知識對齊模型,來對齊LLMs生成的文本中的實體和關系,與知識圖譜中的實體和關系,得到它們的匹配程度。最后,該損失函數使用一個知識損失模型,來計算LLMs生成的文本中的實體和關系,與知識圖譜中的實體和關系,之間的距離,即事實的偏差。該損失函數的目標是最小化知識損失,從而提高LLMs生成的文本的事實性和準確性。

提示微調(Prompt Tuning)

提示微調是在LLMs生成文本的過程中,使用一些特定的文本或符號,作為輸入的一部分,來控制或引導LLMs的生成行為,以消除或減少幻覺。這類方法的優點是可以有效地調節和指導LLMs的參數知識,可以提高LLMs的適應性和靈活性。這類方法的缺點是可能需要對LLMs進行一些額外的訓練或調整,或者可能需要一些高質量的提示。這類方法的代表有:

UPRISE(Universal Prompt-based Refinement for Improving Semantic Equivalence):(Chen等,2021)提出了一種基于通用提示的微調方法,用于提高LLMs生成的文本的語義等價性。首先使用一個提示生成模型,來根據輸入的文本,生成一個通用的提示,即一些用于引導LLMs生成語義等價的文本的文本或符號。然后使用一個提示微調模型,來根據輸入的文本和提示,微調LLMs的參數,使其更傾向于生成與輸入的文本語義等價的文本。最后,該方法使用一個提示生成模型,來根據微調后的LLMs的參數,生成一個語義等價的文本。

SynTra(Synthetic Task for Hallucination Mitigation in Abstractive Summarization):(Wang等,2021)提出了一種基于合成任務的微調方法,用于減少LLMs生成的摘要中的幻覺。首先使用一個合成任務生成模型,來根據輸入的文本,生成一個合成的任務,即一個用于檢測摘要中的幻覺的問題。然后使用一個合成任務微調模型,來根據輸入的文本和任務,微調LLMs的參數,使其更傾向于生成與輸入的文本一致的摘要。最后使用一個合成任務生成模型,來根據微調后的LLMs的參數,生成一個一致的摘要。

5.LLMs幻覺的挑戰和局限性

盡管LLMs中的幻覺緩解技術已經取得了一些進展,但仍然存在一些挑戰和局限性,需要進一步的研究和探索。以下是一些主要的挑戰和局限性:

幻覺的定義和度量:沒有一個統一和明確的定義和度量,不同的研究可能使用不同的標準和指標,來判斷和評估LLMs生成的文本中的幻覺。這導致了一些不一致和不可比較的結果,也影響了LLMs中幻覺問題的理解和解決。因此,需要建立一個通用和可靠的幻覺的定義和度量,以便于對LLMs中的幻覺進行有效的檢測和評估。

幻覺的數據和資源:缺乏一些高質量和大規模的數據和資源,來支持LLMs中幻覺的研究和開發。例如,缺乏一些包含幻覺標注的數據集,來訓練和測試LLMs中幻覺的檢測和緩解方法;缺乏一些包含真實事實和證據的知識源,來提供和驗證LLMs生成的文本中的知識;缺乏一些包含用戶反饋和評價的平臺,來收集和分析LLMs生成的文本中的幻覺的影響。因此,需要構建一些高質量和大規模的數據和資源,以便于對LLMs中的幻覺進行有效的研究和開發。

幻覺的原因和機制:沒有一個深入和全面的原因和機制的分析,來揭示和解釋LLMs為什么會產生幻覺,以及幻覺是如何在LLMs中形成和傳播的。例如,不清楚LLMs中的參數知識、非參數知識和生成策略是如何相互影響和作用的,以及它們是如何導致不同類型、程度和影響的幻覺的。因此,需要進行一些深入和全面的原因和機制的分析,以便于對LLMs中的幻覺進行有效的預防和控制。

幻覺的解決和優化:沒有一個完善和通用的解決和優化的方案,來消除或減少LLMs生成的文本中的幻覺,以及提高LLMs生成的文本的質量和效果。例如,不清楚如何在不損失LLMs的泛化能力和創造力的前提下,提高LLMs的忠實度和準確度。因此,需要設計一些完善和通用的解決和優化的方案,以便于提高LLMs生成的文本的質量和效果。