467億參數MoE追平GPT-3.5!爆火開源Mixtral模型細節首公開,中杯逼近GPT-4

今天,Mistral AI正式放出了Mixtral 8x7B的技術細節——

在大多數基準測試中,Mixtral的表現不僅優于Llama 2 70B,而且推理速度提高了整整6倍!

尤其是,它在大多數標準基準測試上與GPT-3.5打平,甚至略勝一籌。

新開源的Mixtral 8x7B自帶了一些出色的表現:

比如可以很好地處理32k長度的上下文,支持英語、法語、意大利語、德語和西班牙語,且在代碼生成方面表現出強大的性能。

另外,它可以微調為指令跟隨模型(instruction-following model),在MT-Bench上獲得了8.3分的好成績。

467億參數打平GPT-3.5

Mixtral是基于decoder-only架構的稀疏專家混合網絡。

它的前饋模塊從8組不同的參數中進行選擇。在每一層網絡中,對于每個token,路由器網絡選擇8組中的兩組(專家),來處理token并將其輸出累加組合。

這種技術增加了模型的參數數量,同時控制了成本和延遲,因為模型只使用每個token參數集總數的一小部分。

Mixtral有46.7B的總參數量,但每個token只使用其中12.9B參數。因此,Mixtral的實際執行速度和所需的成本,都只相當于一個12.9B的模型。

Mixtral根據從開放網絡中提取的數據進行預訓練——包括訓練專家網絡和路由模塊。

性能實測

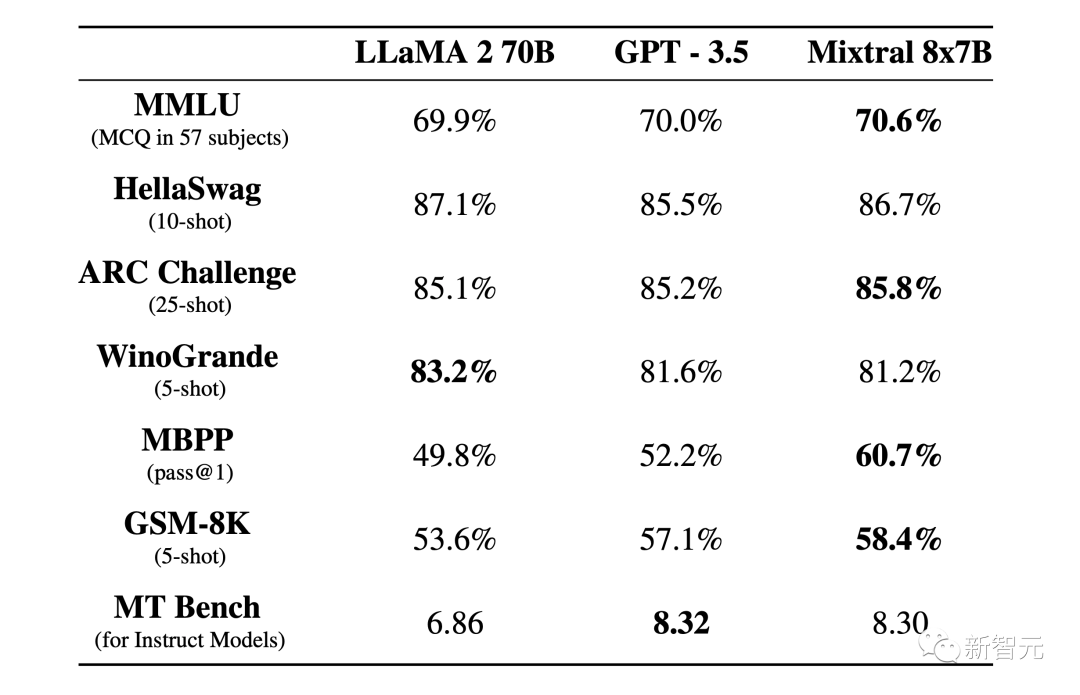

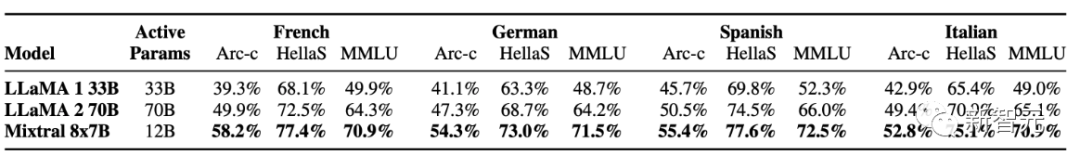

如下圖所示,在大多數基準測試中,Mixtral與Llama 2 70B和GPT-3.5表現相當,其中的幾項測試結果還要優于另外兩個模型。

圖片

圖片

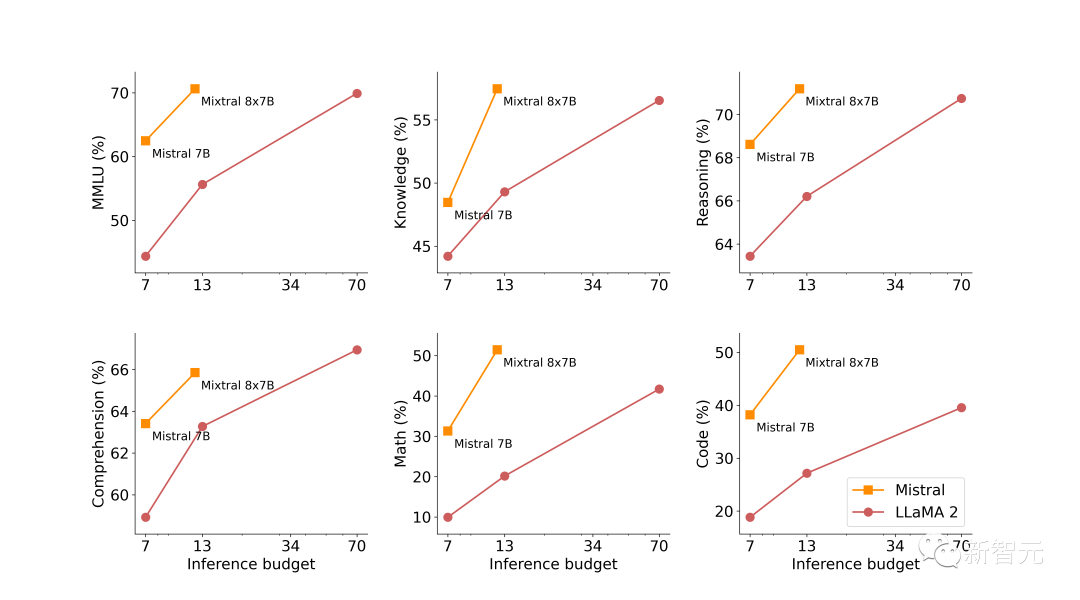

下圖展示了模型生成質量與推理消耗成本的關系。與Llama 2相比,Mistral 7B和Mixtral 8x7B表現出自己高能效的優勢。

圖片

圖片

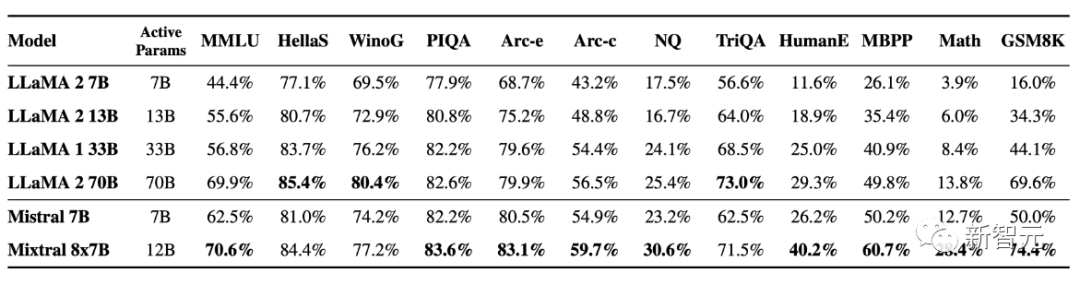

更加詳細的比較結果看下面的表格:

圖片

圖片

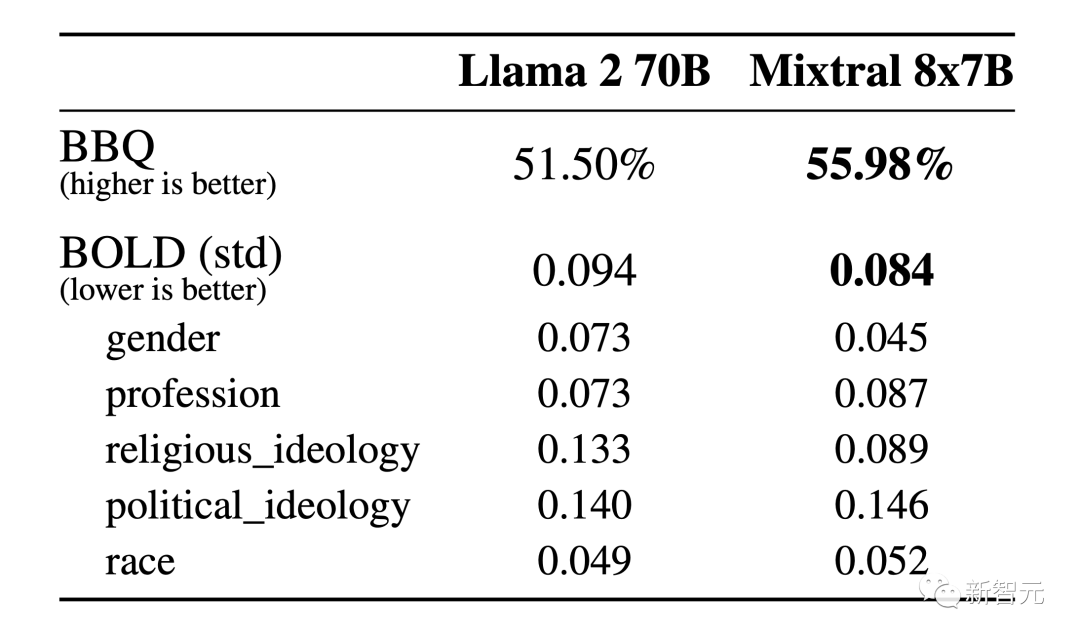

下面來看下模型在幻覺和偏見問題上的表現。

公平起見,為了避免微調或者偏好建模帶來的影響,這里使用BBQ和BOLD來測試基本模型的性能。

圖片

圖片

從上面的結果可以看出,與Llama 2相比,Mixtral更真實,并且在BBQ基準上表現出更少的偏差。

另外,Mixtral在BOLD上表現出比Llama 2更積極的情緒,每個維度的差異相似。

圖片

圖片

上表中,在各種支持的語言上與Llama 2進行PK,Mixtral 8x7B可以說是「精通」法語、德語、西班牙語、意大利語和英語。

本次發布的Mixtral 8x7B Instruct和Mixtral 8x7B,已通過監督微調和直接偏好優化(DPO)進行了優化,并實現了指令的跟隨。

在MT-Bench上,它的得分達到了8.30——是目前開源模型的最好成績,性能可與GPT-3.5相媲美。

用戶還可以通過提示的方式,進一步約束Mixtral,從而構建一些需要嚴格審核級別的應用程序。

另外,為了使社區能夠使用完全開源的堆棧運行Mixtral,開發人員提交了對vLLM項目的更新,并集成了Megablocks CUDA內核以實現高效推理。

逼近GPT-4,「中杯」開啟內測

與此同時,Mistral AI還開放了首個平臺服務的測試版——la plateforme。

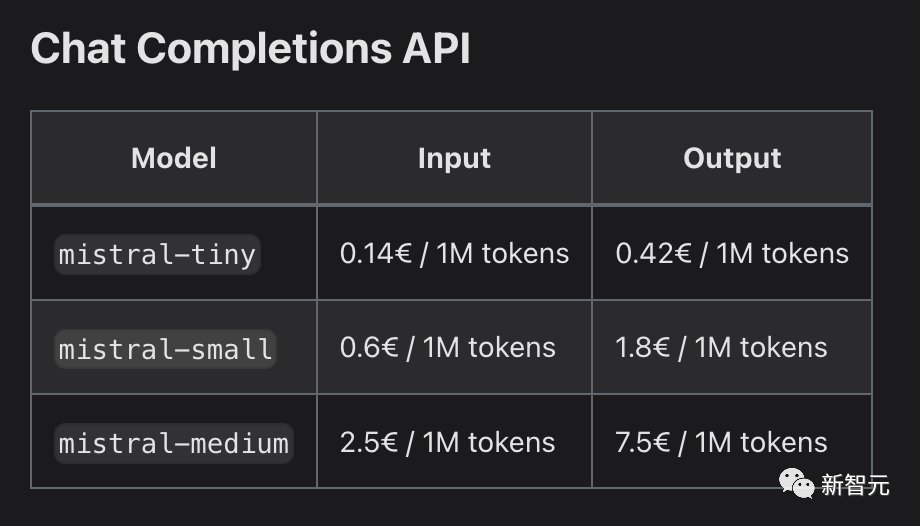

其中,平臺提供了三個基于指令生成文本的聊天模型,以及一個嵌入模型。

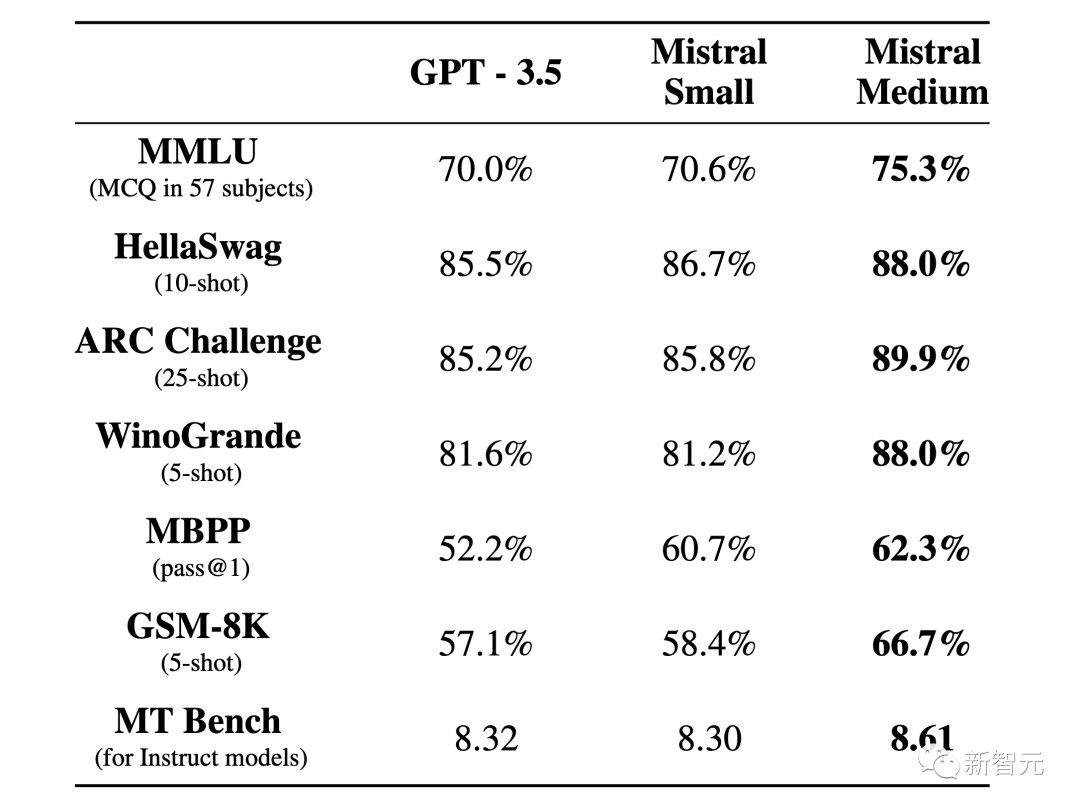

目前,mistral-tiny和mistral-small已經正式發布,而性能更強的mistral-medium還處在測試階段。

這些模型首先在開放網絡抽取的數據上進行預訓練,隨后通過標注進行指令微調,并融合了最為有效的對齊技術(如高效微調、直接偏好優化)。

- Mistral-tiny

基于Mistral 7B Instruct v0.2的Mistral-tiny是最具性價比的模型,它在MT-Bench上的得分為7.6,但僅支持英語。

- Mistral-small

作為最新開源的模型,Mixtral 8x7B在MT-Bench上的得分達到了8.3,并支持英語、法語、意大利語、德語、西班牙語和代碼生成。

- Mistral-medium

這是Mistral AI推出的最強開源模型,雖然目前還處在原型階段,但它在主流評測上已經可以實現對GPT-3.5的碾壓了!

Mistral-medium在MT-Bench上拿下了8.6的高分,同樣支持英語、法語、意大利語、德語、西班牙語和代碼生成。

圖片

圖片

- Mistral-embed

除了文本生成模型外,Mistral還提供了一個具有1024嵌入維度的嵌入模型。

在設計模型時,團隊著重增強了它的檢索功能,從而在MTEB上實現了高達55.26的檢索得分。

從測試到全面開放

從今天起,任何人都可以注冊并使用Mistral的API。

該API與其主要競品類似,并且支持Python和Javascript客戶端庫,從而讓用戶可以方便地檢查模型端點。

此外,Mistral還允許用戶設置系統提示,以便在模型輸出中實施更高級別的內容審查。這一功能對于某些應用來說非常重要。

不過,由于平臺還處在測試階段,使用過程中可能會出現一些小的問題。

致謝

感謝英偉達在TensorRT-LLM和Triton的整合,以及使專家稀疏混合模型與TRT-LLM兼容方面,提供的支持。

網友熱議

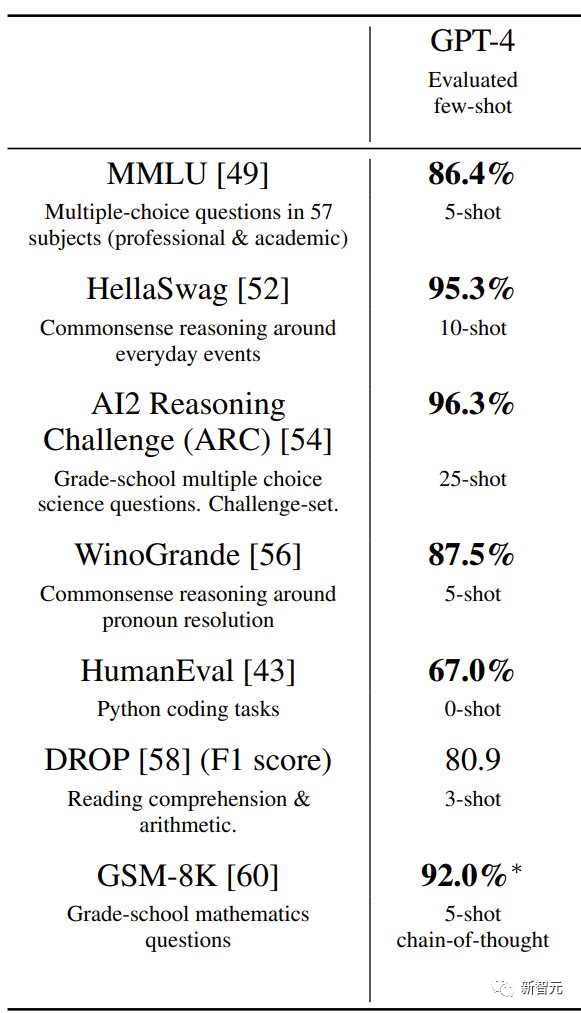

鑒于Mistral-Medium的強力表現,有網友翻出了GPT-4在相關測試中的分數:

圖片

圖片

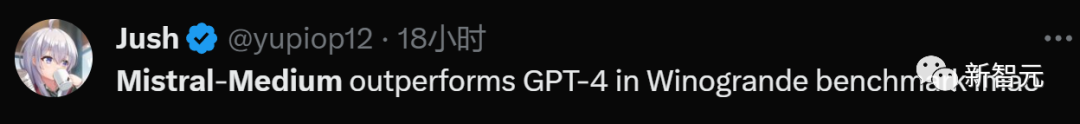

結果,Mistral-Medium在Winogrande基準測試中優于GPT-4。

由于Mistral-Medium的能力貌似可與GPT-4一戰,所以有網友自然開始比較兩者的價格。

圖片

圖片

圖片

圖片

這位網友表示Mistral-Medium的價格約為GPT4-turbo價格的1/4,比自己預期的要昂貴。

對此,也有網友表示反對:「恕我直言,這個價格很公道。小規模模型和GPT-3.5相當,并且更便宜。中等的價格則要高很多,但仍然只有GPT4-turbo的1/4。」

圖片

圖片

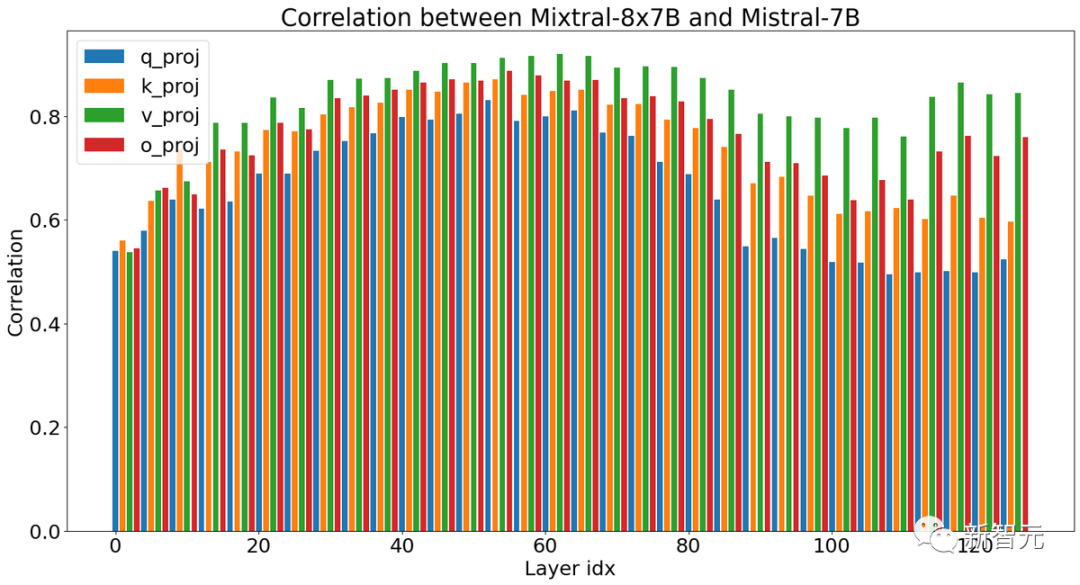

另外也有網友討論和猜測新的Mixtral 8x7B的技術內幕:

圖片

圖片

通過比較Mixtral 8x7B和Mistral 7B每層的相似度,這位網友指出Mistral可能已經大規模地進行了稀疏的升級再造工作。

圖片

圖片

「兩個模型的權重之間的顯著相關性證明了模型的成功重用。這種方法可以賦予OSS社區自己強大的MoE!希望我們能盡快看到類似于GPT-4的開源質量!」