精確率提升7.8%!首個(gè)多模態(tài)開放世界檢測大模型MQ-Det登NeurIPS 2023

目前的開放世界目標(biāo)檢測模型大多遵循文本查詢的模式,即利用類別文本描述在目標(biāo)圖像中查詢潛在目標(biāo),但這種方式往往會(huì)面臨「廣而不精」的問題。

論文鏈接:https://arxiv.org/abs/2305.18980

代碼地址:https://github.com/YifanXu74/MQ-Det

為此,中科院自動(dòng)化等機(jī)構(gòu)的研究人員提出了基于多模態(tài)查詢的目標(biāo)檢測MQ-Det,以及首個(gè)同時(shí)支持文本描述和視覺示例查詢的開放世界檢測大模型。

MQ-Det在已有基于文本查詢的檢測大模型基礎(chǔ)上,加入了視覺示例查詢功能。通過引入即插即用的門控感知結(jié)構(gòu),以及以視覺為條件的掩碼語言預(yù)測訓(xùn)練機(jī)制,使得檢測器在保持高泛化性的同時(shí)支持細(xì)粒度的多模態(tài)查詢,為用戶提供更靈活的選擇來適應(yīng)不同的場景。

其簡單有效的設(shè)計(jì)與現(xiàn)有主流的檢測大模型均兼容,適用范圍非常廣泛。

實(shí)驗(yàn)表明,多模態(tài)查詢能夠大幅度推動(dòng)主流檢測大模型的開放世界目標(biāo)檢測能力,例如在基準(zhǔn)檢測數(shù)據(jù)集LVIS上,無需下游任務(wù)模型微調(diào),提升主流檢測大模型GLIP精度約7.8%AP,在13個(gè)基準(zhǔn)小樣本下游任務(wù)上平均提高了6.3% AP。

從文本查詢到多模態(tài)查詢

一圖勝千言

隨著圖文預(yù)訓(xùn)練的興起,借助文本的開放語義,目標(biāo)檢測逐漸步入了開放世界感知的階段。

為此,許多檢測大模型都遵循了文本查詢的模式,即利用類別文本描述在目標(biāo)圖像中查詢潛在目標(biāo)。

然而,這種方式往往會(huì)面臨「廣而不精」的問題。

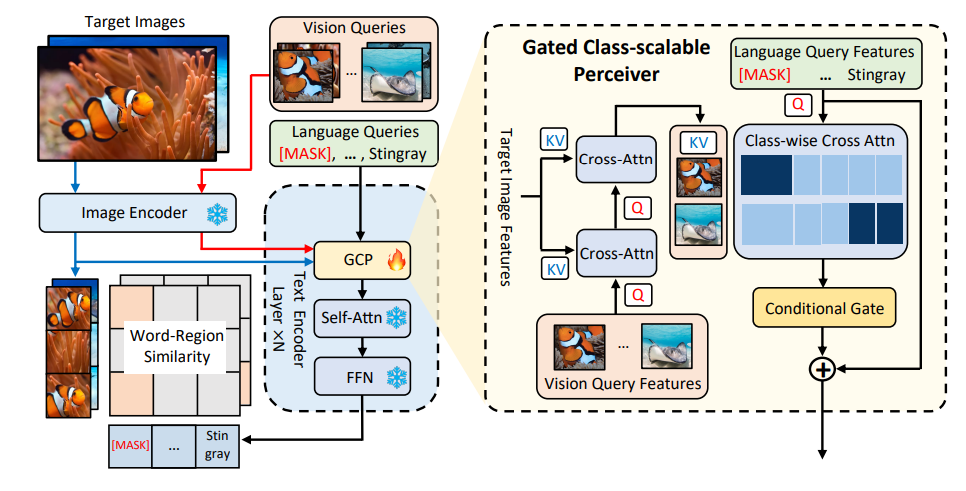

圖1 MQ-Det方法架構(gòu)圖

例如,圖1中的細(xì)粒度物體(魚種)檢測,往往很難用有限的文本來描述各種細(xì)粒度的魚種;類別歧義,bat既可指蝙蝠又可指拍子。

然而,以上的問題均可通過圖像示例來解決,相比文本,圖像能夠提供目標(biāo)物體更豐富的特征線索,但同時(shí)文本又具備強(qiáng)大的泛化性。

由此,如何能夠有機(jī)地結(jié)合兩種查詢方式,成為了一個(gè)很自然地想法。

獲取多模態(tài)查詢能力的難點(diǎn):如何得到這樣一個(gè)具備多模態(tài)查詢的模型,存在三個(gè)挑戰(zhàn):

1. 直接用有限的圖像示例進(jìn)行微調(diào)很容易造成災(zāi)難性遺忘;

2. 從頭訓(xùn)練一個(gè)檢測大模型會(huì)具備較好的泛化性但是消耗巨大,例如,單卡訓(xùn)練GLIP[1]需要利用3000萬數(shù)據(jù)量訓(xùn)練480 天。

多模態(tài)查詢目標(biāo)檢測:基于以上考慮,作者提出了一種簡單有效的模型設(shè)計(jì)和訓(xùn)練策略——MQ-Det

MQ-Det在已有凍結(jié)的文本查詢檢測大模型基礎(chǔ)上插入少量門控感知模塊(GCP)來接收視覺示例的輸入,同時(shí)設(shè)計(jì)了視覺條件掩碼語言預(yù)測訓(xùn)練策略高效地得到高性能多模態(tài)查詢的檢測器。

MQ-Det:即插即用的多模態(tài)查詢模型架構(gòu)

門控感知模塊

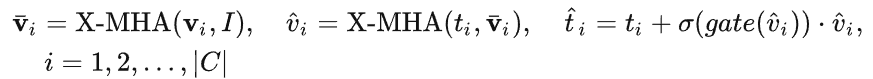

如圖1所示,作者在已有凍結(jié)的文本查詢檢測大模型的文本編碼器端逐層插入了門控感知模塊(GCP),GCP的工作模式可以用下面公式簡潔地表示:

對于第i個(gè)類別,輸入視覺示例 v_i,其首先和目標(biāo)圖像  進(jìn)行交叉注意力( X-MHA)得到

進(jìn)行交叉注意力( X-MHA)得到 以增廣其表示能力,而后每個(gè)類別文本 t_i 會(huì)和對應(yīng)類別的視覺示例

以增廣其表示能力,而后每個(gè)類別文本 t_i 會(huì)和對應(yīng)類別的視覺示例  進(jìn)行交叉注意力得到

進(jìn)行交叉注意力得到  ,之后通過一個(gè)門控模塊gate 將原始文本 t_i 和視覺增廣后文本

,之后通過一個(gè)門控模塊gate 將原始文本 t_i 和視覺增廣后文本  融合,得到當(dāng)前層的輸出

融合,得到當(dāng)前層的輸出

這樣的簡單設(shè)計(jì)遵循了三點(diǎn)原則:(1)類別可擴(kuò)展性;(2)語義補(bǔ)全性;(3)抗遺忘性,具體討論可見原文。

MQ-Det高效訓(xùn)練策略

基于凍結(jié)語言查詢檢測器的調(diào)制訓(xùn)練

由于目前文本查詢的預(yù)訓(xùn)練檢測大模型本身就具備較好的泛化性,作者認(rèn)為,只需要在原先文本特征基礎(chǔ)上用視覺細(xì)節(jié)進(jìn)行輕微地調(diào)整即可。

在文章中也有具體的實(shí)驗(yàn)論證發(fā)現(xiàn),打開原始預(yù)訓(xùn)練模型參數(shù)后進(jìn)行微調(diào)很容易帶來災(zāi)難性遺忘的問題,反而失去了開放世界檢測的能力。

由此,MQ-Det在凍結(jié)文本查詢的預(yù)訓(xùn)練檢測器基礎(chǔ)上,僅調(diào)制訓(xùn)練插入的GCP模塊,就可以高效地將視覺信息插入到現(xiàn)有文本查詢的檢測器中。

在文章中,作者分別將MQ-Det的結(jié)構(gòu)設(shè)計(jì)和訓(xùn)練技術(shù)應(yīng)用于目前的SOTA模型GLIP[1]和GroundingDINO[2],來驗(yàn)證方法的通用性。

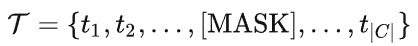

以視覺為條件的掩碼語言預(yù)測訓(xùn)練策略

作者還提出了一種視覺為條件的掩碼語言預(yù)測訓(xùn)練策略,來解決凍結(jié)預(yù)訓(xùn)練模型帶來的學(xué)習(xí)惰性的問題。

所謂學(xué)習(xí)惰性,即指檢測器在訓(xùn)練過程中傾向于保持原始文本查詢的特征,從而忽視新加入的視覺查詢特征。

為此,MQ-Det在訓(xùn)練時(shí)隨機(jī)地用[MASK] token來替代文本token,迫使模型向視覺查詢特征側(cè)學(xué)習(xí),即:

這個(gè)策略雖然簡單,但是卻十分有效,從實(shí)驗(yàn)結(jié)果來看這個(gè)策略帶來了顯著的性能提升。

實(shí)驗(yàn)結(jié)果

Finetuning-free

相比傳統(tǒng)零樣本(zero-shot)評估僅利用類別文本進(jìn)行測試,MQ-Det提出了一種更貼近實(shí)際的評估策略:finetuning-free

其定義為:在不進(jìn)行任何下游微調(diào)的條件下,用戶可以利用類別文本、圖像示例、或者兩者結(jié)合來進(jìn)行目標(biāo)檢測。

在finetuning-free的設(shè)定下,MQ-Det對每個(gè)類別選用了5個(gè)視覺示例,同時(shí)結(jié)合類別文本進(jìn)行目標(biāo)檢測,而現(xiàn)有的其他模型不支持視覺查詢,只能用純文本描述進(jìn)行目標(biāo)檢測。

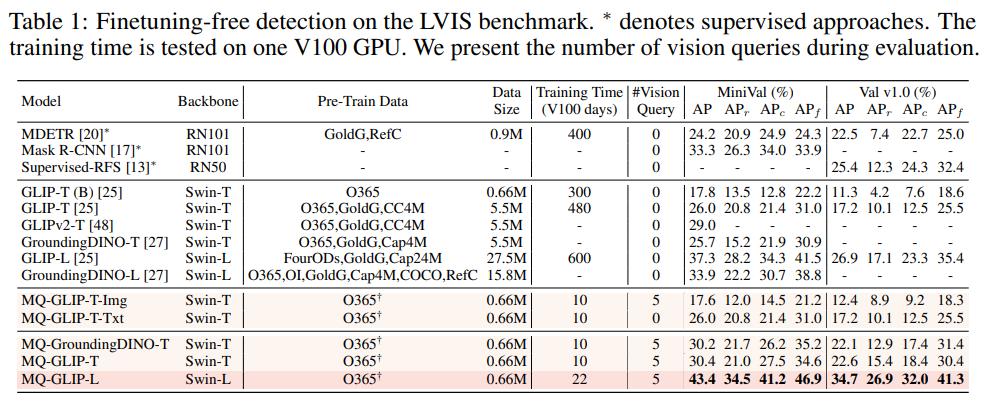

下表展示了在LVIS MiniVal和LVIS v1.0上的檢測結(jié)果。可以發(fā)現(xiàn),多模態(tài)查詢的引入大幅度提升了開放世界目標(biāo)檢測能力。

表1 各個(gè)檢測模型在LVIS基準(zhǔn)數(shù)據(jù)集下的finetuning-free表現(xiàn)

從表1可以看到,MQ-GLIP-L在GLIP-L基礎(chǔ)上提升了超過7%AP,效果十分顯著!

Few-shot評估

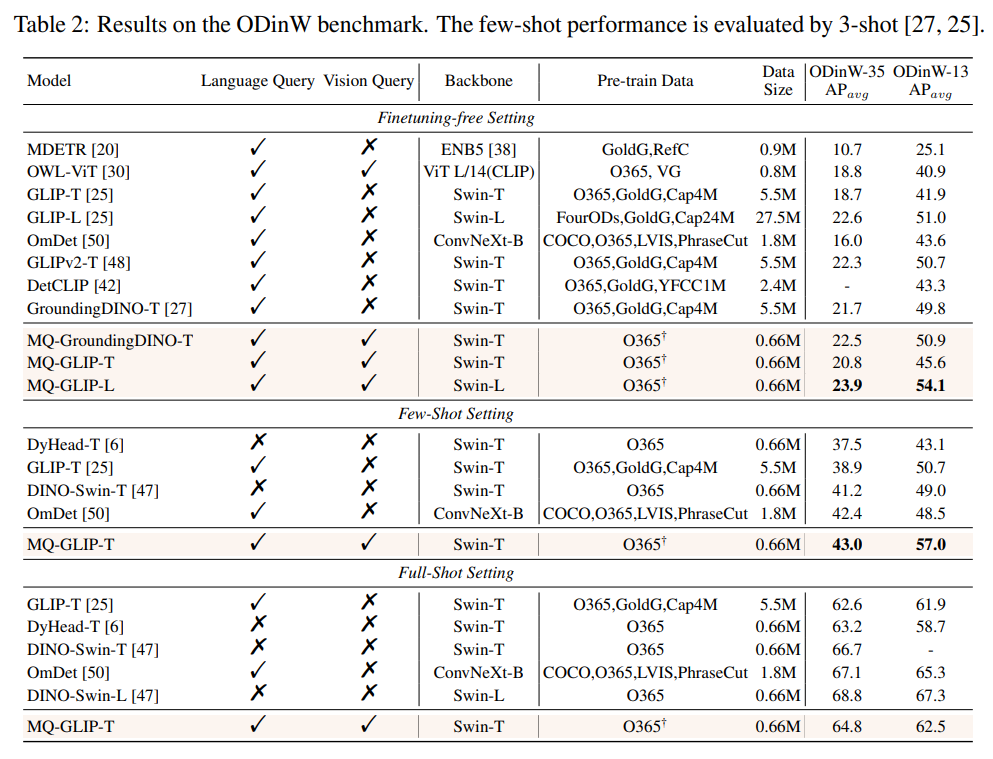

表2 各個(gè)模型在35個(gè)檢測任務(wù)ODinW-35以及其13個(gè)子集ODinW-13中的表現(xiàn)

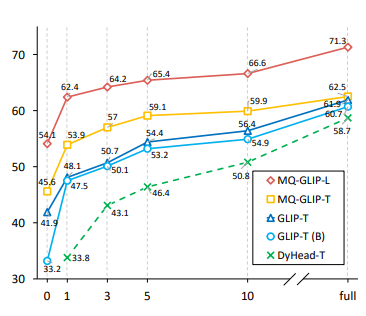

作者還進(jìn)一步在下游35個(gè)檢測任務(wù)ODinW-35中進(jìn)行了全面的實(shí)驗(yàn)。由表2可以看到,MQ-Det除了強(qiáng)大的finetuning-free表現(xiàn),還具備良好的小樣本檢測能力,進(jìn)一步印證了多模態(tài)查詢的潛力。圖2也展示了MQ-Det對于GLIP的顯著提升。

圖2 數(shù)據(jù)利用效率對比;橫軸:訓(xùn)練樣本數(shù)量,縱軸:OdinW-13上的平均AP

多模態(tài)查詢目標(biāo)檢測的前景

目標(biāo)檢測作為一個(gè)以實(shí)際應(yīng)用為基礎(chǔ)的研究領(lǐng)域,非常注重算法的落地。

盡管以往的純文本查詢目標(biāo)檢測模型展現(xiàn)出了良好的泛化性,但是在實(shí)際的開放世界檢測中文本很難涵蓋細(xì)粒度的信息,而圖像中豐富的信息粒度完美地補(bǔ)全了這一環(huán)。

至此我們能夠發(fā)現(xiàn),文本泛而不精,圖像精而不泛,如果能夠有效地結(jié)合兩者,即多模態(tài)查詢,將會(huì)推動(dòng)開放世界目標(biāo)檢測進(jìn)一步向前邁進(jìn)。

MQ-Det在多模態(tài)查詢上邁出了第一步嘗試,其顯著的性能提升也昭示著多模態(tài)查詢目標(biāo)檢測的巨大潛力。

同時(shí),文本描述和視覺示例的引入為用戶提供了更多的選擇,使得目標(biāo)檢測更加靈活和用戶友好。