圖文并茂,三步速出「原神」文稿!首個70億參數圖文混合創作大模型正式開源,一鍵生成神作

解放雙手,動嘴碼字時代真的來了。

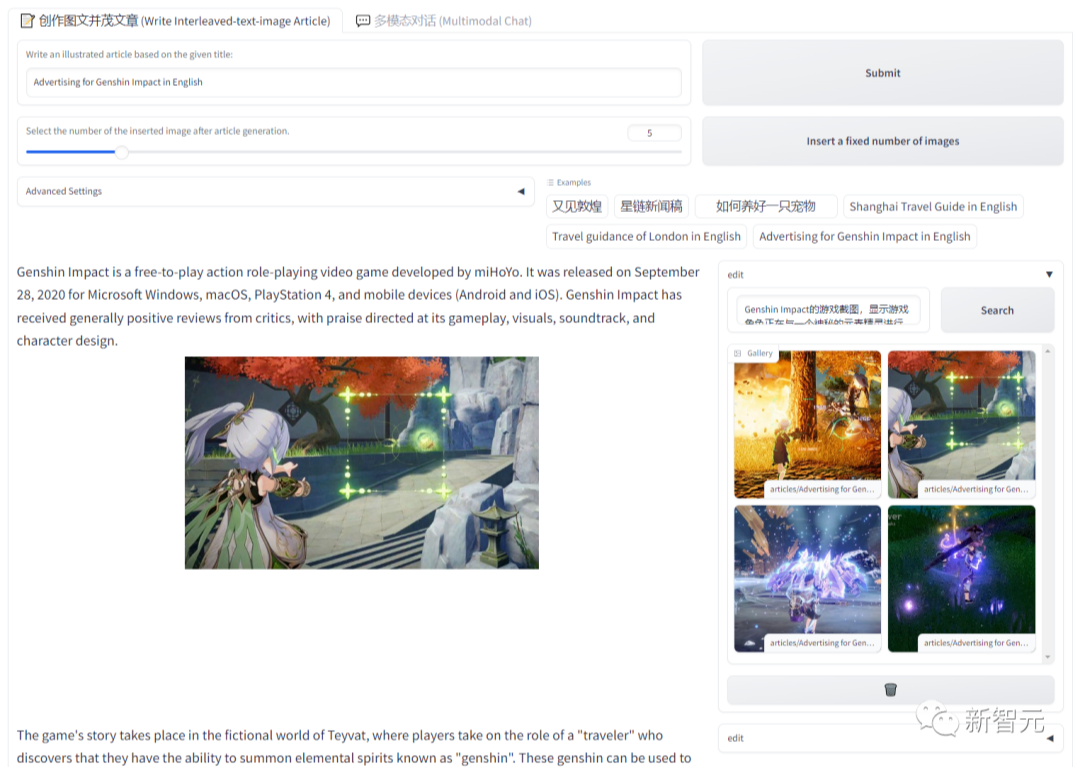

當你想寫一份「原神」的宣傳文稿時,根本完全不用上網翻找收集各種材料,只需要給模型一個指令「幫我以原神為題寫一篇文章」。

游戲背景現、上市時間、影響力等要點已經成文。接下來,你還可以讓LLM自動插入趣味、生動的配圖。

一眨眼的功夫,專屬定制的神作就完成了。

那么,究竟是什么模型有如此神力?

它就是,書生·浦語靈筆(InternLM-XComposer,以下簡稱「浦語靈筆」)。這是上海人工智能實驗室(上海AI實驗室)推出的首個圖文混合創作大模型。

依托強大的多模態性能,可以解鎖「一鍵生成」圖文混合文章的創作能力,為大模型落地應用提供更多可能。

目前,浦語靈筆已開源其中的智能創作和對話(InternLM-XComposer-7B)及多任務預訓練(InternLM-XComposer-VL-7B)版本,并提供免費商用。

開源鏈接:https://github.com/InternLM/InternLM-XComposer

技術報告:https://arxiv.org/abs/2309.15112

今年7月以來,上海AI實驗室陸續開源了書生·浦語大語言模型的7B(InterLM-7B)及20B(InternLM-20B)版本,為業界提供了完整的大模型研發與應用基座,以及全鏈條工具體系。

基于書生·浦語大語言模型(InternLM),浦語靈筆接受視覺和語言模態輸入,不僅在圖文對話方面表現優秀,更具備圖文并茂文章的「一鍵生成」能力。

準確圖文理解,一鍵圖文并茂

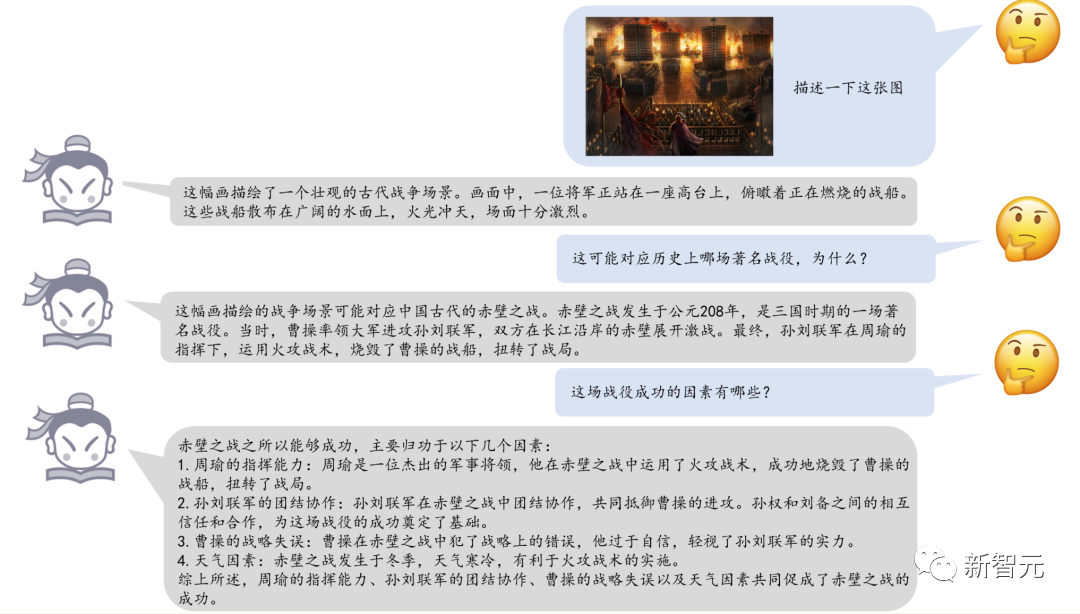

浦語靈筆能夠進行流利的中英文圖文對話,準確理解圖像內容。得益于書生·浦語高質量多語言預訓練的優勢,浦語靈筆表現出對中國文化深厚的知識積淀。

例如,向浦語靈筆輸入相關畫作,其迅速識別并反饋畫作表現主題為《赤壁之戰》典故,亦能準確介紹影響成敗的關鍵因素,體現出在圖像內容理解和知識儲備方面的優秀性能。

浦語靈筆識別中國文化典故

在多模態圖文對話的「基本功」之上,浦語靈筆更是解鎖了圖文并茂文章創作的全新能力。

大語言模型(LLM)具備文本寫作的能力,然而高質量文章往往需要準確且有趣的插圖才「更顯生動」。

浦語靈筆團隊將書生·浦語強大的語言能力向多模態拓展,使其能夠完成多模態文章創作。用戶僅需提供主題,便可一鍵生成圖文并茂的文章,體驗全新的視覺與文本創作范式。

例如,向浦語靈筆提出創作一篇旅游攻略,該模型可迅速生成涵蓋歷史沿革、主要景點文物介紹的長篇文章,并在適當位置自動插入與文字信息對應的圖片。

除自動配圖能力外,浦語靈筆還提供了配圖推薦和更換功能,根據用戶實際需求定制圖文內容。

浦語靈筆生成中文旅游攻略

目前,浦語靈筆已支持科普文稿、營銷廣告、新聞稿件、影視評論、生活指南等類型文章的圖文并茂生成,并將逐漸開放更多能力,適應更多樣化任務需求。

浦語靈筆生成英文電影評論

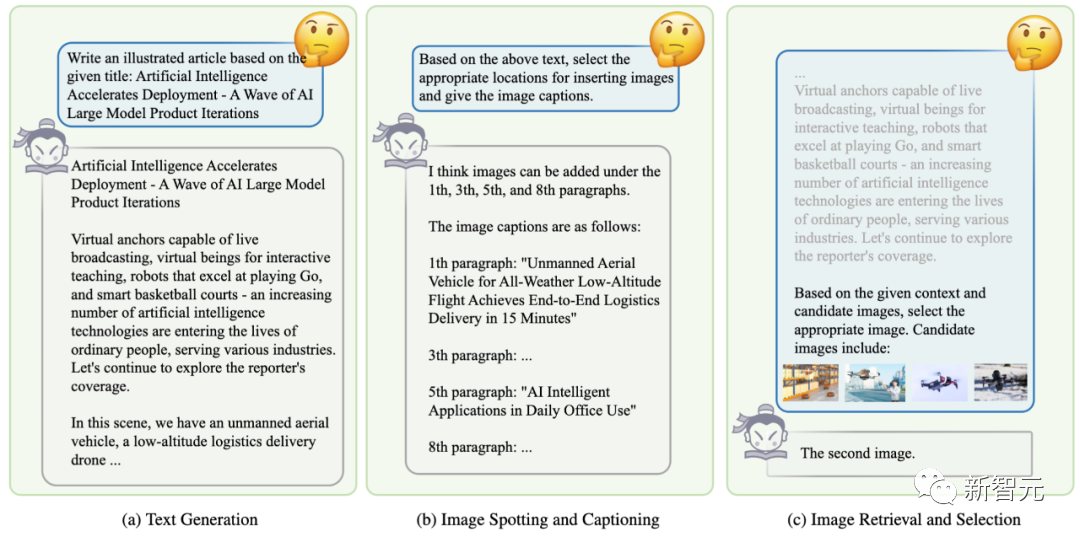

圖文文章創作「三步走」

浦語靈筆為圖文文章創作設計了「三步走」的算法流程。

浦語靈筆圖文文章創作流程

理解用戶指令,創作符合主題要求的長文章:浦語靈筆具有強大的寫作能力,根據用戶輸入的主題,創作出文采斐然的文章。

智能分析文章,模型自動規劃插圖的理想位置,并生成所需圖像的內容要求:浦語靈筆自動分析文章內容和段落布局,規劃需要插圖圖片的位置。對于每個模型判斷需要插圖的位置,同時生成對圖片內容需求的描述。

多層次智能篩選,利用多模態大模型的圖像理解能力,從圖庫中鎖定最完美的圖片:采用從粗篩到精選的配圖策略,根據生成圖像內容需求,浦語靈筆會首先采用圖文檢索(Text-Image Retrieval)方式從海量圖庫中選擇出一組候選圖片。隨后,利用多模態大模型強大的圖像理解能力,將候選圖片作為輸入內容,讓模型自動選擇最符合文章上下文內容和整體圖像風格的圖片,完成文章的自動配圖。

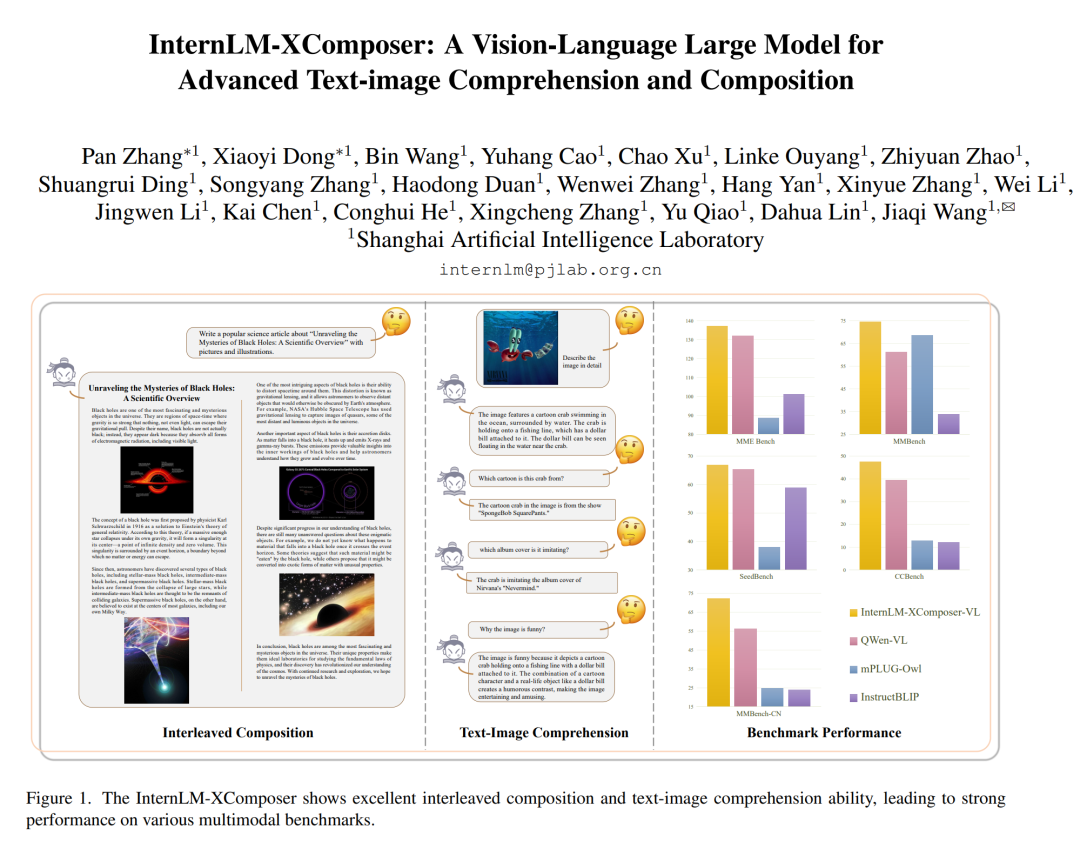

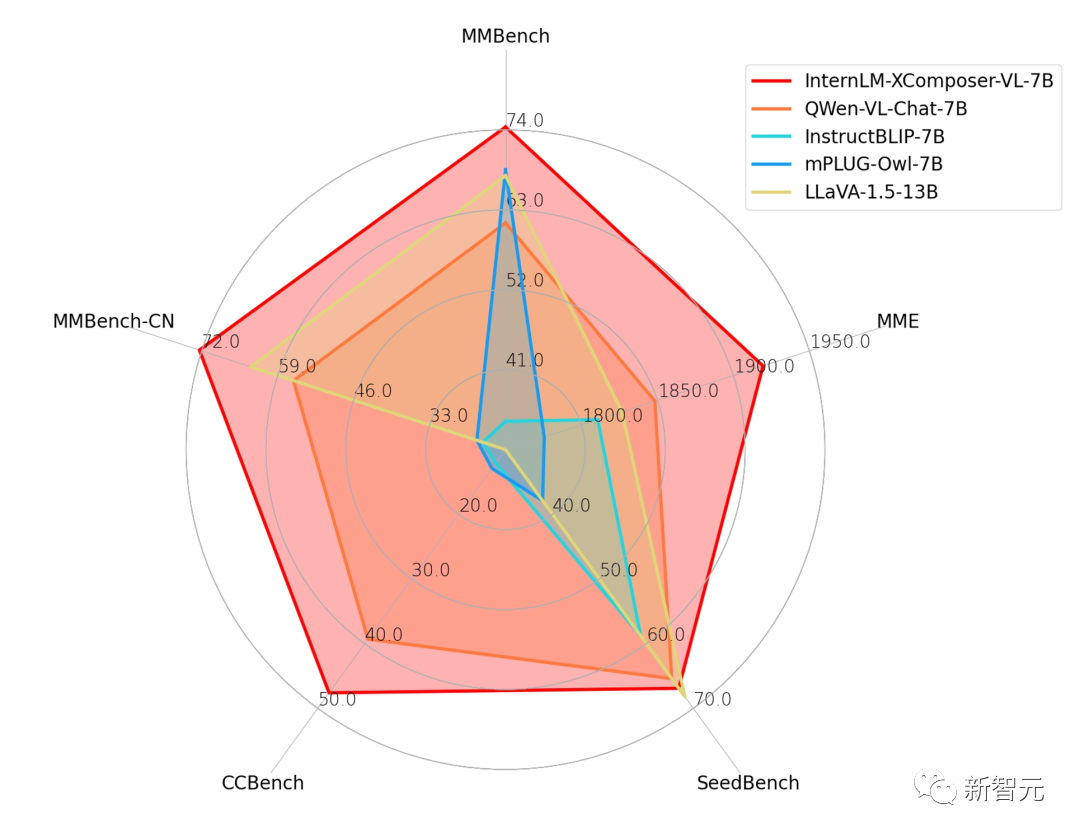

能力評測:綜合領先開源多模態大模型

浦語靈筆出色的圖文創作效果,得益于其多任務預訓練模型(InternLM-XComposer-VL-7B)強大的多模態理解能力。

研究人員采用5個主流的多模態大模型評測對InternLM-XComposer-VL-7B的能力進行了詳細測試,包含:

- MME Benchmark:包括14個子任務的多模態模型全面評測,關注模型的感知(Perception)和認知(Recognition)能力;

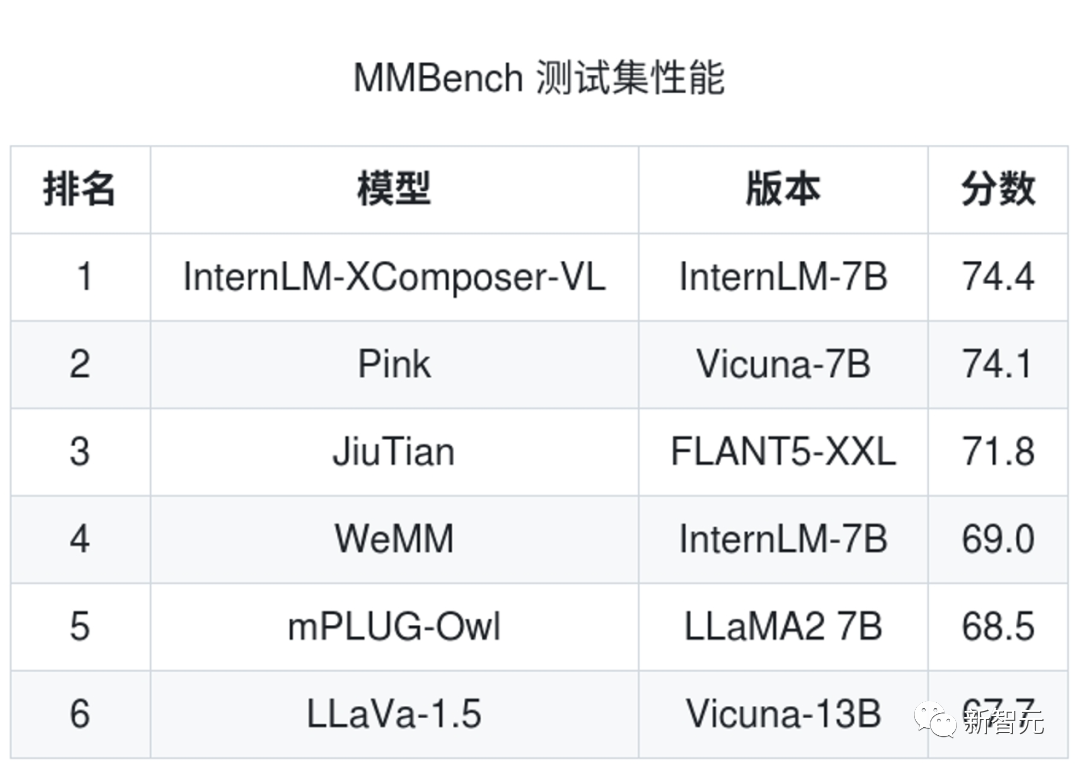

- MMBench:包括20個能力緯度和使用ChatGPT循環評估策略的多模態評測;

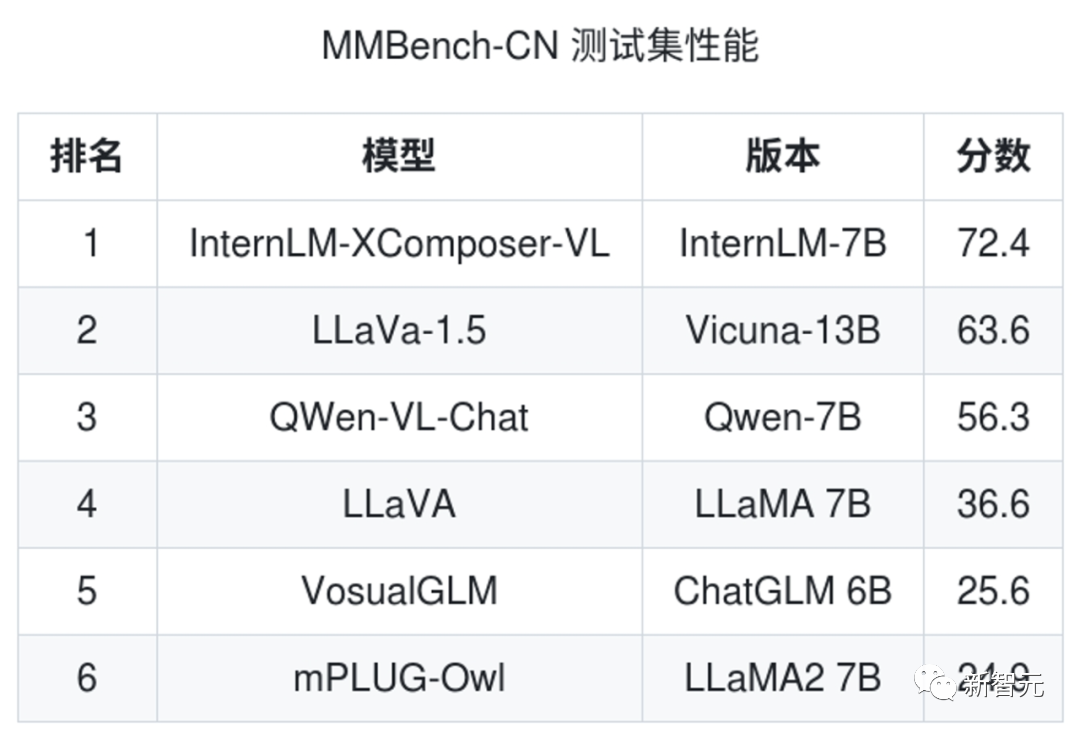

- MMBench-CN:簡體中文版本問題和答案的MMBench評測;

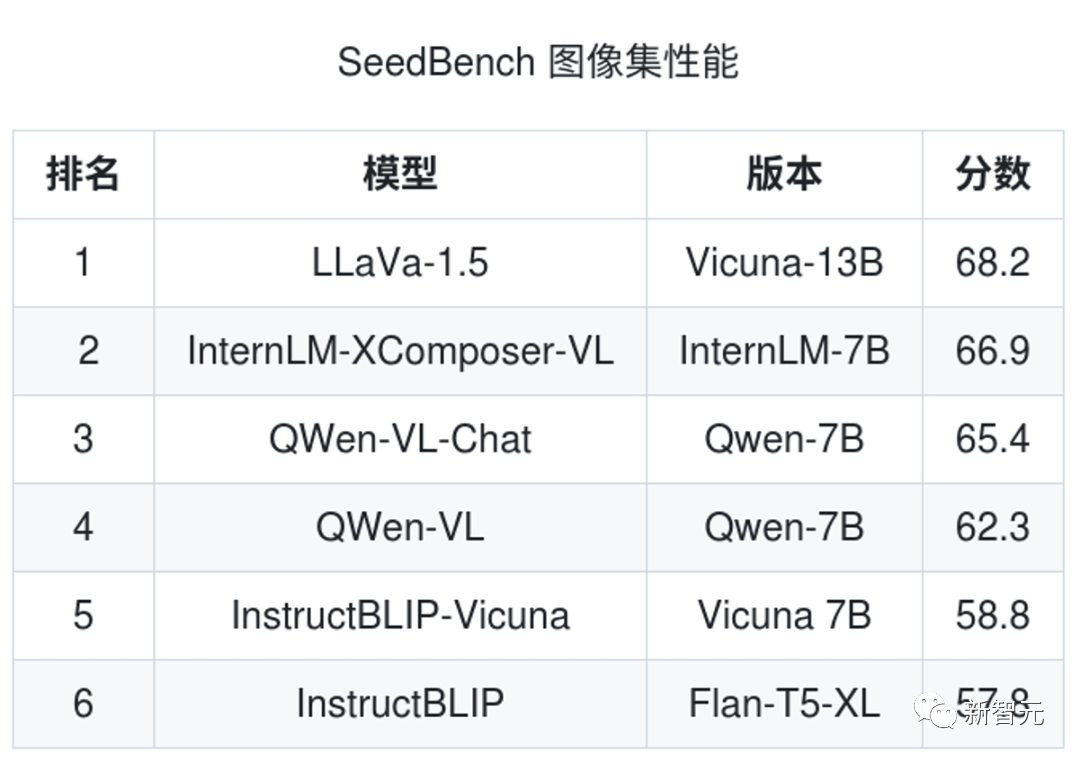

- Seed-Bench:提供包括人工標注的1.9萬道多模態多選題目的多模態評測;

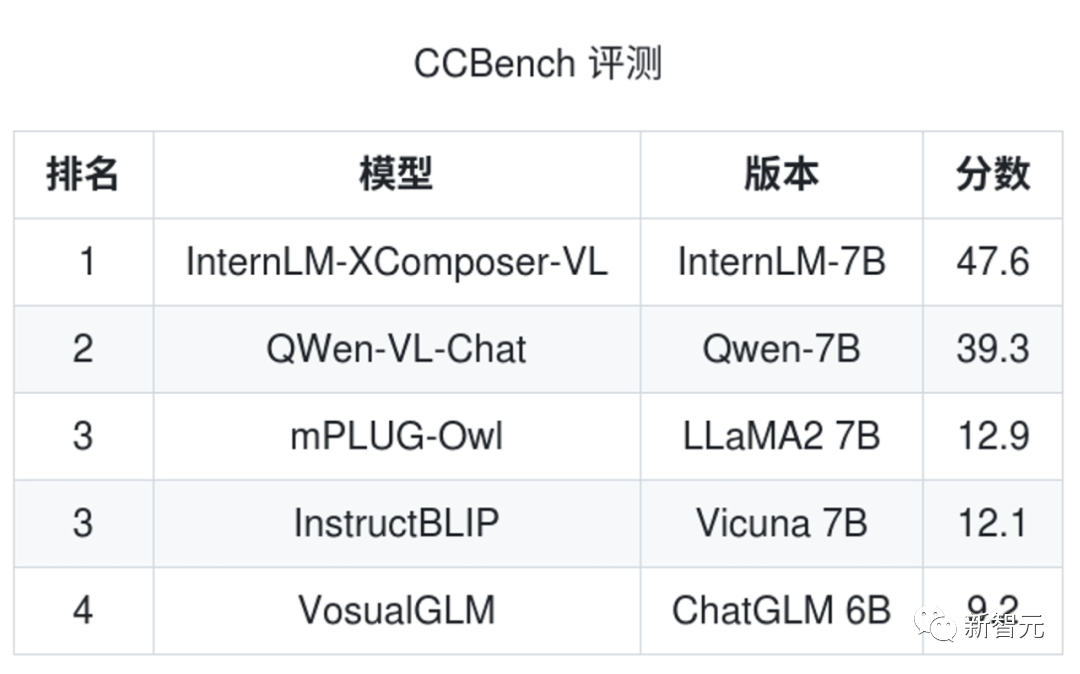

- CCBench:針對中國文化理解的中文多模態評測。

評測結果顯示,在上述5項中英文多模態評測中,浦語靈筆均體現出卓越性能。

浦語靈筆與其他開源模型的性能對比

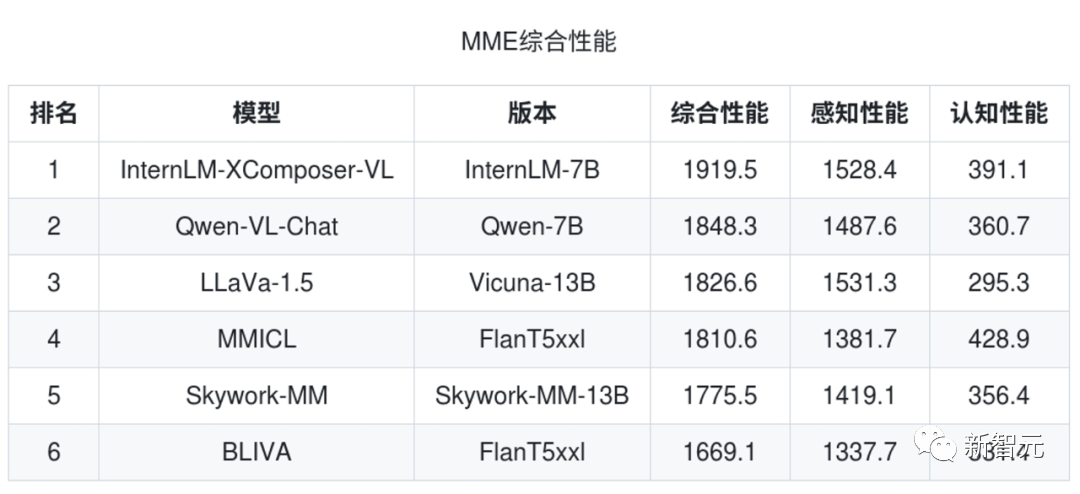

MME Benchmark關注模型的感知(Perception)和認知(Recognition)能力,浦語靈筆綜合性能領先。

MMBench包括了20個能力項,浦語靈筆取得了最佳成績。

MMBench-CN是中文版本的MMBench評測,關注模型的中文多模態理解能力,浦語靈筆亦取得了最佳成績,體現了強大的中文能力。

SEED-Bench 提供包括人工標注的1.9萬道多模態多選題目,覆蓋12個評測維度,浦語靈筆在圖像內容理解上準確率表現出色。

在針對中國文化理解設計的多模態評測CCBench,浦語靈筆評測成績均大幅度領先,生動體現其在中國文化方面深厚的知識積淀。

浦語靈筆現已開源,同時上線GitHub、Hugging Face及魔搭社區(ModelScope),歡迎開發者下載試用。