世界模型立大功!這造假的20多種自動駕駛場景數據太逼真了......

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

你以為這是個平平無奇的自動駕駛視頻?

NO、NO、NO……這其實是完全由AI從頭生成的。

沒有一幀是“真的”。

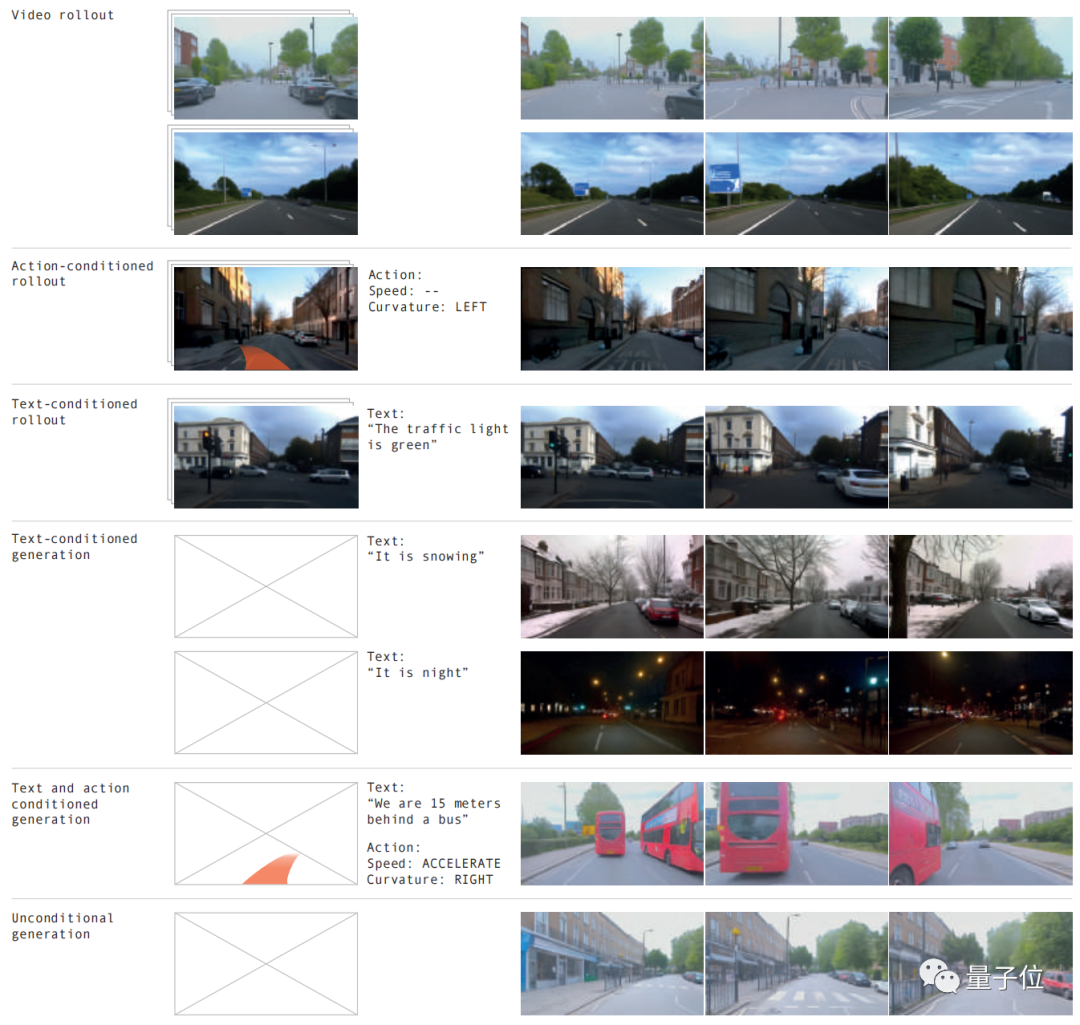

不同路況、各種天氣,20多種情況都能模擬,效果以假亂真。

世界模型再次立大功了!這不LeCun看了都激情轉發(fā)。

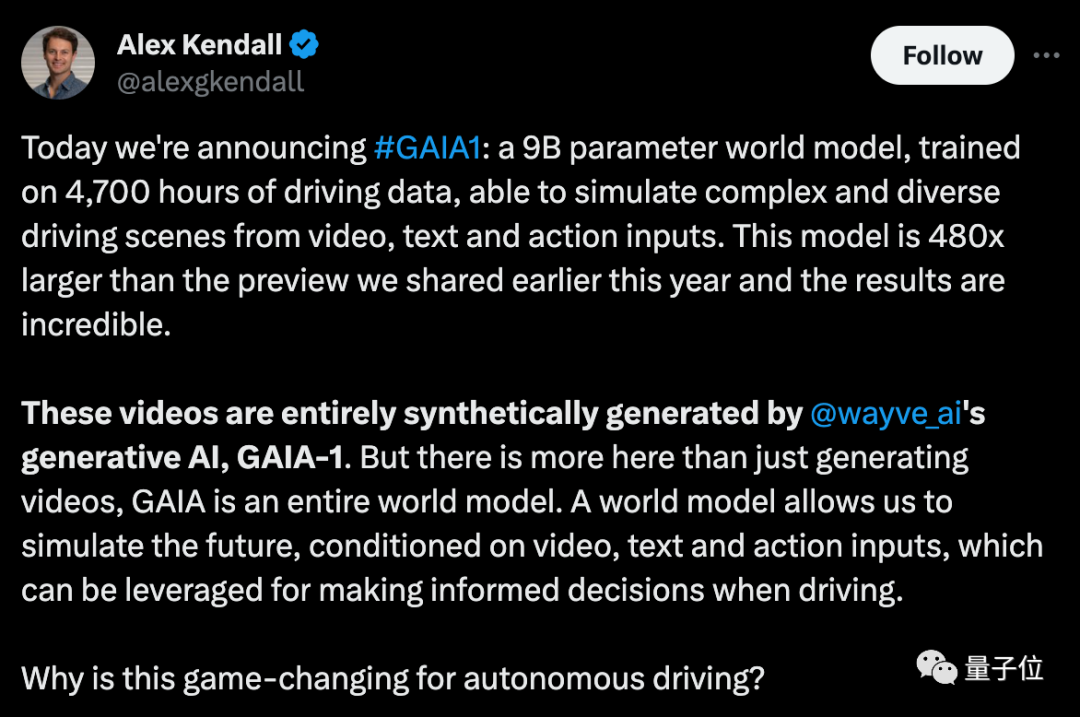

如上效果,由GAIA-1的最新版本帶來。

它規(guī)模達90億參數,用4700小時駕駛視頻訓練,實現了輸入視頻、文本或操作生成自動駕駛視頻的效果。

帶來的最直接好處就是——能更好預測未來事件,20多種場景都能模擬,從而進一步提升了自動駕駛的安全性、還降低了成本。

其主創(chuàng)團隊直言,這能夠改變自動駕駛的游戲規(guī)則!

所以GAIA-1是如何實現的?其實前面自動駕駛Daily已經第一時間為大家詳細介紹過了自動駕駛公司Wayve團隊出品的GAIA-1: A Generative World Model for Autonomous Driving,感興趣的同學可以去公眾號閱讀下!

規(guī)模越大效果越好

GAIA-1是一個多模態(tài)生成式世界模型。

它利用視頻、文本和動作作為輸入,生成逼真的駕駛場景視頻,同時可以對自主車輛的行為以及場景特征進行細粒度控制。

而且可以僅通過文本提示來生成視頻。

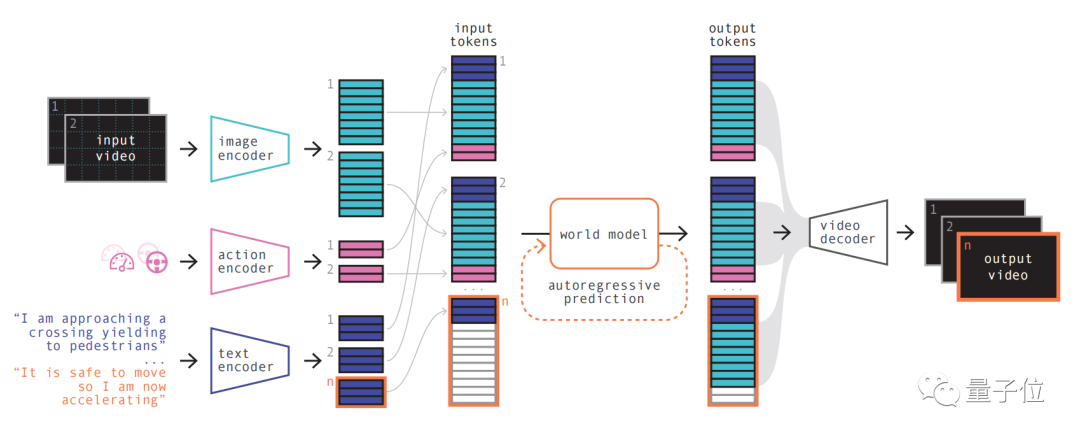

其模型原理有點像大語言模型的原理,就是預測下一個token。

模型可以利用向量量化表示將視頻幀離散,然后預測未來場景,就轉換成了預測序列中的下一個token。然后再利用擴散模型從世界模型的語言空間里生成高質量視頻。

具體步驟如下:

第一步簡單理解,就是對各種輸入進行重新編碼和排列組合。

利用一個專門的編碼器對各種輸入進行編碼,不同輸入投射到共用表示里。文本和視頻編碼器對輸入分離、嵌入,操作(action)表示則被單獨投射到共用表示里。

這些編碼的表示具有時間一致性。

在進行排列之后,關鍵部分世界模型登場。

作為一個自回歸Transformer,它能預測序列中的下一組圖像token。而且它不僅考慮了之前的圖像token,還要兼顧文本和操作的上下文信息。

這就使得模型生成內容,不僅保持了圖像一致性,而且和預測文本、動作也能保持一致。

團隊介紹,GAIA-1中的世界模型規(guī)模為65億參數,在64塊A100上訓練15天而成。

最后再利用視頻解碼器、視頻擴散模型,將這些token轉換回視頻。

這一步關乎視頻的語義質量、圖像準確性和時間一致性。

GAIA-1的視頻解碼器規(guī)模達26億參數規(guī)模,利用32臺A100訓練15天而來。

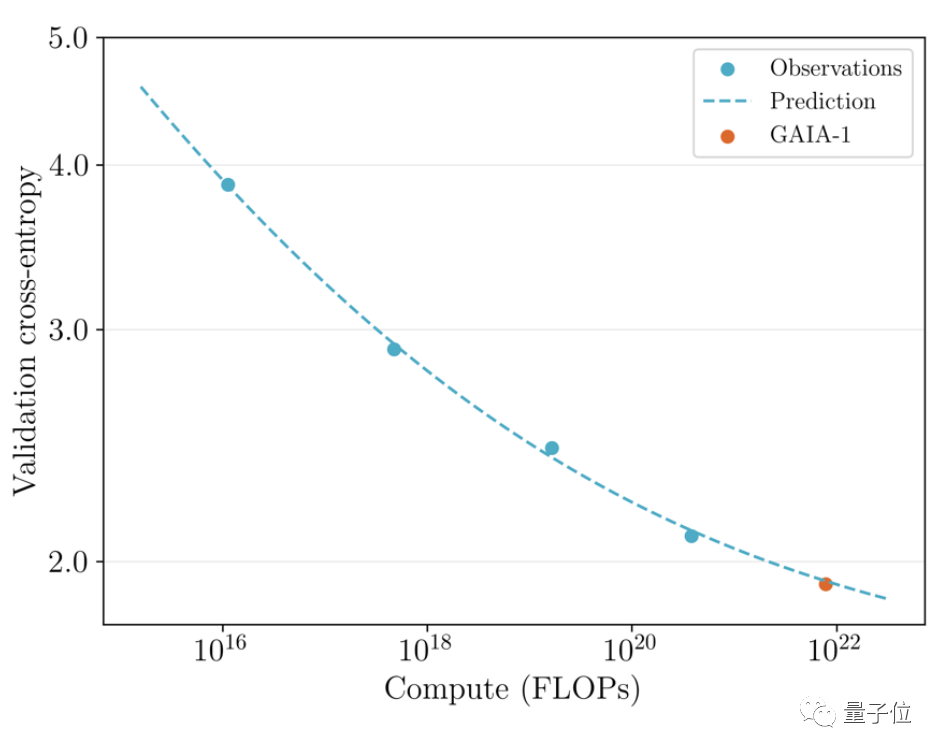

值得一提的是,GAIA-1不僅和大語言模型原理相似,同時也呈現出了隨著模型規(guī)模擴大、生成質量提升的特點。

團隊將此前6月發(fā)布早期版本和最新效果進行了對比。

后者規(guī)模為前者的480倍。

可以直觀看到視頻在細節(jié)、分辨率等方面都有明顯提升。

而從實際應用方面出發(fā),GAIA-1也帶來了影響,其主創(chuàng)團隊表示,這會改變自動駕駛的規(guī)則。

原因來自三方面:

- 安全

- 綜合訓練數據

- 長尾場景

首先安全方面,世界模型能夠通過模擬未來,讓AI有能力意識到自己的決定,這對自動駕駛的安全性來說很關鍵。

其次,訓練數據對于自動駕駛來說也非常關鍵。生成的數據更加安全、便宜,而且還能無限擴展。

最后,它還能解決目前自動駕駛面臨的最大挑戰(zhàn)之一——長尾場景。生成式AI可以兼顧更多邊緣場景,比如在大霧天氣行駛遇到了橫穿馬路的路人。這能更進一步提升自動駕駛的能力。

Wayve是誰?

GAIA-1來自英國自動駕駛初創(chuàng)公司Wayve。

Wayve成立于2017年,投資方有微軟等,估值已經達到了獨角獸。

創(chuàng)始人為現任CEO亞歷克斯·肯德爾和艾瑪爾·沙(公司官網領導層頁已無其信息) ,兩人都是來自劍橋大學的機器學習博士。

技術路線上,和特斯拉一樣,Wayve主張利用攝像頭的純視覺方案,很早就拋棄高精地圖,堅定的走“即時感知”路線。

前不久,該團隊發(fā)布的另一個大模型LINGO-1也引發(fā)轟動。

這個自動駕駛模型能夠在行車過程中,實時生成解說,更進一步提高了模型可解釋性。

今年3月,比爾·蓋茨還曾試乘過過Wayve的自動駕駛汽車。

論文地址:https://arxiv.org/abs/2309.17080

原文鏈接:https://mp.weixin.qq.com/s/bwTDovx9-UArk5lx5pZPag