20+篇里程碑式論文,帶你從「Transformer的前世」速通到ChatGPT

短短五年,Transformer就幾乎顛覆了整個(gè)自然語言處理領(lǐng)域的研究范式,是劃時(shí)代產(chǎn)品ChatGPT的基礎(chǔ)技術(shù),也促進(jìn)了計(jì)算機(jī)視覺、計(jì)算生物學(xué)等領(lǐng)域的研究進(jìn)展。

在發(fā)展的過程中,研究人員發(fā)表了大量論文、模型以及訓(xùn)練技巧,對(duì)于新入行的研究者來說,面對(duì)成山的論文根本不知從何入手。

不久前指出Transformer原始論文中插圖存在漏洞的Sebastian Raschka發(fā)布了一份全面且簡短的論文列表,包含Transformer的機(jī)制來源、預(yù)訓(xùn)練范式、人類反饋強(qiáng)化學(xué)習(xí)等諸多里程碑式論文,小白看完輕松變理論高手。

Transformer底層架構(gòu)

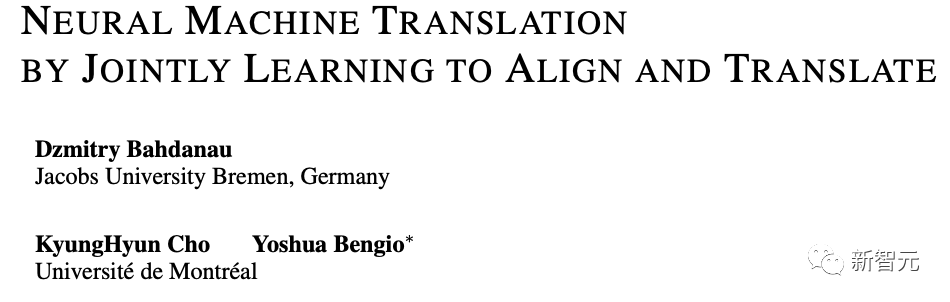

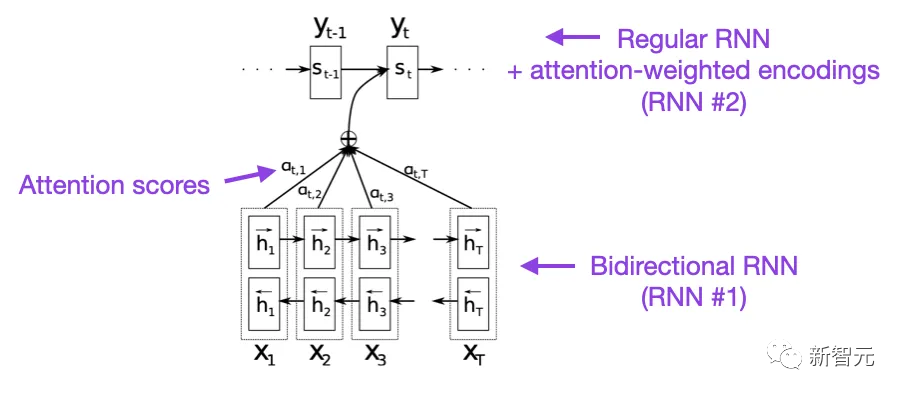

1. Neural Machine Translation by Jointly Learning to Align and Translate(2014)

這篇論文為循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)引入了注意力機(jī)制,以提升長距離序列建模的能力,使得RNN可以更準(zhǔn)確地翻譯更長的句子,也是原始Transformer模型的開發(fā)動(dòng)機(jī)。

論文鏈接:https://arxiv.org/abs/1409.0473

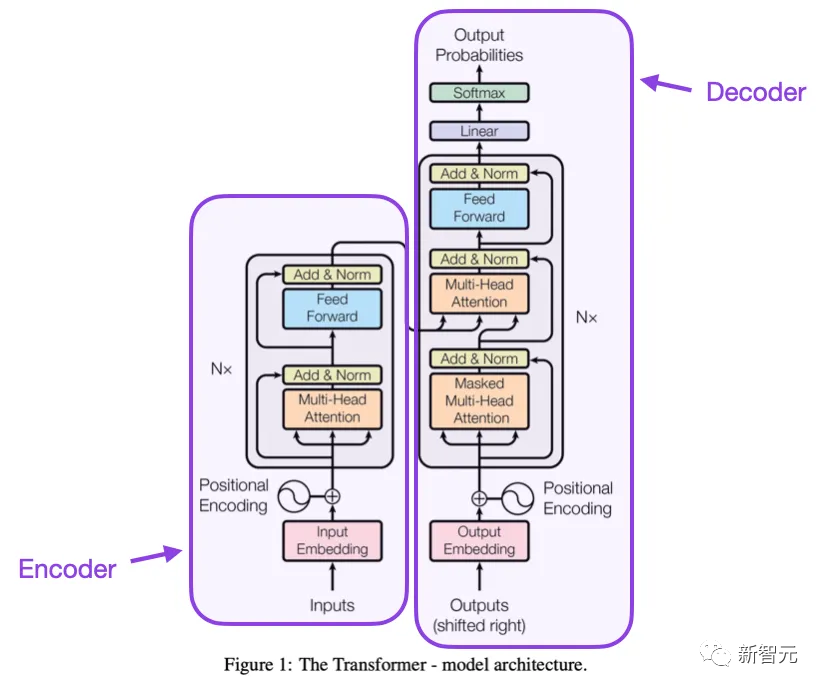

2. Attention is All you need (2017)

這篇論文提出了由編碼器和解碼器部分組成的原始Transformer架構(gòu),并且文中提出的概念,如縮放點(diǎn)積(scale dot product)注意力機(jī)制,多頭注意塊、位置輸入編碼等,到今天為止仍然是Transformer模型的基礎(chǔ)。

論文鏈接:https://arxiv.org/pdf/1706.03762.pdf

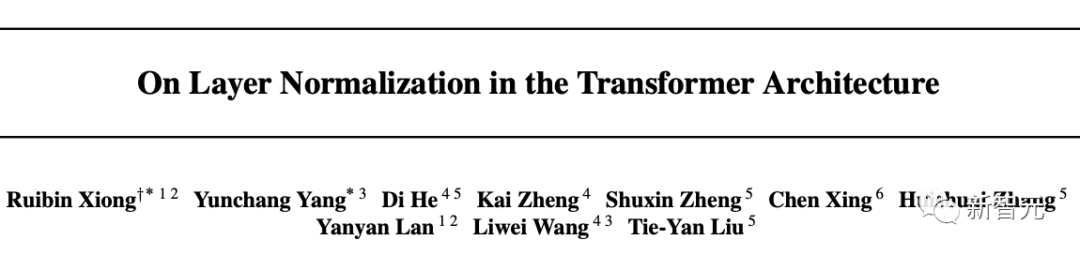

3. On Layer Normalization in the Transformer Architecture (2020)

雖然原始Transformer論文中的圖很好地展現(xiàn)了編碼器-解碼器架構(gòu),但與具體代碼實(shí)現(xiàn)存在細(xì)微差異,比如層歸一化(LayerNorms)在殘差塊之間等,文中顯示的變體也被稱為Post-LN Transformer。

論文鏈接:https://arxiv.org/pdf/2002.04745.pdf

Transformer架構(gòu)論文中的層歸一化表明Pre-LN也很有效,解決了梯度問題,許多模型也在實(shí)踐中采用Pre-LN,缺點(diǎn)在于可能會(huì)導(dǎo)致表示秩崩潰。

雖然業(yè)界關(guān)于使用Post-LN還是Pre-LN仍然存在爭論,但最近有一篇新論文提出同時(shí)利用這兩種方法,不過在實(shí)踐中是否有用仍然需要進(jìn)一步觀察。

論文鏈接:https://arxiv.org/abs/2304.14802

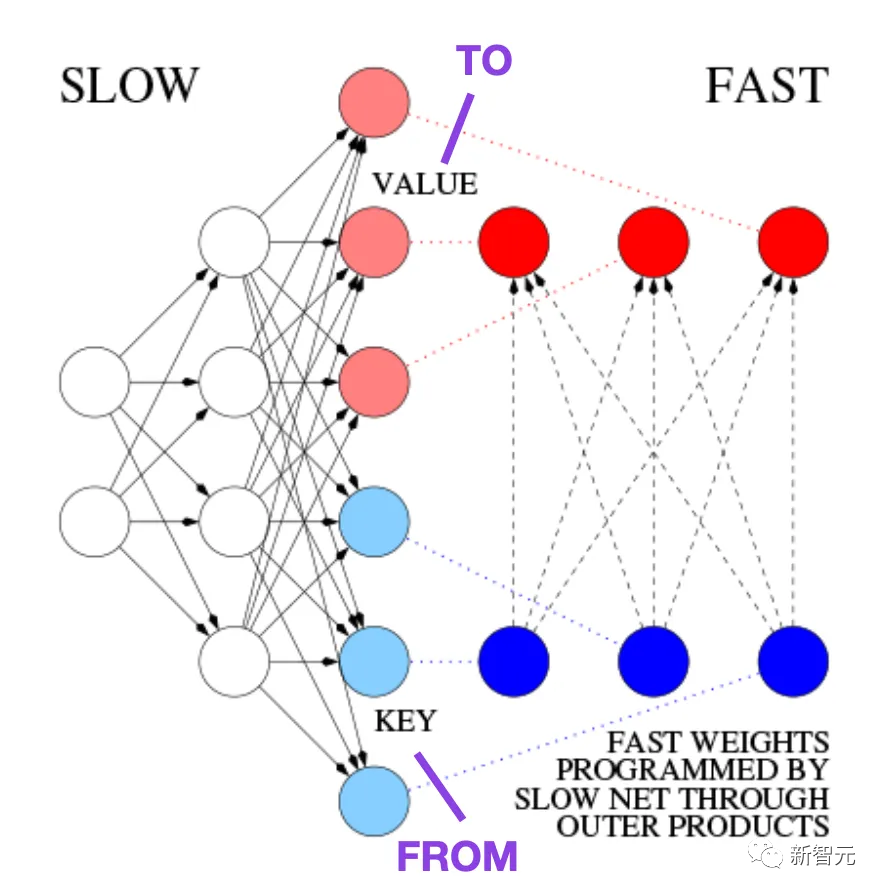

4. Learning to Control Fast-Weight Memories: An Alternative to Dynamic Recurrent Neural Networks (1991)

在1991年,也就是原始Transformer論文發(fā)布之前大約25年,Juergen Schmidhuber提出了一種替代循環(huán)神經(jīng)網(wǎng)絡(luò)的方法,叫做快速權(quán)重編程器(FWP, Fast Weight Programmers)

論文鏈接:https://ieeexplore.ieee.org/document/6796337

FWP方法用到了一個(gè)前饋神經(jīng)網(wǎng)絡(luò),通過梯度下降來緩慢學(xué)習(xí)以對(duì)另一神經(jīng)網(wǎng)絡(luò)的快速權(quán)重變化進(jìn)行編程。

而發(fā)展到今天的Transformer術(shù)語中,F(xiàn)ROM和TO分別被稱為鍵(key)和值(value),應(yīng)用快速網(wǎng)絡(luò)的INPUT叫做查詢(query)。

從本質(zhì)上講,查詢是由快速權(quán)重矩陣處理的,是鍵和值的外積之和(不考慮歸一化和投影的話)。

由于兩個(gè)網(wǎng)絡(luò)的所有操作都是可微的,通過加性外積或二階張量積獲得快速權(quán)重變化的端到端可微主動(dòng)控制。

因此,慢速網(wǎng)絡(luò)可以通過梯度下降來學(xué)習(xí),以在序列處理期間快速修改快速網(wǎng)絡(luò),在數(shù)學(xué)上等同于不包括歸一化的,后來也叫做具有線性化自注意力的Transformer,即線性Transformer

2021年,一篇論文明確證明了線性化自注意力與20世紀(jì)90年代的快速權(quán)重編程器之間的等價(jià)性。

論文鏈接:https://arxiv.org/pdf/2102.11174.pdf

5. Universal Language Model Fine-tuning for Text Classification (2018)

這篇論文雖然發(fā)表于2018年,但并沒有研究Transformer,而主要關(guān)注循環(huán)神經(jīng)網(wǎng)絡(luò),但提出了有效的預(yù)訓(xùn)練語言模型和對(duì)下游任務(wù)的遷移學(xué)習(xí)。

論文鏈接:https://arxiv.org/abs/1801.06146

雖然遷移學(xué)習(xí)最早是在計(jì)算機(jī)視覺中提出的,但當(dāng)時(shí)在自然語言處理(NLP)領(lǐng)域中還沒有普及。

ULMFit是最早證明預(yù)訓(xùn)練語言模型并在特定任務(wù)上對(duì)其進(jìn)行微調(diào)可以在許多NLP任務(wù)中實(shí)現(xiàn)最先進(jìn)性能的論文之一。

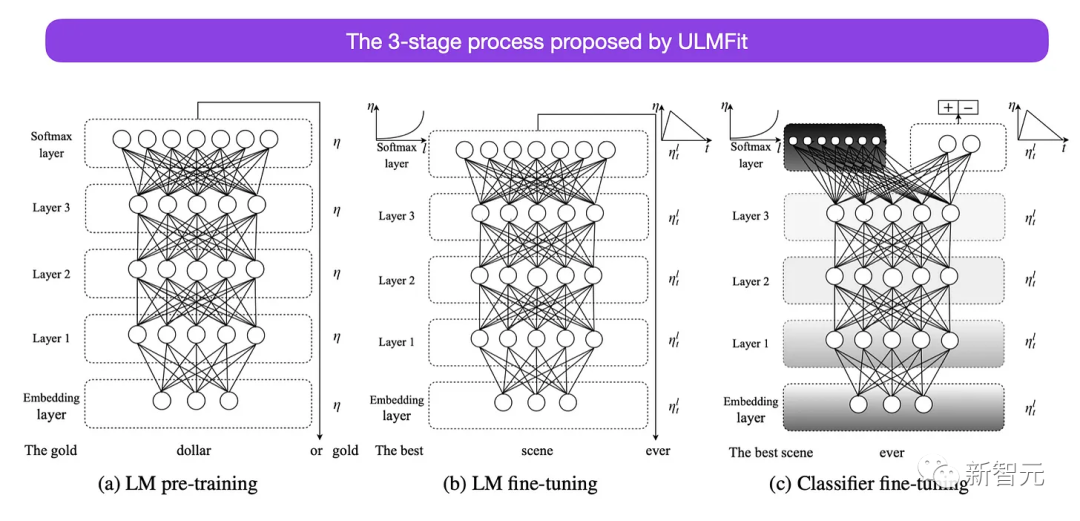

ULMFit提出的微調(diào)語言模型的三階段過程如下:

1. 在大型文本語料庫上訓(xùn)練語言模型

2. 在特定任務(wù)的數(shù)據(jù)上微調(diào)預(yù)訓(xùn)練的語言模型,使其適應(yīng)文本的特定風(fēng)格和詞匯

3. 通過逐層解凍來微調(diào)特定任務(wù)數(shù)據(jù)的分類器,以避免災(zāi)難性遺忘

該方法,即在大型語料庫上訓(xùn)練語言模型,然后在下游任務(wù)上對(duì)其進(jìn)行微調(diào),是基于Transformer的基礎(chǔ)模型(如BERT、GPT-2/3/4、RoBERTa等)中使用的核心方法。

不過ULMFiT的關(guān)鍵組件是逐層解凍,通常無法在Transformer架構(gòu)中實(shí)現(xiàn),其中所有層通常只經(jīng)過一次微調(diào)。

6. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding (2018)

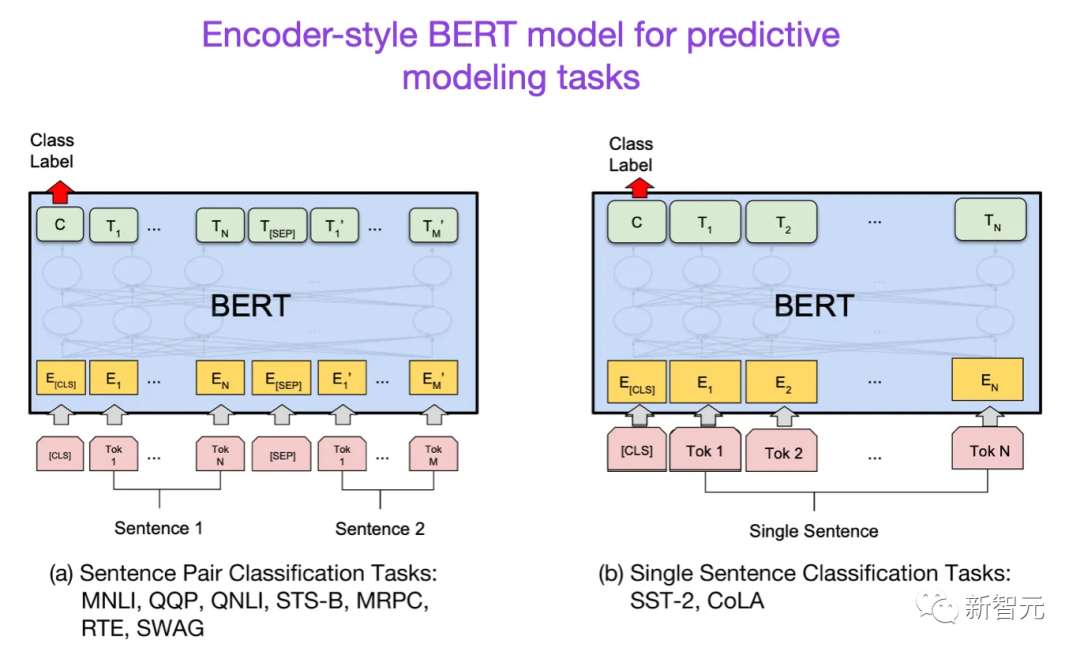

在Transformer架構(gòu)提出之后,大型語言模型研究開始分為兩個(gè)方向:用于預(yù)測建模任務(wù)(如文本分類)的編碼器Transformer;以及用于生成建模任務(wù)(如翻譯、摘要和其他形式的文本創(chuàng)建)的解碼器Transformer

論文鏈接:https://arxiv.org/abs/1810.04805

BERT論文提出了遮罩語言建模的概念,并且下一句預(yù)測(next-sentence prediction)仍然是一種有影響力的解碼器架構(gòu),不過后續(xù)的RoberTa刪除了下一句預(yù)測任務(wù),簡化了預(yù)訓(xùn)練目標(biāo)。

7. Improving Language Understanding by Generative Pre-Training (2018)

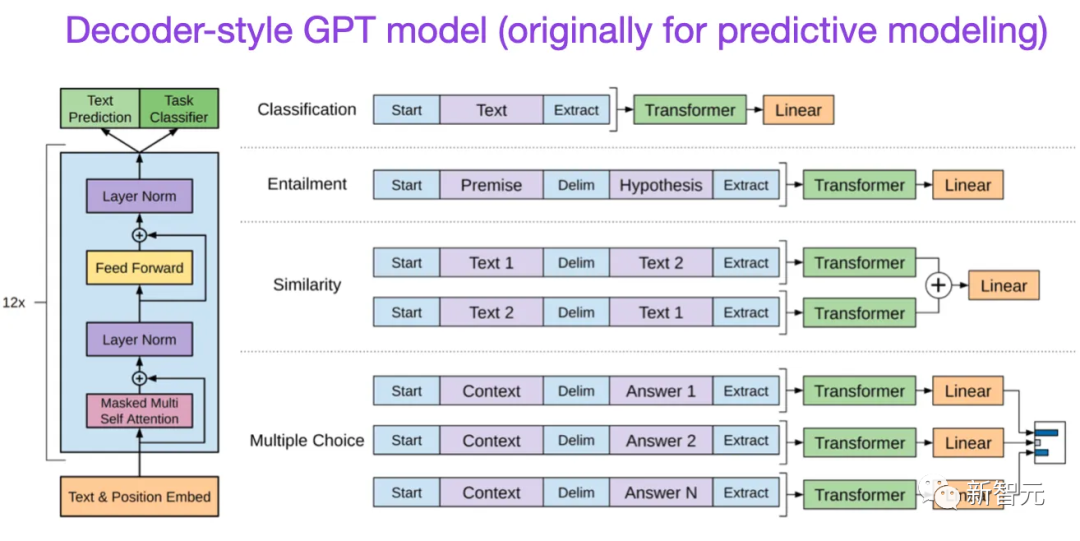

第一版GPT論文提出了解碼器架構(gòu),以及使用下一個(gè)單詞預(yù)測進(jìn)行預(yù)訓(xùn)練。

論文鏈接:https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf

BERT使用的遮罩語言模型預(yù)訓(xùn)練目標(biāo),所以是雙向Transformer模型;而GPT是單向自回歸模型,但其學(xué)到的嵌入也可以用于分類。

GPT方法是當(dāng)下最有影響力的大型語言模型(如chatGPT)的核心技術(shù)。

后續(xù)發(fā)布的GPT-2和GPT-3論文說明了LLM能夠進(jìn)行零樣本和少樣本學(xué)習(xí),指出了大型語言模型的涌現(xiàn)能力。

GPT-3仍然是訓(xùn)練當(dāng)下語言模型(如ChatGPT)的常用基線和基礎(chǔ)模型。

8. BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension (2019)

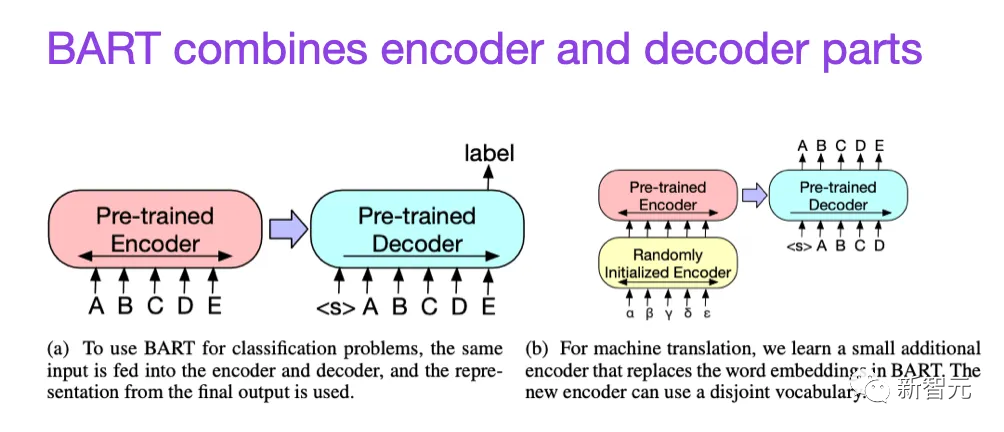

如前所述,BERT類語言模型主要關(guān)注編碼器,通常是預(yù)測建模任務(wù)的首選,而GPT類型的解碼器風(fēng)格的語言模型在文本生成方面更好。

論文鏈接:https://arxiv.org/abs/1910.13461

為了同時(shí)利用二者的優(yōu)勢,BART論文結(jié)合了編碼器和解碼器部分。

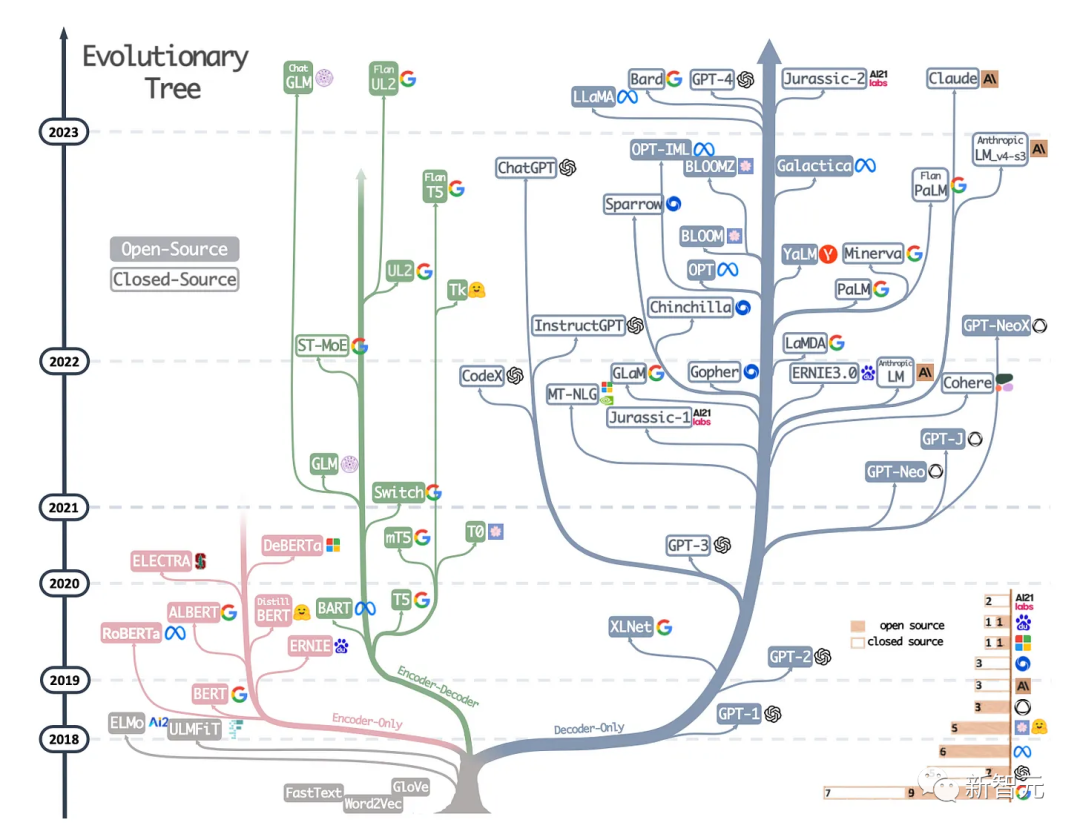

9. Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond (2023)

這篇并不是研究論文,但可能是當(dāng)下最好的綜述報(bào)告,說明了不同的架構(gòu)是如何演變的。

論文鏈接:https://arxiv.org/abs/2304.13712

除了討論BERT風(fēng)格的遮罩語言模型(編碼器)和GPT風(fēng)格的自回歸語言模型(解碼器)之外,還提供了關(guān)于預(yù)訓(xùn)練和微調(diào)數(shù)據(jù)的討論和指導(dǎo)。

縮放定律與效率提升

除了下面列出的論文外,如果想了解更多關(guān)于提高Transformer效率的各種技術(shù),還可以閱讀兩篇綜述。

論文鏈接:https://arxiv.org/abs/2009.06732

論文鏈接:https://arxiv.org/pdf/2302.01107.pdf

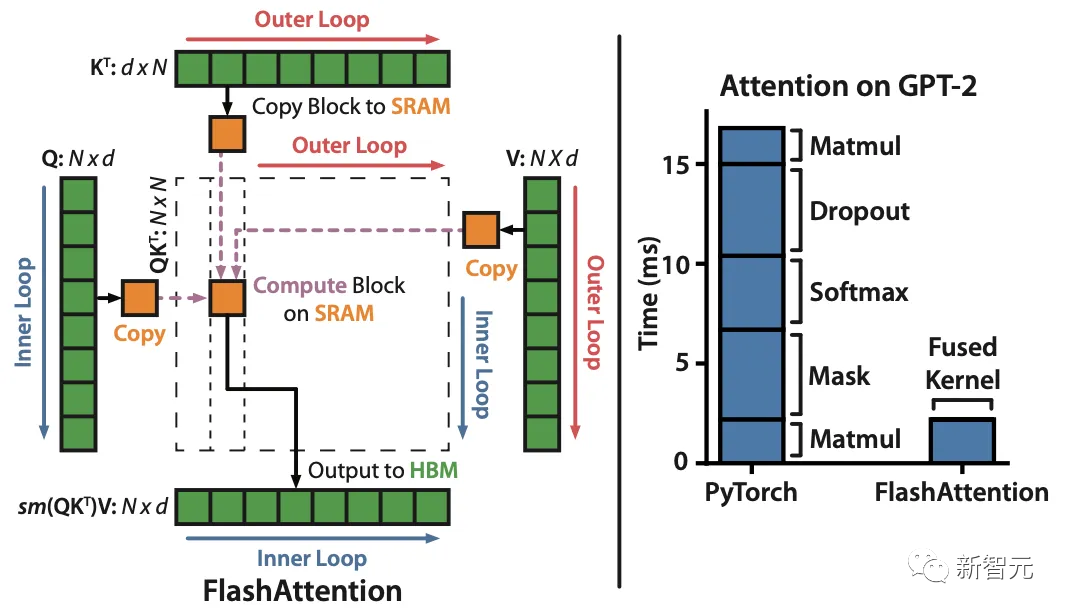

10. FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness (2022)

論文鏈接:https://arxiv.org/pdf/2205.14135.pdf

雖然大多數(shù)transformer論文都沒有替換原始的縮放點(diǎn)積機(jī)制來改進(jìn)自注意力,但FlashAttention是其中最常引用的一種機(jī)制。

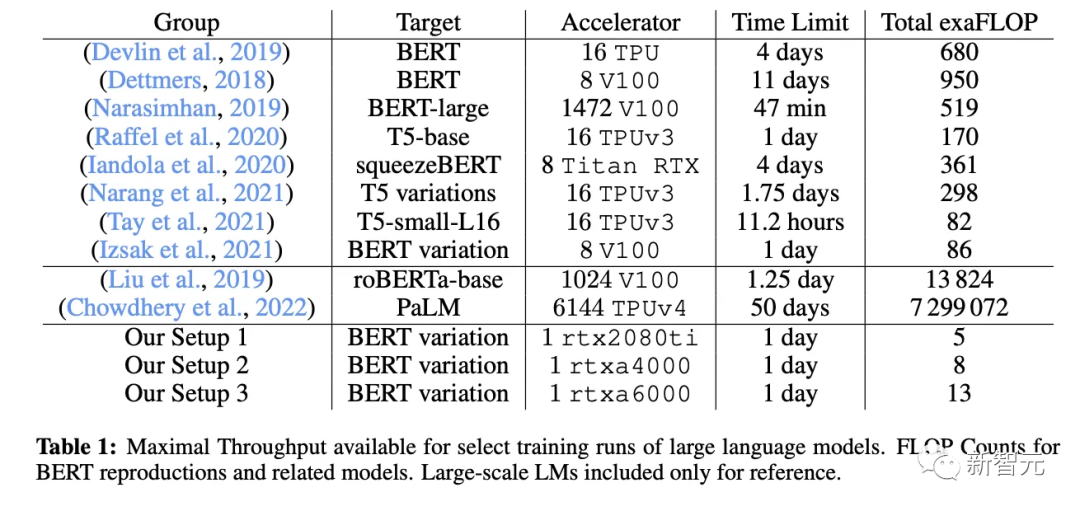

11. Cramming: Training a Language Model on a Single GPU in One Day (2022)

在這篇論文中,研究人員使用單個(gè)GPU用了24個(gè)小時(shí)訓(xùn)練了一個(gè)遮罩語言模型/編碼器風(fēng)格的語言模型,在單個(gè)GPU上進(jìn)行24小時(shí),相比之下,2018年BERT剛提出來的時(shí)候,在16個(gè)TPU上訓(xùn)練了四天。

論文鏈接:https://arxiv.org/abs/2212.14034

一個(gè)有趣的結(jié)論是,雖然較小的模型具有更高的吞吐量,但小模型的學(xué)習(xí)效率也比較低,所以較大的模型不需要更多的訓(xùn)練時(shí)間來達(dá)到特定的預(yù)測性能閾值。

12. LoRA: Low-Rank Adaptation of Large Language Models (2021)

在大型數(shù)據(jù)集上預(yù)訓(xùn)練的現(xiàn)代大型語言模型展現(xiàn)出了涌現(xiàn)能力,并在各種任務(wù)上都實(shí)現(xiàn)了非常強(qiáng)大的性能,包括多語言翻譯、摘要、編碼和問答。

論文鏈接:https://arxiv.org/abs/2106.09685

不過如果想提高Transformer在特定領(lǐng)域數(shù)據(jù)和特定任務(wù)上的性能,那么就需要對(duì)Transformer進(jìn)行微調(diào)。

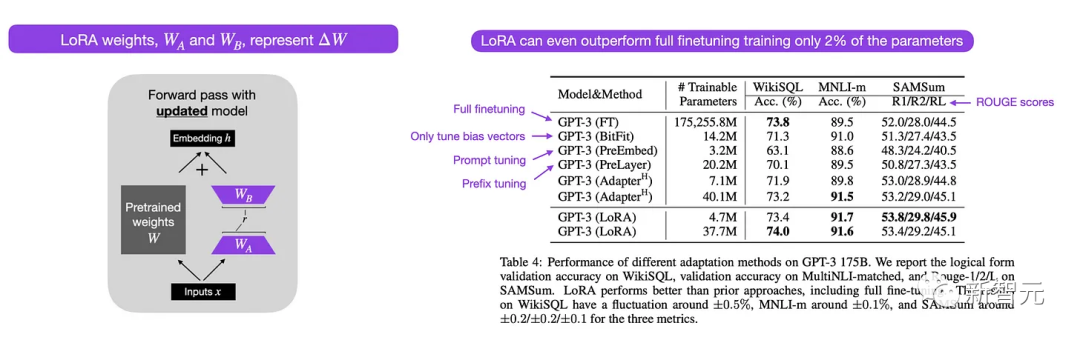

低秩自適應(yīng)(LoRA)是一種參數(shù)高效(parameter-efficient)的方式來微調(diào)大型語言模型,相比其他方法,LoRA既優(yōu)雅又非常通用,可以應(yīng)用于其他類型的模型。

雖然預(yù)訓(xùn)練模型的權(quán)重在預(yù)訓(xùn)練任務(wù)上具有滿秩,但LoRA作者指出,預(yù)訓(xùn)練的大型語言模型在適應(yīng)新任務(wù)時(shí)具有較低的「內(nèi)在維度」。

因此,LoRA背后的主要思想是將權(quán)重變化ΔW分解為更低秩的表示,即更高效的參數(shù)。

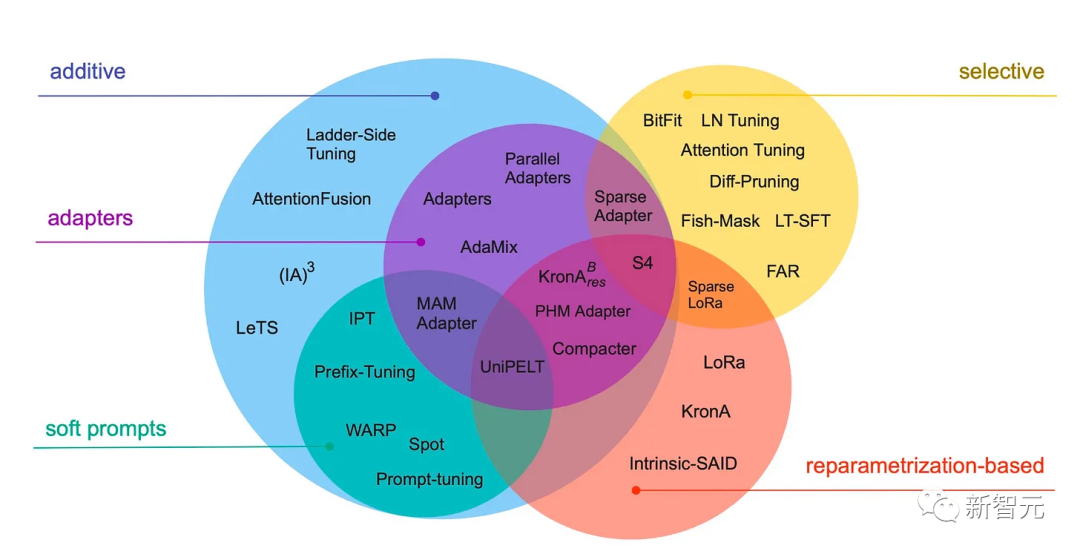

13. Scaling Down to Scale Up: A Guide to Parameter-Efficient Fine-Tuning (2022)

這篇綜述回顧了40多篇關(guān)于參數(shù)高效微調(diào)方法,包括prefix調(diào)整、adapter和LoRA等。

論文鏈接:https://arxiv.org/abs/2303.15647

14. Scaling Language Models: Methods, Analysis & Insights from Training Gopher (2022)

論文鏈接:https://arxiv.org/abs/2112.11446

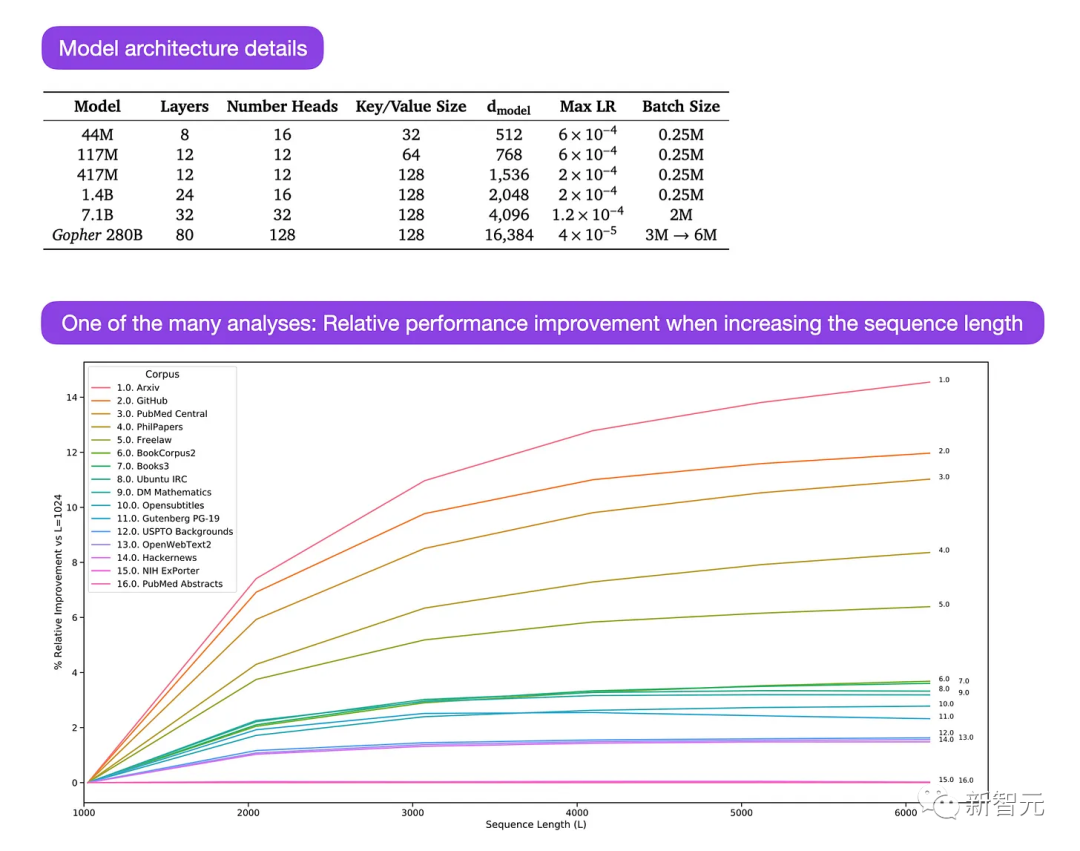

Gopher論文中有大量的分析來理解大型語言模型的訓(xùn)練過程。

研究人員在3000億個(gè)token上訓(xùn)練了一個(gè)80層、2800億參數(shù)的模型,還提出了一些架構(gòu)上的修改,如使用RMSNorm(均方根歸一化)而非LayerNorm(層歸一化)。

LayerNorm和RMSNorm都優(yōu)于BatchNorm,因?yàn)樗鼈儾⒉灰蕾囉赽atch size,也不需要同步,對(duì)于在batch size較小的分布式設(shè)置中是一個(gè)優(yōu)勢,而且RMSNorm通常被認(rèn)為可以穩(wěn)定更深層次架構(gòu)中的訓(xùn)練。

這篇論文的主要重點(diǎn)是不同尺度(sacle)模型在任務(wù)性能上的分析。

對(duì)152個(gè)不同任務(wù)的評(píng)估表明,增加模型尺寸對(duì)理解、事實(shí)核查和有毒語言識(shí)別等任務(wù)的益處最大,而與邏輯和數(shù)學(xué)推理相關(guān)的任務(wù)從架構(gòu)擴(kuò)展中受益較少。

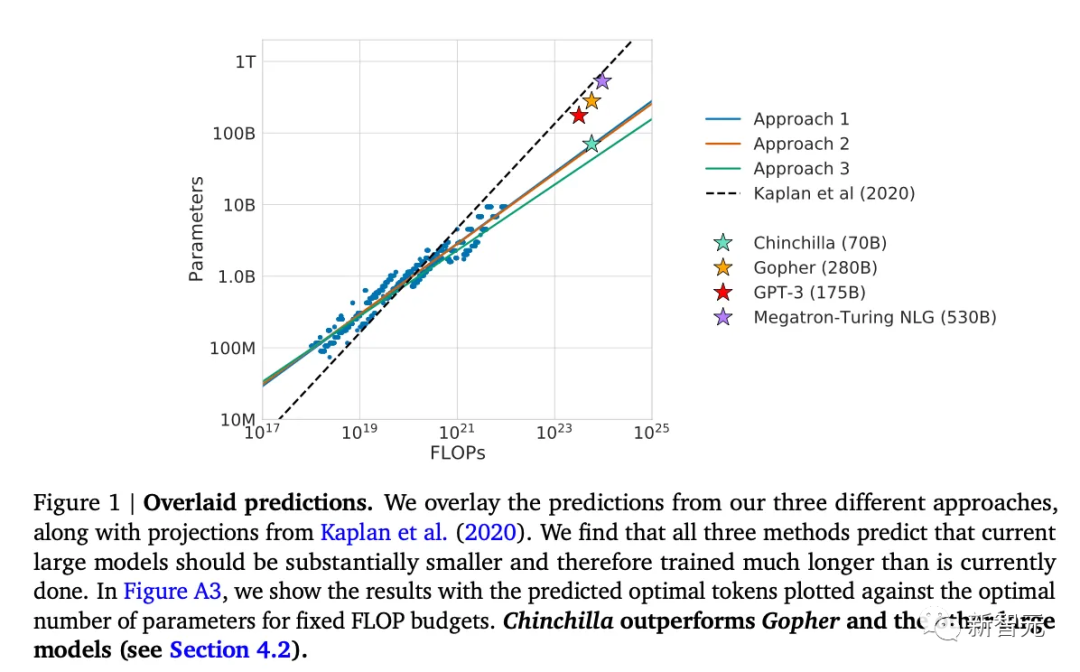

15. Training Compute-Optimal Large Language Models (2022)

這篇論文提出了700億參數(shù)Chinchilla模型,在生成建模任務(wù)上優(yōu)于常用的1750億參數(shù)GPT-3模型,不過這篇文章的主要貢獻(xiàn)是發(fā)現(xiàn)目前大型語言模型存在「嚴(yán)重訓(xùn)練不足」的問題。

論文鏈接:https://arxiv.org/abs/2203.15556

論文中定義了大型語言模型訓(xùn)練的線性縮放律(linear scaling low),例如雖然Chinchilla的大小只有GPT-3的一半,但它的表現(xiàn)優(yōu)于GPT-3,因?yàn)樗窃?.4萬億(而不是3000億)個(gè)token上訓(xùn)練的。

換句話說,訓(xùn)練語料中token的數(shù)量與模型大小一樣重要。

16. Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling (2023)

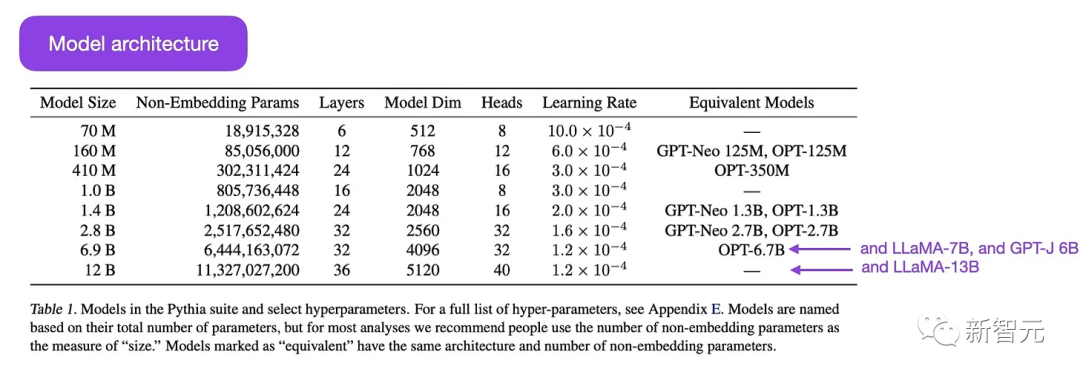

Pythia是一組開源的大型語言模型,參數(shù)量從7千萬到120億不等,以用于研究大型語言模型在訓(xùn)練過程中的演變。

論文鏈接:https://arxiv.org/abs/2304.01373

模型架構(gòu)類似于GPT-3,但包括一些組件改進(jìn),例如用Flash Attention和Rotary Positional Embeddings。

Pythia在Pile數(shù)據(jù)集(825 Gb)上訓(xùn)練了3000億個(gè)token,在regular PILE上訓(xùn)練約1個(gè)epoch,deduplicated PILE上訓(xùn)練約1.5個(gè)epoch

Pythia研究的主要結(jié)論如下:

1. 在重復(fù)數(shù)據(jù)上進(jìn)行訓(xùn)練(超過1個(gè)epoch)不會(huì)提升或降低性能。

2. 訓(xùn)練順序不會(huì)影響記憶。這個(gè)結(jié)論讓我們無法通過重新排序訓(xùn)練數(shù)據(jù)來緩解不希望的逐字記憶問題。

3. 預(yù)訓(xùn)練詞頻影響任務(wù)性能。例如,對(duì)于更頻繁的術(shù)語,少樣本學(xué)習(xí)往往準(zhǔn)確度更高。

4. 將batch size加倍可以將訓(xùn)練時(shí)間減半,但不會(huì)影響收斂。

對(duì)齊:讓大型語言模型符合預(yù)期目標(biāo)

近年來,我們看到了許多相對(duì)強(qiáng)大的大型語言模型,可以生成類人的文本(例如GPT-3和Chinchilla等),但常用的預(yù)訓(xùn)練范式似乎已經(jīng)達(dá)到了上限。

為了使語言模型對(duì)人類更有幫助并減少錯(cuò)誤信息和有害語言,研究人員設(shè)計(jì)了額外的訓(xùn)練范式來微調(diào)預(yù)訓(xùn)練的基礎(chǔ)模型。

17. Training Language Models to Follow Instructions with Human Feedback (2022)

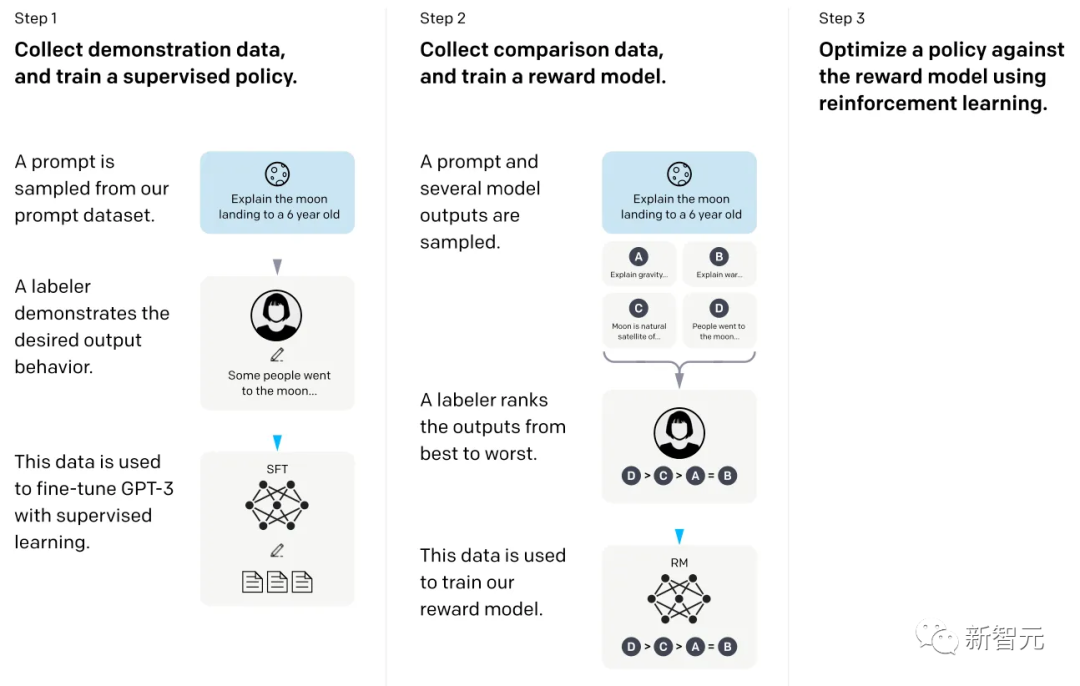

在這篇提出InstructGPT模型論文中,研究人員使用了一種強(qiáng)化學(xué)習(xí)機(jī)制,其中包括人類參與反饋的循環(huán)機(jī)制(RLHF)。

論文鏈接:https://arxiv.org/abs/2203.02155

研究人員從預(yù)訓(xùn)練的GPT-3基礎(chǔ)模型開始,使用監(jiān)督學(xué)習(xí)對(duì)人類生成的提示與模型回復(fù)進(jìn)行進(jìn)一步微調(diào);然后要求人類對(duì)模型輸出進(jìn)行排名,以訓(xùn)練獎(jiǎng)勵(lì)模型;最后使用獎(jiǎng)勵(lì)模型通過近端策略優(yōu)化(PPO, proximal policy optimization)使用強(qiáng)化學(xué)習(xí)來更新預(yù)訓(xùn)練和微調(diào)的GPT-3模型。

這篇論文也被稱為描述ChatGPT背后想法的論文,也有傳言說ChatGPT是InstructGPT的放大版本,在更大的數(shù)據(jù)集上進(jìn)行了微調(diào)。

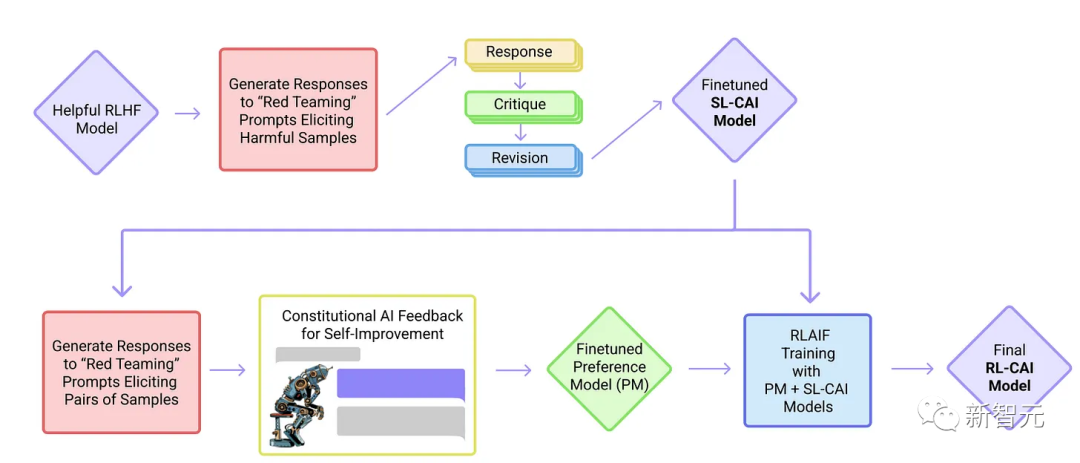

18. Constitutional AI: Harmlessness from AI Feedback (2022)

這篇論文中,研究人員將對(duì)齊思想更進(jìn)一步,提出了一種創(chuàng)建無害AI系統(tǒng)的訓(xùn)練機(jī)制。

論文鏈接:https://arxiv.org/abs/2212.08073

文中提出了一種基于規(guī)則列表(由人類提供)的自訓(xùn)練機(jī)制,而非人類監(jiān)督。

與上面提到的InstructGPT論文類似,這種機(jī)制也使用強(qiáng)化學(xué)習(xí)方法。

19. Self-Instruct: Aligning Language Model with Self Generated Instruction (2022)

指令微調(diào)是從GPT-3之類的預(yù)訓(xùn)練基礎(chǔ)模型發(fā)展到ChatGPT類更強(qiáng)大語言模型的關(guān)鍵技術(shù)。

論文鏈接:https://arxiv.org/abs/2212.10560

開源的人工生成指令數(shù)據(jù)集,如databricks-dolly-15 k,可以幫助調(diào)優(yōu),但想要進(jìn)一步擴(kuò)大指令數(shù)據(jù)集的規(guī)模,可以從語言模型中自舉得到。

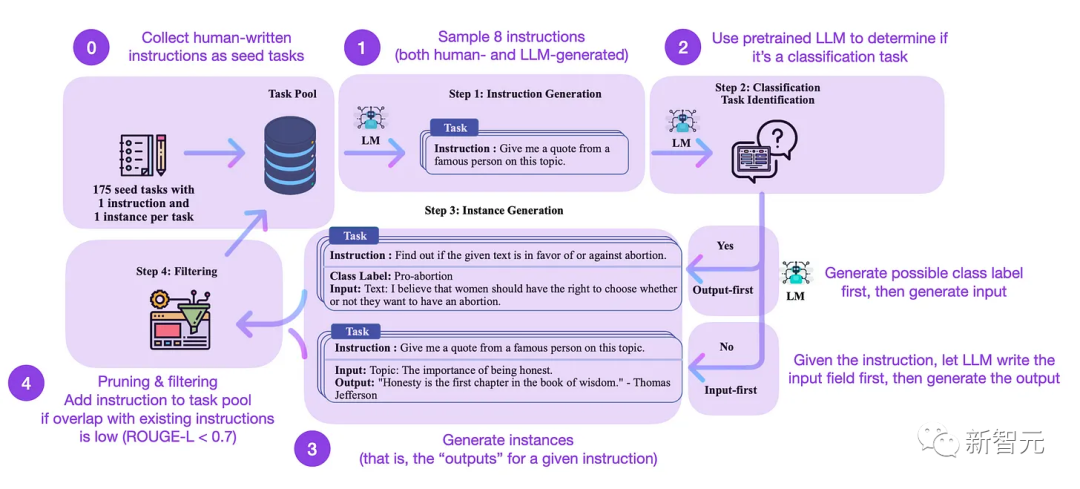

Self-Instruct是一種幾乎無需標(biāo)注,即可將預(yù)訓(xùn)練的LLM與指令對(duì)齊的方法,總共包括4個(gè)步驟:

1. 用一組人工編寫的指令和樣本指令作為種子任務(wù)池。

2. 使用預(yù)訓(xùn)練的語言模型(如GPT-3)來確定任務(wù)類別。

3. 給定新指令,讓預(yù)訓(xùn)練的語言模型生成回復(fù)。

4. 在將回復(fù)添加到任務(wù)池之前,收集、修剪和篩選這些響應(yīng)。

在實(shí)踐中,整個(gè)過程可以基于ROUGE來評(píng)分,可以認(rèn)為Self-Instruct-finetuned LLM的性能優(yōu)于GPT-3基礎(chǔ)LLM,并且可以與在大型人類編寫的指令集上預(yù)訓(xùn)練的LLM競爭,self-instruct也可以使已經(jīng)根據(jù)人類指令進(jìn)行微調(diào)的LLM受益。

當(dāng)然,評(píng)估語言模型的黃金標(biāo)準(zhǔn)是詢問人類評(píng)分員。

基于人類評(píng)估,Self-Instruct優(yōu)于基本LLM和以監(jiān)督方式在人類指令數(shù)據(jù)集上訓(xùn)練的LLM(SuperNI,T0 Trainer),但有趣的是,Self-Instruct并沒有優(yōu)于通過人工反饋強(qiáng)化學(xué)習(xí)(RLHF)訓(xùn)練的方法。

強(qiáng)化學(xué)習(xí)與人類反饋(RLHF)

雖然RLHF(基于人類反饋的強(qiáng)化學(xué)習(xí))可能無法完全解決LLM當(dāng)前的問題,但它目前被認(rèn)為是可用的最佳選擇,特別是與上一代LLM相比。

未來很可能會(huì)看到更多創(chuàng)造性的方法將RLHF應(yīng)用于LLM其他領(lǐng)域。

上面提到的兩篇論文InstructGPT和Consitutinal AI利用了RLHF,但從技術(shù)上來說,Consitutinal AI使用的是AI反饋而非人類反饋。

20. Asynchronous Methods for Deep Reinforcement Learning (2016)

論文鏈接:https://arxiv.org/pdf/1602.01783.pdf

這篇論文引入了策略梯度方法作為基于深度學(xué)習(xí)的RL中Q學(xué)習(xí)的替代方案。

21. Proximal Policy Optimization Algorithms (2017)

論文鏈接:https://arxiv.org/abs/1909.08593

這篇論文提出了一種改進(jìn)的基于近似策略的強(qiáng)化學(xué)習(xí)過程,比上面的策略優(yōu)化算法更具數(shù)據(jù)效率和可擴(kuò)展性。

22. Fine-Tuning Language Models from Human Preferences (2020)

論文鏈接:https://arxiv.org/abs/1909.08593

這篇論文說明了PPO的概念和對(duì)預(yù)訓(xùn)練語言模型的獎(jiǎng)勵(lì)學(xué)習(xí),包括KL正則化,以防止策略與自然語言偏離太遠(yuǎn)。

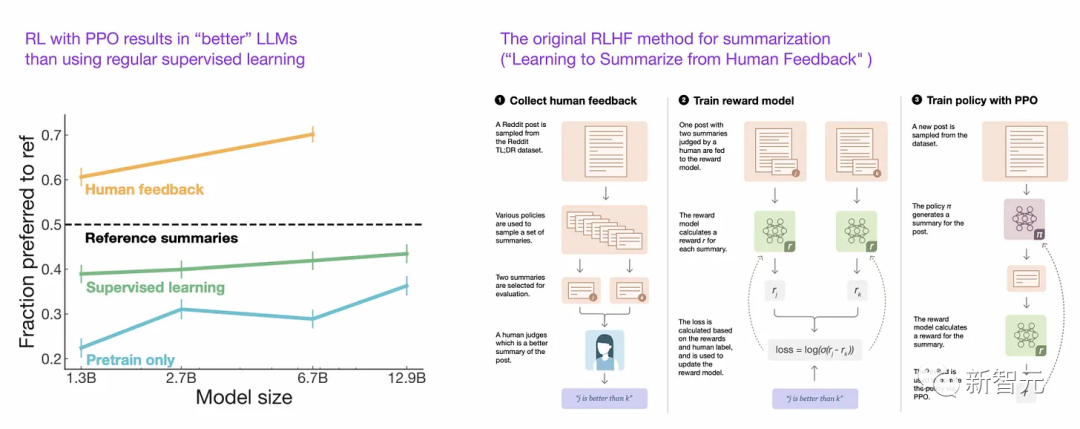

23. Learning to Summarize from Human Feedback (2022)

論文鏈接:https://arxiv.org/abs/2009.01325

這篇論文提出了常用的RLHF三步程序:

1. 預(yù)訓(xùn)練GPT-3

2. 以有監(jiān)督的方式進(jìn)行微調(diào)

3. 同樣以有監(jiān)督的方式訓(xùn)練獎(jiǎng)勵(lì)模型,然后使用具有鄰近策略優(yōu)化的獎(jiǎng)勵(lì)模型來訓(xùn)練微調(diào)模型。

論文還表明,與常規(guī)有監(jiān)督學(xué)習(xí)相比,具有近似策略優(yōu)化的強(qiáng)化學(xué)習(xí)可以產(chǎn)生更好的模型。

24. Training Language Models to Follow Instructions with Human Feedback (2022)

這篇論文提出InstructGPT使用與上述RLHF類似的三步過程,但不是總結(jié)文本,而是專注于基于人類指令生成文本。

論文鏈接:https://arxiv.org/pdf/2203.02155.pdf

除此之外,還使用一個(gè)標(biāo)簽器來從最好到最差對(duì)輸出進(jìn)行排名,而不僅僅是人類和AI生成的文本之間的二元比較。

總結(jié)

讀完上面列出的論文,就可以了解到當(dāng)前大型語言模型背后的設(shè)計(jì)、約束和演變過程,下面是一些可用的資源。

GPT的開源平替:

BLOOM: A 176B-Parameter Open-Access Multilingual Language Model (2022), https://arxiv.org/abs/2211.05100

OPT: Open Pre-trained Transformer Language Models (2022), https://arxiv.org/abs/2205.01068

UL2: Unifying Language Learning Paradigms (2022), https://arxiv.org/abs/2205.05131

ChatGPT的替代方案:

LaMDA: Language Models for Dialog Applications (2022), https://arxiv.org/abs/2201.08239

(Bloomz) Crosslingual Generalization through Multitask Finetuning (2022), https://arxiv.org/abs/2211.01786

(Sparrow) Improving Alignment of Dialogue Agents via Targeted Human Judgements (2022), https://arxiv.org/abs/2209.14375

BlenderBot 3: A Deployed Conversational Agent that Continually Learns to Responsibly Engage, https://arxiv.org/abs/2208.03188

計(jì)算生物學(xué)領(lǐng)域的大型語言模型

ProtTrans:Towards Cracking the Language of Life’s Code Through Self-Supervised Deep Learning and High Performance Computing(2021), https://arxiv.org/abs/2007.06225

Highly Accurate Protein Structure Prediction with AlphaFold (2021), https://www.nature.com/articles/s41586-021-03819-2

Large Language Models Generate Functional Protein Sequences Across Diverse Families (2023), https://www.nature.com/articles/s41587-022-01618-2