威大哥大等聯合發文!最新多模態大模型LLaVA問世,水平直逼GPT-4

視覺指令微調火了。

這篇論文名為Visual Instruction Tuning,由威斯康星大學麥迪遜分校,微軟研究院和哥倫比亞大學共同出品。

作者包括Haotian Liu,Chunyuan Li,Qingyang Wu和Yong Jae Lee。

同時,研究人員也在GitHub上開源了他們的代碼、模型和數據集。論文也發布在了Arxiv上。

講解

那么LLaVA的功能究竟是什么呢?如果一頭扎進論文,不熟悉的朋友可能會有些陌生。

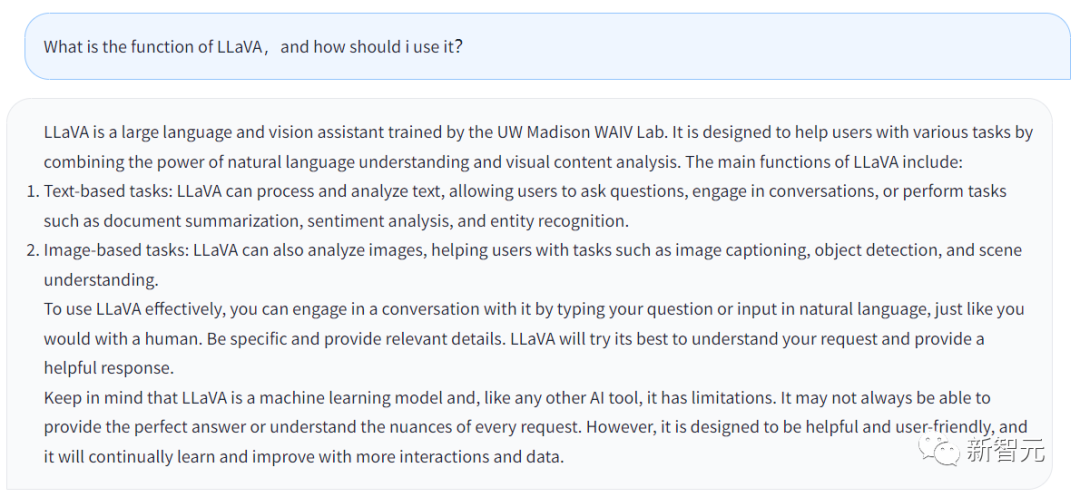

我們先看看LLaVA自己怎么說。

以上回答生成自LLaVA的Chatbot,我輸入的問題是,LLaVA的功能是什么,用戶該如何利用它?

回答如下:

LLaVA是一個大語言和視覺助手,在UW Madison WAIV實驗室經受的訓練。LLaVA被設計出來的目的,就是幫助用戶處理各類任務,方法則是借助自然語言理解的能力和視覺內容分析的能力。

LLaVA的主要功能包括:

· 以文本為基礎的任務:LLaVA可以處理并分析文本,允許用戶問問題,LLaVA可以和用戶交談,或者完成用戶輸入的任務,比如說提煉文件概要,情感分析,實體識別等等。

· 以圖像為基礎的任務:LLaVA可以分析圖像,描述圖像,進行物體識別,分析理解場景。

用戶如果想更好地應用LLaVA,可以直接和LLaVA進行交談,就像和人類之間對話一樣。盡可能多的提供細節,LLaVA就會生成出一個更完善的答案。

同時應該記住,說到底LLaVA是一個機器學習模型,是一個AI工具。只要是工具,就有其限制。LLaVA不一定每一次都能完美地回答用戶輸入的問題。

當然,LLaVA也在不斷學習和完善,其功能也會越來越強大。

總的來說,從LLaVA的回答中可以看出,在Chatbot這方面,和GPT的功能差不了太多。但是LLaVA可以處理一些有關圖像的任務。

表現出彩

研究人員在Arxiv的論文中詳細介紹了LLaVA的技術細節。

要知道使用機器生成的指令跟隨數據對大型語言模型(LLMs)進行指令微調,提高了新任務的零點能力,但這個想法在多模態領域的探索較少。

在論文中,研究人員首次嘗試使用僅有語言的GPT-4來生成多模態語言圖像的指令跟隨數據。

通過對這種生成的數據進行指令調整,研究人員引入了LLaVA:這是一個大型語言和視覺助手,是一個端到端的訓練有素的大型多模態模型,它連接了一個視覺編碼器和LLM,用于通用的視覺和語言理解。

早期實驗表明,LLaVA展示了令人印象深刻的多模態聊天能力,有時在未見過的圖像/指令上都能輸出多模態GPT-4的表現,在合成的多模態指令跟隨數據集上與GPT-4相比,獲得了85.1%的相對分數。

當對Science雜志進行微調時,LLaVA和GPT-4的協同作用達到了92.53%的新的最先進的準確性。

研究人員公開了GPT-4生成的視覺指令調整的數據、模型和代碼庫。

多模態模型

首先厘清定義。

大型多模態模型指的就是一種基于機器學習技術的模型,能夠處理和分析多種輸入類型,如文本和圖像。

這些模型設計用于處理更廣泛的任務,并且能夠理解不同形式的數據。通過將文本和圖像作為輸入,這些模型可以提高理解和編解釋的能力,從而生成更準確和相關的回答。

人類通過視覺和語言等多種渠道與世界互動,因為每個單獨的渠道在代表和傳達某些世界概念方面都有獨特的優勢,從而有利于更好地理解世界。

而人工智能的核心愿望之一是開發一個通用的助手,能夠有效地遵循多模態的視覺和語言指令,與人類的意圖一致,完成各種真實世界的任務。

因此,開發者社區見證了對開發語言增強的基礎視覺模型的新興趣,在開放世界的視覺理解方面具有強大的能力,如分類、檢測、分割、描述,以及視覺生成和編輯。

在這些功能中,每個任務都由一個單一的大型視覺模型獨立解決,在模型設計中隱含考慮了任務指令。

此外,語言只被用來描述圖像內容。雖然這允許語言在將視覺信號映射到語言語義方面發揮重要作用——這是人類交流的常見渠道。但這會導致模型通常具有固定的界面,互動性和對用戶指令的適應性有限。

而大型語言模型(LLM)表明,語言可以發揮更廣泛的作用:通用助手的通用界面,各種任務指令可以明確地用語言表示,并引導端到端訓練有素的神經助手切換到感興趣的任務來解決它。

例如,最近ChatGPT和GPT-4的成功,證明了這種LLM在遵循人類指令方面的能力,并激發了人們對開發開源LLM的巨大興趣。

LLaMA就是一個開源的LLM,其性能與GPT-3相當。正在進行的工作利用各種機器生成的高質量指令跟隨樣本來提高LLM的對齊能力,與專有LLM相比,報告了令人印象深刻的性能。重要的是,這一行的工作是純文本的。

在本文中,研究人員提出了視覺指令調整,這是將指令調整擴展到多模態空間的首次嘗試,它為建立一個通用的視覺助手鋪平了道路。具體來說,論文的主要內容包括:

多模態的指令跟隨數據。一個關鍵的挑戰是缺乏視覺語言指令-跟隨數據。我們提出了一個數據改革的觀點和管道,使用ChatGPT/GPT-4將圖像-文本對轉換為適當的指令-跟隨格式。

大型多模態模型。研究人員開發了一個大型多模態模型(LMM),通過連接CLIP的開放集視覺編碼器和語言解碼器LaMA,并在生成的教學視覺——語言數據上對它們進行端到端的微調。實證研究驗證了使用生成的數據進行LMM指令調諧的有效性,并為建立一個通用的指令跟隨的視覺代理提出了實用的建議。通過GPT 4,研究小組在Science QA多模態推理數據集上取得了最先進的性能。

開源。研究小組向公眾發開了以下內容:生成的多模態指令數據、用于數據生成和模型訓練的代碼庫、模型檢查點,以及一個視覺聊天演示。

成果展示

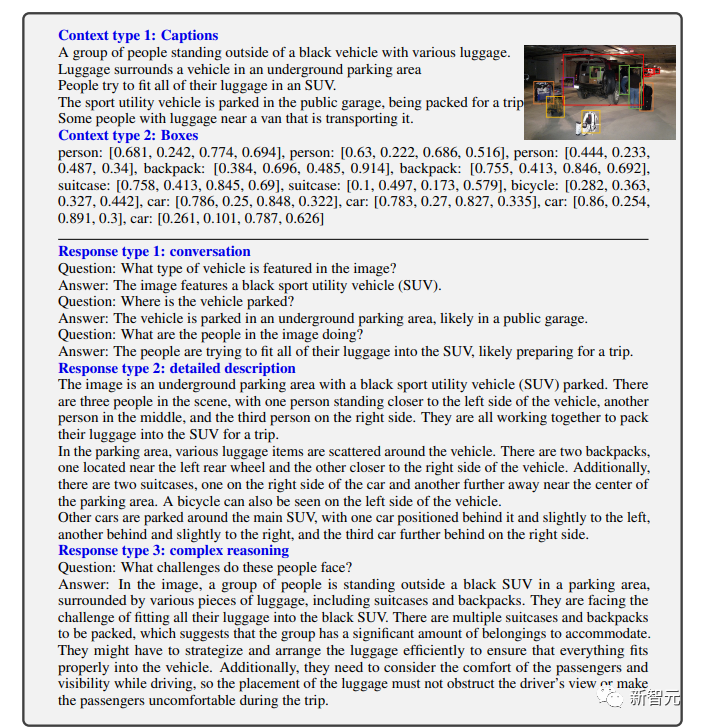

可以看到,LLaVA能處理各類問題,且生成的回答既全面又富有邏輯。

LLaVA表現出一些接近GPT-4水平的多模態能力,在視覺聊天方面,GPT-4相對評分85%。

而在推理問答方面,LLaVA甚至達到了新SoTA——92.53%,擊敗多模態思維鏈。