學(xué)習(xí)=擬合?深度學(xué)習(xí)和經(jīng)典統(tǒng)計(jì)學(xué)是一回事嗎?

?在這篇文章中,理論計(jì)算機(jī)科學(xué)家、哈佛大學(xué)知名教授 Boaz Barak 詳細(xì)比較了深度學(xué)習(xí)與經(jīng)典統(tǒng)計(jì)學(xué)的差異,認(rèn)為“如果純粹從統(tǒng)計(jì)學(xué)角度認(rèn)識深度學(xué)習(xí),就會忽略其成功的關(guān)鍵因素”。

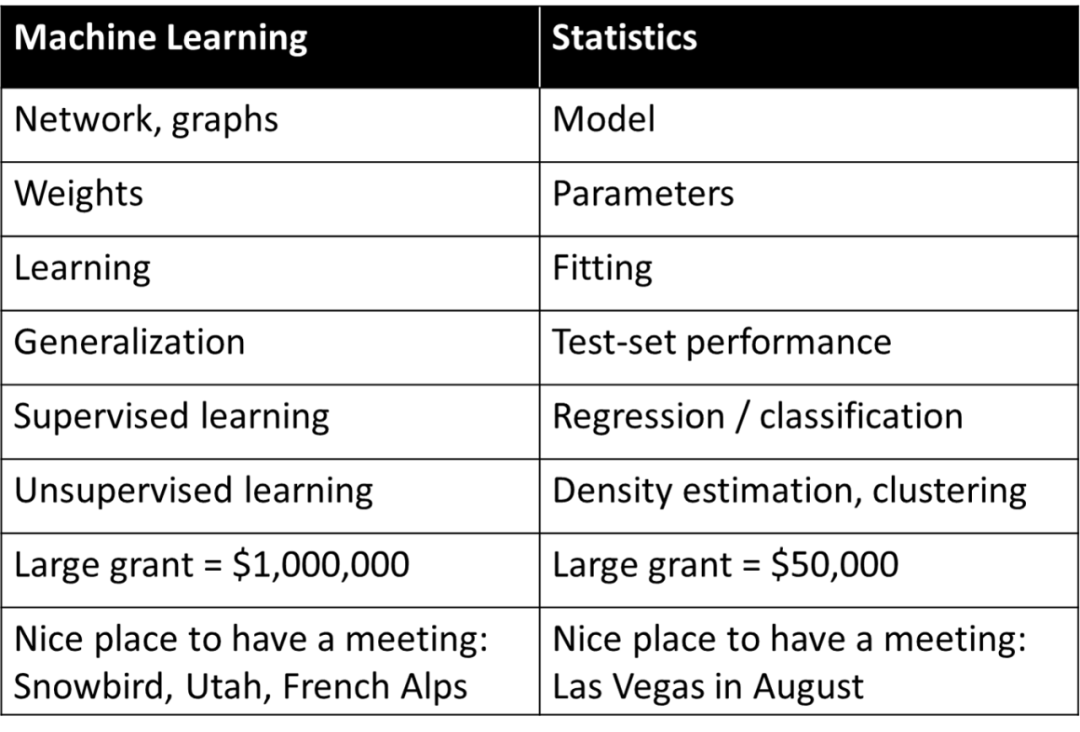

深度學(xué)習(xí)(或一般的機(jī)器學(xué)習(xí))經(jīng)常被認(rèn)為是簡單的統(tǒng)計(jì)學(xué),即它與統(tǒng)計(jì)學(xué)家研究的基本是相同的概念,但是使用與統(tǒng)計(jì)學(xué)不同的術(shù)語來描述。Rob Tibshirani 曾總結(jié)了下面這個(gè)有趣的“詞匯表”:

表中的某些內(nèi)容是不是很能引起共鳴?事實(shí)上所有從事機(jī)器學(xué)習(xí)的人都清楚,Tibshiriani 發(fā)布的這張表中,右側(cè)的許多術(shù)語在機(jī)器學(xué)習(xí)中已被廣泛使用。

如果純粹從統(tǒng)計(jì)學(xué)角度認(rèn)識深度學(xué)習(xí),就會忽略其成功的關(guān)鍵因素。對深度學(xué)習(xí)更恰當(dāng)?shù)脑u價(jià)是:它使用統(tǒng)計(jì)學(xué)術(shù)語來描述完全不同的概念。

對深度學(xué)習(xí)的恰當(dāng)評價(jià)不是它用不同的詞來描述舊的統(tǒng)計(jì)術(shù)語,而是它用這些術(shù)語來描述完全不同的過程。

本文會解釋為什么深度學(xué)習(xí)的基礎(chǔ)其實(shí)不同于統(tǒng)計(jì)學(xué),甚至不同于經(jīng)典的機(jī)器學(xué)習(xí)。本文首先討論模型擬合數(shù)據(jù)時(shí)的「解釋(explanation)」任務(wù)和「預(yù)測(prediction)」任務(wù)之間的差異。接著討論學(xué)習(xí)過程的兩個(gè)場景:1. 使用經(jīng)驗(yàn)風(fēng)險(xiǎn)最小化擬合統(tǒng)計(jì)模型; 2. 向?qū)W生傳授數(shù)學(xué)技能。然后,文章又討論了哪一個(gè)場景更接近深度學(xué)習(xí)的本質(zhì)。

雖然深度學(xué)習(xí)的數(shù)學(xué)和代碼與擬合統(tǒng)計(jì)模型幾乎相同。但在更深層次上,深度學(xué)習(xí)更像是向?qū)W生傳授數(shù)學(xué)技能這種場景。而且應(yīng)該很少有人敢宣稱:我掌握了完整的深度學(xué)習(xí)理論!其實(shí)是否存在這樣的理論也是存疑的。相反深度學(xué)習(xí)的不同方面最好從不同的角度來理解,而僅僅從統(tǒng)計(jì)角度無法提供完整的藍(lán)圖。

本文對比了深度學(xué)習(xí)和統(tǒng)計(jì)學(xué),這里的統(tǒng)計(jì)學(xué)特指的是“經(jīng)典統(tǒng)計(jì)學(xué)”,因?yàn)樗谎芯康米罹茫⑶以诮炭茣薪?jīng)久不衰。許多統(tǒng)計(jì)學(xué)家正在研究深度學(xué)習(xí)和非經(jīng)典理論方法,就像 20 世紀(jì)物理學(xué)家需要擴(kuò)展經(jīng)典物理學(xué)的框架一樣。事實(shí)上,模糊計(jì)算機(jī)科學(xué)家和統(tǒng)計(jì)學(xué)家之間的界限對雙方都是有利的。

預(yù)測與模型擬合

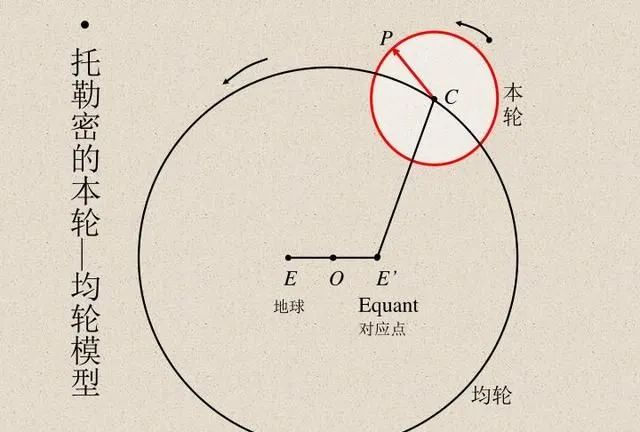

一直以來,科學(xué)家們都是將模型計(jì)算結(jié)果與實(shí)際觀測結(jié)果進(jìn)行比較,以驗(yàn)證模型的準(zhǔn)確性。埃及天文學(xué)家托勒密提出了關(guān)于行星運(yùn)動(dòng)的巧妙模型。托勒密的模型遵循地心說,但有一系列的本輪(見下圖),使其具有極好的預(yù)測準(zhǔn)確性。相比之下,哥白尼最初的日心說模型比托勒密模型簡單,但在預(yù)測觀察結(jié)果方面不太準(zhǔn)確。(哥白尼后來添加了自己的本輪,以便能夠與托勒密的模型媲美。)

托勒密和哥白尼的模型都是無與倫比的。如果我們想通過 “黑盒” 進(jìn)行預(yù)測,那么托勒密的地心模型更勝一籌。但如果你想要一個(gè)簡單的模型,以便可以“觀察模型內(nèi)部”(這是解釋恒星運(yùn)動(dòng)理論的起點(diǎn)),那么哥白尼的模型是不二選擇。后來,開普勒將哥白尼的模型改進(jìn)為橢圓軌道,并提出了開普勒行星運(yùn)動(dòng)三定律,這使得牛頓能夠用適用于地球的引力定律來解釋行星規(guī)律。

因此,重要的是,日心說模型不只是一個(gè)提供預(yù)測的“黑盒”,而是由幾個(gè)簡單的數(shù)學(xué)方程給出的,但是方程中的 “運(yùn)動(dòng)部分” 極少。多年來,天文學(xué)一直是發(fā)展統(tǒng)計(jì)技術(shù)的靈感來源。高斯和勒讓德分別獨(dú)立地在 1800 年左右發(fā)明了最小二乘回歸,以預(yù)測小行星和其他天體的軌道。1847 年,柯西發(fā)明了梯度下降法,這也是由天文預(yù)測推動(dòng)的。

在物理學(xué)中,有時(shí)學(xué)者們可以掌握全部細(xì)節(jié),從而找到 “正確” 的理論,把預(yù)測準(zhǔn)確性做到最優(yōu),并且對數(shù)據(jù)做出最好的解釋。這些都在奧卡姆剃刀之類的觀點(diǎn)范疇內(nèi),可以認(rèn)為是假設(shè)簡單性、預(yù)測能力和解釋性都相互和諧一致的。

然而,在許多其它領(lǐng)域,解釋和預(yù)測這兩個(gè)目標(biāo)之間的關(guān)系卻沒有那么和諧。如果只想預(yù)測觀察結(jié)果,通過 “黑盒” 可能是最好的。另一方面,如果想獲得解釋性的信息,如因果模型、通用原則或重要特征,那么可以理解和解釋的模型可能越簡單越好。

模型的正確選擇與否取決于其用途。例如,考慮一個(gè)包含許多個(gè)體的遺傳表達(dá)和表型(例如某些疾病)的數(shù)據(jù)集,如果目標(biāo)是預(yù)測一個(gè)人生病的幾率,那么無論它有多復(fù)雜或依賴于多少個(gè)基因,都要使用適配該任務(wù)的最佳預(yù)測模型。相反,如果目的是識別一些基因,以便進(jìn)行進(jìn)一步研究,那么一個(gè)復(fù)雜的非常精確的 “黑盒” 的用處是有限的。

統(tǒng)計(jì)學(xué)家 Leo Breiman 在 2001 年關(guān)于統(tǒng)計(jì)建模的兩種文化的著名文章中闡述了這一點(diǎn)。第一種是“數(shù)據(jù)建模文化”,側(cè)重于能解釋數(shù)據(jù)的簡單生成模型。第二種是“算法建模文化”,對數(shù)據(jù)的生成方式不可知,側(cè)重于尋找能夠預(yù)測數(shù)據(jù)的模型,無論其多么復(fù)雜。

論文標(biāo)題:

Statistical Modeling: The Two Cultures

論文鏈接:

https://projecteuclid.org/euclid.ss/1009213726

Breiman 認(rèn)為,統(tǒng)計(jì)學(xué)過于受第一種文化的支配,這種關(guān)注造成兩種問題:

- 導(dǎo)致了不相關(guān)的理論和可疑的科學(xué)結(jié)論

- 阻止了統(tǒng)計(jì)學(xué)家研究令人興奮的新問題

Breiman 的論文一出,就引起了一些爭議。同為統(tǒng)計(jì)學(xué)家的 Brad Efron 回應(yīng)說,雖然他同意一些觀點(diǎn),但他也強(qiáng)調(diào),Breiman 的論點(diǎn)似乎是反對節(jié)儉和科學(xué)見解,支持花大力氣制造復(fù)雜的“黑盒”。但在最近的一篇文章中,Efron 摒棄了之前的觀點(diǎn),承認(rèn) Breima 更有先見之明,因?yàn)椤?1 世紀(jì)統(tǒng)計(jì)學(xué)的焦點(diǎn)都聚焦在預(yù)測算法上,在很大程度上沿著 Breiman 提出的路線演進(jìn)”。

經(jīng)典和現(xiàn)代預(yù)測模型

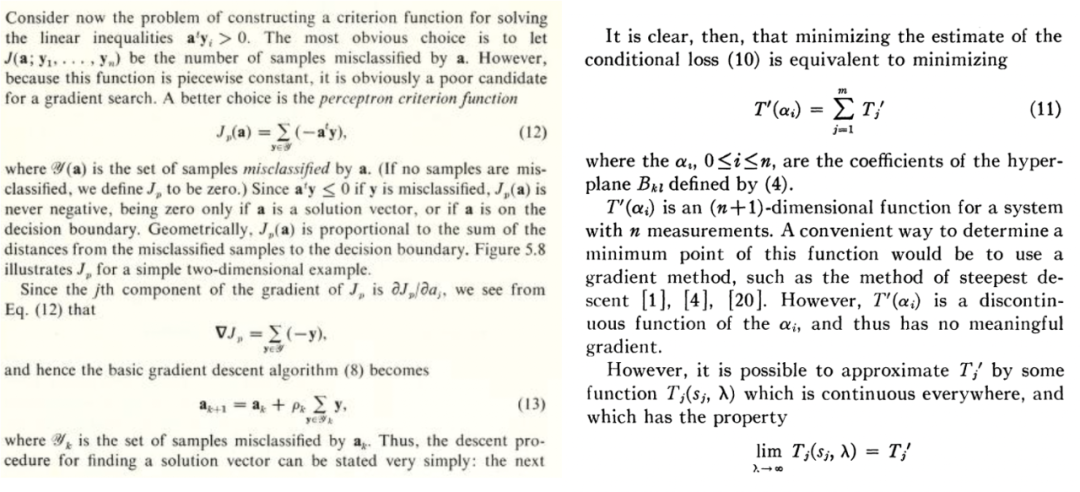

機(jī)器學(xué)習(xí),無論是不是深度學(xué)習(xí),都沿著 Breiman 的第二種觀點(diǎn)演進(jìn),即以預(yù)測為重點(diǎn)。這種文化有著悠久的歷史。例如,Duda 和 Hart 在 1973 年出版的教科書和 Highleyman 1962 年的論文就寫到了下圖中的內(nèi)容,這對于今天的深度學(xué)習(xí)研究者來說是非常容易理解的:

Duda 和 Hart 的教科書《Pattern classification and scene analysis》和 Highleyman 1962 年的論文《The Design and Analysis of Pattern Recognition Experiments》中的片段。

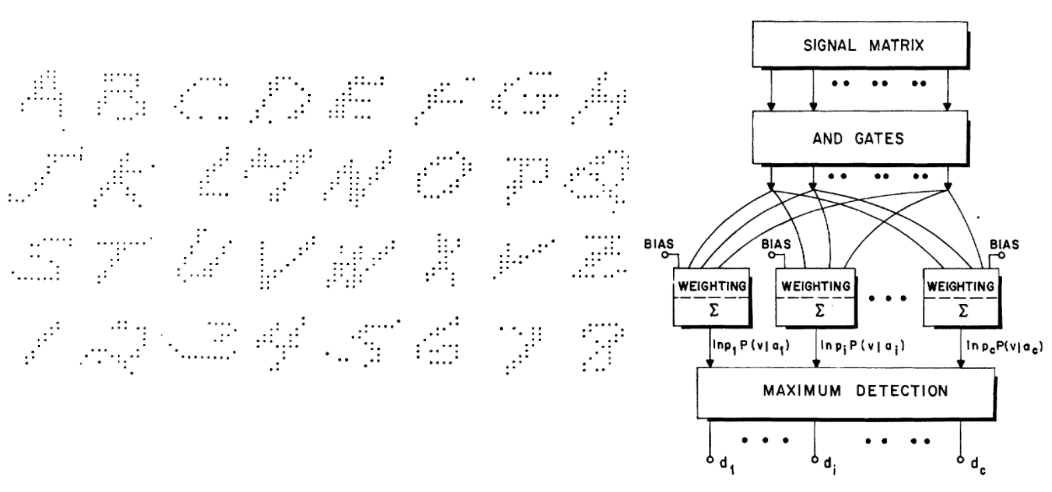

類似地,下圖中的 Highleyman 的手寫字符數(shù)據(jù)集和用于擬合它的架構(gòu) Chow(1962)(準(zhǔn)確率約為 58%)也會引起很多人的共鳴。

為什么深度學(xué)習(xí)與眾不同?

1992 年,Geman、Bienenstock 和 Doursat 寫了一篇關(guān)于神經(jīng)網(wǎng)絡(luò)的悲觀文章,認(rèn)為 “當(dāng)前的前饋神經(jīng)網(wǎng)絡(luò)在很大程度上不足以解決機(jī)器感知和機(jī)器學(xué)習(xí)中的難題”。具體來說,他們認(rèn)為通用神經(jīng)網(wǎng)絡(luò)在處理困難任務(wù)方面不會成功,而它們成功的唯一途徑是通過人工設(shè)計(jì)的特征。用他們的話說:“重要屬性必須是內(nèi)置的或“硬連接的”…… 而不是以任何統(tǒng)計(jì)意義上的方式學(xué)習(xí)。” 現(xiàn)在看來 Geman 等人完全錯(cuò)了,但更有意思的是了解他們?yōu)槭裁村e(cuò)了。

深度學(xué)習(xí)確實(shí)不同于其它學(xué)習(xí)方法。雖然深度學(xué)習(xí)似乎只是預(yù)測,就像最近鄰或隨機(jī)森林一樣,但它可能有更多的復(fù)雜參數(shù)。這看起來似乎只是量的差異,而不是質(zhì)的差異。但在物理學(xué)中,一旦尺度變化了幾個(gè)數(shù)量級,通常就需要完全不同的理論,深度學(xué)習(xí)也是如此。深度學(xué)習(xí)與經(jīng)典模型(參數(shù)化或非參數(shù)化)的基礎(chǔ)過程完全不同,雖然它們的數(shù)學(xué)方程(和 Python 代碼)在更高層次上來看是相同的。

為了說明這一點(diǎn),下面考慮兩個(gè)不同的場景:擬合統(tǒng)計(jì)模型和向?qū)W生教授數(shù)學(xué)。

場景 A:擬合一個(gè)統(tǒng)計(jì)模型

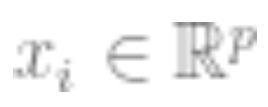

通過數(shù)據(jù)去擬合一個(gè)統(tǒng)計(jì)模型的典型步驟如下:

1. 這里有一些數(shù)據(jù) (

( 是

是 的矩陣;

的矩陣; 是

是 維向量,即類別標(biāo)簽。把數(shù)據(jù)認(rèn)為是來自某個(gè)有結(jié)構(gòu)且包含噪聲的模型,就是要去擬合的模型)

維向量,即類別標(biāo)簽。把數(shù)據(jù)認(rèn)為是來自某個(gè)有結(jié)構(gòu)且包含噪聲的模型,就是要去擬合的模型)

2. 使用上面的數(shù)據(jù)擬合一個(gè)模型 ,并用優(yōu)化算法來最小化經(jīng)驗(yàn)風(fēng)險(xiǎn)。就是說通過優(yōu)化算法找到這樣的

,并用優(yōu)化算法來最小化經(jīng)驗(yàn)風(fēng)險(xiǎn)。就是說通過優(yōu)化算法找到這樣的 ,使得

,使得 最小,

最小, 代表損失(表明預(yù)測值有多接近真實(shí)值),

代表損失(表明預(yù)測值有多接近真實(shí)值), 是可選的正則化項(xiàng)。

是可選的正則化項(xiàng)。

3. 模型的總體損失越小越好,即泛化誤差 的值相對最小。

的值相對最小。

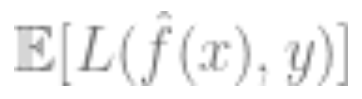

Effron 從包含噪聲的觀測中恢復(fù)牛頓第一定律的展示圖

這個(gè)非常通用的范例其實(shí)包含許多內(nèi)容,如最小二乘線性回歸、最近鄰、神經(jīng)網(wǎng)絡(luò)訓(xùn)練等等。在經(jīng)典統(tǒng)計(jì)場景中,我們通常會碰到下面的情況:

權(quán)衡:假設(shè)是經(jīng)過優(yōu)化的模型集合(如果函數(shù)是非凸的或包含正則化項(xiàng),精心選擇算法和正則化,可得到模型集。的偏差是元素所能達(dá)到的最接近真值的近似值。集合越大,偏差越小,并且可能為 0(如果)。

然而,越大,需要縮小其成員范圍的樣本越多,因此算法輸出模型的方差越大。總體泛化誤差是偏差和方差的總和。因此,統(tǒng)計(jì)學(xué)習(xí)通常是 Bias-Variance 權(quán)衡,正確的模型復(fù)雜度是將總體誤差降至最低。事實(shí)上,Geman 等人證明了其對神經(jīng)網(wǎng)絡(luò)的悲觀態(tài)度,他們認(rèn)為:Bias-Variance 困境造成的基本限制適用于所有非參數(shù)推理模型,包括神經(jīng)網(wǎng)絡(luò)。

“多多益善”并不總是成立:在統(tǒng)計(jì)學(xué)習(xí)中,更多的特征或數(shù)據(jù)并不一定會提高性能。例如,從包含許多不相關(guān)特征的數(shù)據(jù)中學(xué)習(xí)是很難的。類似地,從混合模型中學(xué)習(xí),其中數(shù)據(jù)來自兩個(gè)分布中的一個(gè)(如和,比獨(dú)立學(xué)習(xí)每個(gè)分布更難。

收益遞減:在很多情況中,將預(yù)測噪聲降低到水平所需的數(shù)據(jù)點(diǎn)數(shù)量與參數(shù)和是有關(guān)的,即數(shù)據(jù)點(diǎn)數(shù)量約等于。在這種情況下,需要大約 k 個(gè)樣本才能啟動(dòng),但一旦這樣做,就面臨著回報(bào)遞減的情況,即如果需要個(gè)點(diǎn)才能達(dá)到 90% 的準(zhǔn)確率,則需要大約額外的個(gè)點(diǎn)來將準(zhǔn)確率提高到 95%。一般來說,隨著資源增加(無論是數(shù)據(jù)、模型復(fù)雜度還是計(jì)算),人們希望獲得越來越精細(xì)的區(qū)分,而不是解鎖特定的新功能。

對損失、數(shù)據(jù)的嚴(yán)重依賴性:當(dāng)將模型擬合到高維數(shù)據(jù)時(shí),任何小細(xì)節(jié)都可能會產(chǎn)生很大的差異。L1 或 L2 正則化器等選擇很重要,更不用說使用完全不同的數(shù)據(jù)集。不同數(shù)量的高維優(yōu)化器相互之間也非常不同。

數(shù)據(jù)是相對 “單純” 的:通常會假設(shè)數(shù)據(jù)是獨(dú)立于某些分布進(jìn)行采樣的。雖然靠近決策邊界的點(diǎn)很難分類,但考慮到高維度上測量集中現(xiàn)象,可以認(rèn)為大多數(shù)點(diǎn)的距離都是相近的。因此在經(jīng)典的數(shù)據(jù)分布中,數(shù)據(jù)點(diǎn)間的距離差異是不大的。然而,混合模型可以顯示這種差異,因此,與上述其他問題不同,這種差異在統(tǒng)計(jì)中很常見。

場景 B:學(xué)習(xí)數(shù)學(xué)

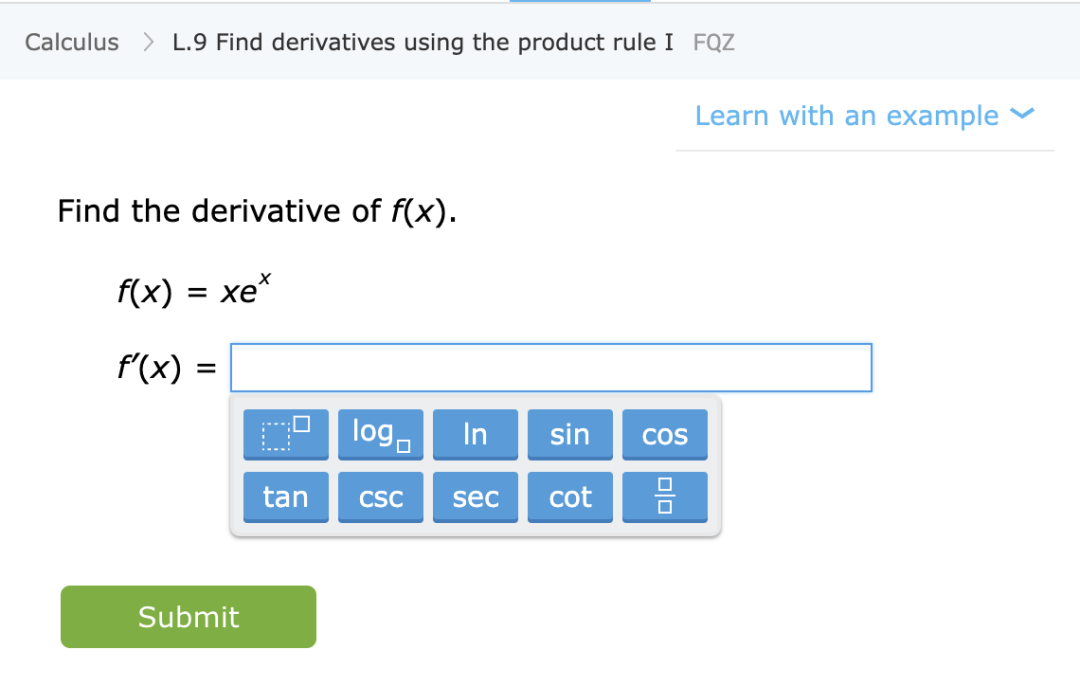

在這個(gè)場景中,我們假設(shè)你想通過一些說明和練習(xí)來教學(xué)生數(shù)學(xué)(如計(jì)算導(dǎo)數(shù))。這個(gè)場景雖然沒有正式定義,但有一些定性特征:

學(xué)習(xí)一項(xiàng)技能,而不是去近似一個(gè)統(tǒng)計(jì)分布:在這種情況下,學(xué)生學(xué)習(xí)的是一種技能,而不是某個(gè)量的估計(jì) / 預(yù)測。具體來說,即使將練習(xí)映射到解的函數(shù)不能被用作解決某些未知任務(wù)的“黑盒”,但學(xué)生在解決這些問題時(shí)形成的思維模式仍然對未知任務(wù)是有用的。

多多益善:一般來說,做題越多、題型涉獵越廣的學(xué)生表現(xiàn)越好。同時(shí)做一些微積分題和代數(shù)題,不會導(dǎo)致學(xué)生的微積分成績下降,相反可能幫助其微積分成績提升。

從提升能力到自動(dòng)化表示:雖然在某些情況下,解決問題的回報(bào)也會遞減,但學(xué)生的學(xué)習(xí)會經(jīng)歷幾個(gè)階段。有一個(gè)階段,解決一些問題有助于理解概念并解鎖新的能力。此外,當(dāng)學(xué)生重復(fù)某一特定類型的問題時(shí),他們見到同類問題就會形成自動(dòng)化的解題流程,從之前的能力提升轉(zhuǎn)變?yōu)樽詣?dòng)化解題。

表現(xiàn)獨(dú)立于數(shù)據(jù)和損失:教授數(shù)學(xué)概念的方法不止一種。使用不同書、教育方法或評分系統(tǒng)學(xué)習(xí)的學(xué)生最終可以學(xué)習(xí)到相同的內(nèi)容以及相似的數(shù)學(xué)能力。

有些問題更困難:在數(shù)學(xué)練習(xí)中,我們經(jīng)常看到不同學(xué)生解決同一問題的方式之間存在著很強(qiáng)的相關(guān)性。對于一個(gè)問題來說,似乎確實(shí)存在一個(gè)固有的難度水平,以及一個(gè)對學(xué)習(xí)最有利的自然難度遞進(jìn)。

深度學(xué)習(xí)更像是統(tǒng)計(jì)估計(jì)還是學(xué)生學(xué)習(xí)技能?

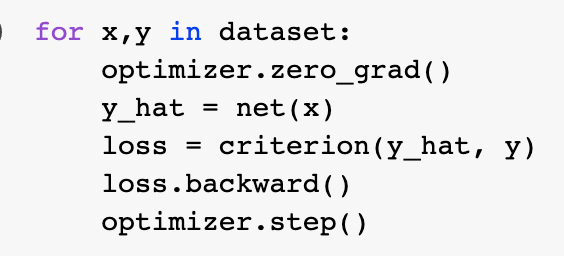

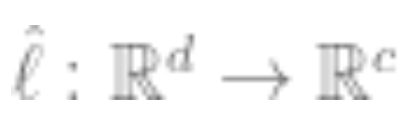

上面兩個(gè)場景的比喻中,哪一個(gè)用來描述現(xiàn)代深度學(xué)習(xí)更恰當(dāng)?具體來說,它成功的原因是什么?統(tǒng)計(jì)模型擬合可以很好地使用數(shù)學(xué)和代碼來表達(dá)。實(shí)際上,規(guī)范的 Pytorch 訓(xùn)練循環(huán)通過經(jīng)驗(yàn)風(fēng)險(xiǎn)最小化訓(xùn)練深度網(wǎng)絡(luò):

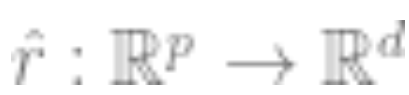

在更深的層次上,這兩種場景之間的關(guān)系并不清楚。為了更具體,這里以一個(gè)特定的學(xué)習(xí)任務(wù)為例。考慮使用 “自監(jiān)督學(xué)習(xí) + 線性探測” 方法訓(xùn)練的分類算法。具體算法訓(xùn)練如下:

?1. 假設(shè)數(shù)據(jù)是一個(gè)序列,其中? 是某個(gè)數(shù)據(jù)點(diǎn)(比如一張圖片),是標(biāo)簽。?

是某個(gè)數(shù)據(jù)點(diǎn)(比如一張圖片),是標(biāo)簽。?

?2. 首先得到表示函數(shù) 的深度神經(jīng)網(wǎng)絡(luò)。通過最小化某種類型的自監(jiān)督損失函數(shù),僅使用數(shù)據(jù)點(diǎn)而不使用標(biāo)簽來訓(xùn)練該函數(shù)。這種損失函數(shù)的例子是重建(用其它輸入恢復(fù)輸入)或?qū)Ρ葘W(xué)習(xí)(核心思想是正樣本和負(fù)樣本在特征空間對比,學(xué)習(xí)樣本的特征表示)。

的深度神經(jīng)網(wǎng)絡(luò)。通過最小化某種類型的自監(jiān)督損失函數(shù),僅使用數(shù)據(jù)點(diǎn)而不使用標(biāo)簽來訓(xùn)練該函數(shù)。這種損失函數(shù)的例子是重建(用其它輸入恢復(fù)輸入)或?qū)Ρ葘W(xué)習(xí)(核心思想是正樣本和負(fù)樣本在特征空間對比,學(xué)習(xí)樣本的特征表示)。

3. 使用完整的標(biāo)記數(shù)據(jù)擬合線性分類器 (是類數(shù)),以最小化交叉熵?fù)p失。我們的最終分類器是:

(是類數(shù)),以最小化交叉熵?fù)p失。我們的最終分類器是:

步驟 3 僅適用于線性分類器,因此 “魔術(shù)” 發(fā)生在步驟 2 中(深度網(wǎng)絡(luò)的自監(jiān)督學(xué)習(xí))。在自監(jiān)督學(xué)習(xí)中有些重要屬性:

學(xué)習(xí)一項(xiàng)技能而不是去近似一個(gè)函數(shù):自監(jiān)督學(xué)習(xí)不是逼近函數(shù),而是學(xué)習(xí)可用于各種下游任務(wù)的表示(這是自然語言處理的主導(dǎo)范式)。通過線性探測、微調(diào)或激勵(lì)獲得下游任務(wù)是次要的。

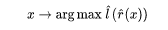

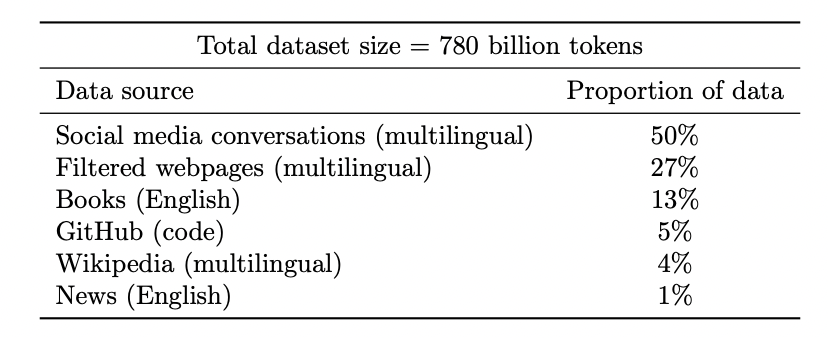

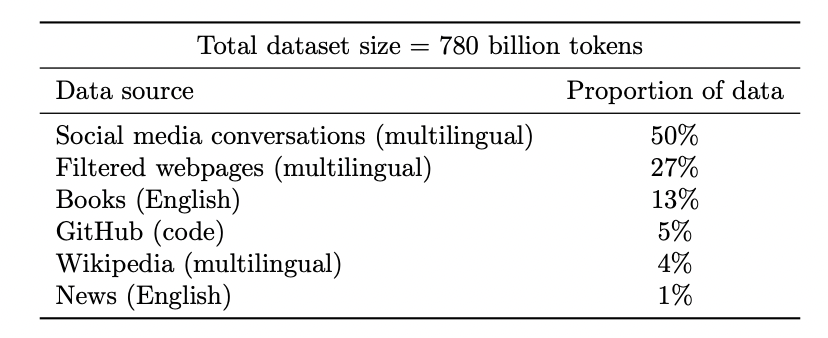

多多益善:在自監(jiān)督學(xué)習(xí)中,表示質(zhì)量隨著數(shù)據(jù)量的增加而提高,不會因?yàn)榛旌狭藥讉€(gè)來源的數(shù)據(jù)而變糟。事實(shí)上,數(shù)據(jù)越多樣化越好。

Coogle PaLM 模型的數(shù)據(jù)集

解鎖新能力:隨著資源(數(shù)據(jù)、計(jì)算、模型大小)投入的增加,深度學(xué)習(xí)模型也在不連續(xù)地改進(jìn)。在一些組合環(huán)境中也證明了這一點(diǎn)。

隨著模型規(guī)模的增加,PaLM 在基準(zhǔn)測試中顯示出不連續(xù)的改進(jìn),并且解鎖令人驚訝的功能,比如解釋笑話為什么好笑。

性能幾乎與損失或數(shù)據(jù)無關(guān):存在多個(gè)自監(jiān)督損失,圖像研究中其實(shí)使用了多種對比和重建損失,語言模型使用單邊重建(預(yù)測下一個(gè) token)或使用 mask 模型,預(yù)測來自左右 token 的 mask 輸入。也可以使用稍微不同的數(shù)據(jù)集。這些可能會影響效率,但只要做出 “合理” 的選擇,通常原始資源比使用的特定損失或數(shù)據(jù)集更能提升預(yù)測性能。

有些情況比其他情況更困難:這一點(diǎn)并不特定于自監(jiān)督學(xué)習(xí)。數(shù)據(jù)點(diǎn)似乎有一些固有的 “難度級別”。事實(shí)上,不同的學(xué)習(xí)算法具有不同的“技能水平”,不同的數(shù)據(jù) dian 具有不同的” 難度水平“(分類器正確分類點(diǎn)的概率隨的技能而單調(diào)提升,隨難度單調(diào)降低)。

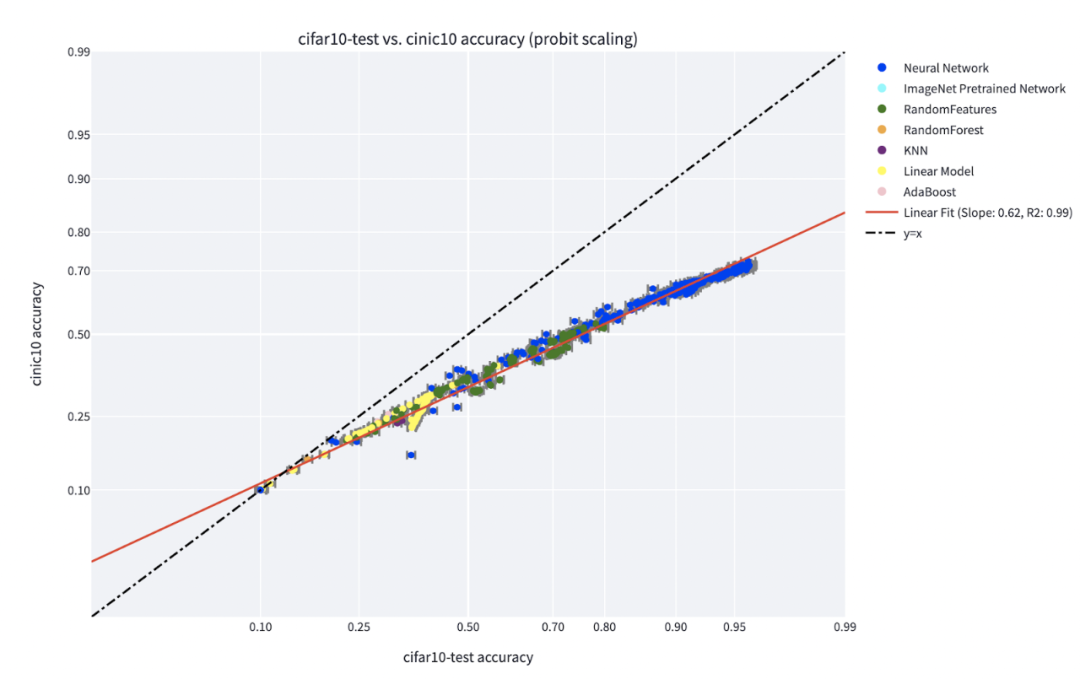

“技能與難度(skill vs. difficulty)”范式是對 Recht 等人和 Miller 等人發(fā)現(xiàn)的 “accuracy on the line” 現(xiàn)象的最清晰解釋。Kaplen、Ghosh、Garg 和 Nakkiran 的論文還展示了數(shù)據(jù)集中的不同輸入如何具有固有的“難度剖面”,對于不同的模型族,該剖面通常是穩(wěn)健的。

C**IFAR-10 上訓(xùn)練并在 CINIC-10 上測試的分類器的 accuracy on the line 現(xiàn)象。圖源:https://millerjohnp-linearfits-app-app-ryiwcq.streamlitapp.com/

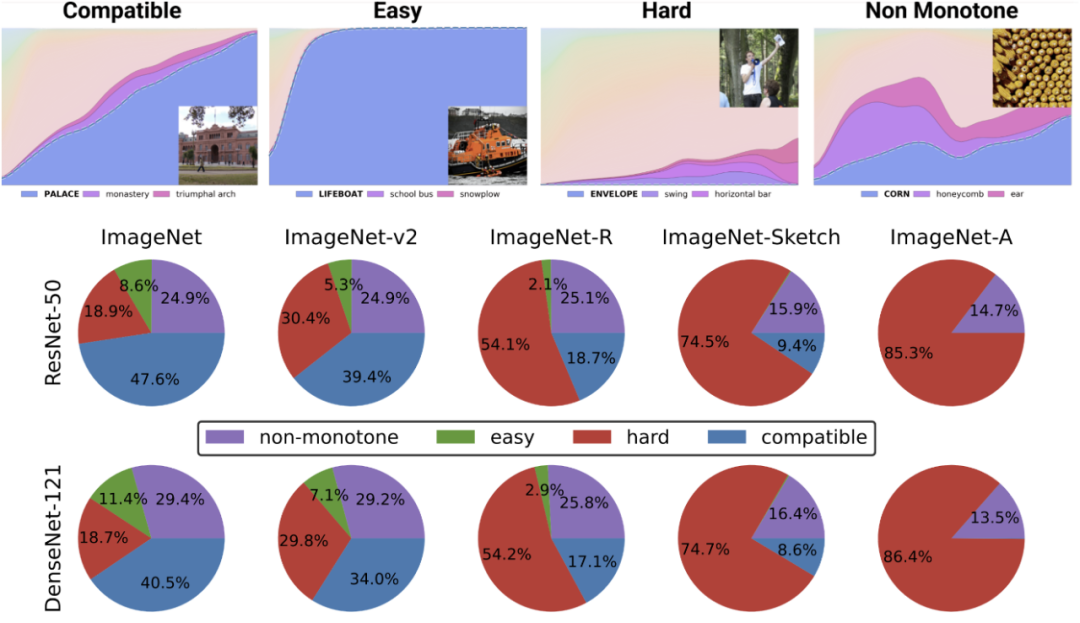

頂部的圖描述了最可能類別的不同 softmax 概率,作為某個(gè)類別分類器的全局精度的函數(shù),該類別由訓(xùn)練時(shí)間索引。底部的餅圖顯示了不同數(shù)據(jù)集分解為不同類型的點(diǎn)(注意,這種分解對于不同的神經(jīng)結(jié)構(gòu)是相似的)。

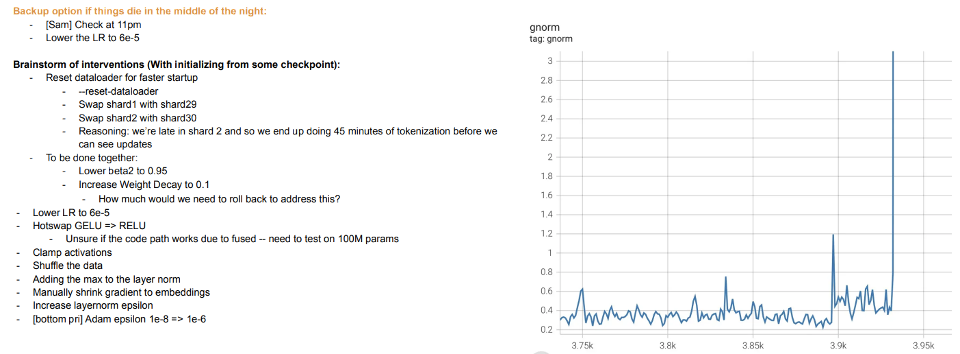

訓(xùn)練就是教學(xué):現(xiàn)代大模型的訓(xùn)練似乎更像是教學(xué)生,而不是讓模型擬合數(shù)據(jù),當(dāng)學(xué)生不懂或感到疲倦時(shí),就 “休息” 或嘗試不同的方法(訓(xùn)練差異)。Meta 的大模型訓(xùn)練日志很有啟發(fā)性——除了硬件問題外,我們還可以看到干預(yù)措施,例如在訓(xùn)練過程中切換不同的優(yōu)化算法,甚至考慮 “hot swapping” 激活函數(shù)(GELU to RELU)。如果將模型訓(xùn)練視為擬合數(shù)據(jù),而不是學(xué)習(xí)表示,則后者沒有多大意義。

Meta 訓(xùn)練日志摘錄

4.1 但是監(jiān)督學(xué)習(xí)怎樣呢?

前面討論了自監(jiān)督學(xué)習(xí),但深度學(xué)習(xí)的典型例子,仍然是監(jiān)督學(xué)習(xí)。畢竟,深度學(xué)習(xí)的 “ImageNet 時(shí)刻” 來自 ImageNet。那么上面所討論的是否仍然適用于這個(gè)設(shè)定?

首先,有監(jiān)督的大規(guī)模深度學(xué)習(xí)的出現(xiàn)在某種程度上是個(gè)偶然,這得益于大型高質(zhì)量標(biāo)記數(shù)據(jù)集(即 ImageNet)的可用性。如果你想象力豐富,可以想象另一種歷史,即深度學(xué)習(xí)首先開始通過無監(jiān)督學(xué)習(xí)在自然語言處理方面取得突破性進(jìn)展,然后才轉(zhuǎn)移到視覺和監(jiān)督學(xué)習(xí)中。

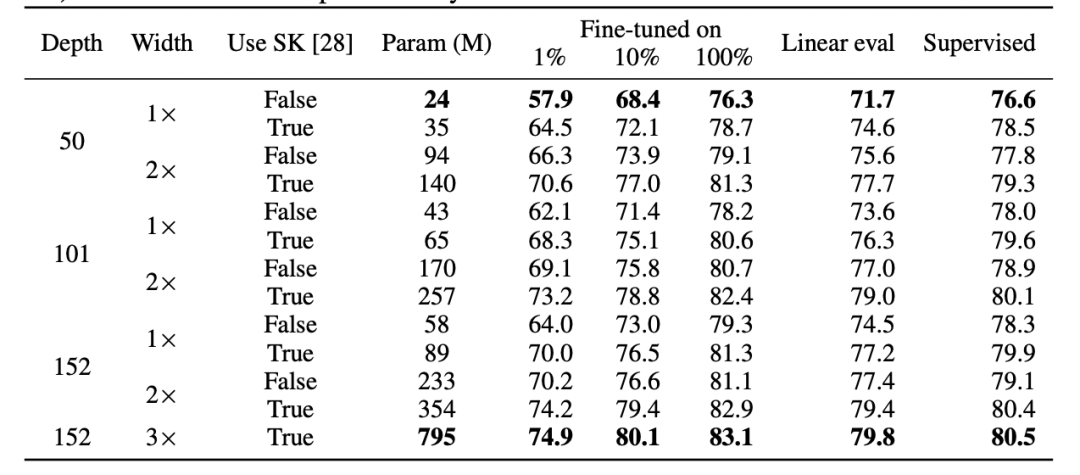

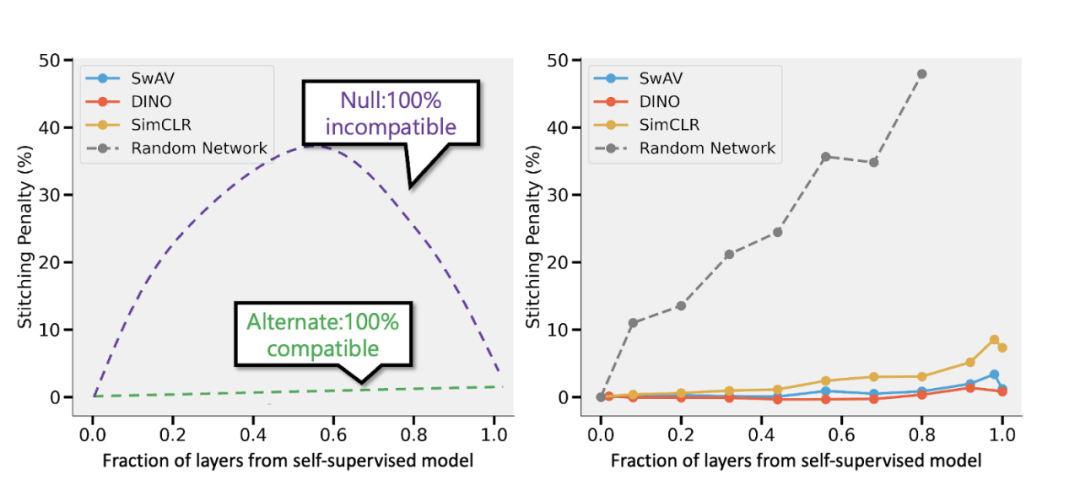

其次,有證據(jù)表明,盡管使用完全不同的損失函數(shù),但監(jiān)督學(xué)習(xí)和自監(jiān)督學(xué)習(xí)在”內(nèi)部“的行為其實(shí)是相似的。兩者通常都能達(dá)到相同的性能。具體地,對于每一個(gè),人們可以將通過自監(jiān)督訓(xùn)練的深度為 d 的模型的前 k 層與監(jiān)督模型的最后 d-k 層合在一起,而性能損失很小。

SimCLR v2 論文的表格。請注意監(jiān)督學(xué)習(xí)、微調(diào)(100%)自監(jiān)督和自監(jiān)督 + 線性探測之間在性能上的一般相似性(圖源:https://arxiv.org/abs/2006.10029)

拼接自監(jiān)督模型和 Bansal 等人的監(jiān)督模型(https://arxiv.org/abs/2106.07682)。左:如果自監(jiān)督模型的準(zhǔn)確率(比如)比監(jiān)督模型低 3%,則當(dāng)層的 p 部分來自自監(jiān)督模型時(shí),完全兼容的表示將導(dǎo)致拼接懲罰為 p 3%。如果模型完全不兼容,那么我們預(yù)計(jì)隨著合并更多模型,準(zhǔn)確率會急劇下降。右:合并不同自監(jiān)督模型的實(shí)際結(jié)果。

自監(jiān)督 + 簡單模型的優(yōu)勢在于,它們可以將特征學(xué)習(xí)或 “深度學(xué)習(xí)魔法”(由深度表示函數(shù)完成)與統(tǒng)計(jì)模型擬合(由線性或其他“簡單” 分類器在此表示之上完成)分離。

最后,雖然這更像是一種推測,但事實(shí)上 “元學(xué)習(xí)” 似乎往往等同于學(xué)習(xí)表征(參見:https://arxiv.org/abs/1909.09157,https://arxiv.org/abs/2206.03271),這可以被視為另一個(gè)證據(jù),證明這在很大程度上是在進(jìn)行的,而不管模型優(yōu)化的目標(biāo)是什么。

4.2 過度參數(shù)化怎么辦?

本文跳過了被認(rèn)為是統(tǒng)計(jì)學(xué)習(xí)模型和深度學(xué)習(xí)在實(shí)踐中存在差異的典型例子:缺乏 “Bias-Variance 權(quán)衡” 以及過度參數(shù)化模型的良好泛化能力。

為什么要跳過?有兩個(gè)原因:

- 首先,如果監(jiān)督學(xué)習(xí)確實(shí)等于自監(jiān)督 + 簡單學(xué)習(xí),那么這可能解釋了它的泛化能力。

- 其次,過度參數(shù)化并不是深度學(xué)習(xí)成功的關(guān)鍵。深度網(wǎng)絡(luò)之所以特別,并不是因?yàn)樗鼈兣c樣本數(shù)量相比大,而是因?yàn)樗鼈冊诮^對值上大。事實(shí)上,通常在無監(jiān)督 / 自監(jiān)督學(xué)習(xí)中,模型不會過度參數(shù)化。即使對于非常大的語言模型,它們的數(shù)據(jù)集也更大。

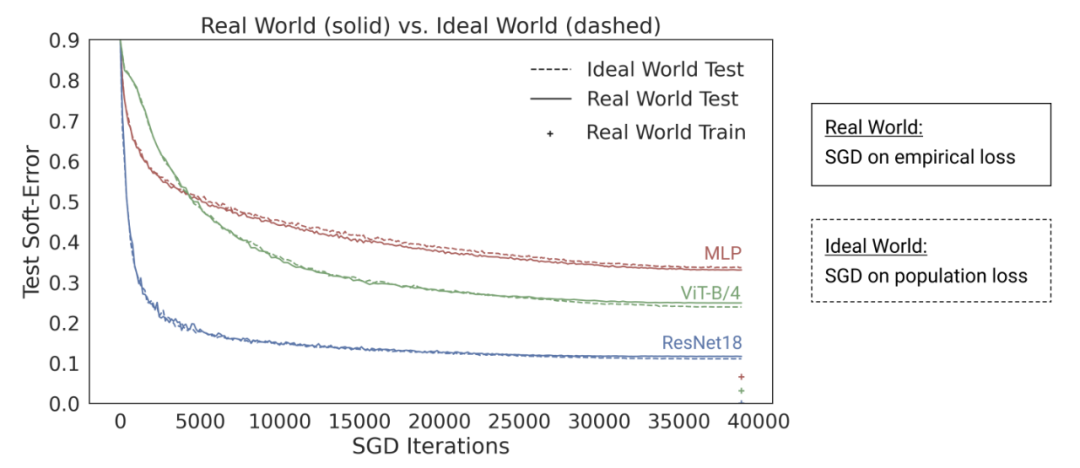

Nakkiran-Neyshabur-Sadghi“deep bootstrap”論文表明,現(xiàn)代架構(gòu)在 “過度參數(shù)化” 或“欠采樣”狀態(tài)下表現(xiàn)類似(模型在有限數(shù)據(jù)上訓(xùn)練多個(gè) epoch,直到過度擬合:上圖中的 “Real World”),在“欠參數(shù)化” 或者 “在線” 狀態(tài)下也是如此(模型訓(xùn)練單個(gè) epoch,每個(gè)樣本只看一次:上圖中的 “Ideal World”)。圖源:https://arxiv.org/abs/2010.08127

總結(jié)

統(tǒng)計(jì)學(xué)習(xí)當(dāng)然在深度學(xué)習(xí)中發(fā)揮著作用。然而,盡管使用了相似的術(shù)語和代碼,但將深度學(xué)習(xí)視為簡單地?cái)M合一個(gè)比經(jīng)典模型具有更多參數(shù)的模型,會忽略很多對其成功至關(guān)重要的東西。教學(xué)生數(shù)學(xué)的比喻也不是完美的。

與生物進(jìn)化一樣,盡管深度學(xué)習(xí)包含許多復(fù)用的規(guī)則(如經(jīng)驗(yàn)損失的梯度下降),但它會產(chǎn)生高度復(fù)雜的結(jié)果。似乎在不同的時(shí)間,網(wǎng)絡(luò)的不同組件會學(xué)習(xí)不同的東西,包括表示學(xué)習(xí)、預(yù)測擬合、隱式正則化和純噪聲等。研究人員仍在尋找合適的視角提出有關(guān)深度學(xué)習(xí)的問題,更不用說回答這些問題。