萬字解析自動駕駛中基于特征點的全局定位技術

在無人駕駛中,感知、定位、規劃決策、控制是四個基本的系統模塊。由于當前算法還無法實現絕對的智能,因此依然需要大量的先驗知識來提高模塊性能、魯棒性,以實現安全的自動駕駛。其中,高精地圖是對道路及周邊環境先驗知識的集成。而建立在地圖之上的準確定位,是判斷行車狀況的重要依據,為后續的感知、規劃決策提供有力支撐。

用于定位的主要數據源目前主要有 GPS、激光雷達、視覺、毫米波雷達。對于視覺而言,雖然目前還沒有一套產業內公認的足夠可靠的定位方案,但是在這方面探索從未停止過,主要原因如下:

安全性是無人駕駛系統最重要的指標,因此大部分功能的實現,都是多源數據、不同算法結果的耦合。沒有哪種傳感器方案是完美的,比如 GPS RTK 作為廣泛使用的方案,容易受衛星狀況、天氣狀況、 數據鏈傳輸狀況影響,在隧道內、室內和高樓密集區無法使用。再者,激光雷達雖然具有運算量小,提供深度信息,不受光照影響等優點,但信息稀疏,造價目前還十分昂貴,還不具備大批量車輛裝配能力。相比較而言,攝像頭提供的視覺信息,雖然會受到光照、天氣影響,但是成本低,內容豐富,是目前輔助駕駛方案主要數據源,在地圖定位方面也具有很大潛力。

由于主流基于視覺定位算法的核心思想一脈相承,所以本文僅從一系列重要算法框架組件角度,介紹了目前實踐中最常用的、基于特征點的全局定位算法,即在地圖坐標系下進行定位。本文省略了其中涉及到的優化、幾何約束公式推導,旨在給同學們一個定位算法的宏觀介紹,具體細節可以參考相關文獻和書籍。

基于特征點全局定位算法

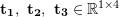

視覺全局定位,指的是根據當前圖像,求出相機在地圖坐標系中的 6 個自由度 (Degree of freedom, DoF) 位姿 (Pose) , 即 (x, y, z) 坐標,以及環繞三個坐標軸的角度偏轉 (yaw, pitch, roll) 。目前主要可以分類為基于 3D 結構的方法、基于 2D 圖像的方法、基于序列圖像的方法、基于深度學習的方法。其中,基于深度學習的方法屬于端到端 (End-to-end) 的方法,而其它多階段 (Multi-stage) 非端到端方法雖然流程有所差別,但算法思路大都如 Fig. 1 所示:

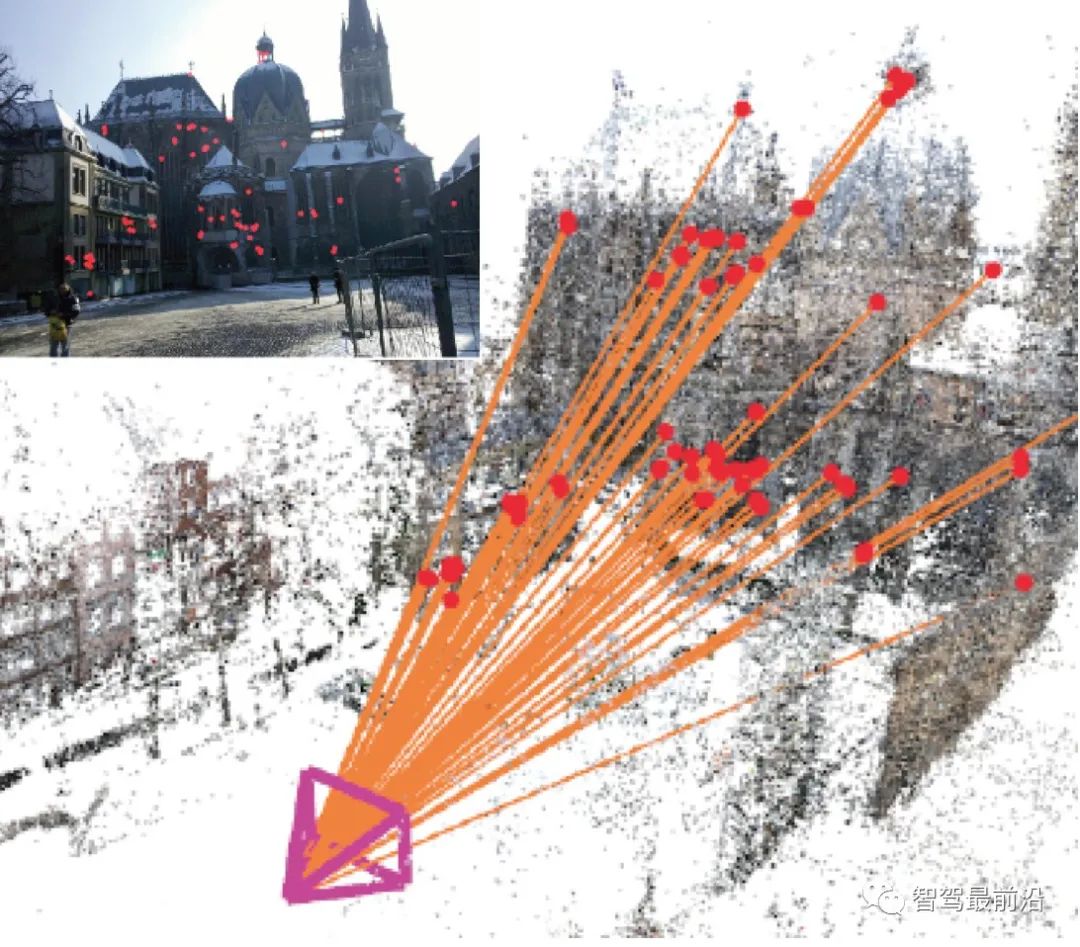

Figure 1: 根據查詢圖像,計算 2D-3D 轉換矩陣,求解相機位姿

基于已建的地圖,匹配歷史中最相似的地圖子集(圖像/點云/特征點),根據匹配到的地圖子集所提供的歷史位姿真值、特征點坐標真值,計算點對間的變換矩陣,求解當前相機位姿。

所以,其核心包含圖像描述、建圖查詢、特征匹配,位姿計算四個方面。這里僅僅是技術層面的宏觀分類,實際算法框架不一定按照此順序執行,而學者在研究中主要針對這些技術進行改進。整體而言,基于特征點的圖像描述基本成熟,發展較少。而位姿計算由于是基于幾何約束的優化問題,所以方法也較為固定。相對地,建圖查詢和特征匹配中改進技術較多。根據數據源不同,建圖查詢、匹配可以是2D-2D,2D-3D,3D-3D。2D 圖像由相機得到,3D 點云可以由提供深度的雙目相機、RGB-D 相機產生。

特征點提取

2D 圖像本身是一個由亮度、色彩組成的矩陣,對視角、光照、色調變化等很敏感,直接使用十分困難。所以,一般會使用具有代表性的點進行相關計算。人們希望這樣的點具有旋轉、平移、尺度、光照不變性等優點。這些點稱為圖像的特征 (Feature) 點,包含關鍵點(Key-points) 和描述子 (Descriptor) 兩部分。關鍵點表達了特征點的位置,而描述子則是對于特征點視覺特性的描述,大多為向量形式。一般而言,描述子主要是以某種模式,統計關鍵點周圍的灰度/色彩梯度變化。一種魯棒的描述子,在不同圖像 的不同情況下,同一特征點的描述子的距離 (Distance) 應當較小。

描述子一般是人為手工設計的 (Hand-crafted features) 。經典的描述如 HOG(Histogram of oriented gradients)[1],SIFT(Scale-invariant feature transform)[2],SURF(Speeded up robust features)[3],AKAZE(Accelerated KAZE)[4] 等。

為了實時性的要求,一些計算速度更快的二值模式描述子被設計出來,如 LBP(Local binary patterns)[5],BRIEF(Binary robust independent elementary features),ORB(Oriented FAST and rotated BRIEF)[6],BRISK(Binary robust invariant scalable key-point)[7],FREAK(Fast retina key-point)[8] 等。

在深度學習流行之前,這些手工特征一直引領著整個計算視覺產業,直到今天,這些特征在那些缺少標注數據、約束較多的場景下,依然被廣泛應用。下面簡單介紹兩類常用的描述子。

SIFT

SIFT 描述子可以算是 CV 界最具影響力的技術之一。從關鍵點檢測層面,主要使用高斯差分 (Difference of Gaussian, DoG) 方法檢測多尺度空間上的極值點,作為關鍵點。而 Babaud 等人 [9] 證明了高斯平滑是唯一的能用多尺度空間平滑濾波核,為相關方法提供了充足的理論支持。

那么為什么這樣的方法可以找到特征關鍵點呢?

由于高斯核可以通過模糊的方式把圖像縮放到不同尺度空間,而梯度變化較小的平滑區域在不同尺度空間的值差距較小。相反,邊緣、點、角、紋理等區域則差距較大。這樣通過對相鄰尺度的圖像做差分,最終可以算得多尺度空間的極值點。但是,不同的圖像細節本身就處于不同的尺度中。比如一副人物畫像中,人臉可能經過較小的模糊就會被平滑為一片,而畫框的角則可能需要更大尺度的平滑才會體現出局部“極值”。

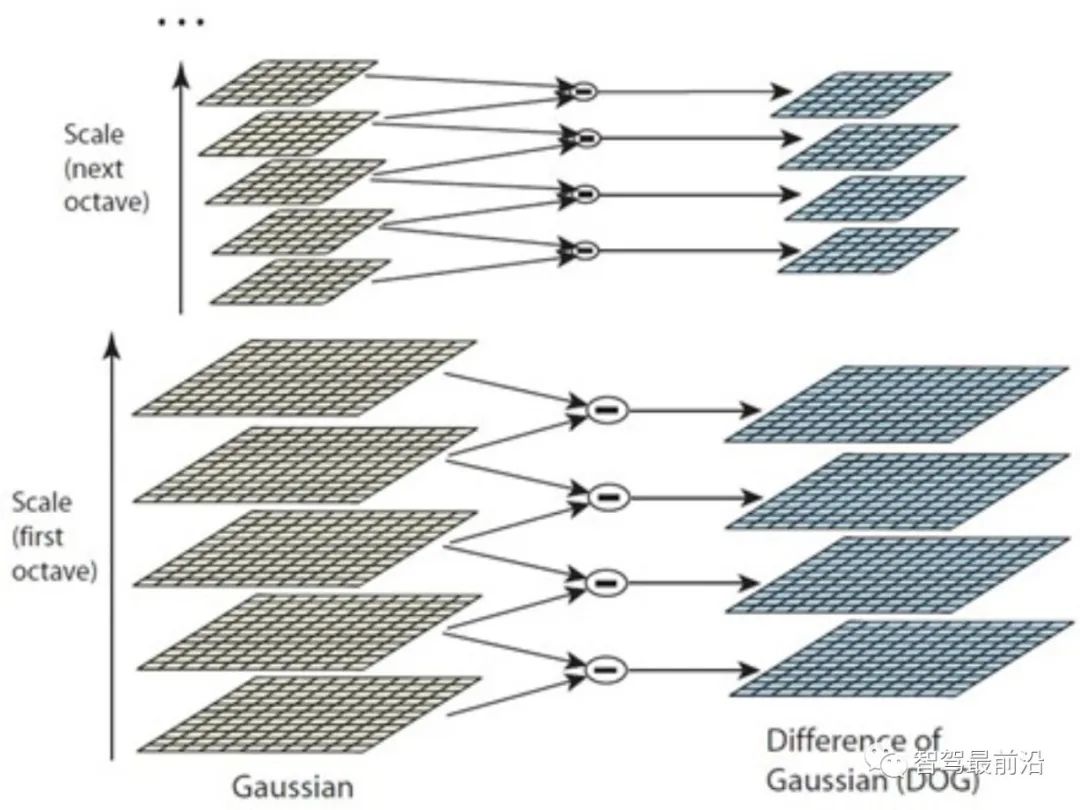

因此,如 Fig. 2 所示,首先利用圖像金字塔將圖像先分組 (Octave) ,每組中再使用不同尺度的高斯核,形成一系列的層。這種方式比單純地使用更多尺度的高斯核效果更好,可以檢測到更多的特征點。需要注意的是,雖然 SIFT 使用了 DoG 進行關鍵點檢測,但是其它檢測方法也是可行的,并不影響 SIFT 描述子的建立。

Figure 2: 高斯差分方法

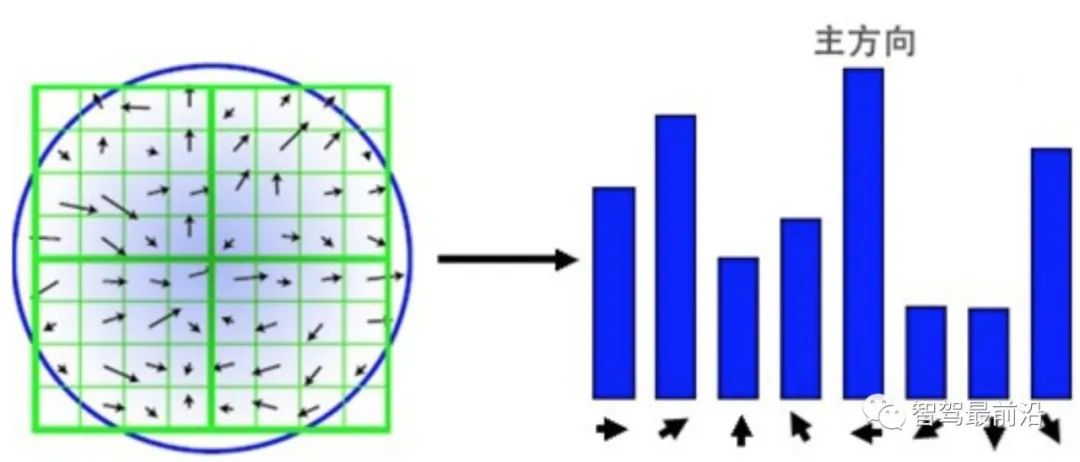

SIFT 特征點的描述子,可以理解為一種簡單統計版的 HOG。如 Fig. 3所示,以檢測到的關鍵點為中心,選取周圍 16 × 16 的區域,將區域再組織為 4 個 4 × 4 的塊(Patch)。對每一個塊,使用 8-bins 的直方圖對梯度進行統計,梯度方向決定落入哪個 bin,而梯度的模決定值的大小。為了保證尺度一致性,梯度大小需要進行歸一化。為了保證旋轉不變性,會根據 16 × 16 的區域內的所有梯度計算出一個主方向, 所有梯度按照主方向進行旋轉。最終形成 4 × 4 × 8 的 128 維向量。

Figure 3: 基于梯度分塊統計的 SIFT 描述子

二值描述子

雖然在 SIFT 提出后,又產生了一些改進算法如 SURF、AKAZE 等,但是即使放在 2019 年的今天, 依然難以保證一些場景對算法實時性的要求。例如,手持設備一般算力有限。而無人駕駛中,CPU、GPU資源需要被多個計算密集型模塊同時調度。因此,效率是考察算法實用性的重要指標。

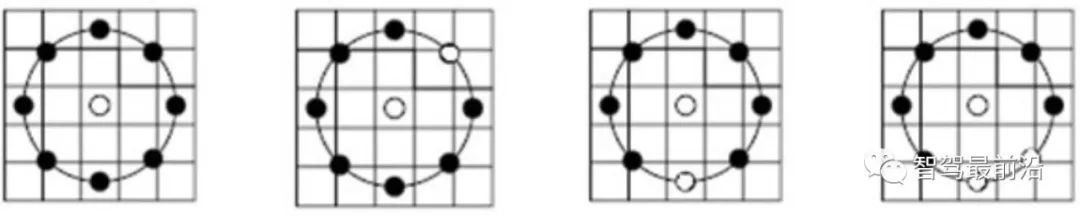

為了提高效率,一些二值描述子被學者們提出。一般地,這些方法都是在特征關鍵點周圍進行點采樣。然后比較一對點的灰度大小,結果以 0/1 表示,形成 N 維的二進制描述向量,構成特征點的二值模式。而不同二值描述子最大的差別,主要在于特征采樣模式不同、點對選取方法不同。

Figure 4: LBP 描述子采樣模式

如 Fig. 4所示,LBP 描述子采用對關鍵點周圍,進行環形采樣,并與中心關鍵點的灰度進行比較的方案。圓環上展示了灰度比較結果,黑色的點是 0,白色的點是 1。LBP 是二值描述子最簡單的形式,而 ORB 改進了 BRIEF 特征,是目前比較常用的二值描述子。如 Fig. 5所示,在點對選取上,與單純使用中心點不同,ORB 采用了隨機的方式,更全面地描述局部細節。但點對的相關性會比較大,從而降低描述子的判別性(Discriminative)。ORB 直接采用了貪婪法、窮舉法解決這一問題,尋找相關性低的隨機點對。

Figure 5: ORB 描述子點對選取模式

以上二值描述子的采樣方式和點對選取方式符合人們一般直覺,而 BRISK、FREAK 等描述子則提供了更加規則化、自帶尺度信息的二值模式構建方法。例如,FREAK 描述子模仿了人眼的視覺采樣模式。如 Fig. 6所示,每個采樣點的值是紅色圓圈范圍內的灰度均值,藍線則表示點對選取方案。

Figure 6: FREAK 描述子采樣、點對選取摸式

二值描述子的高效率,主要體現在三個方面。

(1)二值描述子使用二進制向量作為特征描述,只需要 比較點對大小而不需要計算具體梯度。

(2)兩個描述子之間比較可以使用計算更快,更容易優化的漢明距離 (Hamming distance)。

(3)由于每個二進制向量都對應一個十進制數,所以其本身也代了表一種模 式,而不需要像 SIFT 一樣使用直方圖進行表示。

二值描述子一般判別性不如 SIFT 家族描述子,但在特定場景下,配合并行化編程,可以在保證相似判別能力的同時,效率高出幾十甚至百倍。

數據庫建立與查詢

數據庫可以理解為于地圖 + 索引的集成。地圖可以是由單純的 2D 圖像組成,也可以是由 3D 點云地圖組成,也可以是 2D 圖像和 3D 點云的結合。3D 點云地圖生成主要使用三維重建的方法 SfM(Structure from motion),從時間序列的 2D 圖像中推算 3D 信息。如果有雙目、RGB-D 相機提供深度,可以獲得 更準確的 3D 點信息。其中也包含了一些諸如關鍵幀(Key-frame)的選取策略,具體方法超出了本文的討論范圍,有興趣的同學可以自行查閱相關資料。數據庫的作用在于:

對于一張輸入的觀測圖像,通過數據庫,查詢建圖歷史(圖像/點云/特征點),得到當前圖像最可能觀測到的地圖子集(圖像/點云/特征點),將地圖與觀測信息進行匹配,計算變換矩陣,得到觀測相機的位姿。

索引則是加速這一過程的關鍵。數據庫本身往往是巨大的。以美團的小袋機器人在北京朝陽大悅城二層試運營為例,安裝有 3 個深度相機,即使經過篩選,也使用了將近 8 萬張 900 × 600 的圖片。考慮到定位所需要的實時性,查詢時不可能每次都和 8 萬張圖片一一對比,所以要使用索引技術加速整個算法。這方面技術與 SLAM 中的回環測試,視覺中的圖像檢索、位置識別等高度重合,以下僅介紹一般方法。

一張圖像內有若干特征點,需要先對特征點進行編碼,如 VLAD(Vector of locally aggregated descriptors) 編碼,用局部描述子形成圖像的全局描述。再使用索引,如 kd-tree,進行圖像級查詢。當然,編碼和索引也可以同時進行,如層次化詞袋模型(Bag-of-words,BoW)+ 正向索引 + 逆向索引的方法。

VLAD 編碼

VLAD(Vector of locally aggregated descriptors)[10],如 Fig. 7所示,是一種通過聚合局部描述子形成碼本 (Codebook) ,通過累加計算描述子與碼詞 (Word) 的距離,進行全局編碼的簡單方法。一個  維描述子

維描述子  通過

通過  個碼詞的碼本進行編碼,可以形成一個

個碼詞的碼本進行編碼,可以形成一個  維的描述向量,向量中的值是描述子與第

維的描述向量,向量中的值是描述子與第  個碼詞在第

個碼詞在第  維的差。之后進行

維的差。之后進行  歸一化,形成最后的 VLAD 向量。

歸一化,形成最后的 VLAD 向量。

Figure 7: VLAD 通過描述子與碼詞的距離進行編碼

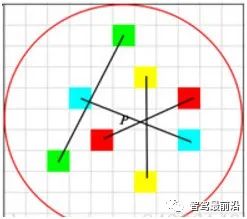

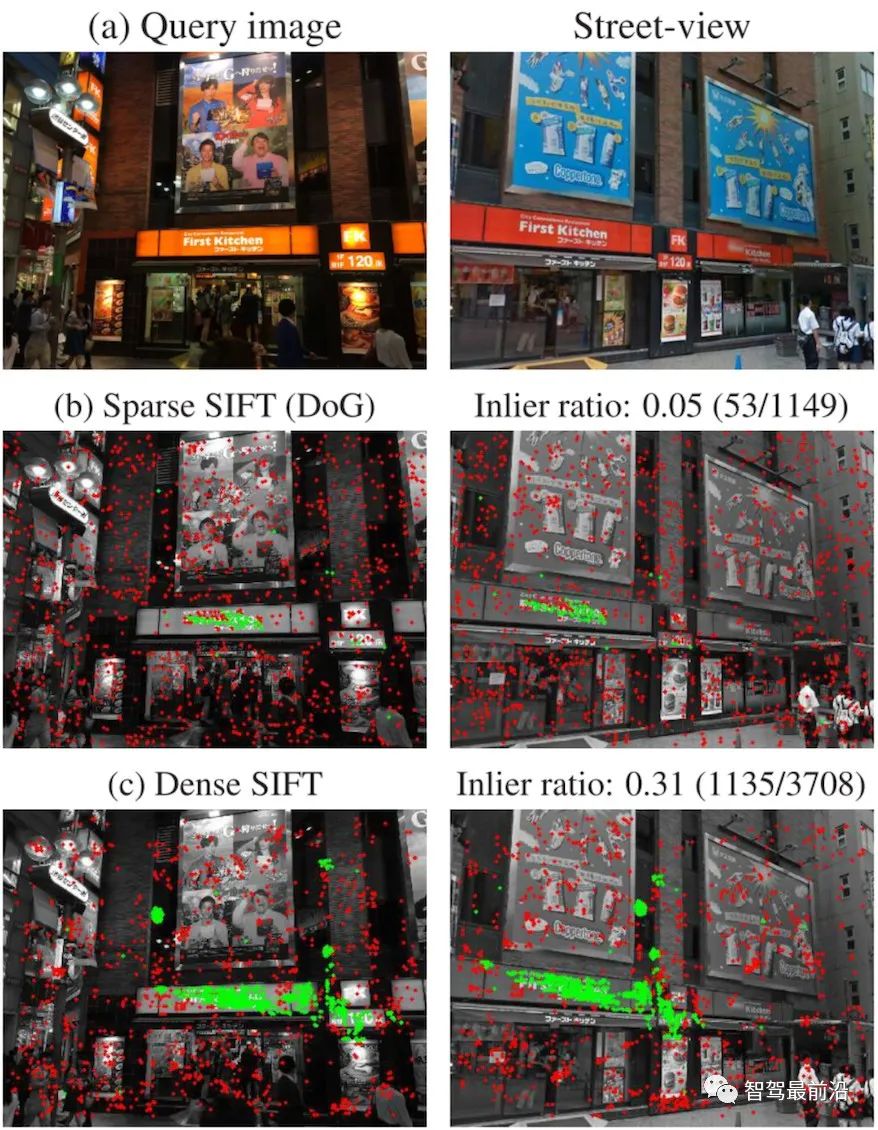

這里要特別提介紹一下 DenseVLAD[11] 和 NetVLAD[12] 。Torii 等人證明,DenseSIFT 在查詢、匹配上都優于標準 SIFT。DenseVLAD 在四個尺度,以 2 個像素間隔的網格狀采樣模式,提取 SIFT 點。在全局隨機采樣 25M 個描述子,用 k-means 算法生成 128 個碼詞的碼本。VLAD 向量在歸一化后使用 PCA(Principal component analysis) 降維,形成最后 4096 維的 DenseVLAD 向量。如 Fig. 8所示,使用DenseSIFT 匹配后的內點(綠)數量更多。

Figure 8: DenseSIFT 和標準 SIFT 特征點,匹配后內點(綠)對比

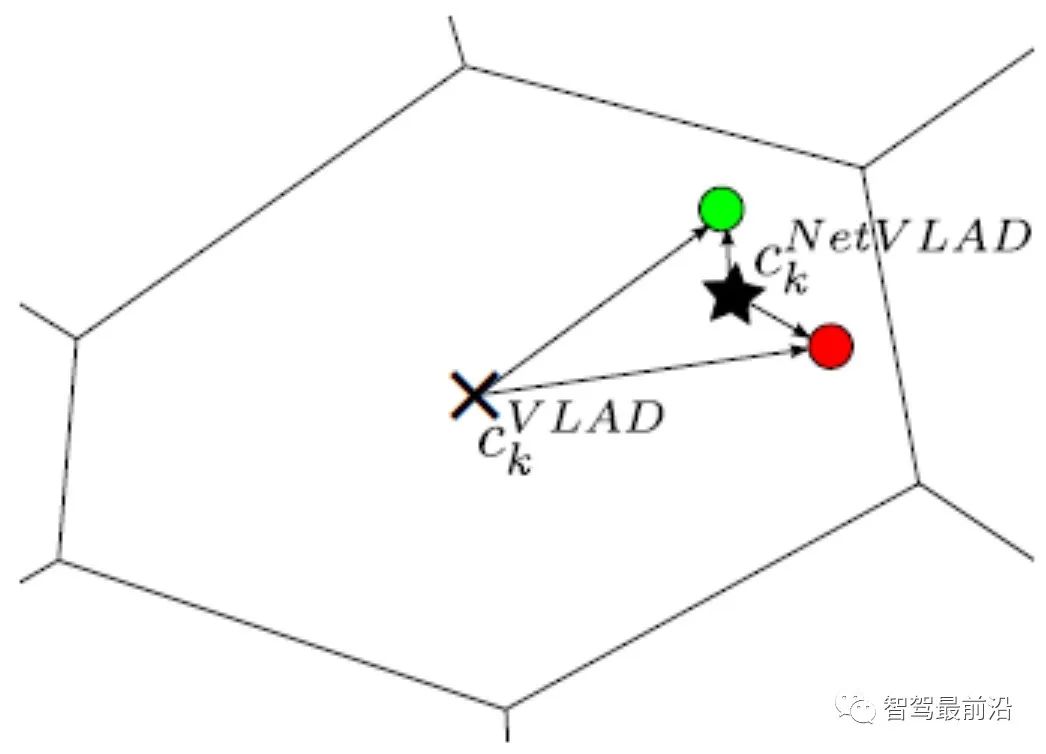

而 NetVLAD,將 VLAD 中加入了監督信息,加強 VLAD 編碼的判別性。如 Fig. 9所示,假設紅、綠兩個描述子來源于不應匹配到一起的兩張圖片。由于它們都離 VLAD 中心(×)半徑較大且距離相似,經過 L2 歸一化,它們編碼后值也會很相似。而加入了紅、綠描述子所對應圖片不匹配的監督信息后,NetVLAD 生成的中心點(★)則可以更好地區分兩個描述子,增加他們編碼后的距離(半徑)差。

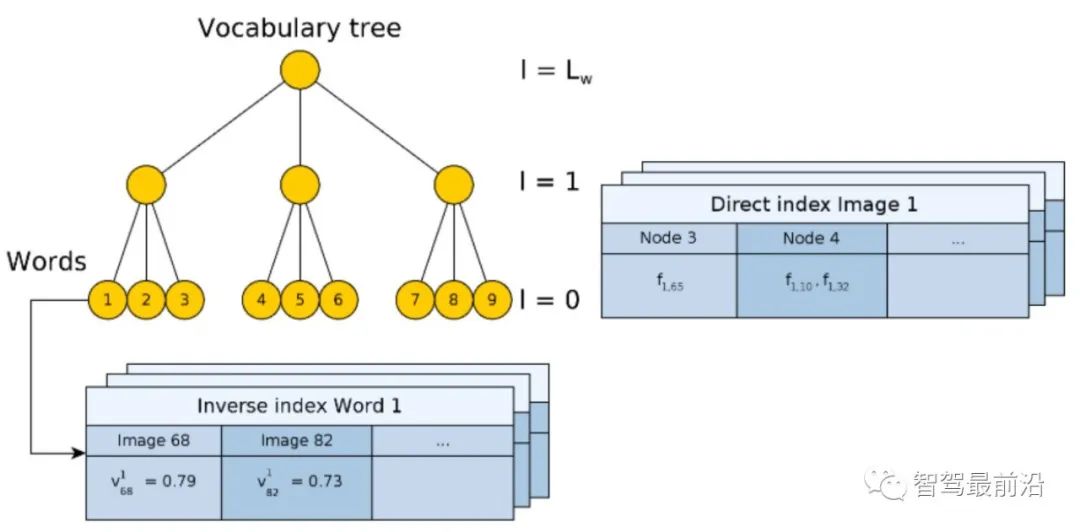

Figure 9: NetVLAD 聚類中心(×)與 VLAD 聚類中心(★)對比BoW 編碼 + 索引基于詞袋模型 BoW[13, 14] 的特征編碼及其設計思想在計算機視覺發展中具有舉足輕重的地位,這里不再展開介紹。本文以 2D 查詢圖像匹配 2D 圖像數據庫為例,介紹一種常見的 BoW 編碼、索引一體化的模型。如 Fig. 10所示,詞典 (Vocabulary) 生成采用層次化方法,對于數據集中的所有描述子,按樹狀結構進行空間劃分,每一層都是由 k-means 聚類計算。最終葉子節點就相當于碼詞(Fig. 10中有 9個碼詞)。

Figure 10: 帶正向索引、逆向索引的層次化 BoW 模型

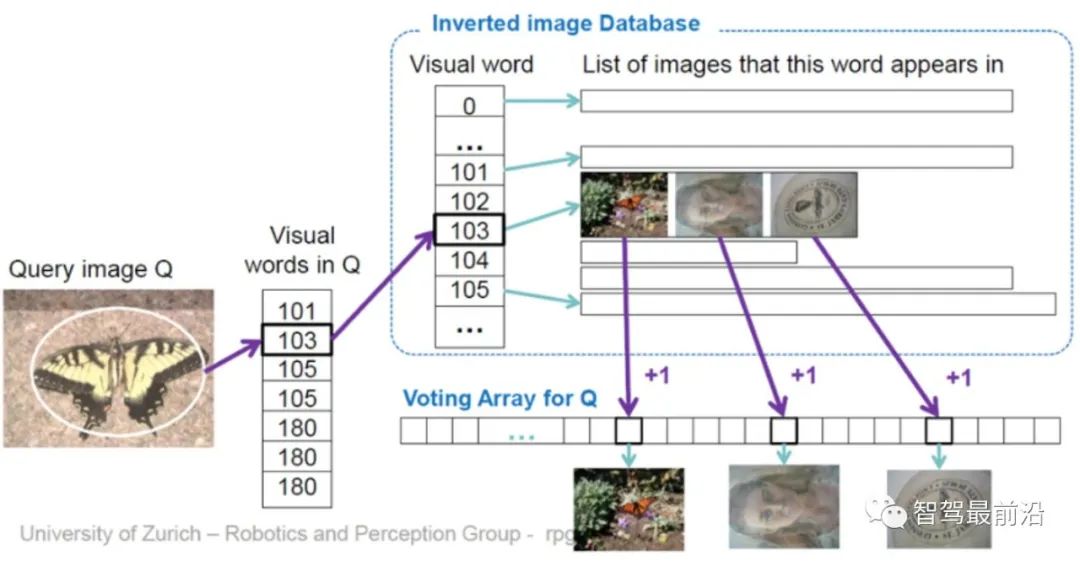

樹的構造過程,實際上就是將原始圖像編碼的過程。但是編碼本身并不能加快搜索過程,與 VLAD 相似,還是需要與數據庫中的圖像逐一比較。因此,這里設計了一種逆向索引(Inverse index) ,不需要比較編碼后的向量。其原理如 Fig. 11所示,對于一張查詢圖像 (Query image) ,將提取的描述子輸入到 BoW 中,最終會落入碼詞葉子結點 (Visual word) k 中。而每個碼詞對應一個索引,記錄碼詞  對于數據庫中第

對于數據庫中第  張圖的權重

張圖的權重  (Fig.10)。這里權重使用 TF-IDF(Term frequency–inverse document frequency) 計算。即如果一個詞

(Fig.10)。這里權重使用 TF-IDF(Term frequency–inverse document frequency) 計算。即如果一個詞  在某個圖像

在某個圖像  中出現頻率高,在其它圖像出現頻率低,則這個詞對于圖像判別性較好,權重值

中出現頻率高,在其它圖像出現頻率低,則這個詞對于圖像判別性較好,權重值  較高。最終通過投票 (Voting) 機制,選出匹配圖像。同樣需要注意的是,逆向索引不一定建立在樹形結構的 BoW 上,它僅僅是提供一種快速查詢的方法。

較高。最終通過投票 (Voting) 機制,選出匹配圖像。同樣需要注意的是,逆向索引不一定建立在樹形結構的 BoW 上,它僅僅是提供一種快速查詢的方法。

Figure 11: 通過逆向索引 + 投票機制,直接查詢圖像

而正向索引 (Direct Index) 的作用主要是記錄構造 BoW 時,數據庫圖片的特征點都落入了哪些結點中,這樣當查詢到圖像后,不需要計算特征點,可以直接通過索引提取特征點。

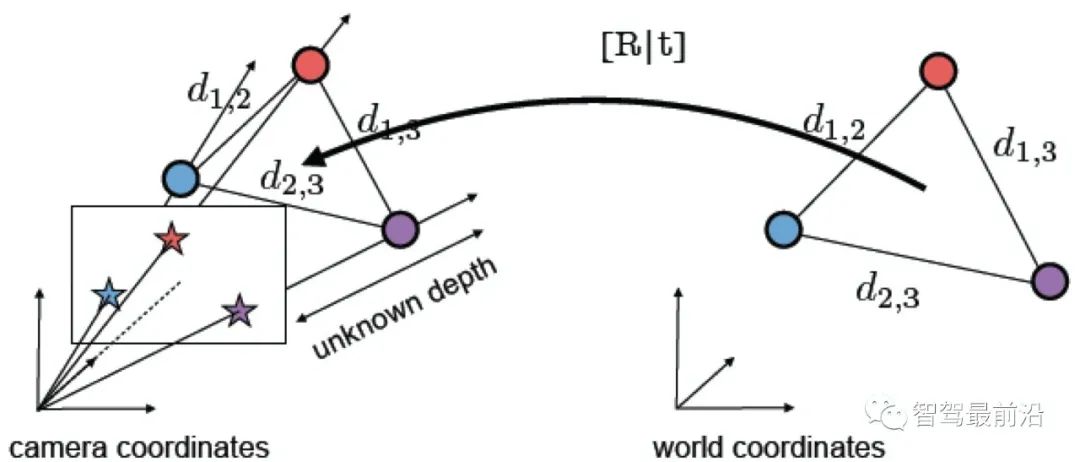

3D 點云查詢

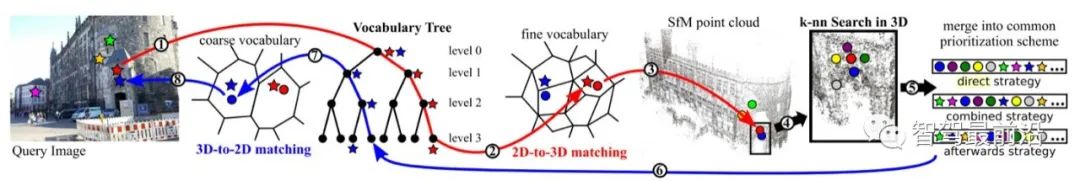

2D 圖像查詢中,是先從語意層面查詢圖像,因此可以通過圖像對特征點的空間范圍進行約束。3D 點云查詢沒有這樣的約束,所以具諸多難點。如需要考慮空間連續性,查詢到的點是否都在可觀測范圍內等。這里僅介紹 Sattler 在 TPAMI 2016 上發表的方法 [15],經過多年的打磨,這套方法框架相對簡潔、完善。由于其中的詞典編碼搜索步驟與上節內容有所重疊,這里僅介紹 Active Search 和 Visbility Filtering 兩種機制。

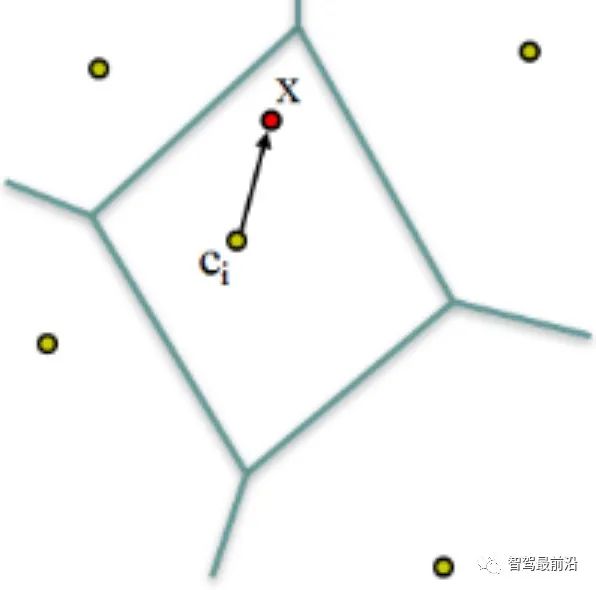

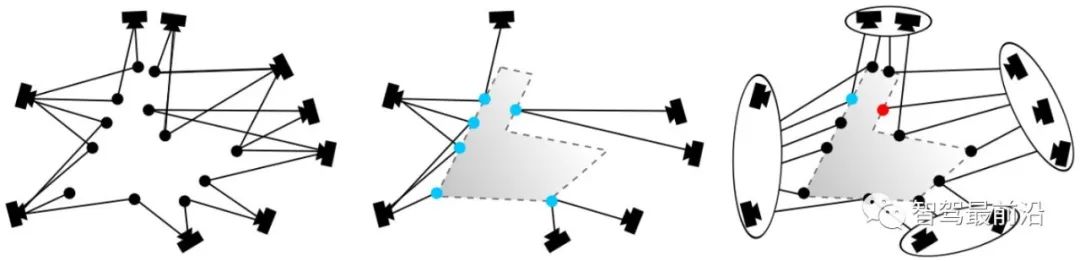

Active Search 主要是為了使得匹配到的 3D 點盡可能空間中臨近、有幾何意義。如 Fig. 12所示,紅 色的點通過一系列編碼、精化過程(紅線),匹配到了點云中一個點。根據所提出優先排序(Prioritization) 框架,從點云中找到一個概率最大的 3D 點,并反向(藍線)匹配查詢圖像中的一個對應的 2D 點。

Figure 12: Active Search

Figure 13: Visbility Filtering Visbility Filtering

主要是為了讓匹配到的點盡可能可以被相機觀測到(定位是無監督的,并不能知道所匹配到的點是否正確)。這里采用的方法是在使用 SfM 建立 3D 點云地圖時,同時建立一個雙向可見圖 (Bipartite visibility graph) 。如 Fig. 13(左)所示,當一個點可以同時被兩個相機觀測時,則建立拓撲關系。Fig. 13(中)里,藍色的點為匹配到的點,它們從觀測視角上存在沖突。通過在已有拓撲上進 行圖聚類,將相機兩兩分組,如 Fig. 13(右)。這樣就可以生成新的圖拓撲關系。之后通過判斷每個子圖(Sub-graph)間的重合情況,過濾掉那些那大概率不可見的點。

需要說明的是,雖然雙目相機和 RGB-D 相機可以獲取深度,查詢 2D 圖像也可以獲得限定范圍內的 3D 特征點坐標,但是由于目前技術限制,在室內材質復雜,室外大尺度場景下,深度并不可靠。所以 2D圖像點和 3D 點云地圖的匹配依然是一種重要的方法。

特征點匹配

特征點匹配過程可以是在數據庫查詢中自適應完成的,這多見于基于 3D 結構的查詢。匹配也可以是在查詢后單獨進行,多見于基于 2D 圖像查詢。特征匹配的目的是,為后續的變換矩陣計算提供匹配的點對集,實現位姿的解算。

經典 RANSAC

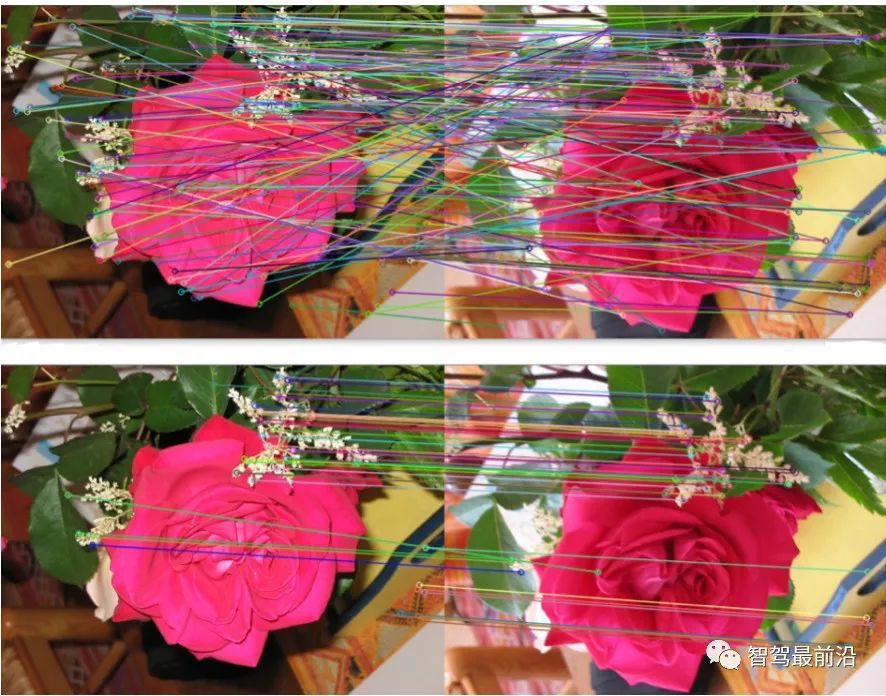

隨機抽樣一致算法 (Random sample consensus,RANSAC)[16] 是一種經典的數據過濾、參數擬合算法。它假設數據(內點,Inliers)分布符合一定的數學模型,通過迭代計算,去除外點 (Outliers) 、噪聲點, 同時獲取概率上最佳的模型參數。在全局定位中,內點指正確的匹配,外點指錯誤的匹配,參數模型指匹配點對的空間變換矩陣。如 Fig. 14所示,經過 RANSAC 算法優化后,匹配更加合理。RANSAC 所期望找到的匹配子集需要滿足兩個指標:內點重投影誤差盡可能小;內點數量盡可能多。所以基本流程如下:

①采樣初始子集。

②計算變換矩陣。

③ 根據變換矩陣計算匹配點的重投影誤差。

④ 去除誤差較大的點

⑤ 循環①-④,保留最滿足指標的匹配方案。

Figure 14: (上)原始特征匹配;(下)經過 RANSAC 算法優化后的匹配

其中,初始候選匹配是根據描述子之間的距離產生的,但重投影誤差則只和關鍵點的空間位置有關, 與描述子本身無關。具體投影矩陣方法請參考“2.4 位姿計算”。需要指出的是,RANSAC 算法受到原始匹 配誤差和參數選擇的影響,只能保證算法有足夠高的概率合理,不一定得到最優的結果。算法參數主要包括閾值和迭代次數。RANSAC 得到可信模型的概率與迭代次數成正比,所得到的匹配數量和閾值成反比。因此實際使用時,可能需要反復嘗試不同的參數設置才能得到較優的結果。

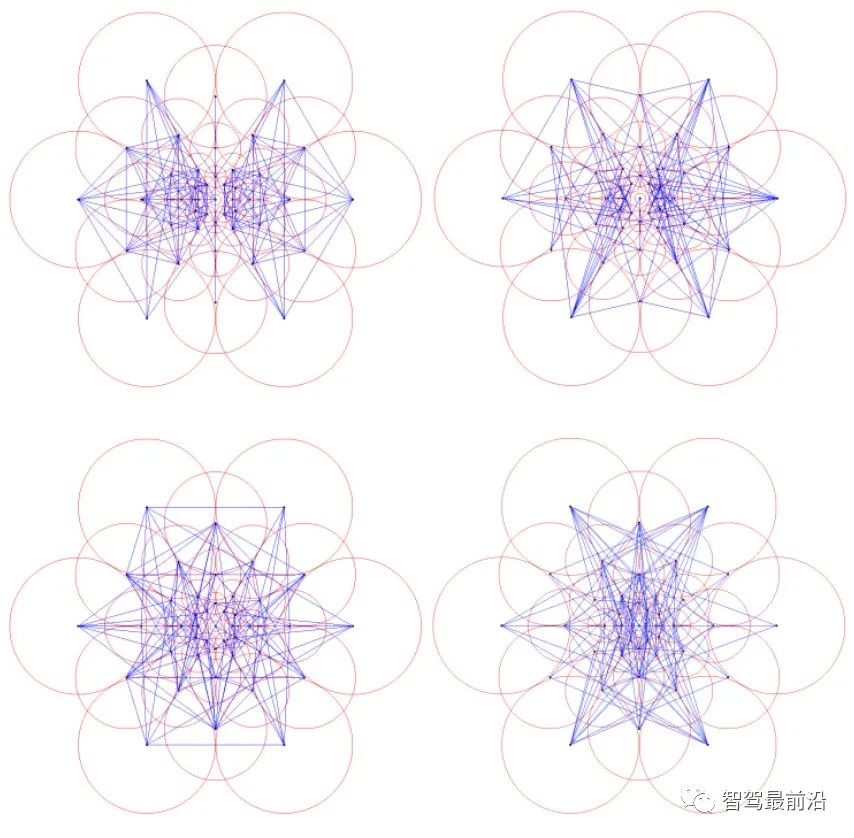

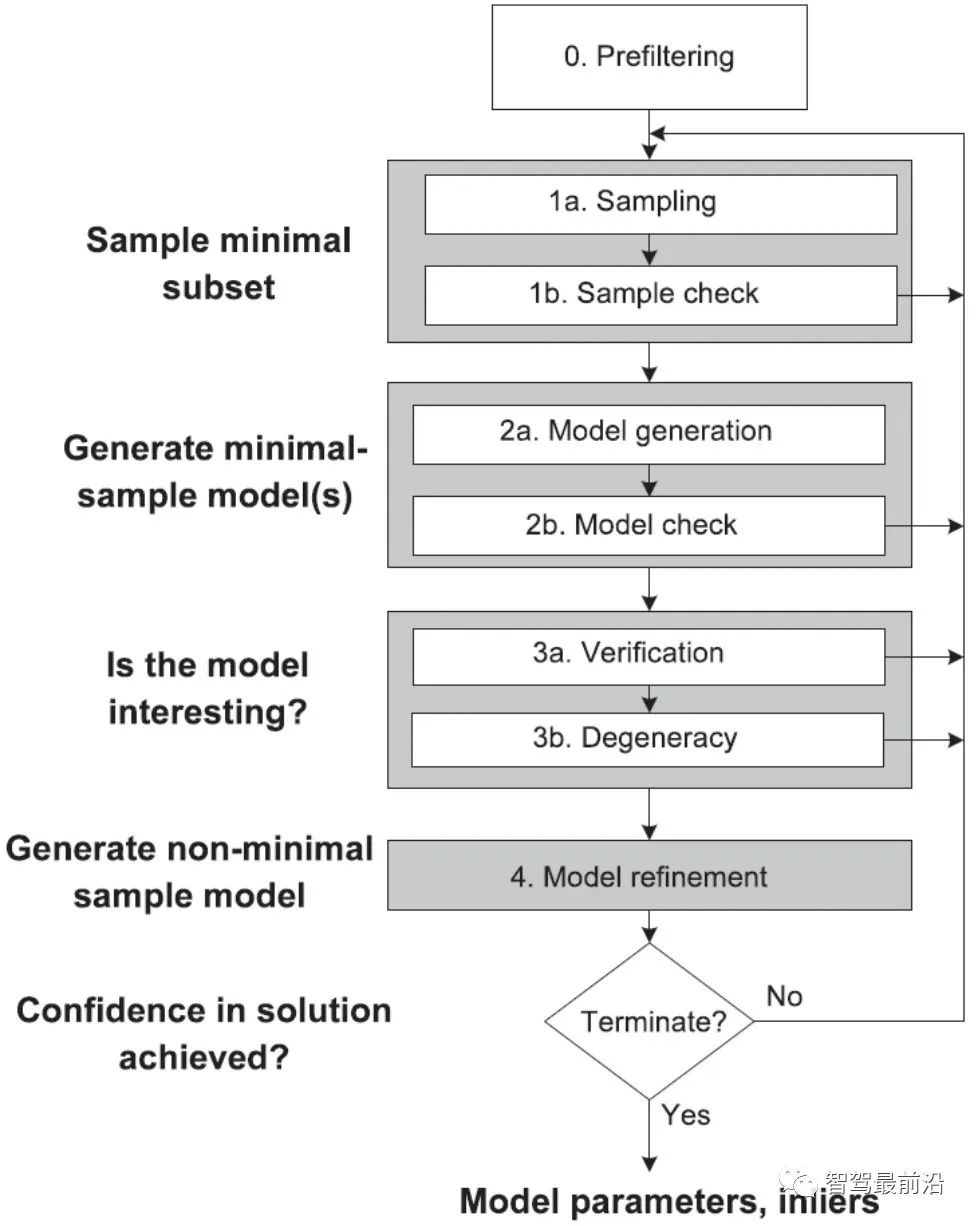

學者們對經典 RANSAC 算法進行了很多改進,如 Fig. 15所示,提出了全局 RANSAC(Universal- RANSAC)[17] 的結構圖,形成了具有普適性的 RANSAC 架構,涵蓋了幾乎所有的 RANSAC 的改進方 面,如預濾波、最小子集采樣、由最小子集生成可靠模型、參數校驗、模型精化。

Figure 15: Universal-RANSAC 通用算法框架

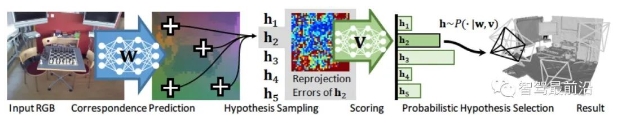

可微分 RANSAC

由于手工描述子在定位領域依然表現出較高的性能,所以一些學者開始探索使用深度學習代替算法框架中的某些部分,而不是直接使用端到端的位姿估計模型完全代替傳統方法。可微分 RANSAC(Differentiable RANSAC,DSAC)[18] 旨在用概率假說選擇代替確定性假說選擇,使得 RANSAC 過程可以被求導,流程如 Fig. 16所示,其中“Scoring”步驟依然采用重投影誤差作為指標,所不同的是,誤差是基于整張圖像而不是特征點,而原先篩選特征點匹配的過程被換為了直接以概率篩選相機位姿假設 h 的過程。雖然目 前方法局限性比較大,但 DSAC 為如何在當前無監督為主的定位算法框架中加入先驗知識,提供了一種可行的思路。

Figure 16: 差分 RANSAC 算法框架

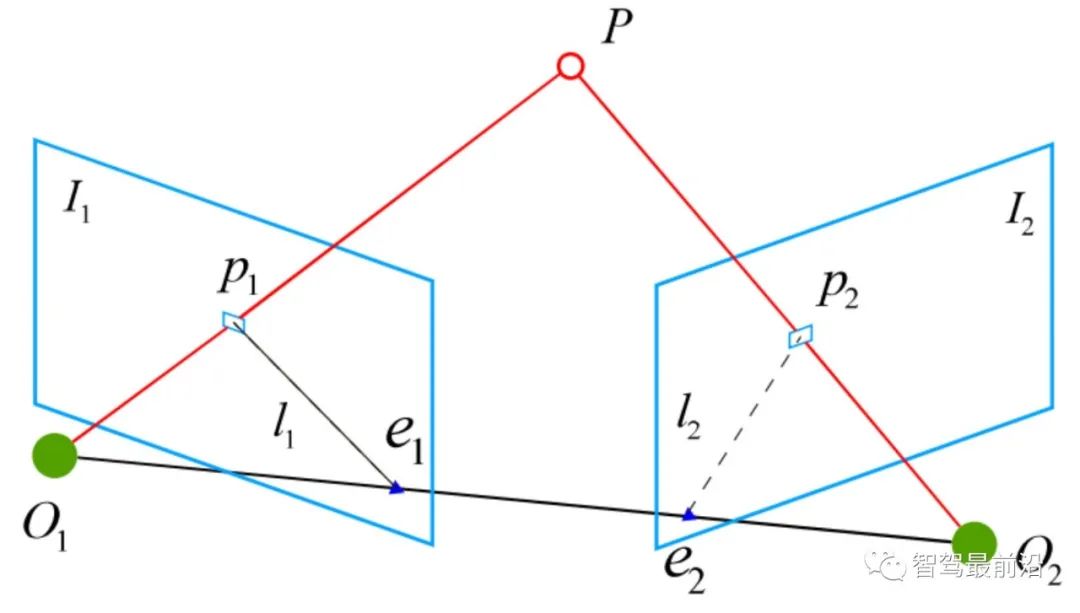

位姿計算

對于已獲得的正確匹配點對,需要通過幾何約束計算相應的變換矩陣 (Transformation matrix) 。由于數據庫中的點坐標,采樣時的相機位姿已知,所以可以通過匹配點對于地圖點的變換矩陣,得到當前相機的位姿。此處定義一些基本符號。相機內參為  ,變換矩

,變換矩  的齊次形式為:

的齊次形式為:

其中, 為旋轉矩陣,

為旋轉矩陣,  為平移矩陣。

為平移矩陣。

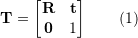

2.4.1 2D-2D 變換矩陣計算

Figure 17: 2D-2D 變換矩陣計算中的對極幾何

對于兩張二維圖像中的已匹配好的特征點對 ( ) ,它們在歸一化平面上的坐標為 (

) ,它們在歸一化平面上的坐標為 ( ),需要通過對極約束計算出相應的變換矩陣。如 Fig. 17所示,其幾何意義是

),需要通過對極約束計算出相應的變換矩陣。如 Fig. 17所示,其幾何意義是  三者共面,這個面也被稱為極平面,

三者共面,這個面也被稱為極平面, 稱為基線,

稱為基線, 稱為極線。對極約束中同時包含了平移和旋轉,定義為:

稱為極線。對極約束中同時包含了平移和旋轉,定義為:

其中, 是

是  在歸一化平面上的坐標,∧ 是外積運算符。將公式中間部分計為基礎矩陣

在歸一化平面上的坐標,∧ 是外積運算符。將公式中間部分計為基礎矩陣  和本質矩陣

和本質矩陣  ,則有:

,則有:

由于本質矩陣  不具有尺度信息,所以 E 乘以任意非零常數后對極約束依然成立。

不具有尺度信息,所以 E 乘以任意非零常數后對極約束依然成立。 可以通過經典的 8 點法求解(Eight-point-algorithm),然后分解得到

可以通過經典的 8 點法求解(Eight-point-algorithm),然后分解得到  ,

,  。因此可以看出 2D-2D 的變換矩陣求解方式有兩個缺點,首先單目視覺具有尺度不確定性,尺度信息需要在初始化中由

。因此可以看出 2D-2D 的變換矩陣求解方式有兩個缺點,首先單目視覺具有尺度不確定性,尺度信息需要在初始化中由  提供。相應地,單目初始化不能只有純旋轉,必須要有足夠程度的平移,否則會導致

提供。相應地,單目初始化不能只有純旋轉,必須要有足夠程度的平移,否則會導致  為零。

為零。

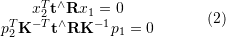

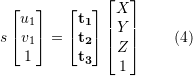

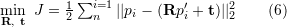

2.4.2 2D-3D 變換矩陣計算

2D-3D 匹配是位姿估計中重要的一種方法。一般使用 PnP 法,即已知  對 2D-3D 匹配點,求解變換矩陣,以獲得相機位姿。我們將 3D 點 P(X, Y, Z) 投影到相機成像平面 (

對 2D-3D 匹配點,求解變換矩陣,以獲得相機位姿。我們將 3D 點 P(X, Y, Z) 投影到相機成像平面 ( ) 上:

) 上:

其中, 為尺度,

為尺度, 。這個等式的求解可以化為一個線性方程問題,每個特征可以提供兩個線性約束:

。這個等式的求解可以化為一個線性方程問題,每個特征可以提供兩個線性約束:

這樣,最少可以通過 6 對匹配點進行求解,而匹配數大于 6 時可以使用 SVD 等方法通過構造最小二乘 求解。P3P 法可以看作是 PnP 法的特殊解法,如 Fig. 18所示,利用三角形相似性質增加更多約束,只需要 3 對點就可以求解。其它解法還有直接線性變換法 (Direct linear transformation,DLT),EPnP(Efficient PnP) 法,和 UPnP(Uncalibrated PnP)等。相對于以上線性優化方法,非線性優化方法如Bundle Adjustment(BA) 也有著廣泛的應用。BA 方法在視覺 SLAM 中是一種“萬金油”的存在,可以同時優化多個變量,這樣可以一定程度緩解局部誤差帶來的系統不魯棒,感興趣的同學可以翻閱相關資料更深入地進行了解。

Figure 18: 2D-3D 變換矩陣計算中的 P3P 方法

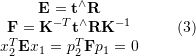

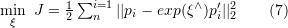

3D-3D 變換矩陣計算

3D 點之間的變換矩陣可以用迭代最近點(Iterative closet point, ICP)算法求解。假設點對匹配 ( ) 結果正確,則求得的轉換矩陣應當盡量減少重投影誤差

) 結果正確,則求得的轉換矩陣應當盡量減少重投影誤差  。可以使用 SVD 求解最小二乘問題:

。可以使用 SVD 求解最小二乘問題:

或者使用建立在李代數上的非線性優化方法 Bundle Adjustment 求解

其中, 表示相機位姿。這里的優化目標與 2D-3D 匹配中的 Bundle Adjustment 的類似,但是不需要考慮相機內參

表示相機位姿。這里的優化目標與 2D-3D 匹配中的 Bundle Adjustment 的類似,但是不需要考慮相機內參  ,因為通過雙目相機或者 RGB-D 深度相機,已經把原本圖像上的 2D 點從相機成像平面投影到 3D 世界中。

,因為通過雙目相機或者 RGB-D 深度相機,已經把原本圖像上的 2D 點從相機成像平面投影到 3D 世界中。

ICP 問題已經被證明存在唯一解和無窮多解的情況。因此,在存在唯一解的情況下,優化函數相當于是一個凸函數,極小值即是全局最優解,無論采取何種初始化,都可以求得這一唯解。這是 ICP 方法的一大優點。

本文從圖像描述、建圖查詢、特征匹配,位姿計算四個方面介紹了基于特征點的位姿估計算法。雖然傳統視覺全局定位方法目前依然是實際應用中的首選,但是,傳統方法是建立在特征點被正確定義、正確提取、正確匹配、正確觀測的前提下進行的,這一前提對于視覺本身而言就是巨大的挑戰。其次,由于傳統方法是 multi-stage 框架,而非 end-to-end,所以中間每個環節,環節之間的交互,都需要眾多參數調整,每個環節的技術都可以作為一個單獨的研究方向。實際應用時,也需要加入對應具體場景的大量tricks,工程上比較復雜。

而人們對 end-to-end 方法的期望催生出了如 PoseNet,VLocNet,HourglassNet 等網絡,在 benchmark上取得了不錯的成績。筆者認為目前 end-to-end 的方法還存在很多問題,主要有 loss function 缺少幾何 約束,建圖時位姿的 6 自由度空間并不連續,與輸入空間難以形成良好映射,而且缺少相應的位姿回歸、 精化機制等。不能否認,作為非線性空間最有力的建模工具,深度學習在未來會更多地出現在定位領域中。

回歸到視覺定位本身,由于視覺最重要的優勢就是成本低、語意豐富、使用場景限制少。因此,以視覺為主,其它低成本傳感器為輔的定位融合方案在未來也將會是一個重要的課題。