70年AI發展迎來大一統?馬毅、曹穎、沈向洋最新AI綜述:探索智能發生的基本原則與「標準模型」

?人工智能發展七十年,雖然技術指標上不斷刷新,但到底什么是「智能」,它如何出現及發展的,還沒有答案。

最近馬毅教授聯手計算機科學家沈向洋博士、神經科學家曹穎教授發表了一篇對智能出現及發展的研究綜述,希望將智能體的研究在理論上統一起來,增進對人工智能模型的理解與可解釋性。

論文鏈接:http://arxiv.org/abs/2207.04630

文中引入了兩個基本原則:簡約(Parsimony)與自洽( Self-consistency)。

作者認為這是智力、人工或自然的興起的基石。盡管在經典文獻里,對這兩個原則各自的相關論述、闡述眾多,但本文對這兩個原則以完全可度量和可計算的方式重新進行解讀。

基于這兩個第一性的原則,作者推演出了一個高效的計算框架:壓縮閉環轉錄,該框架統一并解釋了現代深度網絡和許多人工智能實踐的演變。

兩大基本原則:簡約與自洽

在深度學習加持下,過去十年人工智能取得的進展主要依賴于訓練同質化的黑箱模型,使用粗暴的工程方法訓練大規模神經網絡。

雖然性能提高了,也無需手動設計特征,但神經網絡內部學到的特征表示卻是不可解釋的,并且大模型帶來其他的難題,比如不斷提高的數據收集和計算的成本、學到的表征缺乏豐富性、穩定性(模式崩潰)、適應性(容易出現災難性遺忘);對變形或對抗性攻擊缺乏穩健性等。

作者認為,目前在深度網絡和人工智能的實踐中出現這些問題的根本原因之一是對智能系統的功能和組織原則缺乏系統和綜合的理解。

舉個例子,訓練用于分類的判別式模型和用于采樣或重放的生成性模型基本上在實踐中是分開的。這樣訓練的模型通常叫開環系統,需要通過監督或自監督進行端到端的訓練。

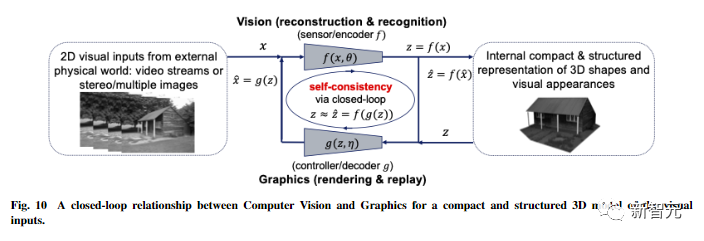

在控制理論中,這種開環系統(open-loop systems)不能自動糾正預測中的錯誤,而且對環境的變化沒有適應性;正是因為這樣的問題,在控制系統(controlled systems)中大家廣泛采用「閉環反饋」,使系統能夠自主糾正錯誤。

類似的經驗在學習中也適用:一旦判別式模型和生成性模型結合在一起,形成一個完整的閉環系統,學習就可以變得自主(無需外部監督),而且更有效率、更穩定、更有適應性。

為了理解智能系統中可能需要的功能組件,如判別器或生成器等部件,我們需要從一個更加「原則」和「統一」的角度來理解智能。

文中提出兩個基本原則:簡約(Parsimony)和自洽(Self-consistency),分別回答了關于學習的兩個基本問題。

- 學什么:要從數據中學習什么,如何衡量學到的好壞?

- 怎么學:我們如何通過高效和有效的計算框架來實現這樣一個學習的目標?

對于第一個「學什么」的問題,簡約原則認為:?

智能系統的學習目標就是從外部世界的觀測數據中找出低維的結構,并且以最緊湊和結構化的方式重新組織和表示它們。

這也就是「奧卡姆剃刀」原則:如無必要,勿增實體。

如果沒有這一原則,智能就不可能發生與存在!如果對外部世界的觀測數據沒有低維結構,就沒有什么值得學習或記憶的東西,也就無法進行良好的泛化或預測。

而且智能系統需要盡量節省資源,如能量、空間、時間和物質等,在某些情況下,該原則也被稱為「壓縮原則」。但是,智能的簡約性(Parsimony of Intelligence)并不是要實現最好的壓縮,而是要通過高效的計算手段獲得觀測數據最緊湊和結構化的表達。

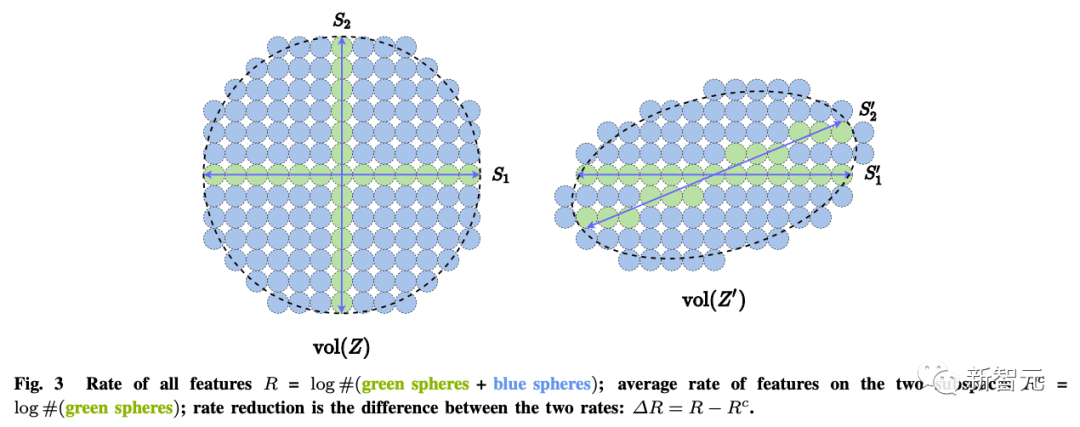

那么簡約性該如何度量?

對于一般的高維模型來說,許多常用的數學或統計學「度量」的計算成本都是指數級的,或者對于有低維結構的數據分布來說,甚至是沒有定義的,比如最大似然、KL分歧、互信息、Jensen-Shannon和Wasserstein距離等。

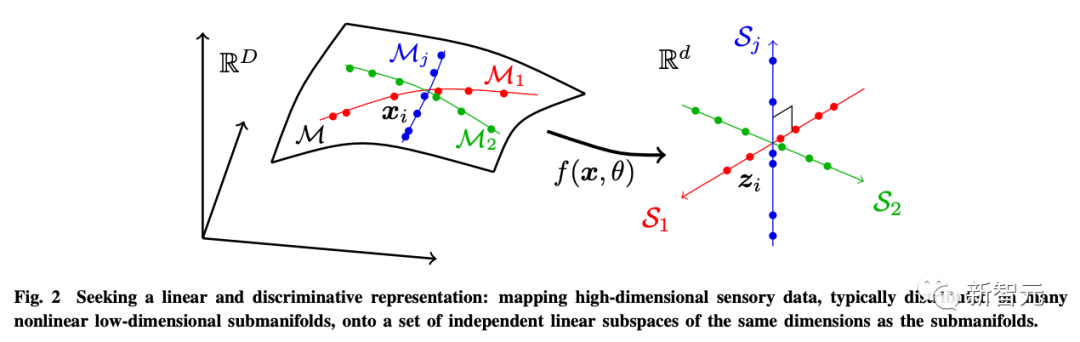

作者認為學習的目的實際上就是建立一個映射(通常是非線性的),從原始高維輸入中得到一個低維的表示。

這樣,得到的特征z的分布應該更加緊湊和結構化;緊湊意味著存儲上更經濟;結構化意味著訪問和使用更加高效:特別是線性結構,是內插或外推的理想選擇。

為了這個目的,作者引入了線性判別表示(LDR),實現三個子目標:

- 壓縮:將高維感官數據x映射到低維表征z;

- 線性化:將分布在非線性子面的每一類物體映射到線性子空間;

- 稀疏化:將不同類別映射到相互獨立或最不相關的子空間。

而這幾個目標可以通過最大編碼率減少(rate reduction)來實現,保證所學到的LDR模型具有最優的簡約性能。

對于第二個「怎么學」的問題,自洽原則認為:?

一個自主的智能系統通過最小化觀測到的數據和再生成的數據在內部表達中的差異,為外部世界的觀測尋求一個最自洽的模型。

僅僅是簡約原則并不能確保學到的模型能夠捕捉到關于外部世界的數據中的所有重要信息。例如,通過最小化交叉熵,將每個類別映射到一個一維的one-hot向量,可以被看作是簡約性的一種形式。

它可能會學到一個好的分類器,但學到的特征也可能會崩潰成一個singleton,也稱為神經崩潰。這樣學到的特征將不再包含足夠的信息來重新生成原始數據。

即使我們考慮更普遍的LDR模型,僅靠最大化編碼率差也不能自動確定環境特征空間的正確維度。

如果特征空間的維度太低,學到的模型就會與數據不匹配;如果太高,模型可能會過度匹配。

更一般地說,我們認為感知的學習不同于學習具體任務。感知的目標是學習關于所感知的一切可預測的內容。

就像愛因斯坦所說過的:「事情應該力求簡單,不過不能過于簡單。」

通用學習引擎

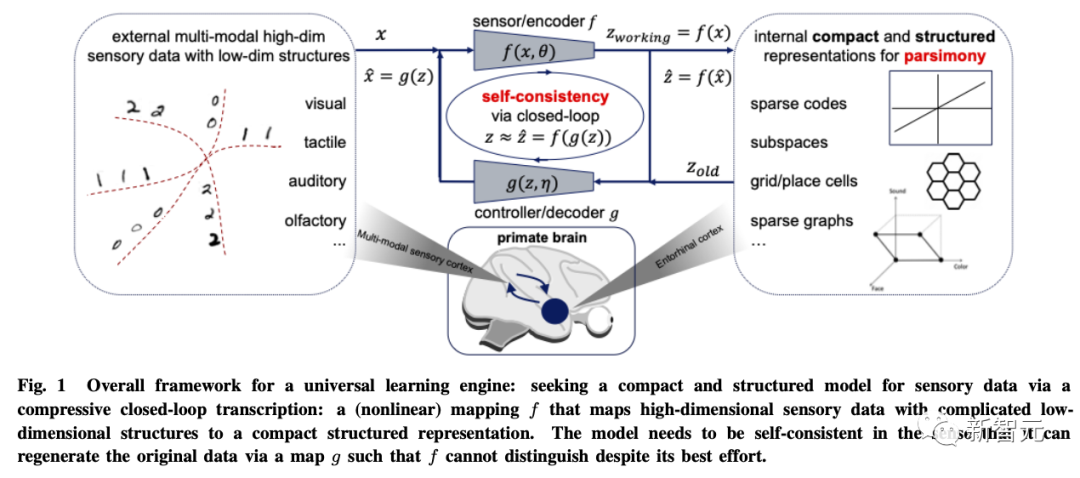

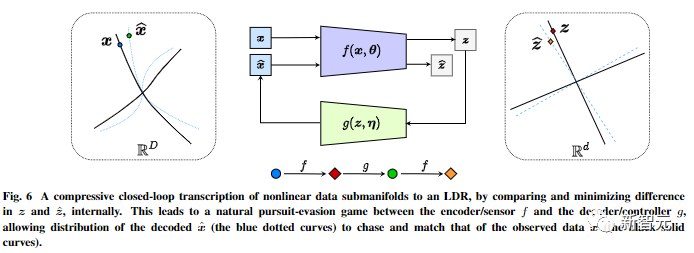

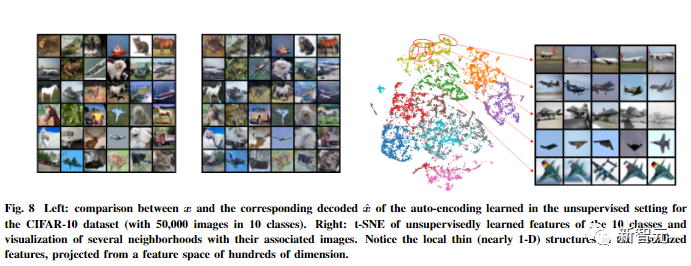

基于這兩個原則,文章以視覺圖像數據建模為例推導出了壓縮閉環轉錄框架(compressive closed-loop transcription framework)。

其通過比較和最小化內部表征的差異,在內部對非線性數據子流型進行壓縮式閉環轉錄,以實現LDR。

編碼器/傳感器和解碼器/控制器之間的追逃游戲,可以讓解碼表征生成的數據的分布追逐和匹配觀察到的真實數據分布。

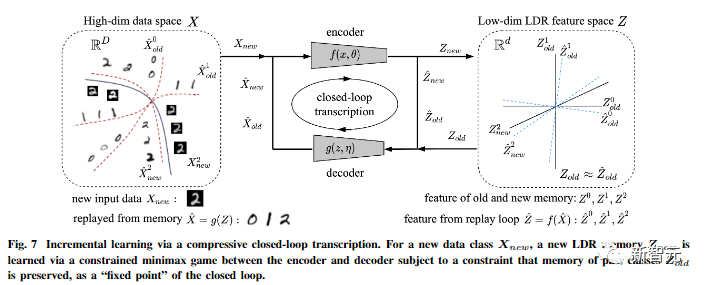

另外作者指出,壓縮式閉環轉錄可以有效地進行增量學習。

一個新的數據類的LDR模型可以通過編碼器和解碼器之間的一個有約束的博弈來學習的:過去學習到的類的記憶可以很自然地作為博弈中的約束被保留,也就是作為閉環轉錄的「固定點」。

文中還對這個框架的普適性提出了更多的推測性想法,將其擴展到三維視覺和強化學習,并預測其對神經科學、數學和高級智能的影響。

通過這個由第一性原理推導出來的框架:信息編碼理論、閉環反饋控制、優化/深度網絡和博弈論的概念都有機地整合在一起,成為一個完整的、自主的智能系統的必要組成部分。

值得一提的是,壓縮閉環式架構在自然界的所有智能生物以及不同尺度上無處不在:從大腦(壓縮感知信息),到脊柱回路(壓縮肌肉運動),直至DNA(壓縮蛋白質的功能信息)等等。

所以作者認為,壓縮性閉環轉錄應該是所有智能行為背后的「通用學習引擎」。它使得自然的或者人工的智能系統能夠從看似復雜的感知數據中發現并提煉出低維的結構,把它們轉換為簡潔規則的內部表達,以利于將來正確地判斷和預測外部世界。

這是一切智能發生和發展的計算基礎和機理。

參考資料:http://arxiv.org/abs/2207.04630?