NLPer復(fù)工了!先看看這份2019機(jī)器學(xué)習(xí)與NLP年度盤點(diǎn)吧

2019 年是機(jī)器學(xué)習(xí)和自然語言處理領(lǐng)域飛速發(fā)展的一年。DeepMind 科學(xué)家 Sebastian Ruder 從 10 個方面總結(jié)了我們在過去的一年中取得的重要進(jìn)展,對未來的研究方向有著重要的指導(dǎo)意義。

本文介紹了 2019 年中 機(jī)器學(xué)習(xí)和自然語言處理領(lǐng)域 10 個影響巨大的有趣研究方向。

對于每個方向,本文都會先總結(jié)今年我們在該方向取得的主要進(jìn)展,簡要說明我認(rèn)為這個方向重要的原因,最后對未來的工作進(jìn)行簡短的展望。

這 10 個方向分別是:

- 通用無監(jiān)督預(yù)訓(xùn)練(Universal unsupervised pretraining)

- 彩票(Lottery tickets)假設(shè)

- 神經(jīng)正切核(The Neural Tangent Kernel)

- 無監(jiān)督多語言學(xué)習(xí)(Unsupervised multilingual learning)

- 更多魯棒的對比基準(zhǔn)(More robust benchmarks)

- 機(jī)器學(xué)習(xí)與自然語言處理對科學(xué)發(fā)展的貢獻(xiàn)(ML and NLP for science)

- 解決自然語言生成問題中的解碼誤差(Fixing decoding errors in NLG)

- 增強(qiáng)預(yù)訓(xùn)練的模型(Augmenting pretrained models)

- 高效且記憶范圍廣的 Transformer(Efficient and long-range Transformers)

- 更加可靠的分析方式(More reliable analysis methods)

通用非監(jiān)督預(yù)訓(xùn)練

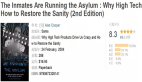

由于 BERT(Devlin et al., 2019)及其變體橫空出世,無監(jiān)督預(yù)訓(xùn)練在今年的自然語言處理(NLP)領(lǐng)域大放異彩。眾多 BERT 的變體已經(jīng)在多模態(tài)場景下被應(yīng)用,這些場景主要涉及文本及其相關(guān)的圖像、視頻(如下圖所示)。無監(jiān)督訓(xùn)練也開始滲透到過去監(jiān)督學(xué)習(xí)統(tǒng)治的領(lǐng)域。在生物信息學(xué)領(lǐng)域中,Transformer 語言模型的預(yù)訓(xùn)練也開始被應(yīng)用在蛋白質(zhì)序列預(yù)測上了(Rives et al., 2019)。

在計算機(jī)視覺領(lǐng)域,包括 CPC(Hénaff et al., 2019), MoCo(He et al., 2019)和 PIRL(Misra & van der Maaten, 2019)在內(nèi)的模型,以及為了提升在 ImageNet 數(shù)據(jù)上的采樣效率與圖像生成效果而提出的強(qiáng)大的生成器模型 BigBiGAN(Donahue & Simonyan, 2019)都利用了自監(jiān)督學(xué)習(xí)方法。在語音領(lǐng)域,多層卷積神經(jīng)網(wǎng)絡(luò)(Schneider et al., 2019)和雙向 CPC(Kawakami et al., 2019)學(xué)習(xí)到的表征都比最先進(jìn)的模型表現(xiàn)要好,而且所需的訓(xùn)練數(shù)據(jù)也更少。

它為什么重要?

無監(jiān)督預(yù)訓(xùn)練使得我們在訓(xùn)練模型時對已標(biāo)注數(shù)據(jù)的需求量大大減少。這使得那些以前數(shù)據(jù)需求得不到滿足的領(lǐng)域開始有了煥發(fā)活力的可能性。

接下來會怎么發(fā)展?

盡管研究人員已經(jīng)著手研究無監(jiān)督預(yù)訓(xùn)練,而且已經(jīng)在一些獨(dú)立領(lǐng)域上已經(jīng)取得了巨大的成功。但如果未來它能夠朝著多模態(tài)緊密融合的方向發(fā)展,應(yīng)該還是很有趣的。

最近提出的 BERT 的多模態(tài)變體 VideoBERT(Sun et al., 2019)。它可以基于食譜生成視頻的「token」(圖片上半部分),還可以在給定某個視頻「token」時,預(yù)測后面不同的時間尺度下的「token」(圖片下半部分)。

彩票假設(shè)

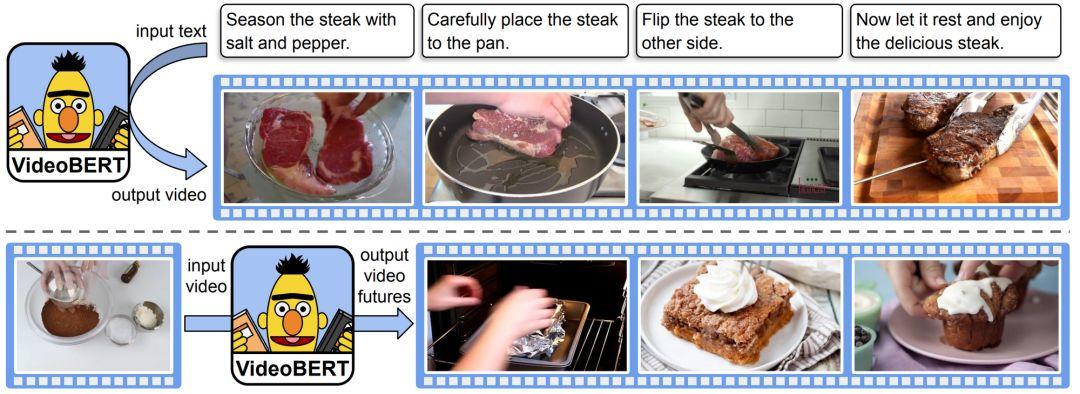

如下圖所示,F(xiàn)rankle and Carbin(2019)定義了「中獎彩票」(winning tickets)——也就是在密集的、隨機(jī)初始化的前饋網(wǎng)絡(luò)中找到的初始化良好的子網(wǎng)絡(luò),獨(dú)立訓(xùn)練這個子網(wǎng)絡(luò)應(yīng)該得到與訓(xùn)練完整網(wǎng)絡(luò)相近的準(zhǔn)確率。

雖然最初的剪枝過程只適用于小的視覺任務(wù),但后來的工作 (Frankle et al., 2019) 將剪枝應(yīng)用于早期的訓(xùn)練,而不是初始化階段,這使得找到更深的模型的小子網(wǎng)絡(luò)成為可能。Yu et al.(2019) 在 NLP 與 RL 的 LSTM 和 Transoformer 模型中也發(fā)現(xiàn)了「中獎彩票」。盡管這種中獎的彩票還是很難找到的,但它們似乎可以在數(shù)據(jù)集和優(yōu)化器之間轉(zhuǎn)移 (Morcos et al., 2019)。

為什么重要?

在神經(jīng)網(wǎng)絡(luò)變得越來越先進(jìn)的同時,它們的規(guī)模也與日俱增,訓(xùn)練它們并將其用于預(yù)測的算力需求也越來越大。能夠穩(wěn)定地找出達(dá)到類似性能的較小的子網(wǎng)絡(luò)可以大大減少訓(xùn)練與推理的算力需求。這可以加速模型迭代,并且為終端設(shè)備計算和邊緣計算開啟了新可能。

接下來會怎么發(fā)展?

目前來說,在低資源的場景下,為了產(chǎn)生實(shí)際的效益,想要找出「中獎彩票」仍然需要巨大的計算開銷。更加魯棒的 one-shot 剪枝方法對剪枝過程中噪音的敏感度小一些,因此可以在一定程度上緩解這個問題。研究「中獎彩票」的特性也能夠幫助我們更好地理解初始化,了解神經(jīng)網(wǎng)絡(luò)訓(xùn)練的過程。

不同剪枝率下的測試準(zhǔn)確率——實(shí)線代表中獎彩票,虛線代表隨機(jī)采樣得到的子網(wǎng)絡(luò)(Frankle & Carbin, 2019)。

神經(jīng)正切核

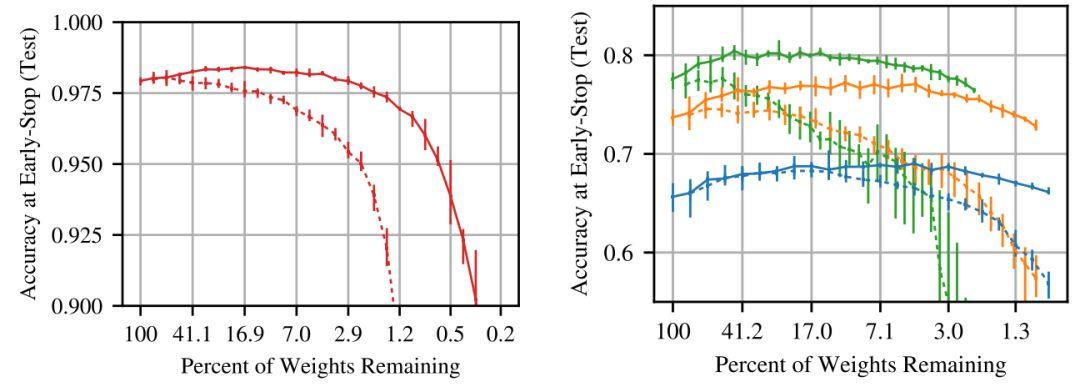

估計一般人都很難想到,當(dāng)神經(jīng)網(wǎng)絡(luò)很寬(更確切地說是無限寬)時,其實(shí)是比它窄的時候更好研究的。研究結(jié)果表明,在無限寬極限下,神經(jīng)網(wǎng)絡(luò)可以近似為一個帶核的線性模型,該核即為神經(jīng)正切核(Neural Tangent Kernel,NTK,Jacot et al., 2018)。實(shí)際上,這些模型的性能不及深度有限的模型(Novak et al., 2019; Allen-Zhu et al., 2019 ; Bietti & Mairal, 2019 ),這也限制了研究結(jié)果在標(biāo)準(zhǔn)方法上的應(yīng)用。

然而,近期的一些工作(Li et al., 2019; Arora et al., 2019)已經(jīng)大大降低了神經(jīng)正切核與標(biāo)準(zhǔn)方法的性能差距(參見 Chip Huyen 關(guān)于 NeurIPS 2019 其他相關(guān)論文的博文)。

為什么重要?

NTK 可能是我們所掌握的用于分析神經(jīng)網(wǎng)絡(luò)理論行為最強(qiáng)大的工具。雖然它也有其局限性(即實(shí)用的神經(jīng)網(wǎng)絡(luò)仍然比相應(yīng)的 NTK 版本的模型性能更好),而且這個領(lǐng)域迄今為止的研究成果都還沒有轉(zhuǎn)化成實(shí)際效益,但它可能幫助我們打開深度學(xué)習(xí)的黑盒。

下一步該做什么?

目前看來,NTK 與標(biāo)準(zhǔn)方法的差距主要來源于寬度的不同,未來的工作可能會試著去描述這種差距。這也將幫我們將無限寬度限制的想法放在實(shí)踐中。最終,NTK 可能幫助我們理解神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過程和泛化行為。

帶有 NTK 的線性模型在輸出放縮因子 α 取不同值時的學(xué)習(xí)過程,圖中的橢圓為 NTK 的可視化結(jié)果。

無監(jiān)督多語言學(xué)習(xí)

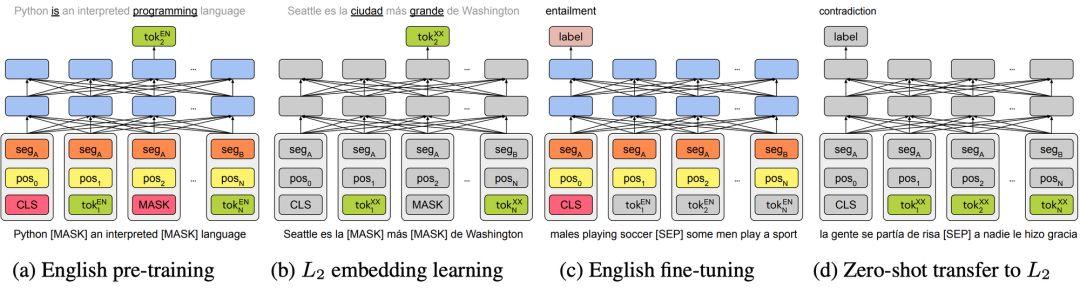

多年來,跨語言表征主要關(guān)注單次級別的研究,詳見總綜述文章「A Survey of Cross-lingual Word Embedding Models」。得益于無監(jiān)督預(yù)訓(xùn)練的發(fā)展,2019 年間涌現(xiàn)出了諸如 multilingual BERT,XLM(Conneau & Lample, 2019)和 XLM- R(Conneau et al., 2019)。盡管這些模型沒有顯式地使用任何跨語言信號,但即使在沒有共享單詞表或進(jìn)行聯(lián)合訓(xùn)練的情況下(Artetxe et al., 2019; Karthikeyan et al., 2019 ; Wu et al., 2019),它們在不同語言之間的泛化效果也是出奇地好。

「Unsupervised Cross-lingual Representation Learning」對多語言模型進(jìn)行了概述。這種深度模型也給無監(jiān)督機(jī)器翻譯領(lǐng)域帶來了很多提升(Song et al., 2019; Conneau & Lample, 2019)。該領(lǐng)域在 2018 年也取得了重要的進(jìn)展,由于統(tǒng)計方法與神經(jīng)網(wǎng)絡(luò)方法更合理的融合而得到了提升。另一個值得高興的發(fā)展是我們可以根據(jù)現(xiàn)有的英文預(yù)訓(xùn)練表征構(gòu)建深度多語言模型(見下圖)。

為什么重要?

現(xiàn)有的跨語言表征技術(shù)使得除了英語外的其它語言模型可以使用更少的語料進(jìn)行訓(xùn)練。而且,如果英文中有充足的標(biāo)注數(shù)據(jù),那這些方法就能讓 zero-shot 遷移成為可能。最終,它們也有可能幫助我們理解不同語言間的關(guān)系。

接下來該怎么發(fā)展?

目前這些方法在沒有任何跨語言監(jiān)督信號的情況下能取得如此好的性能的原因尚不明確。進(jìn)一步了解這些方法的工作機(jī)理可能會幫助我們設(shè)計出更強(qiáng)大的算法,也有可能揭示出不同語言結(jié)構(gòu)之間的關(guān)系。此外,我們不應(yīng)該只把注意力放在 zero-shot 遷移上,我們還應(yīng)該考慮從那些幾乎沒有標(biāo)注數(shù)據(jù)的目標(biāo)語言中學(xué)習(xí)。

Artetxe et al. (2019) 提出的單語言遷移方法的四個步驟。

更魯棒的對比基準(zhǔn)

SOTA 中有東西腐朽了——Nie et al. (2019) 對莎士比亞的名言「Something is rotten in the state of Denmark」的改述。

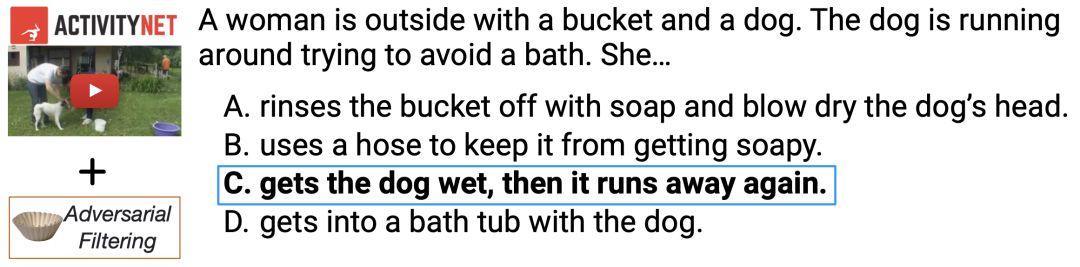

近期,像 HellaSWAG(Zellers et al., 2019)這種新的 NLP 數(shù)據(jù)集都是為了考驗(yàn)當(dāng)前性能最優(yōu)的模型而創(chuàng)建的。數(shù)據(jù)集中的示例都是經(jīng)過人工篩選的,以明確保證留下的數(shù)據(jù)都是那些目前性能最優(yōu)的模型無法成功處理的(相關(guān)示例見下圖)。這種人為參與的對抗性數(shù)據(jù)構(gòu)建工作可以重復(fù)多次,例如最近的對比基準(zhǔn) Adversarial NLI(Nie et al., 2019)就使得數(shù)據(jù)集的創(chuàng)建對于目前的自然語言推斷模型來說更具挑戰(zhàn)性。

為什么重要?

許多研究者發(fā)現(xiàn),當(dāng)前的 NLP 模型并沒有學(xué)到他們應(yīng)該學(xué)到的東西,只是用一些很簡單的啟發(fā)式方法去發(fā)現(xiàn)一些數(shù)據(jù)中很淺層的線索,詳見「NLP's Clever Hans Moment has Arrived」。隨著數(shù)據(jù)集變得越來越魯棒,我們希望新提出的模型可以被逼著學(xué)習(xí)到數(shù)據(jù)中真正深層次的關(guān)系。

接下來該怎么發(fā)展?

隨著模型越來越強(qiáng)大,大多數(shù)數(shù)據(jù)集需要不斷改進(jìn),否則很快就會過時。我們需要專用的基礎(chǔ)系統(tǒng)和工具來促進(jìn)這一進(jìn)程。此外,應(yīng)該運(yùn)行合適的對比基線,包括使用不同數(shù)據(jù)變體的簡單方法和模型(例如使用不完整的輸入),以便數(shù)據(jù)集的初始版本盡可能魯棒。

上圖為 HellaSWAG 中的一個句子填空多選題,當(dāng)前性能最優(yōu)的模型很難回答這個問題。最難的例子在于復(fù)雜度需要「剛剛好」,回答中會包含三個背景中的句子和兩個生成的句子(Zellers et al., 2019)。

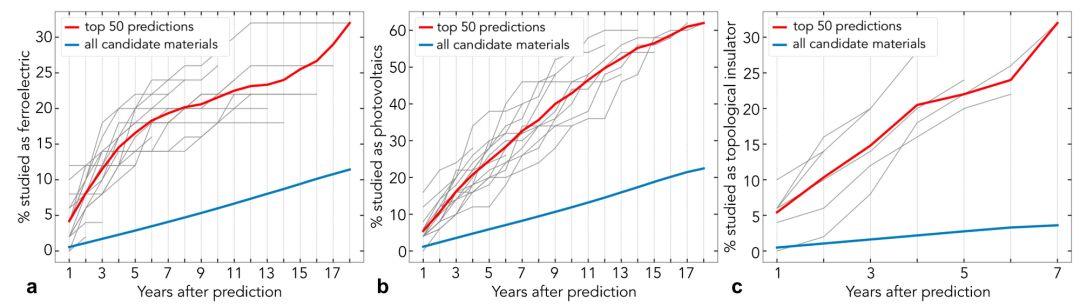

科學(xué)中的機(jī)器學(xué)習(xí)與自然語言處理

將機(jī)器學(xué)習(xí)用于基礎(chǔ)科學(xué)問題取得了一些重要的進(jìn)展。本文作者主要關(guān)注的領(lǐng)域是深度神經(jīng)網(wǎng)絡(luò)在蛋白折疊預(yù)測以及多電子薛定諤方程(Pfau et al., 2019)上的應(yīng)用。從 NLP 的角度來說,值得高興的是,即使是標(biāo)準(zhǔn)模型在融合領(lǐng)域指示后也能得到巨大的進(jìn)步。在材料科學(xué)領(lǐng)域,研究人員完成了一個使用詞嵌入來分析潛在知識的工作(Tshitoyan et al., 2019),從而預(yù)測某種材料會不會擁有某種特性(見下圖)。在生物領(lǐng)域,基因、蛋白質(zhì)等數(shù)據(jù)都是序列型的,因此 NLP 方法(LSTM,Transformer 等)天生就適合解決這類問題,這些方法已經(jīng)被應(yīng)用于蛋白質(zhì)分類任務(wù)中了(Strodthoff et al., 2019; Rives et al., 2019)。

為什么重要?

科學(xué)可以說是機(jī)器學(xué)習(xí)影響最大的應(yīng)用領(lǐng)域之一。解決方案可能對許多其它的領(lǐng)域產(chǎn)生很大的影響,并且可以幫助解決實(shí)際問題。

下一步怎么做?

從在物理問題中對能量建模(Greydanus et al., 2019 )到求解微分方程(Lample & Charton, 2020),機(jī)器學(xué)習(xí)技術(shù)不斷地被應(yīng)用在新的科學(xué)問題中。2020 年,讓我們看看這其中最具影響力的工作是什么,這將非常有趣!

基于不同時間段文獻(xiàn)的摘要進(jìn)行訓(xùn)練獲得詞嵌入,從而預(yù)測這些材料在未來會被作為什么(鐵電體、太陽能光伏、拓?fù)浣^緣體)。

圖片展示了預(yù)測中最可能被研究的 50 個材料與所有候選材料的對比 (Tshitoyan et al., 2019 )。

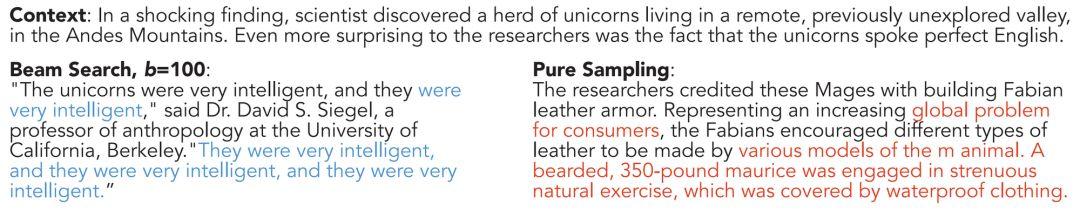

解決自然語言生成(NLG)中的解碼誤差

盡管自然語言生成(natural language generation, NLG)領(lǐng)域的模型越來越強(qiáng)大,但是它們?nèi)匀唤?jīng)常生成重復(fù)或者毫無意義的話(如下圖所示)。這主要是最大似然訓(xùn)練造成的。值得慶幸的是,這一點(diǎn)正在被改進(jìn),并且其進(jìn)展是與建模工作是正交的。這類改進(jìn)大部分都是以新的采樣方式(如原子核采樣,Holtzman et al., 2019)或新的損失函數(shù)(Welleck et al., 2019)的形式出現(xiàn)。

另外一個令人驚訝的發(fā)現(xiàn)是,好的搜索結(jié)果并沒有幫助模型獲得更好的生成結(jié)果:當(dāng)前的模型在一定程度上依賴于不精確的搜索與集束搜索的誤差。相反,在機(jī)器翻譯的場景下,精確搜索通常會返回?zé)o意義的翻譯結(jié)果(Stahlberg & Byrne, 2019)。這個發(fā)現(xiàn)表明,搜索和建模方面的進(jìn)步必須攜手并進(jìn)。

為什么重要?

NLG 是 NLP 中的最基本任務(wù)之一。在 NLP 和機(jī)器學(xué)習(xí)的研究中,大多數(shù)論文都重點(diǎn)關(guān)注對模型的改進(jìn),而其它部分的發(fā)展往往被忽略。對于 NLG 研究者來說,重要的是要提醒我們自己,我們的模型仍然有缺陷,也許可以通過修正搜索或訓(xùn)練過程來改進(jìn)輸出。

下一步怎么做?

盡管 NLG 模型越來越強(qiáng)大,而且有了遷移學(xué)習(xí)的助力,但是模型的預(yù)測結(jié)果依然包含了很大程度的認(rèn)為因素。找出并理解這些人為因素產(chǎn)生的原因是一個很重要的研究方向。

GPT-2 使用集束搜索以及單純的(貪婪)采樣方法產(chǎn)生的結(jié)果,藍(lán)色部分是重復(fù)的,紅色部分則是毫無意義的話。

增強(qiáng)預(yù)訓(xùn)練的模型

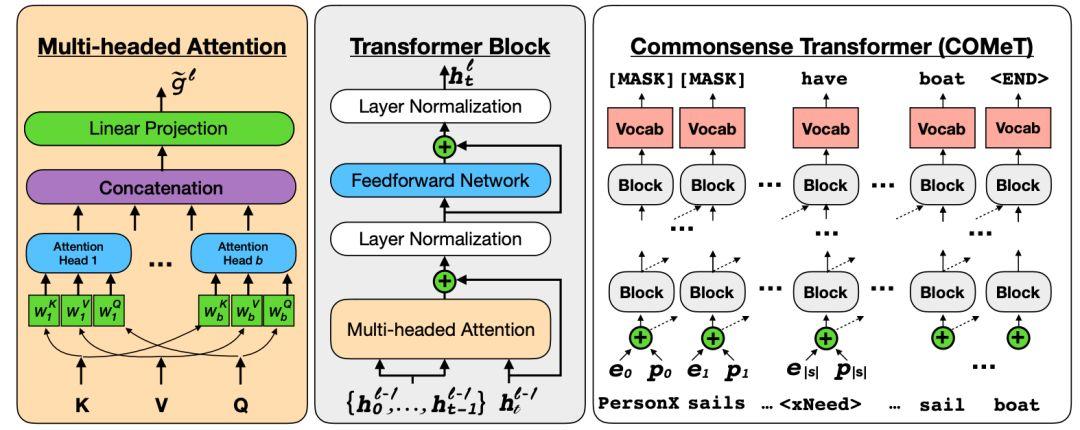

2019 年,值得高興的是,我們使預(yù)訓(xùn)練模型的方法擁有了新的能力。有些方法使用知識庫來加強(qiáng)預(yù)訓(xùn)練模型,用以提升模型在實(shí)體識別(Liu et al., 2019 )任務(wù)上的表現(xiàn)和對事實(shí)的回憶(Logan et al., 2019)。還有一些方法通過訪問一些預(yù)定義的可執(zhí)行程序完成簡單的算法推理(Andor et al., 2019)。由于大多數(shù)模型都有較弱的歸納偏置,且大部分知識是從數(shù)據(jù)中學(xué)習(xí)而來,因此增強(qiáng)預(yù)訓(xùn)練模型的另一個選擇就是增強(qiáng)訓(xùn)練數(shù)據(jù)本身(比如獲取常識,Bosselut et al., 2019),如下圖所示。

為什么重要?

模型正變得越來越強(qiáng)大,但有許多知識是模型無法僅從文本中學(xué)習(xí)的。特別是在處理更復(fù)雜的任務(wù)時,可用的數(shù)據(jù)可能太有限,無法使用事實(shí)或常識進(jìn)行顯式的推理,因此可能需要更強(qiáng)的歸納偏置。

下一步怎么做?

隨著這些模型被應(yīng)用于更有挑戰(zhàn)性的問題,越來越有必要對模型進(jìn)行組合性的修改。在未來,我們可能會結(jié)合強(qiáng)大的預(yù)訓(xùn)練模型和可學(xué)習(xí)的組合程序(Pierrot et al., 2019)。

一個標(biāo)準(zhǔn)的帶有多頭注意力機(jī)制的 Transformer。在給定頭實(shí)體和關(guān)系的情況下,訓(xùn)練后的模型可以預(yù)測知識庫三元組中的尾實(shí)體(Bosselut et al., 2019)。

高效且記憶范圍廣的 Transformer

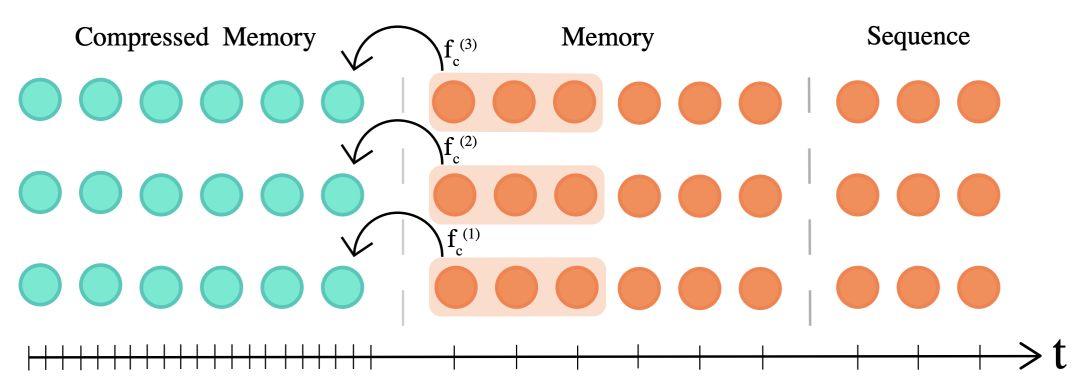

今年 Transformer 架構(gòu)得到了一些改進(jìn)(Vaswani et al., 2017 )。這些新的架構(gòu)(如 Transformer-XL,Dai et al., 2019 與 the Compressive Transformer,Rae et al., 2020 )使其可以獲取長距離依賴。

還有一些方法希望通過使用不同的(通常也很稀疏的)注意力機(jī)制(如 adaptively sparse attention, Correia et al., 2019; adaptive attention spans, Sukhbaatar et al., 2019 ; product-key attention, Lample et al., 2019; locality-sensitive hashing, Kitaev et al., 2020 等)來使 Transformer 更高效。

在基于 Transformer 的預(yù)訓(xùn)練領(lǐng)域中,也出現(xiàn)了很多更高效的變體,比如使用了參數(shù)共享的 ALBERT(Lan et al., 2020)以及使用更高效預(yù)訓(xùn)練任務(wù)的 ELECTRA(Clark et al., 2020)等。當(dāng)然,也有一些沒有使用 Transformer 而且同樣更高效的預(yù)訓(xùn)練模型,比如一元文檔模型 VAMPIRE (Gururangan et al., 2019) 和 QRNN-based MultiFiT (Eisenschlos et al., 2019)。另一個值得注意的趨勢是:對大型 BERT 進(jìn)行蒸餾,以獲得更小的模型(Tang et al., 2019 ; Tsai et al., 2019 ; Sanh et al., 2019)。

為什么重要?

Transformer 架構(gòu)從誕生之初就很有影響力。它是一種最先進(jìn)的 NLP 模型,并已被成功地應(yīng)用于許多其它的領(lǐng)域(參見第 1 和第 6 節(jié))。因此,對 Transformer 架構(gòu)的任何改進(jìn)都可能產(chǎn)生強(qiáng)烈的連鎖反應(yīng)。

下一步怎么做?

這些改進(jìn)需要一段時間才能落實(shí)到實(shí)踐中,但是考慮到預(yù)訓(xùn)練模型的普及和易用性,這種更有效的替代方案可能很快就會被采用。總的來說,我們希望研究者可以持續(xù)關(guān)注強(qiáng)調(diào)效率的模型架構(gòu),而稀疏性就是其中的主要趨勢之一。

Compressive Transformer(Rae et al., 2020)可以將過去的激活函數(shù)的細(xì)粒度記憶壓縮成粒度較粗的壓縮記憶。

更可靠的分析方法

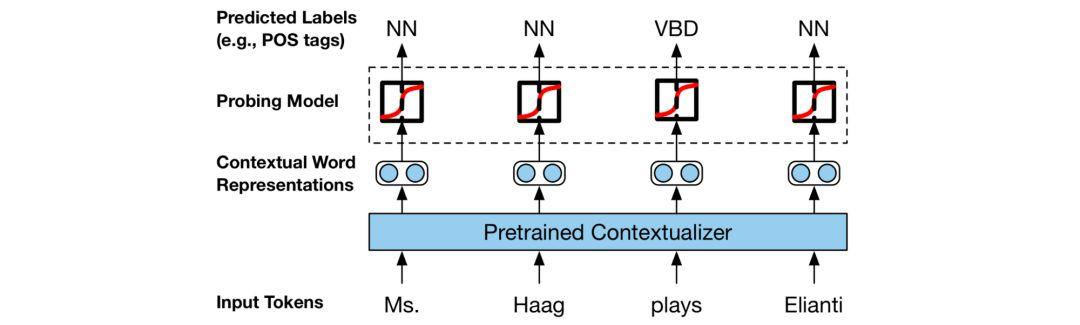

2019 年的一個關(guān)鍵趨勢是分析模型的論文越來越多。事實(shí)上,本文作者最喜歡的幾篇論文就是這樣的分析論文。比較早的一個亮點(diǎn)工作是 Belinkov & Glass 于 2019 年對分析方法的綜述。同時,在我的記憶中,今年也是第一次開始出現(xiàn)有工作致力于分析 BERT 這一種模型(這類論文被稱為 BERTology)的論文。在這種情況下,探針(probe)已經(jīng)成為一種常用的工具,它的目的是通過預(yù)測某些屬性來了解模型是否「理解」了詞法、句法等。

本文作者特別喜歡那些探究如何讓探針技術(shù)更可靠的論文(Liu et al., 2019 ; Hewitt & Liang, 2019)。可靠性也是一直在被討論的一個主題,即注意力是否能提供有意義的解釋(Jain & Wallace, 2019; Wiegreffe & Pinter, 2019; Wallace, 2019)。研究人員對分析方法的興趣方興未艾,最好例證可能是 ACL 2020 的新賽道——NLP 模型的分析與可解釋性。

為什么重要?

目前最先進(jìn)的方法一般都被當(dāng)做黑盒來使用。為了開發(fā)更好的模型并在現(xiàn)實(shí)世界中使用它們,我們需要理解為什么模型會做出這些決策。然而,我們目前解釋模型預(yù)測結(jié)果的方法仍然有限。

下一步怎么做?

我們需要做更多的工作來解釋那些超出我們預(yù)期的預(yù)測,它們通常是不可靠的。在這個方向上,的一個重要趨勢是更多數(shù)據(jù)集提供了人工書寫的解釋(Camburu et al., 2018 ; Rajani et al., 2019; Nie et al., 2019)。

用來學(xué)習(xí)表征中的語言知識的 probing 設(shè)置。

以上便是作者對 2019 年 NLP 領(lǐng)域的盤點(diǎn)了。可以看出,NLP 依然是一個蓬勃發(fā)展的領(lǐng)域,很多理論都在快速發(fā)展,未來研究成果可期。