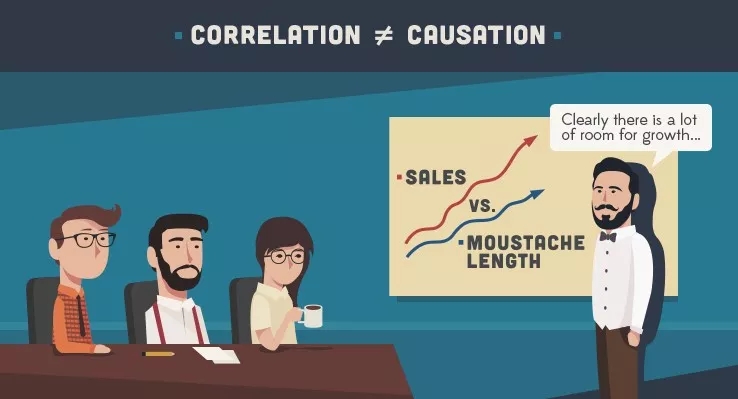

相關不等于因果,深度學習讓AI問出“十萬個為什么”

大數據文摘出品

來源:searchenterpriseai

編譯:張大筆茹

生活經驗告訴我們,相關關系并不能直接推導出因果關系,但不管是日常生活還是學術研究,對于因果關系的解釋要遠比相關關系重要得多。很多時候,我們也會對事件之間的因果關系捉襟見肘。

如果,把這個過程交給AI來處理會怎樣呢?

AI可以利用深度學習技術來構建相關關系模型。但是,用于確定事情發生原因的因果深度學習目前仍處于起步階段,而且它的自動化比普通神經網絡也困難許多。

大部分AI都是通過分析大量數據尋找其中隱藏的規律。全球IT服務公司L&T Infotech的執行副總裁兼首席數據分析官蘇門德拉·莫漢蒂(Soumendra Mohanty)表示,“顯然,這能使我們能了解到‘是什么’,但卻很少能理解‘為什么’”。

這個區別的影響是很大的。建造人工智能的最終目的是訓練AI回答為什么這個因素會影響那個因素,這就是許多研究人員現在將注意力轉向這兒的原因。

加州大學洛杉磯分校的教授朱迪亞·珀爾(Judea Pearl)的關于實施貝葉斯網絡統計分析的研究取得重要成績,他在開發一個可以在可計算框架中區分事件原因的、用于繪制因果關系圖的框架。

分析因果關系的最大挑戰之一是通過專家判斷一件事情的原因,此為主觀意見,然后再通過各種分析技術將其分開。這與統計機器學習所追求的“客觀”形成鮮明對比。長遠來看,因果關系研究可以幫助我們更好地理解世界;短期內,因果分析也可以更好地解釋機器學習模型的結果。

不再期待AI奇跡般地預測未來

Information Builders營銷副總裁杰克·弗賴瓦爾德(Jake Freivald)說:“商業精英通常不相信黑盒子技術,但他們卻對人工智能技術有著異乎尋常的期待。”他表示,企業家意識到將業務流程交給人工智能算法可能就像讓他們兩歲的孩子駕駛自己的汽車一樣冒險。

問題在于,分析型AI主要用于查找數據集中的相關性,而相關性僅僅能暗示因果關系,無法準確解釋事情為什么發生。相關性只能告訴你接下來可能會發生什么。

“我們越能在模型中梳理出因果關系,就越能在現實基礎上準確評估事情發生的原因以及接下來會發生什么,”弗雷瓦德說,“只有到那時,將業務交給人工智能就可以很好地完成工作。否則,結果可能是災難性的。”

不再僅僅是擬合曲線

擬合曲線在回答諸如“下一個最佳報價是什么?”、“這會是詐騙嗎?” 或者“它是貓嗎?”這類問題上表現出色。

“但現實世界中,很多問題是無法僅通過曲線擬合度解決的,”莫漢蒂說。如果幾個因素都可以預測產品偏好,那企業應該選擇哪些因素以及如何確定其重要性順序呢?簡單地將不同變量按強度排列與獨立選擇一些因素并單獨評估其對預測結果的貢獻程度的結果是不同的。

“我們可以觀察相關性,但并不能證明甚至解釋因果關系,”莫漢蒂說。因果關系回答的是“我應該采取什么行動才能實現改變?”或“如果我改變模型的一些基本假設會怎樣?”

因果深度學習技術(又稱結構方程模型SEM)已存在多年了。然而,這些技術或多或少地局限于學術研究,目前還沒有應用到商業領域。

蒙特卡羅模擬,馬爾可夫鏈分析,樸素貝葉斯和隨機建模是當今常用的一些技術,但它們幾乎都不能分析因果關系。還有一些開源軟件包,如DAGitty(一個基于瀏覽器的環境,用于創建,編輯和分析因果模型以及Microsoft的DoWhy庫的軟件包)也用于因果推理。但這些仍在發展中。

自動庫存管理系統的制造商Pinsa Systems的首席執行官兼總裁理查德·施瓦茨(Richard Schwartz)表示,在整體上看,AI應用程序會根據其觀察到的模式執行一系列操作。深度學習使用統計技術來發現規律。在AI中嵌入因果理解的不同方法需要開發基于規則的系統。這種系統可以從其他類型的客觀事實中得出結論,例如“右轉三次等同于左轉”。

規則可以是因果關系或認知關系,它們有助于根據輸入對結果進行建模,但它們也有缺點:“因果規則很難界定的,明確定義往往更難。”

潛在的解決方案是兩種方法的組合,例如,為神經網絡創建可解釋性模塊。這種系統的因果深度學習模式是以更加艱苦的方式構建如何達成結論的認知模型。

另外一種比較好的因果AI技術是通過強化學習領域的“從示范中學習”(Learning from demonstration),這種方法首先輸入一些計算機完成某些事情的例子,然后讓計算機適應該技術,自己解決問題。

彭薩(Pensa)在其庫存管理工具中使用兩種類型的人工智能來解決與商店貨架上重新進貨庫存相關的問題。主要產品使用神經網絡,用以解決攝像機的計算機視覺輸入識別貨架上的物品(例如,亨氏牌番茄醬)以及貨架的擺放方式(例如,亨氏牌產品通常在亨特牌產品的旁邊)等問題。

使用因果模型生成自動提示,例如“亨氏番茄醬快要缺貨”,或者“亨氏番茄醬已經完全缺貨”。為了得出這個結論,系統不僅需要識別產品,還需要理解貨架上物品的相關庫存控制規則以及重新進貨的意義。

人類通常非常擅長得到認知型結論,例如制定經驗法則,從而得出結論。“這是人工智能的瓶頸,”施瓦茨說。

無需模型的因果關系

德克薩斯大學奧斯汀分校的人工智能教授斯科特·尼克姆(Scott Niekum)說,強化學習本質上是因果關系,因為智能體會嘗試不同的方式并通過反復試驗來了解其是如何得到結果的。這種類型的學習被稱為“非模型學習”,很受歡迎,因為它可以學習正確的或有效的行為而無需學習世界是如何運作的。

換句話說,智能體學習行動與后果之間的因果關系,而不是行動如何直接影響世界的。例如,它可以在不了解水和火之間的關系的情況下翻轉火上方的水桶將水倒出用來滅火。

非模型學習是一把雙刃劍。如果沒有模型,智能體就必須從頭學習如何在問題發生變化時解決問題。

在前面的例子中,如果給智能體一個水管而不是一桶水,它就不知道怎么辦了而需要從頭開始學習,因為它只學習了“翻桶”行動與撲滅火災,并沒有學習水和火之間的因果關系。

尼克姆說:“由于這些原因,人們越來越關注基于模型的強化學習,盡管它也有缺點,例如,如何衡量模型的置信度,模型錯誤時該怎么做,如何管理大范圍長線計劃的不確定性?”

解釋機器學習模型

可解釋性的核心是這樣的:解釋必須能夠識別和量化所有對深度學習模型的行為負有因果關系的因素。在這方面,因果關系是指模型函數本身,而不是模型正在解決的任務,Fiddler Labs(一家可解釋的AI引擎公司)的數據科學負責人安庫爾·泰利(Ankur Taly)表示。

由于模型的復雜性,完整地解釋深度學習模型很難。難以分析推斷模型函數中每個特征的重要性,早期的因果深度學習方法是通過觀察模型對數據集的預測,在其中擬合一個更簡單、可解釋的模型來解釋它。

“不幸的是,這些方法容易受到從觀察數據推斷因果關系的影響,”泰利說,人們無法將與模型預測真正相關的特征與那些與之相關的特征區分開來。

最近出現了一套基于合作博弈理論的Shapley值的不同算法。這些算法使用反事實輸入探測模型。然而,FiddlerLabs的研究發現,如果數據集不是正態分布的,這些算法大多數情況下都會導致偏差。泰利說他們正在研究將解釋模型與特定數據集分離的方法。

這種研究有助于識別模型學會依賴的虛假相關性。例如,黑客最近可以通過添加某些類型的數據來偽造Cylance反惡意軟件引擎。減輕這種風險的第一步是確定顯著影響模型預測的因果特征。

“然后人們可以通過研究這些特征來檢查它們是否也是這項任務的原因,或者它們是否被對手利用了,就像Cylance一樣,”泰利說。

不可盲目迷信AI

據Information Builders的弗賴瓦爾德說,目前人類可以比AI更好地通過深度學習建立因果關系。這涉及到限制數據集,剔除可能導致偏差的字段,并塑造學習過程。人類關注因果關系,讓算法完成學習過程。這是一個反饋循環,但人是必不可少的。

如果因果關系可以由人工智能決定,那么人工智能可以重塑學習過程而不再需要人類。理論上,AI可以使用任意數據集來確定因果關系,并以人類完全沒意料到的方式進行學習。

目前還是存在很多未知的。人類可以用自己廣泛的智慧解決問題,而機器尚無法做到。最近的嘗試還產生了不少令人頭疼的并發癥。“我們希望人工智能越萬能,需要的數據就越多,誤報的可能性也就越大——這是機器的局限,我們不能盲目的迷信機器,”弗賴瓦爾德說。

相關報道:

https://searchenterpriseai.techtarget.com/feature/Causal-deep-learning-teaches-AI-to-ask-why

【本文是51CTO專欄機構大數據文摘的原創譯文,微信公眾號“大數據文摘( id: BigDataDigest)”】