10倍速度突破質量瓶頸,效果超越Gen-2和Pika!T2V-Turbo:新一代視頻生成模型 精華

論文鏈接: https://arxiv.org/pdf/2405.18750

項目鏈接:https://t2v-turbo.github.io/

基于擴散的文本到視頻(T2V)模型取得了顯著的成功,但仍然受到迭代采樣過程速度緩慢的影響。為了解決這一挑戰,一些一致性模型被提出來促進快速推理,盡管以犧牲樣本質量為代價。在這項工作中,旨在突破視頻一致性模型(VCM)的質量瓶頸,實現快速且高質量的視頻生成。本文引入了T2V-Turbo,將來自不同可微分獎勵模型混合的反饋集成到預訓練T2V模型的一致性蒸餾(CD)過程中。值得注意的是,本文直接優化與單步生成相關的獎勵,這些獎勵自然產生于計算CD損失,有效地繞過了通過迭代采樣過程反向傳播梯度所施加的內存限制。值得注意的是,本文的T2V-Turbo產生的4步生成在VBench上取得了最高的總分,甚至超過了Gen-2和Pika。

本文進一步進行了人類評估來證實結果,驗證了本文的T2V-Turbo產生的4步生成優于它們的教師模型產生的50步DDIM樣本,這表示視頻生成質量的提升了十倍以上,同時加速了視頻生成的過程。

介紹

擴散模型(DM)已經成為神經圖像和視頻合成的強大框架,加速了文本到視頻(T2V)模型的前沿發展,例如Sora,Gen-2和Pika。盡管這些基于擴散的模型的迭代采樣過程確保了高質量的生成,但它顯著減慢了推理速度,阻礙了它們的實時應用。另一方面,現有的開源T2V模型,包括VideoCrafter和ModelScopeT2V,是在網絡規模的視頻數據集上訓練的,例如WebVid-10M,視頻質量各不相同。因此,生成的視頻通常在視覺上看起來不吸引人,并且無法準確與文本提示對齊,偏離了人類的偏好。

為了解決上述列出的問題,已經進行了一些努力。為了加速推理過程,Wang等人應用了一致性蒸餾(CD)理論,從教師T2V模型中蒸餾出一個視頻一致性模型(VCM),使得在只需4-8個推理步驟中便能生成合理的視頻。然而,VCM生成的質量受到教師模型性能的自然瓶頸限制,并且減少的推理步驟進一步降低了其生成質量。另一方面,為了使生成的視頻與人類偏好保持一致,InstructVideo借鑒了圖像生成技術,并提出通過迭代視頻采樣過程反向傳播可微分獎勵模型(RM)的梯度。然而,計算完整的獎勵梯度成本過高,導致了巨大的內存成本。因此,InstructVideo通過將梯度計算限制為僅在最終DDIM步驟中截斷采樣鏈,從而損害了優化精度。此外,InstructVideo受限于其依賴于圖像文本RM,無法充分捕捉視頻的過渡動態。從經驗上看,InstructVideo僅對有限的一組用戶提示進行實驗,其中大多數與動物相關。因此,它對更廣泛范圍提示的泛化性仍然是未知的。

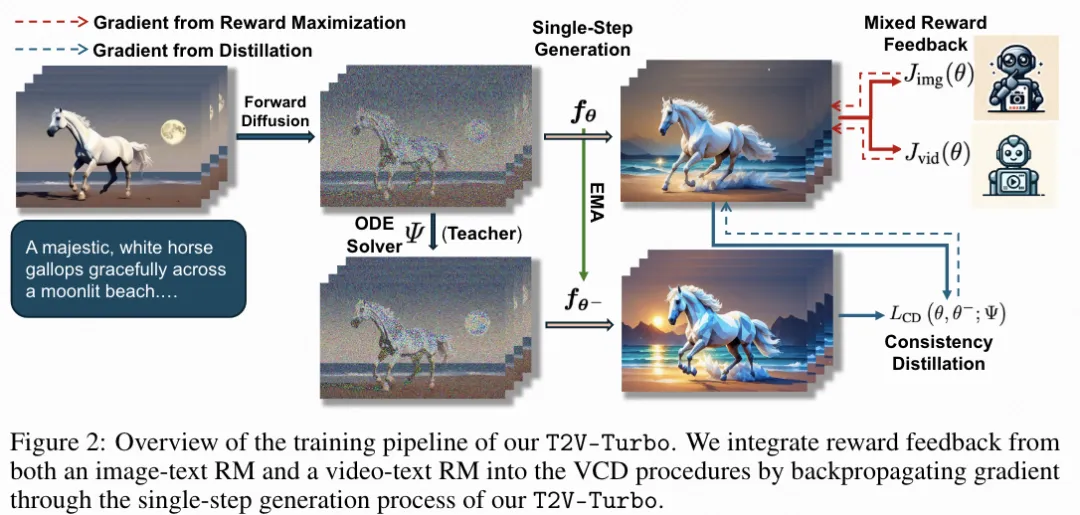

本文旨在通過打破VCM的質量瓶頸,實現快速且高質量的視頻生成。本文介紹了T2V-Turbo,它將來自多種RM混合的獎勵反饋集成到從教師T2V模型中蒸餾VCM的過程中。除了利用圖像文本RM來使單個視頻幀與人類偏好對齊之外,本文進一步結合了來自視頻文本RM的獎勵反饋,全面評估生成視頻中的時間動態和過渡。本文強調,本文的獎勵優化避免了通過迭代采樣過程反向傳播梯度所涉及的高度消耗內存的問題。相反,本文直接優化由計算CD損失而產生的單步生成的獎勵,有效地規避了傳統方法面臨的優化DM時的內存限制。

根據經驗,本文展示了T2V-Turbo在4-8個推理步驟內生成高質量視頻的優越性。為了說明本文方法的適用性,分別從VideoCrafter2和ModelScopeT2V中提取T2V-Turbo(VC2)和T2V-Turbo(MS)。值得注意的是,T2V-Turbo的兩個變體在4個步驟生成的結果都優于視頻評估基準VBench上的SOTA模型,甚至超過了使用大量資源訓練的專有系統,如Gen-2和Pika。本文進一步通過使用EvalCrafter基準中的700個提示進行人類評估來證實這些結果,驗證了T2V-Turbo的4步生成優于其教師T2V模型的50步DDIM樣本,這代表了十倍以上的推理加速和增強的視頻生成質量。

本文的貢獻有三點:

- 從多種RM的反饋中學習T2V模型,包括視頻文本模型。據作者所知,本文是第一個這樣做的。

- 在僅4個推理步驟中在VBench上建立了一個新的SOTA,優于使用大量資源訓練的專有模型。

- 根據人類評估,本文T2V-Turbo的4步生成優于其教師T2V模型的50步生成,代表了超過10倍的推理加速和質量改進。

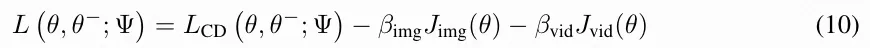

使用混合獎勵反饋訓練T2V-Turbo

特別是,本文利用圖像文本 RM 的獎勵反饋來提高每個單獨視頻幀的人類偏好,并進一步利用視頻文本 RM 的反饋來改善生成視頻中的時間動態和過渡。

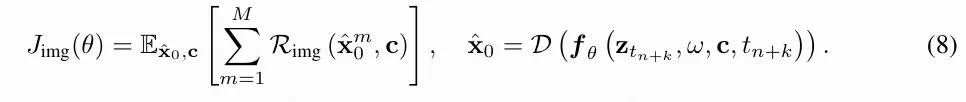

優化人類對個人視頻片段的偏好

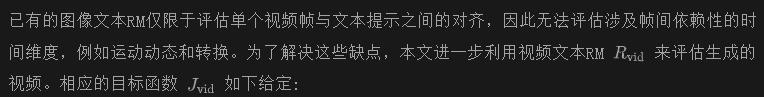

優化Video-Text反饋模型

總結

為了減少內存和計算成本,將本文的T2V-Turbo初始化為教師模型,并且僅優化LoRA權重,而不是執行完整的模型訓練。在完成訓練后,本文合并LoRA權重,使得本文的T2V-Turbo每步推理成本保持與教師模型相同。

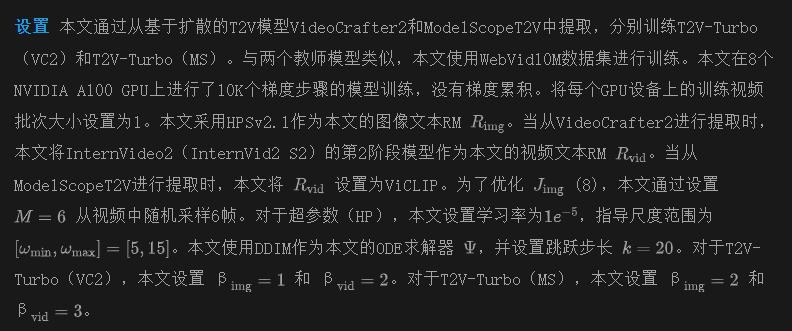

實驗結果

本文的實驗旨在展示T2V-Turbo在4-8個推理步驟內生成高質量視頻的能力。本文首先在標準基準測試集VBench上進行自動評估,以綜合評估本文的方法在各個維度上的性能,并與廣泛的基線方法進行比較。然后,本文使用來自EvalCrafter的700個提示進行人類評估,比較T2V-Turbo的4步和8步生成與教師T2V模型的50步生成以及基線VCM的4步生成。最后,對關鍵設計選擇進行消融研究。

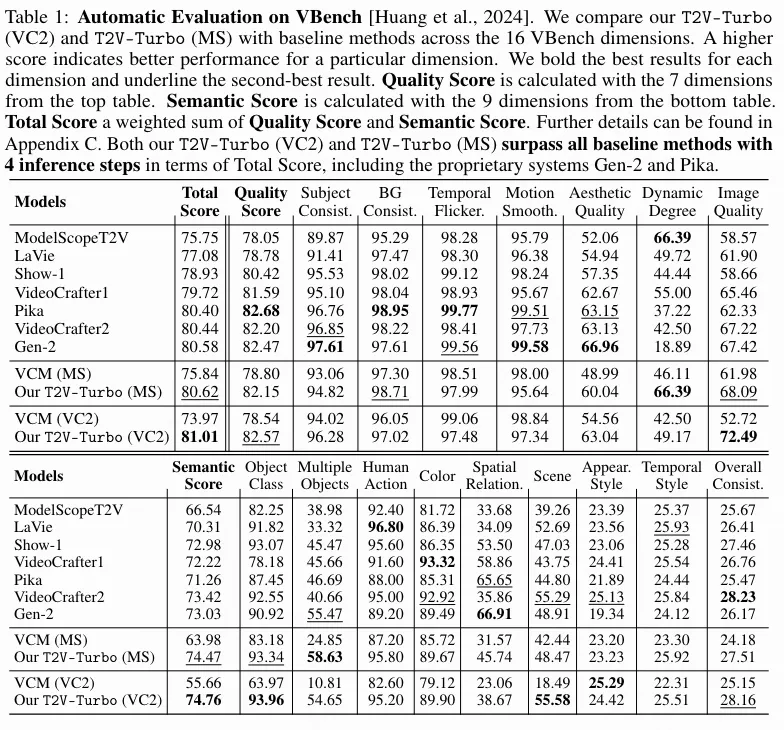

VBench 自動求值

本文評估了本文的T2V-Turbo(VC2)和T2V-Turbo(MS),并將它們與廣泛的基線方法進行比較,使用了標準視頻評估基準VBench。VBench旨在從16個解耦維度全面評估T2V模型。VBench中的每個維度都根據特定的提示和評估方法進行了定制。

下表1比較了本文方法的4步生成與VBench排行榜上各種基線方法的比較,包括Gen-2、Pika、VideoCrafter1、VideoCrafter2、Show-1、LaVie和 ModelScopeT2V。原文附錄中的表4進一步將本文的方法與VideoCrafter0.9、LaVie-Interpolation、Open-Sora和 CogVideo 進行了比較。每個基線方法的性能直接來自于VBench排行榜。為了獲得本文方法的結果,本文嚴格遵循VBench的評估協議,為每個提示生成5個視頻以計算指標。本文進一步從VideoCrafter2和ModelScopeT2V中提取VCM(VC2)和VCM(MS),并將它們的結果進行比較,而不包括獎勵反饋。

VBench已經制定了自己的規則來計算總得分、質量得分和語義得分。質量得分是使用頂部表格中的7個維度計算的。語義得分是使用底部表格中的9個維度計算的。而總得分是質量得分和語義得分的加權和。正如上表1所示,本文的T2V-Turbo(MS)和T2V-Turbo(VC2)的4步生成在總得分方面超過了VBench上的所有基線方法。這些結果尤其引人注目,因為本文甚至超過了使用大量資源訓練的專有系統Gen-2和Pika。即使從一個較不先進的教師模型ModelScopeT2V進行提取,本文的T2V-Turbo(MS)也獲得了第二高的總得分,僅次于本文的T2V-Turbo(VC2)。此外,本文的T2V-Turbo通過超越其教師T2V模型打破了VCM的質量瓶頸,明顯優于基線VCM。

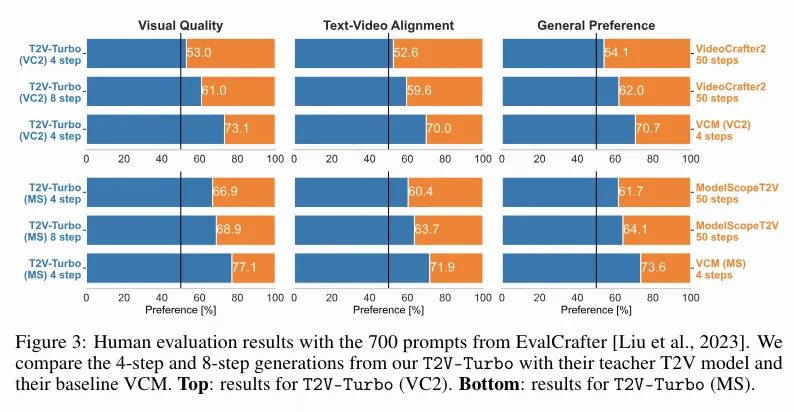

使用 700 個 EvalCrafter 提示進行人工評估

為了驗證本文的T2V-Turbo的有效性,本文將T2V-Turbo的4步和8步生成與相應教師T2V模型的50步DDIM樣本進行比較。本文進一步比較了從相同教師T2V模型提取時,本文的T2V-Turbo的4步生成與它們基線VCM的4步生成。

本文利用來自EvalCrafter視頻評估基準的700個提示,這些提示是基于真實世界的用戶數據構建的。本文從亞馬遜的 Mechanical Turk 平臺雇用人類標注員來比較使用相同提示生成的不同模型的視頻。對于每次比較,標注員需要回答三個問題:

- Q1)哪個視頻在視覺上更吸引人?

- Q2)哪個視頻更符合文本描述?

- Q3)在給定的提示下,您更喜歡哪個視頻?

下圖3提供了完整的人類評估結果。本文還在圖4中對不同的方法進行了定性比較。附錄F進一步包括了額外的定性比較結果。值得注意的是,與其教師T2V模型的50步生成相比,本文的T2V-Turbo的4步生成受到人類的青睞,表示推理加速了25倍并提升了性能。通過將推理步驟增加到8步,本文可以進一步改善從本文的T2V-Turbo生成的視頻的視覺質量和文本-視頻對齊,事實上,本文的8步生成在所有3個評估指標中都更受人類喜愛,相比本文的4步生成。此外,本文的T2V-Turbo顯著優于其基線VCM,證明了將混合獎勵反饋納入模型訓練的方法的有效性。

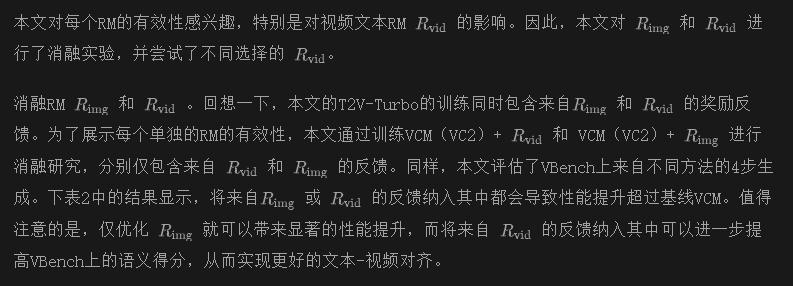

消融實驗

結論 & 限制

在本文中,提出了T2V-Turbo,通過打破VCM的質量瓶頸,實現了快速和高質量的T2V生成。具體來說,本文將混合獎勵反饋集成到教師T2V模型的VCD過程中。從經驗上講,本文通過從VideoCrafter2和ModelScopeT2V中提取T2V-Turbo(VC2)和T2V-Turbo(MS)來說明本文方法的適用性。值得注意的是,本文的兩個T2V-Turbo的4步生成都優于VBench上的SOTA方法,甚至超過了它們的教師T2V模型和專有系統,包括Gen-2和Pika。人類評估進一步證實了這些結果,顯示出本文的T2V-Turbo的4步生成受到人類的青睞,而不是它們的教師的50步DDIM樣本,這代表了超過十倍的推理加速和質量改進。

本文轉自 AI生成未來 ,作者:Jiachen Li 等