萬(wàn)字長(zhǎng)文解析:2024年的機(jī)器消除學(xué)習(xí) 原創(chuàng) 精華

隨著我們今天的機(jī)器學(xué)習(xí)模型變得越來(lái)越龐大,(預(yù))訓(xùn)練集的規(guī)模變得難以理解,人們對(duì)機(jī)器消除學(xué)習(xí)的概念越來(lái)越感興趣,以便在不重新訓(xùn)練模型的情況下刪除不需要的內(nèi)容,例如私人數(shù)據(jù)、過(guò)時(shí)的知識(shí)、受版權(quán)保護(hù)的材料、有害/不安全的內(nèi)容、危險(xiǎn)的功能和錯(cuò)誤信息。

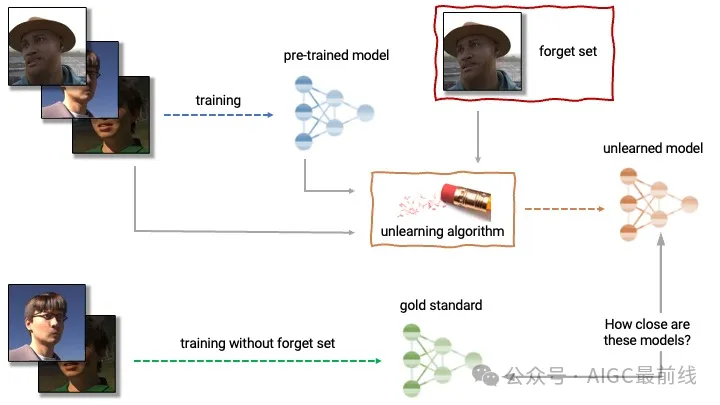

機(jī)器消除學(xué)習(xí)可以廣義地描述為從經(jīng)過(guò)訓(xùn)練的模型中刪除訓(xùn)練數(shù)據(jù)的影響。在其核心中,目標(biāo)模型的消除學(xué)習(xí)旨在產(chǎn)生一個(gè)與重新訓(xùn)練模型等效或至少“行為類(lèi)似”的消除學(xué)習(xí)模型,該重新訓(xùn)練模型是在與目標(biāo)模型相同的數(shù)據(jù)上進(jìn)行訓(xùn)練,但減去需要消除的信息。

上述描述中隱藏著許多問(wèn)題。我們?nèi)绾蚊枋鲂枰男畔ⅲ课覀兪欠窨偸菗碛兄匦掠?xùn)練的準(zhǔn)確模型?如果沒(méi)有,我們?nèi)绾螌?shí)際評(píng)估消除學(xué)習(xí)?我們是否能夠驗(yàn)證和審計(jì)消除學(xué)習(xí)?像人類(lèi)經(jīng)常做的假裝遺忘一樣足夠嗎?消除學(xué)習(xí)是否是正確的解決方案?如果是的話(huà),用于解決什么問(wèn)題?

消除學(xué)習(xí)的精確定義、技術(shù)、保證和度量/評(píng)估將取決于:

- 機(jī)器學(xué)習(xí)任務(wù)(例如二元分類(lèi)或語(yǔ)言建模);

- 需要消除的數(shù)據(jù)(例如一組圖像、新聞文章或制作凝固汽油的知識(shí));

- 消除學(xué)習(xí)算法(例如啟發(fā)式微調(diào)與刪除模型組件);

- 消除學(xué)習(xí)的目標(biāo)(例如用戶(hù)隱私或有害內(nèi)容的移除)。

1. 歷史背景與進(jìn)行消除學(xué)習(xí)的動(dòng)機(jī)

人們對(duì)消除學(xué)習(xí)問(wèn)題已經(jīng)思考了一段時(shí)間了。最初的研究探索主要是受到歐盟《通用數(shù)據(jù)保護(hù)條例》(GDPR)第17條的驅(qū)動(dòng)(通常稱(chēng)為“被遺忘權(quán)”),該條例始于2014年。被遺忘權(quán)基本上是指用戶(hù)有權(quán)要求服務(wù)提供商(例如刪除您的Gmail帳戶(hù))刪除其數(shù)據(jù)。

被遺忘權(quán)是出于善意的。當(dāng)服務(wù)提供商以結(jié)構(gòu)化方式存儲(chǔ)用戶(hù)數(shù)據(jù)時(shí),這也是非常可行的,就像谷歌根據(jù)被遺忘權(quán)請(qǐng)求從其索引中刪除了一些鏈接一樣。

然而,被遺忘權(quán)在提出時(shí)并沒(méi)有真正考慮到機(jī)器學(xué)習(xí)。在2014年,政策制定者不會(huì)預(yù)測(cè)到深度學(xué)習(xí)將成為數(shù)據(jù)和計(jì)算的巨大混合體,而解析和解釋這個(gè)混合體會(huì)變得困難。從此以續(xù)的研究表明,從機(jī)器學(xué)習(xí)模型中刪除數(shù)據(jù)的難度,進(jìn)一步推動(dòng)了所謂的“數(shù)據(jù)刪除”和“機(jī)器消除學(xué)習(xí)”的研究。

十年后的2024年,用戶(hù)隱私不再是消除學(xué)習(xí)的唯一動(dòng)機(jī)。我們已經(jīng)從對(duì)面部圖像訓(xùn)練小型卷積網(wǎng)絡(luò)轉(zhuǎn)變?yōu)閷?duì)付費(fèi)、受版權(quán)保護(hù)、有害和其他有害內(nèi)容進(jìn)行巨型語(yǔ)言模型訓(xùn)練,這些內(nèi)容我們可能希望從機(jī)器學(xué)習(xí)模型中“抹去” - 有時(shí)僅憑一小部分示例。模型的性質(zhì)也發(fā)生了變化。人們不再使用許多在一個(gè)任務(wù)上表現(xiàn)良好的小型專(zhuān)用模型,而是開(kāi)始使用一個(gè)單一的巨型模型,該模型幾乎了解任何任務(wù)。

目前,研究消除學(xué)習(xí)的動(dòng)機(jī)可以分為兩類(lèi):

- 撤銷(xiāo)訪(fǎng)問(wèn)權(quán)限(考慮消除私人和受版權(quán)保護(hù)的數(shù)據(jù))。在理想的世界中,數(shù)據(jù)應(yīng)該被視為“借用”(可能未經(jīng)許可),因此可以“歸還”,而消除學(xué)習(xí)應(yīng)該使這種撤銷(xiāo)成為可能。

從這個(gè)角度來(lái)看,消除學(xué)習(xí)具有挑戰(zhàn)性。一個(gè)主要困難是,我們對(duì)深度學(xué)習(xí)本身的理解有限,使得訓(xùn)練到模型中的數(shù)據(jù)類(lèi)似于“消耗品”(在消耗后不能簡(jiǎn)單地“退還”)。數(shù)據(jù)也可能是不可替代的(例如聊天記錄),甚至可以被視為具有自身財(cái)務(wù)和控制利益的勞動(dòng)力。另一個(gè)挑戰(zhàn)是撤銷(xiāo)訪(fǎng)問(wèn)權(quán)限可能需要證明消除學(xué)習(xí);正如我們將在接下來(lái)的章節(jié)中探討的,這并非總是可能的。

這些困難表明,也許值得修改《被遺忘權(quán)》等法律,并思考諸如數(shù)據(jù)市場(chǎng)之類(lèi)的替代方案,在這些方案中,數(shù)據(jù)所有者能夠得到適當(dāng)?shù)难a(bǔ)償,因此他們就不會(huì)首先要求進(jìn)行消除學(xué)習(xí)。舉例來(lái)說(shuō),假設(shè)鮑勃吃了愛(ài)麗絲的乳酪蛋糕(數(shù)據(jù)),愛(ài)麗絲寧愿鮑勃付款或歸還等值物品(補(bǔ)償),而不是鮑勃恢復(fù)到吃之前的狀態(tài)(消除學(xué)習(xí))。

在實(shí)踐中,實(shí)現(xiàn)撤銷(xiāo)訪(fǎng)問(wèn)權(quán)限的一種方法是通過(guò)對(duì)基礎(chǔ)模型進(jìn)行某種形式的定期重新訓(xùn)練。許多模型提供商已經(jīng)在做這個(gè),以保持他們的模型具有競(jìng)爭(zhēng)力和最新性。例如,OpenAI可以收集一系列消除學(xué)習(xí)請(qǐng)求,并在每年的重新訓(xùn)練中批量滿(mǎn)足這些請(qǐng)求(或者根據(jù)《被遺忘權(quán)》規(guī)定的“不合理延遲”期限來(lái)滿(mǎn)足請(qǐng)求)。更廣泛地說(shuō),這提示了消除學(xué)習(xí)的社會(huì)技術(shù)解決方案:政策制定者可以規(guī)定這種定期重新訓(xùn)練,并設(shè)定經(jīng)濟(jì)可行的截止日期,將成本轉(zhuǎn)嫁給模型所有者。 - 模型修正和編輯(例如毒性、偏見(jiàn)、過(guò)時(shí)/危險(xiǎn)知識(shí)的刪除)。也就是說(shuō),模型是基于一些不可取的內(nèi)容進(jìn)行訓(xùn)練的,我們希望進(jìn)行修正。這與模型編輯的文獻(xiàn)密切相關(guān)。最近提出了“修正性機(jī)器遺忘”的概念,其中遺忘用于糾正不良數(shù)據(jù)的影響,以捕捉這種動(dòng)機(jī)。從這個(gè)角度來(lái)看,遺忘也可以被視為用于AI安全問(wèn)題的訓(xùn)練后風(fēng)險(xiǎn)緩解機(jī)制(在第4節(jié)中進(jìn)一步討論)。

與撤銷(xiāo)訪(fǎng)問(wèn)權(quán)限不同,對(duì)模型進(jìn)行修正時(shí)我們可以更加寬容,因?yàn)檫@種編輯更多是出于欲望,而不是法律所要求的必要性,就像圖像分類(lèi)的模型準(zhǔn)確性或生成文本的毒性一樣(當(dāng)然,這些也可能造成真正的傷害)。在這種情況下,我們不一定需要正式的保證來(lái)使遺忘對(duì)實(shí)際有用;我們有很多例子,人們?cè)敢獠渴鸨徽J(rèn)為“足夠安全”的模型。最近的WMDP基準(zhǔn)測(cè)試對(duì)危險(xiǎn)知識(shí)對(duì)模型進(jìn)行了提問(wèn),是評(píng)估遺忘效果的良好示例。

2. 遺忘的形式

如果我們只是重新訓(xùn)練模型而不包含不需要的數(shù)據(jù),那么遺忘就是微不足道的。然而,我們希望得到更好的結(jié)果,因?yàn)椋?)重新訓(xùn)練可能很昂貴,而且(2)要找出需要從訓(xùn)練數(shù)據(jù)中刪除的內(nèi)容可能需要大量工作——想象一下在萬(wàn)億個(gè)標(biāo)記中找到所有《哈利·波特》的引用。遺忘技術(shù)主要旨在減輕或避免這種重新訓(xùn)練成本,同時(shí)產(chǎn)生相同或相似的結(jié)果。

遺忘的文獻(xiàn)主要可以分為以下幾種形式:

- 精確遺忘

- 通過(guò)差分隱私進(jìn)行“遺忘”

- 經(jīng)驗(yàn)遺忘,其中需要遺忘的數(shù)據(jù)已經(jīng)明確知道(訓(xùn)練示例)

- 經(jīng)驗(yàn)遺忘,其中需要遺忘的數(shù)據(jù)未明確指定(考慮“知識(shí)”)

- 只需要求遺忘?

第2至第4種形式有時(shí)被稱(chēng)為“近似遺忘”,因?yàn)檫z忘的模型近似于重新訓(xùn)練模型的行為。第5種形式非常新穎且有趣,更具體適用于遵循指令的模型。

圖1. 近似遺忘的示意圖。來(lái)源:NeurIPS機(jī)器遺忘挑戰(zhàn)

2.1. 精確遺忘

精確遺忘大致要求未遺忘模型和重新訓(xùn)練后的模型在分布上完全相同;也就是說(shuō),在固定的隨機(jī)性下,它們可以完全相同。

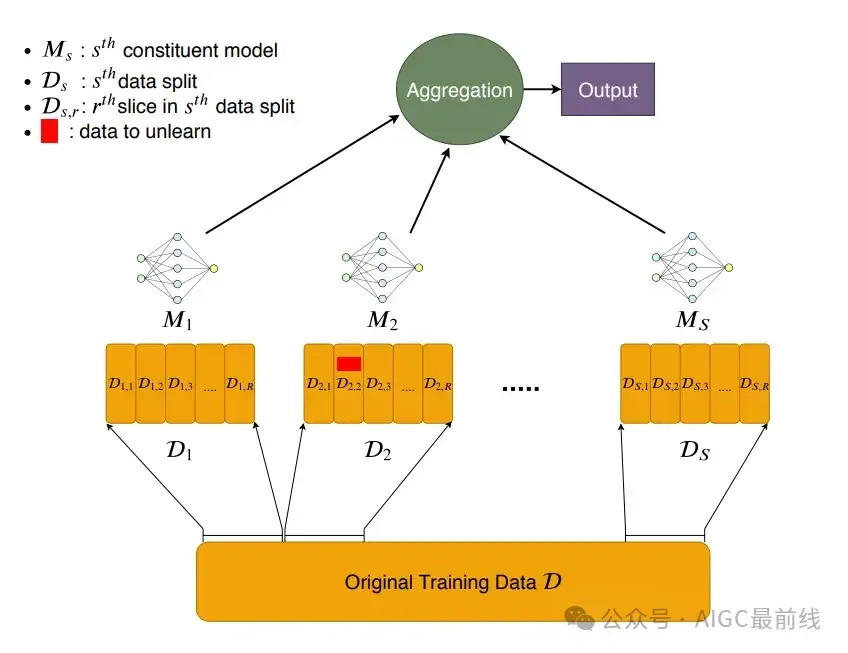

精確遺忘的技術(shù)特點(diǎn)可以追溯到Cao和Yang以及SISA的早期工作。在SISA中,采用了一種非常簡(jiǎn)單的方案,將訓(xùn)練集劃分為N個(gè)非重疊的子集,并為每個(gè)子集訓(xùn)練一個(gè)單獨(dú)的模型。遺忘則涉及重新訓(xùn)練對(duì)應(yīng)的模型,并排除需要遺忘的數(shù)據(jù)點(diǎn)。這樣可以通過(guò)1/N的成本來(lái)減少與普通重新訓(xùn)練相比的開(kāi)銷(xiāo)(如果保留模型檢查點(diǎn),則成本更低)。然后,推斷過(guò)程涉及模型集成1。

圖2. SISA的示意圖:只在數(shù)據(jù)分片上訓(xùn)練模型

更一般地說(shuō),精確遺忘的本質(zhì)是希望學(xué)習(xí)算法中的模塊化組件對(duì)應(yīng)于不同(潛在不重疊)的訓(xùn)練示例集。

精確遺忘有幾個(gè)優(yōu)點(diǎn):

- 算法本身就是證據(jù)。如果我們實(shí)現(xiàn)了類(lèi)似SISA的方法,我們可以從設(shè)計(jì)上知道遺忘的數(shù)據(jù)從未對(duì)其他組件產(chǎn)生過(guò)貢獻(xiàn)。事實(shí)證明,要正式證明模型已經(jīng)遺忘了某些內(nèi)容是相當(dāng)具有挑戰(zhàn)性的,否則會(huì)變得非常混亂。

- 這將遺忘問(wèn)題轉(zhuǎn)化為準(zhǔn)確性/效率問(wèn)題。由于遺忘評(píng)估的混亂和缺乏基準(zhǔn)的問(wèn)題,精確遺忘更容易實(shí)現(xiàn)。

- 設(shè)計(jì)上具有可解釋性。通過(guò)提供學(xué)習(xí)結(jié)構(gòu),我們對(duì)某些數(shù)據(jù)點(diǎn)如何對(duì)性能產(chǎn)生影響有更好的理解。

主要缺點(diǎn)似乎很明顯:大型模型的現(xiàn)代擴(kuò)展定律反對(duì)像SISA中那樣過(guò)分進(jìn)行數(shù)據(jù)和模型分片。或者并非如此嗎?在最近的模型合并文獻(xiàn)中提出了在大型模型背景下重新審視分片的可能性,這表明了在權(quán)重空間合并大型模型的可行性。正如我們將在接下來(lái)的章節(jié)中了解到的,近似遺忘及其在大型模型背景下的評(píng)估的混亂性使精確遺忘非常有吸引力。

2.2. 通過(guò)差分隱私進(jìn)行“遺忘”

這個(gè)研究方向大致上是這樣說(shuō)的:如果模型在有或沒(méi)有特定數(shù)據(jù)點(diǎn)的情況下表現(xiàn)幾乎相同,那么我們就沒(méi)有必要從該數(shù)據(jù)點(diǎn)進(jìn)行遺忘。更廣義地說(shuō),我們要求未遺忘模型和重新訓(xùn)練后的模型在分布上接近。

對(duì)于不熟悉差分隱私(DP)在機(jī)器學(xué)習(xí)中的讀者,DP定義了在不同單個(gè)訓(xùn)練示例的數(shù)據(jù)集上訓(xùn)練的兩個(gè)模型M、M'之間的可量化的不可區(qū)分性保證。經(jīng)典的DP-SGD過(guò)程通過(guò)裁剪每個(gè)示例梯度的L2范數(shù),并向梯度注入一些每個(gè)坐標(biāo)的高斯噪聲來(lái)工作。其思想是噪聲可以掩蓋或模糊任何單個(gè)梯度(示例)的貢獻(xiàn),使得最終的模型對(duì)任何示例都不敏感。通常用(ε,δ)-DP來(lái)表示;噪聲越強(qiáng),標(biāo)量(ε,δ)越小,保護(hù)性越強(qiáng)。

這樣做的直覺(jué)是,如果攻擊者無(wú)法(可靠地)區(qū)分這些模型,那么就好像這個(gè)數(shù)據(jù)點(diǎn)從未被學(xué)習(xí)過(guò),因此就不需要進(jìn)行遺忘。DP可以用來(lái)實(shí)現(xiàn)這種形式的遺忘,但由于遺忘是單向的(我們只關(guān)心數(shù)據(jù)的刪除,而不是添加),DP是一個(gè)嚴(yán)格更強(qiáng)的定義。這種遺忘的概念有時(shí)被稱(chēng)為“(α,β)-遺忘”,其中(α,β)的作用類(lèi)似于(ε,δ),用于衡量分布上的接近程度。

這個(gè)方向上的示例技術(shù)包括:(1)存儲(chǔ)(DP)凸模型的檢查點(diǎn),遺忘是從這些檢查點(diǎn)重新訓(xùn)練的;(2)在前一種技術(shù)的基礎(chǔ)上,使用SISA進(jìn)行自適應(yīng)的遺忘請(qǐng)求(即在觀察到發(fā)布的模型后提出的請(qǐng)求)。

基于差分隱私的遺忘方法的好處在于它提供了某種形式的統(tǒng)計(jì)保證。然而,有一些重要的考慮因素限制了它在大型模型中的適用性:

- 許多這樣的遺忘結(jié)果僅適用于凸模型或損失函數(shù)。

- 什么水平的遺忘((ε,δ)-DP或(α,β)-遺忘的值)是足夠的?由誰(shuí)來(lái)決定?

- 對(duì)于大型模型,當(dāng)前的機(jī)器學(xué)習(xí)系統(tǒng)與類(lèi)似DP的每個(gè)示例的工作負(fù)載不太匹配。內(nèi)存開(kāi)銷(xiāo)也會(huì)成為限制因素。

- 此外,像DP一樣,隨著遺忘請(qǐng)求的增加,保證會(huì)迅速減弱(根據(jù)DP組合定理,最多以O(shè)(√k)的速度下降,其中k是遵循DP組合的請(qǐng)求次數(shù))。

- 類(lèi)似DP的定義默認(rèn)假設(shè)我們對(duì)所有數(shù)據(jù)點(diǎn)都一樣關(guān)心。然而,某些示例更有可能收到遺忘請(qǐng)求,而某些示例根本沒(méi)有對(duì)學(xué)習(xí)產(chǎn)生貢獻(xiàn)。

- 類(lèi)似DP的過(guò)程有時(shí)也可能會(huì)嚴(yán)重?fù)p害模型的準(zhǔn)確性,有時(shí)會(huì)不公平地?fù)p害準(zhǔn)確性。

特別是對(duì)于大型模型,值得區(qū)分取消預(yù)訓(xùn)練數(shù)據(jù)和取消微調(diào)數(shù)據(jù)的情況。后者更容易處理;例如,我們確實(shí)可以對(duì)大型模型進(jìn)行差分隱私微調(diào),但對(duì)于預(yù)訓(xùn)練來(lái)說(shuō)可能不太容易實(shí)現(xiàn)。

2.2.1. 偽造及其對(duì)類(lèi)似差分隱私取消的定義的影響

有時(shí),取消學(xué)習(xí)過(guò)程可能需要外部審計(jì),即我們希望證明取消學(xué)習(xí)程序確實(shí)已經(jīng)發(fā)生。

“偽造”的主要思想是存在兩個(gè)不同的數(shù)據(jù)集,當(dāng)對(duì)其進(jìn)行訓(xùn)練時(shí),會(huì)產(chǎn)生相同的梯度(因此)相同的模型。這在直覺(jué)上是正確的:

- 考慮一下對(duì)一條完美直線(xiàn)上的點(diǎn)進(jìn)行線(xiàn)性回歸;刪除任何一個(gè)點(diǎn)都不會(huì)改變擬合的直線(xiàn);

- 考慮一下小批量梯度下降,用幾個(gè)“偽造”的梯度的總和替換一個(gè)示例梯度會(huì)給出相同的批量梯度。

偽造意味著基于差分隱私的近似取消學(xué)習(xí)可能無(wú)法進(jìn)行審計(jì),即取消學(xué)習(xí)服務(wù)提供者無(wú)法正式證明遺忘集確實(shí)被遺忘。實(shí)際上,即使僅看模型權(quán)重,精確取消學(xué)習(xí)也可能無(wú)法進(jìn)行審計(jì)。

雖然人們可以將此結(jié)果視為理論結(jié)果,但這確實(shí)意味著決策者應(yīng)該仔細(xì)考慮未來(lái)版本的“被遺忘權(quán)”(如果有的話(huà))應(yīng)該是什么樣子,以及類(lèi)似的政策在法律和技術(shù)上是否可執(zhí)行。

的確,什么樣的“審計(jì)”可以是定義和應(yīng)用相關(guān)的。如果審計(jì)員只關(guān)心取消學(xué)習(xí)模型在指定輸入集(例如一組人臉圖像)上的性能表現(xiàn)不佳,那么即使是經(jīng)驗(yàn)性取消學(xué)習(xí)也是“可審計(jì)的”(見(jiàn)下一節(jié))。

2.3. 已知示例空間的經(jīng)驗(yàn)取消學(xué)習(xí)(“示例取消學(xué)習(xí)”)

這一研究方向本質(zhì)上是“訓(xùn)練取消學(xué)習(xí)”或“通過(guò)微調(diào)進(jìn)行取消學(xué)習(xí)”:只需采取更多啟發(fā)式選擇的梯度步驟,將原始模型的行為塑造成我們認(rèn)為重新訓(xùn)練的模型會(huì)做的樣子(同時(shí)還可以選擇重置模型中的某些參數(shù))。它也可以被稱(chēng)為“示例取消學(xué)習(xí)”,因?yàn)橛?xùn)練、保留和遺忘集通常是明確定義的。

NeurIPS 2023機(jī)器取消學(xué)習(xí)挑戰(zhàn)在這個(gè)方向上收集了許多方法。挑戰(zhàn)大致如下進(jìn)行:

- 給定一個(gè)人臉圖像數(shù)據(jù)集,其中訓(xùn)練集有指定的保留/遺忘示例拆分,一個(gè)在全部數(shù)據(jù)上訓(xùn)練的目標(biāo)模型,以及一個(gè)僅在保留集上訓(xùn)練的秘密模型。

- 要求設(shè)計(jì)一個(gè)取消學(xué)習(xí)算法,從目標(biāo)模型中產(chǎn)生“匹配”秘密模型的取消學(xué)習(xí)模型。

- “匹配”或評(píng)估指標(biāo)使用512個(gè)種子的類(lèi)似差分隱私輸出空間相似性:對(duì)于每個(gè)遺忘示例,基于對(duì)手(由組織者提供)的真/假陽(yáng)性率,計(jì)算512個(gè)取消學(xué)習(xí)模型的“經(jīng)驗(yàn)ε”,并在示例間進(jìn)行聚合。

- 所有模型都是一個(gè)小型卷積神經(jīng)網(wǎng)絡(luò)。

為了直觀地了解經(jīng)驗(yàn)取消學(xué)習(xí)的表現(xiàn),而不完全解釋度量標(biāo)準(zhǔn):基準(zhǔn)(重新訓(xùn)練的模型)約為0.19,獲勝的提交約為0.12,基線(xiàn)(遺忘集上的簡(jiǎn)單梯度上升)約為0.06.2。

那么獲勝的思路是什么樣的?大致如下:

- 在遺忘集上進(jìn)行梯度上升;

- 在保留集上進(jìn)行梯度下降(希望災(zāi)難性遺忘能夠處理取消學(xué)習(xí));

- 在遺忘集上進(jìn)行梯度下降,但使用均勻隨機(jī)標(biāo)簽(以“混淆”模型);

- 在保留集上最小化取消學(xué)習(xí)模型和原始模型之間輸出的KL散度(以調(diào)整取消學(xué)習(xí)模型在不相關(guān)數(shù)據(jù)上的性能);

- 重新初始化在保留集和遺忘集上具有相似梯度的權(quán)重,并在保留集上進(jìn)行微調(diào);

- 通過(guò)L1范數(shù)剪枝99%的權(quán)重,并在保留集上進(jìn)行微調(diào);

- 重置前/后k層,并在保留集上進(jìn)行微調(diào);和

- 上述方法的啟發(fā)式/任意組合。

實(shí)際上,盡管這些方法是啟發(fā)式的,但這是當(dāng)前大多數(shù)經(jīng)驗(yàn)取消學(xué)習(xí)算法(尤其是在大型(語(yǔ)言)模型上)所采用的方法。

人們探索經(jīng)驗(yàn)方法是因?yàn)槔碚摴ぞ咄ǔ2磺袑?shí)際;例如,強(qiáng)制差分隱私會(huì)對(duì)準(zhǔn)確性和效率造成過(guò)大的損失,即使對(duì)于計(jì)算能力豐富的GPU也是如此。另一方面,經(jīng)驗(yàn)方法通常快速且易于實(shí)現(xiàn),其效果通常在定性上可見(jiàn)。

經(jīng)驗(yàn)取消學(xué)習(xí)的另一個(gè)關(guān)鍵動(dòng)機(jī)是反事實(shí)的不明確性,特別是在大型語(yǔ)言模型上。在深度學(xué)習(xí)中,我們通常不知道重新訓(xùn)練的模型在未見(jiàn)數(shù)據(jù)上的行為會(huì)如何。如果不是政治家,LLM應(yīng)該行為如何對(duì)待拜登?取消學(xué)習(xí)的圖像分類(lèi)器應(yīng)該對(duì)取消學(xué)習(xí)的圖像給出均勻隨機(jī)的預(yù)測(cè)嗎?它們是否具有泛化能力?還是它們自信地給出錯(cuò)誤的預(yù)測(cè)?這些都是可能的,而且可以由從業(yè)者決定。這也意味著同樣合理的行為可能導(dǎo)致截然不同的度量(例如,取消學(xué)習(xí)模型和重新訓(xùn)練模型之間輸出分布的KL散度),從而使理論保證變得復(fù)雜。

2.4. 未知示例空間的經(jīng)驗(yàn)取消學(xué)習(xí)(“概念/知識(shí)取消學(xué)習(xí)”)

如果訓(xùn)練、保留或遺忘集未被明確定義或根本未被定義,會(huì)怎樣?在訓(xùn)練于互聯(lián)網(wǎng)規(guī)模數(shù)據(jù)的基礎(chǔ)模型中,我們可能會(huì)收到取消學(xué)習(xí)一個(gè)“概念”、“事實(shí)”或一段“知識(shí)”的請(qǐng)求,而這些請(qǐng)求很難與一組示例相對(duì)應(yīng)。術(shù)語(yǔ)“模型編輯”、“概念編輯”、“模型手術(shù)”和“知識(shí)取消學(xué)習(xí)”與這種取消學(xué)習(xí)的概念密切相關(guān)。

取消學(xué)習(xí)請(qǐng)求的不明確性意味著我們現(xiàn)在必須處理“取消學(xué)習(xí)范圍”(或“編輯范圍”)和“蘊(yùn)含”的概念。也就是說(shuō),取消學(xué)習(xí)請(qǐng)求可能提供規(guī)范性示例來(lái)指示要取消學(xué)習(xí)的內(nèi)容,但相同的信息可能以許多不同形式存在于(預(yù))訓(xùn)練集中,并具有許多不同的下游影響,因此僅僅在這些示例上實(shí)現(xiàn)取消學(xué)習(xí),即使是完全實(shí)現(xiàn),也是不夠的。

例如:

- 關(guān)聯(lián)“拜登是美國(guó)總統(tǒng)”分散在各種形式的文本中,包括新聞文章、書(shū)籍、非正式的短信,或者甚至是博客文章。我們能取消學(xué)習(xí)所有的出現(xiàn)嗎?此外,取消學(xué)習(xí)喬·拜登是否意味著取消學(xué)習(xí)拜登貓的顏色?

- 藝術(shù)家可能會(huì)要求通過(guò)提供藝術(shù)樣本來(lái)取消學(xué)習(xí)藝術(shù)風(fēng)格,但他們無(wú)法收集到互聯(lián)網(wǎng)上的所有內(nèi)容及其衍生作品。

- 《紐約時(shí)報(bào)》可能會(huì)要求取消學(xué)習(xí)新聞文章,但他們無(wú)法列舉這些文章的引用和二次轉(zhuǎn)載。

這種模糊性還表明,從大型模型中取消學(xué)習(xí)預(yù)訓(xùn)練數(shù)據(jù)可能是經(jīng)驗(yàn)性的必要條件:如果我們無(wú)法明確指定在數(shù)萬(wàn)億個(gè)標(biāo)記中取消學(xué)習(xí)什么(以及不取消學(xué)習(xí)什么),并在不同實(shí)體之間建立清晰的信息邊界,那么很難獲得形式上的保證。實(shí)現(xiàn)經(jīng)驗(yàn)性取消學(xué)習(xí)的一個(gè)有趣含義是取消學(xué)習(xí)本身可以被取消學(xué)習(xí)。

那么,對(duì)于取消學(xué)習(xí)請(qǐng)求不明確的情況,現(xiàn)有的工作是如何處理的呢?大多數(shù)技術(shù)與之前或多或少相同,只是現(xiàn)在我們還需要找到用于微調(diào)的示例。例如,嘗試取消學(xué)習(xí)《哈利·波特》系列就涉及要求GPT-4提供合理的替代文本完成(例如,波特先生學(xué)習(xí)烘焙而不是魔法);而嘗試取消學(xué)習(xí)有害行為則涉及收集仇恨言論的示例。

另一組技術(shù)涉及將所需行為(或其相反)訓(xùn)練到任務(wù)/控制向量中,并利用大型模型進(jìn)行權(quán)重空間合并或激活調(diào)整的能力。上述方法的基本思路或多或少相同,然而,獲取這些編輯向量涉及(啟發(fā)式地)設(shè)計(jì)梯度的選擇以及在哪些數(shù)據(jù)上應(yīng)用它們。也可以將取消學(xué)習(xí)問(wèn)題框架化為一個(gè)對(duì)齊問(wèn)題,并使用類(lèi)似DPO的目標(biāo)應(yīng)用于遺忘示例。

2.5. 只是請(qǐng)求取消學(xué)習(xí)嗎?

事實(shí)證明,像GPT-4這樣的強(qiáng)大、遵循指令的語(yǔ)言模型是足夠聰明的,可以假裝取消學(xué)習(xí)。這意味著通過(guò)構(gòu)建提示來(lái)誘導(dǎo)(足夠)安全的行為,以實(shí)現(xiàn)目標(biāo)的取消學(xué)習(xí)應(yīng)用。

這是一種有趣的方法,因?yàn)闆](méi)有涉及任何梯度(從系統(tǒng)的角度來(lái)看,這是一個(gè)巨大的優(yōu)勢(shì)),直觀上最終的結(jié)果可能與現(xiàn)有的經(jīng)驗(yàn)性取消學(xué)習(xí)技術(shù)一樣好。在不同的提示方式中,過(guò)去的研究探索了以下兩個(gè)方向。

直接請(qǐng)求假裝取消學(xué)習(xí)。我們可以在系統(tǒng)提示中要求,比如,假裝不知道哈利·波特是誰(shuí)。從設(shè)計(jì)上來(lái)說(shuō),這對(duì)于常見(jiàn)的實(shí)體、事實(shí)、知識(shí)或行為(例如像特朗普那樣說(shuō)話(huà)的能力)效果最好,因?yàn)長(zhǎng)LM需要充分了解它才能假裝不了解。另一方面,現(xiàn)在假設(shè)我們想要取消學(xué)習(xí)一個(gè)不知名人物的地址;預(yù)訓(xùn)練集非常龐大,我們懷疑它是訓(xùn)練數(shù)據(jù)的一部分。我們現(xiàn)在面臨的是一種斯特萊桑效應(yīng)的變體:是否值得要求模型通過(guò)準(zhǔn)確描述上下文來(lái)假裝取消學(xué)習(xí),并隨后冒險(xiǎn)在后續(xù)的模型回復(fù)中泄露它?

少樣本提示或“上下文取消學(xué)習(xí)”。假設(shè)我們現(xiàn)在有一組明確定義的遺忘示例及其相應(yīng)的標(biāo)簽。我們可以翻轉(zhuǎn)它們的標(biāo)簽并將它們放入提示中,連同更多具有正確標(biāo)簽的保留示例,直覺(jué)上模型會(huì)將這些錯(cuò)誤標(biāo)記的遺忘示例視為真實(shí)并相應(yīng)地行動(dòng),就像可以通過(guò)這種方式對(duì)模型進(jìn)行越獄一樣。的確,當(dāng)遺忘示例和對(duì)應(yīng)的反事實(shí)標(biāo)簽明確定義且(在某種程度上)有限時(shí),這種方法效果最好。通過(guò)列舉很多示例,它可能適用于事實(shí)關(guān)聯(lián)(例如,巴黎是法國(guó)的首都),但不太可能適用于取消學(xué)習(xí)有害行為(其中可能的輸出空間更大)。

從某種意義上說(shuō),這些方法是互補(bǔ)的,因?yàn)樗鼈冞m用于不同類(lèi)型的取消學(xué)習(xí)請(qǐng)求。

更廣泛地說(shuō),我們可以想象一個(gè)通過(guò)提示進(jìn)行取消學(xué)習(xí)的封裝式LLM系統(tǒng),其中:

- 只公開(kāi)輸入和輸出接口(例如ChatGPT);

- 不同的強(qiáng)大LLM實(shí)例負(fù)責(zé)準(zhǔn)確模仿所需取消學(xué)習(xí)行為的不同部分(例如,一個(gè)LLM實(shí)例專(zhuān)門(mén)處理通用的問(wèn)答形式,而另一個(gè)處理序列完成);

- 一個(gè)編排器/路由器LLM根據(jù)輸入決定調(diào)用哪個(gè)取消學(xué)習(xí)工作實(shí)例;和

- 一個(gè)作曲家/總結(jié)器LLM起草符合所需取消學(xué)習(xí)行為的最終輸出;它還可以應(yīng)用一些輸出過(guò)濾。

一些讀者可能會(huì)對(duì)基于提示的這種技術(shù)的啟發(fā)性質(zhì)表示不滿(mǎn),認(rèn)為沒(méi)有證據(jù)證明取消學(xué)習(xí)。我們應(yīng)該記住,基于微調(diào)的經(jīng)驗(yàn)性取消學(xué)習(xí),正如最近的方法所做的那樣,也許并沒(méi)有根本區(qū)別。最終歸結(jié)為以下幾個(gè)問(wèn)題:

- 微調(diào)或提示哪個(gè)可以更好地引導(dǎo)模型行為?

- 它們中哪個(gè)更不容受攻擊(暴露的面更少和/或?qū)τ趯?duì)手來(lái)說(shuō)需要更多的努力來(lái)恢復(fù)取消學(xué)習(xí))?

這兩個(gè)問(wèn)題都指向基于微調(diào)的取消學(xué)習(xí),但這在很大程度上還有待討論,并且隨著我們獲得更強(qiáng)大的模型和更好的防御機(jī)制,這種情況可能會(huì)發(fā)生變化。例如,最近提出的指令層次結(jié)構(gòu)的概念可能有助于使這樣的LLM系統(tǒng)對(duì)惡意提示更不容易受到攻擊。

值得注意的是,人類(lèi)實(shí)際上也不真正“取消學(xué)習(xí)”某個(gè)知識(shí)。事實(shí)上,通過(guò)聲稱(chēng)已經(jīng)取消學(xué)習(xí)某件事,我們通常已經(jīng):(1)充分學(xué)習(xí)它,以能夠宣稱(chēng)我們已經(jīng)取消學(xué)習(xí)它,并且(2)有意決定不再將這個(gè)知識(shí)應(yīng)用于我們當(dāng)前的世界狀態(tài),因?yàn)檎J(rèn)為它不再有用/有益。有誰(shuí)能說(shuō)取消學(xué)習(xí)對(duì)于LLM來(lái)說(shuō)應(yīng)該有任何不同呢?

3. 評(píng)估取消學(xué)習(xí)

取消學(xué)習(xí)由于許多原因而變得混亂。但關(guān)于取消學(xué)習(xí)的最大問(wèn)題之一就是評(píng)估。總體而言,我們關(guān)心以下三個(gè)方面:

- 效率:與重新訓(xùn)練相比,算法有多快?

- 模型效用:是否損害了對(duì)保留數(shù)據(jù)或正交任務(wù)的性能?

- 遺忘質(zhì)量:實(shí)際上有多少“遺忘數(shù)據(jù)”被取消學(xué)習(xí)了?我們能多快地恢復(fù)(重新學(xué)習(xí))它們?

評(píng)估效率和模型效用相對(duì)較容易;我們?cè)谟?xùn)練過(guò)程中已經(jīng)對(duì)它們進(jìn)行了衡量。關(guān)鍵挑戰(zhàn)在于理解遺忘質(zhì)量。

如果遺忘示例是指定的,這也感覺(jué)很容易。例如,直觀地說(shuō),取消學(xué)習(xí)特定的圖像類(lèi)別意味著在該類(lèi)別的圖像上達(dá)到接近機(jī)會(huì)準(zhǔn)確率。評(píng)估協(xié)議可以測(cè)量準(zhǔn)確性(在保留集和測(cè)試集上高,在遺忘集上低)或遺忘文本序列的可能性(越低越好)。

然而,這些直觀的指標(biāo)選擇未必是基于原則的或適用于LLM中的知識(shí)取消學(xué)習(xí)等設(shè)置。期望模型在未學(xué)習(xí)的圖像上表現(xiàn)不佳忽略了泛化能力,因?yàn)檫z忘示例很可能是某些保留示例的插值/重復(fù)。而且我們并不總是擁有從未見(jiàn)過(guò)遺忘示例的神諭模型;例如,我們是否有從未閱讀過(guò)《紐約時(shí)報(bào)》文章的LLM?

對(duì)LLM上取消學(xué)習(xí)的評(píng)估更多是一門(mén)藝術(shù)而非科學(xué)。例如,為了取消學(xué)習(xí)“哈利·波特”作為一個(gè)實(shí)體,人們會(huì)可視化標(biāo)記概率如何衰減與哈利·波特相關(guān)的文本,然后其他人會(huì)展示模型仍然能夠回答哈利·波特的問(wèn)答題。關(guān)鍵問(wèn)題在于缺乏數(shù)據(jù)集和用于取消學(xué)習(xí)評(píng)估的基準(zhǔn)測(cè)試的嚴(yán)重不足。

然而自2024年以來(lái),基準(zhǔn)測(cè)試的危機(jī)有所改善。有兩個(gè)值得關(guān)注的最近項(xiàng)目:

- TOFU:一個(gè)專(zhuān)注于取消學(xué)習(xí)個(gè)體(特別是書(shū)籍作者)的基準(zhǔn)測(cè)試。它涉及要求GPT-4創(chuàng)建虛假的作者簡(jiǎn)介,對(duì)它們進(jìn)行微調(diào),并使用微調(diào)后的模型作為取消學(xué)習(xí)目標(biāo)模型,將原始LLM作為神諭的“重新訓(xùn)練”模型。它提供了關(guān)于生成的虛假作者的問(wèn)答對(duì),以評(píng)估模型在應(yīng)用取消學(xué)習(xí)之前/之后對(duì)這些作者的了解。

- WMDP:一個(gè)專(zhuān)注于取消學(xué)習(xí)危險(xiǎn)知識(shí)的基準(zhǔn)測(cè)試,特別是生物安全、網(wǎng)絡(luò)安全和化學(xué)安全。它提供了4000多個(gè)多項(xiàng)選擇問(wèn)題,以測(cè)試模型在應(yīng)用取消學(xué)習(xí)之前/之后對(duì)危險(xiǎn)知識(shí)的了解。作為報(bào)告的一部分,作者還提出了基于激活指導(dǎo)的經(jīng)驗(yàn)性取消學(xué)習(xí)方法。

TOFU和WMDP不同于先前的取消學(xué)習(xí)評(píng)估,它們都是“高級(jí)”評(píng)估,關(guān)注模型的知識(shí)保留和理解,而不是像遺忘序列困惑度這樣的示例級(jí)指標(biāo)。對(duì)于LLM來(lái)說(shuō),這一點(diǎn)尤為重要,因?yàn)樗鼈兺ǔD軌蛞栽S多不同的方式給出相同的答案,而示例級(jí)指標(biāo)無(wú)法捕捉到這一點(diǎn)。

展望未來(lái),像TOFU和WMDP這樣的面向應(yīng)用的取消學(xué)習(xí)基準(zhǔn)測(cè)試,相對(duì)于類(lèi)似NeurIPS取消學(xué)習(xí)挑戰(zhàn)的基于實(shí)例的評(píng)估,對(duì)于評(píng)估基礎(chǔ)模型更有用,這是由于這些模型的多任務(wù)性質(zhì)和每個(gè)任務(wù)的“取消學(xué)習(xí)成功”的不同定義。確實(shí),可以想象針對(duì)取消學(xué)習(xí)個(gè)人識(shí)別信息(PII)、受版權(quán)保護(hù)的內(nèi)容、語(yǔ)音毒性甚至模型后門(mén)等的單獨(dú)基準(zhǔn)測(cè)試。例如,對(duì)于取消學(xué)習(xí)PII,我們可能關(guān)心準(zhǔn)確記憶的標(biāo)記,而對(duì)于毒性,取消學(xué)習(xí)指標(biāo)將是由ToxiGen分類(lèi)器報(bào)告的分?jǐn)?shù)。

4. 取消學(xué)習(xí)的實(shí)踐、陷阱和前景

取消學(xué)習(xí)是一個(gè)棘手的問(wèn)題,尤其是在基礎(chǔ)模型的背景下。在我們積極研究如何使取消學(xué)習(xí)在實(shí)踐中起作用的同時(shí),對(duì)取消學(xué)習(xí)的真正含義以及它是否是我們當(dāng)前問(wèn)題的正確解決方案進(jìn)行一些思考是有幫助的。

4.1. 取消學(xué)習(xí)難度的譜系

直觀地說(shuō),取消學(xué)習(xí)LLM中罕見(jiàn)的文本出現(xiàn),比如Palo Alto的車(chē)禍,應(yīng)該比取消學(xué)習(xí)頻繁出現(xiàn)的情況,比如“拜登是美國(guó)總統(tǒng)”容易,而后者又比取消學(xué)習(xí)“太陽(yáng)每天升起”這樣的基本事實(shí)更容易。

取消學(xué)習(xí)難度的譜系出現(xiàn)是因?yàn)殡S著一個(gè)知識(shí)變得更基礎(chǔ),它與其他知識(shí)的關(guān)聯(lián)會(huì)更多(例如作為前提或推論),取消學(xué)習(xí)的范圍也會(huì)呈指數(shù)級(jí)增長(zhǎng)。事實(shí)上,一個(gè)知識(shí)可以在模型的隱式知識(shí)圖中嵌入得如此之深,以至于不可能取消學(xué)習(xí)它而不引入矛盾并損害模型的效用。

這種直覺(jué)意味著某些取消學(xué)習(xí)請(qǐng)求要么更難,要么根本無(wú)法滿(mǎn)足(任何嘗試都注定有缺陷)。確實(shí),人類(lèi)的經(jīng)驗(yàn)形成了他們后續(xù)行動(dòng)和世界模型的基礎(chǔ);對(duì)于人類(lèi)能以何種能力取消學(xué)習(xí)他們形成的過(guò)去記憶,這是主觀、模糊和哲學(xué)性的。

更廣泛地說(shuō),取消學(xué)習(xí)難度的問(wèn)題適用于所有類(lèi)型的模型,且原因不限于嵌入于知識(shí)/蘊(yùn)涵圖中。讓我們考慮取消學(xué)習(xí)難度的另外兩個(gè)看似矛盾的直覺(jué):

- 后期訓(xùn)練中出現(xiàn)的示例應(yīng)該容易取消學(xué)習(xí),因?yàn)槟P驮跈?quán)重空間中只會(huì)略微移動(dòng)(例如由于衰減的學(xué)習(xí)率),可以簡(jiǎn)單地恢復(fù)梯度或返回到先前的檢查點(diǎn)(如果有存儲(chǔ))。相比之下,早期出現(xiàn)的示例會(huì)被后來(lái)的示例“建立”(以課程學(xué)習(xí)的意義),使它們更難取消學(xué)習(xí)。

- 后期出現(xiàn)的示例應(yīng)該更難取消學(xué)習(xí),因?yàn)樵缙诔霈F(xiàn)的示例會(huì)在訓(xùn)練過(guò)程中逐漸(或?yàn)?zāi)難性地)被遺忘;對(duì)于LLM而言,這可能特別真實(shí)。

無(wú)法解決這些直覺(jué)之間的矛盾將表明在記憶/遺忘、示例重要性(在數(shù)據(jù)選擇和核心集方面的意義)、學(xué)習(xí)難度(在預(yù)測(cè)翻轉(zhuǎn)的意義上)和取消學(xué)習(xí)難度之間的相互作用仍不清楚。

以下是一些有趣的研究問(wèn)題:

- 取消學(xué)習(xí)“易”數(shù)據(jù)(例如地方新聞事件)和“難”數(shù)據(jù)(例如貓有四條腿)之間是否存在定性/基本的差異?

- 如果存在取消學(xué)習(xí)難度的譜系,是否存在一個(gè)閾值來(lái)區(qū)分什么是“容易”和“困難”,從而確定哪些是不可取消學(xué)習(xí)的或不應(yīng)取消學(xué)習(xí)的?是否存在或可以訓(xùn)練這樣一個(gè)神諭分類(lèi)器?人類(lèi)能否判斷?

- 這與影響函數(shù)和數(shù)據(jù)歸因有何關(guān)系?如果某個(gè)特定知識(shí)(如其在模型輸出中的體現(xiàn))可以歸因于訓(xùn)練數(shù)據(jù)的較大部分,那么是否會(huì)使取消學(xué)習(xí)變得更難?

- 我們能夠評(píng)估取消學(xué)習(xí)某個(gè)內(nèi)容的難度有多大嗎?

4.2. 版權(quán)保護(hù)

表面上看,取消學(xué)習(xí)似乎是解決版權(quán)保護(hù)的一個(gè)有前途的解決方案:如果模型侵犯了某些內(nèi)容的版權(quán),我們可以嘗試取消學(xué)習(xí)這些內(nèi)容。可以想象,要通過(guò)取消學(xué)習(xí)來(lái)解決版權(quán)侵權(quán)問(wèn)題,可能需要可證明和準(zhǔn)確的取消學(xué)習(xí)(可能是足夠的);另一方面,近似取消學(xué)習(xí),沒(méi)有保證且可能被攻擊,顯然是不夠的,也可能是不必要的。

然而,在實(shí)踐中,由于當(dāng)前取消學(xué)習(xí)方法的可行性受到質(zhì)疑以及AI與版權(quán)交叉領(lǐng)域的法律環(huán)境不明確,存在著更多的細(xì)微之處。由于我不是法律專(zhuān)家(顯然,本節(jié)的內(nèi)容不構(gòu)成法律建議),我們將主要關(guān)注提出問(wèn)題。核心問(wèn)題似乎是:取消學(xué)習(xí)是否是版權(quán)保護(hù)的正確解決方案?

回想一下,公平使用原則允許有限地使用受版權(quán)保護(hù)的材料,前提是滿(mǎn)足四個(gè)因素:(1)使用的目的和性質(zhì)("創(chuàng)造性"),(2)受版權(quán)保護(hù)作品的性質(zhì),(3)使用的數(shù)量和重要性,以及(4)對(duì)作品價(jià)值的影響。如果模型中使用的受版權(quán)保護(hù)內(nèi)容符合公平使用原則,那么從模型中取消學(xué)習(xí)這些內(nèi)容是不必要的。

假設(shè)模型是在某些受版權(quán)保護(hù)的內(nèi)容上進(jìn)行訓(xùn)練的,并且存在侵犯版權(quán)的風(fēng)險(xiǎn),就像New York Times v. OpenAI案件中的情況一樣。OpenAI是否應(yīng)該在ChatGPT上投入(經(jīng)驗(yàn)性的)取消學(xué)習(xí)算法?還是應(yīng)該專(zhuān)注于公平使用原則的"創(chuàng)造性"軸,并投入部署經(jīng)驗(yàn)性的約束措施,如提示、內(nèi)容管理和定制對(duì)齊,以防止模型重復(fù)訓(xùn)練數(shù)據(jù)?實(shí)踐中似乎更多是采用后者。

更廣泛地說(shuō),還可能存在經(jīng)濟(jì)解決版權(quán)侵權(quán)問(wèn)題的替代方案。例如,模型所有者可以提供準(zhǔn)確的取消學(xué)習(xí)服務(wù)(例如定期重新訓(xùn)練),同時(shí)提供對(duì)版權(quán)侵權(quán)進(jìn)行賠償?shù)谋U希拖馩penAI的"版權(quán)保護(hù)"一樣。人們還開(kāi)始探索如何使用Shapley值為受版權(quán)保護(hù)的數(shù)據(jù)定價(jià)。總的來(lái)說(shuō),目前還不清楚取消學(xué)習(xí)在解決與版權(quán)相關(guān)的問(wèn)題中將發(fā)揮多大的作用(如果有)。準(zhǔn)確的取消學(xué)習(xí)(擴(kuò)展到基于檢索的系統(tǒng),見(jiàn)下一節(jié))確實(shí)有潛力,因?yàn)閯h除是干凈且可證明的,但似乎首先需要建立具有法律約束力的審計(jì)程序/機(jī)制。

4.3. 基于檢索的AI系統(tǒng)

一個(gè)明顯的取消學(xué)習(xí)替代方案是根本不進(jìn)行學(xué)習(xí)。對(duì)于LLM來(lái)說(shuō),這種方式可能是將可能收到取消學(xué)習(xí)請(qǐng)求的所有預(yù)訓(xùn)練集內(nèi)容(例如,紐約時(shí)報(bào)的文章)放入外部數(shù)據(jù)/向量存儲(chǔ)。在推理過(guò)程中,所有與這些內(nèi)容相關(guān)的問(wèn)題將通過(guò)RAG(Retrieval-Augmented Generation)進(jìn)行回答,任何取消學(xué)習(xí)請(qǐng)求都可以通過(guò)從數(shù)據(jù)庫(kù)中刪除數(shù)據(jù)來(lái)輕松滿(mǎn)足。Min等人證明了這種方法在最終困惑度方面可以與(但不完全匹配)訓(xùn)練基線(xiàn)相競(jìng)爭(zhēng)。

基于檢索的解決方案很有前途,因?yàn)榛A(chǔ)模型在推理上的能力越來(lái)越強(qiáng)。然而,在將檢索系統(tǒng)作為取消學(xué)習(xí)的不加思考的解決方案之前,需要考慮以下幾點(diǎn):

- 從預(yù)訓(xùn)練語(yǔ)料庫(kù)中刪除受保護(hù)內(nèi)容可能是一個(gè)難以解決的去重問(wèn)題。與去除數(shù)據(jù)污染一樣,我們?nèi)绾未_保受保護(hù)內(nèi)容的改寫(xiě)、引用/引證或其他改編被刪除?

- 如果要取消學(xué)習(xí)的數(shù)據(jù)無(wú)法檢索怎么辦?今天,我們對(duì)模型進(jìn)行了許多非文檔或知識(shí)項(xiàng)的微調(diào);例如,尚不清楚人類(lèi)偏好和期望行為(例如,寫(xiě)作簡(jiǎn)潔性)是否可以從數(shù)據(jù)庫(kù)中"檢索"出來(lái)。

- 將內(nèi)容放入上下文中可能會(huì)開(kāi)放新的攻擊面。許多基于RAG的LLM方法通過(guò)將相關(guān)內(nèi)容放入上下文中,并要求模型對(duì)其進(jìn)行推理。將受保護(hù)數(shù)據(jù)放入上下文意味著它們現(xiàn)在更容易受到數(shù)據(jù)提取的影響(簡(jiǎn)單的提示攻擊可能仍然有效)。

- 檢索和訓(xùn)練之間的效用差距。雖然有證據(jù)表明基于檢索的解決方案可以與競(jìng)爭(zhēng)的訓(xùn)練解決方案相媲美,但并沒(méi)有普遍共識(shí)認(rèn)為僅依靠檢索就可以取代微調(diào)工作負(fù)載;事實(shí)上,它們可以是互補(bǔ)的。更廣泛地說(shuō),如果不可取消學(xué)習(xí)的數(shù)據(jù)空間太大,以至于如果所有數(shù)據(jù)都存儲(chǔ)在外部存儲(chǔ)中,基礎(chǔ)模型將不再那么有用,那該怎么辦?

4.4. AI安全性

隨著模型變得更加強(qiáng)大并被賦予代理能力,取消學(xué)習(xí)在AI安全性方面成為一個(gè)具體的應(yīng)用領(lǐng)域,正在引起人們的關(guān)注。

粗略地說(shuō),安全性問(wèn)題源于模型的知識(shí)(例如,制作凝固汽油的配方)、行為(例如,展示偏見(jiàn))和能力(例如,黑客攻擊網(wǎng)站)。通過(guò)檢查當(dāng)前的AI系統(tǒng)并推演未來(lái),我們可以想象以下例子來(lái)應(yīng)用取消學(xué)習(xí)并提高AI安全性:

- 刪除危險(xiǎn)知識(shí),例如WMDP基準(zhǔn)測(cè)試中的情況;

- 刪除模型中的污染和后門(mén),其中模型對(duì)對(duì)手植入的輸入觸發(fā)器做出反應(yīng);

- 刪除操縱行為,例如進(jìn)行不道德的說(shuō)服或欺騙的能力;

- 消除偏見(jiàn)和有害性;甚至消除追求權(quán)力的傾向。

對(duì)于以安全為導(dǎo)向的應(yīng)用,值得注意的是,取消學(xué)習(xí)應(yīng)被視為訓(xùn)練后的風(fēng)險(xiǎn)緩解和防御機(jī)制,與現(xiàn)有的工具(如對(duì)齊微調(diào)和內(nèi)容過(guò)濾器)一起使用。與其他工具相比,我們應(yīng)該通過(guò)與工具箱中其他工具(例如,取消學(xué)習(xí)比內(nèi)容過(guò)濾器更具適應(yīng)性但更昂貴)的權(quán)衡來(lái)看待取消學(xué)習(xí),而不是因?yàn)榭赡苋狈ΡWC和效果而將其拋在一邊。

譯自(有刪改):https://ai.stanford.edu/~kzliu/blog/unlearning

本文轉(zhuǎn)載自公眾號(hào)AIGC最前線(xiàn)