全新神經(jīng)網(wǎng)絡架構(gòu)KAN一夜爆火!200參數(shù)頂30萬,MIT華人一作,輕松復現(xiàn)Nature封面AI數(shù)學研究

一種全新的神經(jīng)網(wǎng)絡架構(gòu)KAN,誕生了!

?

與傳統(tǒng)的MLP架構(gòu)截然不同,且能用更少的參數(shù)在數(shù)學、物理問題上取得更高精度。

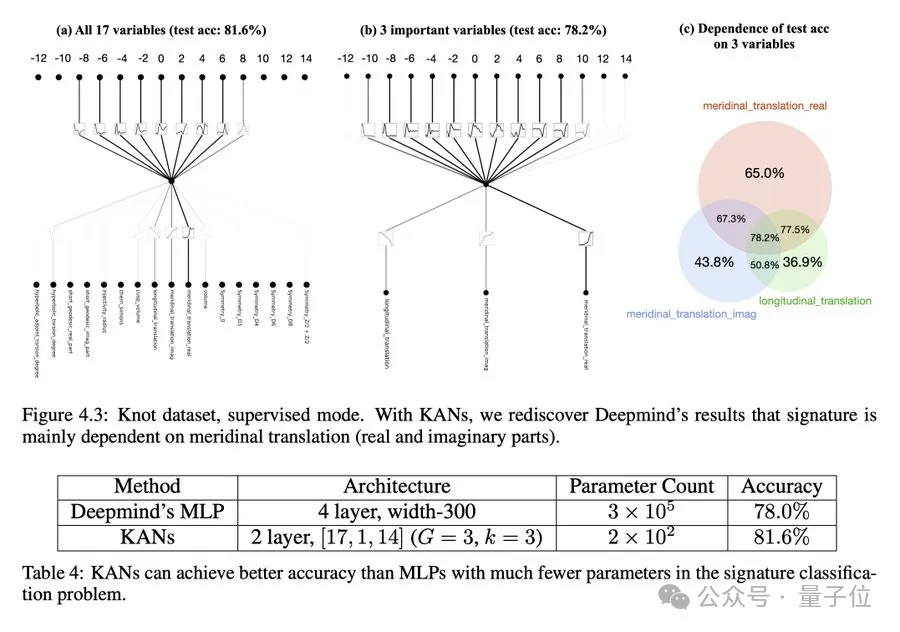

比如,200個參數(shù)的KANs,就能復現(xiàn)DeepMind用30萬參數(shù)的MLPs發(fā)現(xiàn)數(shù)學定理研究。

不僅準確性更高,并且還發(fā)現(xiàn)了新的公式。要知道后者可是登上Nature封面的研究啊~

在函數(shù)擬合、偏微分方程求解,甚至處理凝聚態(tài)物理方面的任務都比MLP效果要好。

而在大模型問題的解決上,KAN天然就能規(guī)避掉災難性遺忘問題,并且注入人類的習慣偏差或領(lǐng)域知識非常容易。

來自MIT、加州理工學院、東北大學等團隊的研究一出,瞬間引爆一整個科技圈:Yes We KAN!

甚至直接引出關(guān)于能否替代掉Transformer的MLP層的探討,有人已經(jīng)準備開始嘗試……

有網(wǎng)友表示:這看起來像是機器學習的下一步。

讓機器學習每個特定神經(jīng)元的最佳激活,而不是由我們?nèi)祟悰Q定使用什么激活函數(shù)。

還有人表示:可能正處于某些歷史發(fā)展的中間。

GitHub上也已經(jīng)開源,也就短短兩三天時間就收獲1.1kStar。

對MLP“進行一個簡單的更改”

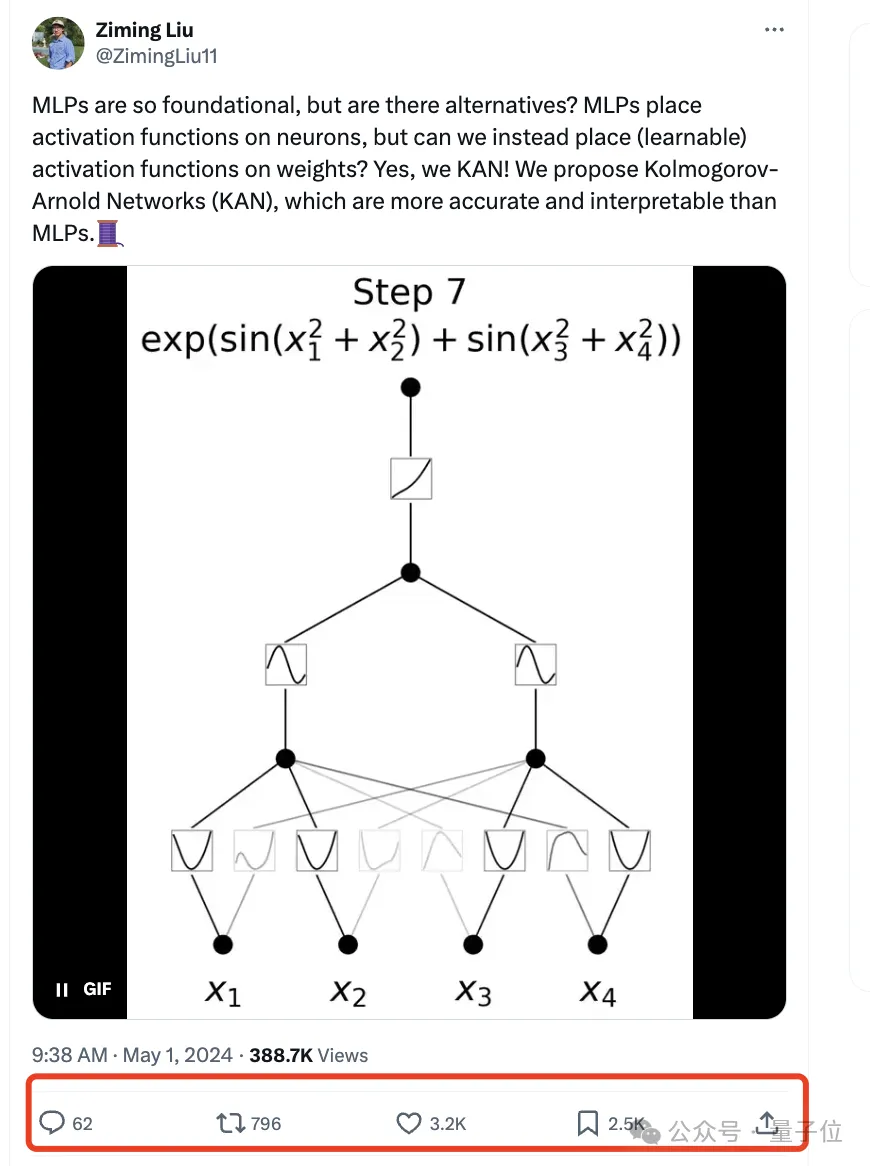

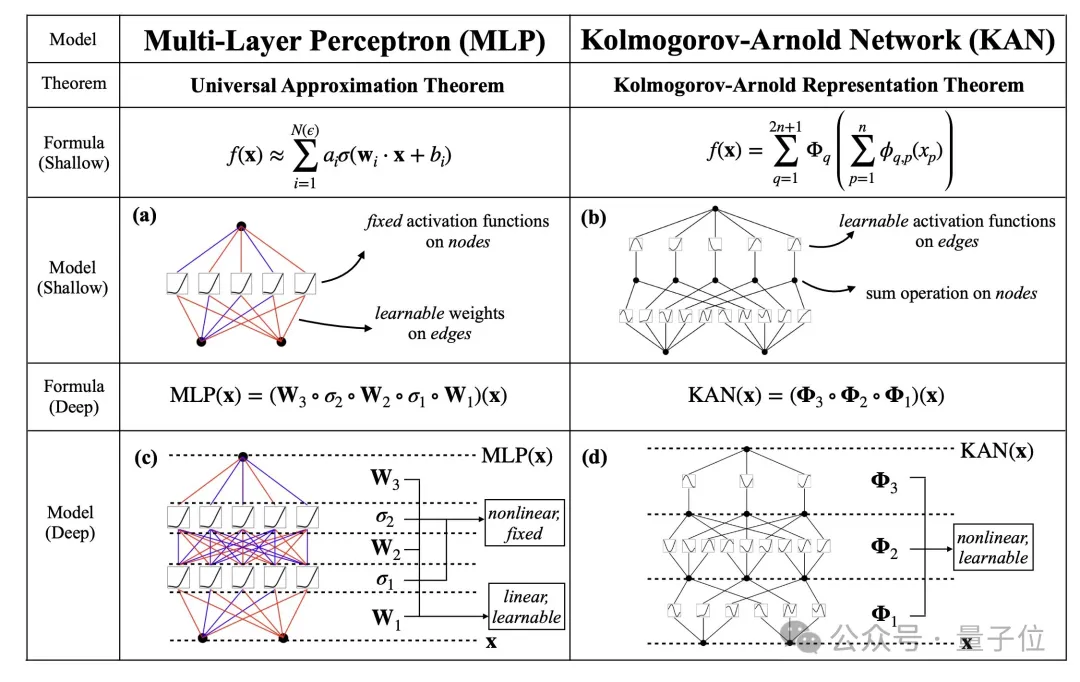

跟MLP最大、也是最為直觀的不同就是,MLP激活函數(shù)是在神經(jīng)元上,而KAN把可學習的激活函數(shù)放在權(quán)重上。

在作者看來,這是一個“簡單的更改”。

從數(shù)學定理方面來看,MLP的靈感來自于通用近似定理,即對于任意一個連續(xù)函數(shù),都可以用一個足夠深的神經(jīng)網(wǎng)絡來近似。

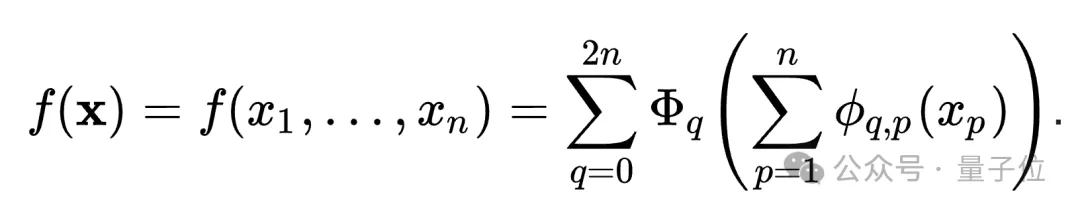

而KAN則是來自于 Kolmogorov-Arnold 表示定理 (KART),每個多元連續(xù)函數(shù)都可以表示為單變量連續(xù)函數(shù)的兩層嵌套疊加。

KAN的名字也由此而來。

正是受到這一定理的啟發(fā),研究人員用神經(jīng)網(wǎng)絡將Kolmogorov-Arnold 表示參數(shù)化。

為了紀念兩位偉大的已故數(shù)學家Andrey Kolmogorov和Vladimir Arnold,我們稱其為科爾莫格羅夫-阿諾德網(wǎng)絡(KANs)。

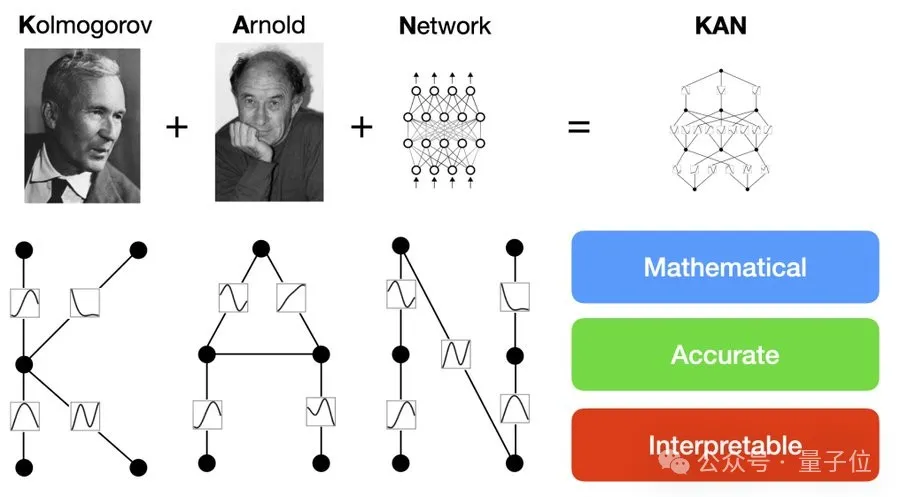

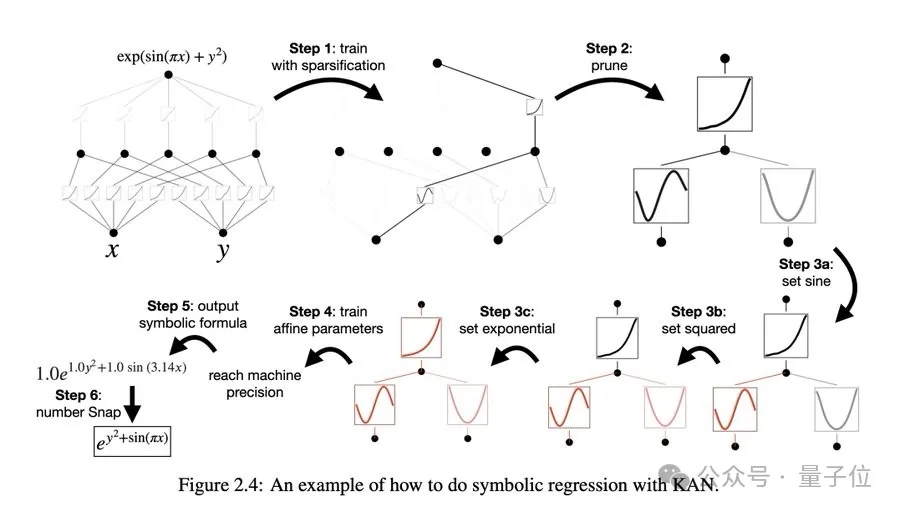

而從算法層面上看,MLPs 在神經(jīng)元上具有(通常是固定的)激活函數(shù),而 KANs 在權(quán)重上具有(可學習的)激活函數(shù)。這些一維激活函數(shù)被參數(shù)化為樣條曲線。

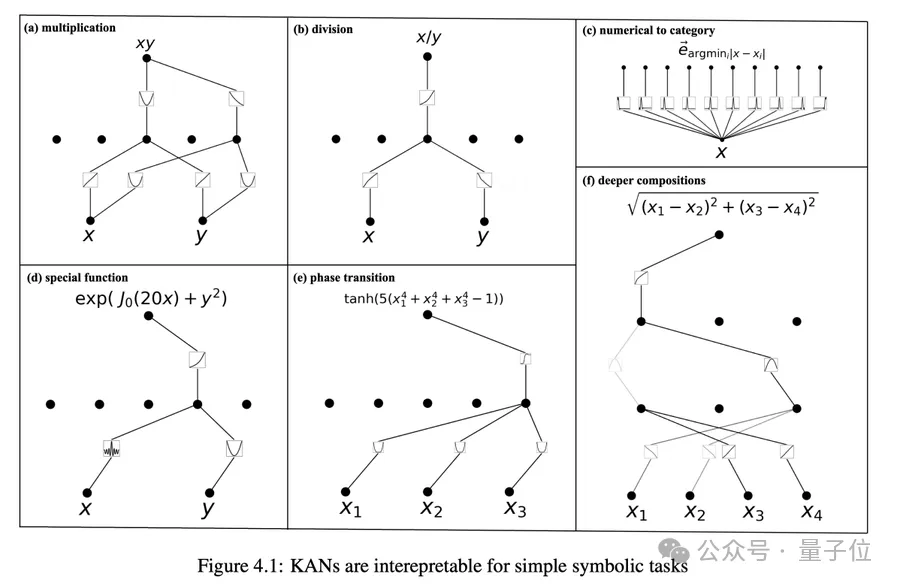

在實際應用過程中,KAN可以直觀地可視化,提供MLP無法提供的可解釋性和交互性。

不過,KAN的缺點就是訓練速度較慢。

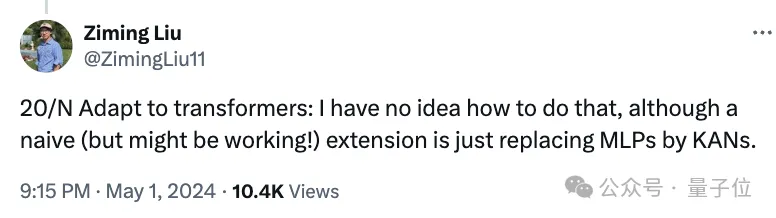

對于訓練速度慢的問題,MIT博士生一作Ziming Liu解釋道,主要有兩個方面的原因。

一個是技術(shù)原因,可學習的激活函數(shù)評估成本比固定激活函數(shù)成本更高。

另一個則是主觀原因,因為體內(nèi)物理學家屬性抑制程序員的個性,因此沒有去嘗試優(yōu)化效率。

對于是否能適配Transformer,他表示:暫時不知道如何做到這一點。

以及對GPU友好嗎?他表示:還沒有,正在努力中。

天然能解決大模型災難性遺忘

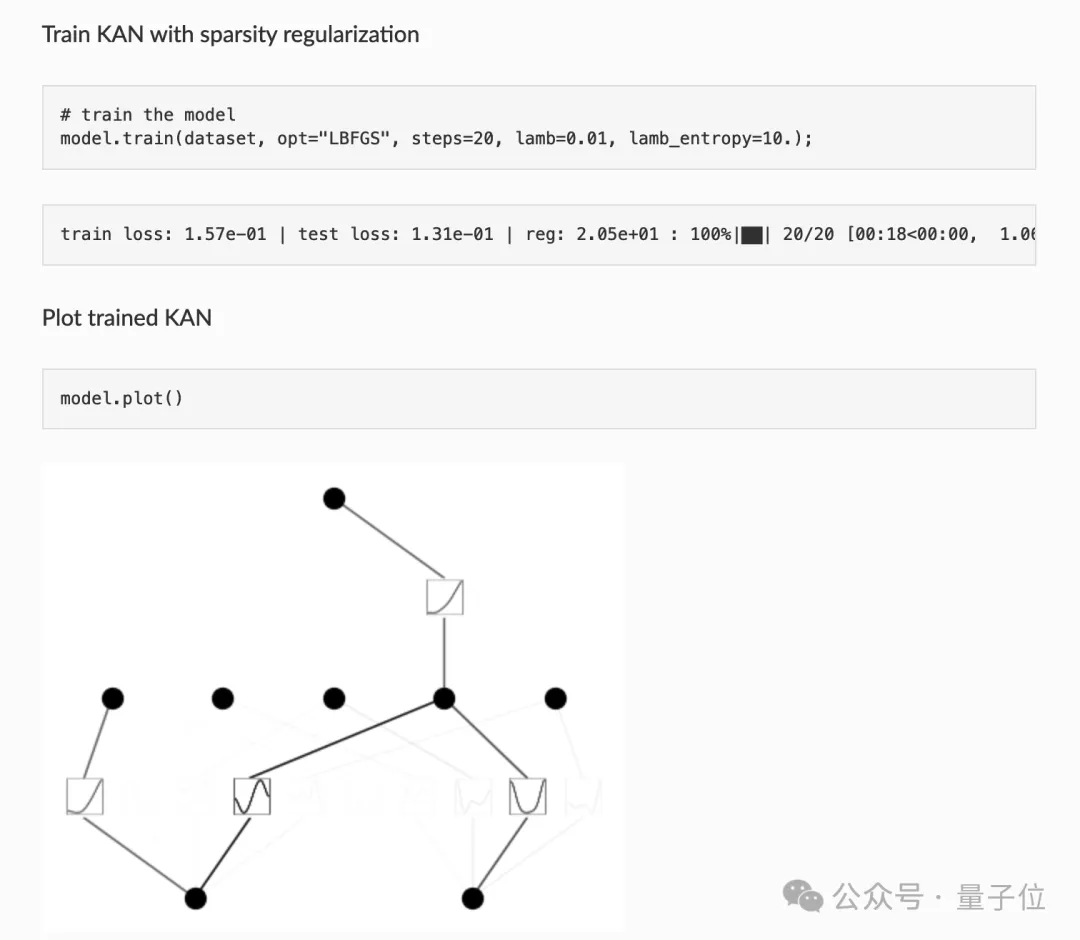

再來看看KAN的具體實現(xiàn)效果。

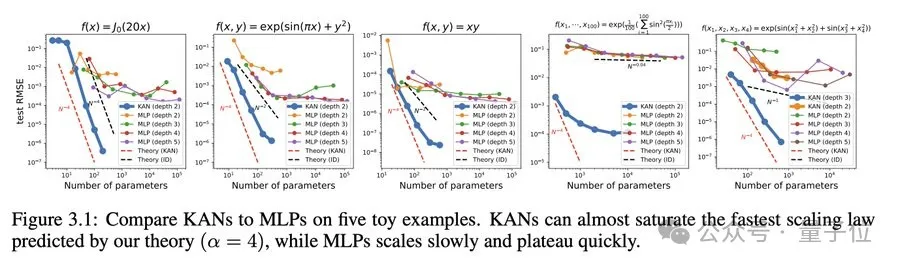

神經(jīng)縮放規(guī)律:KAN 的縮放速度比 MLP 快得多。除了數(shù)學上以Kolmogorov-Arnold 表示定理為基礎,KAN縮放指數(shù)也可以通過經(jīng)驗來實現(xiàn)。

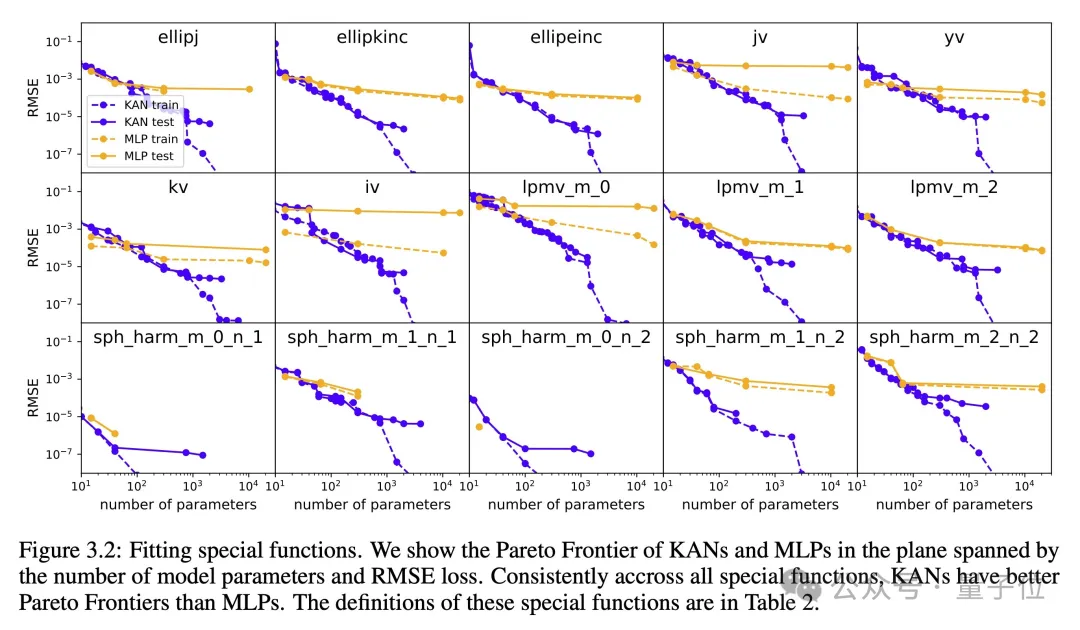

在函數(shù)擬合方面,KAN比MLP更準確。

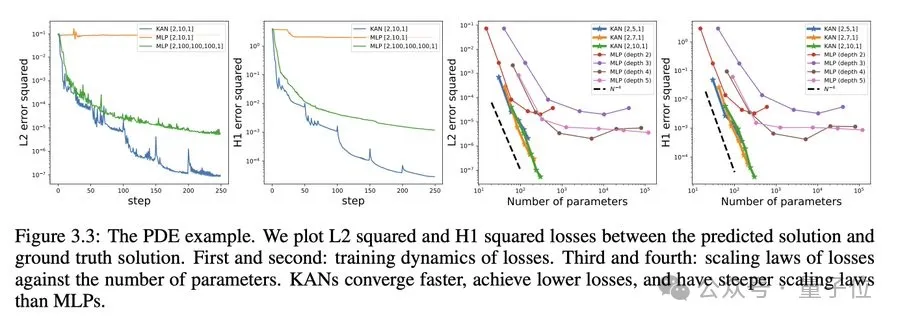

而在偏微分方程求解,比如求解泊松方程,KAN比MLP更準確。

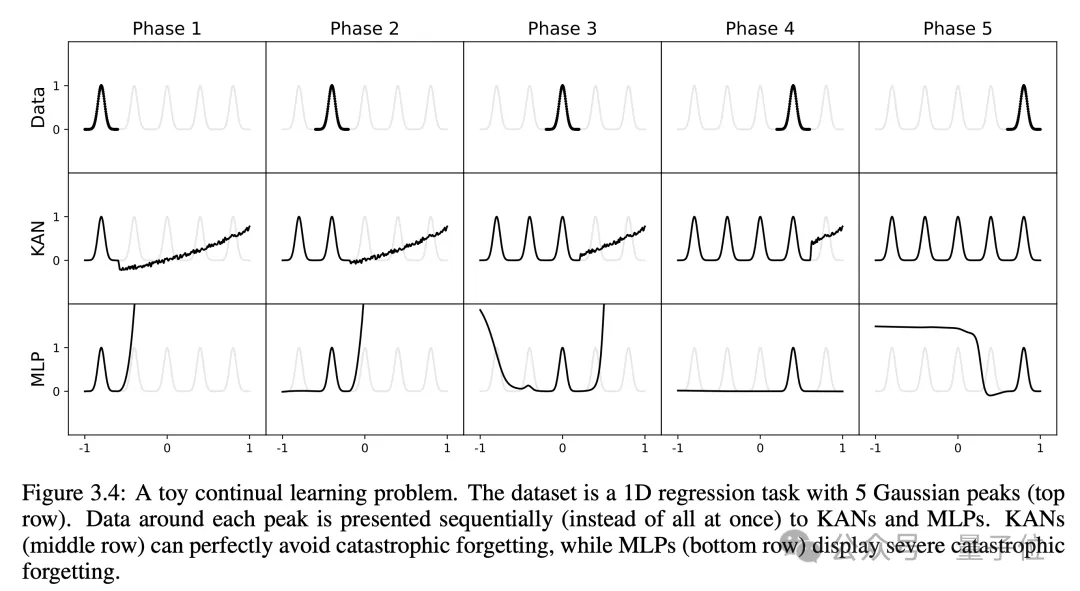

研究人員還有個意外發(fā)現(xiàn),就是KAN不會像MLP那樣容易災難性遺忘,它天然就可以規(guī)避這個缺陷。

好好好,大模型的遺忘問題從源頭就能解決。

在可解釋方面,KAN能通過符號公式揭示合成數(shù)據(jù)集的組成結(jié)構(gòu)和變量依賴性。

人類用戶可以與 KANs 交互,使其更具可解釋性。在 KAN 中注入人類的歸納偏差或領(lǐng)域知識非常容易。

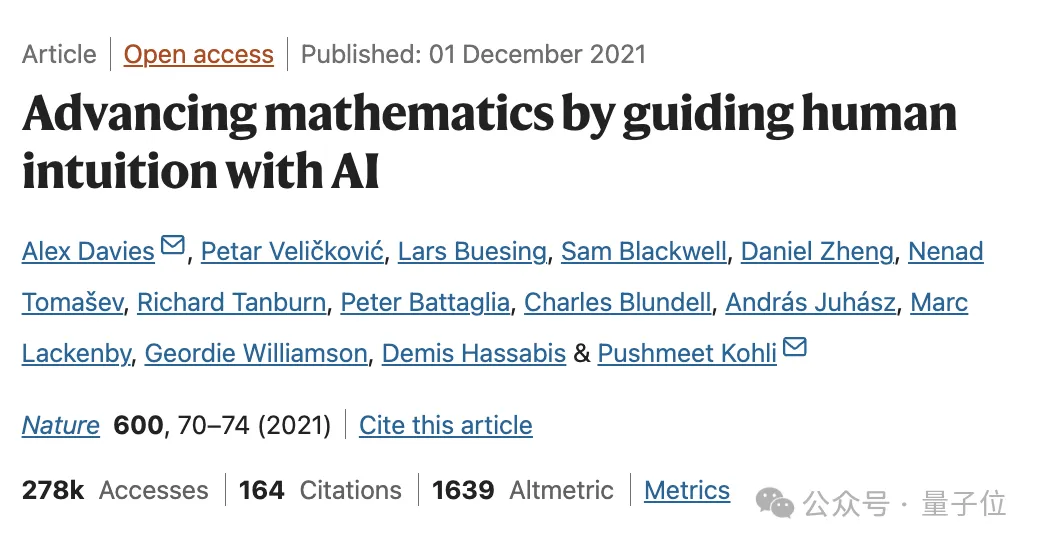

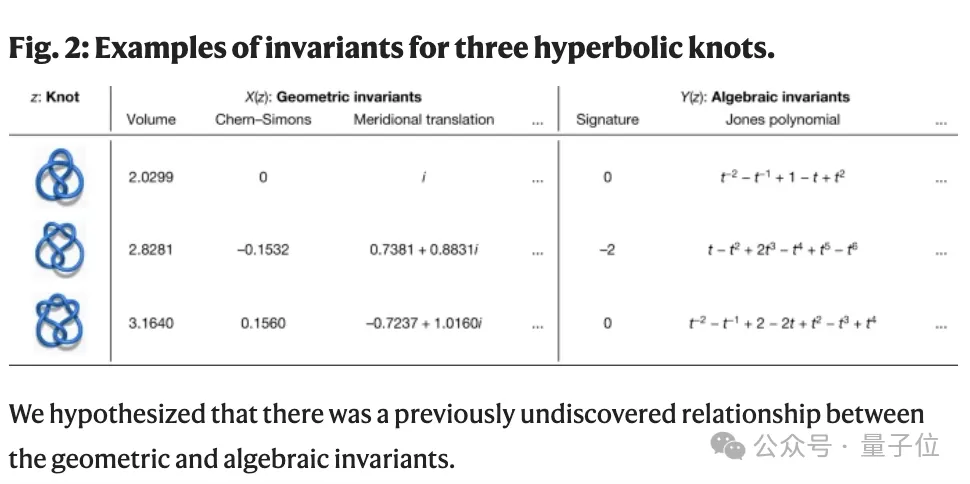

研究人員利用KANs還重新復現(xiàn)了DeepMind當年登上Nature的結(jié)果,并且還找到了Knot理論中新的公式,并以無監(jiān)督的方式發(fā)現(xiàn)了新的結(jié)不變式關(guān)系。

△DeepMind登Nature研究成果

Deepmind的MLP大約300000 個參數(shù),而KAN大約只有200 個參數(shù)。KAN 可以立即進行解釋,而 MLP 則需要進行特征歸因的后期分析。并且準確性也更高。

對于計算要求,團隊表示論文中的所有例子都可以在單個CPU上10分鐘內(nèi)重現(xiàn)。

雖然KAN所能處理的問題規(guī)模比許多機器學習任務要小,但對于科學相關(guān)任務來說就剛剛好。

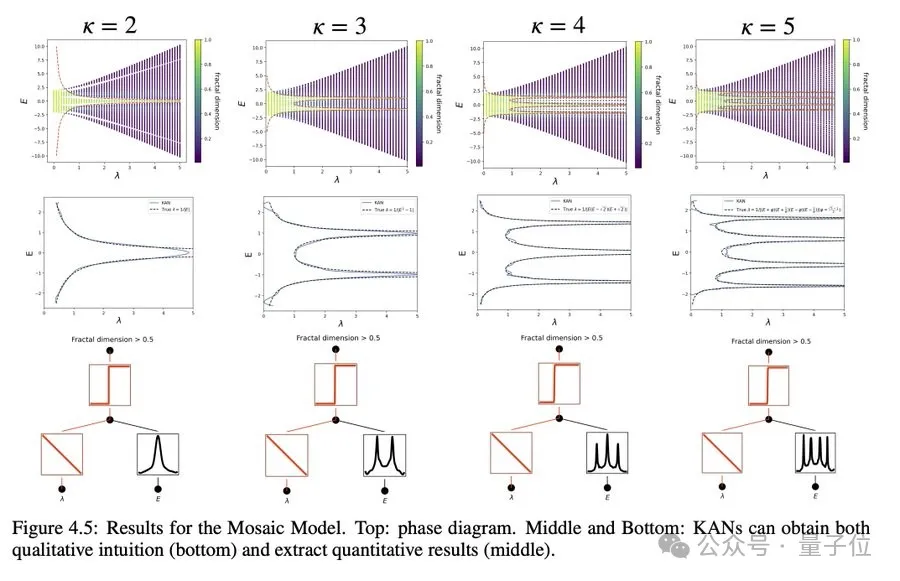

比如研究凝固態(tài)物理中的一種相變:安德森局域化。

好了,那么KAN是否會取代Transformer中的MLP層呢?

有網(wǎng)友表示,這取決于兩個因素。

一點是學習算法,如 SGD、AdamW、Sophia 等—能否找到適合 KANs 參數(shù)的局部最小值?

另一點則是能否在GPU上高效地實現(xiàn)KANs層,最好能比MLPs跟快。

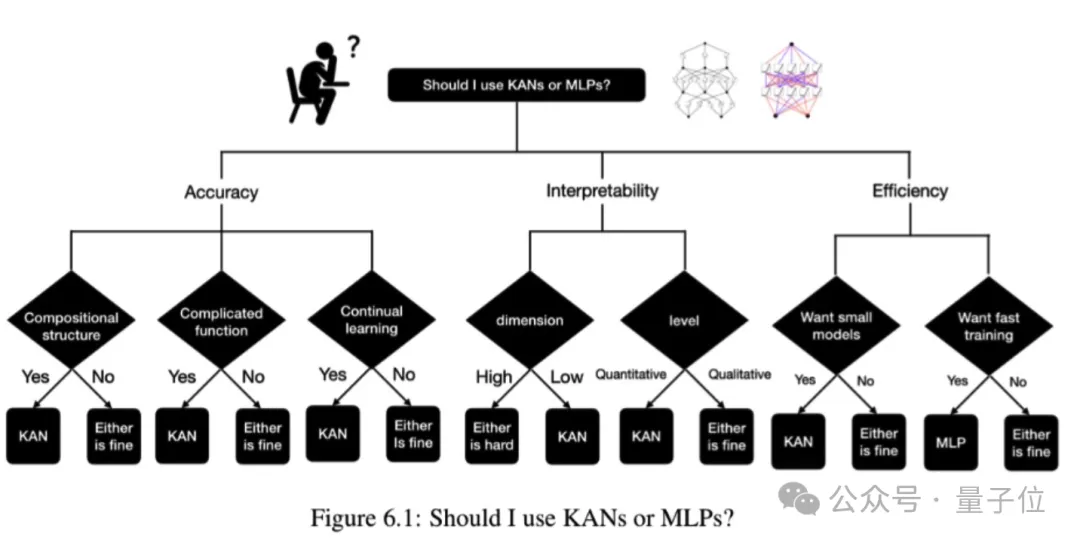

最后,論文中還貼心的給出了“何時該選用KAN?”的決策樹。

那么,你會開始嘗試用KAN嗎?還是讓子彈再飛一會兒~

項目鏈接:

???https://kindxiaoming.github.io/pykan/???

論文鏈接:

???https://arxiv.org/abs/2404.19756???

本文轉(zhuǎn)自 量子位 ,作者:量子位