新加坡見!快手11篇論文入選人工智能領域頂會ICLR 2025

?

ICLR(International Conference on Learning Representations)是人工智能領域頂級學術會議之一,主要聚焦于深度學習及其在表示學習(representation learning)方面的最新研究進展,是學術界和工業界展示最前沿機器學習成果的重要平臺。ICLR 2025 將于 4 月 24 日至 28 日在新加坡博覽中心舉行,本屆論文錄用結果揭曉,本次大會共收到 11672 篇有效投稿,最終有 3706 篇論文中稿,錄取率為 31.75%。logo

ICLR(International Conference on Learning Representations)是人工智能領域頂級學術會議之一,主要聚焦于深度學習及其在表示學習(representation learning)方面的最新研究進展,是學術界和工業界展示最前沿機器學習成果的重要平臺。ICLR 2025 將于 4 月 24 日至 28 日在新加坡博覽中心舉行,本屆論文錄用結果揭曉,本次大會共收到 11672 篇有效投稿,最終有 3706 篇論文中稿,錄取率為 31.75%。logo快手憑借其在深度學習算法研發領域的持續深耕與技術創新,共有 11 篇高質量學術論文成功入選。這些研究成果涵蓋大規模視覺-語言模型、可控視頻生成、3D 人臉動畫生成模型等前沿研究方向,不僅體現了研發團隊在跨模態理解、生成式 AI 等核心領域的關鍵技術突破,更彰顯了企業在人工智能研究方面的國際競爭力。

論文 01:SVBench: A Benchmark with Temporal Multi-Turn Dialogues for Streaming Video Understanding

| 項目地址:??https://github.com/yzy-bupt/SVBench??

| 論文簡介:

盡管大型視覺語言模型(LVLMs)在現有基準測試中取得了顯著進展,但在新興的長上下文流媒體視頻理解領域,其適用性仍缺乏合適的評估體系。當前的視頻理解基準通常側重于孤立的單實例文本輸入,而未能評估模型在視頻流全時長內持續進行時序推理的能力。

為彌補這些缺陷,我們提出了一個具有時序多輪問答鏈的開拓性基準 SVBench,專門用于全面評估當前 LVLMs 在流媒體視頻理解中的能力。我們設計了半自動化標注流程,從 1,353 個流媒體視頻中構建了 49,979 個問答對,包括生成代表視頻片段連續多輪對話的問答鏈,以及在連續問答鏈間建立時序關聯。通過對 14 個模型進行對話式評估和流式評估的實驗結果表明,雖然閉源的 GPT-4o 模型表現最優,但大多數開源 LVLMs 在長上下文流媒體視頻理解方面仍面臨挑戰。我們還構建了 StreamingChat 模型,該模型在 SVBench 上顯著超越開源 LVLMs,并在多樣化視覺語言基準測試中達到可比性能。我們期望 SVBench 能夠通過提供對當前 LVLMs 的全面深入分析,推動流媒體視頻理解領域的研究進展。

論文 02:3DTrajMaster: Mastering 3D Trajectory for Multi-Entity Motion in Video Generation

| 項目地址:??https://github.com/KwaiVGI/3DTrajMaster??

| 論文簡介:

現有的可控視頻生成方法主要利用二維控制信號來調控物體運動,雖已取得顯著合成效果,但二維控制信號本質上難以充分表達物體運動的三維本質。

為解決這一難題,我們提出一個基于用戶設定實體 6 自由度位姿(位置與旋轉)序列的三維空間多實體動力學調控框架 3DTrajMaster。該系統的核心在于創新的即插即用型三維運動基準化物體注入模塊,該模塊通過門控自注意力機制將多輸入實體與其三維軌跡深度融合。此外,我們采用注入式架構以保持視頻擴散模型先驗,這對系統的泛化能力至關重要。為緩解視頻質量衰減,我們在訓練階段引入領域適配器,并在推理階段采用退火采樣策略。針對訓練數據匱乏問題,我們構建了 360-Motion 數據集:首先對齊采集的三維人體與動物資產與 GPT 生成的軌跡數據,隨后在多樣化三維虛幻引擎平臺上使用 12 組均勻環繞攝像頭捕獲其運動。大量實驗表明,3DTrajMaster 在多實體三維運動控制的準確性與泛化性方面均達到當前最優水平。

論文 03:Cafe-Talk: Generating 3D Talking Face Animation with Multimodal Coarse- and Fine-grained Control

| 項目地址:

??https://harryxd2018.github.io/cafe-talk/??

| 論文簡介:

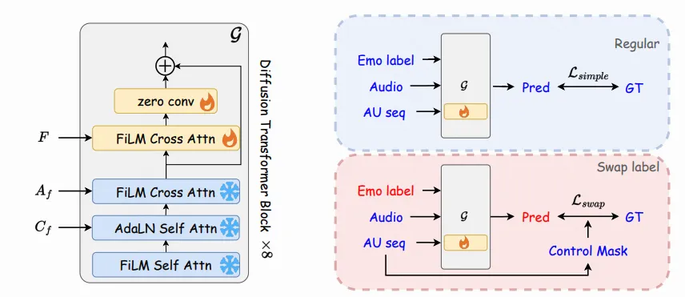

語音驅動的 3D 人臉動畫方法需同時實現精準的唇形同步與可控的表情生成。現有方法僅采用離散情感標簽對整段序列進行全局表情控制,限制了時空域內的靈活細粒度面部調控。

為此,我們提出一種基于擴散-Transformer 架構的 3D 人臉動畫生成模型 Cafe-Talk,通過融合粗粒度與細粒度的多模態控制條件實現同步優化。然而,多重條件的耦合性對模型性能提出了挑戰。為解耦語音與細粒度控制條件,我們采用兩階段訓練策略:首先僅基于語音音頻和粗粒度條件預訓練模型,隨后通過提出的細粒度控制適配器(Fine-grained Control Adapter)逐步引入以動作單元(Action Units, AUs)表征的細粒度指令,避免對唇音同步的干擾。針對粗-細粒度條件的解耦,我們設計了交換標簽訓練機制(Swap-label training mechanism),確保細粒度條件的主導性,并開發了基于掩碼的分類器無關引導技術(Mask-based Classifier-Free Guidance)以調節細粒度控制的強度。此外,通過文本-AU 對齊技術引入基于文本的檢測器,支持自然語言用戶輸入,進一步擴展多模態控制能力。大量實驗表明,Cafe-Talk 在唇形同步精度與表情自然度上均達到最先進水平,并在用戶研究中獲得細粒度控制的高接受度。

?

論文 04:Making Transformer Decoders Better Differentiable Indexers

| 項目地址:??https://openreview.net/pdf?id=bePaRx0otZ??

| 論文簡介:

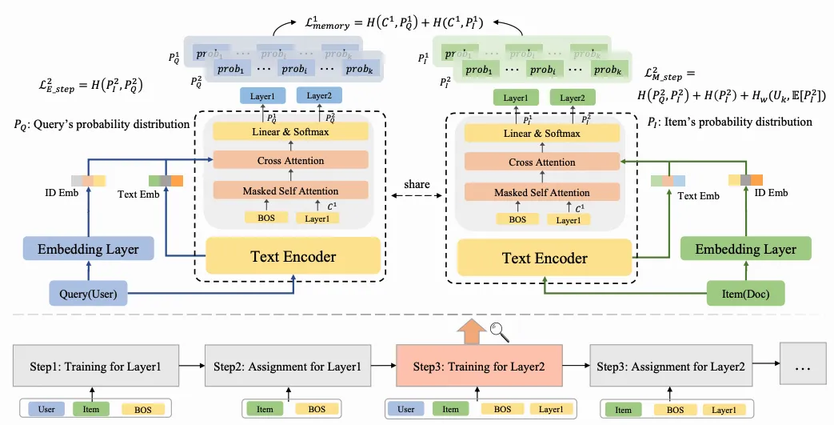

檢索任務旨在從海量數據集中篩選出與查詢/用戶最相關的 top-k 項。傳統檢索模型通過將查詢/用戶與物品表征為嵌入向量,并采用近似最近鄰(ANN)搜索實現檢索。近期研究提出一種生成式檢索方法,其核心創新在于:將物品表示為標記序列,并基于解碼器模型進行自回歸訓練。相較傳統方法,該方法采用更復雜的模型架構,并在訓練過程中整合索引結構,從而獲得更優性能。然而,現有方法仍存在兩階段流程的固有缺陷:索引構建與檢索模型相互割裂,限制了模型整體能力。此外,現有索引構建方法通過在歐氏空間對預訓練物品表征進行聚類實現,但現實場景的復雜性使得此類方法難以保證準確性。

為解決上述問題,本文提出檢索與索引統一框架 URI。該框架通過以下機制實現突破:

- 索引構建與檢索模型(通常為 Transformer 解碼器)的強一致性保障;

- 索引構建與解碼器訓練的同步優化,使索引直接由解碼器內生構建;

- 摒棄基于歐氏空間的單側物品表征,轉而在查詢-物品交互空間中構建索引。

通過在三個真實數據集上的實驗對比,URI 展現出顯著優于現有方法的性能。

論文 05:Pyramidal Flow Matching for Efficient Video Generative Modeling

| 項目地址:??https://pyramid-flow.github.io/??

| 論文簡介:

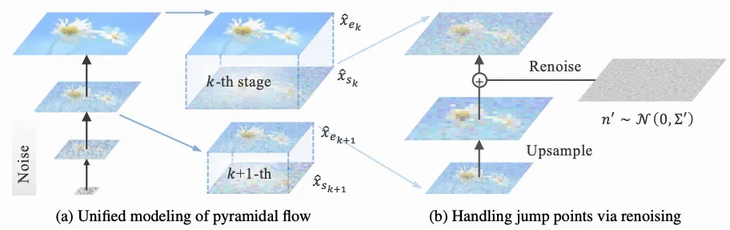

視頻生成需要對廣袤的時空空間進行建模,這對計算資源和數據使用提出了極高要求。為降低復雜度,主流方法采用級聯架構以避免直接訓練全分辨率潛在空間。盡管降低了計算需求,但各子階段的獨立優化阻礙了知識共享并犧牲了靈活性。

本文提出統一的金字塔流匹配算法,將原始去噪軌跡重新詮釋為多級金字塔階段,其中僅最終階段在全分辨率運行,從而實現更高效的視頻生成建模。通過精心設計,不同金字塔階段的流可相互鏈接以保持連續性;同時,我們構建了時域金字塔自回歸視頻生成框架以壓縮全分辨率歷史信息。整個系統可通過端到端方式聯合優化,并僅需單一統一的擴散 Transformer(Diffusion Transformer)。大量實驗表明,該方法支持在 20.7k A100 GPU 訓練小時內生成 768p 分辨率、24 幀率的高質量 5 秒(最高達 10 秒)視頻。

論文 06:RecFlow: An Industrial Full Flow Recommendation Dataset

| 項目地址:??https://github.com/RecFlow-ICLR/RecFlow??

| 論文簡介:

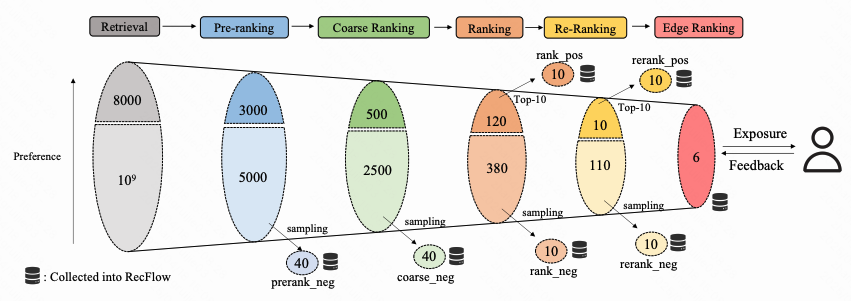

工業推薦系統采用多階段流程,將海量內容庫中的物品逐步篩選并推送給用戶,以在效果與效率之間實現平衡。現有的推薦系統基準數據集主要聚焦于曝光空間,在此空間內進行新算法的訓練與評估。然而,當這些算法遷移至真實工業推薦系統時,面臨兩大關鍵挑戰:

- 忽視規模遠超曝光空間的未曝光物品空間,而兩者差異對推薦系統整體性能有深刻影響;

- 忽視工業推薦系統中多個階段間復雜的相互作用,導致系統整體性能次優。

為彌合離線推薦基準與真實在線環境間的鴻溝,我們推出首個工業級全流程推薦數據集 RecFlow。與現有數據集不同,RecFlow 不僅包含曝光空間樣本,還涵蓋推薦漏斗中各階段被過濾的未曝光樣本。該數據集包含:基于 42,000 用戶對近 900 萬項目的 3,800 萬次交互數據,以及通過 930 萬次在線請求在 37 天內收集的橫跨 6 個流程階段的 19 億階段樣本。基于 RecFlow,我們開展探索實驗驗證其在推薦算法創新中的潛力:引入各階段的未曝光樣本可顯著提升算法效果。部分算法已在快手平臺上線并持續產生顯著收益。我們發布 RecFlow 作為推薦領域首個完整的全流程基準數據集,支持以下研究方向:全流程算法設計(包括選擇偏差研究、去偏算法、多階段一致性與最優性)、多任務推薦及用戶行為建模。

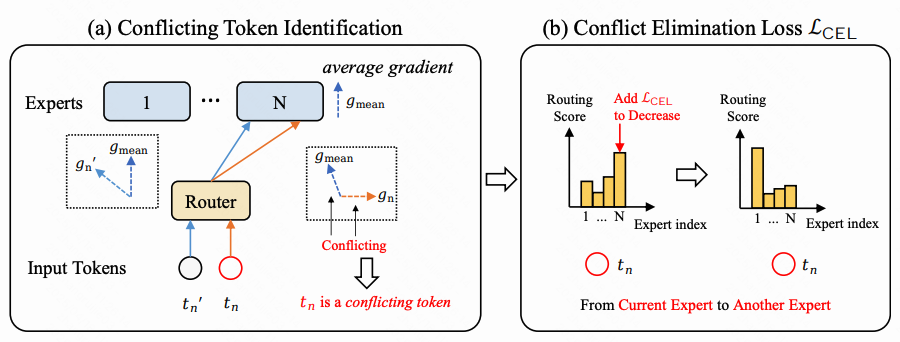

論文 07:Solving Token Gradient Conflict in Mixture-of-Experts for Large Vision-Language Model

| 項目地址:??https://github.com/longrongyang/STGC??

| 論文簡介:

混合專家模型(MoE)在大型視覺語言模型(LVLMs)研究中受到廣泛關注。該方法通過稀疏模型替代稠密模型,在保持可比性能的同時,僅激活少量參數進行推理,從而顯著降低計算成本。現有 LVLM 中的 MoE 方法促使不同專家專注于不同 token,通常通過路由模塊預測每個 token 的路徑。然而,路由模塊并未針對專家內 token 產生的不同參數優化方向進行優化,這可能導致同一專家內 token 間的嚴重干擾。

為解決該問題,本文提出基于 token 級梯度分析的 token 梯度沖突消解方法 STGC。具體而言,我們首先通過 token 級梯度識別專家內的沖突 token,隨后設計定制化正則損失,促使沖突 token 從當前專家路由至其他專家,從而降低專家內 token 間的干擾。該方法可作為即插即用模塊適配多種 LVLM 方法,大量實驗結果驗證了其有效性。

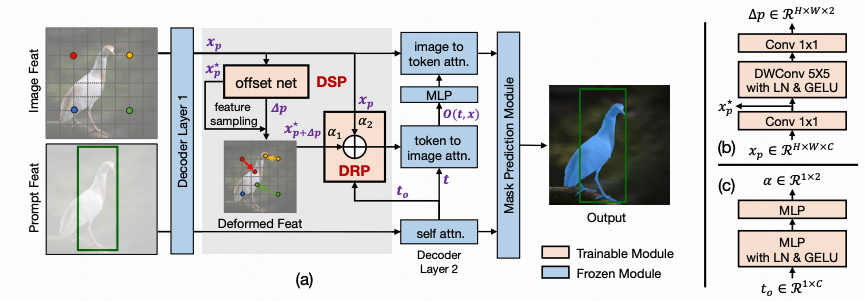

論文 08:Stable Segment Anything Model

| 項目地址:??https://github.com/fanq15/Stable-SAM?tab=readme-ov-file??

| 論文簡介:

盡管 Segment Anything 模型(SAM)在高質量提示下能夠實現卓越的可提示分割效果,但這些提示通常需要較高的標注技巧才能生成。

為了使 SAM 對隨意提示更具魯棒性,本文首次全面分析了 SAM 在不同提示質量(尤其是邊界框不精確和點數不足)下的分割穩定性。我們的關鍵發現表明,當輸入此類低質量提示時,SAM 的掩碼解碼器傾向于激活偏向背景或局限于特定物體局部的圖像特征。為緩解此問題,我們的核心思路是通過調整圖像特征的采樣位置和幅度,僅對 SAM 的掩碼注意力進行校準,同時保持原始 SAM 模型架構和權重不變。由此提出的可變形采樣插件(Deformable Sampling Plugin)使 SAM 能夠以數據驅動的方式自適應地將注意力轉移到提示目標區域。在推理階段,我們進一步提出動態路由插件(Dynamic Routing Plugin),根據輸入提示質量動態切換 SAM 的可變形采樣模式與常規網格采樣模式。因此,我們的解決方案(Stable-SAM)具備以下優勢:

- 顯著提升 SAM 在廣泛提示質量下的分割穩定性;

- 完整保留 SAM 原有的高效可提示分割能力與通用性;

- 僅需極少可學習參數(0.08 M)且支持快速適配。

大量實驗驗證了該方法的有效性和優勢,表明 Stable-SAM 為"分割萬物"任務提供了一個更魯棒的解決方案。

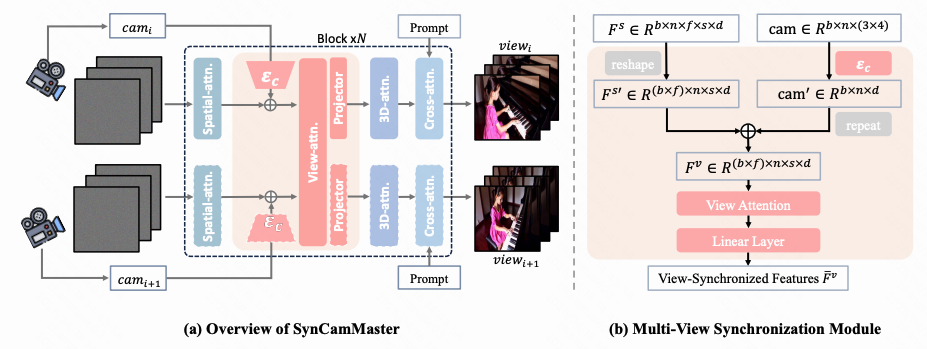

論文 09:SynCamMaster: Synchronizing Multi-Camera Video Generation from Diverse Viewpoints

| 項目地址:??https://jianhongbai.github.io/SynCamMaster/??

| 論文簡介:

近年來,視頻擴散模型在模擬真實世界動態與 3D 一致性方面展現出卓越能力。這一進展促使我們探索此類模型在跨視角動態一致性保持方面的潛力,該特性在虛擬拍攝等應用中備受關注。與現有聚焦于單物體多視角生成以實現 4D 重建的方法不同,我們的研究旨在通過六自由度(6 DoF)相機位姿生成任意視角、多相機同步的開放世界視頻。為此,我們提出了一種即插即用模塊,通過微調預訓練文本到視頻模型實現多相機視頻生成,確保跨視角內容一致性。具體而言,我們設計了多視角同步模塊以促進視角間的內容與幾何一致性。鑒于高質量訓練數據的稀缺性,我們還提出了一種漸進式訓練方案,通過融合多相機圖像與單目視頻作為 Unreal Engine 渲染多相機視頻的補充。這種綜合性策略顯著提升了模型性能。實驗結果表明,我們提出的方法在現有競爭方法與基線模型上均表現出優越性。此外、該工作提出了多視角同步視頻數據集 SynCamVideo-Dataset 用于多視角視頻生成的研究。

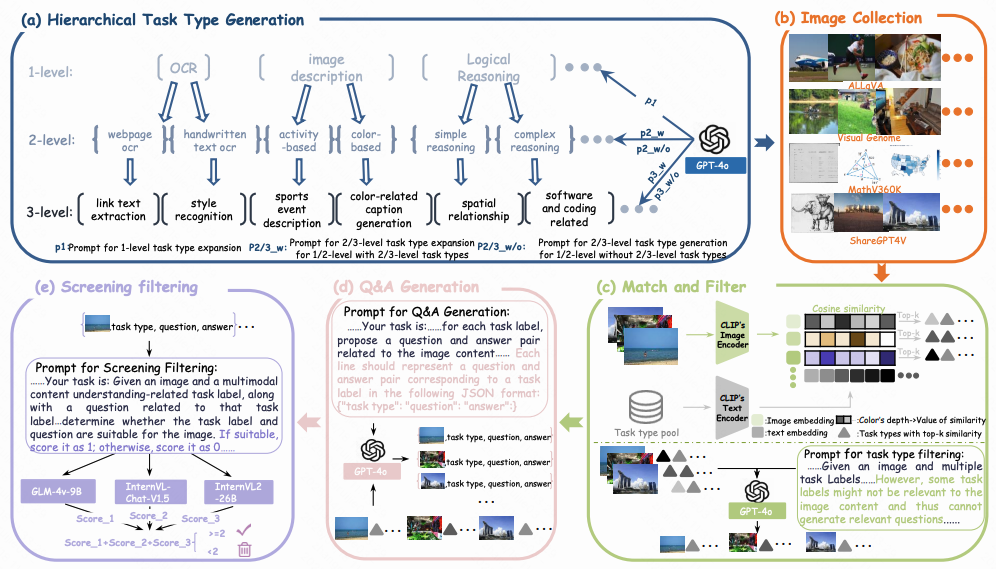

論文 10:TaskGalaxy: Scaling Multi-modal Instruction Fine-tuning with Tens of Thousands Vision Task Types

| 項目地址:??https://github.com/Kwai-YuanQi/TaskGalaxy??

| 論文簡介:

多模態視覺語言模型正憑借模型架構、訓練技術及高質量數據的進步,在開放世界應用中嶄露頭角。然而,特定任務數據不足嚴重制約了其性能,導致泛化能力弱化與輸出偏差。現有增強微調數據集任務多樣性的方法受限于人工任務標注的高成本,通常僅能產生數百種任務類型。

為此,我們提出一個包含 19,227 種層次化任務類型(含 413,648 樣本)的大規模多模態指令微調數據集 TaskGalaxy。該數據集通過 GPT-4o 從少量人工定義任務出發進行任務擴展,利用 CLIP 與 GPT-4o 篩選與開源圖像最匹配的任務,并生成相關問答對;通過多模型協同確保樣本質量。這種自動化流程在提升任務多樣性的同時保障了數據質量,顯著減少人工干預。將 TaskGalaxy 應用于 LLaVA-v1.5 與 InternVL-Chat-v1.0 模型后,在 16 項基準測試中均取得顯著性能提升,充分驗證任務多樣性的關鍵作用。

論文 11:ReDeEP: Detecting Hallucination in Retrieval-Augmented Generation via Mechanistic Interpretability

| 項目地址:??https://github.com/Jeryi-Sun/ReDEeP-ICLR??

| 論文簡介:

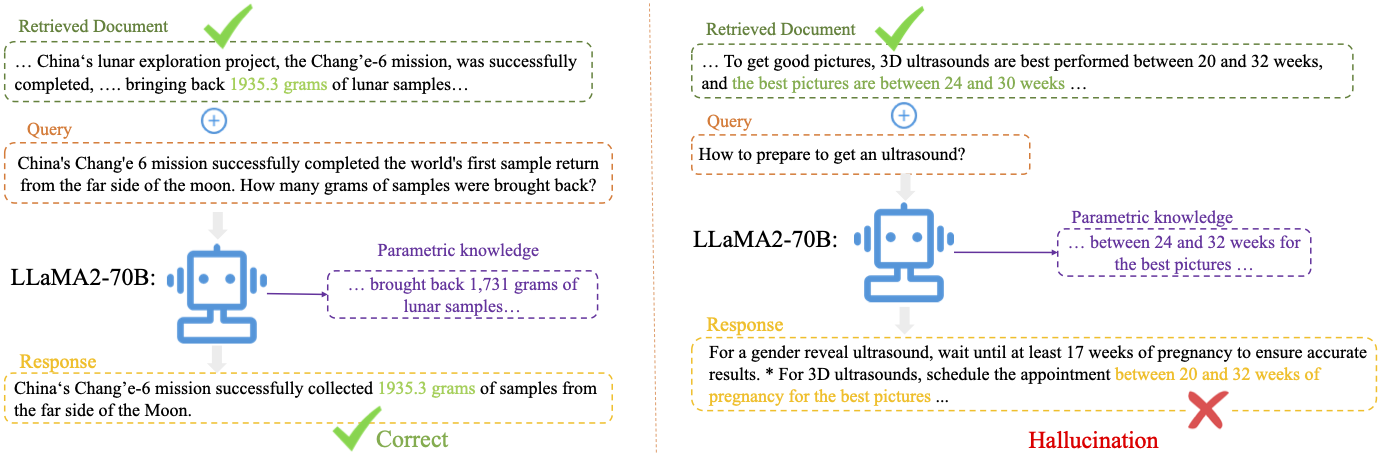

Retrieval-Augmented Generation(RAG)模型通過結合外部知識以減少幻覺問題,但即使檢索到準確的上下文,RAG 模型仍可能在生成過程中產生與檢索信息相沖突的“幻覺”輸出。

我們的研究聚焦于:

1. 幻覺來源

通過機制解釋性 MechanisticInterpretability 分析 LLM 模型內部的注意力和前饋網絡(Feed-Forward Network,FFN),我們發現:

- 某些注意力頭(稱為 Copying Heads)在獲取外部上下文時,經常出現信息丟失或未能有效“拷貝”外部知識的現象。

- 部分深層 FFN(稱為 Knowledge FFNs)過度向殘差流中注入參數化知識 ParametricKnowledge,可能“淹沒”外部上下文。

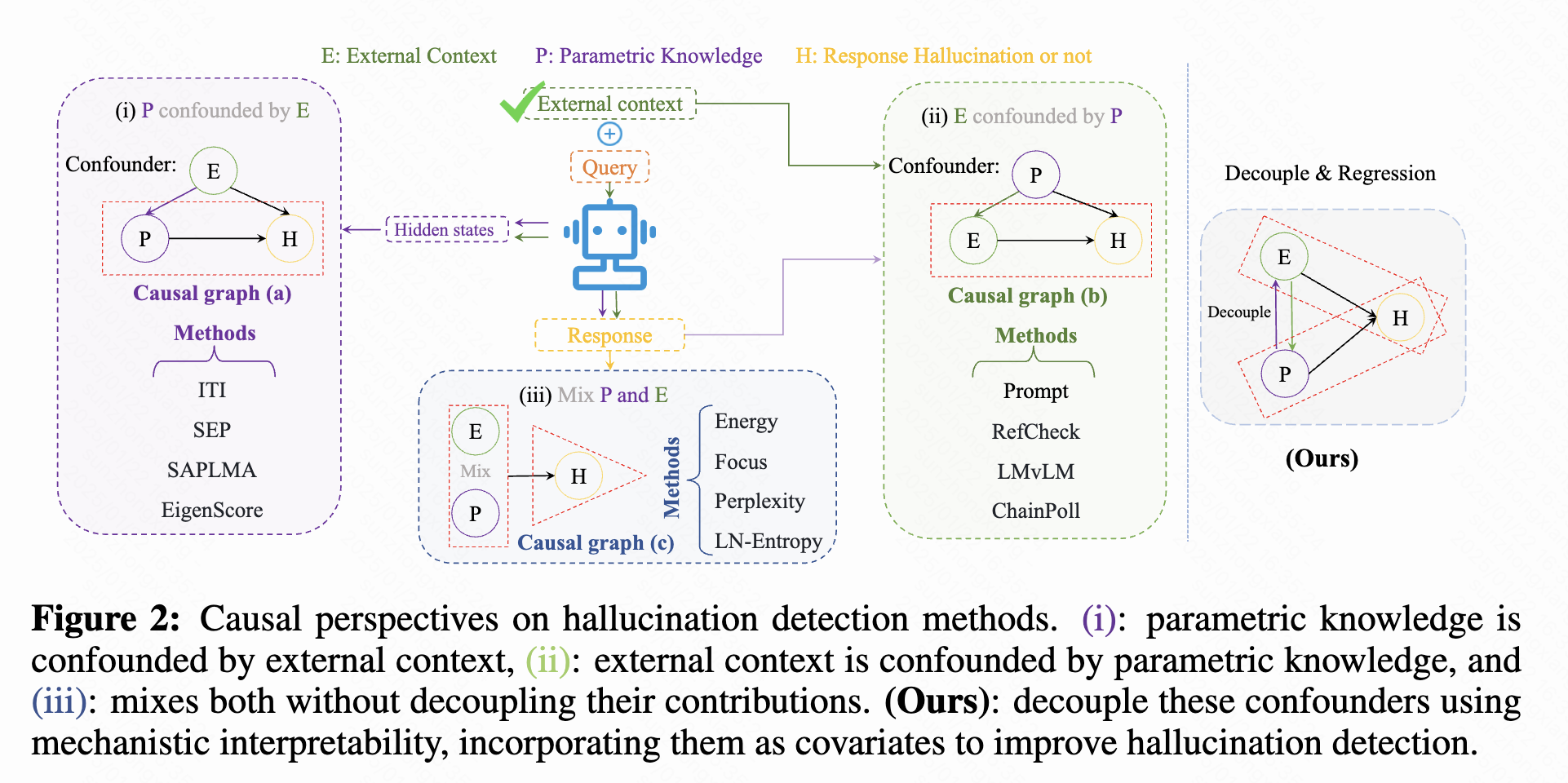

2. 提出方法:

ReDeEP RegressingDecoupledExternalcontextandParametricknowledge

- 將模型對外部上下文和參數化知識的利用進行顯式解耦,并通過多元線性回歸來檢測幻覺傾向。

- 提供兩種檢測粒度:Token-level 和 Chunk-level,兼顧精細度與計算效率。

3. 改進模型生成:

AARF AddAttentionReduceFFN

- 在推理過程中,無需額外訓練,依據實時“幻覺分數”對注意力和 FFN 的輸出進行動態加權調控。

- 引導模型更多依賴外部知識,同時抑制過度依賴內部參數化知識,從而顯著降低幻覺。