【PaperDaily】谷歌推出AlphaGeometry2,超過金牌選手,稱霸IMO

1. Gold-medalist Performance in Solving Olympiad Geometry with AlphaGeometry2

我們推出了 AlphaGeometry2,這是對 Trinh 等人在 2024 年提出的 AlphaGeometry 的重大改進版本,如今它在解決奧林匹克幾何問題方面的能力已經超過了普通金牌得主。為了實現這一突破,我們首先對原有的 AlphaGeometry 語言進行了擴展,使其能夠處理涉及物體運動的更難題型,以及包含角度、比例和距離的線性方程的問題。這些改進以及其他新增內容,顯著提高了 AlphaGeometry 語言對 2000 - 2024 年國際數學奧林匹克(IMO)幾何題的覆蓋率,從 66% 提升到了 88% 。 。

AlphaGeometry2 的搜索過程也有了極大改進,我們采用了 Gemini 架構以實現更優的語言建模,還運用了一種將多個搜索樹結合起來的全新知識共享機制。再加上對符號引擎和合成數據生成的進一步優化,我們大幅提升了 AlphaGeometry2 的整體解題率,在過去 25 年的所有幾何問題上,解題率從之前的 54% 提升到了 84%。AlphaGeometry2 還是在 2024 年國際數學奧林匹克中達到銀牌水平的系統的一部分,詳情見https://dpmd.ai/imo-silver 。

論文: ??https://arxiv.org/pdf/2502.03544??

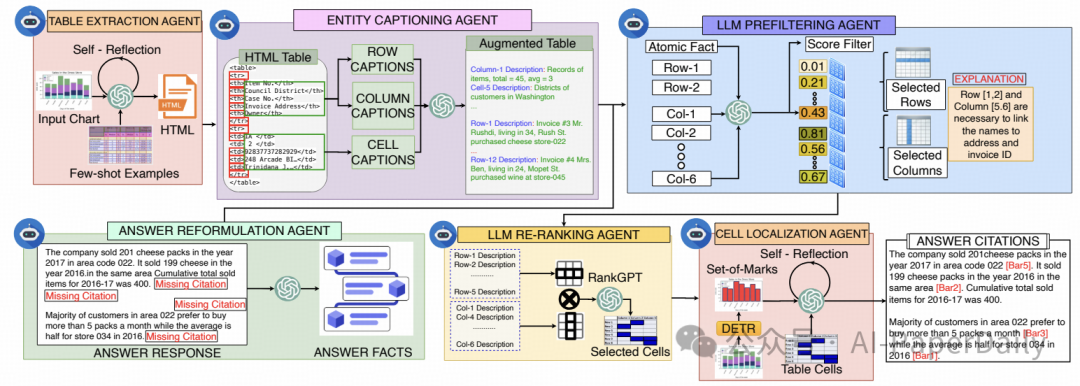

2. ChartCitor: Multi-Agent Framework for Fine-Grained Chart Visual Attribution

大語言模型(LLMs)能夠執行圖表問答任務,但常常會生成未經核實的虛假回復。由于視覺語義上下文有限、復雜的視覺 - 文本對齊要求,以及在復雜布局中進行邊界框預測存在困難,現有的答案歸因方法難以將回復與源圖表建立關聯。

我們推出了 ChartCitor,這是一個多智能體框架,它通過識別圖表圖像中的支撐證據,提供細粒度的邊界框引用。該系統協調大語言模型智能體執行從圖表到表格的提取、答案重新組織、表格擴充、通過預過濾和重排序進行證據檢索,以及從表格到圖表的映射。

在不同類型的圖表中,ChartCitor 的表現均優于現有的基線模型。定性用戶研究表明,ChartCitor 通過增強大語言模型輔助圖表問答的可解釋性,有助于提升用戶對生成式人工智能的信任,還能讓專業人士提高工作效率。

論文: ??https://arxiv.org/pdf/2502.00989??

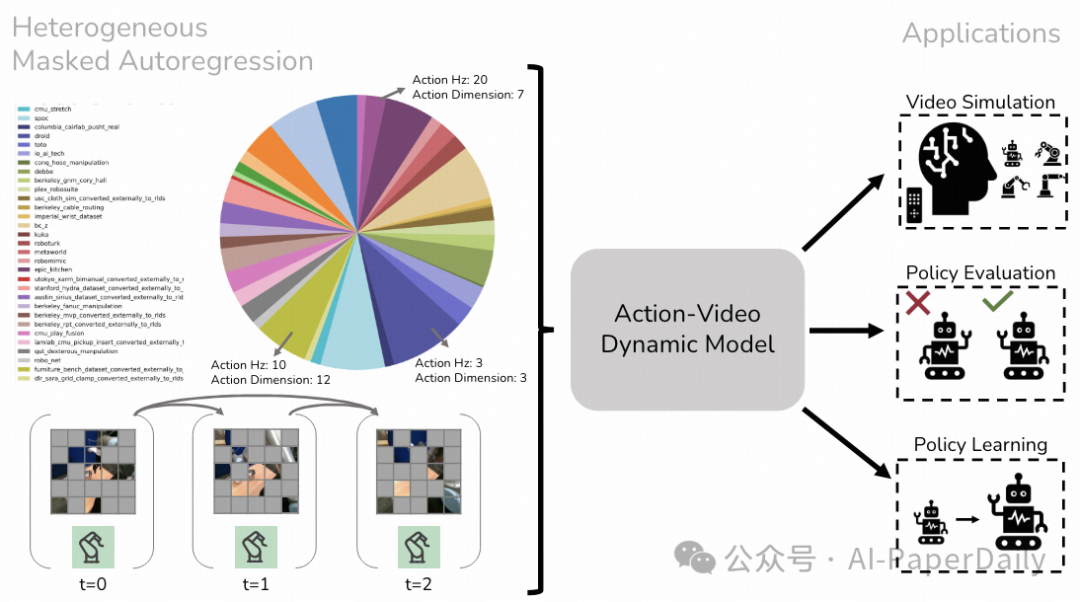

3. Learning Real-World Action-Video Dynamics with Heterogeneous Masked Autoregression

我們提出了異構掩碼自回歸(HMA)方法,用于對動作視頻動態進行建模,以生成高質量數據,并在拓展機器人學習中開展評估工作。由于既要應對各種不同場景,又要保持計算效率以實現實時運行,因此構建適用于機器人技術的交互式視頻世界模型和策略頗具挑戰。

HMA 利用來自不同機器人實體、領域及任務中的觀測數據和動作序列,進行異構預訓練。它借助掩碼自回歸生成量化或軟令牌,以實現視頻預測。與以往的機器人視頻生成模型相比,我們的模型(HMA)視覺保真度和可控性更佳,在現實世界中的運行速度更是快了 15 倍。經過后期訓練,該模型可用作視頻模擬器,接受低層級動作輸入,以評估策略并生成合成數據。如需更多信息,請訪問此鏈接:https://liruiw.github.io/hma 。

論文: ??https://arxiv.org/pdf/2502.04296??

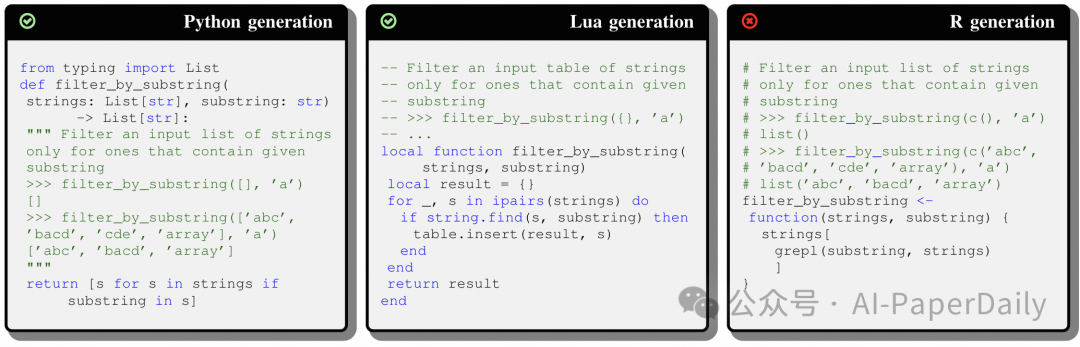

4. Enhancing Code Generation for Low-Resource Languages: No Silver Bullet

大語言模型(LLMs)的出現極大地推動了自動化代碼生成領域的發展。大語言模型依賴大量多樣的數據集來學習編程語言的語法、語義及使用模式。對于低資源語言(即那些因訓練數據稀缺而小眾的編程語言)而言,此類數據的有限可用性限制了模型的有效泛化能力,導致其代碼生成性能相較于高資源語言要差。因此,人們一直在探尋能夠縮小這一性能差距的技術。

我們開展了一項實證研究,探究幾種提升大語言模型在低資源語言上性能的方法的有效性,具體如下:(i)經典的微調方法,但由于訓練數據稀缺,其規模受限;(ii)三種上下文學習變體,通過精心設計提示,為大語言模型提供關于低資源語言的額外信息(例如,展示目標語言特性的少樣本示例);(iii)一種預訓練目標,教會模型如何在高資源語言和低資源語言之間進行翻譯。

我們的研究以兩種低資源語言(R 語言和 Racket 語言)以及六種不同架構和規模的大語言模型為背景。研究結果表明,對于規模較小的大語言模型,微調通常是最佳選擇,這可能是因為即使是少量數據集也足以訓練其有限數量的參數。隨著模型規模的增大,上下文學習變得越來越有效,是一種穩妥且成本較低的策略(即它總能起到一定作用,只是程度有所不同)。然而,對于超大規模的大語言模型,進行微調時,它們在低資源語言上的性能可能會下降,這可能是由于缺乏足夠的數據來有效更新其權重。

論文: ???https://arxiv.org/pdf/2501.19085??

本文轉載自 ??AI-PaperDaily??,作者: AI-PaperDaily