面向統(tǒng)一的單、多主體個(gè)性化文生圖框架!阿里通義發(fā)布AnyStory!

論文鏈接:https://arxiv.org/pdf/2501.09503

項(xiàng)目鏈接:https://aigcdesigngroup.github.io/AnyStory/

亮點(diǎn)直擊

- 提出了一種統(tǒng)一的單主體和多主體個(gè)性化框架,稱為AnyStory。該框架在個(gè)性化單主體和多主體時(shí)實(shí)現(xiàn)了一致性,同時(shí)遵循文本提示;

- 引入了一種增強(qiáng)的主體表示編碼器,由簡(jiǎn)化的輕量級(jí) ReferenceNet 和 CLIP 視覺(jué)編碼器組成,能夠?qū)σ话阒黧w進(jìn)行高保真細(xì)節(jié)編碼;

- 提出了一種解耦的實(shí)例感知router模塊,能夠準(zhǔn)確感知和預(yù)測(cè)主體的隱空間條件區(qū)域,從而實(shí)現(xiàn)對(duì)單個(gè)或多個(gè)主體的靈活和可控的個(gè)性化生成;

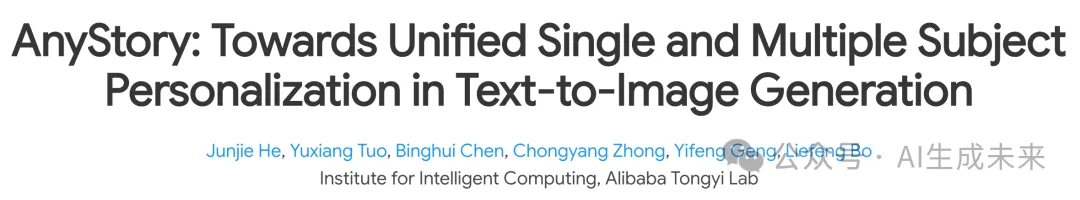

- 實(shí)驗(yàn)結(jié)果表明,本方法在保持主體細(xì)節(jié)的真實(shí)性、對(duì)齊文本描述以及個(gè)性化多個(gè)主體方面表現(xiàn)出色。

總結(jié)速覽

解決的問(wèn)題:

- 生成具有特定主體的高保真?zhèn)€性化圖像面臨挑戰(zhàn),尤其是在涉及多個(gè)主體的情況下。

- 在不犧牲主體保真度的情況下,處理多個(gè)主體的個(gè)性化生成。

提出的方案:

- 提出 AnyStory,一種統(tǒng)一的單主體和多主體個(gè)性化框架。

- 采用“編碼-route”的方式來(lái)建模主體個(gè)性化問(wèn)題。

- 在編碼步驟中,利用 ReferenceNet 和 CLIP 視覺(jué)編碼器實(shí)現(xiàn)高保真編碼。

- 在route步驟中,使用解耦的實(shí)例感知主體router,準(zhǔn)確感知和預(yù)測(cè)隱空間中主體的位置。

應(yīng)用的技術(shù):

- ReferenceNet:一種簡(jiǎn)化的輕量級(jí)圖像編碼器,用于高保真細(xì)節(jié)編碼。

- CLIP 視覺(jué)編碼器:用于增強(qiáng)主體表示的編碼。

- 解耦的實(shí)例感知route模塊:用于準(zhǔn)確感知和預(yù)測(cè)主體的隱條件區(qū)域,實(shí)現(xiàn)靈活和可控的個(gè)性化生成。

達(dá)到的效果:

- 在保留主體細(xì)節(jié)、對(duì)齊文本描述和個(gè)性化多個(gè)主體方面表現(xiàn)優(yōu)異。

- 實(shí)現(xiàn)了單主體和多主體個(gè)性化的一致性,同時(shí)遵循文本提示。

方法

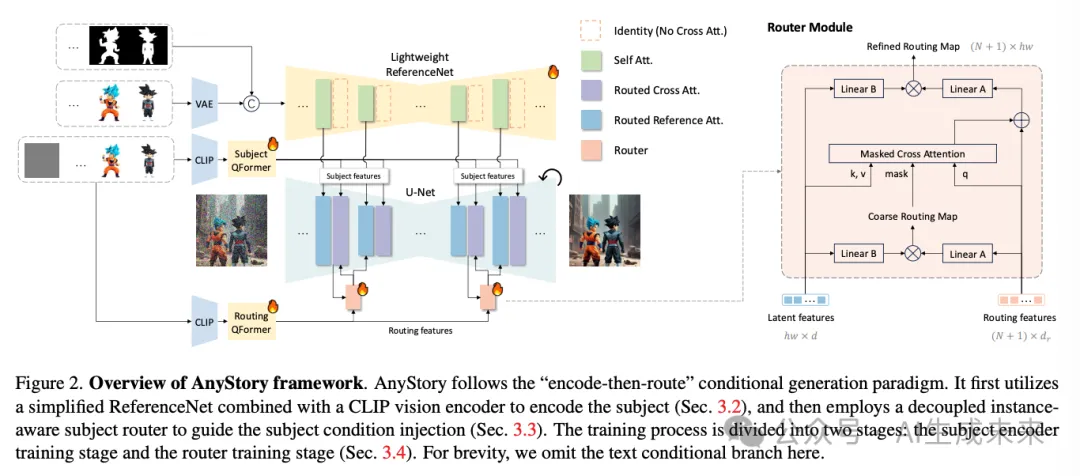

AnyStory,這是一種在文本到圖像生成中實(shí)現(xiàn)單主體和多主體個(gè)性化的開(kāi)創(chuàng)性方法。首先回顧擴(kuò)散模型的背景,然后詳細(xì)介紹兩個(gè)提出的關(guān)鍵組件,即增強(qiáng)的主體編碼器和解耦的實(shí)例感知主體router。最后,介紹本文的訓(xùn)練方案。方法的框架如下圖 2 所示。

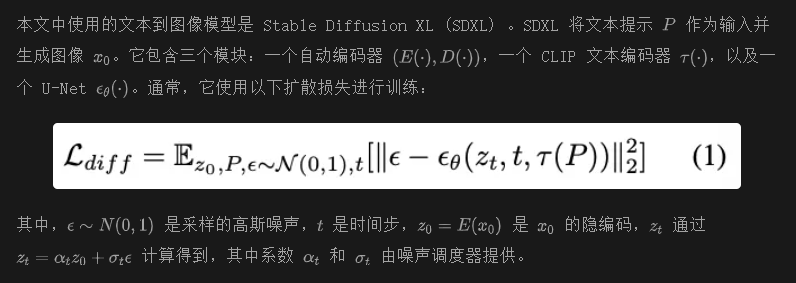

預(yù)備知識(shí)

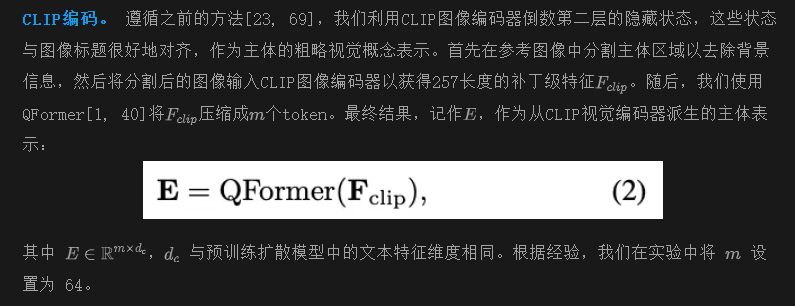

增強(qiáng)的主體表示編碼

在開(kāi)放領(lǐng)域中個(gè)性化主體圖像,同時(shí)確保對(duì)主體細(xì)節(jié)和文本描述的忠實(shí)度,仍然是一個(gè)未解決的問(wèn)題。一個(gè)關(guān)鍵的挑戰(zhàn)在于主體信息的編碼,這需要在最大限度地保留主體特征的同時(shí),保持一定的編輯能力。當(dāng)前主流方法[16, 39, 44, 46, 56, 66, 69, 70]主要依賴CLIP視覺(jué)編碼器來(lái)編碼主體。然而,由于對(duì)比圖像-文本訓(xùn)練范式的原因,CLIP的特征主要是語(yǔ)義性的,并且分辨率較低(通常為224 × 224),因此在提供主體詳細(xì)信息方面存在局限性。替代方法[19, 41, 48, 64]結(jié)合了特定領(lǐng)域的專(zhuān)家模型,如面部編碼器[12, 29],以增強(qiáng)主體身份表示。盡管這些方法取得了一定的成功,但它們?cè)谄漕I(lǐng)域內(nèi)是有限的,不能擴(kuò)展到一般主體。

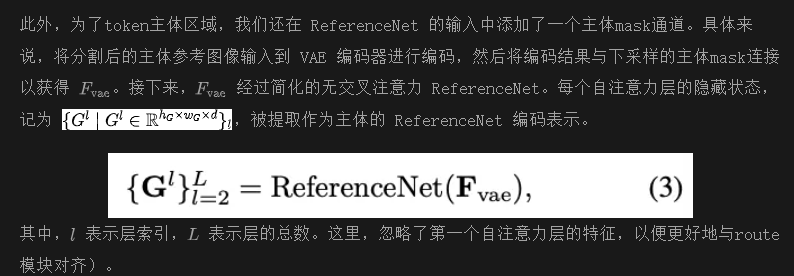

為了解決這些問(wèn)題,引入了ReferenceNet,一種強(qiáng)大而多功能的圖像編碼器,與CLIP視覺(jué)編碼器一起編碼主體。ReferenceNet利用變分自編碼器(VAE)來(lái)編碼參考圖像,然后通過(guò)與U-Net相同架構(gòu)的網(wǎng)絡(luò)提取其特征。它具有三個(gè)顯著優(yōu)勢(shì):(1)支持更高分辨率的輸入,從而能夠保留更多的主體細(xì)節(jié);(2)其特征空間與去噪U(xiǎn)-Net對(duì)齊,便于U-Net在不同深度和尺度上直接提取主體特征;(3)使用預(yù)訓(xùn)練的U-Net權(quán)重進(jìn)行初始化,這些權(quán)重具有豐富的視覺(jué)先驗(yàn),并在學(xué)習(xí)一般主體概念方面表現(xiàn)出良好的泛化能力。

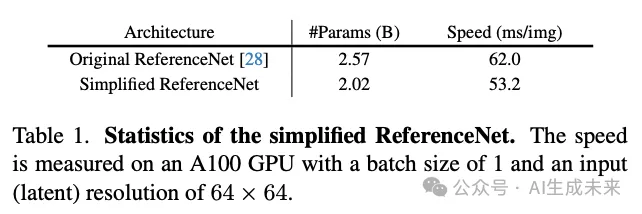

ReferenceNet 編碼。 在原始實(shí)現(xiàn)中ReferenceNet 采用與 U-Net 相同的架構(gòu),包括帶有文本條件注入的交叉注意力塊。然而,由于在我們的任務(wù)中 ReferenceNet 僅用作視覺(jué)特征提取器,并不需要文本條件注入,我們跳過(guò)了所有交叉注意力塊,從而減少了參數(shù)數(shù)量和計(jì)算復(fù)雜度(見(jiàn)下表 1)。

解耦的實(shí)例感知主體route

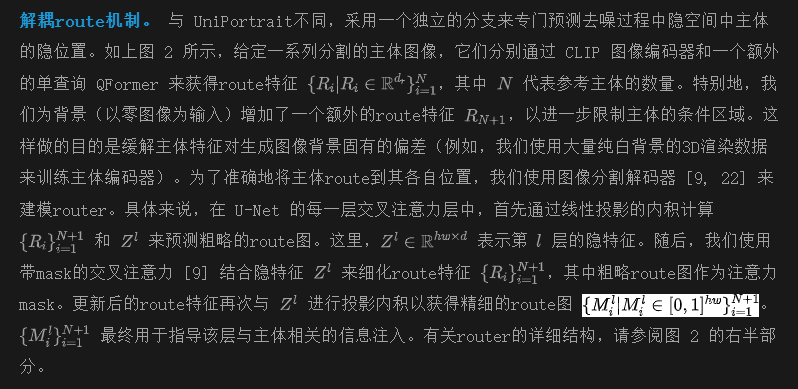

注入主體條件時(shí)需要仔細(xì)考慮注入位置,以避免影響不相關(guān)的目標(biāo)。以前的方法 [37, 39, 56, 66, 69, 70] 通常通過(guò)簡(jiǎn)單的注意力模塊將條件特征注入隱空間。然而,由于軟加權(quán)機(jī)制,這些方法容易出現(xiàn)語(yǔ)義泄漏 [10, 67],導(dǎo)致主體特征的混合,特別是在生成外觀相似的實(shí)例時(shí)。一些方法 [18, 34, 38, 44, 46, 65, 71] 引入了預(yù)定義的布局mask來(lái)解決這個(gè)問(wèn)題,但這限制了它們的實(shí)際應(yīng)用。UniPortrait [23] 提出了一種router,可以自適應(yīng)地感知并限制主體條件的影響區(qū)域;然而,其route特征完全與主體特征耦合,這限制了route模塊的能力;此外,它沒(méi)有考慮主體條件對(duì)背景的影響。在本研究中,我們提出了一種解耦的實(shí)例感知主體route模塊,可以準(zhǔn)確有效地將主體特征route到相應(yīng)區(qū)域,同時(shí)減少對(duì)不相關(guān)區(qū)域的影響。

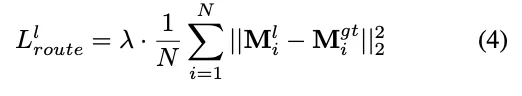

實(shí)例感知route正則化損失。 為了促進(jìn)router學(xué)習(xí)并區(qū)分不同實(shí)例的主體,我們引入了一種實(shí)例感知route正則化損失。損失函數(shù)定義為:

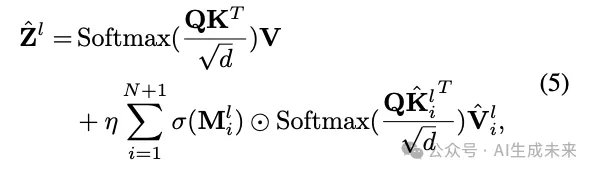

route引導(dǎo)的主體信息注入。 對(duì)于CLIP編碼的主體表示,我們使用解耦的交叉注意力 [69] 將其整合到U-Net中,但增加了route引導(dǎo)的定位約束:

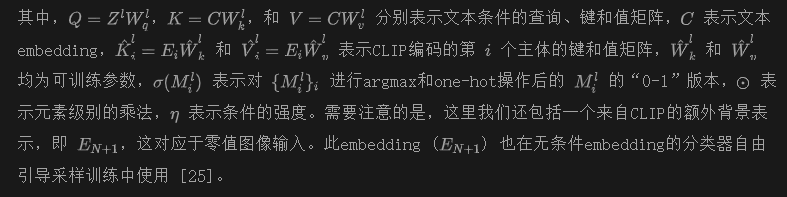

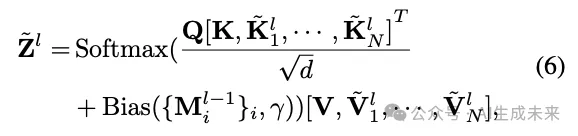

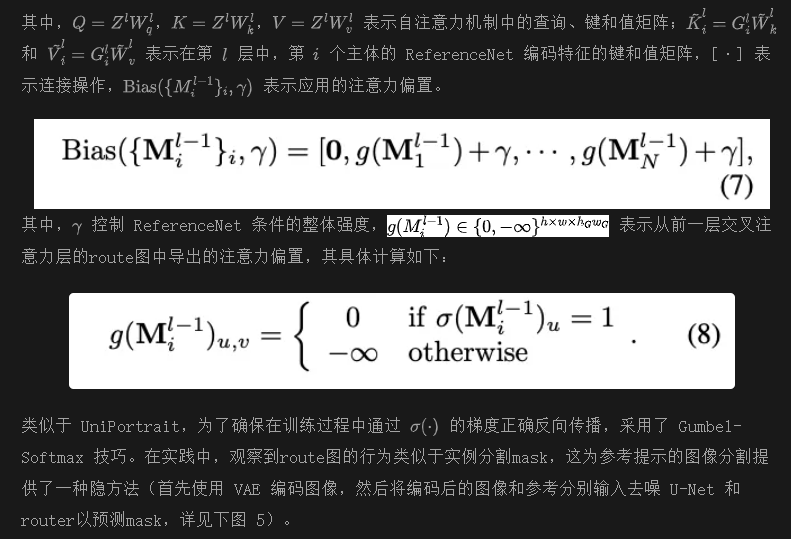

關(guān)于ReferenceNet編碼的主體特征的注入,采用原始參考注意力,但增加了由route圖引導(dǎo)的額外注意力mask。稍微濫用一下符號(hào),這個(gè)過(guò)程可以表示為:

訓(xùn)練

根據(jù) UniPortrait,AnyStory 的訓(xùn)練過(guò)程分為兩個(gè)階段:主體編碼器訓(xùn)練階段和router訓(xùn)練階段。

主體編碼器訓(xùn)練:訓(xùn)練主體 QFormer、ReferenceNet 及注意力塊中的對(duì)應(yīng)鍵和值矩陣。ReferenceNet 使用預(yù)訓(xùn)練的 UNet 權(quán)重進(jìn)行初始化。為了避免主體特征的細(xì)粒度編碼導(dǎo)致的復(fù)制粘貼效應(yīng),收集了大量配對(duì)數(shù)據(jù),這些數(shù)據(jù)在保持主體身份一致的同時(shí)展示了背景、姿勢(shì)和視角的變化。這些數(shù)據(jù)來(lái)自于圖像、視頻和 3D 渲染數(shù)據(jù)庫(kù),并由 Qwen2-VL 進(jìn)行標(biāo)注。具體來(lái)說(shuō),圖像(約 41 萬(wàn))和視頻(約 52 萬(wàn))數(shù)據(jù)主要來(lái)自以人為中心的數(shù)據(jù)集,如 DeepFashion2 和人類(lèi)舞蹈視頻,而 3D 數(shù)據(jù)(約 560 萬(wàn))則來(lái)自 Objaverse ,其中從七個(gè)不同角度渲染的物體圖像作為配對(duì)數(shù)據(jù)。在訓(xùn)練過(guò)程中,這些配對(duì)中的一張圖像用作參考輸入,而另一張圖像則在不同的背景下展示相同的主體身份,作為預(yù)測(cè)目標(biāo)。此外,還對(duì)參考圖像應(yīng)用了包括隨機(jī)旋轉(zhuǎn)、裁剪和零填充在內(nèi)的數(shù)據(jù)增強(qiáng)技術(shù),以進(jìn)一步防止主體過(guò)擬合。該階段的訓(xùn)練損失與原始擴(kuò)散損失相同,如公式(1)所示。

實(shí)驗(yàn)

設(shè)置

使用 stable diffusion XL 作為基礎(chǔ)模型。所使用的 CLIP 圖像編碼器是 OpenAI 的 clip-vit-huge-patch14。主體 QFormer 和route QFormer 都由 4 層組成。ReferenceNet 的輸入圖像分辨率為 512×512。所有訓(xùn)練在 8 個(gè) A100 GPU 上進(jìn)行,批大小為 64,使用 AdamW優(yōu)化器,學(xué)習(xí)率為 1e-4。為了促進(jìn)無(wú)分類(lèi)器引導(dǎo)的采樣 [25],在訓(xùn)練時(shí)對(duì) 10% 的圖像去掉 CLIP 主體條件。在推理過(guò)程中,使用 25 步 EDM采樣和 7.5 的無(wú)分類(lèi)器引導(dǎo)比例,并使用來(lái)自 huggingface 的 RealVisXL V4.0 模型以實(shí)現(xiàn)更逼真的圖像生成。

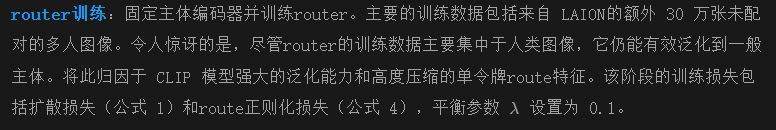

ReferenceNet 編碼器的效果

下圖 3 展示了 ReferenceNet 編碼器的有效性,相較于僅使用 CLIP 視覺(jué)編碼器,它增強(qiáng)了主體細(xì)節(jié)的保留。然而,顯然僅使用 ReferenceNet 并不能產(chǎn)生令人滿意的結(jié)果。事實(shí)上,在大量測(cè)試中發(fā)現(xiàn),ReferenceNet 編碼器只能實(shí)現(xiàn)主體細(xì)節(jié)的對(duì)齊,而不能引導(dǎo)主體生成。仍然需要依賴與文本embedding良好對(duì)齊的 CLIP 編碼特征來(lái)觸發(fā)主體生成。

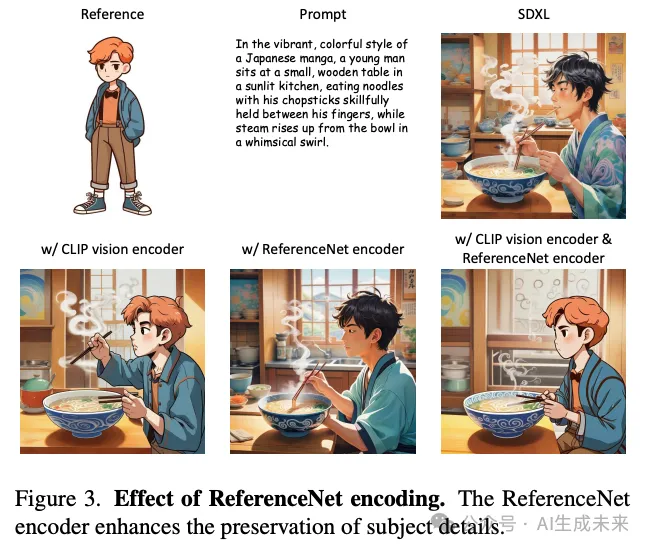

解耦實(shí)例感知router的效果

下圖 4 展示了所提出router的有效性,它可以有效避免多主體生成中主體之間的特征混合。此外,觀察到在單主體設(shè)置中使用router也提高了生成圖像的質(zhì)量,特別是在圖像背景中。這是因?yàn)閞outer限制了主體條件的影響區(qū)域,從而減少了主體特征固有的隱偏差(例如,從大量 3D 渲染數(shù)據(jù)中學(xué)習(xí)到的簡(jiǎn)單白色背景偏好)對(duì)生成圖像質(zhì)量的影響。

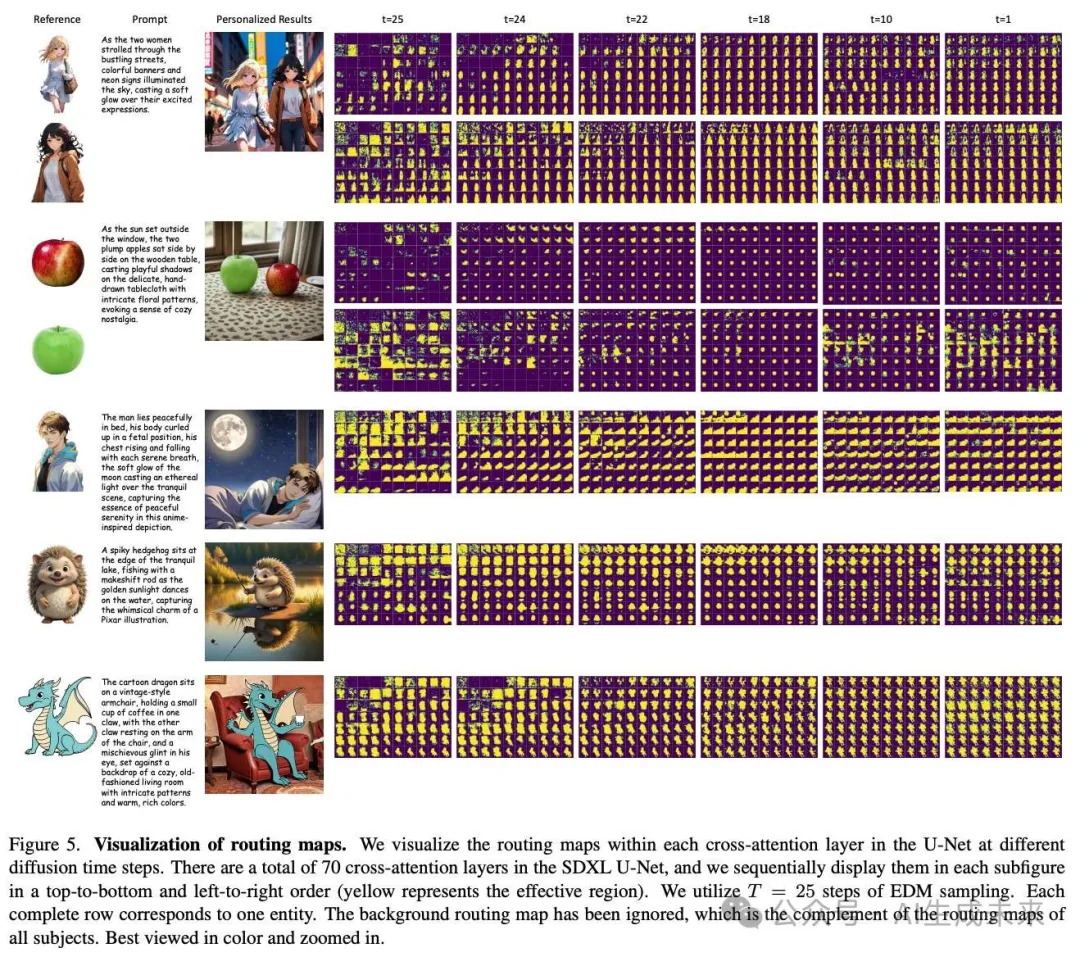

上圖 5 可視化了擴(kuò)散模型在去噪過(guò)程中不同時(shí)間步的route圖。這些結(jié)果表明,所提出的router可以在去噪過(guò)程中準(zhǔn)確感知并定位每個(gè)主體條件的影響區(qū)域。顯示的route圖類(lèi)似于圖像分割mask,表明通過(guò)去噪 U-Net 和訓(xùn)練好的router可以實(shí)現(xiàn)基于參考圖像的引導(dǎo)圖像分割的潛力。此外,如前文所述,盡管router主要在以人為中心的數(shù)據(jù)集上訓(xùn)練,但它對(duì)一般主體(如上圖 5 中的卡通恐龍)具有良好的泛化能力。我們將此歸因于 CLIP 模型強(qiáng)大的泛化能力和高度壓縮的單token route特征。

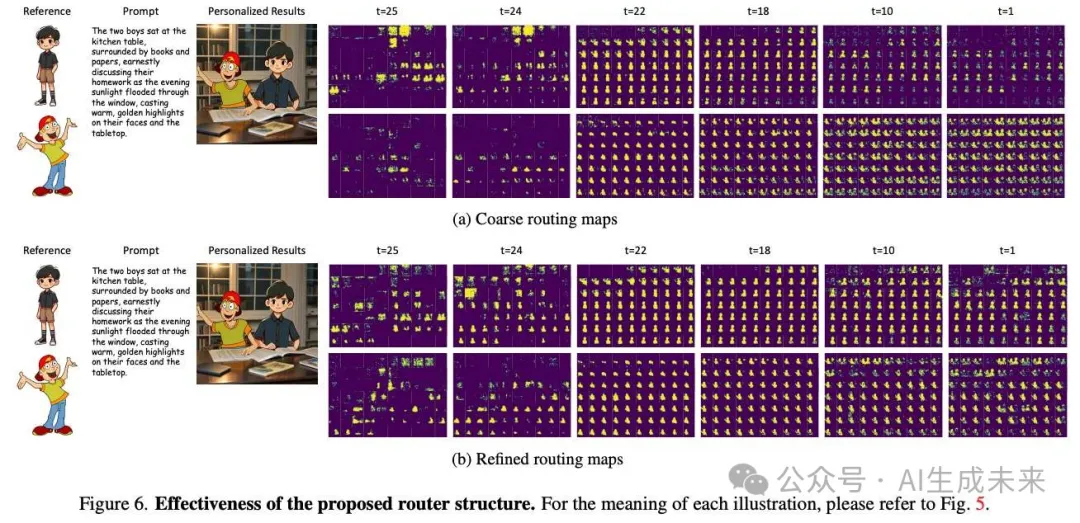

下圖 6 展示了將router建模為微型圖像分割解碼器的有效性。與通過(guò)簡(jiǎn)單點(diǎn)積獲得的粗略route圖相比,通過(guò)輕量級(jí)mask交叉注意模塊細(xì)化后的route圖可以更準(zhǔn)確地預(yù)測(cè)每個(gè)主體的隱位置。

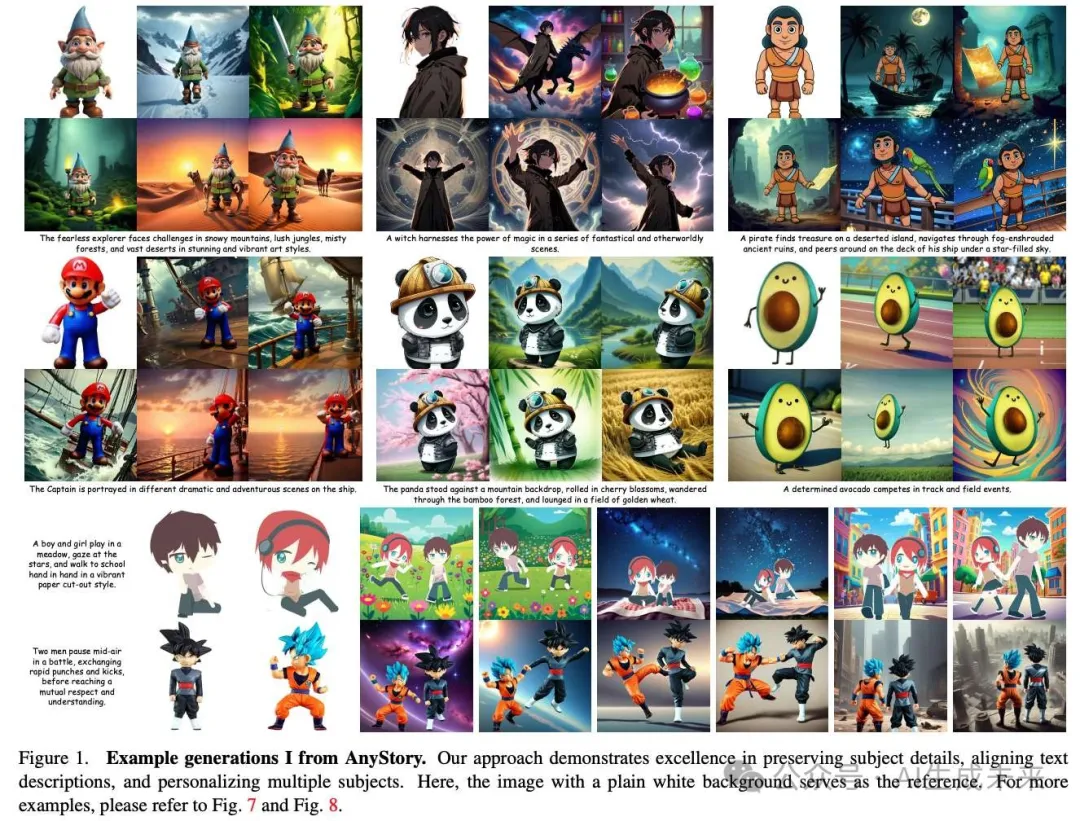

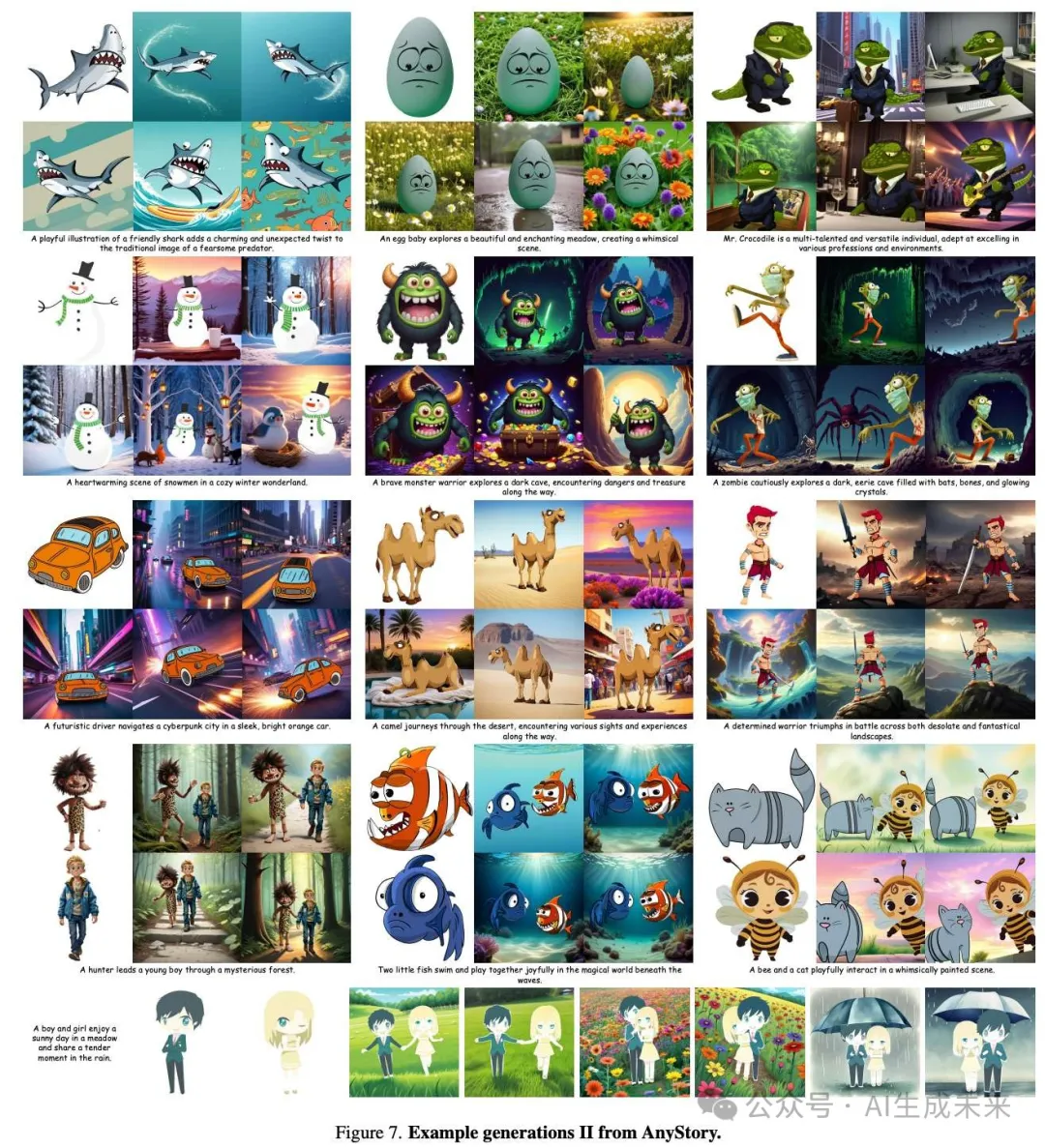

示例生成

在上圖 1、上圖 7 和上圖 8 中,展示了本方法的更多結(jié)果,顯示了其在保持主體細(xì)節(jié)、對(duì)齊文本提示以及實(shí)現(xiàn)多主體個(gè)性化方面的卓越性能。

結(jié)論

AnyStory是一種針對(duì)單主體和多主體個(gè)性化生成的統(tǒng)一方法。AnyStory 利用通用且強(qiáng)大的 ReferenceNet 以及 CLIP 視覺(jué)編碼器來(lái)實(shí)現(xiàn)高保真度的主體編碼,并采用解耦的、實(shí)例感知的route模塊,以靈活和準(zhǔn)確地注入單/多主體條件。實(shí)驗(yàn)結(jié)果表明,本方法在保留主體細(xì)節(jié)、與文本描述對(duì)齊以及多主體個(gè)性化方面表現(xiàn)出色。

局限性和未來(lái)工作。 目前,AnyStory 無(wú)法為圖像生成個(gè)性化背景。然而,在序列圖像生成中保持圖像背景的一致性同樣重要。未來(lái),將擴(kuò)展 AnyStory 的控制能力,從主體域擴(kuò)展到背景域。此外,AnyStory 生成的主體中仍然存在復(fù)制粘貼效應(yīng),我們計(jì)劃通過(guò)數(shù)據(jù)增強(qiáng)和使用更強(qiáng)大的文本到圖像生成模型來(lái)進(jìn)一步緩解這一問(wèn)題。

本文轉(zhuǎn)自AI生成未來(lái) ,作者:AI生成未來(lái)