多模態(tài)大模型能力評(píng)測(cè)基準(zhǔn)全面綜述:理解、推理、生成、應(yīng)用、趨勢(shì) 精華

隨著人工智能的快速發(fā)展,多模態(tài)大型語(yǔ)言模型(MLLMs)已經(jīng)成為理解視覺(jué)數(shù)據(jù)和語(yǔ)言上下文的關(guān)鍵技術(shù)。這些模型能夠處理和生成結(jié)合文本、圖像和其他模態(tài)的內(nèi)容,但如何有效評(píng)估它們的性能一直是個(gè)挑戰(zhàn)。本文通過(guò)全面回顧現(xiàn)有的多模態(tài)基準(zhǔn)測(cè)試,為研究人員提供了評(píng)估MLLMs性能的工具和方法,這對(duì)于推動(dòng)人工智能技術(shù)的發(fā)展具有重要意義。

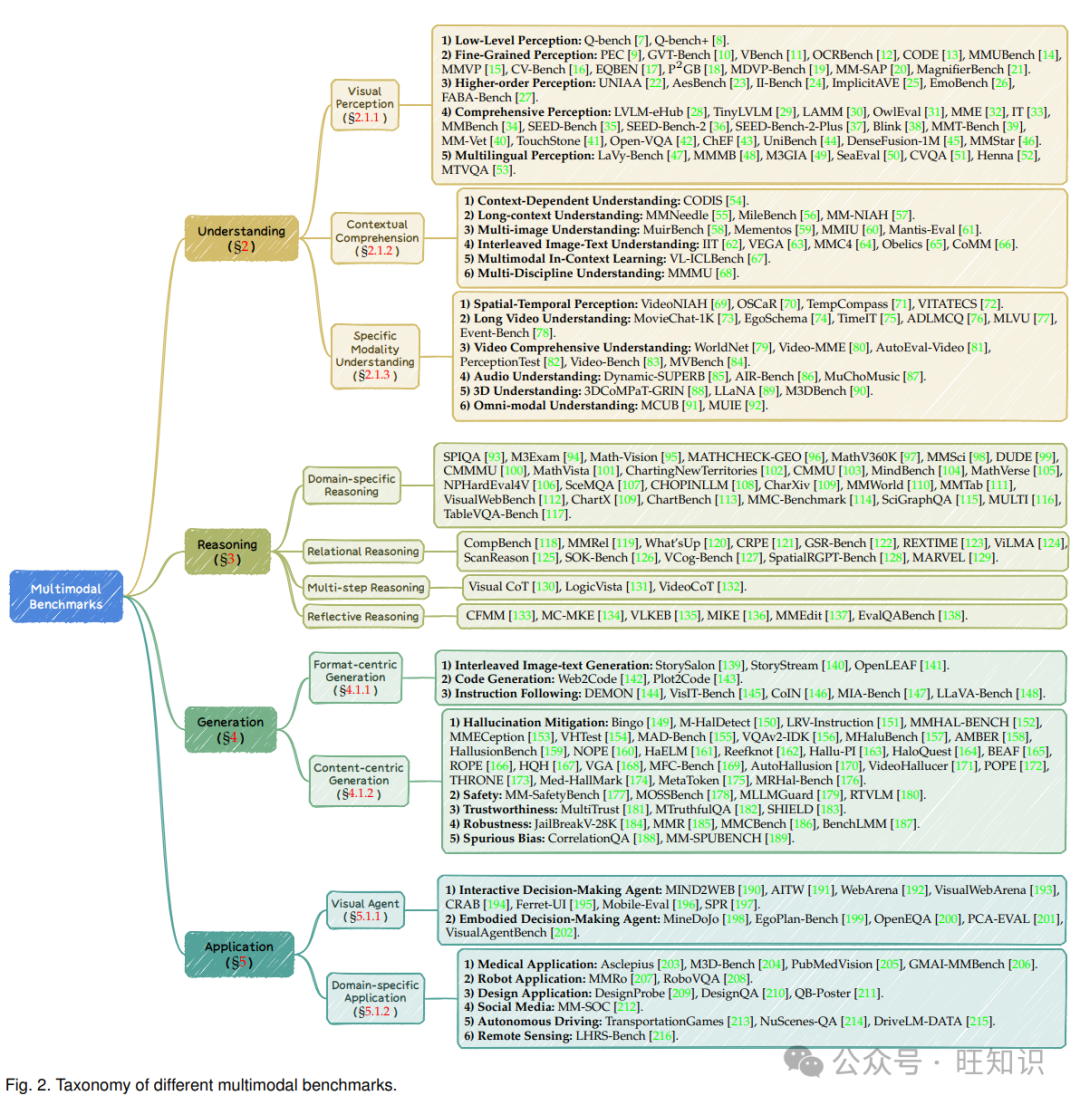

多模態(tài)大型語(yǔ)言模型(MLLMs)的快速發(fā)展為人工智能帶來(lái)了重大進(jìn)步,顯著增強(qiáng)了理解和生成多模態(tài)內(nèi)容的能力。盡管以往的研究主要集中在模型架構(gòu)和訓(xùn)練方法上,但對(duì)用于評(píng)估這些模型的基準(zhǔn)測(cè)試的徹底分析仍然鮮有探索。本綜述通過(guò)系統(tǒng)回顧211個(gè)評(píng)估MLLMs的基準(zhǔn)測(cè)試,填補(bǔ)了這一空白,涵蓋了理解、推理、生成和應(yīng)用四個(gè)核心領(lǐng)域。我們提供了任務(wù)設(shè)計(jì)、評(píng)估指標(biāo)和數(shù)據(jù)集構(gòu)建的詳細(xì)分析,跨越了多種模態(tài)。我們希望本綜述能夠通過(guò)提供基準(zhǔn)測(cè)試實(shí)踐的全面概述并確定未來(lái)工作的有前途的方向,為MLLM研究的持續(xù)進(jìn)步做出貢獻(xiàn)。相關(guān)的GitHub倉(cāng)庫(kù)收集了最新的論文。

1 引言

人工智能(AI)的快速發(fā)展與健壯基準(zhǔn)測(cè)試的發(fā)展密切相關(guān)。這些基準(zhǔn)測(cè)試提供了評(píng)估和比較AI模型性能的客觀指標(biāo)。作為計(jì)算機(jī)視覺(jué)的先驅(qū),ImageNet提供了一個(gè)大規(guī)模且注釋良好的數(shù)據(jù)集,為開(kāi)發(fā)既高度準(zhǔn)確又廣泛泛化的模型鋪平了道路。AI模型和基準(zhǔn)測(cè)試的發(fā)展是互補(bǔ)的。例如,隨著分類基準(zhǔn)測(cè)試在數(shù)據(jù)量和類別多樣性方面的增長(zhǎng),其上訓(xùn)練的模型顯著改進(jìn),從而在現(xiàn)實(shí)世界中的性能得到了提升。這種特定任務(wù)基準(zhǔn)測(cè)試與模型架構(gòu)之間的協(xié)同作用一直是AI實(shí)際應(yīng)用的基石。

最近在大型語(yǔ)言模型(LLMs)方面的突破,例如ChatGPT,已經(jīng)在眾多研究領(lǐng)域引起了重大變化,并深刻影響了各種社會(huì)和工業(yè)部門(mén)。利用LLM作為大腦,多模態(tài)大型語(yǔ)言模型(MLLMs),例如GPT-4v和Gemini,彌合了視覺(jué)數(shù)據(jù)和語(yǔ)言上下文之間的差距,使這些模型能夠理解和生成結(jié)合文本、圖像和其他模態(tài)的內(nèi)容。盡管它們具有巨大的潛力,但基準(zhǔn)測(cè)試的發(fā)展并沒(méi)有總是跟上相應(yīng)MLLMs的演變。傳統(tǒng)基準(zhǔn)測(cè)試通常關(guān)注增加數(shù)據(jù)量或類別數(shù)量,難以充分評(píng)估MLLMs的多方面能力。

這引出了一個(gè)自然的問(wèn)題:我們?nèi)绾斡行У卦u(píng)估這些大型AI模型的各種能力和可靠性?目前,用于AI模型的多模態(tài)基準(zhǔn)測(cè)試領(lǐng)域豐富多樣(見(jiàn)圖1),包括視覺(jué)問(wèn)答和圖像字幕等多種任務(wù)。這種多樣性無(wú)疑推動(dòng)了MLLMs的發(fā)展,為研究人員提供了多個(gè)途徑來(lái)探索和改進(jìn)他們的模型。然而,眾多基準(zhǔn)測(cè)試是一把雙刃劍。眾多基準(zhǔn)測(cè)試的數(shù)量使其難以導(dǎo)航,尤其是對(duì)于新手來(lái)說(shuō):

- 目標(biāo)不一致:每個(gè)基準(zhǔn)測(cè)試都有不同的目標(biāo),導(dǎo)致研究領(lǐng)域碎片化。研究人員必須投入大量時(shí)間來(lái)確定現(xiàn)有基準(zhǔn)測(cè)試是否充分測(cè)試了MLLMs的能力,這使得開(kāi)發(fā)新的、一致的基準(zhǔn)測(cè)試變得復(fù)雜。

- 任務(wù)飽和:由多樣化目標(biāo)驅(qū)動(dòng)的任務(wù)激增,導(dǎo)致了一個(gè)壓倒性的領(lǐng)域。這種飽和使得很難辨別真正創(chuàng)新或有影響力的基準(zhǔn)測(cè)試,導(dǎo)致寶貴的資源被忽視或利用不足。

- 指標(biāo)演變與差異:盡管一些研究提出了設(shè)計(jì)良好的指標(biāo),但它們的采用受到基準(zhǔn)測(cè)試快速演變和頻繁更新的阻礙。這種不一致性迫使研究人員在傳統(tǒng)和新指標(biāo)之間進(jìn)行復(fù)雜的平衡,使得公平比較變得復(fù)雜,并阻礙了對(duì)MLLMs的全面評(píng)估。為了解決這一差距,我們提出了一個(gè)全面的綜述,系統(tǒng)回顧了當(dāng)前多模態(tài)基準(zhǔn)測(cè)試的能力、任務(wù)設(shè)計(jì)、數(shù)據(jù)集構(gòu)建和特定設(shè)計(jì)的指標(biāo)。

本綜述從理解、推理、生成和應(yīng)用的角度審視這些方面:

理解。它指的是從多模態(tài)數(shù)據(jù)中提取和整合特征以執(zhí)行跨模態(tài)分析的能力。這涉及解釋視覺(jué)表示、識(shí)別關(guān)鍵細(xì)節(jié)、把握語(yǔ)義含義并準(zhǔn)確回應(yīng)相關(guān)問(wèn)題的任務(wù)。評(píng)估這些能力是基礎(chǔ)性的,因?yàn)樗鼈儤?gòu)成了MLLMs在多樣化任務(wù)和應(yīng)用中更廣泛功能的基礎(chǔ)。

推理。它超越了基本理解,包括執(zhí)行復(fù)雜推理和跨模態(tài)得出邏輯結(jié)論的能力。這包括需要模型處理和操縱信息的任務(wù),使它們能夠基于跨模態(tài)數(shù)據(jù)解決問(wèn)題和做出決策。強(qiáng)大的推理能力對(duì)于MLLMs處理需要更深層次認(rèn)知處理的復(fù)雜任務(wù)至關(guān)重要。

生成。它涉及基于多模態(tài)輸入創(chuàng)建新內(nèi)容,例如從圖像生成描述性文本或從文本描述生成視覺(jué)內(nèi)容。這種能力對(duì)于需要?jiǎng)?chuàng)造力、連貫性和準(zhǔn)確性的實(shí)際應(yīng)用至關(guān)重要。

應(yīng)用。它探索了評(píng)估MLLMs在現(xiàn)實(shí)世界場(chǎng)景中的實(shí)際應(yīng)用的基準(zhǔn)測(cè)試。它包括具身AI、基于智能體的任務(wù)和特定領(lǐng)域的應(yīng)用,如醫(yī)療診斷和自主系統(tǒng)。這一類別的基準(zhǔn)測(cè)試評(píng)估模型如何整合多種模態(tài)以在動(dòng)態(tài)和交互式環(huán)境中執(zhí)行復(fù)雜任務(wù)。

2 理解基準(zhǔn)測(cè)試

2.1 背景和分類

MLLMs的快速發(fā)展突出了全面基準(zhǔn)測(cè)試的必要性,以評(píng)估它們?cè)诙喾N數(shù)據(jù)類型中的理解能力[64],[217]。本節(jié)回顧了旨在評(píng)估MLLMs感知和理解以各種格式呈現(xiàn)的信息的多模態(tài)理解基準(zhǔn)測(cè)試。這些基準(zhǔn)測(cè)試對(duì)于微調(diào)MLLMs至關(guān)重要,確保它們?cè)诂F(xiàn)實(shí)世界應(yīng)用中的健壯性和泛化能力[77],[189]。最近的理解決基準(zhǔn)測(cè)試關(guān)注于評(píng)估MLLMs的多個(gè)方面,例如,視覺(jué)感知、上下文理解和特定模態(tài)理解。

2.1.1 視覺(jué)感知

視覺(jué)感知能力是理解基準(zhǔn)測(cè)試的一個(gè)基礎(chǔ)方面。它涉及提取顯著特征和準(zhǔn)確識(shí)別和解釋視覺(jué)元素(例如,多個(gè)對(duì)象、文本信息和復(fù)雜的情感或隱含線索)的能力[45]。本節(jié)將視覺(jué)感知基準(zhǔn)測(cè)試分為三組:低級(jí)感知、細(xì)粒度感知、高階感知和綜合感知。

- 低級(jí)感知。MLLMs中的低級(jí)感知涉及檢測(cè)和解釋基本視覺(jué)屬性(例如,顏色、照明、構(gòu)圖)和扭曲(例如,模糊、噪聲、偽影)的能力,這些不需要推理或外部知識(shí)[7],[8]。這些低級(jí)感知能力對(duì)于各種應(yīng)用至關(guān)重要,包括推薦系統(tǒng)、相機(jī)系統(tǒng)指導(dǎo)和視覺(jué)質(zhì)量增強(qiáng)[7]。

- 細(xì)粒度感知。這個(gè)核心維度代表了圖像理解的復(fù)雜水平,關(guān)注于視覺(jué)內(nèi)容的詳細(xì)和微妙方面。它包括識(shí)別和解釋微妙特征的能力,例如文本識(shí)別(OCRBench [12])、視覺(jué)-語(yǔ)言概念和模式(例如,SPEC [9] 和 MMVP [15]),以及在高分辨率圖像中識(shí)別小對(duì)象(例如,V* Bench [11] MagnifierBench [21],P2GB [18])。具體來(lái)說(shuō),MDVPBench [19]專注于評(píng)估模型對(duì)細(xì)粒度像素級(jí)理解的能力,包括詳細(xì)描述、相互關(guān)系分析和跨多樣化視覺(jué)元素的復(fù)雜推理。此外,一些基準(zhǔn)測(cè)試還強(qiáng)調(diào)視覺(jué)-語(yǔ)言對(duì)齊,這指的是模型準(zhǔn)確鏈接視覺(jué)元素與相應(yīng)文本描述的能力。例如,Eqben [17]專注于“稍微”錯(cuò)位的對(duì)的等變對(duì)話,這些對(duì)的語(yǔ)義漂移最小,與明顯不匹配的對(duì)相比,它們更難區(qū)分。與視覺(jué)概念識(shí)別和對(duì)齊不同,MMUBench [20]評(píng)估MLLMs中的機(jī)器遺忘能力,即有效遺忘視覺(jué)概念識(shí)別的能力。而MM-SAP [14]評(píng)估MLLMs的自我意識(shí)能力,即理解它們能和不能從圖像中感知什么。

- 高階感知能力

- 綜合感知。綜合感知基準(zhǔn)測(cè)試全面評(píng)估MLLMs執(zhí)行廣泛視覺(jué)識(shí)別任務(wù)的能力[28]– [30],[32],[34],[36],[38]–[40],涉及各種類型的視覺(jué)內(nèi)容。根據(jù)輸入語(yǔ)言類型,基準(zhǔn)測(cè)試分為:1) 單語(yǔ)言感知,評(píng)估在廣泛使用的英語(yǔ)中跨多樣化內(nèi)容類型的總體視覺(jué)識(shí)別[29],[35]– [37],[43]。具體來(lái)說(shuō),MM-Vet專注于不同核心VL能力的整合能力,即識(shí)別、OCR、知識(shí)、語(yǔ)言生成、空間意識(shí)和數(shù)學(xué)。與感知評(píng)估不同,DenseFusion-1M [45] 和 IT [33] 創(chuàng)建了超詳細(xì)的圖像注釋,以賦予MLLMs詳細(xì)的文本識(shí)別和高分辨率圖像感知能力,以及一些圖像描述質(zhì)量的評(píng)估基準(zhǔn),例如DID-Bench,D2I-Bench和LIN-Bench [33]。2) 多語(yǔ)言感知,評(píng)估模型理解和解釋多種語(yǔ)言中的視覺(jué)內(nèi)容的能力,強(qiáng)調(diào)它們?cè)诓煌Z(yǔ)言和文化背景下的適應(yīng)性[47],[49]–[53]。

2.1.2 上下文理解

它指的是MLLMs理解和解釋受周?chē)舷挛挠绊懙男畔⒌哪芰Α8鶕?jù)不同的輸入上下文格式,這些基準(zhǔn)測(cè)試分為以下幾組:

- 上下文依賴?yán)斫狻ODIS [54]定義上下文依賴?yán)斫鉃槟P蜏?zhǔn)確識(shí)別單個(gè)圖像中的視覺(jué)元素的能力,帶有補(bǔ)充的上下文文本信息(例如,位置和方向)[54]。這對(duì)于使用上下文線索解決歧義至關(guān)重要。

- 長(zhǎng)上下文理解。它評(píng)估MLLMs從長(zhǎng)序列中保持連貫性和提取相關(guān)信息的能力[55]–[57]。這對(duì)于MLLMs尤其重要,特別是在現(xiàn)實(shí)世界應(yīng)用中,如多輪對(duì)話[219],動(dòng)作識(shí)別[220]和科學(xué)論文理解[93]。

- 多圖像理解。這種能力涉及比較多個(gè)圖像之間的一致性和變化,使模型能夠通過(guò)識(shí)別模式和解釋復(fù)雜的視覺(jué)動(dòng)態(tài)來(lái)獲得更全面的見(jiàn)解。它通常由MuirBench [58],Mementos [59],Mantis-Eval [61]和MMIU [60]評(píng)估。

- 交錯(cuò)圖像-文本理解。它表示MLLMs有效管理和解釋混合的文本和視覺(jué)數(shù)據(jù)流的能力,這對(duì)于現(xiàn)實(shí)世界設(shè)置中的動(dòng)態(tài)多媒體交互至關(guān)重要[64],[66]。具體來(lái)說(shuō),VL-ICLBench [67]評(píng)估多模態(tài)上下文學(xué)習(xí)能力,其中MLLMs在不更新模型參數(shù)的情況下,從幾個(gè)輸入-輸出示例中學(xué)習(xí)新任務(wù)。而MMMU [68]專注于具有特定領(lǐng)域知識(shí)的多學(xué)科多模態(tài)理解。鑒于示例和學(xué)科的交錯(cuò)圖像-文本格式,這些能力被認(rèn)為是一種交錯(cuò)圖像-文本理解。

2.1.3 特定模態(tài)理解

在多模態(tài)理解中,MLLMs被評(píng)估其處理和整合來(lái)自不同感官模態(tài)的輸入的能力,如視頻、音頻、3D數(shù)據(jù)和全模態(tài)環(huán)境。每種模態(tài)都提出了獨(dú)特的挑戰(zhàn),要求模型在內(nèi)部分析信息并在不同輸入類型之間進(jìn)行綜合。以下是每種模態(tài)所需的關(guān)鍵能力:

- 視頻。與靜態(tài)圖像不同,視頻捕獲動(dòng)態(tài)序列,要求模型解釋空間和時(shí)間信息。1) 空間-時(shí)間感知。這涉及區(qū)分不同的時(shí)間方面,如速度、方向(例如,TempCompass [71])和對(duì)象狀態(tài)變化(例如,OSCAR [221]),以及理解隨時(shí)間演變的復(fù)雜概念[69]。因?yàn)樵S多人類語(yǔ)言中的關(guān)鍵概念,例如動(dòng)作,具有超出靜態(tài)圖像范圍的時(shí)間維度,VITATECS [72]專注于時(shí)間概念理解。2) 長(zhǎng)視頻理解。長(zhǎng)視頻由于計(jì)算復(fù)雜性、內(nèi)存需求以及模型需要維持長(zhǎng)期時(shí)間連接的需要,提出了額外的挑戰(zhàn)[73]。典型的基準(zhǔn)測(cè)試是MovieChat-1K [73],EgoSchema [74],MLVU [77]。TimeChat [75]通常專注于內(nèi)在時(shí)間戳定位能力。由于視頻中缺乏豐富的事件,MLLMs可能遭受捷徑偏差。因此,Event-Bench [78]專門(mén)評(píng)估事件理解,專注于原子、復(fù)合和整體事件理解。3) 綜合感知。Video-MME [80]和Video-Bench [83]包含對(duì)時(shí)間和空間動(dòng)態(tài)的全面理解,整合多層感知以完全理解視頻中的連續(xù)性和上下文。AutoEval [81]和WorldNet [79]專注于現(xiàn)實(shí)世界場(chǎng)景,分別針對(duì)開(kāi)放式的視頻理解和狀態(tài)轉(zhuǎn)換。此外,ADLMCQ [76]專注于日常生活活動(dòng)場(chǎng)景,進(jìn)一步豐富了對(duì)視頻中日常人類動(dòng)作的理解。

- 音頻。音頻數(shù)據(jù)挑戰(zhàn)模型解釋復(fù)雜的聽(tīng)覺(jué)信息,包括語(yǔ)音、音樂(lè)和環(huán)境聲音,要求理解時(shí)間模式和上下文細(xì)微差別。Dynamic-SUPERB測(cè)試了語(yǔ)音模型在廣泛的音頻處理挑戰(zhàn)中的泛化能力,使用指令調(diào)整,強(qiáng)調(diào)它們?cè)诹銟颖厩闆r下處理多樣化和未見(jiàn)場(chǎng)景的能力。AIR-Bench [86]評(píng)估大型音頻-語(yǔ)言模型在音頻中心交互能力上理解并解釋廣泛的音頻信號(hào),從人類語(yǔ)音到自然聲音,通過(guò)基于文本的格式促進(jìn)無(wú)縫交互。MuChoMusic [87]專注于評(píng)估MLLMs中的音樂(lè)理解,檢查它們?cè)诓煌幕凸δ鼙尘跋掳盐蘸屯评砀鞣N音樂(lè)概念的能力。

- 3D。與2D圖像不同,3D數(shù)據(jù)要求模型理解深度、體積和空間關(guān)系,挑戰(zhàn)它們解釋復(fù)雜形狀和結(jié)構(gòu)[88]。3DCoMPaT-GRIN [88]評(píng)估模型的部件感知理解能力,以識(shí)別和分割3D對(duì)象的部件,這有助于彌合當(dāng)前MLLMs能力和復(fù)雜的人類類感知之間的差距。LLaNA [89]作為NeRFs的第一個(gè)基準(zhǔn)測(cè)試,專注于模型的NeRFs理解能力,直接處理NeRF權(quán)重,捕獲有關(guān)3D場(chǎng)景的幾何和外觀的詳細(xì)信息。M3DBench [90]通過(guò)結(jié)合多模態(tài)輸入擴(kuò)展了3D理解,推動(dòng)模型整合空間推理和視覺(jué)理解,以與復(fù)雜的3D環(huán)境互動(dòng)。

- 全模態(tài)理解。它評(píng)估MLLMs同時(shí)處理和整合來(lái)自多種模態(tài)的輸入的能力,展示它們識(shí)別跨多樣化感官數(shù)據(jù)的共同模式和相關(guān)性的能力。MCUB [91]評(píng)估MLLMs在無(wú)縫解釋和綜合來(lái)自各種來(lái)源的輸入的能力,增強(qiáng)跨模態(tài)推理和泛化。MUIE [92]進(jìn)一步挑戰(zhàn)MLLMs在細(xì)粒度多模態(tài)基礎(chǔ)定位,測(cè)試它們?cè)诳缥谋尽⒁纛l、圖像和視頻輸入提取和鏈接信息的熟練程度。

2.2 多模態(tài)任務(wù)和指標(biāo)

理解基準(zhǔn)測(cè)試的多模態(tài)任務(wù)和指標(biāo)設(shè)計(jì)圍繞兩個(gè)主要維度構(gòu)建:面向能力的任務(wù)和指標(biāo),衡量特定能力,以及面向格式的指標(biāo),確保評(píng)估與生成的輸出類型一致。更多詳細(xì)信息顯示在表1中。

2.2.1 面向能力的任務(wù)和指標(biāo)

本節(jié)概述了各種理解基準(zhǔn)測(cè)試的任務(wù)和指標(biāo)設(shè)計(jì)。低級(jí)感知。正如Q-bench [7]所提出的,低級(jí)屬性識(shí)別涉及與扭曲和其他低級(jí)屬性相關(guān)的問(wèn)題,例如光線。除了單圖像,Q-bench+ [8]進(jìn)一步引入了圖像對(duì)之間的比較。這兩個(gè)基準(zhǔn)測(cè)試然后擴(kuò)展到低級(jí)描述任務(wù),使MLLMs描述圖像的質(zhì)量和其他低級(jí)信息。為了評(píng)估精確的質(zhì)量評(píng)估能力,Q-Bench [7]引入了一種基于softmax的質(zhì)量評(píng)估策略,而不是直接解碼標(biāo)記,提取“好”和“差”結(jié)果的對(duì)數(shù),并通過(guò)在這兩個(gè)對(duì)數(shù)之間應(yīng)用softmax池化來(lái)預(yù)測(cè)可量化的分?jǐn)?shù)。

細(xì)粒度感知。

這些任務(wù)旨在評(píng)估模型解釋和分析視覺(jué)內(nèi)容的詳細(xì)和微妙方面的能力。具體來(lái)說(shuō),給定輸入圖像,子任務(wù)可以分為

1) 多類識(shí)別:識(shí)別圖像中是否存在某些對(duì)象[9],[10]。

2) 對(duì)象屬性:識(shí)別對(duì)象的特定屬性,如顏色、紋理和狀態(tài)[11],[15]。

3) 對(duì)象計(jì)數(shù):確定圖像中特定對(duì)象的實(shí)例數(shù)量[9]。

4) 對(duì)象位置:表示對(duì)象相對(duì)于圖像的位置[9],[13]。由于上下文在對(duì)象檢測(cè)中的重要性,CODE基準(zhǔn)測(cè)試[13]通過(guò)上下文豐富的環(huán)境更好地評(píng)估模型,增強(qiáng)了任務(wù)設(shè)計(jì)。

5) 空間關(guān)系:推理兩個(gè)或多個(gè)對(duì)象之間的空間關(guān)系[9]。

6) 光學(xué)字符識(shí)別(OCR):識(shí)別查詢區(qū)域內(nèi)的文本[12]。具體來(lái)說(shuō),CV-Bench [16]將2D細(xì)粒度感知擴(kuò)展到3D,并引入了深度順序和相對(duì)距離任務(wù)。與視覺(jué)概念識(shí)別不同,MM-SAP [14]設(shè)計(jì)了三個(gè)自我意識(shí)評(píng)估任務(wù):BasicVisQA測(cè)試“已知已知”問(wèn)題,通過(guò)提出五個(gè)多項(xiàng)選擇答案,包括一個(gè)拒絕選項(xiàng)。KnowVisQA評(píng)估視覺(jué)知識(shí)(例如,品牌、地標(biāo))與類似的多項(xiàng)選擇輸出。BeyondVisQA關(guān)注“已知未知”,要求模型識(shí)別無(wú)法回答的問(wèn)題并選擇拒絕選項(xiàng)。

高階感知。

1) 情感識(shí)別:從圖像中識(shí)別情感表達(dá)。EmoBench [26]擴(kuò)展了這些通用情感任務(wù),增加了情感應(yīng)用任務(wù)(例如,幽默、仇恨和諷刺檢測(cè))。

2) 含義理解:給定圖像和一組多項(xiàng)選擇問(wèn)題,具有固定的可能答案,模型必須選擇最能解釋圖像的視覺(jué)隱含含義[24]或價(jià)值[25]的正確答案。

3) 美學(xué)理解:如UNIAA [22]所定義,它首先通過(guò)問(wèn)題從圖像中識(shí)別美學(xué)屬性(例如,內(nèi)容和主題),然后提供美學(xué)描述,最后通過(guò)數(shù)量分?jǐn)?shù)進(jìn)行美學(xué)評(píng)估。AesBench [23]進(jìn)一步結(jié)合了美學(xué)解釋,使MLLMs解釋和分析美學(xué)質(zhì)量的原因。

綜合感知。

例如LVLMeHub [28],TinyLVLM [29],LAMM [30]和OwlEval [31]的基準(zhǔn)測(cè)試,結(jié)合了人類判斷或基于GPT的評(píng)估,以提供全面的評(píng)估,但可能會(huì)引入偏差。為此,像MME [32]和MMBench [34]這樣的基準(zhǔn)測(cè)試使用了像二元判斷陳述或多項(xiàng)選擇問(wèn)題這樣的結(jié)構(gòu)化格式,以提供更客觀的評(píng)估。然而,相對(duì)較小的規(guī)模可能導(dǎo)致不穩(wěn)定性。因此,SEED-Bench [35],以及SEED-Bench2 [36]和SEED-Bench-2-Plus [37],在多樣化多模態(tài)生成、層次化和文本豐富的場(chǎng)景中分別提供了大規(guī)模評(píng)估。超越傳統(tǒng)的識(shí)別任務(wù),像Blink [38]和MMTBench [39]這樣的基準(zhǔn)測(cè)試測(cè)試了微妙的感知能力和多模態(tài)推理,而MM-Vet [40]設(shè)計(jì)了能力整合任務(wù)。然而,多項(xiàng)選擇格式有時(shí)未能捕捉到現(xiàn)實(shí)世界的復(fù)雜性,這更好地由開(kāi)放式基準(zhǔn)測(cè)試如TouchStone [41]和OpenVQA [42]解決。ChEF [43]引入了相對(duì)ICL準(zhǔn)確性和相對(duì)魯棒性,用于多選QA,以衡量上下文學(xué)習(xí)和魯棒性,特別強(qiáng)調(diào)超越隨機(jī)猜測(cè)的改進(jìn)。M3GIA [49]引入了通用智能準(zhǔn)確性(GIA)指標(biāo),利用驗(yàn)證性因子分析來(lái)驗(yàn)證MLLMs的認(rèn)知結(jié)構(gòu)與人類智能的一致性。然而,傳統(tǒng)評(píng)估方法在多模態(tài)訓(xùn)練期間難以處理數(shù)據(jù)泄露,MMStar [46]通過(guò)引入兩個(gè)指標(biāo)來(lái)解決這個(gè)問(wèn)題:多模態(tài)增益(MG)衡量視覺(jué)輸入的改進(jìn),以及多模態(tài)泄漏(ML)檢測(cè)意外的數(shù)據(jù)暴露,確保公平比較。

上下文依賴?yán)斫狻?/strong>

衡量這種能力的典型任務(wù)是上下文依賴圖像消歧:給定一個(gè)查詢和一個(gè)帶有兩種不同上下文的圖像,MLLMs需要生成正確的響應(yīng)[54]。為了更好地衡量在不同上下文中識(shí)別的能力,CODIS [54]設(shè)計(jì)了上下文意識(shí)指標(biāo)。

多圖像理解。

它通常結(jié)合多圖像輸入任務(wù),如動(dòng)作識(shí)別和圖表理解[58],[60]。具體來(lái)說(shuō),Mementos [59]專注于復(fù)雜任務(wù)的監(jiān)控和解密圖像序列中對(duì)象的位置變化。它使用GPT-4可靠地提取和標(biāo)準(zhǔn)化AI生成的描述中的對(duì)象和行為關(guān)鍵詞,將這些列表與人類基準(zhǔn)進(jìn)行比較以評(píng)估準(zhǔn)確性。

長(zhǎng)上下文理解。

最近的基準(zhǔn)測(cè)試[55]–[57]采用針 haystack任務(wù):這項(xiàng)任務(wù)通過(guò)在長(zhǎng)無(wú)關(guān)圖像和文本語(yǔ)料庫(kù)(haystack)中準(zhǔn)確找到相應(yīng)的信息(針)來(lái)評(píng)估MLLM的長(zhǎng)上下文理解能力。具體來(lái)說(shuō),MMNeedle [55]引入了“圖像haystack”,其中模型必須定位由給定標(biāo)題描述的特定子圖像。MileBench [56]擴(kuò)展了這個(gè)概念,包括“文本針在haystack中”和“圖像針在haystack中”任務(wù)。在文本任務(wù)中,模型從密集的多模態(tài)上下文中提取7位密碼,而在圖像任務(wù)中,它識(shí)別并檢索嵌入在圖像中的文本,需要OCR能力。MM-NIAH [57]進(jìn)一步測(cè)試多模態(tài)文檔中的長(zhǎng)上下文理解,專注于跨不同“多模態(tài)針”的檢索、計(jì)數(shù)和推理任務(wù)。MMNeedle [55]引入了一組評(píng)估指標(biāo),即存在準(zhǔn)確性、索引準(zhǔn)確性和精確準(zhǔn)確性,全面評(píng)估MLLMs在序列、圖像和子圖像級(jí)別的表現(xiàn)。

交錯(cuò)圖像-文本理解。

通常,給定交錯(cuò)的圖像-文本內(nèi)容(例如,上下文示例),模型必須有效地響應(yīng)查詢(例如,QA或字幕格式)[24],[65],[66],[68]。VEGA [63]引入了交錯(cuò)圖像-文本理解任務(wù),其中模型不僅基于更長(zhǎng)的圖像-文本序列回答問(wèn)題,還識(shí)別與響應(yīng)相關(guān)的特定圖像索引。VL-ICLBench [67]通過(guò)包括八個(gè)任務(wù)擴(kuò)展了這一點(diǎn),評(píng)估多模態(tài)上下文學(xué)習(xí)能力。

空間-時(shí)間感知。

VideoNIAH [69]涉及檢索、排序和計(jì)數(shù)插入到視頻序列中的視覺(jué)“針”,挑戰(zhàn)模型準(zhǔn)確處理和分析長(zhǎng)上下文視頻中的空間和時(shí)間信息。對(duì)于時(shí)間感知,VTATES [72]通過(guò)使用反事實(shí)描述來(lái)識(shí)別六個(gè)細(xì)粒度方面——方向、強(qiáng)度、序列、定位、組合性和類型——同時(shí)保持靜態(tài)內(nèi)容一致,修改只有時(shí)間信息。

長(zhǎng)視頻理解。

Event-Bench [78]專注于以事件為導(dǎo)向的長(zhǎng)視頻理解,并提出了層次化任務(wù)分類法,包括原子事件理解(例如,事件描述)、復(fù)合事件理解(例如,時(shí)間推理)和整體理解(例如,上下文推理)。由于一些長(zhǎng)期視頻任務(wù)實(shí)際上是短期任務(wù)的偽裝,EgoSchema [74]引入了時(shí)間證書(shū)的概念,以衡量視頻剪輯的內(nèi)在時(shí)間復(fù)雜性。

綜合視頻理解。

Video-Bench [83]包括10個(gè)精心設(shè)計(jì)的任務(wù),涵蓋三個(gè)不同的層次:視頻專有理解、基于先驗(yàn)知識(shí)的問(wèn)題回答和理解與決策。MVBench [84]系統(tǒng)地將靜態(tài)圖像任務(wù)轉(zhuǎn)換為動(dòng)態(tài)視頻任務(wù),使評(píng)估在開(kāi)放世界場(chǎng)景中的一系列時(shí)間技能成為可能。與專注于計(jì)算任務(wù)(例如分類)的現(xiàn)有基準(zhǔn)測(cè)試不同,PerceptionTest [82]強(qiáng)調(diào)技能(記憶、抽象、物理、語(yǔ)義)和推理類型(描述性、解釋性、預(yù)測(cè)性、反事實(shí)性)在視頻、音頻和文本模態(tài)上的跨模態(tài),提供了一個(gè)全面且高效的評(píng)估工具。

音頻理解。

Dynamic-SUPERB [85]專門(mén)關(guān)注六個(gè)維度的分類任務(wù)——內(nèi)容、說(shuō)話者、語(yǔ)義、退化、副語(yǔ)言學(xué)和音頻處理——使用指令調(diào)整來(lái)評(píng)估模型處理已見(jiàn)和未見(jiàn)場(chǎng)景的能力。AIR-Bench [86]獨(dú)特地結(jié)合了基礎(chǔ)和基于聊天的音頻任務(wù)的層次化評(píng)估,涵蓋所有音頻類型。

3D理解。

為了評(píng)估3D MLLMs的部件感知理解能力,3DCoMPaT-GRIN [88]引入了兩個(gè)新任務(wù):部件感知點(diǎn)定位和部件感知點(diǎn)定位字幕。在部件感知點(diǎn)定位中,模型根據(jù)用戶指令預(yù)測(cè)部件級(jí)別的分割掩模。在部件感知點(diǎn)定位字幕中,模型生成一個(gè)詳細(xì)的字幕,包括部件級(jí)別的描述,每個(gè)描述對(duì)應(yīng)一個(gè)分割掩模。對(duì)于NeRF理解,LLaNA [89]專注于像字幕和QA這樣的任務(wù),以評(píng)估模型如何通過(guò)NeRF權(quán)重解釋3D場(chǎng)景的幾何和逼真表示。

全模態(tài)理解。

MCUB [91]評(píng)估模型識(shí)別來(lái)自不同模態(tài)的輸入實(shí)體的共同點(diǎn)的能力,挑戰(zhàn)它從四個(gè)給定選項(xiàng)中選擇最合適的答案。具體來(lái)說(shuō),MUIE [92]強(qiáng)調(diào)視覺(jué)定位,并引入了地面多模態(tài)通用信息提取的概念,涉及跨文本、圖像、音頻和視頻輸入提取和關(guān)聯(lián)信息,確保實(shí)體和事件準(zhǔn)確鏈接到它們對(duì)應(yīng)的模態(tài)。

2.2.2 面向格式的指標(biāo)設(shè)計(jì)

在評(píng)估MLLMs時(shí),使用不同的輸出格式來(lái)評(píng)估模型準(zhǔn)確和適當(dāng)?shù)仨憫?yīng)各種類型查詢的能力。根據(jù)格式,指標(biāo)可以分為以下類別:

- 二元/多項(xiàng)選擇:1) 二元選擇。模型以簡(jiǎn)單的是/否響應(yīng),測(cè)試其直接決策的能力。2) 多項(xiàng)選擇:模型被呈現(xiàn)幾個(gè)可能的答案,通常被鼓勵(lì)選擇一個(gè)字母(例如,A/B/C/D)[21]。這種格式有效地測(cè)試了模型在區(qū)分密切相關(guān)的選項(xiàng)并做出明確選擇的能力。典型的指標(biāo)包括準(zhǔn)確性、精確度和召回率。為了增強(qiáng)魯棒性,MMBench [34]引入了CircularEval指標(biāo),其中模型必須在多次通過(guò)中正確回答問(wèn)題,以測(cè)試其在多次傳遞中的一致性。具體來(lái)說(shuō),如果MLLMs輸出自由形式的文本,一個(gè)LLM(例如,GPT-4)被用作選擇提取器,將自由形式的答案與預(yù)定義的選擇匹配[34]。相比之下,SEED系列[35]–[37]采用了答案排名策略[222],[223]來(lái)評(píng)估模型性能,評(píng)估生成的內(nèi)容與正確選擇匹配的可能性。為了從MLLMs的輸出中提取選擇,MMTBench [39]遵循OpenCompass [224]中的三步協(xié)議:檢查選項(xiàng)字母,用ChatGPT檢查選項(xiàng)內(nèi)容,并將選擇設(shè)置為默認(rèn)選項(xiàng)字母,以避免隨機(jī)分配[68]。

- 定義形式:要求模型以定義的格式輸出。例如,生成的格式被定義為(索引,行,列)的元組在MMNeedle [55]中。具體來(lái)說(shuō),對(duì)于分類任務(wù):準(zhǔn)確性用于評(píng)估正確預(yù)測(cè)標(biāo)簽的百分比。對(duì)于檢測(cè)和定位任務(wù),平均精度均值(mAP)用于評(píng)估模型預(yù)測(cè)對(duì)象標(biāo)簽和邊界框的準(zhǔn)確性。

- 自由形式:與二元和多項(xiàng)選擇格式不同,這些格式是預(yù)定義的,自由形式響應(yīng)允許模型生成開(kāi)放式答案[21],[42]。這種格式更好地反映了現(xiàn)實(shí)世界的場(chǎng)景,用戶通常不提供預(yù)定義的選項(xiàng),模型必須依賴于其理解和創(chuàng)造力來(lái)生成上下文適當(dāng)?shù)捻憫?yīng)。像BLEU和ROUGE-L這樣的指標(biāo)通過(guò)測(cè)量與參考文本的n-gram重疊來(lái)評(píng)估生成的字幕的質(zhì)量[23],[30],[47],[56]。受到LLM-asa-Judge [225]的啟發(fā),一些基準(zhǔn)測(cè)試采用了基于LLM的評(píng)估,利用LLMs(例如,GPT-4,Gemini)來(lái)驗(yàn)證生成的響應(yīng)的準(zhǔn)確性和質(zhì)量,確保與人類評(píng)估的一致性。例如,在MM-VET [40]中,GPT-4作為主要評(píng)估者,根據(jù)正確性在0到1的范圍內(nèi)對(duì)開(kāi)放式輸出進(jìn)行評(píng)分。AutoEval [81]利用GPT-4根據(jù)特定實(shí)例的提示和規(guī)則評(píng)估答案的正確性。為了確保魯棒性,QBench [7]通過(guò)GPT輔助的5輪評(píng)估過(guò)程來(lái)評(píng)分MLLM-描述的完整性、精確性和相關(guān)性,類似于MM-Bench [34]。而TinyLVLM [29]引入了ChatGPT集成評(píng)估(CEE)指標(biāo),使用多樣化的提示和集成投票。

3 推理基準(zhǔn)測(cè)試

3.1 背景和分類

推理,從給定信息和獲得的知識(shí)中得出結(jié)論的能力,是人類水平機(jī)器智能的基石。隨著MLLMs的不斷進(jìn)步,評(píng)估它們?cè)诙鄻踊B(tài)和場(chǎng)景中的推理能力已成為迫切需要和有價(jià)值的研究課題。本節(jié)提供了專門(mén)設(shè)計(jì)來(lái)評(píng)估MLLMs推理能力的基準(zhǔn)測(cè)試的全面回顧,這些能力對(duì)于它們?cè)谛枰獜?fù)雜決策的環(huán)境中部署至關(guān)重要。

為了系統(tǒng)分析MLLMs推理評(píng)估的格局,我們將現(xiàn)有的基準(zhǔn)測(cè)試分為五個(gè)不同的組,基于它們的主要關(guān)注點(diǎn)。請(qǐng)注意,這些組并不是相互排斥的。在以下小節(jié)中,我們介紹每個(gè)類別并討論其重要性。

特定領(lǐng)域推理 [93]–[109],[109]–[117]指的是在特定領(lǐng)域或?qū)W科內(nèi)應(yīng)用專門(mén)知識(shí)和邏輯過(guò)程。與通用推理不同,它需要對(duì)特定領(lǐng)域的獨(dú)特概念、規(guī)則和方法論有深入的理解。這種推理形式在不同學(xué)科和各種復(fù)雜性水平上都是基礎(chǔ)性的。為特定領(lǐng)域推理設(shè)計(jì)的基準(zhǔn)測(cè)試不僅調(diào)查MLLMs獨(dú)立解決特定領(lǐng)域任務(wù)的潛力,還探索MLLMs是否可以支持并增強(qiáng)特定領(lǐng)域內(nèi)人類專家的能力。

關(guān)系推理 [118]–[129]指的是MLLMs識(shí)別、操縱和推理不同實(shí)體或概念之間關(guān)系的能力。現(xiàn)有工作主要涉及三種類型的關(guān)系:i) 空間關(guān)系——理解實(shí)體在物理上相對(duì)于彼此的位置或方向;ii) 時(shí)間關(guān)系——把握不同狀態(tài)之間事件的順序或時(shí)間的流逝;iii) 邏輯關(guān)系——理解概念或命題之間的抽象聯(lián)系或依賴性;以及iv) 相對(duì)關(guān)系——理解對(duì)象、場(chǎng)景或情境之間的比較概念。關(guān)系推理的基準(zhǔn)測(cè)試評(píng)估MLLMs通過(guò)理解元素之間的聯(lián)系而不是僅僅它們的個(gè)體屬性來(lái)解決問(wèn)題的能力。這些評(píng)估對(duì)于開(kāi)發(fā)能夠處理復(fù)雜、相互連接的數(shù)據(jù)和任務(wù)的AI系統(tǒng)至關(guān)重要,這些任務(wù)需要對(duì)信息關(guān)系有細(xì)微的理解。

多步推理 [101],[130]–[132]對(duì)于需要導(dǎo)航一系列相互連接的邏輯步驟的復(fù)雜認(rèn)知任務(wù)至關(guān)重要。相關(guān)基準(zhǔn)測(cè)試關(guān)注兩個(gè)關(guān)鍵方面:i) 使用預(yù)定義或上下文依賴規(guī)則進(jìn)行推理;以及ii) 通過(guò)思維鏈(CoT,將復(fù)雜任務(wù)分解為更簡(jiǎn)單、可管理的子任務(wù))進(jìn)行推理。邏輯推理要求應(yīng)用明確的邏輯規(guī)則從給定的前提中得出結(jié)論。與此同時(shí),思維鏈允許MLLM通過(guò)將困難問(wèn)題分解為一系列更簡(jiǎn)單、更直接的任務(wù)來(lái)接近它。這一類別的基準(zhǔn)測(cè)試測(cè)試MLLMs在廣泛的推理序列中保持邏輯連貫性的能力,確保每一步都邏輯地跟隨上一步并與任務(wù)的總體目標(biāo)一致。

反思推理 [133]–[137]包括MLLMs評(píng)估和提煉思想、知識(shí)等方面的能力。當(dāng)前的努力主要調(diào)查三個(gè)方面:i) 反事實(shí)思維——考慮替代場(chǎng)景和結(jié)果;ii) 分析性提問(wèn)——制定和評(píng)估獲取知識(shí)的查詢;以及iii) 知識(shí)推理——評(píng)估現(xiàn)有知識(shí)并更新非事實(shí)、過(guò)時(shí)或未知的知識(shí)。反思推理對(duì)于開(kāi)發(fā)能夠基于反饋調(diào)整策略并提高決策準(zhǔn)確性的MLLMs至關(guān)重要。關(guān)注這種推理類型的基準(zhǔn)測(cè)試衡量MLLMs在自我評(píng)估、識(shí)別和調(diào)整偏差以及進(jìn)行必要的更正以提高可靠性和性能方面的有效性。

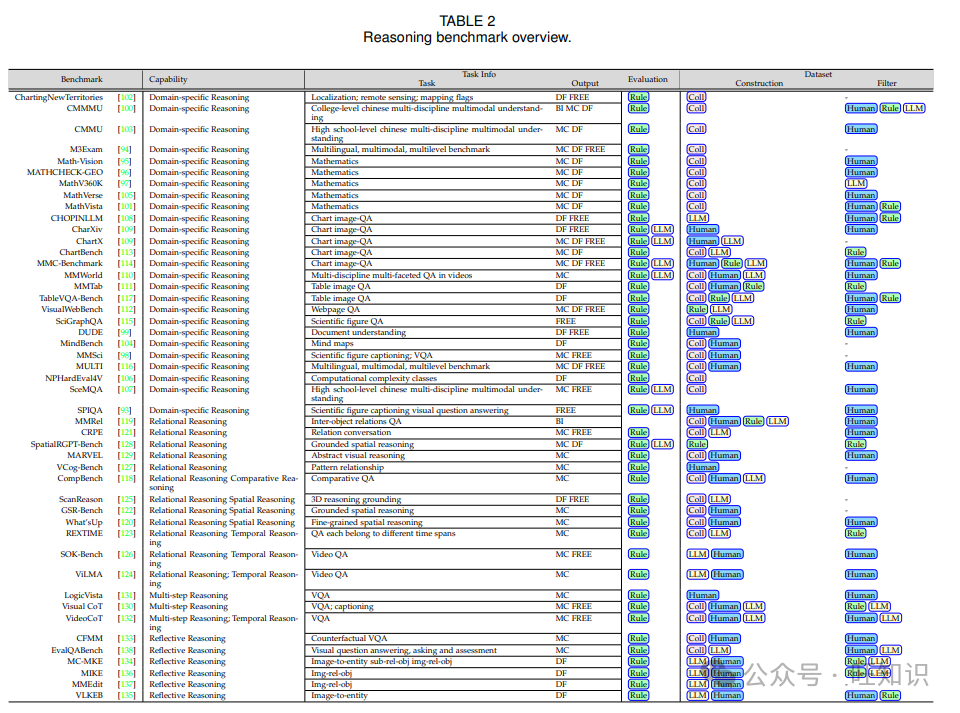

3.2 多模態(tài)任務(wù)和指標(biāo)

推理基準(zhǔn)測(cè)試的輸出格式與理解基準(zhǔn)測(cè)試相似。本節(jié)僅介紹與推理能力相關(guān)的任務(wù)和評(píng)估指標(biāo)。更多詳細(xì)信息可以在表2中找到。特定領(lǐng)域推理。當(dāng)前特定領(lǐng)域推理的任務(wù)可以根據(jù)它們所需的專門(mén)知識(shí)分為幾個(gè)組:i) 數(shù)學(xué)中心任務(wù)[95]–[97],[101],[105]。它們通常基于現(xiàn)有的基于文本的數(shù)學(xué)推理數(shù)據(jù)集,結(jié)合額外的模態(tài),如圖形的視覺(jué)表示。ii) 多語(yǔ)言和中文多學(xué)科中心任務(wù)[94],[100],[103],[107],[110],[116]。它們通常來(lái)源于中文或多種語(yǔ)言環(huán)境中的多學(xué)科問(wèn)題,從高中到博士水平的考試、筆記等。iii) 科學(xué)論文中心任務(wù)[93],[98],[115]。這些是專門(mén)為評(píng)估MLLMs在解釋各種領(lǐng)域科學(xué)研究文章中的復(fù)雜圖形和表格方面的熟練程度而設(shè)計(jì)的。iv) 其他專門(mén)領(lǐng)域任務(wù)。由于空間限制,我們列出這一類別的額外任務(wù),關(guān)注于地理和地理空間推理[102]、思維導(dǎo)圖結(jié)構(gòu)分析[104]、圖表圖像分析[108],[109],[109],[113],[114],表格圖像分析[111],[117],網(wǎng)頁(yè)分析[112],文檔分析[99],以及計(jì)算密集型場(chǎng)景[106]。所有列出任務(wù)的評(píng)估指標(biāo)主要關(guān)注中間結(jié)果和最終答案的準(zhǔn)確性。

關(guān)系推理。MLLMs的關(guān)系推理任務(wù)可以廣泛分為三種主要類型。第一種類型側(cè)重于預(yù)測(cè)關(guān)系,無(wú)論是實(shí)體之間還是模式之間。以實(shí)體為中心的任務(wù)[121]涉及檢測(cè)對(duì)象及其成對(duì)關(guān)系,而以模式為中心的任務(wù)[127],[129]旨在從給定的視覺(jué)模式中推斷關(guān)系,以預(yù)測(cè)后續(xù)模式。召回率和準(zhǔn)確性分別用于評(píng)估以實(shí)體為中心和以模式為中心的任務(wù)。第二類涉及空間中心關(guān)系,如地面空間推理[122],[128],3D空間定位[125]和細(xì)粒度空間推理[120]。像基于IoU(交并比)的準(zhǔn)確性這樣的指標(biāo)用于評(píng)估性能。第三類涉及時(shí)間中心關(guān)系,如基于不同視頻片段回答問(wèn)題[123],或執(zhí)行時(shí)間和語(yǔ)言定位[124]。這些任務(wù)的常見(jiàn)評(píng)估指標(biāo)包括準(zhǔn)確性、BLEU、BERT分?jǐn)?shù)和召回率。最后,以比較為中心的任務(wù)[118]側(cè)重于在對(duì)象、場(chǎng)景或情境之間進(jìn)行相對(duì)比較。準(zhǔn)確性用于評(píng)估。

多步推理。現(xiàn)有的多步推理任務(wù)可以廣泛分為兩種主要類型:基于規(guī)則的任務(wù)和思維鏈(CoT)任務(wù)。在基于規(guī)則的任務(wù)[101],[131]中,模型被期望應(yīng)用預(yù)定義的規(guī)則或推斷底層模式來(lái)解決問(wèn)題。例如,在尋找數(shù)學(xué)謎題中缺失值的任務(wù)[101]中,模型必須從給定的信息中推斷出控制規(guī)則。另一方面,CoT任務(wù)[130],[132]強(qiáng)調(diào)模型將問(wèn)題分解為一系列邏輯的、順序的步驟的能力。一個(gè)突出的例子是VisualCoT [130],它要求模型識(shí)別關(guān)鍵圖像區(qū)域并通過(guò)問(wèn)題逐步推理。VisualCoT提供了中間邊界框和推理注釋以促進(jìn)評(píng)估。VideoCoT [132]共享CoT推理的相同精神,但側(cè)重于視頻而不是圖像。這些基準(zhǔn)測(cè)試的指標(biāo)通常評(píng)估最終解決方案的準(zhǔn)確性以及模型的中間推理步驟與人類注釋的地面真實(shí)情況的一致性。

反思推理。反思推理任務(wù)可以廣泛分為三種類型:反事實(shí)思維、分析性提問(wèn)和知識(shí)編輯。在反事實(shí)VQA [133]中,MLLMs被要求通過(guò)基于給定事實(shí)的假設(shè)場(chǎng)景生成答案,從而評(píng)估它們執(zhí)行反事實(shí)推理的能力。例如,一個(gè)典型的問(wèn)題可能會(huì)問(wèn)“如果地面是干的,人們戴著太陽(yáng)帽而不是舉著傘,天氣可能會(huì)是什么?”。LOVA3 [138]認(rèn)為,現(xiàn)有工作主要集中在問(wèn)答上,而留下了分析性提問(wèn)——包括提問(wèn)和評(píng)估技能——在很大程度上未被探索。前兩種任務(wù)類型的評(píng)估通常使用標(biāo)準(zhǔn)指標(biāo),如準(zhǔn)確性、精確度和F1分?jǐn)?shù)。第三種類型的任務(wù),知識(shí)編輯[134]–[137],評(píng)估MLLMs更新知識(shí)的能力,特別是當(dāng)面對(duì)過(guò)時(shí)或不準(zhǔn)確的信息時(shí)。例如,VLKEB [135]引入了一跳和多跳推理任務(wù),用于知識(shí)編輯。知識(shí)編輯的指標(biāo)更為微妙,包括可靠性、普遍性、局部性、可移植性和一致性等措施。

4 生成基準(zhǔn)測(cè)試

4.1 背景和分類

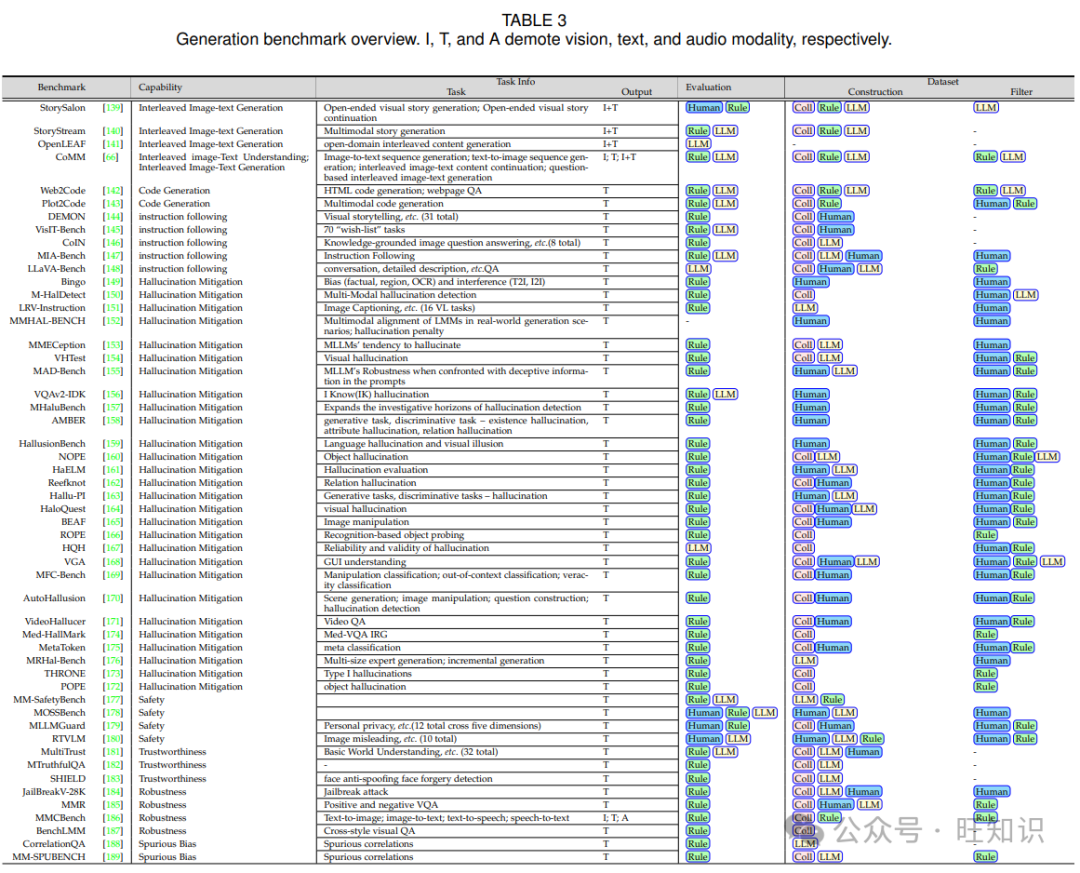

MLLMs的進(jìn)步不僅提高了理解能力,還提高了在各種格式和上下文中的生成能力。與簡(jiǎn)單的文本到圖像生成基準(zhǔn)測(cè)試不同,本節(jié)探討了旨在評(píng)估MLLMs不僅生成連貫、一致的格式,而且生成健壯、真實(shí)和安全內(nèi)容的能力的基準(zhǔn)測(cè)試。

4.1.1 以格式為中心的生成

- 交錯(cuò)圖像-文本生成。它代表了MLLMs無(wú)縫生成視覺(jué)和文本內(nèi)容的能力,這些內(nèi)容不僅同步,而且上下文相關(guān)且視覺(jué)準(zhǔn)確[64]。它挑戰(zhàn)模型在生成的輸出中保持?jǐn)⑹龊鸵曈X(jué)連貫性。最近的基準(zhǔn)測(cè)試,如MMC4 [64],OBELICS [65]和CoMM [66]在構(gòu)建通用交錯(cuò)圖像-文本對(duì)方面發(fā)揮了關(guān)鍵作用,這些對(duì)對(duì)于預(yù)訓(xùn)練或微調(diào)這些能力在MLLMs中很有用。超越這一點(diǎn),OpenLEAF [141]引入了開(kāi)放領(lǐng)域的交錯(cuò)圖像-文本生成,支持多樣化格式并擴(kuò)大了MLLMs的應(yīng)用潛力。在更專門(mén)的領(lǐng)域,StorySalon [139]和StoryStream [140]專注于視覺(jué)敘事,強(qiáng)調(diào)特定風(fēng)格的交錯(cuò)內(nèi)容創(chuàng)作。此外,StoryStream [140]通過(guò)生成長(zhǎng)序列,提出了更具挑戰(zhàn)性的設(shè)置。

- 代碼生成。它反映了MLLMs自主生成語(yǔ)法正確且功能精確的編程代碼的能力[227]。這個(gè)基準(zhǔn)測(cè)試測(cè)試了MLLMs解釋軟件需求和算法約束的能力,生成的代碼不僅能夠編譯,而且能夠根據(jù)指定的功能執(zhí)行。早期的基準(zhǔn)測(cè)試,如CodeXGLUE [227],DeepCode [228]和Codex [229]在通過(guò)結(jié)構(gòu)化的問(wèn)題陳述開(kāi)發(fā)和細(xì)化這些能力方面發(fā)揮了關(guān)鍵作用。更近期的基準(zhǔn)測(cè)試,如Web2Code [142]和PlotCode [143],將這些挑戰(zhàn)擴(kuò)展到多模態(tài)代碼生成,解決了代碼必須與多樣化數(shù)據(jù)形式交互或從其生成的復(fù)雜場(chǎng)景,如網(wǎng)頁(yè)和圖形圖表。

- 指令遵循。它表示生成與特定指令一致的內(nèi)容的能力,這對(duì)于自動(dòng)化內(nèi)容創(chuàng)作、編程和交互式系統(tǒng)基準(zhǔn)測(cè)試中的應(yīng)用至關(guān)重要。IFEval [230]評(píng)估MLLMs遵循清晰、可驗(yàn)證指令的能力,而InfoBench [231]使用分解要求遵循比率(DRFR)將復(fù)雜指令分解為更小、更易于管理的組件。然而,兩者主要關(guān)注基于文本的場(chǎng)景。相比之下,LLaVA-Bench [148]專注于視覺(jué)指令遵循,而DEMON [144]主要以交錯(cuò)的視覺(jué)-語(yǔ)言指令為特色,這與傳統(tǒng)的單圖像數(shù)據(jù)集不同。隨后,VisIT-Bench [145]評(píng)估指令遵循以響應(yīng)真實(shí)世界的圖像上下文、開(kāi)放式請(qǐng)求。它還強(qiáng)調(diào)評(píng)估指令條件字幕和推理。此外,CoIN [146]通過(guò)檢查持續(xù)的指令調(diào)整來(lái)擴(kuò)展評(píng)估,調(diào)查模型在學(xué)習(xí)新知識(shí)時(shí)如何保留現(xiàn)有技能。與此同時(shí),MIA-Bench [147]探索了MLLMs遵循分層指令并生成上下文適當(dāng)響應(yīng)的能力,提供了對(duì)指令遵循和適應(yīng)性更細(xì)致的視角。

4.1.2 以內(nèi)容為中心的生成

幻覺(jué)緩解。術(shù)語(yǔ)“幻覺(jué)”通常指的是生成的響應(yīng)包含在視覺(jué)內(nèi)容中不存在的信息的情況[232]–[235]。減少幻覺(jué)對(duì)于需要高事實(shí)保真度的應(yīng)用至關(guān)重要,如新聞寫(xiě)作和學(xué)術(shù)內(nèi)容生成。在MLLMs領(lǐng)域,幻覺(jué)通常被分為三種不同的類型:對(duì)象、屬性和關(guān)系[235]–[237]。

- 對(duì)象幻覺(jué)。當(dāng)模型生成在視覺(jué)輸入中不存在或不相關(guān)的對(duì)象時(shí),就會(huì)發(fā)生對(duì)象幻覺(jué)[160]。這些錯(cuò)誤通常源于對(duì)視覺(jué)元素的誤解或過(guò)度泛化,導(dǎo)致在生成的描述中包含與目標(biāo)圖像不一致的對(duì)象。這為視覺(jué)-語(yǔ)言(VL)模型提出了重大挑戰(zhàn),因?yàn)樗ǔ?dǎo)致無(wú)意義或不忠實(shí)的響應(yīng)[172],損害了輸出的事實(shí)完整性。解決對(duì)象幻覺(jué)對(duì)于需要精確對(duì)象識(shí)別和準(zhǔn)確場(chǎng)景理解的任務(wù)至關(guān)重要,如自動(dòng)圖像字幕和視覺(jué)推理應(yīng)用。

- 屬性幻覺(jué)。屬性幻覺(jué)指的是錯(cuò)誤生成對(duì)象特征[32],如狀態(tài)(例如,顏色或形狀),數(shù)量(例如,圖像中對(duì)象出現(xiàn)多次)或動(dòng)作(例如,人類或動(dòng)物的移動(dòng))[158],這些都偏離了視覺(jué)內(nèi)容中呈現(xiàn)的。當(dāng)模型誤解圖像中現(xiàn)有對(duì)象的屬性時(shí),就會(huì)出現(xiàn)這些錯(cuò)誤,導(dǎo)致不準(zhǔn)確性,如生成錯(cuò)誤的動(dòng)作或數(shù)量。這種誤解可能會(huì)誤導(dǎo)下游任務(wù),包括細(xì)粒度識(shí)別和產(chǎn)品檢索,因此在感知模型中緩解這些問(wèn)題至關(guān)重要,以確保準(zhǔn)確性和可靠性。

- 關(guān)系幻覺(jué)。當(dāng)模型不準(zhǔn)確地推斷對(duì)象之間的關(guān)系時(shí),就會(huì)產(chǎn)生關(guān)系幻覺(jué),例如空間排列、互動(dòng)或因果聯(lián)系,這些在視覺(jué)輸入中并未描繪。這種類型的幻覺(jué)需要更復(fù)雜的推理能力,因?yàn)樗婕皥D像中的至少兩個(gè)對(duì)象,并且可以通過(guò)感知(例如,空間術(shù)語(yǔ)如“在...上”或“在...后面”)或認(rèn)知角度(例如,抽象動(dòng)作如“吹”或“觀看”)[162]發(fā)生。這些錯(cuò)誤可能會(huì)嚴(yán)重?fù)p害模型的推理能力,特別是在需要多模態(tài)分析或視頻理解的任務(wù)中。減少關(guān)系幻覺(jué)對(duì)于提高生成輸出的連貫性和可靠性至關(guān)重要。具體來(lái)說(shuō),對(duì)于視頻模態(tài),VideoHallucer [171]檢測(cè)視頻-語(yǔ)言模型中的幻覺(jué),并將其分為內(nèi)在和外在類型,包括對(duì)象-關(guān)系、時(shí)間和語(yǔ)義細(xì)節(jié)幻覺(jué)的子類別。

安全性。安全性能力確保MLLMs生成的輸出在道德上是健全的,避免有害、誤導(dǎo)或不適當(dāng)?shù)捻憫?yīng)。這對(duì)于在敏感環(huán)境中的實(shí)際部署和維護(hù)公眾信任至關(guān)重要。例如,MM-SafetyBench [177]測(cè)試MLLMs對(duì)基于查詢的相關(guān)圖像攻擊的彈性,評(píng)估它們?nèi)绾翁幚韺?duì)抗性查詢。與此相輔相成的是,RTVLM [180]通過(guò)引入紅隊(duì)評(píng)估來(lái)擴(kuò)展安全性的范圍,在這些評(píng)估中,模型在對(duì)抗性、道德上具有挑戰(zhàn)性或有害的場(chǎng)景中進(jìn)行測(cè)試,重點(diǎn)關(guān)注關(guān)鍵領(lǐng)域,如真實(shí)性、隱私、安全性和公平性。此外,MLLMGUARD [179]擴(kuò)展到雙語(yǔ)安全評(píng)估,涵蓋五個(gè)維度的方面,確保全面性、嚴(yán)謹(jǐn)性和健壯性。與這些基準(zhǔn)測(cè)試不同,MOSSBench [178]評(píng)估MLLMs的過(guò)度敏感性,關(guān)注它們?nèi)绾尾划?dāng)?shù)鼐芙^良性查詢。

可信度。可信度測(cè)試MLLMs生成的內(nèi)容的可信度,評(píng)估信息是否可靠、來(lái)源準(zhǔn)確,并以維護(hù)道德標(biāo)準(zhǔn)的方式呈現(xiàn)。這對(duì)于新聞生成、教育內(nèi)容和其他信息完整性至關(guān)重要的應(yīng)用領(lǐng)域尤為重要。具體來(lái)說(shuō),Shield [183]旨在評(píng)估MLLMs在多個(gè)模態(tài)中檢測(cè)面部偽造和偽造攻擊的有效性。相比之下,MTruthfulQA [182]旨在評(píng)估多語(yǔ)言場(chǎng)景中LLMs的真實(shí)性。更全面地,MultiTrust [181]首次統(tǒng)一評(píng)估MLLMs在五個(gè)關(guān)鍵維度上的可信度:真實(shí)性、安全性、健壯性、公平性和隱私性,重點(diǎn)關(guān)注多模態(tài)風(fēng)險(xiǎn)和跨模態(tài)影響。

健壯性。MLLMs的健壯性指的是它們?cè)诿鎸?duì)分布偏移或輸入擾動(dòng)時(shí)保持一致性能的能力[181]。為了探索這一點(diǎn),BenchLMM [187]檢查跨風(fēng)格的視覺(jué)能力,即MLLMs如何處理三種不同的風(fēng)格:藝術(shù)、傳感器和基于應(yīng)用的變化,揭示了模型在面對(duì)非標(biāo)準(zhǔn)視覺(jué)上下文時(shí)的弱點(diǎn)。同樣,MMCBench [186]擴(kuò)展評(píng)估,測(cè)試在文本、圖像和語(yǔ)音中的常見(jiàn)腐敗下的自一致性,提供了對(duì)MLLMs跨模態(tài)健壯性的更全面視圖。在不同的背景下,MMR [185]針對(duì)誤導(dǎo)性提示的健壯性,揭示了MLLMs經(jīng)常在正確理解視覺(jué)內(nèi)容的情況下與引導(dǎo)性問(wèn)題作斗爭(zhēng)。此外,JailBreakV-28K [184]專注于可轉(zhuǎn)移性,研究針對(duì)LLMs的越獄技術(shù)如何轉(zhuǎn)移到MLLMs,強(qiáng)調(diào)了文本和基于圖像的對(duì)抗性攻擊中的漏洞,并強(qiáng)調(diào)了在多模態(tài)設(shè)置中需要更強(qiáng)的防御。CorrelationQA [188]和MM-SPUBENCH [189]都關(guān)注于評(píng)估MLLMs對(duì)偶然偏見(jiàn)的易感性。雖然CorrelationQA揭示了誤導(dǎo)性的圖像-文本對(duì)如何誘導(dǎo)幻覺(jué),但MM-SPUBENCH通過(guò)測(cè)試MLLMs對(duì)九個(gè)類別中偶然相關(guān)性的脆弱性,提供了更全面的評(píng)估。

4.2 多模態(tài)任務(wù)和指標(biāo)

本章介紹了與每種生成能力相關(guān)的設(shè)計(jì)任務(wù)和評(píng)估指標(biāo)。更多詳細(xì)信息顯示在表3中。

4.2.1 面向能力的任務(wù)和指標(biāo)

交錯(cuò)圖像-文本生成。給定包含文本和圖像的提示,此任務(wù)旨在評(píng)估模型在模態(tài)間生成連貫、交錯(cuò)內(nèi)容的能力。CoMM [66]引入了一個(gè)更具挑戰(zhàn)性的變化,基于給定問(wèn)題的交錯(cuò)圖像-文本生成,模型僅基于給定的問(wèn)題生成交錯(cuò)內(nèi)容,而不提供初始圖像信息,推動(dòng)模型推理和預(yù)測(cè)結(jié)果。StorySalon [139]和StoryStream [140]都專注于故事領(lǐng)域,涉及任務(wù)如多模態(tài)故事延續(xù)和多模態(tài)故事生成。前者專注于用文本和圖像擴(kuò)展給定的敘述,而后者挑戰(zhàn)模型從頭開(kāi)始創(chuàng)建整個(gè)敘述序列,無(wú)縫整合文本和視覺(jué)內(nèi)容。此任務(wù)的主要評(píng)估方向是生成的交錯(cuò)圖像和文本的連貫性和一致性[66],[140]。例如,OpenLEAF [141]利用BingChat [238]評(píng)估交錯(cuò)圖像-文本內(nèi)容中的實(shí)體和風(fēng)格一致性。通過(guò)采用思維鏈方法,BingChat逐步檢測(cè)和分析常見(jiàn)主題和視覺(jué)風(fēng)格因素,如色彩調(diào)色板和氛圍,以生成最終的定量分?jǐn)?shù)。

代碼生成。它涉及從各種格式的輸入創(chuàng)建編程代碼,如文本和圖像[143],甚至更復(fù)雜的網(wǎng)頁(yè)[142]。此任務(wù)旨在整合MLLMs的優(yōu)勢(shì),它們可以理解和處理多樣化數(shù)據(jù)類型,促進(jìn)將復(fù)雜的、多方面的規(guī)范轉(zhuǎn)換為可執(zhí)行代碼。對(duì)于HTML代碼生成評(píng)估,Web2Code [142]從網(wǎng)頁(yè)圖像生成HTML代碼,通過(guò)將代碼轉(zhuǎn)換回圖像并與地面真實(shí)情況進(jìn)行比較,專注于視覺(jué)保真度,而不是傳統(tǒng)的代碼級(jí)指標(biāo)。Plot2Code [143]強(qiáng)調(diào)功能性和視覺(jué)準(zhǔn)確性,通過(guò)整合傳統(tǒng)的代碼執(zhí)行檢查與使用GPT-4v和詳細(xì)文本匹配指標(biāo)的高級(jí)視覺(jué)評(píng)估,提供超出標(biāo)準(zhǔn)代碼通過(guò)率的全面評(píng)估。

指令遵循。此任務(wù)要求MLLMs生成嚴(yán)格遵循給定指令或指令的輸出。正如DEMON [144]所示,查詢輸入通常結(jié)合了定義目標(biāo)和格式的任務(wù)指令,以及提供多模態(tài)上下文的特定任務(wù)實(shí)例。對(duì)于每個(gè)指令,VisIT-Bench [145]收集了指令條件字幕,這些字幕不僅提供圖像的一般描述,還強(qiáng)調(diào)與給定指令相關(guān)的特定信息。

幻覺(jué)。視覺(jué)幻覺(jué)(VH)[154]指的是在視覺(jué)問(wèn)答期間模型生成關(guān)于圖像的錯(cuò)誤細(xì)節(jié)的實(shí)例。這包括錯(cuò)誤的前提、上下文不足和解釋視覺(jué)數(shù)據(jù)的挑戰(zhàn),如基準(zhǔn)測(cè)試HaloQuest [164]所捕獲的。此外,“我知道(IK)”幻覺(jué)[156]發(fā)生在模型提供錯(cuò)誤答案時(shí),適當(dāng)?shù)捻憫?yīng)應(yīng)該是“我不知道”,突出了MLLMs中不確定性識(shí)別的需要。CHAIR [232]通過(guò)測(cè)量模型響應(yīng)中幻覺(jué)對(duì)象的頻率來(lái)評(píng)估幻覺(jué)。在此基礎(chǔ)上,AMBER [158]通過(guò)結(jié)合幻覺(jué)問(wèn)題的精確度和召回率以及整體準(zhǔn)確性,增強(qiáng)了評(píng)估,從而在生成和判別任務(wù)中提供了更平衡的評(píng)估。此外,MMECeption [153]提供了一種無(wú)需注釋的方法,通過(guò)多次迭代評(píng)估跨模態(tài)語(yǔ)義一致性,生成GC@T分?jǐn)?shù)來(lái)量化模型的幻覺(jué)傾向。與此同時(shí),IDK指標(biāo)[156]關(guān)注模型識(shí)別和傳達(dá)不確定性的能力,如果包含預(yù)定義的IDK關(guān)鍵詞,則將響應(yīng)標(biāo)記為正確。Halr [162]旨在測(cè)量判別和生成任務(wù)中的幻覺(jué)頻率,確保在不同任務(wù)類型中保持一致的評(píng)估框架。此外,MediHall Score [174]引入了一個(gè)特定于醫(yī)療的評(píng)估指標(biāo),采用分層評(píng)分系統(tǒng),考慮幻覺(jué)的嚴(yán)重性和類型,實(shí)現(xiàn)對(duì)其潛在臨床影響的細(xì)致評(píng)估。為了提高可信度并解決MLLMs中的幻覺(jué),BEfore-AFter幻覺(jué)數(shù)據(jù)集(BEAF)[165]引入了四個(gè)關(guān)鍵指標(biāo):真理解(TU)、無(wú)知(IG)、固執(zhí)己見(jiàn)(SB)和猶豫不決(ID)。TU評(píng)估模型是否正確回答了關(guān)于移除對(duì)象的問(wèn)題,而IG在給出錯(cuò)誤答案時(shí)測(cè)量無(wú)知。SB評(píng)估模型堅(jiān)持初始答案的傾向,SBp和SBn表示一致的“是”或“否”響應(yīng)。最后,ID跟蹤與移除對(duì)象無(wú)關(guān)的問(wèn)題的答案的不必要變化。

安全性。安全性任務(wù)確保MLLMs的響應(yīng)不會(huì)導(dǎo)致有害或非法的結(jié)果。對(duì)于毒性評(píng)估,它提供了輸入,如NSFW圖像(例如,暴力或露骨內(nèi)容)與字幕查詢配對(duì),以評(píng)估模型傾向于生成有害響應(yīng)的趨勢(shì)[181]。對(duì)于越獄,它涉及測(cè)試模型對(duì)旨在繞過(guò)安全協(xié)議的提示的抵抗力(例如,帶有嵌入文本截圖的圖像詢問(wèn)非法查詢),并衡量模型是否以不違反安全指南的方式適當(dāng)響應(yīng)[181]。具體來(lái)說(shuō),在RTVLM中,給定單個(gè)圖像和紅隊(duì)問(wèn)題,MLLM被要求從安全回答、謹(jǐn)慎回答或拒絕回答中選擇。

可信度。真實(shí)性任務(wù)通過(guò)提供圖像與事實(shí)性或誤導(dǎo)性文本查詢配對(duì)的輸入來(lái)評(píng)估MLLMs,并評(píng)估它們響應(yīng)的準(zhǔn)確性[181]。具體來(lái)說(shuō),Shield [183]專注于面部反欺騙和面部偽造檢測(cè)任務(wù),要求MLLMs根據(jù)不同模態(tài)(例如,RGB、深度圖、紅外圖像)的挑戰(zhàn)性輸入,準(zhǔn)確識(shí)別真實(shí)與假面部。此外,它引入了多屬性思維鏈范式,通過(guò)分析多個(gè)屬性(例如,形狀、顏色、紋理)來(lái)增強(qiáng)推理,以實(shí)現(xiàn)更可靠和全面的決策。

健壯性。在MMR [185]中,MLLMs被給予圖像,并被要求回答正面問(wèn)題以評(píng)估視覺(jué)理解,并回答誤導(dǎo)性問(wèn)題以測(cè)試對(duì)欺騙性提示的健壯性,從多個(gè)選擇中選擇正確答案。至于偶然偏見(jiàn),MM-SPUBENCH [189]中的任務(wù)通過(guò)呈現(xiàn)圖像和文本提示來(lái)評(píng)估MLLMs,其中兩個(gè)輸入都包含核心和偶然特征。根據(jù)模型的響應(yīng)如何專注于本質(zhì)的核心特征,同時(shí)忽略不相關(guān)、誤導(dǎo)性的偶然特征,評(píng)估其對(duì)跨模態(tài)偶然偏見(jiàn)的抵抗力。

4.2.2 面向模態(tài)的指標(biāo)設(shè)計(jì)

- 僅文本。與第2.2節(jié)中提到的自由形式格式類似,它們通常應(yīng)用傳統(tǒng)的圖像字幕指標(biāo),例如ROUGE和METEOR,以及基于LLM的評(píng)估[66]。

- 僅視覺(jué)。對(duì)于評(píng)估圖像生成質(zhì)量,像Fréchet Inception Distance(FID)[239],Inception Score(IS)[240]和CLIP分?jǐn)?shù)這樣的指標(biāo)衡量與地面真實(shí)參考的視覺(jué)保真度和多樣性。為了評(píng)估風(fēng)格一致性和重建準(zhǔn)確性,采用了像結(jié)構(gòu)相似性指數(shù)度量(SSIM)和峰值信噪比(PSNR)[66]這樣的指標(biāo)。

- 跨模態(tài)。確保不同模態(tài)間內(nèi)容一致性和敘事連貫性至關(guān)重要,這在交錯(cuò)圖像-文本生成中被強(qiáng)調(diào)。評(píng)估如OpenLEAF [141],CoMM [66]和StoryStream [140]利用MLLMs評(píng)估圖像和文本之間的連貫性或一致性,通過(guò)檢查風(fēng)格、實(shí)體、內(nèi)容趨勢(shì)等。

5 應(yīng)用

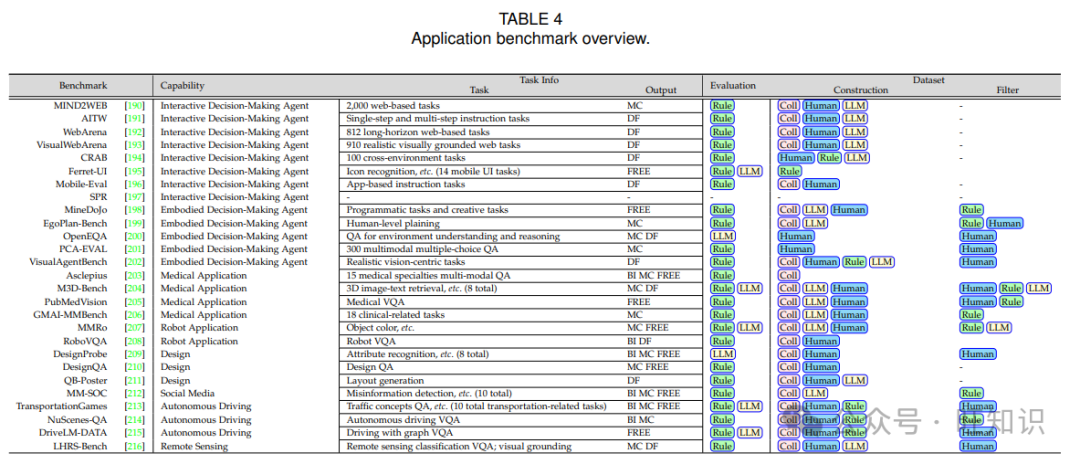

5.1 背景和分類

為了全面評(píng)估MLLMs的能力,基準(zhǔn)測(cè)試必須超越一般任務(wù),涵蓋各種應(yīng)用。本節(jié)根據(jù)它們的應(yīng)用導(dǎo)向重點(diǎn)對(duì)基準(zhǔn)測(cè)試進(jìn)行分類,提供MLLMs在不同領(lǐng)域和環(huán)境中的表現(xiàn)見(jiàn)解。

5.1.1 視覺(jué)智能體

- 交互式?jīng)Q策制定智能體。這些智能體處理視覺(jué)和文本輸入,以在不同平臺(tái)上執(zhí)行實(shí)時(shí)任務(wù)。對(duì)于網(wǎng)絡(luò)平臺(tái),像MIND2WEB [190],WebArena [192]和VisualWebArena [193]這樣的基準(zhǔn)測(cè)試評(píng)估智能體在基于網(wǎng)絡(luò)的任務(wù)上的表現(xiàn),重點(diǎn)關(guān)注導(dǎo)航和復(fù)雜內(nèi)容互動(dòng)。對(duì)于專注于移動(dòng)平臺(tái),像Ferret-UI [195]和Mobile-Eval [196],SPR [197]評(píng)估智能體與移動(dòng)UI互動(dòng)并僅基于視覺(jué)感知執(zhí)行任務(wù)的能力。AITW [191]強(qiáng)調(diào)智能體在各種Android設(shè)備上理解和執(zhí)行指令的能力。為了測(cè)試跨不同平臺(tái)的適應(yīng)性,CRAB [194]強(qiáng)調(diào)跨環(huán)境的多功能性,確保在多樣化界面中的一致性能。

- 具身決策制定智能體。這一類別的智能體專注于感官輸入整合與現(xiàn)實(shí)世界行動(dòng),模仿類似人類的決策制定。MineDoJo [198]和PCA-EVAL [201]挑戰(zhàn)智能體在模擬環(huán)境中感知、推理和協(xié)調(diào)行動(dòng)的能力。OpenEQA [200]和EgoPlan-Bench [199]專注于現(xiàn)實(shí)世界場(chǎng)景,而后者特別針對(duì)從第一人稱視角的人類水平規(guī)劃能力,要求長(zhǎng)期任務(wù)跟蹤和高級(jí)視覺(jué)推理。全面地,VisualAgentBench [202]評(píng)估MLLMs作為視覺(jué)基礎(chǔ)智能體,專注于它們?cè)趶?fù)雜、現(xiàn)實(shí)世界環(huán)境和圖形界面中的多任務(wù)能力。

5.1.2 特定領(lǐng)域應(yīng)用

- 醫(yī)療應(yīng)用。醫(yī)療MLLMs旨在增強(qiáng)多個(gè)模態(tài)和專業(yè)中的診斷準(zhǔn)確性和臨床決策制定。Asclepius [203]評(píng)估Med-MLLMs的診斷熟練能力,以匹配或超過(guò)人類水平的診斷推理,確保健壯和臨床有效的評(píng)估。M3D-Bench [204]推進(jìn)了對(duì)MLLMs在3D醫(yī)學(xué)成像中的評(píng)估,突出了它們解釋和分析復(fù)雜空間數(shù)據(jù)的能力,這對(duì)于現(xiàn)代診斷至關(guān)重要。PubMedVision [205]和GMAIMMBench [206]增強(qiáng)了視覺(jué)和文本醫(yī)學(xué)知識(shí)的整合,推進(jìn)了MLLMs通過(guò)準(zhǔn)確解釋和跨模態(tài)推理支持臨床決策制定的能力。

- 機(jī)器人應(yīng)用。機(jī)器人應(yīng)用要求MLLMs有效整合多模態(tài)感知、推理和規(guī)劃,以適應(yīng)動(dòng)態(tài)環(huán)境。RoboVQA [208]通過(guò)處理視頻輸入增強(qiáng)機(jī)器人的視覺(jué)理解和決策制定能力,以執(zhí)行復(fù)雜的現(xiàn)實(shí)世界任務(wù),而MMRo [207]評(píng)估關(guān)鍵技能,如空間推理、任務(wù)規(guī)劃和安全意識(shí),確保在安全關(guān)鍵場(chǎng)景中的有效任務(wù)執(zhí)行。

- 設(shè)計(jì)應(yīng)用。設(shè)計(jì)應(yīng)用要求MLLMs綜合細(xì)粒度視覺(jué)元素與更廣泛的布局理解。DesignProbe [209]和PosterLLaVA [211]都評(píng)估MLLMs推理設(shè)計(jì)特征如顏色、字體和布局的能力,強(qiáng)調(diào)在生成內(nèi)容感知、結(jié)構(gòu)化設(shè)計(jì)中的適應(yīng)性。此外,DesignQA [210]作為第一個(gè)零樣本基準(zhǔn)測(cè)試,評(píng)估MLLMs在工程背景下綜合復(fù)雜多模態(tài)數(shù)據(jù)的熟練程度,專注于它們解釋視覺(jué)和文本信息的能力。

- 社交應(yīng)用。它挑戰(zhàn)MLLMs解釋多模態(tài)輸入,整合社交、環(huán)境和行為線索。1) 社交媒體。在社交媒體背景下,MLLMs必須導(dǎo)航動(dòng)態(tài)和多樣化的內(nèi)容,要求對(duì)情感、錯(cuò)誤信息和復(fù)雜的社交互動(dòng)有先進(jìn)的理解,如MM-SOC [212]所示。2) 交通。TransportationGames [213]評(píng)估MLLMs應(yīng)用交通知識(shí)的能力,強(qiáng)調(diào)多模態(tài)理解、邏輯推理和決策制定。3) 自動(dòng)駕駛。自動(dòng)駕駛系統(tǒng)依賴于MLLMs進(jìn)行空間推理和實(shí)時(shí)規(guī)劃,從多模態(tài)感官輸入,以NuScenes-QA [214]和DriveLM-DATA [215]為重點(diǎn),專注于安全導(dǎo)航和類似人類的響應(yīng)。4) 遙感。LHRSBench [216]評(píng)估MLLMs在解釋地理空間數(shù)據(jù)方面的能力,要求強(qiáng)大的空間推理和圖像識(shí)別,以理解復(fù)雜的環(huán)境背景。

5.2 多模態(tài)任務(wù)設(shè)計(jì)

應(yīng)用基準(zhǔn)測(cè)試通常包括與理解、推理和生成相關(guān)的任務(wù),這些任務(wù)側(cè)重于不同的領(lǐng)域。因此,本節(jié)還涉及與多樣化應(yīng)用能力相關(guān)的任務(wù)和指標(biāo)。

交互式?jīng)Q策制定智能體。正式地,環(huán)境和智能體被建模為部分可觀察的馬爾可夫決策過(guò)程(POMDP):E = (S, A, ?, T)。其中智能體接收狀態(tài)st ∈ S的部分觀察ot ∈ ?,采取行動(dòng)at ∈ A,并根據(jù)函數(shù)T : S × A → S轉(zhuǎn)換到新?tīng)顟B(tài),旨在完成像網(wǎng)頁(yè)導(dǎo)航或信息檢索這樣的任務(wù)。在WebArena [192]的基礎(chǔ)上,VisualWebArena [193]強(qiáng)調(diào)視覺(jué)定位,要求智能體解釋視覺(jué)數(shù)據(jù),而不僅僅是依賴于文本或HTML線索。對(duì)于跨環(huán)境,CRAB [194]將任務(wù)定義為元組(M, I, R),其中M是一組環(huán)境,I是任務(wù)目標(biāo),R是獎(jiǎng)勵(lì)函數(shù)。智能體的政策π((m, a) | (I, H, o1, ..., on))根據(jù)指令和觀察確定跨環(huán)境的行動(dòng),測(cè)試智能體的適應(yīng)性和在多個(gè)平臺(tái)上的性能。由于傳統(tǒng)的目標(biāo)基礎(chǔ)和軌跡基礎(chǔ)評(píng)估的限制,它們未能捕捉到增量進(jìn)展,CRAB [194]引入了圖形評(píng)估器,通過(guò)跟蹤關(guān)鍵中間狀態(tài),允許進(jìn)行更細(xì)粒度的評(píng)估。它引入了完成率(CR),執(zhí)行效率(EE)和成本效率(CE)等指標(biāo),分別評(píng)估任務(wù)進(jìn)展、行動(dòng)效率和資源使用。

具身決策制定智能體。在提供了概述任務(wù)目標(biāo)的語(yǔ)言指令時(shí),人類水平的規(guī)劃涉及根據(jù)視覺(jué)輸入確定下一個(gè)合適的行動(dòng)[199]。這種視覺(jué)輸入由顯示過(guò)去幀的視頻序列組成,這些幀跟蹤任務(wù)進(jìn)展,最后一幀代表當(dāng)前的自我中心視圖。

機(jī)器人應(yīng)用。對(duì)于MMRo基準(zhǔn)測(cè)試[207]中的開(kāi)放式問(wèn)題,響應(yīng)使用GPT-4 API進(jìn)行評(píng)估。這種方法改編自LLM-as-Judge框架[225],進(jìn)行了小幅調(diào)整。GPT-4V被要求提供判斷,將模型的響應(yīng)分類為“A”(正確),“B”(錯(cuò)誤)或“C”(不確定)。

自動(dòng)駕駛。DriveLM-DATA [215]引入了圖形視覺(jué)問(wèn)答(GVQA),其中推理任務(wù)被構(gòu)建為問(wèn)題-答案對(duì)內(nèi)的有向圖,與傳統(tǒng)的自動(dòng)駕駛視覺(jué)問(wèn)答不同,GVQA利用問(wèn)題-答案之間的邏輯依賴關(guān)系來(lái)增強(qiáng)回答過(guò)程。

6 數(shù)據(jù)集構(gòu)建

由于不同類型的構(gòu)建過(guò)程具有很強(qiáng)的共性,本節(jié)是一般介紹常見(jiàn)的數(shù)據(jù)集構(gòu)建過(guò)程,包括數(shù)據(jù)集收集和質(zhì)量控制。

6.1 數(shù)據(jù)集收集

數(shù)據(jù)集收集是訓(xùn)練和評(píng)估MLLMs的關(guān)鍵步驟。該過(guò)程通常涉及多種方法,以確保數(shù)據(jù)集多樣化和代表性。

- 手工制作:這種方法涉及人工注釋或精心選擇的數(shù)據(jù)。有時(shí),LLM生成的樣本可能引入偏差,人工努力可以確保高質(zhì)量和客觀性[35]–[37]。此外,為了減少?gòu)墓矓?shù)據(jù)集的數(shù)據(jù)泄露風(fēng)險(xiǎn),通過(guò)新設(shè)計(jì)的問(wèn)題或答案引入了人工注釋,這些可以反映真實(shí)世界的場(chǎng)景[32]。

- 自動(dòng)化規(guī)則:應(yīng)用自動(dòng)化規(guī)則或算法以結(jié)構(gòu)化的方式生成圖像或問(wèn)答對(duì)。例如,VideoHIAN [69]設(shè)計(jì)了一個(gè)合成框架,通過(guò)針插入自動(dòng)生成特定的查詢-響應(yīng)對(duì)。

- 基于LLM的生成:利用LLMs生成問(wèn)題或圖像數(shù)據(jù),能夠有效創(chuàng)建大型數(shù)據(jù)集。例如,在問(wèn)題生成中,LVLM-eHub [28]利用像GPT-4這樣的MLLMs,使用上下文學(xué)習(xí)策略創(chuàng)建正面和負(fù)面的視覺(jué)指令。同樣,對(duì)于圖像生成,SPEC [9]利用StableDiffusion-XL [241]生成具有單個(gè)對(duì)象的圖像,創(chuàng)建了一個(gè)專注的視覺(jué)數(shù)據(jù)集合。MileBench [56]利用DALLE-3 [242]生成隨機(jī)卡通風(fēng)格的圖像針。

6.2 質(zhì)量控制

質(zhì)量控制對(duì)于確保用于訓(xùn)練和評(píng)估MLLMs的數(shù)據(jù)集的可靠性和完整性至關(guān)重要。各種方法,從人工篩選到自動(dòng)化過(guò)濾,幫助消除錯(cuò)誤、冗余和不相關(guān)數(shù)據(jù)。

- 人工篩選:人工審查員手動(dòng)評(píng)估數(shù)據(jù)的準(zhǔn)確性、相關(guān)性和質(zhì)量[34]–[37]。它通常用作LLM基于數(shù)據(jù)生成后的雙重檢查[30],[68]或作為反饋給LLMs的數(shù)據(jù)生成提示[30]。

- 基于規(guī)則的篩選:應(yīng)用自動(dòng)化基于規(guī)則的過(guò)濾應(yīng)用結(jié)構(gòu)化算法來(lái)清理和優(yōu)化數(shù)據(jù)集。對(duì)于去重復(fù):II-Bench [24]采用圖像相似性算法和OCR過(guò)濾重復(fù)和以文本為主的圖像。DenseFusion-1M [45]遵循SemDeDup [243],使用來(lái)自EVA-CLIP的圖像特征進(jìn)行k均值聚類,根據(jù)設(shè)定的閾值移除每個(gè)聚類內(nèi)語(yǔ)義重復(fù)的圖像。對(duì)于過(guò)濾NSFW圖像,一些基準(zhǔn)測(cè)試[64],[66]使用基于4層多層感知器(MLP)的二元NSFW圖像分類器[244],該分類器在LAION-2B的NSFW數(shù)據(jù)集[245]上訓(xùn)練,準(zhǔn)確率達(dá)到97.4%。預(yù)測(cè)NSFW概率超過(guò)定義閾值的圖像被自動(dòng)移除。

- 基于LLM的篩選:LLMs可以作為檢查員,確保視覺(jué)依賴性,并最小化數(shù)據(jù)泄露,并要求先進(jìn)的多模態(tài)能力進(jìn)行解決[46]。例如,一些基準(zhǔn)測(cè)試直接將純文本問(wèn)題輸入到多個(gè)MLLMs中。通過(guò)限制正確率,它們可以過(guò)濾與圖像無(wú)關(guān)的問(wèn)題[35]–[37]。

7 未來(lái)研究方向

隨著我們進(jìn)入多模態(tài)學(xué)習(xí)的未知領(lǐng)域,雄心勃勃但充滿希望的AI研究前沿將推動(dòng)范式轉(zhuǎn)變。我們?cè)O(shè)想未來(lái)的多模態(tài)基準(zhǔn)測(cè)試將包括多功能、以人為本、高效和無(wú)偏見(jiàn)的應(yīng)用。鑒于此,我們提出以下研究方向,這些方向需要?jiǎng)?chuàng)建更動(dòng)態(tài)、交互式和復(fù)雜的MLLMs:

任何模態(tài)到任何模態(tài)。目前,當(dāng)前多模態(tài)基準(zhǔn)測(cè)試中不同任務(wù)的輸入和輸出模態(tài)是嚴(yán)格預(yù)定的。例如,大多數(shù)情況下,任務(wù)可能要求處理文本和圖像作為輸入,并以文本標(biāo)簽作為輸出。這種剛性安排與人類智能形成鮮明對(duì)比,在日常交流中,人類可以輕松適應(yīng)不同種類的輸入和輸出模態(tài)。一個(gè)復(fù)雜的MLLM應(yīng)該理想地容納任何模態(tài)的輸入和輸出;例如,它應(yīng)該處理文本、圖像和語(yǔ)音輸入,并生成文本、圖像、語(yǔ)音甚至動(dòng)畫(huà)。這種靈活性將反映MLLMs在多樣化真實(shí)世界環(huán)境中更通用和實(shí)用的能力。為此,未來(lái)的基準(zhǔn)測(cè)試需要設(shè)計(jì)來(lái)支持和評(píng)估這種“任何到任何”模態(tài)轉(zhuǎn)換,作為下一代MLLMs的普遍挑戰(zhàn)和理想標(biāo)準(zhǔn)。

通用表示學(xué)習(xí)。當(dāng)前基準(zhǔn)測(cè)試通常針對(duì)特定任務(wù)量身定制,從而鼓勵(lì)模型為每種模態(tài)學(xué)習(xí)專門(mén)的表示。因此,跨所有模態(tài)的通用表示學(xué)習(xí),這可以說(shuō)是深度學(xué)習(xí)的最終目標(biāo)之一,被擱置一邊。我們假設(shè)通過(guò)開(kāi)發(fā)能夠?qū)W習(xí)和轉(zhuǎn)換跨所有模態(tài)的通用表示的MLLMs,將在基準(zhǔn)測(cè)試和模型效率方面帶來(lái)重大好處。這將本質(zhì)上要求模型無(wú)歧義且有效地理解和翻譯跨模態(tài)關(guān)系。追求這種粒度學(xué)習(xí)要求在多模態(tài)基準(zhǔn)測(cè)試設(shè)計(jì)中進(jìn)行范式轉(zhuǎn)變:促進(jìn)模型探索多種模態(tài)之間的潛在統(tǒng)一性,從而促進(jìn)它們學(xué)習(xí)一組普遍適用的特征的能力。

實(shí)時(shí)響應(yīng)。大多數(shù)現(xiàn)有基準(zhǔn)測(cè)試沒(méi)有考慮MLLMs響應(yīng)的時(shí)間方面,通常忽略了對(duì)實(shí)時(shí)或至少快速響應(yīng)的需求。然而,這種時(shí)間約束在各種真實(shí)世界應(yīng)用中至關(guān)重要,從語(yǔ)音助手到自動(dòng)駕駛汽車(chē),高延遲簡(jiǎn)單地使系統(tǒng)不可接受。為了強(qiáng)調(diào)及時(shí)性因素,基準(zhǔn)測(cè)試應(yīng)整合嚴(yán)格的時(shí)間約束,并相應(yīng)地激發(fā)方法來(lái)加速推理過(guò)程。這反過(guò)來(lái)又會(huì)激勵(lì)研究,不僅在功能上健壯,而且在時(shí)間上高效的MLLMs,從而賦予這些模型以真實(shí)世界部署的可靠性。

人在環(huán)路(HITL)。當(dāng)前的基準(zhǔn)測(cè)試機(jī)制通常在隔離中評(píng)估AI模型,忽略了人類互動(dòng)和合作這一不可或缺的部分。然而,為了實(shí)現(xiàn)最大效用,AI系統(tǒng)必須能夠與人類進(jìn)行動(dòng)態(tài)互動(dòng),在循環(huán)過(guò)程中學(xué)習(xí),同時(shí)隨著時(shí)間的推移進(jìn)行適應(yīng)和改進(jìn)。這需要實(shí)施HITL基準(zhǔn)測(cè)試,在這些基準(zhǔn)測(cè)試中,可以準(zhǔn)確捕捉和評(píng)估人類行為的細(xì)微差別、實(shí)時(shí)協(xié)作決策和雙向通信挑戰(zhàn)。超越關(guān)鍵應(yīng)用領(lǐng)域如對(duì)話代理,人機(jī)協(xié)作可能會(huì)揭示一個(gè)新的基準(zhǔn)測(cè)試領(lǐng)域,而不是將AI視為一個(gè)孤立的實(shí)體,而是完全認(rèn)識(shí)到它作為真實(shí)世界應(yīng)用中的社會(huì)技術(shù)系統(tǒng)的一部分。

8 結(jié)論

本綜述系統(tǒng)回顧了211個(gè)多模態(tài)基準(zhǔn)測(cè)試,將它們分類為理解、推理、生成和應(yīng)用。盡管現(xiàn)有的基準(zhǔn)測(cè)試顯著推進(jìn)了MLLM發(fā)展,但任務(wù)飽和、目標(biāo)不一致和指標(biāo)不一致等挑戰(zhàn)仍然存在。解決這些問(wèn)題被認(rèn)為是創(chuàng)建更準(zhǔn)確反映MLLMs能力和局限性的基準(zhǔn)測(cè)試所必需的。我們的綜述旨在通過(guò)提供基準(zhǔn)測(cè)試領(lǐng)域的清晰概述并建議未來(lái)方向,以實(shí)現(xiàn)更有效和全面的評(píng)估,為研究人員提供指導(dǎo)。

本文轉(zhuǎn)載自 ??旺知識(shí)??,作者: 旺知識(shí)