拋棄UNet,首個(gè)基于DiT的圖像編輯框架!DiT4Edit:多尺寸編輯質(zhì)量更優(yōu) | 北大&港科大

文章鏈接:https://arxiv.org/pdf/2411.03286

工程鏈接:https://github.com/fkyyyy/DiT4Edit(待開源)

亮點(diǎn)直擊

- 基于基于Transformer的擴(kuò)散模型在圖像編輯中的優(yōu)勢(shì),提出了DiT4Edit,第一個(gè)不需要調(diào)優(yōu)的基于擴(kuò)散Transformer(DiT)的圖像編輯框架。

- 為了適應(yīng)基于Transformer的去噪計(jì)算機(jī)制,首先提出了統(tǒng)一的注意力控制機(jī)制,以實(shí)現(xiàn)圖像編輯。引入了DPM-Solver反演和圖像塊合并策略,以減少推理時(shí)間。

- 大量定性和定量的實(shí)驗(yàn)結(jié)果證明了DiT4Edit在對(duì)象編輯、風(fēng)格編輯和形狀感知編輯方面的優(yōu)越性能,適用于各種圖像尺寸,包括512 × 512、1024 × 1024和1024 × 2048。

總結(jié)速覽

解決的問題:

現(xiàn)有的基于UNet的高分辨率圖像編輯方法在實(shí)現(xiàn)形狀感知的對(duì)象編輯方面仍存在不足。相比之下,Diffusion Transformers (DiT) 能更有效地捕捉圖像塊之間的長(zhǎng)程依賴關(guān)系,但目前在圖像編輯領(lǐng)域的應(yīng)用仍較少。

提出的方案:

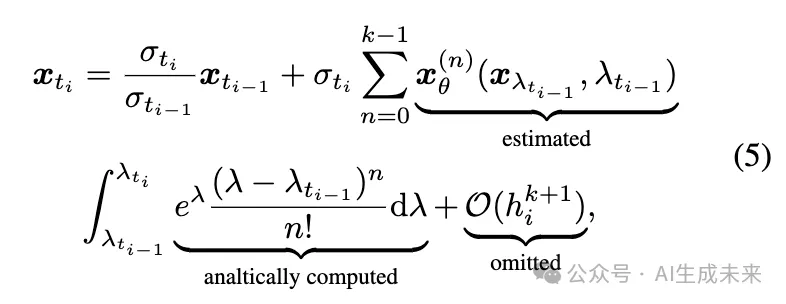

本文提出了基于Diffusion Transformers的首個(gè)圖像編輯框架——DiT4Edit。DiT4Edit采用DPM-Solver反演算法來獲取反演隱變量,與傳統(tǒng)UNet框架常用的DDIM反演算法相比,顯著減少了迭代步數(shù)。此外,設(shè)計(jì)了適用于Transformer計(jì)算流的統(tǒng)一注意力控制和圖像塊合并機(jī)制。

應(yīng)用的技術(shù):

- Diffusion Transformers (DiT) 框架

- DPM-Solver反演算法

- 統(tǒng)一注意力控制和圖像塊合并機(jī)制

達(dá)到的效果:

DiT4Edit在編輯質(zhì)量和速度上優(yōu)于UNet框架,尤其在高分辨率和任意尺寸的圖像編輯中表現(xiàn)突出。大量實(shí)驗(yàn)驗(yàn)證了該框架在各種編輯場(chǎng)景中的強(qiáng)大性能,展示了Diffusion Transformers在支持圖像編輯方面的潛力。

方法

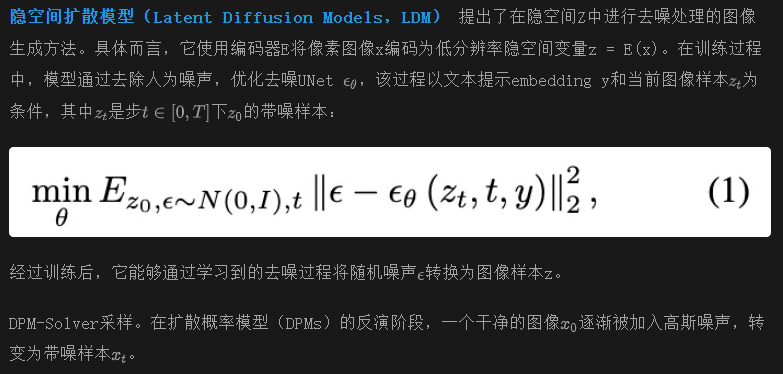

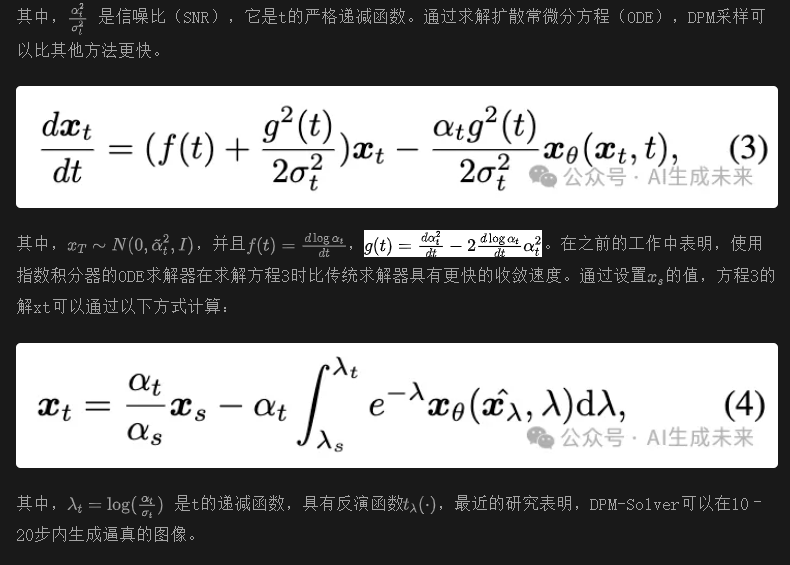

基礎(chǔ)知識(shí):隱空間擴(kuò)散模型

擴(kuò)散模型架構(gòu)

選擇Transformer作為去噪模型的原因

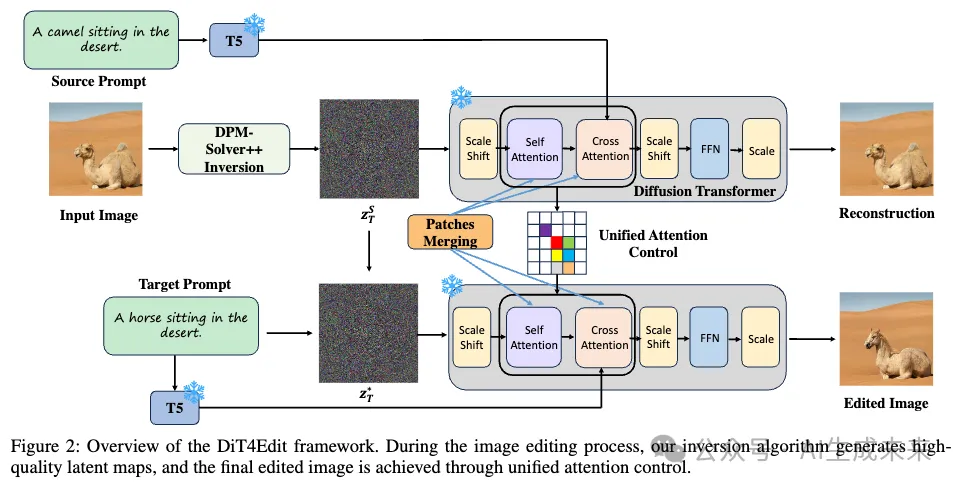

與UNet結(jié)構(gòu)相比,Transformer引入了全局注意力機(jī)制,使得模型能夠關(guān)注圖像中的更廣泛區(qū)域。這種增強(qiáng)的可擴(kuò)展性使得Transformer能夠生成大尺寸(例如大于512×512)甚至任意尺寸的高質(zhì)量圖像。本文基于DiT的編輯框架在大尺寸圖像上的編輯結(jié)果在下圖1和圖2中有所展示,這些是UNet框架之前未涉及的編輯任務(wù)。因此,采用了基于Transformer的去噪模型作為編輯框架,利用Transformer的能力來應(yīng)對(duì)這些更復(fù)雜的編輯挑戰(zhàn)。

基于擴(kuò)散Transformer的圖像編輯

如上圖2所示,基于預(yù)訓(xùn)練的擴(kuò)散Transformer圖像編輯框架的流程。

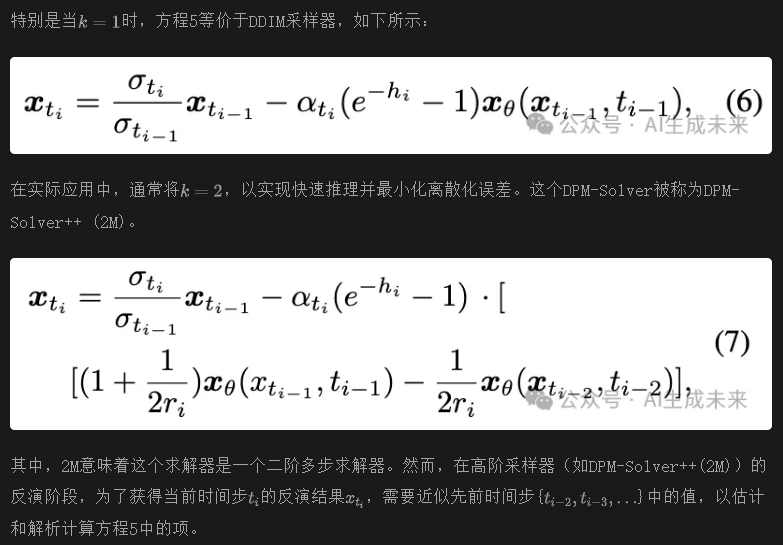

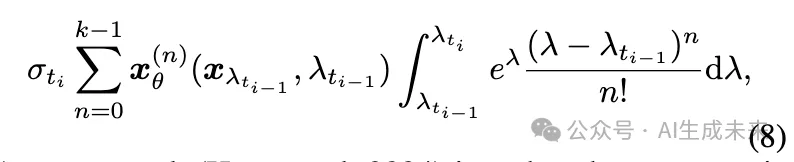

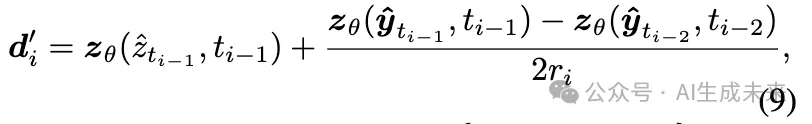

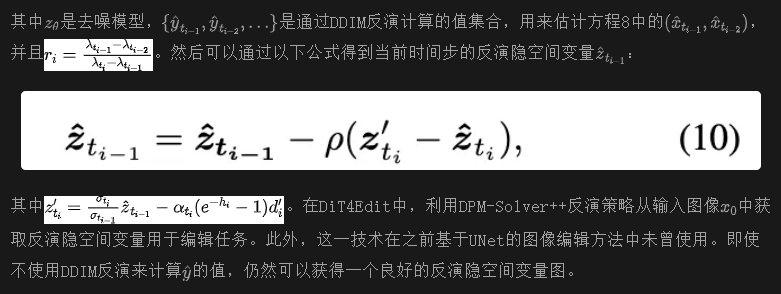

最近的研究(Hong等,2024)提出了一種通過反向歐拉方法來獲取方程8中高階項(xiàng)近似的策略。

統(tǒng)一控制注意力機(jī)制:在之前的研究Prompt to Prompt (P2P)中,研究人員展示了交叉注意力層包含來自提示文本的豐富語義信息。這一發(fā)現(xiàn)可以通過在擴(kuò)散過程中替換源圖像與目標(biāo)圖像之間的交叉注意力圖來編輯圖像。具體而言,常用的兩種基于文本引導(dǎo)的交叉注意力控制策略是交叉注意力替換和交叉注意力細(xì)化。這兩種方法確保了從目標(biāo)提示到源提示的信息無縫流動(dòng),從而將隱空間變量圖引導(dǎo)到期望的方向。

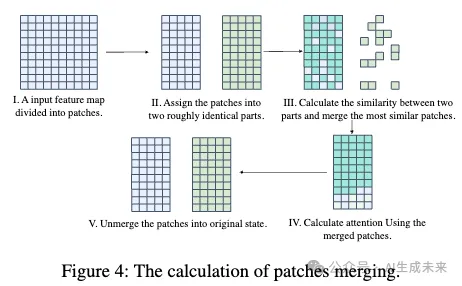

Patches Merging:為了提高推理速度,借鑒了Token Merging的方法,將patch合并技術(shù)嵌入到去噪模型中。這個(gè)方法的靈感來自于這樣一個(gè)觀察:在transformer架構(gòu)中,涉及到的patch數(shù)量明顯大于UNet。計(jì)算流程如下圖4所示。對(duì)于一個(gè)特征圖,我們首先計(jì)算每個(gè)patch之間的相似度,然后將最相似的patch合并,從而減少由注意力機(jī)制處理的patch數(shù)量。經(jīng)過注意力計(jì)算后,我們會(huì)將patch拆分回來,以保持模型下一層的輸入大小。通過將patch合并技術(shù)融入我們的框架中,我們旨在簡(jiǎn)化處理過程,提高整體效率,同時(shí)不改變每一層的基本操作。

實(shí)驗(yàn)

實(shí)現(xiàn)細(xì)節(jié)

研究者們?cè)u(píng)估了DiT4Edit編輯框架與六個(gè)先前基準(zhǔn)模型(包括Pix2Pix-Zero、PnPInversion、SDEdit、IP2P、MasaCtrl和InfEdit)的質(zhì)量表現(xiàn)差異,所有方法均使用官方開源代碼實(shí)現(xiàn)。

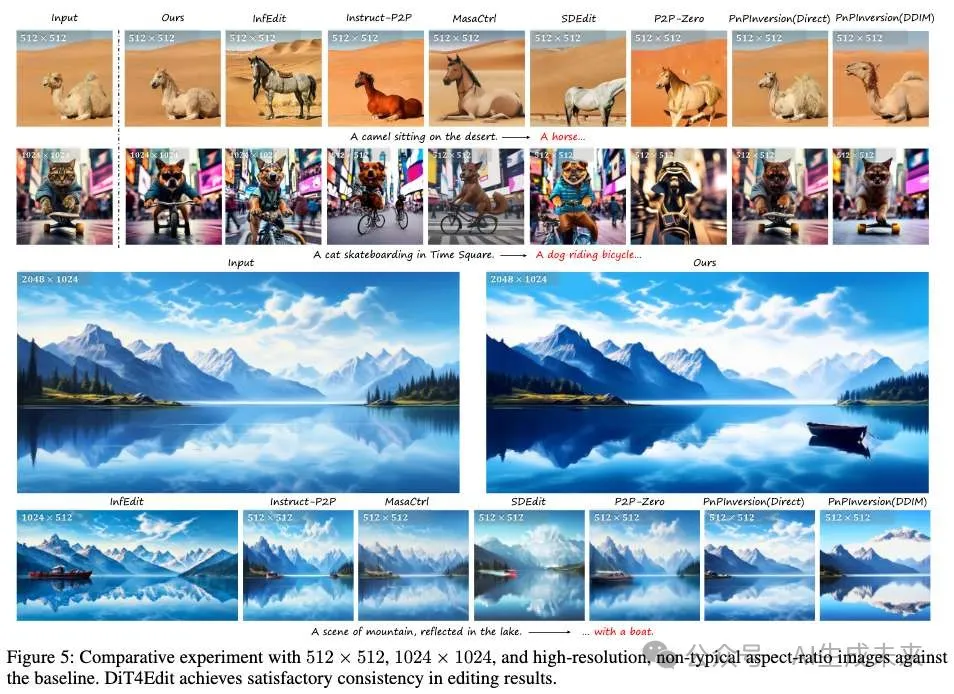

如下圖5所示,在512×512和1024×1024圖像上對(duì)比了本文的方案。圖5的第一行展示了本文的框架在編輯真實(shí)512×512圖像時(shí),能夠生成與原始內(nèi)容一致的編輯圖像,而現(xiàn)有方法通常會(huì)改變?cè)紙D像的背景或目標(biāo)細(xì)節(jié)。此外,圖5的第二行和第三行展示了在大規(guī)模圖像和任意尺寸圖像上的實(shí)驗(yàn)——這些任務(wù)是以前基于UNet的方法難以處理的。結(jié)果表明,本文提出的框架有效地處理了大圖像中的風(fēng)格和物體形狀修改。相比之下,一些先進(jìn)的基于UNet的方法,盡管能夠進(jìn)行編輯任務(wù),但通常會(huì)導(dǎo)致背景和物體位置的顯著變化和損壞。此外,由于UNet結(jié)構(gòu)的局限性,這些方法通常只能生成512×512大小的目標(biāo)圖像。這些發(fā)現(xiàn)強(qiáng)調(diào)了基于transformer的擴(kuò)散模型在大規(guī)模圖像編輯中的巨大潛力。

定量比較

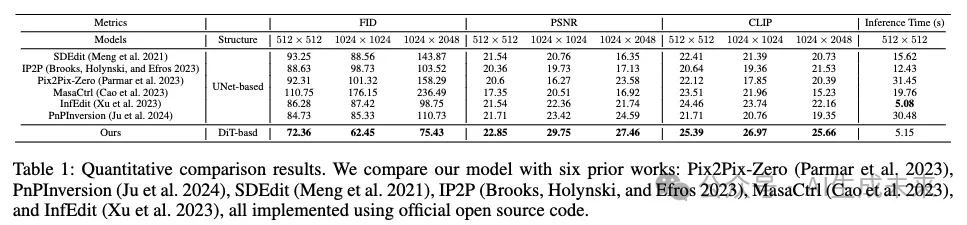

為了進(jìn)行定量評(píng)估,使用了三個(gè)指標(biāo):Fréchet Inception Distance (FID)、峰值信噪比(PSNR)和CLIP,以評(píng)估我們模型與SOTA(最先進(jìn)方法)在圖像生成質(zhì)量、背景保持和文本對(duì)齊方面的性能差異。本文比較了三種尺寸的圖像:512×512、1024×1024 和1024×2048,結(jié)果詳細(xì)列在下表1中。與Pix2Pix-Zero、PnPInversion、SDEdit、IP2P、MasaCtrl和InfEdit進(jìn)行了性能比較。需要注意的是,由于此前沒有基于DiT的編輯框架,所有對(duì)比基準(zhǔn)都基于UNet架構(gòu)。實(shí)驗(yàn)結(jié)果表明,DiT4Edit編輯策略在圖像生成質(zhì)量、背景保持和文本對(duì)齊方面優(yōu)于SOTA方法。由于集成的transformer結(jié)構(gòu)具備全局注意力能力,DiT4Edit框架在各種大小的編輯任務(wù)中表現(xiàn)出了強(qiáng)大的魯棒性。生成的圖像不僅顯示出更高的質(zhì)量,而且在背景和細(xì)節(jié)控制方面提供了更好的控制,保持了與原始圖像的一致性。特別是在編輯大規(guī)模或任意尺寸的圖像時(shí),DiT4Edit相較于其他方法展示了顯著的優(yōu)勢(shì),充分展示了transformer架構(gòu)強(qiáng)大的可擴(kuò)展能力。同時(shí),我們的編輯框架具有更短的推理時(shí)間,與無反演編輯方法(InfEdit)相當(dāng)。

消融實(shí)驗(yàn)

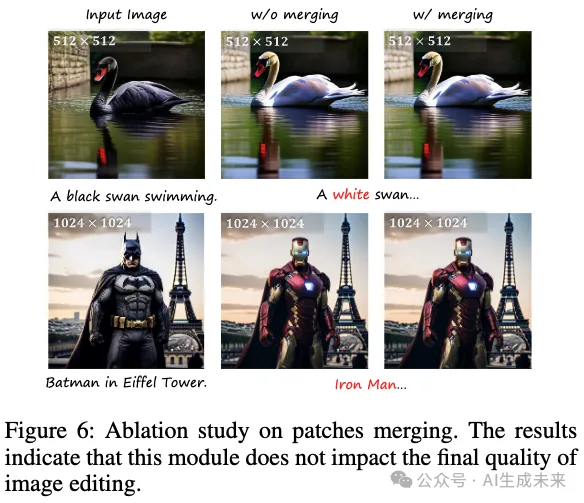

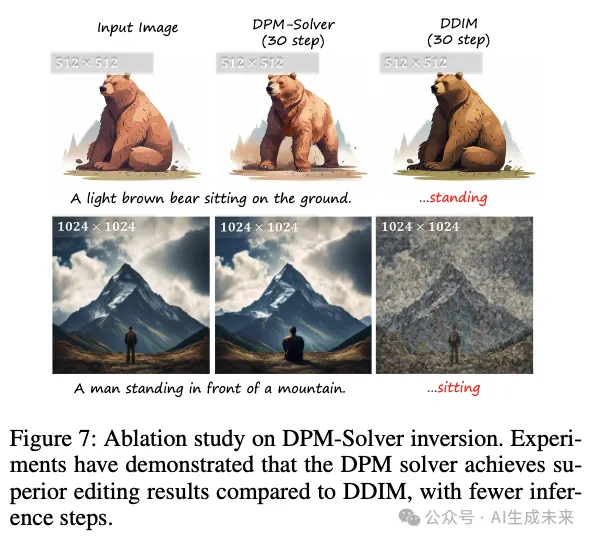

本文進(jìn)行了系列消融研究,旨在展示DPM-Solver反演和patch合并的有效性。關(guān)于patch合并的消融實(shí)驗(yàn)結(jié)果如前面圖4和下表2所示。實(shí)現(xiàn)patch合并后,盡管保持了與未使用patch合并時(shí)相當(dāng)?shù)木庉嬞|(zhì)量,但大尺寸圖像的編輯時(shí)間顯著減少。這表明,patch合并可以顯著提升圖像編輯框架的整體性能。此外,DPM-Solver和DDIM的消融實(shí)驗(yàn)結(jié)果如圖7所示。在相同推理步數(shù)(T = 30)下比較兩種方法時(shí),DPM-Solver在圖像編輯質(zhì)量方面始終優(yōu)于DDIM。這表明本文采用的DPM-Solver反演策略能夠生成更優(yōu)的潛在圖像,從而在較少的步中獲得更好的編輯效果。

結(jié)論

本文提出了DiT4Edit,這是首個(gè)基于擴(kuò)散transformer的圖像編輯框架。與之前的UNet框架不同,DiT4Edit提供了更優(yōu)的編輯質(zhì)量,并支持多種尺寸的圖像。通過利用DPM Solver反演、統(tǒng)一的注意力控制機(jī)制和patch合并,DiT4Edit在512×512和1024×1024尺寸圖像的編輯任務(wù)中超越了UNet結(jié)構(gòu)。特別是,DiT4Edit能夠處理任意尺寸的圖像,如1024×2048,展示了transformer在全局注意力和可擴(kuò)展性方面的優(yōu)勢(shì)。本文的研究為基于DiT的圖像編輯奠定了基礎(chǔ),并有助于進(jìn)一步探索transformer結(jié)構(gòu)在生成式AI中的潛力。

局限性

在實(shí)驗(yàn)中,觀察到T5-tokenizer偶爾會(huì)遇到詞匯分割問題,這可能導(dǎo)致最終編輯過程中的失敗。此外,我們的模型與原始圖像相比,可能會(huì)出現(xiàn)顏色不一致的情況。更多的編輯失敗案例請(qǐng)參考補(bǔ)充材料。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來