十個可擴展到數十億條記錄的 Go 數據庫模式

當數據規模躍升至數十億行、只讀副本出現延遲、每一次慢查詢都在吞噬預算時,構建一套持續穩定運行的系統變得異常艱巨。以下十條模式源自我們在生產環境中的一線實踐,均經受住了規模沖擊的考驗。

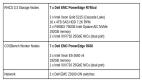

1. 連接池配置:每月節省 1 萬美元

某階段我們為未充分利用的只讀副本付費,原因是 Go 服務打開的連接數量遠超實際需求且長期空閑。通過以下配置,我們將數據庫實例數量減半,平均查詢耗時降低 20%,每月節省基礎設施費用逾 1 萬美元。

db.SetMaxOpenConns(100)

db.SetMaxIdleConns(10)

db.SetConnMaxLifetime(30 * time.Minute)關鍵在于“平衡”而非“足夠”。

2. 預處理語句緩存:消除 SQL 解析開銷

預處理語句不僅防止 SQL 注入,還能避免重復解析、規劃及數據庫端緩存抖動。

stmt, err := db.Prepare("SELECT id FROM users WHERE email = ?")注意:在 PostgreSQL 等數據庫中,過量的已準備語句可能引發性能問題。請借助智能緩存或 sqlx 等庫進行安全管理。

3. 批量插入:每秒處理 100 萬條記錄

逐行插入是性能陷阱。我們將數據攝取任務改寫為在單個事務內每 5000 條記錄刷新一次緩沖區:

tx, _ := db.Begin()

stmt, _ := tx.Prepare("INSERT INTO logs (...) VALUES (...)")

for _, row := range rows {

stmt.Exec(row...)

}

tx.Commit()吞吐量由每秒 5000 行躍升至超過 1000000 行。若在 PostgreSQL 使用 COPY,或在 MySQL 使用 LOAD DATA,效果將更佳。

4. 事務模式:防止死鎖

Go 應用中的死鎖多源于事務管理不當:持鎖時間過長、表訪問順序不一致或隔離級別理解不足。遵循以下原則:

- 始終以相同順序訪問表

- 縮短事務生命周期

- 僅在必要時使用 FOR UPDATE

- 記錄鎖等待事件

示例封裝:

tx, _ := db.Begin()

defer tx.Rollback()

// 業務邏輯

tx.Commit()死鎖仍可能發生,但不再導致系統崩潰。

5. 讀取副本:分擔查詢負載

在主庫上運行分析查詢會沖垮 OLTP 負載。我們通過自定義連接包裝器將讀取請求路由至副本、寫入請求路由至主庫,可選擇 go-pg、pgx 或 context.WithValue() 實現。

副本延遲客觀存在;對一致性敏感的查詢須顯式走主庫。該策略卸載了 60% 的查詢量,性能提升近一倍且無需修改模式。

6. 安全的模式遷移

在十億行表上變更列需格外謹慎。我們執行“三步走”:

- 添加可空新列

- 分塊回填數據

- 切換邏輯并刪除舊列

使用 golang-migrate、goose 或批量 SQL 可避免鎖表與性能抖動。未經演練的遷移禁止進入生產。

7. 查詢構建器:徹底杜絕 SQL 注入

database/sql 在使用參數時本身安全;但動態拼接 SQL 極易失誤。推薦使用 squirrel:

sql, args, _ := squirrel.

Select("id").

From("users").

Where(squirrel.Eq{"email": email}).

ToSql()

db.Query(sql, args...)它負責轉義與類型綁定,避免字符串拼接。采用以來,我們再未遭遇 SQL 注入事件。

8. 全鏈路數據庫監控

“不可測即不可控”。我們為每個查詢監控以下指標并上報至 Prometheus + Grafana:

- 延遲

- 返回行數

- 錯誤

- 慢查詢閾值觸發

start := time.Now()

rows, err := db.Query(...)

duration := time.Since(start)借此,我們在客戶無感知前捕獲并緩解了 10 倍延遲峰值。數據庫監控應為默認而非可選。

9. 分片:突破單實例上限

垂直擴展終有極限。我們按 customer ID 水平拆分,每個分片獨立數據庫,通過映射及哈希函數路由連接:

shard := hash(customerID) % numShards

db := shardMap[shard]雖然跨分片聯接需額外編碼,但 p95 延遲下降 70%,容量實現線性擴展。

10. 索引策略:避免基數陷阱

“看似良好”的索引曾使數據庫膨脹、寫入受阻。原則如下:

- 僅為 WHERE/ORDER BY/JOIN 字段建索引

- 優先低至中等基數列

- 復合索引順序必須匹配查詢

我們結合慢查詢日志及索引使用指標,自動每周預警無效索引:凡無法顯著縮短查詢時間或支撐功能的索引,一律移除。

結語

擴展至數十億行并非單純的數據庫難題,而是架構、流程與模式的綜合挑戰。Go 賦予開發者細粒度控制,但唯有審慎使用、深度監控并在問題影響用戶前先行修復,方能從容應對。以上 10 條模式已在實踐中多次證明其價值,愿能助你在下一次擴容風暴中穩坐釣魚臺。