真正的編程大佬到底怎么學的?學些什么?

大家好,我是哪吒。

前兩天,一個朋友去面試,被問了很多K8S的問題,問的很深入,入職了之后才發現,這個公司會K8S的就一個人,正在辦理離職手續,怪不得會薪資double。

太強了,還是得持續學習才行,真的羨慕。

啥也不說了,學習去了。

Kubernetes是一個開源的容器編排平臺,可以自動化管理容器的部署、伸縮和升級。它可以減輕開發者的負擔,并提高應用程序的可靠性和可擴展性。Kubernetes 成功的一個原因是它的自動化故障轉移和自愈能力,這些功能使它成為云原生應用開發的首選平臺之一。

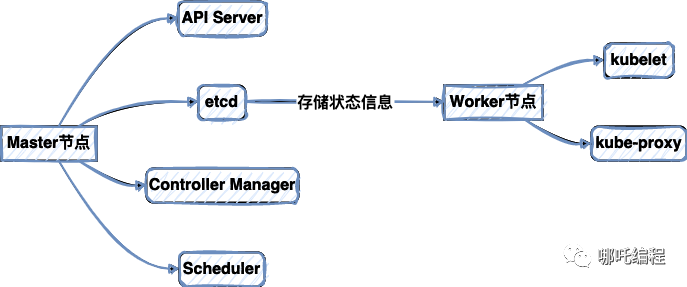

一、先了解一下Kubernetes的架構

Kubernetes架構包括以下組件:

- Master節點: 控制整個集群的狀態和進程,以及調度應用程序。

- Worker節點: 運行容器實例。

- etcd: 存儲整個集群的狀態信息。

在Kubernetes架構中,Master節點是負責管理和監視整個集群的組件。它包括以下核心組件:

- API Server: 通過REST API接口公開集群狀態信息以及可以進行操作的接口。所有的Kubernetes控制命令都由API Server轉發給相應的組件。

- etcd: 存儲集群的狀態信息。它是一個高度可靠、可擴展的鍵值存儲系統,Kubernetes使用它來存儲整個集群的配置、狀態和元數據。

- Controller Manager: 監視集群狀態并保證系統的期望狀態與實際狀態一致。它通過多個控制器實現了這一目標,比如Replication Controller和Endpoint Controller等。

- Scheduler: 負責根據調度策略將應用程序分配給 worker 節點并安排容器實例的位置。

Worker節點是Kubernetes集群中的計算節點,運行容器實例并負責監控這些容器實例。它包括以下組件:

- kubelet: 監視容器實例的運行狀態并向Master節點匯報狀態信息。它還解析容器的spec信息以確保容器配置正確,并運行容器中的應用程序。

- kube-proxy: 網絡代理,負責維護集群網絡規則以及將網絡請求路由到它們應該去的地方。它通過iptables實現了內部負載均衡,并以ICMP協議響應外部負載均衡器的“健康”檢查請求。

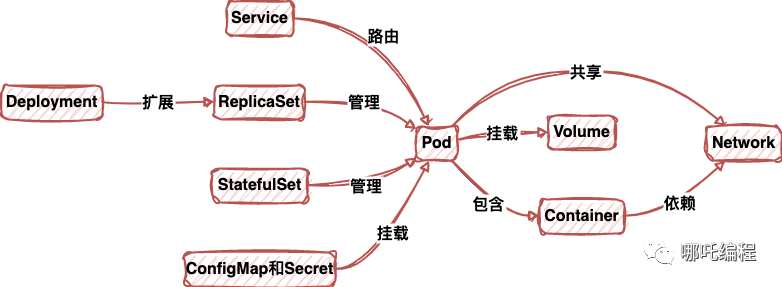

二、Kubernetes 組件和功能

Kubernetes提供了以下組件和功能,以便更好地管理和操作容器化應用程序:

- Pod: Pod是Kubernetes中最基本的組成單位,它是一個或多個容器的集合。Pod擁有單獨的IP地址和獨立的環境,容器之間共享網絡空間,可以通過IPC和Volum等資源共

- Service: Service是容器之間的網絡通信機制,它可能映射了一組相同類型的容器,并提供負載平衡和服務發現等功能。Service通過ClusterIP、NodePort和LoadBalancer等方式提供了不同的服務類型。

- Volume: Volume是容器的存儲抽象,可用于持久化數據或共享存儲。

- ReplicaSet: ReplicaSet確保一組Pod的數量始終滿足指定的副本數,可以用來保證應用程序在出現故障時進行自愈和可用性。

- Deployment: Deployment是一種ReplicaSet的擴展,它提供了滾動升級和回滾等功能。

- StatefulSet: StatefulSet是一種Pod的序列,每個Pod都有獨立的網絡標識符并具有可識別性,可用于需要持久化存儲、有序部署或集成存儲系統的應用程序。

- ConfigMap和Secret: ConfigMap和Secret是將配置和密碼信息從應用程序源代碼中分離出來的對象,它們可以被掛載到容器實例中而不暴露到環境變量或代碼中。

Kubernetes提供了許多功能,使得容器化應用程序的部署和運維變得更加方便。通過Kubernetes,可以輕松地擴放應用程序、實現負載平衡、確保高可用性,并進行滾動更新和回滾等操作。此外,通過與其它云原生工具和平臺(如ISTIO和Operator Framework)高度集成,還能夠進一步提高容器化應用程序的功能和效率。

三、故障轉移

1、如何定義故障轉移

故障轉移是指系統或應用程序在出現故障時,自動將工作負載轉移或重分配到其他可用節點或實例上,以保持服務的可用性和連續性。故障轉移是云計算和分布式系統的關鍵特性,可以幫助應用程序保持其功能并確保順暢運行。

故障轉移機制包括協調和監視應用程序節點的狀況以及自動恢復其在出現故障時的正常運行,以保持服務的可靠性。為了實現故障轉移,系統和應用程序可以采取備份和冗余策略,例如備份存儲器和容錯系統。

2、Kubernetes 中的故障轉移機制

Kubernetes是一種開源的容器編排系統,可用于自動化部署、擴展和管理容器化應用程序。它提供了多種故障轉移機制來確保應用程序在發生故障時保持可用并繼續運行。

以下是Kubernetes中的故障轉移機制:

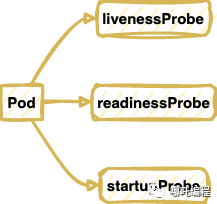

(1)健康檢查

健康檢查是Kubernetes故障轉移機制的核心部分。它通過定期檢查容器內部的應用程序或Pod的狀態,以便及時檢測到故障或崩潰,并自動重啟或重建失敗的Pod。

健康檢查分為三種類型:

- livenessProbe:檢查容器內的應用程序是否存活和響應請求。

- readinessProbe:檢查容器內的應用程序是否已就緒并可以接受網絡流量。

- startupProbe:檢查容器內的應用程序是否正在啟動,并在啟動完成之前等待一段時間。

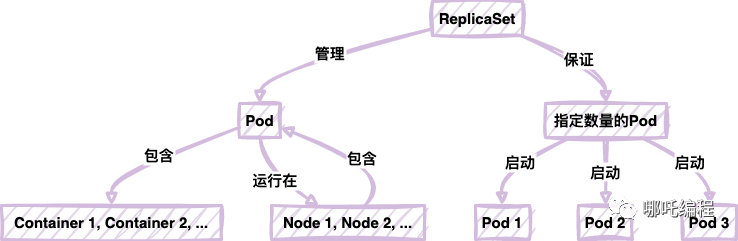

(2)Pod 和 ReplicaSet

Pod是Kubernetes中的最小部署單元。它可以容納一個或多個容器,并提供了共享存儲和網絡資源的環境。

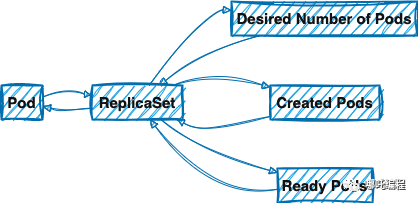

ReplicaSet是Kubernetes中的另一個重要概念。它用于管理Pod的副本,并確保所需的Pod數量始終處于運行狀態。

如果一個Pod失敗或被終止,ReplicaSet將自動啟動一個新的Pod來替換它。這可確保容器應用程序在運行時始終處于可用狀態。

(3)控制器和故障轉移

在Kubernetes中,控制器是一個高級別的抽象,用于管理Pod和ReplicaSet,并確保您的應用程序按預期運行。Kubernetes提供了多種控制器類型,包括Deployment、StatefulSet和DaemonSet等。

控制器可以監視Pod和ReplicaSet的狀態,并根據需要進行故障轉移或重新創建。例如,Deployment控制器可以自動擴展或收縮Pod的數量,以確保您的應用程序具有足夠的資源。

3、Pods和ReplicaSets之間的關系

Pod是Kubernetes中的最小部署單元,它可以容納一個或多個容器,并提供共享存儲和網絡資源的環境。ReplicaSet是用于管理Pod副本并確保所需Pod數量處于運行狀態的抽象。

Pod和ReplicaSet之間的關系如下:

- 每個Pod都由ReplicaSet管理,并且在創建時必須為其指定一個ReplicaSet。

- ReplicaSet確定所需的Pod數量,并在需要時自動創建、刪除和重建Pod。

- ReplicaSet可以立即發現失敗的Pod并用新的Pod替換它。

4、控制器和故障轉移

在Kubernetes中,控制器是一種高級別的抽象,用于管理Pod和ReplicaSet,并確保您的應用程序按預期運行。Kubernetes提供了多種控制器類型,包括Deployment、StatefulSet和DaemonSet等。

控制器可以監視Pod和ReplicaSet的狀態,并根據需要執行故障轉移或重新創建。例如,如果一個Pod失敗或被刪除,Deployment控制器可以自動創建一個新的Pod,并確保應用程序在運行時保持可用狀態。

此外,控制器還可以使用滾動部署功能來確保在更新應用程序時不會中斷服務。它基于可用性和負載均衡策略切換新版本的Pod,以確保在應用程序升級期間不會發生故障。

四、自愈能力

1、如何定義自愈能力

自愈能力指的是系統或應用程序自我監測和修復的能力,以提高系統的可用性和可靠性。當出現故障或異常情況時,自愈能力可以自動檢測和處理問題,減少對人工干預的需求,從而快速地恢復到正常工作狀態。這可以提高系統的可用性,保證系統持續穩定運行。

自愈能力是現代分布式應用的基礎。在云計算、容器技術和微服務架構等領域,大規模復雜的應用程序已經成為了常態。這些應用程序中包含了很多組件和服務,這些組件和服務之間存在著復雜的依賴關系。當其中一個組件或服務出現故障時,很可能會影響到整個應用程序的正常運行。

因此,在現代應用程序中,自愈能力已經成為了一個必不可少的功能。這種能力可以減少對人工干預的需求,提高應用程序的可用性和穩定性。

2、Kubernetes 中的自愈能力機制

Kubernetes 是一種流行的容器編排系統,它提供了一系列的自愈能力機制,以保證容器應用程序的可用性和可靠性。下面是一些常見的 Kubernetes 自愈能力機制:

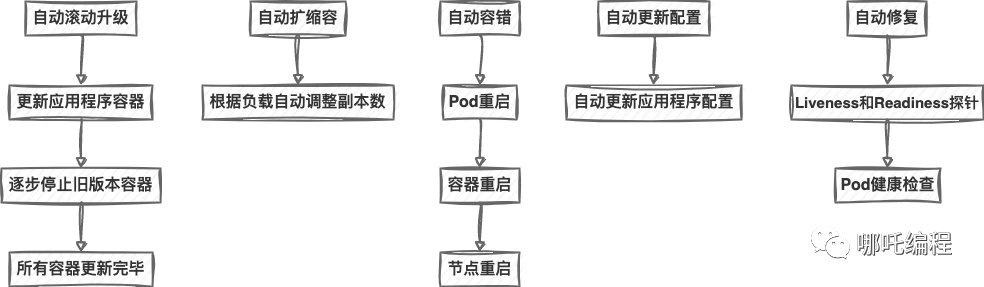

(1)自動滾動升級

滾動更新是 Kubernetes 中更新應用程序的一種方式。它使用兩種版本的應用程序來逐步更新所有容器,以避免出現瞬間的服務中斷和故障。滾動更新會先啟動新版本的應用程序容器,然后逐步停止舊版本的容器,直到所有容器都已更新為止。

(2)自動擴縮容

Kubernetes 可以根據應用程序的負載自動地調整副本數,以保證系統的可用性。當負載變得很高時,它會自動增加副本數;當負載變得很低時,它會自動減少副本數。這種自適應的擴縮容機制可以保證系統的穩定性和可用性。

(3)自動容錯

Kubernetes 有一系列容錯機制,包括 Pod 的重啟、容器重啟、節點重啟等。這些機制可以確保應用程序在發生故障時能夠快速地恢復到正常狀態。

(4)自動更新配置

Kubernetes 可以自動更新應用程序的配置,以確保應用程序在運行時具有最新的配置。這種更新的過程是非常安全的,因為它會確保所有的 Pod 都已經成功地啟動,并在這個過程中不會中斷或丟失任何的請求。

(5)自動修復

Kubernetes 有一些自愈機制,可以自動檢測和修復 Pod 中的故障或異常情況。這些機制包括 Liveness 和 Readiness 探針、Pod 健康檢查等。

3、Pod健康監控

Kubernetes 中的 Pod 健康監控是指對 Pod 內各個容器的健康情況進行監控。當某個容器狀態異常時,Kubernetes 會根據配置自動重啟容器或者整個 Pod。這種健康監控機制可以確保應用程序在失敗時能夠快速地恢復到正常狀態。

當 Kubernetes 判斷 Pod 內部的容器出現故障,會通過自愈機制自動重啟容器,以恢復盡可能多的容器正常運行。如果無法恢復,就會殺掉整個 Pod 實例。這一機制在避免運維人員需要手動介入,使得自動化變得更加完美。

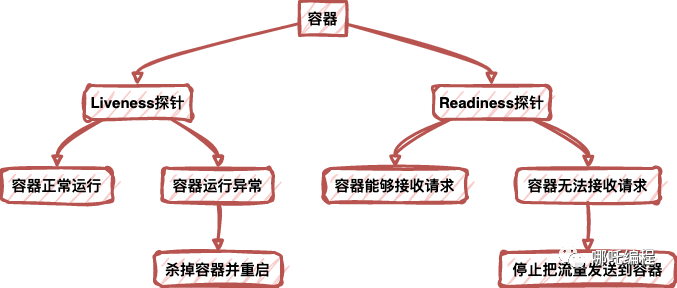

4、什么是Liveness和Readiness探針

Liveness 探針監測容器是否還在運行,如果探針失敗,Kubernetes 就會殺掉容器并重啟一個新的容器。Liveness 探針用于容器內部解決進程假死、死鎖等問題。Liveness 探針通過向容器的控制臺發送請求來檢測容器的運行狀態。如果探針收到了響應,則容器運行正常;否則容器可能有問題,需要進行重新啟動。

Readiness 探針監測容器是否接收到了來自外部的請求。如果探針失敗,Kubernetes 就會停止把流量發送到容器,這樣就可以避免向故障容器發送請求。Readiness 探針用于解決容器啟動時不能立即接收請求的問題。

自愈能力是現代應用程序必不可少的功能。 Kubernetes 提供了一系列的自愈能力機制,包括自動滾動升級、自動擴縮容、自動容錯、自動修復和自動更新配置。 Pod 健康監控和 Liveness、Readiness 探針也是 Kubernetes 中非常重要的自愈機制。這些機制可以減少對人工干預的需求,提高應用程序的可用性和穩定性。 以上內容帶著marknow語法放到代碼塊內輸出

五、Kubernetes 中的調試

1、Kubernetes中的日志記錄

在Kubernetes中,日志記錄是非常重要的一環。Kubernetes集群中的許多組件提供了不同級別的日志記錄,這些日志可以告訴你集群中發生了什么事情,并幫助你查找可能的問題。以下是一些常見的Kubernetes組件和它們對應的日志記錄位置:

- kube-apiserver:默認情況下,kube-apiserver的日志記錄位置是/var/log/kube-apiserver.log。

- kube-controller-manager:默認情況下,kube-controller-manager的日志記錄位置是/var/log/kube-controller-manager.log。

- kube-scheduler:默認情況下,kube-scheduler的日志記錄位置是/var/log/kube-scheduler.log。

- kubelet:kubelet會輸出日志到stdout和/var/log/kubelet.log。

- kube-proxy:kube-proxy的默認日志記錄位置是/var/log/kube-proxy.log。

除了上述組件的日志記錄之外,還有其他一些日志記錄位置需要考慮。例如,在容器中運行的應用程序通常將日志記錄到stdout或stderr,然后由Kubernetes收集并寫入它們的Pod日志。

可以使用kubectl命令來訪問Pod日志,例如:

kubectl logs <pod-name>此外,還有一些工具可以幫助收集和查看Kubernetes日志。例如,Elasticsearch和Kibana可以用于對Kubernetes日志進行集中診斷和分析。

2、調試故障轉移和自愈能力

Kubernetes提供了很多故障轉移和自愈能力,包括:

- 自動重啟容器:如果一個容器崩潰,Kubernetes會自動重啟該容器,這有助于保持應用程序的穩定性。

- 自動擴展Pod:Kubernetes可以自動根據CPU利用率等指標擴展Pod,以滿足應用程序的需求。

- 自動故障轉移:如果一個節點或Pod崩潰,Kubernetes會自動將該節點或Pod遷移到其他節點,并且會盡快為應用程序恢復服務。

但是,當Kubernetes無法自動解決故障時,需要手動跟蹤和調試問題。以下是一些常見的調試技巧:

- 查看Pod狀態:可以使用kubectl命令查看Pod的狀態,例如:

kubectl get pods這將列出所有Pod及其當前狀態。

- 查看事件:可以使用kubectl命令查看集群中發生的事件,例如:

kubectl get events這將列出集群中已發布的所有事件。

- 導出Pod日志:當一個Pod處于異常狀態時,可以使用kubectl命令導出Pod日志,例如:

kubectl logs <pod-name> > pod.log這將把Pod日志導出到pod.log文件中,以便更容易地分析。

- 調試容器:可以使用kubectl exec命令在容器內運行命令,例如:

kubectl exec <pod-name> <container-name> -- <command>這將在容器內運行命令。

在Kubernetes中,日志記錄和調試故障轉移和自愈能力非常重要。通過監控集群中的日志和事件,可以快速識別問題和調試應用程序。Kubernetes的自動故障轉移和自愈能力可以幫助我們保持應用程序的穩定性,但當Kubernetes無法自動解決問題時,手動跟蹤和調試問題是必要的。

六、提高故障轉移和自愈能力

1、最佳實踐和工具

在Kubernetes中,為提高故障轉移和自愈能力,可以采用以下最佳實踐和工具:

(1)使用健康檢查

在容器中配置Liveness Probe和Readiness Probe可以定期檢查容器的健康狀態,并根據情況重新啟動或結束容器。這有助于避免因單個容器出現故障而導致整個應用程序中斷。

要使用健康檢查,請執行以下操作:

- 創建一個 Kubernetes 部署或 Pod。

- 在部署或 Pod 中定義健康檢查。

- 運行部署或 Pod。

使用 HTTP 健康檢查的部署的示例代碼:

apiVersion: apps/v1

kind: Deployment

metadata:

name: example-deployment

spec:

replicas: 3

selector:

matchLabels:

app: example

template:

metadata:

labels:

app: example

spec:

containers:

- name: example-container

image: example-image

ports:

- containerPort: 80

livenessProbe:

httpGet:

path: /healthz

port: 80

periodSeconds: 5

initialDelaySeconds: 15在這個例子中,我們定義了一個名為example-deployment的部署,它會創建三個副本,每個副本都包含一個名為example-container的容器。該容器使用 image: example-image,它會監聽端口 80。此外,我們還定義了一個HTTP 健康檢查,它檢查容器的 /healthz 端點是否可用。livenessProbe 告訴 Kubernetes 每 5 秒檢查一次容器的健康狀況,并在容器啟動 15 秒后才能開始檢查。

- 您可以使用 kubectl 命令行工具來運行上面的部署:

kubectl apply -f example-deployment.yaml此時,Kubernetes 將創建這個部署,其中包括三個 Pod 和一個服務。然后,Kubernetes 將開始檢查容器的健康狀況,并在它們變得不健康時重新啟動它們。

(2)運行多個副本:

Kubernetes 可以通過運行多個副本來提高應用程序的可用性和可靠性。這意味著如果一個 Pod 失效,Kubernetes 可以自動擴展副本并啟動新 Pod,確保該應用程序在集群中始終處于運行狀態。

使用 Kubernetes 運行多個副本的操作步驟:

- 創建一個 Deployment 或 StatefulSet。

- 在 YAML 文件中定義副本數量。

- 運行 Deployment 或 StatefulSet。

以下是一個包含 3 個副本的 Deployment 的示例代碼:

apiVersion: apps/v1

kind: Deployment

metadata:

name: example-deployment

spec:

replicas: 3

selector:

matchLabels:

app: example

template:

metadata:

labels:

app: example

spec:

containers:

- name: example-container

image: example-image

ports:

- containerPort: 80在這個例子中,我們定義了一個名為 example-deployment 的 Deployment,并在 spec 中指定它的副本數量為 3。然后,我們定義了一個容器,名為example-container,它使用 image: example-image,并監聽端口 80。

- 您可以使用 kubectl 命令行工具來運行上面的 Deployment:

kubectl apply -f example-deployment.yamlKubernetes 將啟動 3 個副本,每個副本包含一個 example-container 容器。則Kubernetes 可以自動地轉移工作負載,使調度集無故障運行,其中一個 Pod 運行得不正常,Kubernetes會啟動一個新的Pod來替換。

這就是 Kubernetes 如何通過運行多個副本來提高應用程序的可用性和可靠性的簡單操作。

(3)使用自動擴容:

Kubernetes 的自動擴容功能可以幫助應對高流量、高并發以及其他負載等問題,確保您的應用程序始終保持最佳性能。

使用 Kubernetes 自動擴容的操作步驟:

- 創建一個 Deployment 或 StatefulSet。

- 在 YAML 文件中定義 CPU 和/或內存閾值。

- 配置自動伸縮規則。

- 運行 Deployment 或 StatefulSet。

以下是一個基于 CPU 使用率自動擴容的 Deployment 示例代碼:

apiVersion: apps/v1

kind: Deployment

metadata:

name: example-deployment

spec:

replicas: 3

selector:

matchLabels:

app: example

template:

metadata:

labels:

app: example

spec:

containers:

- name: example-container

image: example-image

ports:

- containerPort: 80

resources:

limits:

cpu: "500m"

requests:

cpu: "200m"

readinessProbe:

httpGet:

path: /healthz

port: 80

periodSeconds: 5

initialDelaySeconds: 15

livenessProbe:

httpGet:

path: /healthz

port: 80

periodSeconds: 5

initialDelaySeconds: 15

autoscaler:

targetCPUUtilizationPercentage: 80

minReplicas: 3

maxReplicas: 10在這個例子中,我們定義了一個名為 example-deployment 的 Deployment,并在 spec 中指定副本數量為 3。然后我們定義一個容器,它使用 image: example-image,并監聽端口 80。除了容器,我們還定義了一個 HorizontalPodAutoscaler 對象,它配置了自動擴容規則,根據 CPU 使用率來調整副本數量。

autoscaler 的 targetCPUUtilizationPercentage 字段設置了 CPU 使用率的目標值為80%,minReplicas 設置最小 Pod 實例數量為 3,maxReplicas 設置最大 Pod 實例數量為 10 。這意味著當 CPU 使用率超過 80% 時,Kubernetes 將在 3 個 Pod 實例之間自動擴展部署,以便最多達到 10 個副本。

- 您可以使用 kubectl 命令行工具來運行上面的 Deployment:

kubectl apply -f example-deployment.yamlKubernetes 將啟動 3 個副本,并在負載增加時自動擴展部署,確保您的應用程序始終保持最佳性能。

(4)灰度發布

灰度發布是一種將新版本應用程序漸進性引入生產環境的方法。它可以幫助減少故障風險,并提高應用程序的可用性。Kubernetes提供了一些資源對象,如Deployment和Service,可以用來實現灰度發布。

使用 Kubernetes 灰度發布的操作步驟:

- 創建兩個 Deployment,一個是舊應用程序的 Deployment,另一個是新應用程序的 Deployment。

- 在負載均衡器上定義 Service,并將其指向舊 Deployment 的 Pod。

- 通過逐步更改 Service 指向新 Deployment 的 Pod,按順序對新應用程序的功能和性能進行測試。

以下是一個使用灰度發布的示例代碼:

apiVersion: apps/v1

kind: Deployment

metadata:

name: old-app

spec:

replicas: 3

selector:

matchLabels:

app: old-app

template:

metadata:

labels:

app: old-app

spec:

containers:

- name: old-app-container

image: old-app-image

ports:

- containerPort: 80

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: new-app

spec:

replicas: 1

selector:

matchLabels:

app: new-app

template:

metadata:

labels:

app: new-app

spec:

containers:

- name: new-app-container

image: new-app-image

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: app-service

spec:

type: LoadBalancer

selector:

app: old-app

ports:

- name: http

port: 80

targetPort: 80在這個例子中,我們定義了兩個 Deployment,一個是名為 old-app 的舊應用程序,另一個是名為 new-app 的新應用程序。我們還定義了一個名為 app-service 的 Service,它設置為負載均衡器類型,并將其指向 old-app 的 Pod。這將使所有流量都流向舊應用程序中的 Pod。

接下來,我們可以逐步更改 Service 的定義,將其指向新應用程序的 Pod。您可以使用 kubectl 命令行工具進行這個操作:

在這個例子中,我們定義了兩個 Deployment,一個是名為 old-app 的舊應用程序,另一個是名為 new-app 的新應用程序。我們還定義了一個名為 app-service 的 Service,它設置為負載均衡器類型,并將其指向 old-app 的 Pod。這將使所有流量都流向舊應用程序中的 Pod。

接下來,我們可以逐步更改 Service 的定義,將其指向新應用程序的 Pod。您可以使用 kubectl 命令行工具進行這個操作:

kubectl apply -f new-service.yaml這將使用新定義中的 Service,將流量轉發到新應用程序的 Pod。隨著時間的推移,您可以逐步增加新應用程序的副本數,并將流量轉換為新應用程序,以便更全面地測試它的性能和功能。

(5)配置備份和恢復:

Kubernetes支持通過將ConfigMap和Secret映射到Pod來輕松備份和恢復應用程序配置。這可以幫助避免恢復時出現錯誤。

使用 Kubernetes 配置備份和恢復的操作步驟:

Kubernetes 配置備份與恢復可以幫助您在遇到意外情況時更好地保護您的應用程序和配置數據。以下是使用 Kubernetes 配置備份和恢復的操作步驟:

- 創建配置文件。

- 備份配置文件。

- 恢復配置文件。

以下是一個基本的配置文件示例:

apiVersion: v1

kind: ConfigMap

metadata:

name: app-config

data:

app.properties: |

database.url=jdbc:mysql://localhost/mydb

database.username=admin

database.password=secret在這個例子中,我們定義了一個名為 app-config 的ConfigMap 對象。它包含一個名為 app.properties 的鍵值對,該鍵值對包含應用程序的配置細節、數據庫 URL 以及用戶名和密碼等。

備份配置文件,可以使用 kubectl 命令行工具來備份 ConfigMap 對象到一個 YAML 文件中:

kubectl get configmaps app-config -o yaml > app-config.yaml這將把名為 app-config 的 ConfigMap 對象導出到 app-config.yaml 文件中,以便稍后恢復。您可以根據需要備份更多的資源,例如 Deployment 和 StatefulSet 等。

恢復配置文件,您可以使用 kubectl 命令行工具將備份文件導入回Kubernetes:

kubectl apply -f app-config.yaml這將創建一個新的 ConfigMap 對象,并將 app-config.yaml 文件中定義的鍵值對導入回對象中。

(6)使用存儲類:

Kubernetes提供了不同類型的存儲類,如Persistent Volume和StorageClass,可用于實現持久化存儲和容器間數據共享。它們可以幫助數據在應用程序遷移和節點失效時得到保護。

使用 Kubernetes 使用存儲類的操作步驟:

下面是使用存儲類的基本操作流程:

① 創建一個存儲類。

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: my-storage-class

provisioner: my-provisioner其中 my-storage-class 是存儲類的名稱,my-provisioner 是一個動態卷子系統的名稱。

② 在 Pod 中使用存儲類。

apiVersion: v1

kind: Pod

metadata:

name: my-pod

spec:

containers:

- name: my-container

image: nginx

volumeMounts:

- mountPath: "/usr/share/nginx/html"

name: my-volume

volumes:

- name: my-volume

persistentVolumeClaim:

claimName: my-claim其中 my-claim 是一個使用存儲類的持久卷聲明名。

③ 創建一個持久卷聲明對象,它將使用存儲類來提供持久化存儲。

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: my-claim

spec:

storageClassName: my-storage-class

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 1Gi其中 my-claim 是持久卷聲明的名稱,my-storage-class 是使用的存儲類的名稱。

2、通過Kubernetes運行應用程序可以帶來更可靠的系統

Kubernetes是一種自動化容器化技術,它可以在分布式系統中管理和運行應用程序。這種技術的主要優點是:

- 自動配置節點、服務發現和故障恢復等功能。

- 支持水平擴展,從而提高系統的容錯性和負載能力。

- 可以使用滾動更新進行代碼部署,從而避免應用程序中斷和停機時間。

- 提供自動化的負載均衡器和服務發現,以便優化網絡流量和路由。

- 集成多種監控工具,以便實時檢測和解決應用程序中的錯誤和故障。

七、總結

總的來說,本文介紹了 Kubernetes 如何提高故障轉移和自愈能力的多種方法,包括使用健康檢查、運行多個副本、自動擴容和灰度發布,以及配置備份和恢復。這些方法旨在確保應用程序始終處于可用狀態,并在遇到故障時能夠自動從故障中恢復。

隨著云計算的發展和應用程序的復雜性不斷增加,提高應用程序的可用性和彈性變得越來越重要。通過使用 Kubernetes 提供的這些方法,可以幫助企業更好地管理和保護其應用程序和數據,從而更好地滿足用戶的需求和要求。