卷積神經(jīng)網(wǎng)絡(luò)十五問(wèn):CNN與生物視覺(jué)系統(tǒng)的研究探索

CNN 的發(fā)展早期從大腦神經(jīng)網(wǎng)絡(luò)取得了很多靈感,現(xiàn)在相關(guān)研究中的一些思路和方法也在反過(guò)來(lái)幫助神經(jīng)科學(xué)方面的研究,如DeepMind近期用AI探索大腦導(dǎo)航和多巴胺功能的工作。近日,哥倫比亞大學(xué)神經(jīng)生物學(xué)與行為學(xué)博士 Grace Lindsay 在其博客上發(fā)文,通過(guò)問(wèn)答的形式討論了 CNN 和生物視覺(jué)系統(tǒng)之間的區(qū)別和聯(lián)系。

和我近期的大多數(shù)博文一樣,我寫(xiě)這篇文章的起因是近期一個(gè) Twitter 討論,具體是關(guān)于如何將深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)的組件與大腦聯(lián)系起來(lái)。但是,這里的大多數(shù)思考都是我以前考慮并討論過(guò)的。當(dāng)有人使用 CNN 作為視覺(jué)系統(tǒng)的模型時(shí),我通常(在研究討論和其它對(duì)話(huà)上)必須鼓勵(lì)和支持這一選擇。部分原因是它們(在某種程度上)是神經(jīng)科學(xué)領(lǐng)域相對(duì)較新的方法,還有部分原因是人們對(duì)它們持懷疑態(tài)度。計(jì)算模型一般在神經(jīng)科學(xué)領(lǐng)域發(fā)展較慢,很大部分(但并非全部)是來(lái)自不使用或構(gòu)建計(jì)算模型的人;它們通常被描述成不切實(shí)際或沒(méi)有用處。在對(duì)技術(shù)宅的普遍反感和深度學(xué)習(xí)/人工智能(會(huì)值多少錢(qián)?)的過(guò)度炒作氛圍中,不管你得到了什么模型,某些人都會(huì)厭惡它。

所以在這里我希望使用一個(gè)簡(jiǎn)單(但很長(zhǎng))的問(wèn)答形式來(lái)相對(duì)合理且準(zhǔn)確地闡釋使用 CNN 建模生物視覺(jué)系統(tǒng)的情況。這個(gè)子領(lǐng)域很大程度上仍處于發(fā)展階段,所以文中不會(huì)有太多確定無(wú)疑的事實(shí),但我會(huì)盡可能引述。此外,這些顯然是我個(gè)人對(duì)這些問(wèn)題的答案(以及我個(gè)人提出的問(wèn)題),所以請(qǐng)相信其中值得相信的。

我重點(diǎn)關(guān)注的是作為視覺(jué)系統(tǒng)的模型的 CNN——而不是更寬泛的問(wèn)題,比如「深度學(xué)習(xí)能否幫助我們理解大腦?」——因?yàn)槲蚁嘈胚@一領(lǐng)域是比較起來(lái)最合理、信息最多、最富成效的(而且也是我研究的領(lǐng)域)。但這種通用流程(根據(jù)生物學(xué)信息指定一個(gè)架構(gòu)然后在相關(guān)數(shù)據(jù)上訓(xùn)練)也可用于幫助理解和復(fù)現(xiàn)其它大腦區(qū)域和功能。當(dāng)然,已經(jīng)有人做過(guò)這種事了,可參閱:

https://www.frontiersin.org/articles/10.3389/fncom.2016.00094/full

(我希望機(jī)器學(xué)習(xí)和數(shù)據(jù)科學(xué)領(lǐng)域的讀者都能讀懂這篇文章,但其中確實(shí)有些神經(jīng)科學(xué)詞匯沒(méi)有給出定義。)

1. CNN 是什么?

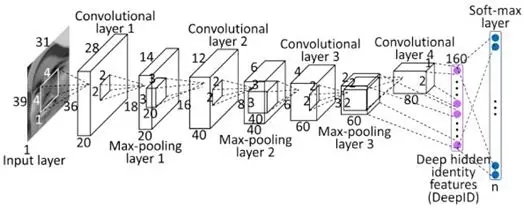

卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一類(lèi)人工神經(jīng)網(wǎng)絡(luò)。因此,它們是由被稱(chēng)為「神經(jīng)元」的單元構(gòu)成的,這些單元可根據(jù)輸入的加權(quán)和輸出一個(gè)活動(dòng)水平。這個(gè)活動(dòng)水平通常是輸入的非線(xiàn)性函數(shù),通常只是一個(gè)整流線(xiàn)性單元(ReLU),其中當(dāng)輸入全為正時(shí)活動(dòng)等于輸入,當(dāng)輸入全為非正時(shí)活動(dòng)等于 0。

CNN 的獨(dú)特之處是神經(jīng)元之間的連接的構(gòu)建方式。在一個(gè)前饋神經(jīng)網(wǎng)絡(luò)中,單元會(huì)被組織成層的形式,給定層的單元只會(huì)獲得來(lái)自其下面一層的輸入(即不會(huì)有來(lái)自同一層或后續(xù)層的其它單元的輸入,大多數(shù)情況下也不會(huì)有來(lái)自之前超過(guò) 1 層的輸入)。CNN 是前饋網(wǎng)絡(luò)。但不同于標(biāo)準(zhǔn)的單純的前饋網(wǎng)絡(luò),CNN 中的單元具有一種空間排列。在每一層,單元都會(huì)被組織成 2D 網(wǎng)格形式,這被稱(chēng)為特征圖(feature map)。每一個(gè)特征圖都是在其下面一層上執(zhí)行卷積所得的結(jié)果(CNN 也因此得名)。這意味著在其下面一層的每個(gè)位置都應(yīng)用了同樣的卷積過(guò)濾器(權(quán)重集)。因此,在該 2D 網(wǎng)格上特定位置的單元只能收到來(lái)自其下面一層相似位置的單元的輸入。此外,輸入上附帶的權(quán)重對(duì)一個(gè)特征圖中的每個(gè)單元都是一樣的(而各個(gè)特征圖各不相同)。

在卷積(和非線(xiàn)性)之后,通常還會(huì)完成一些其它計(jì)算。一種可能的計(jì)算是交叉特征歸一化(盡管這種方法在現(xiàn)代的高性能 CNN 中已不再流行)。其中,特征圖中某個(gè)特定空間位置的單元的活動(dòng)會(huì)除以其它特征圖中同一位置的單元活動(dòng)。一種更常見(jiàn)的操作是池化(pooling)。其中,每個(gè) 2D 特征圖的一小個(gè)空間區(qū)域中的***活動(dòng)會(huì)被用于表示該區(qū)域。這能縮減特征圖的大小。這一組操作(卷積+非線(xiàn)性→歸一化→池化)整體被稱(chēng)為一層。一個(gè)網(wǎng)絡(luò)架構(gòu)就是由層的數(shù)量和各種相關(guān)參數(shù)(比如卷積過(guò)濾器的大小)的選擇定義的。

大多數(shù)現(xiàn)代 CNN 都有多個(gè)(至少 5)這樣的層,其中***一層會(huì)向一個(gè)全連接層饋送數(shù)據(jù)。全連接層就像是標(biāo)準(zhǔn)的前饋網(wǎng)絡(luò),其中沒(méi)有空間布局或受限的連接。通常會(huì)有 2-3 個(gè)全連接層連在一起使用,并且網(wǎng)絡(luò)的***一層執(zhí)行分類(lèi)。舉個(gè)例子,如果該網(wǎng)絡(luò)執(zhí)行的是 10 類(lèi)目標(biāo)分類(lèi),那么***一層將會(huì)有 10 個(gè)單元,會(huì)有一個(gè) softmax 操作應(yīng)用在它們的活動(dòng)水平上以得到每個(gè)類(lèi)別相關(guān)的概率。

這些網(wǎng)絡(luò)主要通過(guò)監(jiān)督學(xué)習(xí)和反向傳播訓(xùn)練。這時(shí),提供給網(wǎng)絡(luò)的輸入是圖像及其相關(guān)類(lèi)別標(biāo)簽構(gòu)成的配對(duì)集。圖像像素值輸入網(wǎng)絡(luò)的***層,然后網(wǎng)絡(luò)***一層得出一個(gè)預(yù)測(cè)類(lèi)別。如果這個(gè)預(yù)測(cè)得到的標(biāo)簽與所提供的標(biāo)簽不一致,那么就會(huì)計(jì)算梯度,確定應(yīng)該如何修改權(quán)重(即卷積過(guò)濾器中的值)以使分類(lèi)正確。如此重復(fù)很多很多次(很多網(wǎng)絡(luò)都是在 ImageNet 數(shù)據(jù)庫(kù)上訓(xùn)練的,這個(gè)數(shù)據(jù)庫(kù)包含 1000 個(gè)目標(biāo)類(lèi)別的超過(guò) 100 萬(wàn)張圖像),就能得到在留存測(cè)試圖像上有很高準(zhǔn)確度的模型。CNN 的某些變體模型現(xiàn)在已能達(dá)到 4.94% 乃至更低的錯(cuò)誤率,優(yōu)于人類(lèi)水平。要得到優(yōu)良的表現(xiàn),通常需要很多訓(xùn)練「技巧」,比如智能學(xué)習(xí)率選擇和權(quán)重正則化(主要是通過(guò) dropout,即在每個(gè)訓(xùn)練階段都有隨機(jī)一半的權(quán)重關(guān)閉)。

歷史上曾使用無(wú)監(jiān)督預(yù)訓(xùn)練來(lái)初始化權(quán)重,然后再使用監(jiān)督學(xué)習(xí)來(lái)進(jìn)行改善。但是,這似乎已經(jīng)不再是優(yōu)越性能所必需的了。

神經(jīng)科學(xué)家能夠理解的深度 CNN 介紹可參閱《深度神經(jīng)網(wǎng)絡(luò):一種用于建模生物視覺(jué)和大腦信息處理的新框架》:

https://www.annualreviews.org/doi/10.1146/annurev-vision-082114-035447

2. CNN 是否曾受視覺(jué)系統(tǒng)的啟發(fā)?

是的。首先,從名稱(chēng)上就能看出來(lái),人工神經(jīng)網(wǎng)絡(luò)整體都受到了 20 世紀(jì)中期開(kāi)始發(fā)展的神經(jīng)生物學(xué)的啟發(fā)。人工神經(jīng)元被設(shè)計(jì)用來(lái)模擬神經(jīng)元接收和轉(zhuǎn)換信息的基本特性。

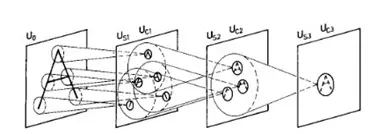

其次,卷積網(wǎng)絡(luò)所執(zhí)行的主要功能和計(jì)算受到了某些關(guān)于視覺(jué)系統(tǒng)的早期發(fā)現(xiàn)的啟發(fā)。1962 年,Hubel 和 Wiesel 發(fā)現(xiàn)初級(jí)視覺(jué)皮層中的神經(jīng)元會(huì)響應(yīng)視覺(jué)環(huán)境中特定的簡(jiǎn)單特征(尤其是有向的邊)。此外,他們注意到了兩種不同類(lèi)型的細(xì)胞:簡(jiǎn)單細(xì)胞(它們只在非常特定的空間位置對(duì)它們偏好的方向起***烈的響應(yīng))和復(fù)雜細(xì)胞(它們的響應(yīng)有更大的空間不變性)。他們得出結(jié)論:復(fù)雜細(xì)胞通過(guò)在來(lái)自多個(gè)簡(jiǎn)單細(xì)胞(每個(gè)都有一個(gè)不同的偏好位置)的輸入上進(jìn)行池化而實(shí)現(xiàn)了這種不變性。這兩個(gè)特征(對(duì)特定特征的選擇性以及通過(guò)前饋連接增大空間不變性)構(gòu)成了 CNN 這樣的人工視覺(jué)系統(tǒng)的基礎(chǔ)。

神經(jīng)認(rèn)知機(jī)(neocognitron)

CNN 的發(fā)展可以通過(guò)被稱(chēng)為神經(jīng)認(rèn)知機(jī)的模型直接追溯到這一發(fā)現(xiàn)。神經(jīng)認(rèn)知機(jī)是福島邦彥(Kunihiko Fukushima)于 1980 年開(kāi)發(fā)的,其融合了當(dāng)時(shí)有關(guān)生物視覺(jué)的知識(shí),以期構(gòu)建出一個(gè)能夠工作的人工視覺(jué)系統(tǒng)。神經(jīng)認(rèn)知機(jī)由「S 細(xì)胞」和「C 細(xì)胞」構(gòu)成,可通過(guò)無(wú)監(jiān)督學(xué)習(xí)來(lái)學(xué)習(xí)識(shí)別簡(jiǎn)單的圖像。最早開(kāi)發(fā)出 CNN 的 AI 研究者 Yann LeCun 明確表明他們的開(kāi)發(fā)根基于神經(jīng)認(rèn)知機(jī),參閱:

https://www.cs.toronto.edu/~hinton/absps/NatureDeepReview.pdf

3. CNN 什么時(shí)候開(kāi)始流行起來(lái)的?

縱觀整個(gè)計(jì)算機(jī)視覺(jué)史,很多研究工作都集中在人工設(shè)計(jì)要在圖像中檢測(cè)的特征上,這些設(shè)計(jì)都基于人們對(duì)圖像中最有信息的部分的看法。經(jīng)過(guò)這些人工設(shè)計(jì)的特征的過(guò)濾之后,學(xué)習(xí)只會(huì)在***的階段進(jìn)行,以將特征映射到目標(biāo)類(lèi)別。通過(guò)監(jiān)督學(xué)習(xí)端到端訓(xùn)練的 CNN 提供了一種自動(dòng)生成這些特征的方法,這是最適合這種任務(wù)的方法。

這方面最早的主要示例出現(xiàn)在 1989 年。那時(shí)候 LeCun 等人使用反向傳播訓(xùn)練了一個(gè)小型 CNN 來(lái)識(shí)別手寫(xiě)數(shù)字。隨著 1999 年 MNIST 數(shù)據(jù)集的引入,CNN 的能力得到了進(jìn)一步的發(fā)展和驗(yàn)證。盡管取得了這樣的成功,但由于研究界認(rèn)為這種訓(xùn)練很困難,這種方法失勢(shì)了,非神經(jīng)網(wǎng)絡(luò)方法(比如支持向量機(jī))迎來(lái)了發(fā)展勢(shì)頭。

下一個(gè)大事件直到 2012 年才出現(xiàn),那一年完全通過(guò)監(jiān)督方法訓(xùn)練的一個(gè)深度 CNN 贏得了當(dāng)年的 ImageNet 競(jìng)賽。那時(shí)候,1000 類(lèi)目標(biāo)分類(lèi)的優(yōu)良錯(cuò)誤率大約是 25%,但 AlexNet 實(shí)現(xiàn)了 16% 的錯(cuò)誤率,這是一個(gè)巨大進(jìn)步。這一挑戰(zhàn)賽之前的獲勝方法依賴(lài)于更古老的技術(shù),比如淺網(wǎng)絡(luò)和 SVM。CNN 的這一進(jìn)展得益于使用了某些全新的技術(shù),比如 ReLU(而不是 sigmoid 或雙曲正切非線(xiàn)性)、將網(wǎng)絡(luò)分配在 2 個(gè) GPU 上執(zhí)行和 dropout 正則化。但這并不是無(wú)中生有突如其來(lái)的,神經(jīng)網(wǎng)絡(luò)的復(fù)興早在 2006 年就初見(jiàn)端倪了。但是,這些網(wǎng)絡(luò)大都使用了無(wú)監(jiān)督預(yù)訓(xùn)練。2012 年的這一進(jìn)展絕對(duì)算得上是現(xiàn)代深度學(xué)習(xí)大爆發(fā)的一個(gè)重磅時(shí)刻。

參閱《用于圖像分類(lèi)的深度卷積神經(jīng)網(wǎng)絡(luò):全面回顧》:

https://www.mitpressjournals.org/doi/abs/10.1162/neco_a_00990

4. CNN 與視覺(jué)系統(tǒng)的當(dāng)前聯(lián)系是何時(shí)出現(xiàn)的?

當(dāng)今神經(jīng)科學(xué)領(lǐng)域?qū)?CNN 的熱情喧囂很多都源自 2014 年左右發(fā)表的少數(shù)研究。這些研究明確比較了在不同的系統(tǒng)看到同樣的圖像時(shí),從人類(lèi)和獼猴身上記錄到的神經(jīng)活動(dòng)與 CNN 中的人工活動(dòng)。

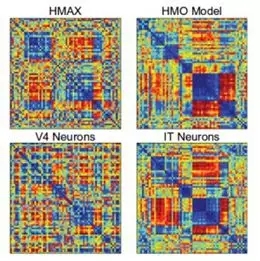

首先是 Yamins et al. (2014)。這一研究探索了很多不同的 CNN 架構(gòu),以確定是什么導(dǎo)致了預(yù)測(cè)猴子 IT 細(xì)胞的響應(yīng)的優(yōu)良能力。對(duì)于一個(gè)給定的網(wǎng)絡(luò),數(shù)據(jù)的一個(gè)子集被用于訓(xùn)練能將人工網(wǎng)絡(luò)中的活動(dòng)映射到單個(gè) IT 細(xì)胞活動(dòng)的線(xiàn)性回歸模型。在留存數(shù)據(jù)上的預(yù)測(cè)能力被用于評(píng)估該模型。另外還有使用另外一種方法:表征相似度分析(representational similarity analysis)。這一方法不涉及對(duì)神經(jīng)活動(dòng)的直接預(yù)測(cè),而是會(huì)問(wèn)兩個(gè)系統(tǒng)是否能以相同的方式表征信息。這是通過(guò)為每個(gè)系統(tǒng)構(gòu)建一個(gè)矩陣實(shí)現(xiàn)的,其中的值代表對(duì)兩個(gè)不同輸入的響應(yīng)的相似度。如果這些矩陣在不同的系統(tǒng)上看起來(lái)一樣,那么它們表征信息的方式也是類(lèi)似的。

不同系統(tǒng)的表征相異度矩陣(Representational Dissimilarity Matrix)

通過(guò)這兩種措施,為目標(biāo)識(shí)別優(yōu)化過(guò)的 CNN 的表現(xiàn)超越了其它方法。此外,該網(wǎng)絡(luò)的第 3 層能更好地預(yù)測(cè) V4 細(xì)胞的活動(dòng),而第 4 層(***一層)能更好地預(yù)測(cè) IT 細(xì)胞的活動(dòng)。這表明模型層與腦區(qū)之間存在對(duì)應(yīng)關(guān)系。

另一個(gè)發(fā)現(xiàn)是在目標(biāo)識(shí)別上表現(xiàn)更好的網(wǎng)絡(luò)在獲取 IT 活動(dòng)上也表現(xiàn)更好,而無(wú)需直接在 IT 數(shù)據(jù)上進(jìn)行優(yōu)化。這一趨勢(shì)在更大更好的網(wǎng)絡(luò)上也能大致保持,直到遇到某些限制(見(jiàn)第 11 問(wèn))。

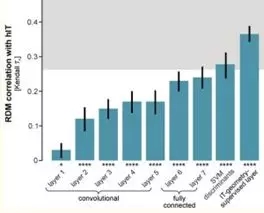

CNN 的后面幾層有與人類(lèi) IT 更相似的表征

另一篇論文 Khaligh-Razavi and Kriegeskorte (2014) 也使用了表征相似度分析,其將 37 種不同的模型與人類(lèi)和猴子 IT 進(jìn)行了比較。他們也發(fā)現(xiàn)更擅長(zhǎng)目標(biāo)識(shí)別的模型也能更好地匹配 IT 表征。此外,通過(guò)監(jiān)督學(xué)習(xí)訓(xùn)練的深度 CNN(AlexNet)是表現(xiàn)***的,也是最匹配的,其中該網(wǎng)絡(luò)的后面基層的表現(xiàn)比前面幾層更好。

5. 神經(jīng)科學(xué)家過(guò)去是否使用過(guò)類(lèi)似 CNN 的方法?

是的!第 2 問(wèn)中提到的神經(jīng)認(rèn)知機(jī)受到了 Hubel 和 Wiesel 的發(fā)現(xiàn)的啟發(fā),并且又轉(zhuǎn)而啟發(fā)了現(xiàn)代 CNN,但它也還催生了一些視覺(jué)神經(jīng)科學(xué)領(lǐng)域的研究分支,其中最顯眼的是 Tomaso Poggio、Thomas Serre、Maximilian Riesenhuber 和 Jim DiCarlo 的實(shí)驗(yàn)室的研究。基于卷積的堆疊和***池化的模型被用于解釋視覺(jué)系統(tǒng)的各種性質(zhì)。這些模型通常使用了不同于當(dāng)前 CNN 的非線(xiàn)性和特征的無(wú)監(jiān)督訓(xùn)練(在當(dāng)時(shí)的機(jī)器學(xué)習(xí)領(lǐng)域也很流行),而且它們沒(méi)有達(dá)到現(xiàn)代 CNN 的規(guī)模。

視覺(jué)神經(jīng)科學(xué)家和計(jì)算機(jī)視覺(jué)研究者所選擇的道路有各種不同的重合和分岔,因?yàn)樗麄兯非蟮哪繕?biāo)不同但又相關(guān)。但總體而言,CNN 可以很好地被視為視覺(jué)神經(jīng)科學(xué)家的建模道路的延續(xù)。來(lái)自深度學(xué)習(xí)領(lǐng)域的貢獻(xiàn)涉及到計(jì)算能力和訓(xùn)練方法(以及數(shù)據(jù)),讓這些模型最終發(fā)揮了作用。

6. 我們有什么證據(jù)說(shuō) CNN 的工作方式「類(lèi)似大腦」?

卷積神經(jīng)網(wǎng)絡(luò)有三個(gè)主要特點(diǎn)能支持將它們用作生物視覺(jué)的模型:(1)它們可以以接近人類(lèi)的水平執(zhí)行視覺(jué)任務(wù),(2)它們的工作架構(gòu)復(fù)制了有關(guān)視覺(jué)系統(tǒng)的已知基本功能,(3)它們產(chǎn)生的活動(dòng)能與視覺(jué)系統(tǒng)中不同區(qū)域的活動(dòng)直接關(guān)聯(lián)。

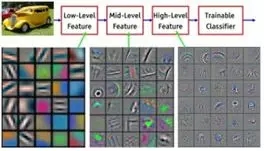

視覺(jué)層次結(jié)構(gòu)的特征

首先,究其根本和架構(gòu),它們有視覺(jué)層次結(jié)構(gòu)的兩個(gè)重要組件。首先,單個(gè)單元感受野的大小會(huì)隨網(wǎng)絡(luò)中層的遞進(jìn)而增大,就像 V1 到 IT 中感受野的增大一樣。第二,隨著層的遞進(jìn),神經(jīng)元所響應(yīng)的圖像特征也越來(lái)越復(fù)雜,就像調(diào)諧過(guò)程從 V1 中的簡(jiǎn)單線(xiàn)條到 IT 中的目標(biāo)部分一樣。這種特征復(fù)雜度的增長(zhǎng)可直接通過(guò)可用于 CNN 的可視化技術(shù)看到。

網(wǎng)絡(luò)在不同層所學(xué)習(xí)的特征的可視化

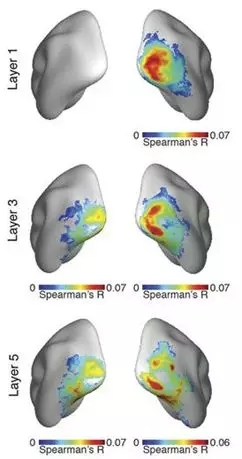

再更深入地看一下第(3)點(diǎn),在原來(lái)的 2014 年的研究(Q4)之后的很多研究都在進(jìn)一步確定 CNN 中的活動(dòng)與視覺(jué)系統(tǒng)之間的關(guān)系。這些都表明了同樣的一般性發(fā)現(xiàn):在觀看同樣的圖像時(shí),人工網(wǎng)絡(luò)中的活動(dòng)可與視覺(jué)系統(tǒng)的活動(dòng)關(guān)聯(lián)起來(lái)。此外,人工網(wǎng)絡(luò)中后面的層能對(duì)應(yīng)于腹視流(ventral visual stream)中更后的區(qū)域(或使用 MEG 等方法時(shí)所得響應(yīng)中更后的時(shí)間點(diǎn))。

很多不同的方法和數(shù)據(jù)集都可被用于制作這些點(diǎn),比如下列研究:Seibert et al. (2016)、Cadena et al. (2017)、Cichy et al. (2016)、Wen et al. (2018)、Eickenberg et al. (2017)、Güçlü and van Gerven (2015) 和 Seeliger et al. (2017)。

不同 CNN 層與腦區(qū)的表征的對(duì)應(yīng)(來(lái)自 Cichy et al.)

這些研究關(guān)注的重點(diǎn)一般是在簡(jiǎn)單呈現(xiàn)不同目標(biāo)類(lèi)別的自然圖像時(shí)所得到的初始神經(jīng)響應(yīng)。因此,這些 CNN 實(shí)現(xiàn)的是所謂的「核心目標(biāo)識(shí)別」或「快速鑒別給定視覺(jué)目標(biāo)與其它所有目標(biāo)的能力,即使出現(xiàn)了身份保持不變的變換(位置、尺寸、視角和視覺(jué)背景改變)」。一般而言,標(biāo)準(zhǔn)的前饋 CNN 能***地得到視覺(jué)響應(yīng)的早期組件,這說(shuō)明它們復(fù)現(xiàn)了從視網(wǎng)膜到更高的皮層區(qū)的初始前饋信息掃視。

視覺(jué)系統(tǒng)創(chuàng)建的一系列神經(jīng)表征可以被 CNN 復(fù)現(xiàn),這一事實(shí)說(shuō)明它們執(zhí)行了一樣的「解開(kāi)(untangling)過(guò)程。也就是說(shuō),這兩種系統(tǒng)都會(huì)取圖像/視網(wǎng)膜層面上不可分的不同目標(biāo)類(lèi)別的表征,并且創(chuàng)建允許線(xiàn)性可分的表征。

除了比較活動(dòng),我們還可以更深入(1),即網(wǎng)絡(luò)的表現(xiàn)。這些網(wǎng)絡(luò)與人類(lèi)和動(dòng)物的行為之間的詳細(xì)比較可以進(jìn)一步被用于驗(yàn)證它們作為模型的使用情況以及確定仍然需要進(jìn)展的領(lǐng)域。來(lái)自這類(lèi)研究的發(fā)現(xiàn)已經(jīng)表明這些網(wǎng)絡(luò)可以比之前來(lái)自多個(gè)領(lǐng)域的模型更好地取得人類(lèi)分類(lèi)行為的模式(甚至能預(yù)測(cè)/操作它),但在某些特定領(lǐng)域這些網(wǎng)絡(luò)表現(xiàn)很差,比如圖像中出現(xiàn)噪聲或圖像差別很小但準(zhǔn)確度下降很多的情況。

這種行為效應(yīng)的研究包括:Rajalingham et al. (2018)、Kheradpishesh et al. (2015)、Elsayed et al. (2018)、Jozwik et al. (2017)、Kubilius et al. (2016)、Dodge and Karam (2017)、Berardino et al. (2017) 和 Geirhos et al. (2017)。

所有這些是否滿(mǎn)足優(yōu)秀大腦模型的標(biāo)準(zhǔn)?我們***看看視覺(jué)領(lǐng)域的人說(shuō)他們希望從視覺(jué)系統(tǒng)模型中得到什么:

| 理解大腦的目標(biāo)識(shí)別解決方案的進(jìn)展需要構(gòu)建人工識(shí)別系統(tǒng)(通常會(huì)用到生物學(xué)啟發(fā),比如 [2-6]),其最終目的是模擬我們自己的視覺(jué)能力。這樣的計(jì)算方法是至關(guān)重要的,因?yàn)樗鼈兡芴峁┛赏ㄟ^(guò)實(shí)驗(yàn)檢驗(yàn)的假設(shè),也因?yàn)橛行ёR(shí)別系統(tǒng)的實(shí)例化是理解目標(biāo)識(shí)別上一種特別有效的成功度量。

——Pinto et al., 2007 |

從這個(gè)角度看,很顯然 CNN 并不是視覺(jué)科學(xué)領(lǐng)域目標(biāo)的轉(zhuǎn)移,而是實(shí)現(xiàn)其目標(biāo)的一種方法。

7. 有其它能更好預(yù)測(cè)視覺(jué)區(qū)域的行為的模型嗎?

總體而言,沒(méi)有。已經(jīng)有一些研究直接比較了 CNN 與之前的視覺(jué)系統(tǒng)模型(比如 HMAX)的獲取神經(jīng)活動(dòng)的能力。CNN 出類(lèi)拔萃。這樣的研究包括:Yamins et al. (2014)、Cichy et al. (2017) 和 Cadieu et al. (2014)。

8. CNN 是視覺(jué)系統(tǒng)的機(jī)制模型還是描述模型?

機(jī)制模型的合理定義是該模型的內(nèi)部部分可以映射到系統(tǒng)中相關(guān)的內(nèi)部部分。而描述模型則是僅匹配他們的整體輸入-輸出關(guān)系。所以視覺(jué)系統(tǒng)的描述模型可能是一個(gè)輸入圖像并且能輸出與人類(lèi)給出的標(biāo)簽一致的目標(biāo)標(biāo)簽的模型,但可能其工作方式與大腦并沒(méi)有明顯的聯(lián)系。但是,如上所述,CNN 的層可以映射到大腦的區(qū)域。因此,在 CNN 執(zhí)行目標(biāo)識(shí)別時(shí),它是腹側(cè)系統(tǒng)所執(zhí)行的表征變換的機(jī)制模型。

整體而言,如果要讓 CNN 是機(jī)制模型,我們不需要讓所有組件都有對(duì)應(yīng)機(jī)制。舉個(gè)例子,傳統(tǒng)的大腦回路模型中基于放電率(rate-based)的神經(jīng)元的使用。基于放電率的神經(jīng)模型只是一個(gè)將輸入強(qiáng)度映射到輸出放電率的簡(jiǎn)單函數(shù)。因此,它們只是神經(jīng)元的描述性模型:模型中沒(méi)有內(nèi)部組件與導(dǎo)致放電率的神經(jīng)過(guò)程有關(guān)(Hodgkin-Huxley 神經(jīng)元等更細(xì)化的生物物理模型是機(jī)制的)。然而,我們?nèi)匀豢梢允褂没诜烹娐实纳窠?jīng)元來(lái)構(gòu)建回路的機(jī)制模型(我喜歡的一個(gè)案例:https://www.ncbi.nlm.nih.gov/pubmed/25611511)。所有機(jī)制模型都依賴(lài)描述模型作為它們的基本單元(否則我們都需要深入到量子機(jī)制來(lái)構(gòu)建模型了)。

所以 CNN 的組件(即層——由卷積、非線(xiàn)性、可能的歸一化和池化構(gòu)成)是腦區(qū)的機(jī)制模型還是描述模型?這個(gè)問(wèn)題更難以回答。盡管這些層是由人工神經(jīng)元構(gòu)成的,其可以合理地映射到真實(shí)的神經(jīng)元(或神經(jīng)元群),但很多計(jì)算的實(shí)現(xiàn)都不是生物式的。比如,歸一化(在使用它的網(wǎng)絡(luò)中)是使用高度參數(shù)化的除法方程實(shí)現(xiàn)的。我們相信這些計(jì)算可以使用擬真的神經(jīng)機(jī)制實(shí)現(xiàn)(見(jiàn)上面引用的研究),但目前的模型并沒(méi)有這樣使用(不過(guò)我和其他一些人正在研究這個(gè)問(wèn)題……見(jiàn)第 12 問(wèn))。

9. 我們應(yīng)該如何解讀 CNN 的不同部分與大腦的關(guān)系?

對(duì)于習(xí)慣了處理細(xì)胞層面的事物的神經(jīng)科學(xué)家而言,可能會(huì)覺(jué)得 CNN 這樣的模型的抽象價(jià)值大過(guò)實(shí)用價(jià)值(盡管研究抽象多區(qū)域建模的認(rèn)知科學(xué)家可能會(huì)更熟悉它們)。

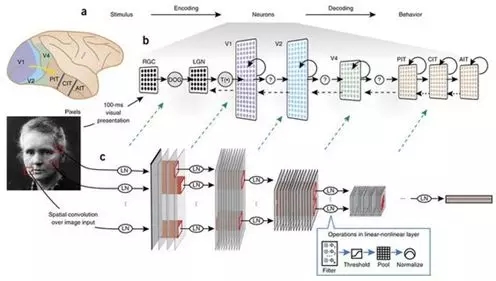

將 CNN 與大腦的區(qū)域和處理關(guān)聯(lián)起來(lái)

但就算沒(méi)有確切的生物學(xué)細(xì)節(jié),我們還是可以將 CNN 的組件映射到視覺(jué)系統(tǒng)的組件。首先,CNN 的輸入通常是三維(RGB)的像素值,它們已經(jīng)過(guò)了一些歸一化或變白處理,大致可以對(duì)應(yīng)視網(wǎng)膜和背外側(cè)膝狀體核所執(zhí)行的計(jì)算。卷積所創(chuàng)造的特征圖有一個(gè)空間布局,類(lèi)似于在視覺(jué)區(qū)域中找到的視網(wǎng)膜拓?fù)溆成?retinotopy),這意味著每個(gè)人工神經(jīng)元都有一個(gè)空間受限的感受野。與每個(gè)特征圖相關(guān)的卷積過(guò)濾器確定了該特征圖中的神經(jīng)元的特征調(diào)制。單個(gè)人工神經(jīng)元并不是要直接映射到單個(gè)真實(shí)神經(jīng)元;將單個(gè)單元想成是皮質(zhì)柱(cortical column)可能會(huì)更合理一點(diǎn)。

CNN 的哪些層對(duì)應(yīng)于哪些腦區(qū)?早期使用僅包含少量層的模型的研究為一層映射一個(gè)腦區(qū)提供了支持。比如,在 Yamins et al. (2014) 中,***的卷積層能***地預(yù)測(cè) IT 活動(dòng),而倒數(shù)第二層能***地預(yù)測(cè) V4。但是,其確切的關(guān)系將取決于所使用的模型(更深度的模型允許每個(gè)腦區(qū)有更多層)。

在卷積網(wǎng)絡(luò)末尾的全連接層有更復(fù)雜的解讀方式。它們與分類(lèi)器的最終決策的緊密關(guān)系以及它們不再有視網(wǎng)膜拓?fù)涞氖聦?shí)說(shuō)明它們更像是前額皮質(zhì)。但它們?cè)陬A(yù)測(cè) IT 活動(dòng)上也可能表現(xiàn)很好。

10. 視覺(jué)系統(tǒng)有哪些 CNN 不具備的東西?

有很多。尖峰、掃視(saccade)、分開(kāi)的激勵(lì)和抑制細(xì)胞、動(dòng)態(tài)、反饋連接、跳過(guò)某些層的前饋連接、振蕩、樹(shù)突、皮質(zhì)層、神經(jīng)調(diào)質(zhì)、中央凹、橫向連接、不同細(xì)胞類(lèi)型、雙眼視覺(jué)、適應(yīng)、噪聲以及大腦的其它細(xì)節(jié)。

當(dāng)然,還有一些特性是當(dāng)今用作模型的大多數(shù)標(biāo)準(zhǔn) CNN 默認(rèn)沒(méi)有的。但它們中很多都已經(jīng)在更新型的模型中得到了研究,比如:skip 連接、反饋連接、掃視、尖峰、橫向連接和中央凹。

所以很顯然,CNN 并不是對(duì)靈長(zhǎng)類(lèi)視覺(jué)的直接復(fù)制。還應(yīng)該清楚這并不意味著模型不合格。模型不可能是(也不應(yīng)該)是相關(guān)系統(tǒng)的完整復(fù)現(xiàn)。我們的目標(biāo)是讓模型具備能解釋我們想要了解的關(guān)于視覺(jué)的信息的必要特性,所以某個(gè)特性的缺乏對(duì)不同的人來(lái)說(shuō)重要性也不一樣。比如說(shuō),預(yù)測(cè) IT 神經(jīng)元在前 100 ms 左右對(duì)圖像的平均響應(yīng)需要哪些特性?這是一個(gè)需要實(shí)證的問(wèn)題。我們不能事先就說(shuō)某個(gè)生物特性是必要的或沒(méi)有這個(gè)特性的模型不好。

我們可以說(shuō)沒(méi)有尖峰、E-I 類(lèi)型和其它實(shí)現(xiàn)特性的細(xì)節(jié)的模型比有這些細(xì)節(jié)的模型更加抽象。但抽象沒(méi)有錯(cuò)。這只是意味著我們?cè)敢獍褑?wèn)題分成不同的層次,然后單獨(dú)解決它們。我們某天應(yīng)該能將這些不同層面的解釋組合到一起,得到在大尺度和精細(xì)尺度上復(fù)現(xiàn)大腦的復(fù)制品。但我們必須記住,不要讓***成為成功路上的敵人。

11. CNN 能做到什么視覺(jué)系統(tǒng)無(wú)法做到的事?

對(duì)我而言,這是一個(gè)更加相關(guān)的問(wèn)題。使用某種非生物學(xué)的模型來(lái)繞過(guò)困難問(wèn)題比使用缺乏某些特定生物特性的模型更有問(wèn)題。

***個(gè)問(wèn)題:卷積權(quán)重有正有負(fù)。這意味著前饋連接有激勵(lì)性的,也有抑制性的(而在大腦區(qū)域之間的大腦連接大都是激勵(lì)性的),單個(gè)的人工神經(jīng)元可以激勵(lì)也可以抑制。如果我們只把權(quán)重看作是凈效果,那么這還問(wèn)題不大,這實(shí)際上也許可以通過(guò)連接抑制細(xì)胞的前饋激勵(lì)連接而執(zhí)行。

接下來(lái):權(quán)重是共享的。這意味著特征圖中某個(gè)位置的神經(jīng)元在其輸入上會(huì)使用與同一特征圖中另一個(gè)不同神經(jīng)元完全一樣的權(quán)重。盡管方位調(diào)諧(orientation tuning)等功能在 V1 中的視網(wǎng)膜拓?fù)渖鲜沁@個(gè)情況,但我們不相信在一個(gè)視覺(jué)空間中更偏愛(ài)垂直線(xiàn)的神經(jīng)元會(huì)與另一個(gè)位置更偏愛(ài)垂直線(xiàn)的神經(jīng)元有完全一樣的輸入權(quán)重。這里可沒(méi)有確保所有權(quán)重都相關(guān)和共享的「鬼魅般的超距作用」。因此,當(dāng)前使用的幫助訓(xùn)練這些網(wǎng)絡(luò)的權(quán)重共享應(yīng)該被更接近生物創(chuàng)建空間不變調(diào)節(jié)的方法替代。

第三:***池化怎么樣?用神經(jīng)科學(xué)的術(shù)語(yǔ)講,***池化操作類(lèi)似于神經(jīng)元的放電率,其等于其***放電輸入的放電率。因?yàn)樯窠?jīng)元會(huì)匯集很多神經(jīng)元的信號(hào),所以很難設(shè)計(jì)一個(gè)能直接做到這一點(diǎn)的神經(jīng)元。但池化操作是受復(fù)雜細(xì)胞的發(fā)現(xiàn)啟發(fā)的,而且最早是被用作一種平均化操作,這是神經(jīng)元可以輕松實(shí)現(xiàn)的。但事實(shí)已經(jīng)證明***池化在目標(biāo)識(shí)別表現(xiàn)和擬合生物數(shù)據(jù)方面會(huì)更加成功,而且現(xiàn)在已被廣泛使用。

機(jī)器學(xué)習(xí)研究者對(duì) CNN 的進(jìn)一步發(fā)展已經(jīng)讓它們遠(yuǎn)遠(yuǎn)超越了視覺(jué)系統(tǒng)的范疇(因?yàn)闄C(jī)器學(xué)習(xí)研究者的目標(biāo)只有表現(xiàn)水平本身)。某些表現(xiàn)***的 CNN 現(xiàn)在有很多在生物學(xué)角度上看起來(lái)很奇怪的特征。此外,這些更新的模型的極端深度(大約 50 層)已然降低了它們的活動(dòng)與視覺(jué)系統(tǒng)的關(guān)聯(lián)。

當(dāng)然,也還存在這些網(wǎng)絡(luò)的訓(xùn)練方式的問(wèn)題(通過(guò)反向傳播)。這會(huì)在第 13 問(wèn)討論。

12. CNN 能做得更像人腦嗎?

我當(dāng)計(jì)算神經(jīng)科學(xué)家的一個(gè)主要原因是(沒(méi)有實(shí)驗(yàn)設(shè)置的限制)我們可以做任何我們想做的事情。所以,是的!我們可以讓標(biāo)準(zhǔn) CNN 有更多生物啟發(fā)式特性。讓我們看看我們已經(jīng)取得的成果:

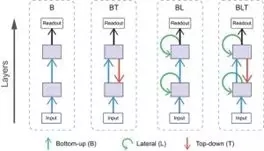

正如第 10 問(wèn)中提及的,很多架構(gòu)元素已經(jīng)被添加到了 CNN 的不同變體中,這使得它們更接近腹側(cè)流。此外,在增加學(xué)習(xí)過(guò)程的合理性方面也已經(jīng)有了一些研究成果(見(jiàn)第 13 問(wèn))。

除了這些努力之外,在復(fù)現(xiàn)生物細(xì)節(jié)方面的具體研究還包括:

受生物學(xué)啟發(fā)的 Spoerer et al. (2017) 表明橫向連接和反饋連接可以讓模型更好地識(shí)別有遮擋和有噪聲的目標(biāo)。

增加生物學(xué)啟發(fā)的連接,來(lái)自 Spoerer et al. (2017)

我本人的一些研究(在 Cosyne 2017 上呈現(xiàn)并在準(zhǔn)確提交期刊)涉及到將穩(wěn)定超線(xiàn)性網(wǎng)絡(luò)(stabilized supralinear network)(一種實(shí)現(xiàn)歸一化的仿生物回路模型)納入 CNN 架構(gòu)中。這會(huì)為 CNN 引入 E 和 I 細(xì)胞類(lèi)型、動(dòng)態(tài)和循環(huán)(recurrence)。

Costa et al. (2017) 使用生物學(xué)啟發(fā)的組件實(shí)現(xiàn)了長(zhǎng)短期記憶網(wǎng)絡(luò)(LSTM)。在為人工神經(jīng)網(wǎng)絡(luò)添加循環(huán)時(shí),LSTM 是很常用的,所以確定可以如何通過(guò)生物式的方式實(shí)現(xiàn)這種功能會(huì)很有用。

13. CNN 使用反向傳播學(xué)習(xí)權(quán)重的方法是否重要?

反向傳播涉及到計(jì)算網(wǎng)絡(luò)中任意位置的權(quán)重應(yīng)該變化的方式,以便減少分類(lèi)器產(chǎn)生的誤差。這意味著***層的一個(gè)突觸會(huì)有一些關(guān)于錯(cuò)誤的信息并一直傳遞到頂層。但真正的神經(jīng)元往往依賴(lài)于局部的學(xué)習(xí)規(guī)則(比如赫布可塑性(Hebbian plasticity)),其中權(quán)重的變化主要是由神經(jīng)元之前和之后的突觸決定的,而不會(huì)受到任何遙遠(yuǎn)因素的影響。因此,反向傳播應(yīng)該不是模擬生物方式。

這無(wú)需影響我們對(duì)完全訓(xùn)練的 CNN 作為視覺(jué)系統(tǒng)的模型的影響。計(jì)算模型中的參數(shù)往往是用與大腦學(xué)習(xí)方式(比如用于獲取功能連接性的貝葉斯推理)沒(méi)有任何相似之處的技術(shù)擬合的。但這并不會(huì)讓所得到的回路模型無(wú)法解讀。在極端的情況下,我們可以將反向傳播看作是一個(gè)和其它技術(shù)一樣的單純的參數(shù)擬合工具。而且 Yamins et al. (2014) 確實(shí)使用了一種不同的參數(shù)擬合技術(shù)(不是反向傳播)。

但是,采納這一觀點(diǎn)并不意味著模型的特定方面是無(wú)法解讀的。比如,我們并不期望學(xué)習(xí)曲線(xiàn)(誤差隨模型學(xué)習(xí)的變化方式)與人類(lèi)或動(dòng)物學(xué)習(xí)時(shí)犯錯(cuò)的情況有關(guān)聯(lián)。

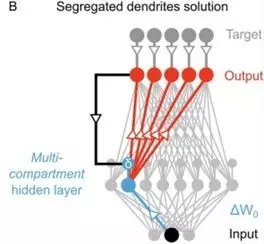

使用分離樹(shù)突(segregated dendrite)的局部誤差計(jì)算

盡管當(dāng)前實(shí)現(xiàn)的反向傳播不具有生物合理性,但其可被看作是大腦實(shí)際工作方式的一種抽象版本。目前有多個(gè)研究正努力使反向傳播具有生物合理性,比如通過(guò)局部計(jì)算和擬真的細(xì)胞類(lèi)型來(lái)實(shí)現(xiàn)反向傳播,比如《Towards deep learning with segregated dendrites》和《An Approximation of the Error Backpropagation Algorithm in a Predictive Coding Network with Local Hebbian Synaptic Plasticity》。這會(huì)讓這一學(xué)習(xí)過(guò)程獲得更好的生物學(xué)解釋。使用更有生物合理性的學(xué)習(xí)流程是否能得到更匹配數(shù)據(jù)的神經(jīng)活動(dòng)?這還是一個(gè)需要實(shí)證解答的問(wèn)題。

另一方面,無(wú)監(jiān)督學(xué)習(xí)看起來(lái)像是一個(gè)大腦機(jī)制,因?yàn)樗恍枰P(guān)于標(biāo)簽的明確反饋,而是使用了有關(guān)環(huán)境的自然統(tǒng)計(jì)來(lái)發(fā)展表征。到目前為止,無(wú)監(jiān)督學(xué)習(xí)還沒(méi)有實(shí)現(xiàn)監(jiān)督學(xué)習(xí)那樣高的目標(biāo)分類(lèi)表現(xiàn)。但使無(wú)監(jiān)督學(xué)習(xí)和方法具有生物合理性的進(jìn)展可能最終會(huì)帶來(lái)更好的視覺(jué)系統(tǒng)模型。

14. 我們能使用 CNN 了解到有關(guān)視覺(jué)系統(tǒng)的什么信息?

只靠 CNN,什么也了解不到。所有的見(jiàn)解和發(fā)展都需要通過(guò)與實(shí)驗(yàn)數(shù)據(jù)的交互而進(jìn)行驗(yàn)證和延展。也就是說(shuō),CNN 對(duì)我們理解視覺(jué)系統(tǒng)的方式可以有三種貢獻(xiàn)。

***是驗(yàn)證我們的直觀理解。就像費(fèi)曼說(shuō)的「我們不能理解我們不能創(chuàng)造的東西」。有了收集到的所有數(shù)據(jù)和發(fā)展起來(lái)的視覺(jué)系統(tǒng)理論,神經(jīng)科學(xué)家為什么不能創(chuàng)造一個(gè)可工作的視覺(jué)系統(tǒng)呢?這應(yīng)該能讓我們警醒,并意識(shí)到我們錯(cuò)過(guò)了一些關(guān)鍵的東西。現(xiàn)在我們可以說(shuō)我們對(duì)視覺(jué)系統(tǒng)的直觀理解基本上是正確的,我們只是缺少計(jì)算能力和訓(xùn)練數(shù)據(jù)。

第二是允許實(shí)現(xiàn)理想的實(shí)驗(yàn)檢驗(yàn)平臺(tái)。這是科學(xué)界對(duì)機(jī)制模型的常用方法。我們可以使用已有數(shù)據(jù)建立一個(gè)模擬我們所感興趣的內(nèi)容的合理模型。然后我們測(cè)試其各個(gè)部分,看哪些部分對(duì)功能實(shí)現(xiàn)是重要的。這能用于產(chǎn)生假設(shè)以便未來(lái)實(shí)驗(yàn)和/或解釋之前未用于構(gòu)建該模型的數(shù)據(jù)。

第三種貢獻(xiàn)方式是通過(guò)數(shù)學(xué)分析。對(duì)于計(jì)算建模而言,情況總是如此;將我們關(guān)于視覺(jué)系統(tǒng)工作方式的信念整合成具體的數(shù)據(jù)術(shù)語(yǔ),從而開(kāi)啟新型的研究方向。盡管在模型上進(jìn)行分析時(shí)通常需要將它們進(jìn)一步簡(jiǎn)化,但這仍然能為模型行為的一般趨勢(shì)和局限性提供有幫助的見(jiàn)解。在這種特定情況下,還會(huì)有一些額外的發(fā)展動(dòng)力,因?yàn)槟承C(jī)器學(xué)習(xí)也有興趣在數(shù)學(xué)上剖解這些模型。這樣他們的見(jiàn)解就能在適當(dāng)?shù)那闆r成為我們的見(jiàn)解,比如 http://www.cs.toronto.edu/~wenjie/papers/nips16/top.pdf

15. 使用 CNN 作為視覺(jué)系統(tǒng)模型已讓我們了解到了什么?

首先,我們表明我們的直觀理解實(shí)際上可以用來(lái)構(gòu)建可工作的視覺(jué)系統(tǒng),從而驗(yàn)證了這些直觀理解。此外,這種方法已經(jīng)幫助我們定義了(用 Marr 的術(shù)語(yǔ))視覺(jué)系統(tǒng)的計(jì)算層面和算法層面。通過(guò)在目標(biāo)檢測(cè)上訓(xùn)練而獲得如此之多神經(jīng)數(shù)據(jù)和行為數(shù)據(jù)的能力說(shuō)明這是腹側(cè)流的核心計(jì)算作用。而一系列卷積和池化就是做到這一點(diǎn)所需的算法的一部分。

我相信,這些網(wǎng)絡(luò)的成功也有助于我們改變對(duì)視覺(jué)神經(jīng)科學(xué)領(lǐng)域基本研究單元的看法。很多視覺(jué)神經(jīng)科學(xué)領(lǐng)域(乃至所有神經(jīng)科學(xué)領(lǐng)域)一直以來(lái)都被以單個(gè)細(xì)胞及其調(diào)諧偏好為中心的方法所主導(dǎo)。沒(méi)有嚴(yán)格一個(gè)神經(jīng)元對(duì)應(yīng)一個(gè)神經(jīng)元的獲取數(shù)據(jù)的抽象模型將關(guān)注焦點(diǎn)放在了群編碼(population coding)上。某天有可能對(duì)理解單個(gè)調(diào)制函數(shù)的嘗試會(huì)得到同樣的結(jié)果,但目前群層面的方法看起來(lái)更有效。

此外,將視覺(jué)系統(tǒng)看作一整個(gè)系統(tǒng),而不是隔離的區(qū)域,能重塑我們對(duì)這些區(qū)域的理解方式。人們?cè)谘芯?V4 上投入了大量工作,比如試圖用語(yǔ)言或簡(jiǎn)單的數(shù)學(xué)來(lái)描述什么會(huì)導(dǎo)致該區(qū)域的細(xì)胞產(chǎn)生響應(yīng)。當(dāng) V4 被看作是目標(biāo)識(shí)別路徑上的中間立足點(diǎn)時(shí),似乎就更不可能將其拿出來(lái)單獨(dú)描述了。就像這篇綜述論文《Deep neural networks: a new framework for modelling

biological vision and brain information processing》說(shuō)的:「對(duì)一個(gè)單位的口頭功能解釋(比如作為眼睛或人臉檢測(cè)器)可能有助于我們直接理解某些重要的東西。但是,這樣的口頭解釋可能會(huì)夸大分類(lèi)和定位的程度,并低估這些表征的統(tǒng)計(jì)和分布本質(zhì)。」事實(shí)上,對(duì)訓(xùn)練后的網(wǎng)絡(luò)的分析已經(jīng)表明對(duì)單個(gè)單元的強(qiáng)大且可解讀的調(diào)制與優(yōu)良表現(xiàn)無(wú)關(guān),這說(shuō)明歷史上對(duì)單個(gè)單元的關(guān)注的方向有誤。

在探索不同的架構(gòu)方面還有一些更加具體的進(jìn)展。通過(guò)檢查獲取神經(jīng)和行為響應(yīng)的哪些元素上需要哪些細(xì)節(jié),我們可以得到結(jié)構(gòu)和功能之間的直接聯(lián)系。在《Deep Recurrent Neural Network Reveals a Hierarchy of Process Memory during Dynamic Natural Vision》這項(xiàng)研究中,加入網(wǎng)絡(luò)的橫向連接在解釋背側(cè)流響應(yīng)的時(shí)間過(guò)程上比在腹側(cè)流上的作用更大。其它研究說(shuō)明反饋連接對(duì)于獲取腹側(cè)流動(dòng)態(tài)而言是很重要的。還有研究表明神經(jīng)響應(yīng)的特定組分可以通過(guò)隨機(jī)權(quán)重的模型取得,這說(shuō)明分層架構(gòu)本身就能解釋它們。而其它組分則需要在自然且有效的圖像類(lèi)別上訓(xùn)練得到。

此外,我們還觀察到,特定表現(xiàn)優(yōu)良的 CNN 并不能準(zhǔn)確預(yù)測(cè)神經(jīng)行為(見(jiàn)第 11 問(wèn))。這個(gè)觀察很重要,因?yàn)檫@說(shuō)明并非所有具有視覺(jué)能力的模型都是大腦的良模型。這讓我們相信,我們看到的能很好預(yù)測(cè)神經(jīng)活動(dòng)的架構(gòu)(通過(guò)大腦區(qū)域和層之間的對(duì)應(yīng))表現(xiàn)良好的原因是它們確實(shí)獲取到了大腦所執(zhí)行的變換的某些過(guò)程。

因?yàn)?CNN 提供了一種生成擬真神經(jīng)響應(yīng)的「圖像可計(jì)算的」方式,所以它們也可被用于將更少被理解的信號(hào)與視覺(jué)處理關(guān)聯(lián)起來(lái),比如這兩項(xiàng)關(guān)于 contextualizing oscillation 的研究:《Using DNNs as a yardstick for estimating the representational value of oscillatory brain signals.》和《Activations of Deep Convolutional Neural Network are Aligned with Gamma Band Activity of Human Visual Cortex》。

我自己也有使用 CNN 作為視覺(jué)系統(tǒng)的模型的研究《Understanding Biological Visual Attention Using Convolutional Neural Networks》,我的研究主要是證明特征相似性增益模型(它描述了注意的神經(jīng)影響)可以解釋注意機(jī)制對(duì)表現(xiàn)效果的有益影響。

***,某些研究已經(jīng)記錄到了沒(méi)有被 CNN 所實(shí)現(xiàn)的神經(jīng)或行為元素(見(jiàn)第 6 問(wèn))。這些研究有助于確定需要進(jìn)一步實(shí)驗(yàn)和計(jì)算探索的區(qū)域。

案例還有很多。總而言之,鑒于這方面的研究從 2014 年左右才真正開(kāi)始,我會(huì)說(shuō)研究的數(shù)量已經(jīng)相當(dāng)不錯(cuò)了。

原文鏈接:

https://neurdiness.wordpress.com/2018/05/17/deep-convolutional-neural-networks-as-models-of-the-visual-system-qa/

【本文是51CTO專(zhuān)欄機(jī)構(gòu)“機(jī)器之心”的原創(chuàng)文章,微信公眾號(hào)“機(jī)器之心( id: almosthuman2014)”】